大数据——hadoop之hbase安装和配置

hadoop之hbase安装和配置

- 安装HBase前,需要的准备条件

- 安装HBase

- 配置HBase

-

- 单机模式

- 伪分布式模式

- 完全分布式模式(集群)

安装HBase前,需要的准备条件

- HBASE运行需要JDK

JDK安装和配置 - HBase的底层存储依赖于HDFS,需要安装hadoop环境

hadoop环境安装和配置 - HBase依赖于ZooKeeper来做分布式协调工作,所以需要安装Zookeeper的环境,博主所用的伪分布式,所以不用hbase内置的

zookeeper安装和配置

安装HBase

- 下载安装

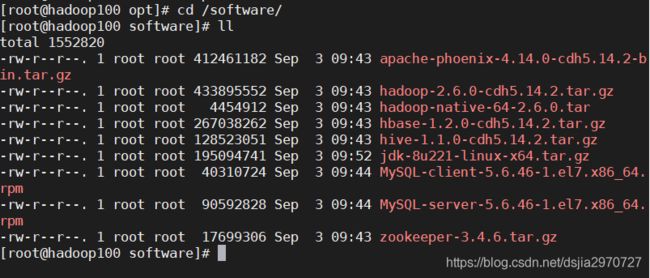

所用版本为hbase-1.2.0 - 进入到software目录下,并查看安装包:

[root@hadoop100 ~]# cd /software

[root@hadoop100 software]# ll

- 把hbase-1.2.0-cdh5.14.2.tar.gz解压到opt目录下

[root@hadoop100 software]# tar -zxvf hbase-1.2.0-cdh5.14.2.tar.gz -C /opt

- 移动到opt目录

[root@hadoop100 software]# cd /opt

- 把hbase-1.2.0-cdh5.14.2改名

[root@hadoop100 opt]# mv hbase-1.2.0-cdh5.14.2 hbase

配置HBase

单机模式

- 解压后就可以在单机模式下运行了。

- 配置环境变量

[root@hadoop100 opt]# vi /etc/profile

- 输入:

export HBASE_HOME=/opt/hbase

export PATH=$PATH:$HBASE_HOME/bin

- 保存退出,使其生效

[root@hadoop100 opt]# source /etc/profile

- 进入配置文件

[root@hadoop100 opt]# cd /opt/hbase/conf/

- 修改配置文件hbase-stie.xml

[root@hadoop100 conf]# vi hbase-site.xml

- 在两个configuration标签内插入:

<!-- hbase文件存储目录,这里指定的是linux系统,也可指定在hdfs://下-->

<property>

<name>hbase.rootdir</name>

<value>file:///opt/hbase/hbaseTmp

</property>

- 启动hbase

[root@hadoop100 conf]# start-hbase.sh

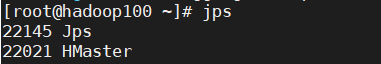

- 使用jps查看进程

[root@hadoop100 conf]# jps

- 关闭hbase

[root@hadoop100 conf]# stop-hbase.sh

伪分布式模式

- 配置环境变量

[root@hadoop100 opt]# vi /etc/profile

- 输入:

export HBASE_HOME=/opt/hbase

export PATH=$PATH:$HBASE_HOME/bin

- 保存退出,使其生效

[root@hadoop100 opt]# source /etc/profile

- 进入配置文件

[root@hadoop100 opt]# cd /opt/hbase/conf/

- 修改配置文件hbase-stie.xml

[root@hadoop100 conf]# vi hbase-site.xml

- 在两个configuration标签内插入:

<property>

<name>hbase.rootdir</name>

<value>hdfs://hadoop100:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>false</value>

</property>

- 配置hbase-env.sh

[root@hadoop100 conf]# vi conf/hbase-env.sh

- 在46和47行之前加上#,注释掉,输入

export JAVA_HOME=/opt/java8

export HBASE_MANAGES_ZK=true

- 启动hadoop

[root@hadoop100 conf]# start-all.sh

- 启动hbase

[root@hadoop100 conf]# hbase-daemon.sh start maseter

或

[root@hadoop100 conf]# start-hbase.sh

- 查看进程

[root@hadoop100 conf]# jps

- 进入shell

[root@hadoop100 conf] hbase shell

- 创建表测试一下

create 'abc',{NAME=>'kb09'},{NAME=>'kgc'},{NAME=>'kb07'}

- 查看表

list

- 查看表数据

desc 'abc'

- 退出shell

quit

关闭hbase

[root@hadoop100 conf]# stop-hbase.sh

或

[root@hadoop100 conf]# hbase-daemon.sh stop master

注意:开启时:先要开启hdfs,再开启hbase。

关闭时:先要关闭hbase,再关闭hdfs

完全分布式模式(集群)

前提:所有机器的时间误差不能大于30秒钟

时区同步

- 配置环境变量

[root@hadoop100 opt]# vi /etc/profile

- 输入:

export HBASE_HOME=/opt/hbase

export PATH=$PATH:$HBASE_HOME/bin

- 保存退出,使其生效

[root@hadoop100 opt]# source /etc/profile

- 进入配置文件

[root@hadoop100 opt]# cd /opt/hbase/conf/

- 修改配置文件hbase-stie.xml

[root@hadoop100 conf]# vi hbase-site.xml

- 在两个configuration标签内插入:

<!-- HRegionServer的数据存储目录-->

<property>

<name>hbase.rootdir</name>

<value>hdfs://hadoop100:9000/hbase</value>

</property>

<!-- 配置hbase为分布式值改为true-->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<!-- 配置Hmaster的地址,这里选择主机器hadoop110-->

<property>

<name>hbase.master</name>

<value>hadoop100:6000</value>

</property>

<!-- 配置zookeeper集群-->

<property>

<name>hbase.zookeeper.quorum</name>

<value>hadoop100,hadoop101,hadoop102</value>

</property>

- 配置hbase-env.sh:

[root@hadoop100 conf]# vi hbase-env.sh

- 添加:

export JAVA_HOME=/opt/java8

export HBASE_HOME=/opt/hbase

export HADOOP_HOME=/opt/hadoop

#表示内置zookeeper不开启(手动配置了zookeeper集群)

export HBASE_MANAGES_ZK=false

- 配置regionservers

[root@hadoop100 conf]# vi regionservers

- 输入:

hadoop101

hadoop102

- 将hbse目录和环境变量文件复制到另外的机器上:

[root@hadoop100 conf]# scp -r /opt/hbase root@hadoop101:/opt/hbase

[root@hadoop100 conf]# scp /etc/profile root@hadoop101:/etc/profile

[root@hadoop100 conf]# scp -r /opt/hbase root@hadoop102:/opt/hbase

[root@hadoop100 conf]# scp /etc/profile root@hadoop102:/etc/profile

- 在另外的机器上使环境变量生效:

[root@hadoop101 conf]# source /etc/profile

[root@hadoop102 conf]# source /etc/profile

- 启动主机器的hdfs

[root@hadoop100 conf]# start-all.sh

- 启动所有机器的zookeeper

[root@hadoop100 conf]# zkServer.sh start

[root@hadoop101 conf]# zkServer.sh start

[root@hadoop102 conf]# zkServer.sh start

- 启动主机器的hbase

[root@hadoop100 conf]# start-hbase.sh

- 所有机器进入shell

[root@hadoop100 conf]# hbase shell

[root@hadoop101 conf]# hbase shell

[root@hadoop102 conf]# hbase shell

- 所有机器退出shell

quit

quit

quit

- 关闭主机器的hbase

[root@hadoop100 conf]# stop-hbase.sh

- 最后关闭主机器的hdfs

[root@hadoop100 conf]# stop-all.sh