Hadoop中的MapReduce框架原理、切片源码断点在哪断并且介绍相关源码、FileInputFormat切片源码解析、总结,那些可以证明你看过切片的源码

文章目录

- 13.MapReduce框架原理

-

- 13.1InputFormat数据输入

-

- 13.1.3FileInputFormat切片源码解析

-

- 13.1.3.1切片源码断点在哪断并且介绍相关源码:

- 13.1.3.2切片源码详解

- 13.1.3.3总结,那些可以证明你看过切片的源码

13.MapReduce框架原理

13.1InputFormat数据输入

13.1.3FileInputFormat切片源码解析

13.1.3.1切片源码断点在哪断并且介绍相关源码:

断点在https://blog.csdn.net/Redamancy06/article/details/126501627?spm=1001.2014.3001.5501

这篇文章写了一部分了,可以先跟着这篇文章做,然后再看这篇文件就好理解了。

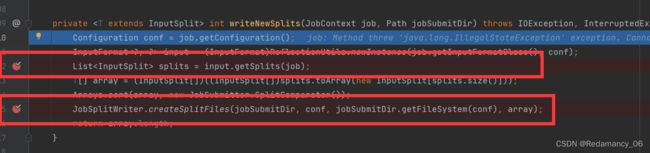

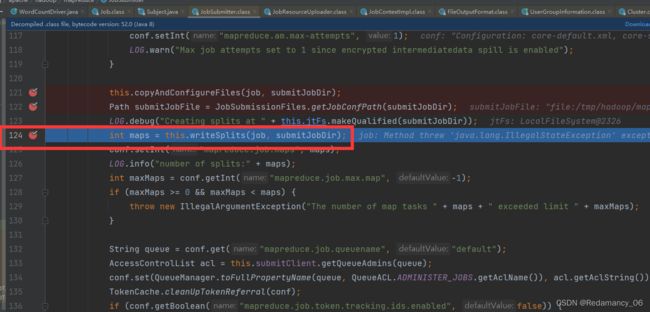

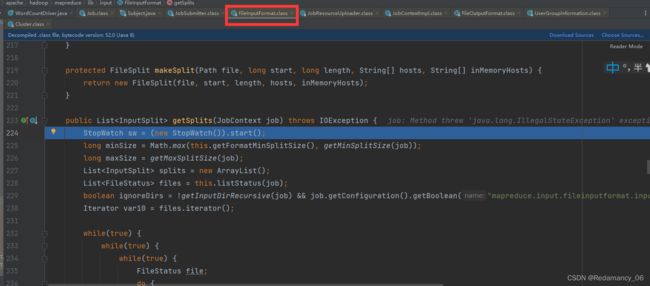

一直运行到这一步然后强制进入。

一直运行到这一步然后强制进入。

在这个位置打上断点,然后再断点处强行进入

在这个位置打上断点,然后再断点处强行进入

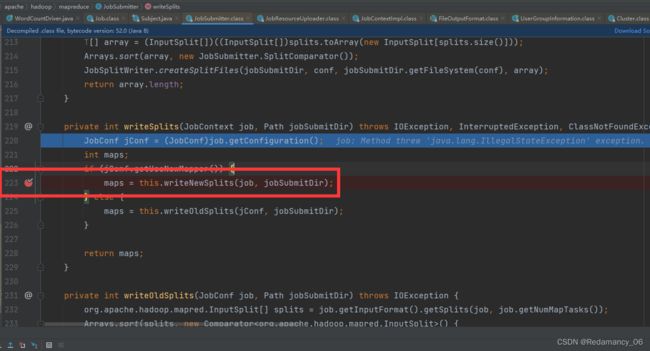

然后进入这个断点

然后进入这个断点

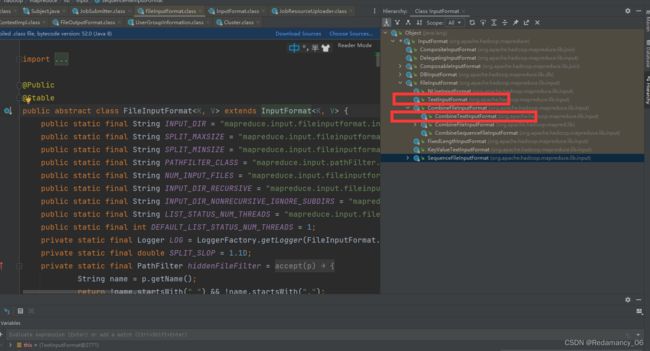

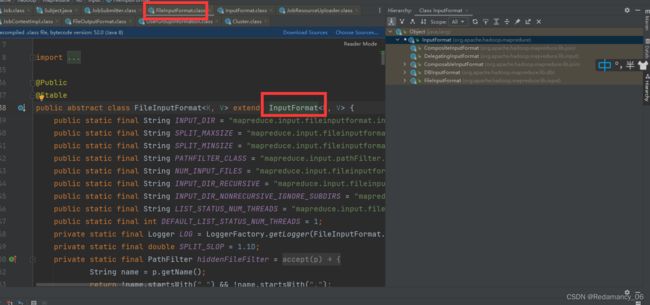

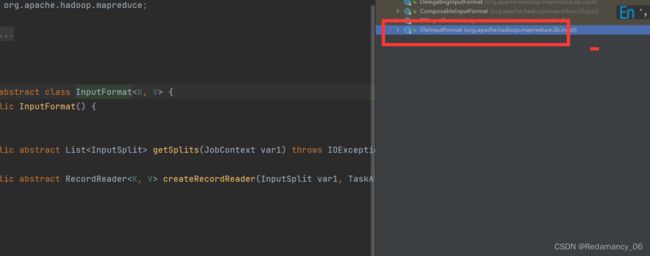

就到FileInputFormat类里面了

就到FileInputFormat类里面了

然后一直往上翻到最上面,点这个按下f4,就可以出现继承关系(type hierarchy)

然后一直往上翻到最上面,点这个按下f4,就可以出现继承关系(type hierarchy)

- 红色框住的是最常用的

TextInputFormat是默认的按行切

CombineTextInputFormat把多个小文件放到一起统一的进行切割 - 还有两个不经常用的

NLineInputFormat按行进行切割

KeyValueTextInputFormat

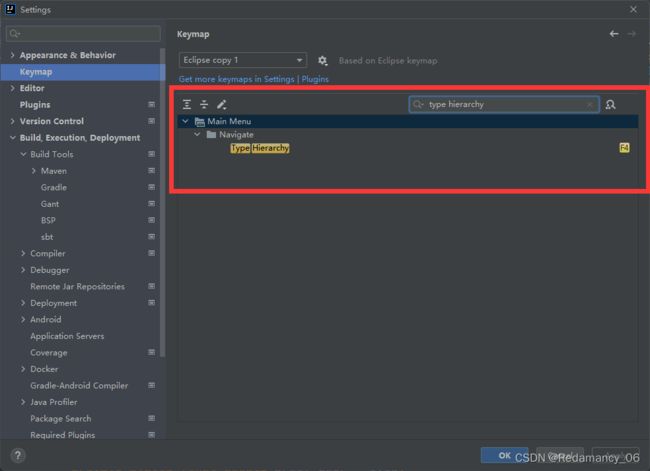

我是设置过的,参考的尚硅谷的java课程,有兴趣的可以看下我之前的博客,或者你在设置里面全部快捷键里搜一下type hierarchy

就可以知道你的快捷键是什么了

就可以知道你的快捷键是什么了

https://blog.csdn.net/Redamancy06/article/details/126134561

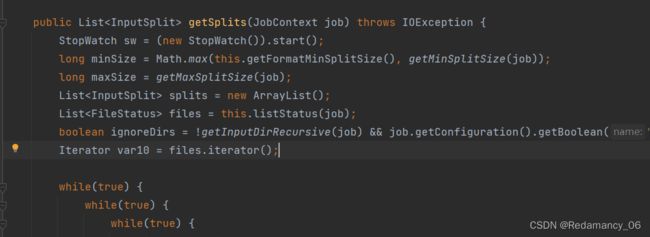

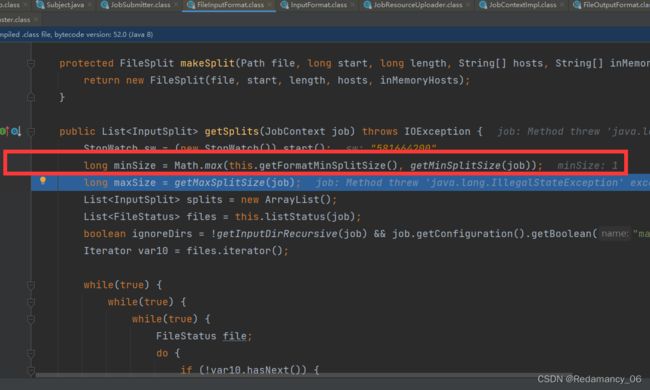

这里minSize获取的是1,1是怎么来的,可以看getFormatMinSplitSize这个和getMinSplitSize方法

这里minSize获取的是1,1是怎么来的,可以看getFormatMinSplitSize这个和getMinSplitSize方法

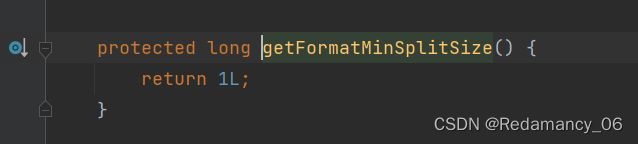

getFormatMinSplitSize方法他是返回的是1,

getFormatMinSplitSize方法他是返回的是1,

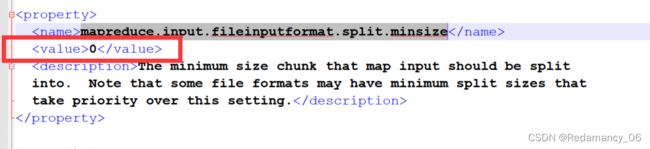

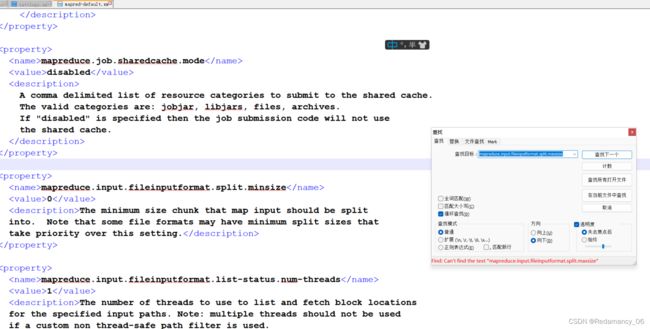

他这个值是由mapreduce.input.fileinputformat.split.minsize这个值来决定

他这个值是由mapreduce.input.fileinputformat.split.minsize这个值来决定

这个参数去mapred-default.xml里面找

<property>

<name>mapreduce.input.fileinputformat.split.minsize</name>

<value>0</value>

<description>The minimum size chunk that map input should be split

into. Note that some file formats may have minimum split sizes that

take priority over this setting.</description>

</property>

这里的值默认是0

所以minSize的值取1

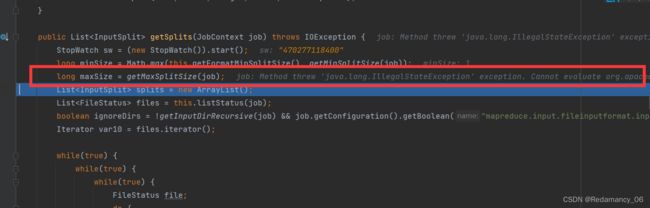

maxSize没有获取到,是为什么呢,进入getMaxSplitSize方法里面看看

他的值是由mapreduce.input.fileinputformat.split.maxsize这个值决定

他的值是由mapreduce.input.fileinputformat.split.maxsize这个值决定

在mapred-default.xml里面mapreduce.input.fileinputformat.split.maxsize是找不到的,如果找不到,则会返回long的最大值,

在mapred-default.xml里面mapreduce.input.fileinputformat.split.maxsize是找不到的,如果找不到,则会返回long的最大值,

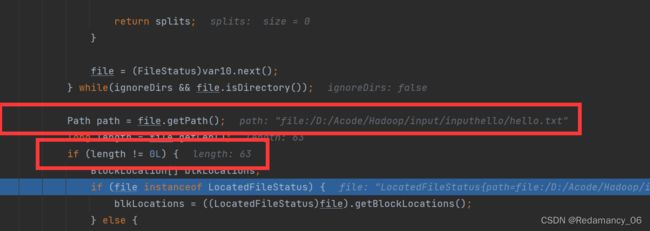

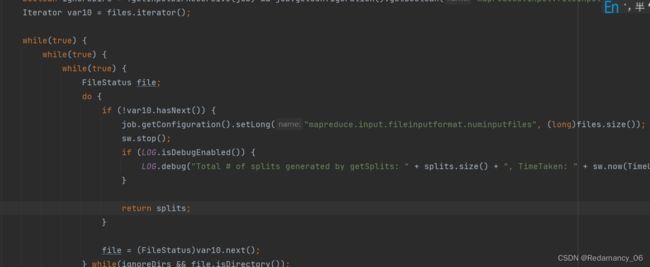

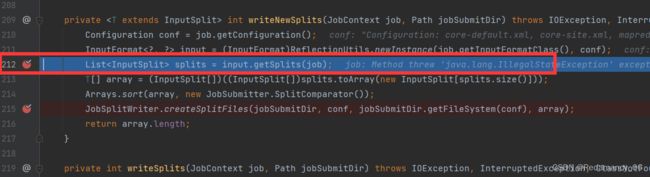

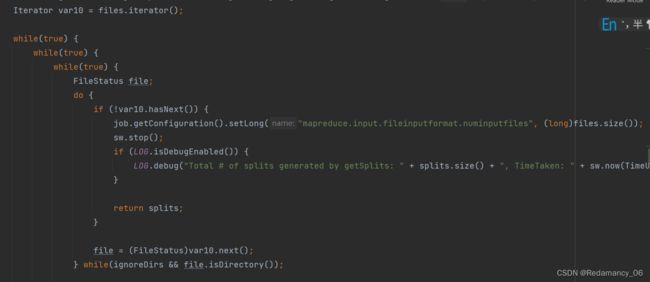

这里开始循环变量输入的个数,这里可以说明是一个文件一个文件的切片

这里开始循环变量输入的个数,这里可以说明是一个文件一个文件的切片

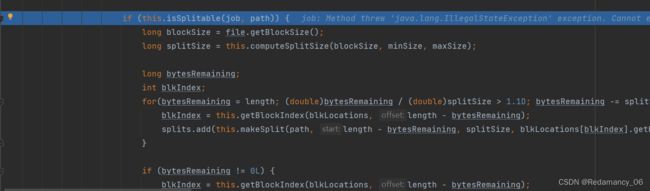

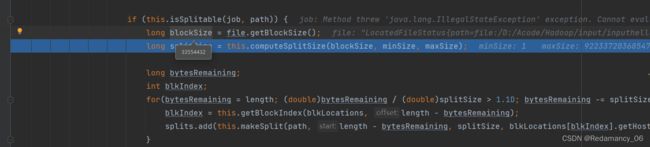

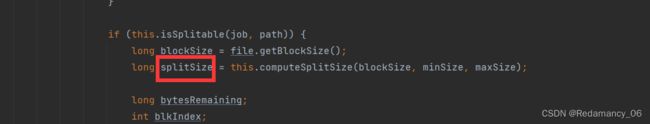

然后继续往下走到这里,isSplitable是检查是否支持切片,如果是压缩文件就不支持切片

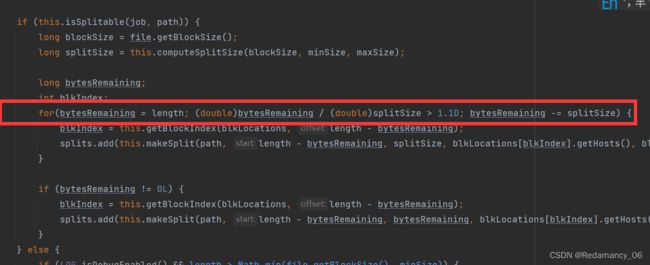

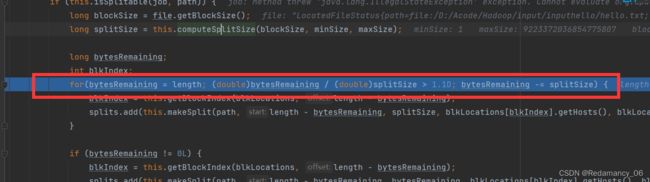

然后再往下走到这里,blockSize是块的大小为32m,因为是在本地,所以他是32m

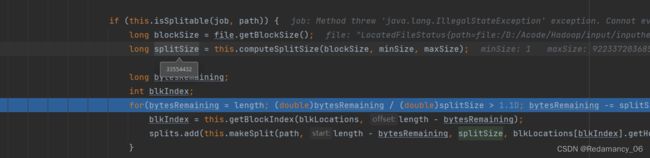

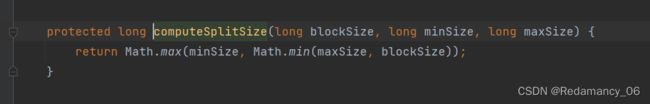

然后再往下走,splitSize是切片大小,他也是32m,是怎么来的,进入computeSplitSize方法看看

然后再往下走,splitSize是切片大小,他也是32m,是怎么来的,进入computeSplitSize方法看看

因为minSize为1,maxSize为long 的最大值,blockSize是32,所以切片的大小与minSize和maxSize有关,可以通过调整这两个的值来改变切片的大小

如果文件大小除以切片大小大于1.1则切成两片,如果小于1.1则按一片来处理

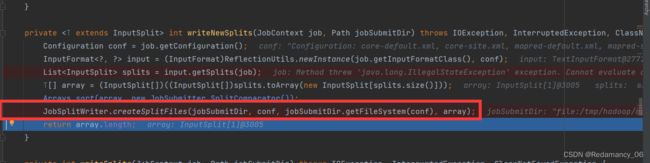

这行代码就是将切片信息存在本地

然后后面就是job提交源码的过程,有兴趣的可以看我之前写的博客https://blog.csdn.net/Redamancy06/article/details/126501627?spm=1001.2014.3001.5501

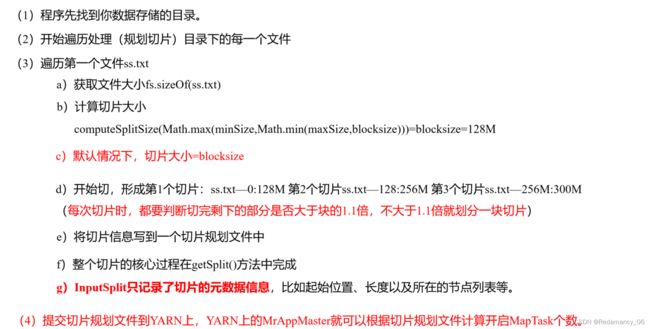

13.1.3.2切片源码详解

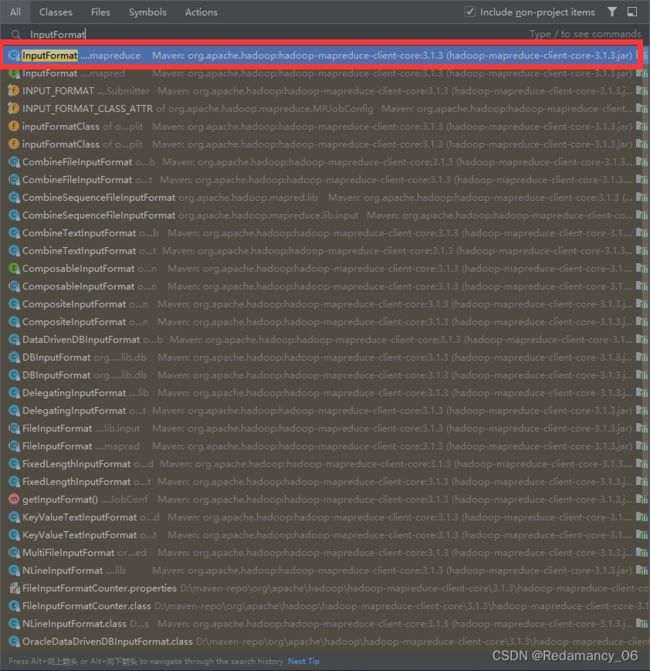

双shift打开查找文件,然后输入InputFormat

双shift打开查找文件,然后输入InputFormat

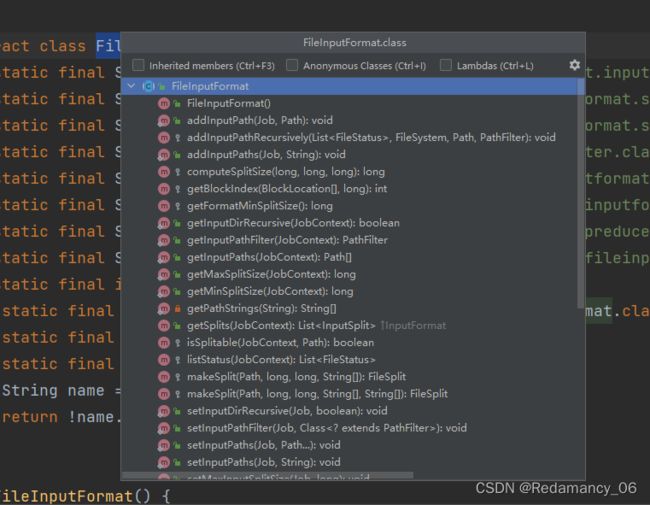

然后按f4打开这个进入FileInputFormat

然后ctrl+f3查看对应的方法

最主要关心的是getSplits这个方法

13.1.3.3总结,那些可以证明你看过切片的源码

还有这个,他的值取决于块大小,minSize,maxSize,但是块大小是不能改变的,因为他是实实在在存在物理地址的数据,因此块是不能改变的,但是minSize,和maxSize是可以改变的,可以通过改变这两个值来改变切片大小

还有这个,他的值取决于块大小,minSize,maxSize,但是块大小是不能改变的,因为他是实实在在存在物理地址的数据,因此块是不能改变的,但是minSize,和maxSize是可以改变的,可以通过改变这两个值来改变切片大小