文本识别综述 <软件学报_王建新等>

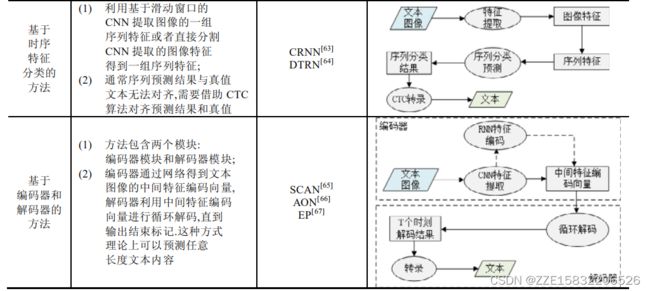

基于时序特征分类的方法

基于时序特征分类的方法首先利用卷积网络将图像转换为图像特征序列,然后采用循环神经网络或者卷积网络将图像特征序列识别为字符概率预测序列.鉴于图像特征序列长度和字符概率预测序列长度相同,预测结果和真值可能无法对齐导致模型无法计算损失函数和训练,该类方法中往往引入连接时序分(connectionist temporal classification,简称CTC)算法.CTC 算法首先定义预测结果到真值序列之间的转换方式,利用动态规划的思想从预测概率矩阵中得到多条状态转移路径,并将最大化所有路径概率和作为优化目标.

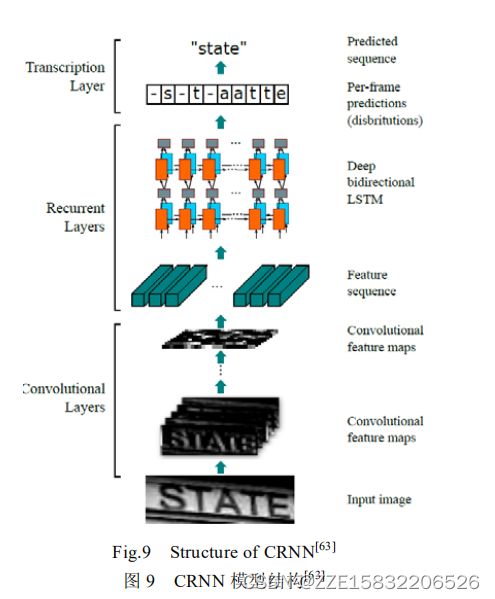

CRNN包含卷积层、循环层和转录层:卷积层从产生的图像特征中提取特性向量序列,循环层采用多层 BiLSTM 结构学习特征序列的双向依赖关系,并预测得到文本字符序列概率;转录层根据 CTC 算法定义的预测结果转换方式将预测的字符概率序列转录为文本.由于 RNN 能获得文本序列的上下文关系特征,使得该方法的识别性能优于基于朴素卷积神经网络的方法.

DTRN,通过宽高与图像的高度相同的滑动窗口将图像剪裁为一组子图像,并将子图像依次输入卷积网络中提取特征向量,然后得到与其对应的一组特征列.DTRN的卷积网络采用 MaxOut 激活方法,即将特征图分为固定组数,并将每组特征图中每个位置的最大值作为激活特征.最后,该网络模型将特征序列输入到循环网络中得到序列分类预测结果.该激活方法增强了模型的拟合能力,但增加了模型的参数量.

通常,基于时序特征分类的方法大都首先利用卷积网络提取图像序列特征.这些特征的空间不变性不利于预测具有时序依赖的文本序列,因此提出了基于注意力的文本识别网络模型,并将像素的坐标添加到卷积特征中增强特征的空间相关性,其注意力机制将图像特征和循环网络隐含层输出的时变偏移特征相结合得到空间注意力矩阵,循环网络当前时刻分类预测输入特征包含前一时刻的预测输出和前一时刻得到的空间注意力权重矩阵与图像特征的加权.该方法在具有挑战性的法国街道名称标志数据集上达到了较好的识别准确率.

基于编码器和解码器的方法

基于编码器和解码器的方法是一类将序转化为另一序列的算法框架,该类方法通过编码器将图像特征转换为固定长度的中间语义编码特征,解码器将中间语义编码特征解码为文本序列.这种识别方法可以训练预测任意的两个序列之间的对应关系,而且避免了时序特征分类识别方法中的序列对齐问题.但是由于其解码器的

输入特征仅依赖于的固定长度的中间语义编码特征向量,当输入序列较长时,编码器编码过程存在信息丢失的问题;其次,在解码器每个时刻的解码过程中,使用的中间语义特征是相同的,这都会给解码识别目标序列带来一定的困难.为了解决上述问题,该类方法通常引入注意力机制,使得编码器每个中间特征向量的权重不同.这 样,每个时刻的输入特征与当前预测输出具有时序上下文关系,更有利于得到准确的预测结果.

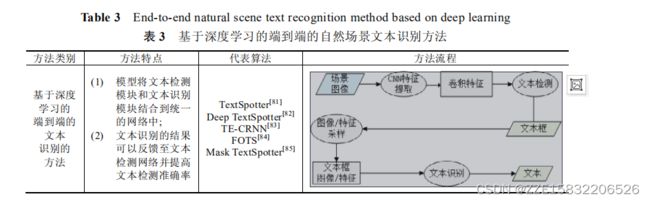

基于深度学习的端到端的自然场景文本识别方法

,大部分研究者将自然场景文本检测和识别分割为两个独立的任务,即首先利用检测网络得到图像中文本框,再将根据文本框得到剪裁的文本实例图像输入到文本识别网络识别文本内容.基于深度学习的端到端的自然场景文本识别方法将文本检测任务.和文本识别任务结合在统一的网络模型中.该类方法通常共享底层卷积特征,根据共享特征检测文本区域,再将文本区域共享特征馈送到识别模块中识别文本内容.相较于将文本检测和识别分割为不同任务的方法,端到端的识别方法更具有挑战性,其优点在于,共享底层特征的方式降低了文本检测到识别过程的运算参数,并且其文本识别损失根据反向传播算法能够优化底层特征的提取和文本检测.本节将对端到端的自然场景文本识别方法(见表3)的特点、关键技术和主要优缺点进行分析介绍.

通常,自然场景文本端到端的识别方法通常都需要先进行定位再识别文本.文献[86]提出了基于深度卷积网络的街景图像多位数字识别模型,该模型通过直接在图像像素矩阵上进行卷积操作获取图像特征,并通过全连接层输出预测值.该模型根据现实场景特点将图像中的数字长度分为 0~5 以及大于 5 共 7 种情况,并将图像

中的数字长度和对应长度的多位数字作为预测结果,最终选取数字长度概率和对应长度数字概率和最大

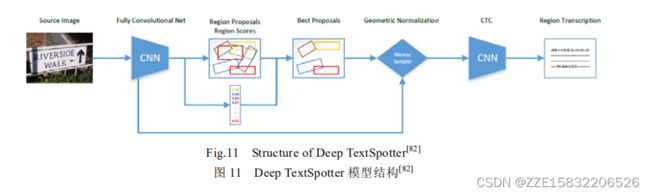

将文本检测和识别整合到端到端的场景文本识别网络中,如图 11 所示.该网络利用统一的神经网络训练学习文本检测和识别模块,其中,文本检测模块基于通用目标检测框架 YOLOv2[87],RPN 网络的预设文本候选框采用 k-means 算法从训练集上得到的不同比例大小矩形框;识别模块使用基于时序特征分类文本识别方

法对识别文本框内容,并且根据识别结果过滤错误的文本检测结果.为了提取不同倾斜角度的文本卷积特征,该模型用仿射变换和双线性采样代替 YOLOv2[87]的 ROI 池化方法.

大多数端到端的文本识别模型的训练数据标签包含文本框的位置信息和文本框的内容信息,对于需要大量训练数据的文本识别模型来说增加了手工标注的工作量.文献[90]提出一种半监督的端到端的文本识别模型,模型的训练数据标签仅包含一组文本内容标签,不使用任何标签来训练文本检测模块.该模型的文本检测模

块使用卷积网络和 BiLSTM 预测一组空间变换参数,根据变换参数和图像大小生成采样网格,再根据采样网格从原图中提取文本区域,文本检测模块使用采样得到的文本区域图像识别图像中的文本.虽然该方法的识别率不及其他方法,但为端到端的文本识别技术发展提供了新的思路.

端到端的文本识别性能评估

端到端的文本识别性能评估方式

通常,ICDAR 端到端的文本识别任务采用文献[4]中的评估方式,如果图像中某个检测框与真值框重叠超过阈值(一般为 50%)并且检测框中的单词识别正确,则该检测框文本识别成功;否则为识别失败.评估方式分为两类:end-to-end 和 word spotting,其中,end-to-end 表示检测并识别图像中的文本,word spotting 表示检测并识别词汇表单词(即将包含不合法字符的标注的真值单词视为无关项,该项识别结果不影响评估结果).与文本识别类似,端到端的文本识别任务提供 3 种不同的约束词汇表.

(1) Strong:每张图像的强语境词汇表(100 个单词),包括图像中的所有单词以及从训练或测试集的其余部分选择的干扰词.

(2) Weakly:包括训练和测试集中所有单词的弱语境词汇表.

(3) Generic:源自 Jaderberg 等人的数据集,大约 90K 单词的通用词汇表.

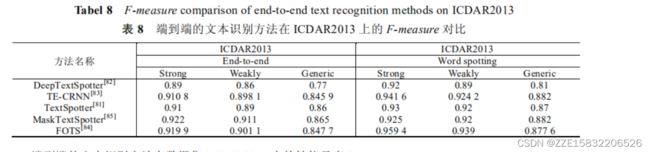

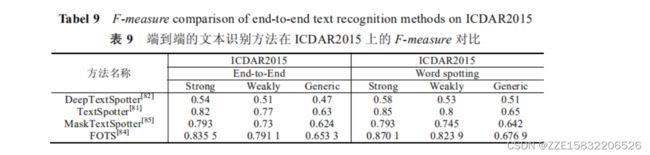

目前,大部分文本识别研究主要面向单独的文本检测和单独文本识别模型构建,涉及端到端的文本识别网络模型的构建研究并不多,本节介绍几种主要的端到端的文本识别方法在数据集 ICDAR2013 和 ICDAR2015上的识别性能.

端到端的文本识别方法分析对比

端到端的文本识别方法在数据集 ICDAR2013 上的性能见表 8,通用词典、弱语境词典和强语境词典约束条件的文本识别 F-measure 逐渐提高.由于 word spotting 评估方式将图像中包含非法字符的文本视为无关文本,使得 word spotting 评估方式的 F-measure 高于 end-to-end.Deep TextSpotter采用 RPN 和卷积特征时序分类识别图像文本内容在 end-to-end 和 word spotting 评估方式的强语境约束条件下的 F-measure 分别达到了 0.89 和0.92.TE-CRNN]采用 Faster-RCNN 以及基于 LSTM 的编码器和解码器识别文本内容,该方法在数据集ICDAR2013 上的不同评估方法和约束条件的识别 F-measure 均高DeepTextSpotter.TextSpotter使用ESAT模块检测文本框并在解码器增加了注意力对齐和增强,其 F-measure 在数据集 ICDAR2013 上与 TE-CRNN相近.Mask TextSpotter方法在数据集 ICDAR2013 上 end-to-end 评估方式的 F-measure 达到了 0.922, 0.911 和 0.865,该方法基于字符实例概率图的识别方式在数据集 ICDAR2013 上仅 word spotting 评估方式的强语境约束的 F-measure 低于其他方法.FOTS基于ESAT和时序特征分类的识别模型在 ICDAR2013 上的F-measure 与 TE-CRNN相当,其中 word spotting 评估方式的强语境和弱语境约束的 F-measure 高于其他方法.