云计算OpenStack详解

一、OpenStack简介

1、OpenStack发展历程

2002年,美国著名的电商公司亚⻢逊(Amazon)干了一件“不务正业”的事。他们向客户推出了一项全新的业务——包括存储空间、计算能力等资源服务的Web Service。这就是大名鼎鼎的AWS(Amazon Web Service)。

说白了,这个Web Service服务,就是为大家提供“远程电脑”。你可以远程控制它,有硬盘,有CPU,有内存啥的。你在上⾯配置你的各种服务,然后给你的用户使用,例如网站、FTP等。

这个就是云计算的一种早期形式。

后来,到了2006年,亚马逊又推出了弹性计算云(Elastic Compute Cloud),也称EC2 。

EC2配置界面更简单,使用起来更方便,关键一点,它开始有了“弹性”!

同样是2006年,8月9日,Google首席执行官艾瑞克·愛默⽣·施密特(英語:Eric Emerson Schmidt),2001年到2011年十年间在Google担任CEO,也曾是苹果公司董事会成员。它在搜索引擎大会上首次提出“云计算” (Cloud Computing)的概念。从此,云计算进入了高速发展阶段。

到了2010年,当时有一家名叫Rackspace的公司,他们一直在做和亚马逊一样的云主机和云储存服务,但是始终都干不过亚马逊,排名第二。他们一气之下,干脆就把它们的云储存服务给开源了。

和rackspace一起开放源代码的,还有一个家伙,就是——NASA。

NASA之前在云计算方面投入了大量的资金,但是后来发现这玩意好像是个无底洞,太烧钱了。而且,他们也似乎意识到这不是他们该干的事。所以,NASA和Rackspace一起,选择开放源代码。

其实还有一个原因∶以前NASA是使用Eucalyptus云计算管理平台,不过这个平台分成两个版本,一个开源的版本,一个收费的版本。这就导致NASA很不爽,向Eucalyptus贡献代码,结果Eucalyptus认为这个代码和收费版本冲突,不接受。NASA给气得不行,所以选择了将代码开源。

Rackspace和NASA并不是简单地代码一丢完事,而是联手共同成立了一个开源项目。这个项目,就是OpenStack。

OpenStack 是在 2010年由托管服务器及云计算提供商 RackSpace 和美国航天航空局NASA 共同发起的开源项目,愿景是为数据中心建立一套云操作系统,大幅提升数据中心的运营效率。其旨在为公有云和私有云的建设与管理提供软件开源项目,社区拥有超过170 家企业及3000位开发者,这些机构与个人都将OpenStack作为基础设施即服务(IaaS)的解决方案。

下表是OpenStack已经发布的版本信息及使用状态:

2、OpenStack架构

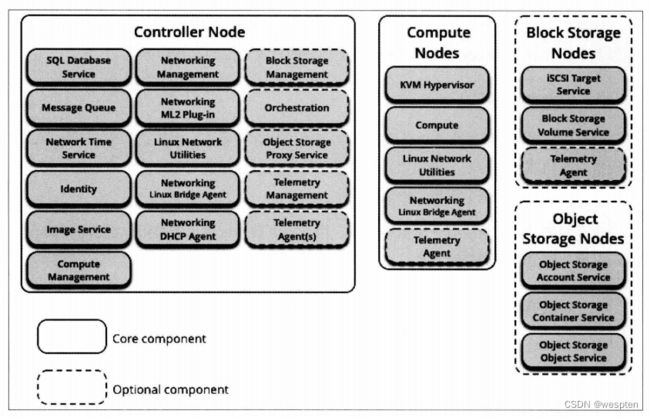

OpenStack组件:

![]()

OpenStack 项目通过一系列相互关联的内部服务组件提供了基础设施即服务(Infrastructure as a Service,IaaS)的解决方案,每个内部服务组件都提供了有利于集成的应用程序接口(API)。根据实际需要,可以选择安装某几个或全部服务组件。

OpenStack项目各服务组件功能:

● Keystone 为各服务组件提供用户认证和权限验证功能。

● Ceilometer为各服务组件提供监控、检索和计量功能。

● Horizon为用户操作 OpenStack 项目中的各服务组件提供基于Web形式的图形界面。

● Glance为虚拟机实例提供镜像服务,同时,Glance服务中的镜像介质存放在Swift中。

● Neutron为虚拟机实例提供网络连接服务,同时也为Ironic提供PXE网络。

● Ironic 提供物理机的添加、删除、电源管理和安装部署等功能。

● Nova为虚拟机实例提供计算资源。

● Trove为虚拟机镜像提供注册服务;使用Nova启动数据库实例;依附虚拟机实例,

提供数据存储、操作和管理;可以备份数据库实例到Swift中。

● Cinder为虚拟机实例提供块设备,同时备份块设备数据到Swift中。

● Sahara 通过Heat 编排集群配置;在 Swift中保存数据或二进制文件;将任务分派给虚拟机实例处理;通过Nova运行数据处理实例;在Glance中注册Hadoop镜像。

● Heat可以编排Cinder、Neutron、Glance和Nova各种资源。

OpenStack组件描述:

| 服务 | 项目名称 | 描述 |

|---|---|---|

| Dashboard (仪表盘) |

Horizon | 提供了一个基于web的自服务门户,与OpenStack底层服务交互,诸如启动一个实例,分配IP地址以及配置访问控制。 |

| Compute (计算) |

Nova | 在OpenStack环境中计算实例的生命周期管理。按需响应包括生成、调度、回收虚拟机等操作。 |

| Networking (网络) |

Neutron | 确保为其它OpenStack服务提供网络连接即服务,比如OpenStack计算。为用户提供API定义网络和使用。基于插件的架构其支持众多的网络提供商和技术。 |

| Object Storage (对象存储) |

Swift | 通过一个 RESTful,基于HTTP的应用程序接口存储和任意检索的非结构化数据对象。它拥有高容错机制,基于数据复制和可扩展架构。它的实现并像是一个文件服务器需要挂载目录。在此种方式下,它写入对象和文件到多个硬盘中,以确保数据是在集群内跨服务器的多份复制。 |

| Block Storage (块存储) |

Cinder | 为运行实例而提供的持久性块存储。它的可插拔驱动架构的功能有助于创建和管理块存储设备。 |

| Identity Service (认证) |

Keystone | 为其他OpenStack服务提供认证和授权服务,为所有的OpenStack服务提供一个端点目录。 |

| Image Service (镜像) |

Glance | 存储和检索虚拟机磁盘镜像,OpenStack计算会在实例部署时使用此服务。 |

| Telemetry (计量) |

Ceilometer | 为OpenStack云的计费、基准、扩展性以及统计等目的提供监测和计量。 |

| Orchestration (编排) |

Heat | Heat编排服务组件提供基于模板的服务,它集成OpenStack项目中的许多核心服务组件于一个模板中,使用这个模板可以创建许多类型的资源,如虚拟机实例、Floating IPs、卷设备、安全组和用户等。 |

| Database (数据库) |

Trove |

提供高稳定性和可扩展的关系型或非关系型数据库服务。 |

| Data Processing Service (数据分析) |

Sahara |

通过配置相关参数,如 Hadoop 版本、拓扑和硬件配置,提供和扩展OpenStack项目中Hadoop集群的能力。 |

OpenStack架构:

OpenStack 逻辑架构:

Openstack各个组件之间的调度:

第一步:使用用户名和密码(凭据)提交给horizon,horizon将凭据送到keystone,问用户是否有使用自己(horizon)的权限,keystone查找自己的数据库,判断凭据是否在数据库中,发现用户的凭据在数据库中,那么就会根据用户的凭据做成2个令牌,自己留一个,然后给horizon一个。令牌代表了用户有什么样的权限,有调用什么组件的权利。horizon收到了令牌后,通过令牌判断出用户有使用自己的权限,则登录成功。

第二步∶用户想查看glance里面的镜像,决定自己创建什么类型的虚拟机。用户命令horizon显示glance里面有什么镜像。horizon通过令牌判断出用户具有查看glance的权限。所以呢,就请求glance提供镜像信息。

二、Nova计算服务

OpenStack 项目中的Nova计算服务组件是非常重要、核心的部分,负责承载和管理云计算系统,与其他组件有密切联系。例如,与Keystone身份认证服务组件完成服务认证,与Glance镜像服务组件协作生成虚拟机实例,在Horizon仪表板服务组件上完成操作等。Nova计算服务组件支持使用标准的x86硬件进行横向扩展。

Nova计算服务组件包括以下部分:

● nova-api service∶负责对终端用户调用Compute API的接收和反馈。支持OpenStack Compute API、the Amazon EC2 API和其他的 Admin API,运行策略和编排活动。

● nova-api-metadata service∶ 负责接收虚拟机实例对metadata(元数据)的访问请求。一般部署 nova-network的多主机模式才会使用 nova-api-metadata service。

● nova-compute service∶该服务通过 Hypervisor APIs 创建和终止虚拟机实例。

Hypervisor APIs 包括 XenAPI for XenServer/XCP、Libvirt for KVM or QEMU 和VMwareAPI for VMware。该服务接收消息队列中的信息,执行一系列操作命令,如创建和更新虚拟机实例状态,过程极其复杂。

● nova-scheduler service∶该服务接收消息队列中的请求,从而决定虚拟机实例运行在哪个计算节点上。

● nova-conductor module∶该服务部署支持横向扩展。出于安全考虑,其不能和nova-compute service 部署在同一节点上。因为nova-compute service不能直接访问数据库,所以需要nova-conductor module 置于它们中间,与它们交互、通信,传递信息。

● nova-cert module∶该服务是一个守护进程,用于 X509 证书的认证服务,通常为euca-bundle-image(打包好将要上传的镜像)生成证书。仅EC2API需要此module。

● nova-network worker daemon∶类似于 nova-compute service,从消息队列中接收和处理关于网络的请求,如配置桥接网络端口、修改防火墙规则等。

● nova-consoleauth daemon∶该进程必须和控制台管理程序(novncproxy、spicehtml 5proxy、xvpvncproxy)共同使用,起安全作用。

● nova-novncproxy daemon∶通过VNC连接OpenStack环境中正在运行的虚拟机实例。无须安装VNC客户端,可以使用浏览器访问。

● nova-spicehtml5proxy daemon∶通过SPICE连接OpenStack环境中正在运行的虚拟机实例。需要使用HTML5访问。

● nova-xvpvncproxy daemon∶通过VNC连接OpenStack环境中正在运行的虚拟机实例。使用OpenStack指定的Java客户端访问。

● nova-cert daemon∶ X509证书。

● euca2ools client∶用于管理Amazon EC2云资源,不属于OpenStack项目。

● nova client∶用户通过 nova client 提交请求,包括管理员和非管理员。

● The queue∶用于进程和服务间传输信息。支持RabbitMQ、Apache Qpid和ZeroMQ,RabbitMQ使用频率较高。

● SQL database∶用于存储各种信息。只要是Python编程语言支持的数据库,Nova计算服务组件都可以使用。比较常见的数据库包括SQLite3、MySQL和PostgreSQL,MySQL使用频率较高。

1、架构设计

Nova计算服务组件使用基于消息、无共享、松耦合、无状态的架构。OpenStack 项目中的核心服务组件都运行在多台主机节点上,包括Nova、Cinder、Neutron、Swift和Glance 等服务组件,状态信息都存储在数据库中。控制节点服务通过HTTP与内部服务进行交互,但与Scheduler服务、网络和卷服务的通信依赖高级消息队列协议进行。为避免消息阻塞而造成长时间等待响应,Nova计算服务组件采用异步调用的机制,当请求被接收后,响应即被触发,发送回执,而不关注该请求是否被完成。

请求一个虚拟机实例过程:

![]()

OpenStack 项目中的控制节点服务影响着整个云环境的状态,API服务器为控制节点服务扮演着Web服务的前端,处理各种交互信息。计算节点提供各种计算资源和计算服务。Nova计算服务组件中的网络服务提供虚拟网络,使实例能够彼此访问和访问公共网络,当然也可以使用 Neutron 网络服务组件代替该功能。目前 Nova 计算服务组件中的网络模块nova-network 已经过时,代码已经不再更新,强烈建议使用 Neutron 网络服务组件。Scheduler服务的功能是选择最合适的计算节点运行虚拟机实例。

2、虚拟化技术

Nova计算服务组件通过API服务器控制虚拟机管理程序。基于预算控制、资源限制、支持特性和所需技术要求等因素,我们需要选择一个最佳的虚拟化技术。根据目前OpenStack的发展情况,大部分Nova计算服务组件采用的是KVM和Xen虚拟化技术。

Nova支持的虚拟化平台:

Nova计算服务组件具备一个抽象层,其允许在部署时选择一种虚拟化技术。现实情况是,每种虚拟化技术的支持和特性是不同的,测试完整度也不相同,并非全部支持相同的特性。以下从测试完整度和功能多样性两方面详细阐述每种虚拟化技术所支持的特性。

1. 测试特性

1)虚拟化技术一测试范围

● 测试范围∶

- 单元模块化测试。

- 功能性测试。

● 虚拟化技术一∶QEMU/KVM。

2)虚拟化技术二测试范围

● 测试范围∶

- 单元模块化测试。

- 外部组织进行功能性测试。

● 虚拟化技术二∶

- Hyper-V。

- VMware。

- XenServer。

- 基于Libvirt的Xen。

3)虚拟化技术三测试范围

截至Icehouse版本,该组中的虚拟化技术已经过期,不再更新。这些都没有经过充分的测试,使用它们存在一定的风险。

● 测试范围∶

- 单元模块化不完全测试。

- 未公开的功能性测试。

● 虚拟化技术三∶

- Baremetal(裸金属)。

- Docker(容器技术)。

- 基于Libvirt的LXC。

2. 虚拟化技术支持功能特性

以下基于虚拟化技术支持特性帮助用户选择合适的方案∶

● 从OpenStack发展轨迹观察,KVM是最通用的虚拟化技术,在社区中可以找到许多错误的解决方案。KVM和QEMU支持OpenStack的所有特性。

● 由于Microsoft Hyper-V是免费的,因而得到很多支持。VMware ESXi由于部分免费,也得到一些支持,但是没有vCenter和企业级License,一些API的使用是受限的。

● Xen技术分类较多,包含以下几种。

- XenServer∶开源,但是有Citrix的商业支持。

- Xen Cloud Platform(XCP)∶开源版本,等同于XenServer。XenServer支持的特性,

- XCP全部支持。

- XenAPI∶管理XenServer和XCP的API程序。

- XAPI∶XenServer和XCP的主守护进程,与XenAPI直接通信。

- 基于Libvirt的Xen∶Xen 虚拟化技术使用Libvirt驱动。

通过XenAPI,Nova计算服务组件支持XenServer和XCP两种虚拟化技术。但是这并不意味着支持所有基于Xen的平台,如运行SUSE和RHEL的平台,它们都是基于Libvirt 虚拟化层的Xen虚拟化技术。

● 对于Baremetal而言,技术已经过期,不再更新,Baremetal驱动也不再更新。新的特性会被更新到Ironic中,由Ironic代替Baremetal。

下面对目前主流的两种虚拟化技术KVM和Xen进行详细介绍。

3、KVM 虚拟化技术

KVM(Kernel-based Virtual Machine)是基于x86硬件虚拟化扩展(Intel VT或AMD-V)的全虚拟化解决方案,它包含一个可加载的内核模块kvm.ko,提供核心的虚拟化基础架构,还有一个处理器特定模块kvm-intel.ko或kvm-amd.ko。

全虚拟化解决方案∶虚拟机与底层硬件之间由一个虚拟化逻辑层Hypervisor来完全模拟底层硬件,上层虚拟机完全感知不到运行在虚拟硬件上。优点是虚拟机操作系统内核不需要进行特殊配置,部署便捷、灵活、兼容性好。缺点是虚拟机操作系统的内核不能直接管理底层硬件,内核通过Hypervisor管理底层硬件,有转换性能开销。

半虚拟化解决方案∶虚拟机操作系统内核需要经过修改,与宿主机操作系统内核共享底层硬件实现。优点是半虚拟化的虚拟机操作系统内核能够直接管理底层硬件,性能表现比全虚拟化技术更好。缺点是虚拟机操作系统内核需要事先进行修改,部署的便捷性、灵活性和兼容性差。

KVM允许在一台主机节点上运行多个未经改动的虚拟镜像,包括Windows和Linux。每台虚拟机都有独立的虚拟硬件,包括网卡、磁盘等。

KVM是一个开源项目,其核心组件包含在Linux更新主线中(从Linux 内核2.6.20版本开始),用户空间组件包含在QEMU更新主线中(从QEMU1.3版本开始)。

KVM是在CPU硬件支持基础之上的虚拟化技术,同Hyper-V、Xen一样依赖此项技术。没有CPU硬件虚拟化的支持,KVM是无法工作的。

KVM是Linux的一个模块,可以用modprobe加载KVM模块。只有在加载模块后,才能进一步通过其他工具创建虚拟机。但仅有 KVM 模块是远远不够的,因为用户无法直接控制内核模块去做事情,必须有一个用户空间的工具才行,这个用户空间的工具就是开源虚拟化软件QEMU。QEMU也是一个虚拟化软件,其特点是可虚拟不同的硬件,比如在x86的CPU上可虚拟一个安腾的CPU,并可利用它编译出可运行在安腾上的程序。KVM 使用了QEMU的一部分,并稍加改造,就变成了可控制KVM的用户空间工具。仔细观察,发现官方提供的KVM下载有两大部分三个文件,分别是KVM模块、QEMU工具及二者的合集。也就是说,可以只升级KVM模块,也可以只升级QEMU工具。

一个普通的Linux进程有两种运行模式∶内核模式和用户模式。但KVM拥有3种模式,分别是内核模式、用户模式和客户模式。在KVM模型中,每个虚拟主机都是由Linux 调度程序管理的标准进程,该进程调用 KVM 用户模式,执行应用程序。对于应用程序而言,用户模式是默认模式,当需要一些来自内核的服务时便切换到内核模式,如在磁盘上写入数据时。客户模式进程运行在虚拟机内,拥有自己的内核和用户空间变量,在客户模式下可以使用正常的kill和ps命令,KVM虚拟机表现为一个正常的进程,可以像其他进程一样被杀掉。KVM利用硬件虚拟技术模拟处理器的形态,虚拟机的内存管理由内核直接处理。内核模式在需要的时候,向QEMU进程发送信号处理大部分的硬件仿真。KVM管理CPU和内存的访问调用,QEMU仿真硬件资源(如硬盘、网卡、声卡等)。当QEMU单独运行时,也可以同时模拟CPU和硬件。

KVM的API是通过/dev/kvm设备访问的,/dev/kvm是一个标准的字符设备,可以使用常用的 open、close、ioctl接口操作,但是在KVM的实现中,没有提供 read和 write 接口,所有对KVM的操作都是通过ioctl接口操作的。KVM提供给上层的API功能可分为3 种类型。

(1)system 指令∶针对虚拟化系统的全局性参数进行设置和控制,包括全局性的参数设置和虚拟机创建等工作,主要指令如下表所示。

其中,KVM_CREATE_VM比较重要,用于创建虚拟机,并返回一个代表该虚拟机的文件描述符(fd)。新创建的虚拟机没有虚拟CPU,也没有内存等资源,需要对新创建虚拟机时返回的文件描述符使用ioctl指令进行下一步的配置,生成虚拟CPU和内存等资源。

(2)VM指令∶针对虚拟机进行控制,大部分需要针对从KVM_CREATE_VM中返回的文件描述符(fd)进行操作,包括配置内存、配置虚拟CPU、运行虚拟主机等,主要指令如下表所示。

KVM_CREATE_VCPU和KVM_RUN是VM ioctl指令中两种重要的指令,通过KVM_CREATE_VCPU为虚拟机创建虚拟CPU,并获得对应的fd文件描述符后,可以对其调用KVM_RUN,以启动该虚拟机(或称为调度虚拟CPU)。

KVM_RUN结构体定义在include /linux/kvm.h中,可以通过该结构体了解KVM的内部运行状态。

(3)VCPU指令∶针对具体的虚拟CPU进行参数设置,包括寄存器读/写、中断设置、内存设置、时钟管理、调试开关等。KVM虚拟机运行时也可以进行相关设置。主要指令如下。

● 寄存器控制方面的主要指令如下表所示。

● 中断和事件管理方面的主要指令如下表所示。

● 内存管理方面主要指令如下表所示。

●其他方面的主要指令包括CPUID设置、调试接口等。

对于KVM的操作都是从打开 /dev/kvm 设备文件开始的,打开后,会获得相应的文件描述符(fd),然后通过ioctl系统指令对该fd进行进一步的操作,如通过KVM_CREATE_VM 指令可以创建一个虚拟机并返回虚拟机对应的文件描述符,接着根据该描述符来进一步控制虚拟机的行为,如通过KVM_CREATE_VCPU指令来为该虚拟机创建VCPU。

下面通过图示介绍KVM的初始化过程:

1. 加载模块

加载KVM和SVM或VMX。成功加载后,生成/dev/kvm文件供用户空间访问,如下图所示。

2. 调用/dev/kvm

/dev/kvm 既不可读也不可写。

/dev/kvm拥有ioctl接口,如下图所示。

3. 调用kvm ioctl()

调用KVM_GET_API_VERSION进行版本检查。

调用KVM_CREATE_VM创建一个虚拟主机,并返回一个kvm-vm文件描述符,如下图所示。

4. 调用kvm和kvm-vm ioctl()

在kvm 文件描述符上调用KVM_CHECK_EXTENSIONS(检查扩展支持情况)。在kvm-vm文件描述符上调用KVM_SET_TSS_ADDR(在Intel架构中初始化TSS内存区域)设置TSS地址,如下图所示。

5. 调用kvm和kvm-vm ioctl()

在kvm 文件描述符上调用KVM_CHECK_EXTENSIONS(检查扩展支持情况)。在kvm-vm 文件描述符上设置KVM_SET_MEMORY_REGION(修改虚拟CPU的内存区域),如下图所示。

6. 调用kvm和kvm-vm ioctl()

在kvm文件描述符上调用KVM_CHECK_EXTENSIONS(检查扩展支持情况)。在kvm-vm文件描述符上调用KVM_CREATE_IRQCHIP(创建虚拟APIC并将虚拟CPU 关联到APIC)设置 irqchip,如下图所示。"

7. 创建虚拟CPU

在kvm文件描述符上调用KVM_CREATE_VCPU。执行后,返回kvm-vcpu文件描述符,如下图所示。

![]()

KVM/QEMU的内存管理非常有趣,因为KVM/QEMU运行就像Linux系统中的一个程序运行,所以它分配内存是调用malloc()和mmap()函数进行的。当一个虚拟机申请1GB 的物理内存时,KVM/QEMU会执行malloc(1<<30)操作,从宿主机上分配1GB的虚拟地址空间。所以它只调用 malloc()函数,并没有进行实际的物理内存分配;而是当虚拟机第一次启动需要访问内存时,才会给虚拟机分配真正的物理内存。虚拟机操作系统启动运行,它可以识别通过 malloc()函数分配的物理内存,接下来操作系统 Kernel 开始访问已识别的物理内存地址,这时KVM/QEMU进程会访问已识别的第一个内存页。

KVM/QEMU 虚拟机的任何内存变动都会关联底层宿主机的变化,宿主机会确认该虚拟机变化在其整个内存分页表中是否有效、可用,不允许其访问任何不属于它的内存页。此内存运行访问机制有两种。

● 第一种是影子分页表技术。虚拟机所使用的内存分页表与实际的内存分页表是独立的,不是同一张分页表。当虚拟机修改自己的内存分页表时,宿主机会检测到有修改动作发生,然后进行确认,之后才会修改真正的分区表,使由虚拟机发起的修改

操作生效。虚拟机不能直接访问真正的内存分页表,而是访问影子分页表。这是一种非常普通的虚拟化内存技术。

● 第二种是VMX/AMD-V扩展技术。VMX/AMD-V扩展技术允许底层宿主机始终监控,以此获得虚拟机修改真正内存分页表的信息。这种内存运行访问机制实际且有效,但是它对性能有一些影响,完成一次访问最高可能消耗25页内存,代价非常大。造成这种问题的原因是每次内存访问需要两次操作才能完成,包括虚拟机内存分页表访问和宿主机内存分页表访问。当然,宿主机运行和维护影子分页表也需要消耗大量资源。

AMD和Intel厂商为了解决这些性能损耗问题,开发了两种全新的技术EPT和NPT。这两种技术很相似,都使硬件重新识别架构,快速地将虚拟机内存变化直接传递给宿主机的物理内存,而不用再去访问宿主机内存分页表,减少一次操作,效率更高。

但由此带来的问题就是宿主机的内存分页表像进程隔离一样会被强制执行,当一个内存页在宿主机内标记为没有被分配时,实际上该内存页可能已经被虚拟机占有了,所以必须与EPT/NPT共同协商处理这个变化。

为了解决该问题,可以在软件层面通过调用 mmu_notifiers()函数解决此问题,因为KVM/QEMU的内存本来就是正常的物理内存,Kernel可以像交换、替换和释放正常的物理内存一样处理这些内存页。

在虚拟机释放内存页给宿主机前,需要等待宿主机的通知。当KVM/QEMU虚拟主机在影子分页表或EPT/NPT中删除该内存页后,宿主机便可以自由地使用该内存页。

关于内存的申请与回收,可以总结为以下几个步骤。

(1)内存申请

① QEMU调用malloc( )函数为虚拟机分配虚拟内存页,但是此时并没有申请真正的物理内存。

② 虚拟机开始访问该虚拟内存页,并且认为该虚拟内存页是真正的物理内存页,但是由于该内存页没有被真正分配,所以开始向宿主机申请。

③ 宿主机内核发现有一个内存页错误,便会在已经被分配的malloc( )'d 区域调用do_page_fault( )函数。如果一切顺利,没有打断,则宿主机开始响应虚拟机的操作。

④ 宿主机内核创建 pte_t,使 malloc( )d 虚拟地址连接到真正的物理内存地址,生成rmap,并把它们放到LRU中。

⑤ 此时,mmu_notifier_change_pte( )被调用,其允许KVM为该内存页创建NPT/EPT。

⑥ 宿主机从该错误的内存页中返回标识,虚拟机得到内存后执行操作恢复。

(2)内存回收

① 宿主机内核利用 rmap 结构寻找到需回收的内存页被映射到哪个 VMA(vm_area_struct)。

② 宿主机内核查找该VMA所关联的mm_struct,并遍历宿主机的内存分页表,查找到该内存页在物理硬件上的位置。

③ 宿主机内核替换出该内存页并清空pte_t。

④ 宿主机内核接着调用mmu_notifier invalidate_pageO函数,在NPT/EPT中查找到该页并删除。

⑤ 现在,该页已经被释放,任何需要该页的访问都可以向宿主机申请(此时,可以转换到内存申请的第二步)。

4、Xen 虚拟化技术

Xen是一种开源的、属于类型1(裸金属虚拟化,Baremetal Hypervisor)的虚拟化技术,它使多个同样操作系统或不同操作系统的虚拟机运行在同一个物理主机节点上成为可能并实现。Xen是唯一的属于类型1(裸金属虚拟化,Baremetal Hypervisor)并且开源的虚拟化技术,它被作为商业应用或开源应用的基础而加以使用,如服务器虚拟化、Infrastructure as a Service(laaS)、桌面虚拟化、安全应用、嵌入式和硬件设备等。由于它性能稳定,因而被广泛用于云计算生产环境。

以下是Xen虚拟化技术的一些关键特性:

● 轻便小型的设计(核心代码有1MB左右)。它使用了微小内核设计,占用极少内存,加上有限的接口设计,使得它比其他虚拟化技术更健壮、更安全。

● 操作系统无关性。Domain0一般安装在Linux操作系统中,也可以使用其他操作系统代替,如NetBSD和OpenSolaris等。

● 驱动分离。Xen 虚拟化技术允许主要的硬件设备驱动运行于虚拟机内部,当驱动出现 crash(宕机)或者报错时,包含该驱动的虚拟机可以重启,该驱动也可以重启,这样不会影响其他的虚拟机。

● 半虚拟化技术。运行在半虚拟化技术上的虚拟机已经经过优化,它们可以运行得更加流畅,比运行在需要硬件扩展支持的全虚拟化管理程序(HVM)上的虚拟机更快。当然,Xen可以运行在不支持硬件扩展的硬件平台上。

Xen虚拟化技术架构包含3个关键点,掌握这3个关键点对于用户理解和做出正确的选择至关重要。

● 类型∶Xen虚拟机技术支持半虚拟化(Para-Virtualization,PV)和全虚拟化(Hardware assisted Virtualization,HVM)两种类型。

● Domain0∶Xen虚拟化架构中包含一个特殊的域 Domain0,其包括硬件设备驱动和控制虚拟机的Toolstack。

● Toolstacks∶其涵盖各种不同的Toolstack。

类型1(裸金属虚拟化,Baremetal Hypervisor)∶该类型的虚拟化技术直接运行在物理主机节点硬件设备上,并且管理虚拟机操作系统,如下图所示。第一个此类型的虚拟化技术是在1960年由IBM发布的,它包括一个测试软件SIMMON和CP/CMS操作系统(IBM的z/VM操作系统的前身)。

目前比较流行的产品或技术包括Oracle VM Server for SPARC、Oracle VM Server for x86、Citrix XenServer、Microsoft Hyper-V和VMware ESX/ESXi。

类型2(可托管的虚拟化,Hosted Hypervisor)∶该类型的虚拟化技术允许运行在普通的操作系统上,和普通的计算机程序类似,如下图所示。一个运行的虚拟机作为一个进程存在于物理主机节点的操作系统中。目前比较流行的产品或技术包括VMware Workstation、VMware Player、VirtualBox和QEMU。

尽管对虚拟化技术的架构进行了分类,并且划分了类型1和类型2,但是在实际运用和当今IT技术发展中,它们彼此之间并没有如此严格的分类。Linux的Kernel-based Virtual Machine (KVM)和FreeBSD的BHyVe是基于内核的虚拟化技术,利用该基于内核的虚拟化技术将传统的操作系统转化成类型1的虚拟化管理程序,与此同时,Linux 发行版和FreeBSD仍然是通用的操作系统,与其他应用一起竞相争夺虚拟机操作系统可以使用的资源。所以据此分析,KVM和BHyVe虚拟化技术属于类型2的虚拟化技术架构。

1. Xen架构

Xen 虚拟化管理程序直接运行在硬件之上,处理各种CPU、内存和中断请求。在包含虚拟化管理程序的操作系统启动过程中,BootLoader加载完成并退出后,加载的第一个程序就是Xen,在其上运行着虚拟机。运行的虚拟机叫作Domain(域)或客户机(Guest),其中有一个特殊的 Domain 叫作 Domain0,其包含了所有硬件设备的驱动。Domain0 还包含了控制栈(Toolstack),用于虚拟机创建、删除和配置等。下图是Xen虚拟化管理程序的架构。

在Xen架构中包含以下几个重点。

● Xen 虚拟化管理程序是一个极小的软件程序,包含大概15万行代码。Xen虚拟化管理程序本身没有I/O功能虚拟化,如网络和存储等。

● 虚拟机是一个虚拟化的环境,每个虚拟机都运行着自己的操作系统和应用程序。Xen支持两种虚拟化模式∶半虚拟化和全虚拟化。在同一个虚拟化管理程序上可以同时并行使用这两种虚拟化模式,也可以串行在全虚拟化模式上使用半虚拟化模式,以此保证半虚拟化和全虚拟化的连续性。虚拟机与硬件之间是完全隔离的,它们没有任何权限可以访问底层的硬件和 I/O 设备等,因此它们也被叫作 DomainU (Unprivileged Domain)。

● Domain0是一个特殊的虚拟机,其具备特殊的、足够的权限直接访问底层的硬件设备,处理所有底层的 I/O 设备请求,并与其他虚拟机(DomainU)进行交互通信。Domain0对外部开放一个接口,使用户可以控制整个系统。没有Domain0,Xen 虚拟化管理程序是无法使用的,它是整个系统启动后加载的第一个虚拟机。

● Toolstack 包含在Domain0中,也叫作控制栈,其允许用户管理虚拟机,包括虚拟机创建、删除和配置等。

● 终端是 Toolstack 对外部开放的一个接口,用户可以通过命令行或/和图形化界面控制整个系统,OpenStack和CloudStack中的编排服务也被支持。

● Domain0要求一个支持Xen虚拟化管理程序的内核,半虚拟化的虚拟机(DomainU)要求一个支持半虚拟化的内核。比较新的Linux操作系统都支持Xen虚拟化管理程序,并且也包含支持虚拟化和Toolstack的软件包。

2. 虚拟机类型

下图是 Xen 虚拟化管理程序支持虚拟化模式的变化。

1)半虚拟化(PV)

半虚拟化是由Xen虚拟化管理程序引入的一个轻量级、高效的虚拟化模式,之后被其他虚拟化平台所采用。半虚拟化不要求物理主机节点CPU具备扩展特性,但是其需要支持半虚拟化的内核和驱动,因此,虚拟机能够感知到虚拟化管理程序;同时,因为没有硬件仿真,所以运行非常高效。支持半虚拟化的内核包括Linux、FreeBSD、NetBSD和OpenSolaris。Linux内核从2.6.24版本开始,使用Linux pvops framework的内核都支持半虚拟化,这也就意味着除了比较老的版本外,几乎所有的Linux 内核都支持半虚拟化。下图是半虚拟化模式在Xen虚拟化管理程序中的性能表现。

2)全虚拟化(HVM)

全虚拟化需要物理主机节点CPU扩展特性的支持,为此,Intel和AMD厂商提供了Intel VT和AMD-V技术。Xen虚拟化管理程序使用QEMU仿真硬件设备,包括BIOS、IDE磁盘控制器、VGA 图形适配器、USB控制器和网络适配器等。硬件的扩展特性提高了仿真性能。同时,全虚拟化模式下的虚拟机不再需要特殊内核的支持,这也就意味着Windows 操作系统在基于Xen全虚拟化的平台上也是被支持的。一般情况下,半虚拟化的虚拟机比全虚拟化的虚拟机性能表现更好,因为全虚拟化的虚拟机需要硬件仿真,会消耗一部分性能。

在某些情况下,可以使用半虚拟化驱动加速全虚拟化虚拟机的I/O性能。在Windows 虚拟机中,需要安装合适的半虚拟化驱动。具体信息可以参照以下链接。

● Xen半虚拟化驱动列表∶http∶//xenproject.org/downloads/windows-pv-drivers.html。

● 第三方GPL半虚拟化驱动列表∶http∶//wiki.xensource.com/wiki/Xen_Windows_GplPv。

● Windows 半虚拟化驱动列表:http∶/wiki.xensource.com/wiki/Category∶Windows_PV_Drivers。

在Xen虚拟化支持的操作系统中,在选择全虚拟化模式运行操作系统时,其已安装的半虚拟化或全虚拟化驱动可以自动被使用。下图展示了全虚拟化模式和含有半虚拟化驱动的全虚拟化模式之间的区别。

3)全虚拟化模式+半虚拟化驱动(PVHVM)

全虚拟化模式下的虚拟机可以使用指定的半虚拟化驱动,以此达到增强系统性能的目的。这些驱动是为全虚拟化环境而优化的半虚拟化驱动,绕过磁盘和网络的模拟仿真,从而在全虚拟化模式下获得更好的性能。这也就意味着在使用一些虚拟机操作系统时会获得更好的性能,如 Windows 等。

基于Xen虚拟化管理程序的半虚拟化虚拟机可以自动使用半虚拟化驱动,全虚拟化模式下使用的半虚拟化驱动仅适用于全虚拟化模式下的虚拟机。下图展示了3种类型的全虚拟化模式之间的区别。

4)半虚拟化+硬件扩展特性(PVH)

Xen 虚拟化管理程序4.4版本中包含一种虚拟化模式,叫作基于DomainU的PVH;4.5 版本又开发了一种基于Domain0(Linux和BSD)的PVH虚拟化模式,其实质是半虚拟化的虚拟机可以使用半虚拟化驱动以提高I/O性能,也可以使用硬件扩展特性提高系统性能,不需要硬件仿真。PVH在4.4和4.5版本中作为试验进行发布和测试使用,性能表现非常好,并且在4.6版本中进行了优化。从本质上讲,PVH对两种虚拟化模式进行了合并,简化了Xen虚拟化管理程序的架构。

简而言之,PVH在Linux和BSD中使用了极少的代码和接口,从而减少了TCB和攻击的可能性,降低了风险。一旦对其进行相应的优化,它将具备更好的性能和更低的延迟,特别是在64位的操作系统上表现更优。

PVH要求虚拟机操作系统对其提供支持,在配置文件中设置pvh=1即可启用PVH支持。下图展示了全虚拟化、半虚拟化和PVH之间的区别。

3. Toolstacks、APIs和终端

Xen 虚拟化管理程序包含许多不同的 Toolstacks,每个 Toolstack 对外开放接口,利用该开放接口可以运行各种不同的工具,管理整个系统。下面介绍一些商业化产品所使用的Toolstack,以及托管服务商使用API的案例。

Xen 虚拟化管理程序与默认的Toolstacks、Libvirt和XAPI相互作用、协同运行。Xen 虚拟化管理程序与 XAPI 配合使用的虚拟化产品是 XCP,但是其已经逐渐被开源产品XenServer 所取代。基于 Xen 虚拟化管理程序的各种虚拟化模式都具备各自的优势,并且针对不同的案例进行了优化,因此对虚拟化方案的选择也是见仁见智。

下图中的Default∶XL 和XAPI/XE由Xen虚拟化管理程序提供。

下面针对图形中各种不同的Toolstacks进行解释:

● Default∶XL∶XL是一个使用Libxenlight建立的轻量级CLI Toolstack,其随着Xen的更新而发展,在Xen 4.1版本中,XL是默认使用的 Toolstack。由于 Xend 已经过时,即将从Xen中删除,所以XL被设计为与XMCLI向后兼容,它提供了一个简单的、针对Xen的命令行接口,用于虚拟机的创建和管理等。

● XAPI/XE∶Xen 虚拟化管理程序管理 API(XAPI)是 XenServer 虚拟化产品默认使用的Toolstack,有时在CloudStack中也会使用。目前,逐渐被废弃的XCP虚拟化平台正尝试提供一个基于 XAPI的社区开发平台,以开源的形式进行,并在正式发行版中提供该技术。

● Libvirt/virsh∶Libvirt是一个虚拟化API,用于管理各种虚拟化技术,如Xen、KVM等。Libvirt拥有一个Libxenlight端口,用于与xm进行接口通信。

● Default/Xend∶ Xend是一个诞生时间比较早的Toolstack,一直作为Xen虚拟化管理程序的一部分进行更新、发布和使用。但是自 Xen 4.1 版本发布后,Xend 开始过时,不再推荐使用;在 Xen 4.5 版本以后,其已经被删除。现在推荐使用上述三种Toolstacks。XL被设计成一个与XM CLI兼容的命令行Toolstack,可以将请求发送给Xend,所以使用XL不失为一种很好的升级方法。

下表是以上介绍的Toolstack与其CLI命令行的对应关系:

5、Libvirt技术介绍

Libvirt是一个函数库,包含实现Linux虚拟化功能的Linux API,提供了管理虚拟机的通用的、稳定的、统一的接口。其主要包括Libvirt API、Libvirtd 进程和 virsh 工具集三部分。

为了便于理解,我们将Libvirt分为三层,从三个层级进行介绍,具体如下图所示。

其中,接口层的virsh工具集和Libvirt API负责接收程序和用户的指令;在抽象驱动层,接收上层发出的指令调用Libvirt 库或控制Libvirtd进程提供统一的接口;在具体驱动层,调用底层相应的虚拟化技术接口执行操作。

Libvirt 可以提供关于虚拟机管理的所有 API,包括创建、修改、监控、控制、迁移和停止虚拟机。当然,并不是所有的虚拟化技术都支持Libvirt提供这些关于虚拟机的操作,

但是Libvirt可以提供关于这些操作的API。任何一个对虚拟机有价值的操作,Libvirt都会提供。利用 Libvirt 可以同时访问多个物理主机,但是对单主机节点的操作是有限制的。Libvirt API提供了管理虚拟机所需的物理主机节点层面的所有操作,如防火墙规则、存储管理和一般配置API等。同时,它也提供了实施管理策略所需的状态监控API,对虚拟机的状态监控也从某种角度反映出物理主机的资源消耗情况,这对掌握生产环境中硬件资源的使用率极其重要。

综上所述,Libvirt实现了以下功能∶

● 所有API通过安全协议都可以远端执行操作。

● 大部分 API对虚拟化和物理主机操作系统的管理都是通用的,但是一些API只能应用于虚拟化管理。

● Libvirt API可以完成虚拟机需要的所有操作。

● Libvirt API不提供高级别虚拟化策略或多节点管理功能,如负载均衡功能。但是Libvirt不拒绝在其外部通过技术实现这些高级功能。

● 目前Libvirt的稳定性存在一些问题,建议将经常需要变化的、稳定性低的应用与稳定性要求高的应用进行分离。

● 被管理的物理主机节点可以来自不同的厂商,但是Libvirt对其进行远程管理必须使用安全协议。

● Libvirt API可以监控和使用被管理物理主机节点的资源,包括CPU、内存、存储和网络等。

由此可以总结出∶Libvirt的目标是建立一套集中在虚拟化层面、面向应用的高级管理工具。

如前所述,Libvirt API的功能是使用有效的硬件资源服务当前的虚拟机操作系统。下面从Libvirt驱动和Libvirtd进程两方面展开介绍。

1. Libvirt驱动

Libvirt驱动是实现Libvirt功能的基本模块,保证了Libvirt程序可以处理和调用指定的虚拟化程序。Libvirt驱动在连接处理过程中被发现和注册,每个驱动都有一个注册API,其负责加载指定的驱动。下图是关于虚拟化程序驱动的简单视图。

Libvirt目前支持的虚拟化技术如下表所示:

2. Libvirtd进程

Libvirtd进程通过 remote 驱动可以远程处理对Libvirt驱动的访问请求。一些虚拟化技术支持来自客户端的连接和反馈,如 Test、OpenVZ、VMware、PowerVM、VirtualBox、ESX、Hyper-V和Xen等。Libvirtd进程随操作系统启动而启动运行,与普通进程一样,具有足够权限的用户可以重启和停止它。确定需要使用的驱动后,Libvirtd进程可以将请求路由到正确的驱动上,建立连接并检索所请求的信息,返回状态信息或数据给应用。应用可以根据需求确定利用这些数据执行哪些操作,如展示、打印日志等。

下图是Libvirtd进程的简单视图:

3. Libvirt 网络架构

下面从网络逻辑架构和物理架构两方面来阐述Libvirt的网络设计。

● vlan1∶该虚拟网络的流量连接到物理网络2上。

● vlan2∶该虚拟网络与物理网络完全隔离。

●虚拟机A∶网络端口 eth0桥接到物理网络1上,网络端口 ethl 连接到vlan1上。

● 虚拟机B∶网络端口 eth0连接到vlanl上,网络端口 eth1连接到vlan2上。该虚拟主机扮演路由的角色,在两个vlan之间可以转发网络包,使虚拟机C连接到物理网络2上。

●虚拟机C∶仅有的网络端口 eth0连接到vlan2上,没有直接连接物理网络,依靠虚拟机B的路由转发流量实现网络互通。

其逻辑架构如下图所示:

其物理架构如下所示:

4. Libvirt 存储架构

Libvirt的存储设计包括两个核心部分。

● 存储卷∶一个存储卷可以分配给虚拟机使用,或创建成存储池以供使用。一个存储卷可以是一个块设备、一个.raw 文件或其他格式的文件。

● 存储池∶存储池可以理解成将存储资源池化,分割成存储卷分配给虚拟机使用。存储池用来管理物理磁盘、NFS服务器或一个LVM组。

三、Neutron网络服务

OpenStack项目中的Neutron网络服务组件提供虚拟机实例对网络的连接,其中plug-ins 能够提供对多种网络设备和软件的支持,使 OpenStack 环境的构建和部署具备更多的灵活性,其最主要的功能是为虚拟机实例提供网络连接。

Neutron 网络服务组件包括以下几部分:

● neutron-server∶接收和路由API请求到OpenStack中的网络plug-in。

● OpenStack Networking plug-ins and agents∶创建端口(Ports)、网络(Networks)和子网(Subnets),提供IP地址。plug-ins和agents根据不同的厂商和技术而应用于不同的云环境中,OpenStack中的plug-ins一般支持Cisco Virtual and Physical Switches、NEC OpenFlow Products、Open vSwitch、Linux Bridging和VMware NSX Product。常见的 agents 包括L3(Layer 3)、DHCP(Dynamic Host Configuration Protocol)和plug-in agent。

● Messaging queue∶在neutron-server和 agents之间路由信息,同时也会作为一个数据库存储plug-ins的网络连接状态。

1、OSI 7层模型

Open Systems Interconnection(OSI)模型的全称是开放系统互联参考模型,是一个逻辑上的定义,是一个规范,使通信和计算系统自由互联,而不依赖其他内在的架构或技术。它诞生的目标就是使用标准协议使不同平台的系统互联互通。该模型为了更好地被理解和应用,抽象成层的概念,共分为7层,每一层既服务于上层,又被下层所服务。7层由低到高分别是物理层、数据链路层、网络层、传输层、会话层、表示层和应用层。处于同一层的两个实例是互相可见的,并且是水平连接的。

OSI模型属于International Organization Standardization(ISO)项目,由ISO/IEC7498-1 进行维护。

OSI 模型最大的优点是将服务、接口和协议明确分开,其中,服务说明某层为上一层提供某些功能,接口说明上层如何调用下层所提供的服务,协议则负责如何实现本层服务。因此,OSI 模型中的每一层都具备很强的独立性,互相连接的网络中各层所采用的协议是没有限制的,只要向上层提供服务并且不改变接口即可。

下表是对OSI模型7个层级的描述:

OSI模型中每个层级相互通信设备上的两个实体,在相同层级上使用协议交换Protocol Data Unit(PDU)。每个PDU中包含的有效数据叫作Service Data Unit(SDU),其包含每层协议相关的数据头和数据尾信息。在OSI模型中,两个相互通信的设备之间的数据处理过程如下∶

(1)一个拥有N层的传输设备在其最高层级将要传输的数据解析成Protocol Data Unit (PDU)。

(2)PDU传输到N-1层,在该层级,此PDU作为Service Data Unit(SDU)被识别。

(3)在N-1层,该SDU使用数据头、数据尾或二者共同使用进行连接、组合,生成全新的N-1层的PDU,然后继续将其传递给N-2层。

(4)拆分和组合的流程和动作会一直重复,直至数据到达底层,也就是数据从发送设备传递到目标设备。

(5)在目标设备上,数据以 SDU 格式从底层传递到最高层。在数据传递过程中,不断地剥离每层的数据头、数据尾,直至数据到达最高层,也就是数据最终被应用、消耗的地方。

下面对OSI模型进行详细介绍:

1. 物理层

物理层并不是物理媒介本身,它只是开放系统中利用物理媒介实现物理连接的功能描述和执行连接的规程。物理层提供用于建立、保持和断开物理连接的机械的、电气的、功能的和过程的条件。

简而言之,物理层提供有关同步和全双工比特流在物理媒介上的传输手段。

物理层有以下主要功能∶

● 定义数据连接电气和物理规格,为设备之间的数据通信提供传输媒介及互连设备,为数据传输提供可靠的环境。物理层的媒介包括架空明线、平衡电缆、光纤、无线设备(5GHz或24GHz)等。

● 负责传输和接收非结构化原始数据。

● 定义传输模式,如单工模式、半双工模式和全双工模式。

● 定义网络拓扑类型,如总线、网格和环等。

● 主要处理原始数据。

2. 数据链路层

数据链路层为互相连接的节点提供数据传输,并且能够发现错误并进行纠错,建立或终止节点间的连接,定义节点间的流量控制协议。数据链路的建立、拆除,以及对数据的检错、纠错,是数据链路层的基本任务。

IEEE802协议将数据链路层分为两个子层。

● Media Access Control(MAC)层∶负责控制网络中的设备如何获得访问权而传输数据。

● LogicalLink Control(LLC)层∶负责识别网络层协议,进行封装、错误检查、纠错和帧同步。

IEEE 网络(如802.3网络、802.11无线和802.15.4ZigBee)的MAC子层和LLC子层都在数据链路层处理数据。

Point-to-Point Protocol(PPP)协议工作在数据链路层,并且支持多种物理链接。

ITU-T Ghn规范通过有线连接(电源线、电话线和同轴电缆等)提供了高速的局域网连接,其中就包括完整的数据链路层,负责错误纠正和流量控制等。

3. 网络层

网络层将逻辑网络地址翻译成物理主机节点地址,在不同的主机节点间提供各种功能和程序,传输各种不同长度的数据流。网络作为一种介质,多个设备通过这种介质连接在一起,网络中的每个设备都有一个地址,彼此间通过该地址进行连接、信息交互,通过被传递的数据包中含有的目标主机节点地址信息进行准确传送。如果传递的数据太大,在数据链路层不能直接进行传递,那么网络层会将该数据分割成数据段。在传输时,数据段之间没有依赖性,各自独立发送,当到达目标主机节点后进行重组,形成完整的数据。网络层可以发现并报告传输过程中的任何错误,同时提供选项供用户选择是否保证数据可靠传输。

在Annex和ISO7498/4国际标准中定义的协议和功能都包含在网络层中,包括路由协议、多播组管理、网络层信息和错误报告、网络地址分配。这些功能都属于网络层,而不是协议。

网络层是可选的,它只适用于多个设备处于不同的、由路由器分隔开的网段,或者当通过应用要求某种网络层或传输层提供的服务、特性或者能力时。

4. 传输层

传输层负责跨越多个网络传输不同长度的数据段,并保证服务质量,满足更高层次的要求。例如Transmission Control Protocol(TCP)协议,可提供可靠的端到端的纠错和流量控制,保证数据的正确传输。

传输层通过链路流量控制、数据分段和组合及错误控制等功能提供可靠性。同时,传输层的一些协议是面向状态或面向连接的,所以可以跟踪数据段的流向,以及在传输失败时重新传输。传输层可以对已经成功传输的数据段进行确认并继续发送下一个数据段,也可以将从应用层收到的消息数据转化成数据包。数据包转化的过程就是将长消息数据分割成短消息数据的过程。

在OSI模型中,传输层根据传输协议连接模式的不同,从TP0到TP4分成5类。一般情况下,TP0代表支持的特性少,不包含错误恢复,多应用于无错误连接;TP4代表支持的特性多,多应用于可靠性低的网络,例如Intermet 网络,TCP是TP4的典型代表。

下表是TP0~TP4所支持特性的详细信息:

举例来说,传输层和邮局的功能有许多相似之处,如邮局进行邮件分发和分类是根据邮件信封信息来操作的,这与传输层的功能相同。当然,在OSI模型中,更高层级可能包含两个“信封”,如加密后的信息,根据第一个“信封”,任何人都可以读取,但是根据第二个“信封”,只有收件人才能读取。一般来说,隧道协议应该发生在传输层,但是根据数据封装地点的不同而不同。如Generic Routing Encapsulation(GRE)协议,根据功能定义,它好像一个网络层协议;但是它对数据的封装发生在端点,则GRE更像一个传输层协议。

5. 会话层

会话层控制着应用之间的连接,可以启用、管理和终止连接,提供全双工、半双工和单工操作,设置检查点可使通信会话在通信失效恢复时从检查点继续恢复通信,这种功能对于传送大文件极为重要。会话层、表示层和应用层构成OSI模型的高三层,面向应用进程提供分布处理、对话管理、信息表示、检查和恢复与语义上下文有关的传送查错等功能。在使用Remote Procedure Calls(RPC)的应用环境中,会话层经常被用到。

6. 表示层

表示层的主要功能是将不同格式的信息进行转换,使数据表示具备独立性,成为应用层可以识别的数据。表示层之所以重要,是因为不同体系结构所使用的数据表示方法不同,例如,IBM主机使用EBCDIC编码,而大部分PC使用的是ASCII码。在这种情况下,就需要表示层来完成这种转换。通过前面的介绍可以总结出,包括会话层在内的下五层完成了端到端的数据传送,并且是可靠的、无差错的传送。但是数据传送只是手段而不是目的,最终是要实现对数据的应用。由于各种应用程序对数据的定义并不完全相同,最容易明白的例子就是键盘,其上的某些按键的含义在许多操作系统中都有差异,表示层就负责消除这些障碍。表示层也可以对数据进行加密。

7. 应用层

应用层是OSI模型中的最高层,最接近终端用户,通过软件应用与终端用户直接通信。其主要功能是识别通信对象、确定资源可用性和同步通信。当通信对象被识别后,应用层确定数据传输应用程序的身份和通信对象的可用性,在确定资源有效性之后,应用层必须确定有足够的网络资源供该请求使用。在同步通信中,应用层管理所有的通信请求。在这个过程中涉及的通信对象、服务的质量要求、用户认证和隐私、语法约束使用等都是由应用程序指定的。

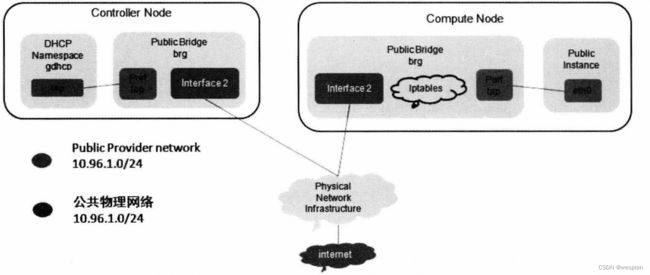

2、网络介绍

OpenStack项目中的Neutron网络服务组件管理着所有的网络端口,无论是在虚拟网络架构(Virtual Networking Infrastructure,VNI)中,还是物理网络架构(Physical Networking Infrastructure,PNI)中(与Neutron连接的部分)。同时,Neutron网络服务组件可以为租户提供高级服务,如创建防火墙、负载均衡(Virtual Private Network)等。

Neutron 网络服务组件利用软件定义提供网络、子网和路由功能,它模仿物理网络设备的功能,在网络中划分多个子网,路由器在不同的子网间传递数据。

路由器通过网关连接网络,虚拟机实例上的网络端口连接到子网中,不同子网中的虚拟机实例通过同一路由器相互连接。

已经部署完成的Neutron 网络服务组件至少包含一个外部网络(External Network),外部网络不仅是一个网络,它同时代表着一个物理网络的视图。外部网络能够连接 OpenStack 项目之外的网络环境,DHCP功能被关闭。

除了外部网络外,还至少包含一个内部网络,虚拟机实例在这些内部网络中获得IP地址,那些连接在相同路由器上的设备能够与虚拟机实例相互通信。

外部网络和虚拟机实例之间的通信需要由路由器连接,路由器依靠网关完成。例如一个物理路由器设备,不同子网中的设备之间进行通信必须依靠路由器,虚拟机实例能够访问外部网络必须通过网关完成。

在外部网络中,也可以分配IP地址给虚拟机实例,虚拟机实例的网络端口既可以连接内部网络,又可以连接外部网络。这样,网络中的所有设备都可以与该虚拟机实例进行通信。

Neutron 网络服务组件支持安全组(Security Group)设置,管理员可以定义一些安全规则,包括禁止或者允许某个端口、端口范围和访问类型(如TCP或UDP)。多个安全组可以应用于同一个虚拟机实例。

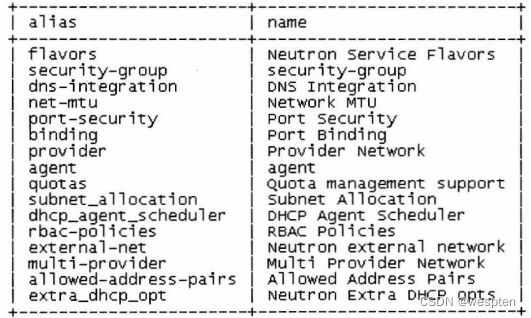

Neutron 网络服务组件支持的每个 plug-in 都有各自的概念、功能和作用,可能不会全部应用于OpenStack项目,但是理解和掌握这些plug-ins对Neutron网络服务组件的应用会起到事半功倍的作用。Neutron 网络服务组件包含一个核心的网络 plug-in 和一个安全组plug-in, Firewall as a Service(FWaaS)和Load Balancer as a Service(LBaaS)plug-ins都可以作为Security Group plug-in的一个选项。

3、网络架构

在部署和使用Neutron 网络服务组件前,理解Neutron网络服务组件的架构和拓扑,以及与OpenStack项目中的其他服务组件如何交互和互动,将对后期的学习、工作很有帮助。

Neutron 网络服务组件是OpenStack项目中一个独立、核心的模块化服务组件,它与其他服务组件一起协同工作,如Nova计算、Glance镜像、Keystone身份认证和Horizon仪表板服务组件等。它可以在多个物理主机节点上部署多个服务。在网络主机节点上运行neutron-server 主进程提供了相关程序需调用的 Networking API和进行配置网络插件的管理。

在控制节点上可以运行Nova计算服务组件,同样,也可以将Neutron 网络服务组件部署在控制节点上。当然,Neutron 网络服务组件是独立组件,支持运行在专用的物理主机节-点上,而且最好的实践也是部署在专用的物理主机节点上。

Neutron 网络服务组件包括下表所示的agents:

以上这些 agents 通过RPC(RabbitMQ或 Qpid)或标准 API与Neutron 网络进程进行通信,在运行过程中,需要与其他服务组件进行交互。

● Neutron 网络服务组件依赖于Keystone 身份认证服务组件的功能,对所有API请求进行身份认证和授权。

● Nova 计算服务组件通过调用标准API与Neutron 网络服务组件进行交互。在创建虚拟机实例时,nova-compute服务与Neutron 网络服务组件的API进行交互,以分配虚拟网络地址给虚拟机实例,用于连接到网络中。

● Horizon 仪表板服务组件与Neutron 网络服务组件的 API进行交互,管理员和租户使用基于Web的图形界面管理网络服务。

4、网络API简介

Neutron 网络服务组件是一个虚拟网络服务,它提供了一组强大的API来定义网络连接和IP地址,供Nova计算服务组件使用。

Nova计算服务组件也提供了一组强大的API来描述虚拟机的计算资源。同样,Neutron 网络服务组件提供的 API通过网络、子网和网络端口等抽象概念而详细、具化地描述网络资源,如下表所示。

在配置网络拓扑结构时,可以创建网络、子网和网络端口,以配合其他服务组件使用。例如,Nova计算服务组件可以将虚拟设备连接到虚拟网络端口,使其可以连接到虚拟网络中。

Neutron 网络服务组件支持每个租户有属于自己的网络地址段,每个租户可以根据自己的需求选择合适的网络地址类型和区段。每个租户之间的网络设置可以重复,使用同一类型或区段的IP地址。

Neutron 网络服务组件的功能可以归纳为以下三点∶

● 具备高级的虚拟网络功能。例如,构建多层次的Web应用、应用系统从传统环境迁移到云环境无须修改IP地址等。

● 灵活性高,在网络架构、功能方面提供更多自定义。

● 允许开发者对Neutron 网络服务组件进行二次开发,从而使更多人受益。

5、LBaaS和FWaaS

Load Balancer as a Service(LBaaS)功能使 Neutron 网络服务组件在多个网络主机节点间可以均衡分配、处理请求,这种机制可以分散负载压力,使请求造成的工作负载被均衡分配,以提高系统资源的利用率。负载均衡包含以下三种策略。

● Round Robin∶在多个网络主机节点间轮询处理各种请求。

● Source IP∶来自同一源IP的请求被持续指向同一网络主机节点。

● Least Connections∶分配请求给具有最少活动连接数的网络主机节点。

LBaaS的特性描述如下表所示:

Firewall as a Service(FWaaS)添加防火墙管理到Neutron 网络服务组件中,使用Iptables 作为防火墙策略应用到L3虚拟路由中。

安全组(Security Group)应用于虚拟机实例级别,FWaaS在虚拟路由外围过滤各种流量。下图为instance02虚拟机实例进口和出口流量的数据流图。

6、网络类型介绍

OpenStack 项目中的网络分为两类,分别为Tenant Network 和Provider Network。普通用户可以在租户内创建Tenant Network,并且关于该Tenant Network 的信息对其他用户是不可见的,以保证独立性和安全性。具有管理员权限的用户可以创建Provider Network,根据已经存在的物理网络属性设置该Provider Network 的属性和信息,该虚拟网络必须与数据中心已经存在的物理网络配置相匹配。

具体的拓扑结构如下图所示:

1. Provider Network

Provider Network 允许具有管理员权限的用户创建虚拟网络直接连接到数据中心的物理网络中,虚拟机实例利用此网络可以直接访问外部网络。Provider Network 扩展属性允许管理员管理虚拟网络和物理网络之间的关系,如VLAN、Tunnels等。在启用这些扩展属性后,具有管理员权限的用户便可以使用这些属性创建虚拟网络。Open vSwitch(OVS)和Linux Bridge 插件都支持该扩展属性,且配置大概相同。

Provider Network支持的网络类型包括Flat(untagged)和VLAN(802.1Q tagged)。

2. Tenant Network

普通用户可以在租户内创建虚拟网络,在默认情况下,租户之间的网络是隔离的、不能共享的。

Neutron 网络服务组件支持的网络隔离和重叠类型(overlay)如下:

● Flat∶所有虚拟机实例都连接在同一网络中,并且与宿主机也可以运行在同一网络中,没有对网络数据包进行打标签(vlan tag)或者隔离。

● Local∶虚拟网络使用Nova计算服务组件的nova-network。目前该网络类型的代码不再更新,功能使用很少。

● VLAN∶Neutron 网络服务组件使用vlan tag(802.1Q tagged)技术允许用户创建多个Provider Network和Tenant Network,该虚拟网络中的vlan tag信息与数据中心物理网络中的 vlan tag 信息是一一对应的。因此,虚拟机实例可以和网络中的任何设备进行通信,包括服务器、防火墙、负载均衡和其他L2层的设备。

● GRE和VXLAN∶GRE和VXLAN是一种封装数据包的协议,创建重叠网络以激活和控制虚拟网络。Neutron 网络服务组件中的 neutron router 允许采用GRE和VXLAN 的Tenant Network数据流出虚拟网络或当下租户网络,使数据自由流动,原因就是neutron router 连接了 Tenant Network 和外部网络,使彼此互通。从外部网络访问Tenant Network 中的虚拟机实例,需要通过Floating IP地址进行连接。

下表对本章中出现的网络名词进行了总结:

![]()

ML2、Open vSwitch(OVS)和Linux Bridge(桥接)插件支持VLAN、Flat和Local 三种虚拟网络类型。只有ML2和Open vSwitch(OVS)支持GRE和VXLAN虚拟网络类型,支持的前提是主机节点Kernel、Open vSwitch(OVS)和 iproute2包含其所需的特性。

四、存储服务

顾名思义,存储服务是为数据保存而使用的,在 OpenStack 项目中被多个服务组件使用,非常重要。从数据保存时间的角度区分,存储可以分为两种∶临时存储和持久存储。

临时存储是指数据被虚拟机实例使用,一旦虚拟机实例被关机、重启或删除,该虚拟机实例中的所有数据信息全部丢失。换言之,就是所有的数据都保存在临时存储中。在OpenStack 项目中,部署完Nova计算服务组件后,用户可以使用nova boot 命令创建虚拟机实例,这时虚拟机实例使用的就是临时存储,所有数据都保存在临时存储上,安全性没有保障。

持久存储包括对象存储、块存储和文件系统存储,它们维护数据持续可用,保证数据安全性,无论虚拟机实例是否终止。

下表从多个角度对存储特性进行了描述:

用户对 OpenStack 环境中存储的使用存在许多不同的需求,一些用户需要快速访问非经常修改的数据,一些用户需要访问可以被格式化成文件系统的存储,还有一些用户希望虚拟机实例不再使用时存储能够立即释放。

针对目前主流的开源存储技术特点,我们对其进行了总结,如下表所示:

1、块存储(Cinder)服务介绍

OpenStack 项目中的 Cinder 块存储服务组件为虚拟机实例提供了块存储设备,同时为管理块存储设备提供了一整套方法,如卷快照(Volume Snapshot)、卷类型(Volume Type)等。块存储类型是由驱动或者后端设备配置的驱动决定的,如NAS、NFS、SAN、ISCSI、Ceph或其他。Cinder块存储服务组件的API和cinder-scheduler服务通常运行在控制节点上,cinder-volume服务可以运行在控制节点、计算节点或者独立的存储节点上。

Cinder块存储服务组件由以下服务进程组成:

● cinder-api∶接收API请求,并将请求转发到cinder-volume。

● cinder-volume∶与块存储直接进行交互通信,处理一些任务,如由 cinder-scheduler分配的任务,同时通过消息队列与这些任务进行交互通信。cinder-volume 还会维护块存储的状态,通过驱动与各种类型的存储进行交互通信。

● cinder-scheduler dacmon∶选择最佳存储节点创建卷。具有相似功能的是nova-scheduler。

● cinder-backup daemon∶提供任意类型卷的备份。

● messaging queue∶负责在各进程间传递信息。

块存储又称卷存储(Volume Storage),为用户提供基于数据块的存储设备访问,用户对数据块存储设备的访问和交互是通过将数据块存储设备映射到正在运行的虚拟机实例上进行的,可以对其进行读/写、格式化等。

块存储属于持久存储,当取消块存储设备与虚拟机实例之间的映射或将块存储设备重新映射给其他虚拟机实例时,该块存储设备上的数据都不受影响,数据是完整的。换言之,只要该块存储设备是存在的、无损坏的、完整的,那么其上的数据就是完整的、可用的。至于该块存储设备是否映射给其他虚拟机实例识别和使用,与其上已经保存的数据的完整性和可用性无关。块存储由OpenStack项目中的Cinder块存储服务组件提供,根据已经包含的存储驱动,其目前支持多种类型的后端存储。

许多存储驱动支持虚拟机实例直接访问底层存储,无须经过层层转化和性能消耗,这无疑对提升整体的I/O性能很有帮助。同时,Cinder块存储服务组件也支持使用文件作为块设备,如NFS、GlusterFS等。在NFS和GlusterFS文件系统中,可以创建一个独立文件作为块设备映射给虚拟机实例使用。这种方法类似于在QEMU中创建虚拟机实例,这些虚拟机实例是一个个文件,保存在/var/lib/nova/instances目录中。

2、对象存储(Swift)服务介绍

OpenStack项目中的Swift对象存储服务组件通过RESTAPI提供对象数据存储和检索。它不能独立使用,至少要和Keystone身份认证服务组件配合使用,所以在部署Swift对象存储服务组件前,Keystone 身份认证服务组件必须已经准备就绪。

Swift对象存储服务组件支持多租户(Multi-Tenant),投入成本低,具有高扩展性和存储大量非结构化数据的特性。

Swift对象存储服务组件包括以下几部分:

● Proxy servers(swift-proxy-server)∶接收对象存储的API和HTTP请求,修改metadata、创建containers;在Web图形界面上提供文件或者containers列表;使用MemCached 提供缓存功能,提高性能。

● Account servers(swift-account-server)∶管理对象存储内的账户。

● Container servers(swift-container-server)∶管理对象存储内 containers和文件夹之间的映射。

● Object servers(swift-object-server)∶管理真正的对象数据,如文件等。

● Various periodic processes∶执行日常事务。其中的复制服务能够保证数据的连续性和有效性,还包括审核服务、更新服务和删除服务。

● WSGI middleware∶处理认证相关问题,与Keystone 身份认证服务组件连接。

swift client∶允许各种具有权限的用户在该客户端上提交命令,执行操作。

● swift-init∶初始化Ring文件的脚本,需要守护进程名字作参数,并提供操作命令。

● swift-recon∶CLI工具,用于检索集群各种性能指标和状态信息。

● swift-ring-builder∶创建和重平衡Ring的工具。

在 Swift 对象存储服务组件中,用户通过调用 API可以访问存储中的元数据,与著名的 Amazon S3对象存储有异曲同工之处。Swift 对象存储的主要功能是对静态大数据集的归档和管理,同时也可以存储虚拟机镜像。

Swift 对象存储服务组件提供了一套可扩展、高可用的存储方案,以代替传统的、昂贵的存储设备。从本质上讲,此类型存储的诞生为解决不同严重级别和时间点的硬件故障提供了另外一种方案,如控制器宕机、RAID卡损坏等。

Swift对象存储具备数据持久性和可用性的特点,依靠软件逻辑设计使所有数据能够均衡分布存储。一般情况下,默认保存三份数据。这三份数据的保存位置非常重要,既可以分布在同一服务器的不同硬盘中,也可以分布在同一机架内的不同服务器中,分布位置的选择对集群整体性能的影响很大。在 Swift 对象存储集群中,当出现存储数据的主机节点宕机时,整个集群的负载压力会非常大。

例如,在一个含有三份副本的集群中,一个主机节点上保存有8TB数据,那么在故障出现时,瞬间便会有24TB的数据需要进行传输和重平衡,可想而知,对网络和磁盘的压力有多大。这就对网络带宽和磁盘性能提出了更高的要求,在生产环境中要尽可能多地使用网卡聚合和固态磁盘等技术来提高整体性能。

1. 对象存储特点

Swift对象存储区别于传统存储(见下图),具体如下∶

● 所有的数据存放和访问都有一个URL地址。

● 所有的数据保存三份副本,分布在不同的Zone里。

● 所有的数据都有自己的元数据(metadata)。

●软件开发人员可以通过API与Swift对象存储进行交互操作。

● 数据随机存放在集群中的任意位置。

● 集群添加存储节点不产生性能损耗,是横向扩展,而不是纵向叠加。

● 数据不需要一次性迁移到新存储。

● 集群添加存储节点不需要停机时间。

● 故障存储节点或硬件设备进行替换不需要停机时间。

● Swift对象存储运行在标准的x86服务器上,如Dell、HP和Lenovo服务器。

软件开发人员既可以通过API也可以通过开发语言的函数库,与Swift对象存储进行交互操作,开发语言包括Java、Python、Ruby和C#等。Amazon S3和RackSpace的对象存储与Swift对象存储非常相似。

下表是Swift对象存储的特点和优势:

2. 对象存储组成

Swift对象存储使用以下组件提供高可用性、高稳定性和高并发。

● Proxy Server∶接收和处理各种传入的API请求。

● Ring∶将数据名称映射到磁盘的具体位置上。

● Zone∶用于隔离副本数据,当一个Zone 出现问题时,不会影响其他Zone中的副本数据。

● Account和Container∶每个Account和Container都是一个独立的数据库,分布在集群的多个存储节点上。每个Account数据库包含属于它的Container列表,每个Container 数据库包含属于它的对象数据列表。

● Object∶数据。

● Partition∶每个Partition中保存对象数据、Account数据库和Container数据库,管理着对象数据在集群中的存放位置。

下图是对象存储组成图示及操作层级展示:

1)Proxy Server

Proxy Server 是 Swift 对象存储的公共接口,接收并处理所有传入的请求。当 Proxy Server 接收到请求后,根据对象数据的 URL 定位到相应的存储节点上,如 https∶//swift. object.storage/vl/account/container/object。同时,Proxy Server 负责协助处理请求反馈、请求失败和标记时间戳等。

Proxy Server采用共享无状态架构,能够根据业务负载压力扩展Proxy Server,最小的Proxy Server集群包含两个主机节点,当其中一个主机节点出现故障时,另一个主机节点能够接管所有业务请求。

2)Ring

Ring 是对象数据的名称与其在磁盘上具体位置之间的映射。因为 Account、Container 和 Object 之间的组合会产生许多 Rings,当需要对 Account、Container 或 Object 进行操作时,都需要与相应的Ring进行交互操作,以确定其在磁盘上的具体位置。

Ring使用Zone、Partition、磁盘和数据副本构成映射,Ring中的Partition都有多个副本,默认是三份副本。当出现故障切换时,Ring可以确定使用哪个磁盘进行数据迁移。

Ring使用Zone对数据进行隔离,每个Partition的副本都存储在不同的Zone中。Zone可以是一块磁盘、一台服务器,甚至是一个数据中心。

Ring将数据副本的Partition存放在多个磁盘上,当Partition进行移动时(如集群添加新存储节点),Ring需要确认移动的Partition数量,一次只允许移动一个副本的Partition。通过设置权重值也可以平衡Partition的分布,控制数据流向,避免集群在压力负载大时各主机节点的压力负载不均衡。

下图是Ring的功能示意图:

3)Zone

Swift对象存储利用Zone功能隔离风险,当某一Zone内的数据丢失或被破坏时,不影响其他Zone 内的数据副本,保持数据整体上的完整性和可用性。理想情况下,每个数据副本分别存储在不同的Zone中,充分隔离。Zone的最小单位可以是一块磁盘设备或一组磁盘设备,其标志性作用是允许存储节点出现停机时间而数据仍然保持实时可用性。

下图是Zone的功能示意图:

4)Account和Container

Account和Container都有自己独立的SQLite数据库,SQLite数据库采用分布式,部署在 Swift对象存储集群的多个存储节点上。每个 Account 数据库中包含属于它的 Container 列表,同样,每个Container数据库中也包含属于它的对象数据列表,示意图如下图所示。

由上图可以看出,为了能够正确获取对象数据位置,Account、Container 和 Object 之间的对应关系很重要。

5)Partition

Partition 代表需存储数据的一个集合,包含多个 Account 数据库、Container 数据库和相应的对象数据。

可以把Partition看作一个小型仓库,包含多个Account、Container和相应的对象数据,它是作为一个整体在 Swift 对象存储集群中进行操作的,从而避免单独操作多个小型的对象,既增加复杂度,又增大系统负载压力。数据副本的复制和对象数据的上传下载都是基于Partition进行操作的。

关于Partition的概念很简单,它就像存放在磁盘中的一个目录,有自己的哈希表,关联着属于该Partition的Account、Container和对象数据,示意图如下图所示。

6)Replicator

为保证存放在Swift对象存储集群中三份数据副本的一致性,Replicator会持续检查每个Partition,将本地的Partition与其他Zone中的Partition副本进行比较,检查是否一致。

Replicator通过检查哈希表确认是否需要进行数据重同步,是否发起数据同步操作。每个Partition都有一张哈希表,包含一个含有哈希表的目录。例如,数据存储三个副本,对于其中一个 Partition,会将其哈希文件与其他两个副本的哈希文件进行比较,如果不同,则数据需要进行重同步,目录中的哈希文件也需要进行同步。

Replicator会持续检查数据的一致性,其中,新数据的同步优先级较高。

当集群中某个存储节点宕机后,包含同样数据副本的存储节点会进行检查和发出通知,并将数据复制到其他存储节点上。示意图如下图所示。

3、文件系统存储

文件系统存储是一个远端的、可以被挂载的文件系统。它是共享的,通过挂载到虚拟机实例上,可以供多个租户使用。文件系统存储可以在同一时间被多个用户同时挂载和访问。用户的操作包括∶

● 创建指定容量大小的文件和文件系统协议。

● 创建的文件可以分布在一个或多个服务器上。

●指定访问规则和安全协议。

● 支持快照。

● 通过快照恢复一个文件系统。

● 查看使用率。

文件系统存储与Cinder块存储相同,也属于持久存储。它能被多个虚拟机实例挂载,可以从虚拟机实例解除映射,重新映射到其他虚拟机实例,而数据依然保持完整。

在 OpenStack 项目中,文件系统存储的程序代号是 manila,支持多种后端存储驱动,通过多种存储协议(NFS、CIFS、GlusterFS和HDFS)进行共享。

4、Ceph简介

Ceph是一个符合POSIX(Portable Operating System for UNIX")、开源的分布式存储系统,遵循LGPL协议。该项目最初由Sage Weill于2007年开发,其理念是开发一个没有任何单点故障的集群,确保能够跨集群节点进行永久数据复制。

与任何经典的分布式文件系统中一样,放入集群中的文件是条带化的,依据一种称为Ceph Controlled Replication Under Scalable Hashing(CRUSH)的数据分布算法放入集群节点中。

Ceph支持自动扩展、自动恢复和自主管理集群,其生态系统支持许多与其交互的方式,这使得在已运行的基础架构中进行集成变得既简单又便捷,即便它执行的是一个在项目中需要提供块和对象双类型存储功能的复杂任务。

Ceph共有5个主要组成部分,如下图所示:

● RADOS(Reliable Autonomic Distributed Object Store)是一个稳定的、独立的和完全分布式的对象存储,具备自主健康检查、自主恢复、自主管理和高级智能等特点。因此,理解RADOS是理解Ceph的基础与关键。

● LIBRADOS是一个lib函数库,运行应用程序直接访问RADOS,支持PHP、Ruby、Java、Python、C和C++等编程语言与其交互。

● RADOSGW提供了兼容Amazon S3和Swift的RESTful API接口,相应的对象存储可与其交互通信,将对象数据直接存储在集群中。

● RBD是一个稳定的、完全分布式的块设备,包含Linux内核客户端和QEMU/KVM驱动,为物理主机或虚拟机提供块存储。

● Ceph FS是一个与POSIX兼容的分布式文件系统,包含Linux内核客户端和FUSE(Filesystem in Userspace)支持。

当我们在OpenStack云平台上使用Ceph或CephFS作为块存储和对象存储时,需要安装部署多个Ceph存储节点、配置网络和Ceph存储集群。一个Ceph存储集群要求至少包含一个Ceph Monitor进程和两个Ceph OSD进程。当使用Ceph FS时,还需要使用Ceph 元数据服务器(MDS),如下图所示。

下面分别介绍OSD、Monitor和MDS:

● OSD∶一个Ceph OSD进程负责存储数据,处理数据复制、恢复、回填、重平衡等,同时,通过心跳检查Ceph OSD进程的相关状态信息并汇总传递给Ceph Monitor进程。当Ceph存储集群设置数据存储副本数量为2时(Ceph存储集群默认存储三份数据副本,但是可以根据需要进行相应调整),那么该Ceph存储集群要求至少运行两个OSD进程,以达到Active+Clean的状态。

● Monitor∶Ceph Monitor维护着关于集群状态的映射管理表(map),包括Monitor map、OSD map、PG(Placement Group)map 和 CRUSH map。同时,在Ceph Monitor、Ceph OSD和PG中,Ceph 还维护着每次状态更改的历史信息(epoch)。

● MDS∶Ceph 元数据服务器存储着Ceph FS需要使用的元数据(Ceph块存储和对象存储不需要使用MDS),POSIX文件系统用户可以在Ceph FS上执行ls、find等命令,这一切都要归功于Ceph 元数据服务器,是它帮助用户实现了这种功能,同时又避免了对Ceph存储集群造成巨大的压力。

在Ceph存储集群中,用户的数据作为一个对象被存放在存储池中,至于数据存放在什么位置、以何种方式存放,就涉及一个比较重要的算法,即CRUSH(Controlled Replication Under Scalable Hashing)算法。CRUSH算法能够最优地安排对象数据放置在某个存放组中,并进一步安排该存放组放置在某个OSD中。CRUSH算法使Ceph存储集群具备了高扩展、重平衡和动态恢复的能力。

1. 存储数据过程

在Ceph存储集群中,数据的来源包括Ceph块存储(RBD)单元组件、Ceph对象存储单元组件、Ccph FS和使用librados开发的应用程序,数据作为一个对象进行存储。每个对象关联着一个文件,该文件存储在磁盘中,Ceph的OSD进程负责处理磁盘中对象的读/写操作,如下图所示。

Ceph OSD进程以扁平命名空间格式(而不是传统的目录层次结构)存储着所有的对象数据,一个对象数据拥有一个唯一ID、二进制数据和元数据(以name-value键值对形式出现),如下图所示。Ceph FS使用元数据存储文件属性,文件属性包括文件属主、创建日期、修改日期等。

2. 可扩展性和高可用性

对于传统的分布式存储,客户端通过一个中央控制器与其进行通信,中央控制器是一个单点输入,控制着整个存储集群的功能。这就暴露出其在扩展性和性能方面的一个缺陷,即中央控制器作为一个单点,一旦出现宕机或其他意外情况,整个集群就会出现功能性宕机,不能对外提供服务。

为了解决此问题,Ceph使客户端可以直接与OSD进程通信,OSD进程存在于集群中的每个存储节点中,负责创建对象数据副本,以此保证数据的安全性和高可用性。同时,集群中的Monitor进程负责整个集群的高可用性,使用CRUSH算法确保Ceph存储集群具备中央控制器所提供的功能。

1)CRUSH介绍

Ceph的客户端和 OSD 进程都需要使用 CRUSH算法计算出对象数据的存放位置,而不是像传统的分布式存储一样,完全依赖于中央控制器。同时,CRUSH算法提供了一个更好的数据管理方式,即分配工作负载给Ceph集群中所有的 OSD进程,以实现更大规模的集群。Ceph集群中的副本技术也是由CRUSH算法提供的,数据保存多个副本保证了安全性和可扩展性。

2)集群映射表

Ceph 依赖于客户端和OSD进程来实现集群的拓扑,其包括5个map。

(1)Monitor map∶其包含了fsid、位置、名称地址、端口号、当前的 epoch、map创建日期和最后修改日期。可以使用“ceph mon dump”命令查看Monitor map。

(2)OSD map∶其包含了fsid、map创建日期和最后修改日期、存储池、副本数量、OSD列表及其数量。可以使用“ceph osd dump”命令查看OSD map。

(3)PG map∶其包含了PG版本、时间戳、最后的 OSD map epoch和每个PG的详细信息等。PG的详细信息包括PGID、状态和使用率统计等。

(4)CRUSH map∶其包含了存储设备列表、故障域(如设备级别、主机级别、机柜级别和数据中心级别等)和用于存储数据时映射层级传递的规则。可以使用“ceph osd getcrushmap-o{filename}"命令查看CRUSHmap。

(5)MDS map∶其包含了MDS map epoch、map创建日期和最后修改日期、元数据池、元数据服务列表及状态。可以使用“ceph mds dump”命令查看MDS map。

每个map中都包含着操作状态更改的历史信息。Ceph Monitor维护着集群映射表的主副本,其包括集群成员、状态、修改和存储集群的健康状态。

3)Monitor高可用

在Ceph 客户端读/写数据之前,必须首先与 Monitor 进程建立联系,以获取最新的集群映射表副本。Ceph存储集群可以只包含一个Monitor进程,但是这样又出现了与传统分布式存储同样的问题,即单点故障。一旦该Monitor进程被终止,Ceph客户端将读/写数据失败。

为了解决此问题,增加Monitor稳定性和容错性,Ceph存储集群支持Monitor集群功能。但是随着Monitor集群规模和负载压力的增大,在Monitor集群中,延迟和其他故障可能导致Monitor集群状态出现异常,进而导致整个Ceph存储集群出现故障。针对该问题,Ceph 设置了一个协议,采用少数服从多数规则和Paxos算法以保证Monitor集群的可持续性,进而不影响整个集群的状态,使Ceph存储集群可以持续对外提供服务。

4)身份认证

为了进行用户身份认证,同时避免存储集群遭受人为攻击,Ceph提供了cephx认证系统,以验证用户和进程身份是否合法。cephx使用共享的安全keys进行身份认证,客户端和 Monitor 集群各自拥有同一个安全key,客户端和 Monitor集群彼此之间都可以证明对方拥有自己安全key的副本,而无须透露安全key去进行验证。这种身份认证机制使Ceph客户端可以和集群中的每个OSD直接通信,提高了效率,同时,安全key的扩展性也避免了其出现单点故障。

下面我们大概了解一下如何使用cephx认证系统。首先,客户端管理员必须设置用户,用户调用 ceph auth get-or-create-key命令生成一个用户名和安全key,cephx认证系统将生成的用户名和安全key在Monitor集群中存储一个副本,并发送该用户的安全key给客户端管理员,这也就证明了客户端和Monitor集群共享一个安全key,如下图所示。

![]()

其次,在身份验证过程中,客户端传送用户名给Monitor集群,Monitor集群会生成一个session key,并将session key与该用户名关联的安全key一起加密,然后将加密信息传送给客户端。客户端使用共享的安全key对其解密并检索该sessionkey,该sessionkey即可验证当前session的用户身份。客户端请求一个ticket,Monitor生成一个ticket,并将其与用户的安全key一起加密,发送给客户端。客户端解密该ticket去对OSD进程和元数据服务器发起请求,如下图所示。

3. 集群管理

Ceph 存储集群最重要的特点是自动管理、故障自动修复和智能 OSD 进程。下面介绍一下Ceph如何利用CRUSH算法实现数据存放、集群数据重平衡和自我故障恢复。

1)池化的概念

Ceph 存储集群支持池化,其可以理解为对象数据存储的一个逻辑概念。Ceph 客户端从 Monitor 进程中检索集群映射表,并将对象数据写入池中,如下图所示。池的大小或副本数量、CRUSH规则设置和PG数量决定了Ceph如何存储对象数据。

2)PG和OSD

每个池中包含多个PG(Placement Group),CRUSH可以动态地将PG映射给OSD。当客户端需要存储数据时,CRUSH会将对象数据映射给PG,然后将PG映射给OSD,完成对象数据的存储。

PG位于对象数据和OSD之间,是一个中间层。如果Ceph客户端知道对象数据存放在哪个OSD上,则会在客户端和OSD之间建立一个联系,下次需要访问该对象数据时,可以直接访问。如果不知道,则CRUSH会将对象数据映射在PG上,再将该PG映射在OSD 上,最终写在磁盘上。当Ceph存储集群增加或减少OSD时,Ceph利用中间层PG进行数据的动态平衡,以保证存储具备最佳性能,如下图所示。

3)计算PGID

当Ceph客户端和Monitor建立联系后,客户端会对最新的集群映射表进行检索,由此可以得到关于Monitor、OSD、元数据服务器的所有信息,但是仍不能获知关于对象数据存放位置的信息。对象数据的存放位置信息需要通过计算获得。

下面简要介绍一下计算对象数据存放位置的过程。当客户端需要存储对象数据时,CRUSH会根据对象数据名称、Hash码、PG数量和池的名称计算出PGID,大概分为以下几个步骤。

(1)客户端输入池和对象数据的ID或者名称(例如,pool="Liverpool",object-id="john")。

(2)Ceph将对象数据的ID进行Hash编码。

(3)Ceph使用Hash编码和PG数量计算出PGID(例如,id=58)。

(4)Ceph获知池ID(例如,"Liverpool"=4)。

(5)Ceph将池ID和PGID进行关联,即可确定对象数据的存放位置(例如,位置信息为4.58)。

由上面的介绍可以得知,对于获知对象数据的存放位置信息,计算比在存储集群中检索速度更快。CRUSH算法允许客户端计算对象数据的存放位置,并和OSD建立联系以存放和检索对象数据。

4)数据重平衡

当在Ceph存储集群中添加新的OSD时,CRUSH会重新计算PGID,相应的集群映射表也会更新,基于重新计算的结果,对象数据的存放位置也会发生变化。下面简要介绍一下数据重平衡的过程∶在一个含有两个OSD的存储集群中,在加入第三个OSD后,原有的两个OSD内的PG不会全部移动到新的 OSD中,CRUSH会重新计算,确定哪些PG需要迁移,大部分PG会保持原有配置和位置,少部分PG会进行迁移,如下图所示。重平衡的操作会使每个 OSD 释放出一些空闲空间,总体上增加了存储集群的容量。

![]()

5)数据一致性

为了保证数据的一致性和清洁度,Ceph存储集群会定期擦洗PG中的对象数据,大概原理就是Ceph OSD会将一个PG中的数据与另一个PG中的该数据副本进行比较,以此获知比对结果。数据擦洗分为两种∶第一种是轻度擦洗,每天发生,可以捕捉到OSD的一些Bug 或文件系统错误;第二种是重度擦洗,每周发生,在字节级别(bit-for-bit)进行数据比较,可以捕捉到一些硬盘坏块等错误,这种错误在轻度擦洗中无法检测到。

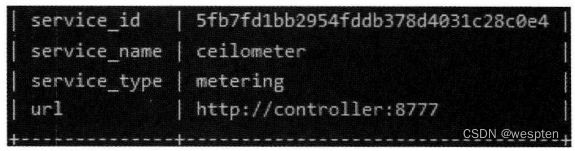

五、Ceilometer计量服务

在OpenStack项目中,Ceilometer计量服务组件以标准格式收集数据存储和系统资源的使用信息而进行统计和计费。同时,它也可以获取操作执行所产生的信息,触发通知。这些数据会被存储下来,作为计量数据。

随着计量服务组件收集数据量的不断增加,除了用于计费外,还可以有其他用途。例如,跟踪到某个系统负载压力过大而发出警告,可以据此对系统进行硬件资源扩容。

1、计量服务组件组成

Ceilometer计量服务组件采用客户端部署agent的架构,收集数据,将数据存放在数据库中,或者提供一个处理传入请求的API服务。

Ceilometer计量服务组件包括以下几部分。

● A compute agent(ceilometer-agent-compute)∶运行在每个计算节点上,循环查询资源使用率统计情况。

● A central agent(ceilometer-agent-central)∶运行在管理服务器上,循环查询资源使用率统计情况。

● A notification agent(ceilometer-agent-notification)∶运行在管理服务器上,使用消息队列中的信息记录事件和计量数据。

● A collector(ceilometer-collector)∶运行在管理服务器上,分发收集监测数据到数据存储上或展示给用户。

● An alarm evaluator(ceilometer-alarm-evaluator)∶运行在管理服务器上,根据设置的阈值定义确定何时进行报警。

● An alarm notifier(ceilometer-alarm-notifier)∶运行在管理服务器上,允许报警阈值在合适的范围内进行调整、设置。

● An API server(ceilometer-api)∶运行在管理服务器上,提供数据访问。

以上这些服务通过OpenStack项目的消息总线进行通信。只有Collector和API Server 可以访问数据存储。

2、量服务组件支持列表

计量服务组件对OpenStack项目中的资源进行监控、统计和计费是有要求的,下面从数据库、虚拟化技术和网络三个方面分别介绍计量服务组件的支持情况。

1. 数据库

计量服务组件最核心的部分就是数据库,它存储着事件、样例、定义警告触发的阈值和警告等。其所支持的数据库列表如下∶

● ElasticSearch(仅支持事件存储)。

● MongoDB。·

● MySQL。

● PostgreSQL。

● HBase。

2. 虚拟化技术

计算服务组件收集关于虚拟机的信息。其所支持的虚拟化技术列表如下∶

以下虚拟化技术通过Libvirt支持∶

- KVM(Kernel-based Virtual Machine)。

- QEMU (Quick Emulator)。

- LXC(Linux Containers)。

- UML(User-Mode Linux)。

● Hyber-V。

● Xen。

● VMware VSphere。

3. 网络

计量服务组件支持对OpenStack项目内部的Neutron网络服务组件和外部网络服务进行检索、计量。其支持列表如下∶

● OpenStack项目内部网络服务组件(Neutron)∶

基本网络模型:

- FWaaS (Firewall as a Service)。

- LBaaS (Load Balance as a Service)。

- VPNaaS (V P N as a Service)。

●软件定义网络(SDN)∶

- OpenDayLight。

- OpenContrail。

六、Keystone身份认证服务

OpenStack 项目中的Keystone身份认证服务组件提供了认证、授权和目录的服务,其他 OpenStack 项目中的服务组件都需要使用它,彼此之间相互协作。当一个 OpenStack 服务组件收到用户的请求时,首先要交给Keystone身份认证服务组件检查该用户是否具有足够权限完成其提出的请求任务。Keystone 身份认证服务组件是唯一可以提供身份认证的服务组件。

Keystone身份认证服务组件包括以下几部分。

● Server∶使用一个程序接口提供认证和授权服务。

● Drivers∶集成到服务器中,用作 OpenStack 项目之外和已经在项目之内(SQL Database)的程序访问身份认证信息。

● Modules∶运行在使用认证服务的 OpenStack 服务组件中,监听服务请求,提取用户凭证,发送这些信息去服务器验证并对其授权。

当Keystone身份认证服务组件安装完毕后,需要将OpenStack项目中的每个服务组件都注册到其中,以使Keystone身份认证服务组件能够识别这些服务组件。

下面对Keystone身份认证服务组件中的一些概念进行介绍,以帮助在后续操作中可以更好地理解每个选项的含义。

1. Authentication

对用户进行身份确认的过程。对于一个操作请求,Keystone 身份认证服务组件会验证发起请求的用户所提供的凭证,该凭证既可以是用户名和密码,又可以是用户名和APIkey。当Keystone身份认证服务组件验证用户凭证正确后,会发出一个认证令牌。在后续的请求中,用户会提供该认证令牌。

2. Credential

确认用户身份的数据,例如,用户名和密码、用户名和API key、Keystone 身份认证服务组件提供的认证令牌。

3. Domain

项目和用户的集合,为认证实体定义了管理界限。域是个人、运营商或公司所拥有的空间,用户可以直接在域中进行管理操作。用户可以获得域管理员角色,创建项目、用户和组,分配角色给用户和组。

4. Endpoint

一个网络访问地址,通过它可以访问某个服务组件,以URL形式为主。

5. Group

组是域所拥有的所有用户的集合。组角色授予域或项目,应用于该组中所有的用户。从组中添加或删除用户会相应地获得或撤销该用户在域或项目中的角色和认证信息。

6. OpenStackClient

OpenStack项目中服务组件的命令行接口。例如,用户可以使用openstack service create 和 nova boot命令注册服务或创建实例。

7. Project

集合或分离资源或对象的容器。根据不同的操作管理员,一个项目可以映射到客户、用户、组织或租户。

8. Region

OpenStack部署的分区区域。可以关联多个子区域到一个区域,形成树形结构的大区域。虽然区域并不代表实际的物理位置,但是可以使用代表物理区域的名词进行命名,例如,ch-bj。

9. Role

定义一组用户的权利和权限,具备执行一系列指定操作的特性。Keystone 身份认证服务组件发送给用户的令牌环包含多个角色。当用户调用某个服务时,该服务会分析该用户的角色设置,确定该角色是否拥有操作和访问资源的权限。

10. Service

OpenStack项目中的服务组件,例如,计算(Nova)、对象存储(Swift)等。这些服务组件提供一个 endpoint,用户通过该 endpoint 可以访问资源和执行操作。

11. Token

允许访问OpenStack项目APIs及各种资源的由字母和数字组成的字符串。认证令牌在任何时间都可以被撤销,同时也具备有效期限。在OpenStack的L版本中,Keystone身份认证服务组件支持基于Token的验证,未来会支持更多的功能。Keystone是一个集成的服务组件,具备很多功能和特性,而不是一个只具备身份认证和管理功能的技术方案。

12. User

使用 OpenStack 云服务的个人、系统或服务的一个数码表示凭证。Keystone 身份认证服务组件会确认用户发出请求的有效性。用户利用自身的Token可以登录和访问各种资源。

七、Glance镜像服务

Glance镜像服务组件是OpenStack项目的核心组件,它接收来自用户和Nova计算服务组件的 API请求,支持在不同的介质上进行存储,包括 OpenStack项目中的 Swift 对象存储。

Glance镜像服务组件上运行的进程支持缓存、副本服务保证可用性和一致性,其他进程还包括审计、更新等服务。

这里介绍的Glance镜像服务将虚拟机镜像放在控制节点的文件系统中,默认路径是 /var/lib/glance/images/。在进行下面的操作之前,必须确认该文件系统拥有足够的空闲空间用以存储虚拟机镜像。

Glance 镜像服务组件包括以下几部分:

● glance-api∶接收发现、检索和存储镜像的API请求。

● glance-registry∶存储、处理和检索镜像元数据。镜像元数据包括大小、类型等。glance-registry 是Glance镜像服务组件内部的私有服务,不能开放给外部用户使用。

● Database∶存储镜像元数据。Glance镜像服务组件支持多种数据库,大部分使用MySQL或者SQLite数据库。

● Storage repository for image files∶虚拟机镜像文件的存储介质支持多种类型,包括普通的文件系统、对象存储、分布式存储(如Ceph)、HTTP和Amazon S3。在使用这些存储介质时,务必确认存储介质是否只支持只读使用。

八、Heat编排服务

Heat 编排服务组件提供基于模板的服务,它集成 OpenStack 项目中的许多核心服务组件于一个模板中,使用这个模板可以创建许多类型的资源,如虚拟机实例、Floating IPs、卷设备、安全组和用户等。当然,还有一些其他高级功能,如实现虚拟机实例高可用、虚拟机实例的自动横向扩展等。这些功能使 OpenStack 项目适用的应用场景更多,获得了更多的用户群。

Heat编排服务组件包括以下几部分。

● heat command-line client∶提供命令行客户端,与 heat-api 交互通信以运行 AWS CloudFormation APIs。开发人员可以直接使用Heat 编排服务组件RESTAPI。

● heat-api component∶通过使用RPC将请求发送到 heat-engine 处理 API请求。

● heat-api-cfn component∶与AWS CloudFormation兼容的AWS Query API,通过使用RPC将请求发送到heat-engine处理这些API请求。

● heat-engine∶编排模板的运行,并提供日志、事件输出给管理员。

随着Heat 编排服务组件的不断发展,它已经开始兼容AWS CloudFormation模板,许多AWS CloudFormation模板可以直接在OpenStack环境中运行。

九、OpenStack安装配置准备

以 OpenStack Liberty 版本为例进行安装部署,物理主机节点的操作系统选择SUSE 系统(openSUSE 13.2或SUSELinux Enterprise Server 12)。OpenStack由多个服务组件构成,既可以选择全部服务组件,也可以选择部分服务组件进行安装部署。

在进行OpenStack安装和配置之前,需要仔细思考以下几个问题∶

● 我们需要使用哪几个服务组件,使我们的架构达到最优,既不臃肿又不单薄?

● 我们需要使用哪些方法和策略保证架构安全?

● 我们需要使用哪些工具或者技术使 OpenStack 的安装部署自动化,且管理简单?

1、架构设计

OpenStack 示例环境架构设计包括5个主机节点,分别为一个控制节点、两个计算和块存储节点(计算和存储服务在一个节点上)和两个对象存储节点。

1. 控制节点

控制节点非常重要,许多服务组件和软件运行其上,如 Horizon 仪表板服务组件、Keystone 身份认证服务组件、Glance镜像服务组件,以及支持 OpenStack 运行的各种软件,包括数据库、消息队列和时钟服务等。

控制节点要求最少有两个网络端口,以满足需要∶一个是管理/数据网络,用于主机节点间的数据传输和网络连接;另一个是公共网络,用于虚拟机实例的网络连接。

2. 计算节点

计算节点运行着虚拟化软件(默认使用KVM虚拟化技术)和网络服务,用于提供虚拟机实例及其网络连接和防火墙服务(通过安全组提供)。

计算节点要求最少有两个网络端口,作用与控制节点相同。在 OpenStack 环境中可以部署多个计算节点,以增加整个OpenStack环境的计算资源的容量和体量。

3. 块存储节点

块存储服务不是必选服务,为虚拟机实例提供块存储服务。在真正的生产环境中,管理网络(存储节点与控制节点通信)和数据传输网络(存储节点和计算节点通信)必须是相互独立的,以增强整个架构的性能和安全。

块存储节点要求最少有一个网络端口,用于提供数据传输。但是可以部署多个存储节点,以增加整个环境的存储容量。

4. 对象存储节点

对象存储服务不是必选服务,为各种服务组件提供存储服务。在真正的生产环境中,管理网络(存储节点与控制节点通信)和数据传输网络(存储节点和计算节点通信)必须是独立的,以增强整个架构的性能和安全。

对象存储至少包括两个存储节点,每个节点要求最少有一个网络端口。

5. 网络节点

网络节点可以部署多种网络拓扑模型,具体如下。

1)Flat模式

Flat 模式是一种简单的网络服务形式,在 OSI模型中属于第二层(数据链路层),虚拟网络和物理网络进行桥接,路由交换依赖于物理网络中的OSI模型第三层(网络层),DHCP服务提供了对虚拟机实例的IP地址分配功能。

该模式缺少对私有网络的支持,不能在 OpenStack 环境内部实现网络自服务功能、基于OSI模型三层的虚拟路由功能和其他服务,如LBaaS和FWaaS等。

网络模式1∶Flat模式,如下图所示。

2)VLAN、VXLAN模式

该模式可以提供网络自服务和路由交换,使用NAT技术实现数据在虚拟网络和物理网络之间的路由连接,同时提供了各种其他服务,如LBaaS和FWaaS等。

网络模式2∶VLAN和VXLAN模式,如下图所示。

2、基础环境准备

本章主要介绍在安装配置 OpenStack 各服务组件之前,如何准备基础环境。基础环境准备是否充分对后续的安装配置是否成功至关重要。整个 OpenStack 环境需要仪表板服务(Horizon)、计算服务(Nova)、身份认证服务(Keystone)、网络服务(Neutron)、镜像服务(Glance)、块存储(Cinder)、对象存储(Swift)、计量服务(Ceilometer)、编排服务(Heat)。

注意:

在后续的介绍中,将默认使用各服务组件的英文名称,这样既简单又有利于后续学习。随着学习的深入,就会慢慢发现,有效的信息大多是以英文出现的。

需要配置的所有服务组件都要运行在Linux 操作系统上,同时需要拥有管理员权限的用户,既可以是root用户,也可以是有sudo权限的普通用户。

实例使用的操作系统为SLES(SUSELinux Enterprise Server),使用systemctl命令可以操作各项服务。

● systemctl enable SERVICE_NAME∶设定某项服务开机自启动。

● systemctl start/stop/restart/reload SERVICE_NAME∶设定某项服务启动、停止、重启、重加载。

为使OpenStack项目更好地运行,建议物理主机节点至少配置以下硬件资源。

●控制节点∶1 Processor,4 GB Memory,20 GB Storage。

●计算节点∶2 Processor,5 GB Memory,40 GB Storage。

为使 OpenStack 项目能够使用更多的硬件资源,建议操作系统最小化安装,并且必须是64位的。

每个物理主机节点必须有一个独立的磁盘分区安装操作系统,同时在计算节点上必须有一块独立磁盘分区作块存储使用。

基于学习的需要,可以采取虚拟机作为物理主机节点建立OpenStack 云环境,其优势和要求如下∶

●一个物理机可以支持多个虚拟机,用于安装多个服务组件,成本最小化。

● 目前市场上主流的虚拟化产品(VMware WorkStation、VirtualBox等)都支持SnapShot功能,方便在配置出现问题时进行回退。

● 物理磁盘数量和大小及网卡数量可以随意调整和定义。

当然,使用虚拟机作为物理主机节点安装 OpenStack 的服务组件也有缺点,如性能降低、缺少硬件加速等功能。

注意:

如果确定使用虚拟机作为物理主机节点部署OpenStack,请确认物理CPU是否支持虚拟化功能、网卡是否支持MAC地址过滤功能。

1. 安全设置规则

OpenStack项目的各服务组件支持不同类型的安全规则,如密码、策略和加密等,有的还支持数据库加密和消息代理,但是有一个共性,那就是都支持设置密码作为安全规则。

为了简化整个 OpenStack 环境的安装部署过程,我们对所有的服务组件都使用密码作为安全规则。

下表是OpenStack项目各服务组件设置的密码格式和规则:

2. 主机节点网络设置

在主机节点上安装完操作系统后,需要为每台主机节点配置网络。建议关闭OpenStack环境中有关网络的所有自动管理工具,手动编辑有关网络连接的配置文件。

由于 OpenStack 环境中所有的主机节点都需要安装或更新软件包,进行 DNS 解析和NTP同步,所以OpenStack环境中的所有主机节点必须能够连接互联网。

网络布局如下图所示:

该网络布局有以下几点需要注意和解释∶

●可以根据实际情况修改以上网络信息,包括IP地址和网关。

● 管理/数据网络可以提供主机节点间的数据传输,也可以提供互联网访问。

● 公共网络为虚拟机实例提供网络连接。

● 每个主机节点的IP地址与主机名必须能够相互解析。

注意∶

在安装操作系统时,建议关闭防火墙,以防在后续配置过程中产生各种问题。

控制节点配置:

1)网络配置

首先配置管理/数据网络的网卡信息。

IP地址:172.168.1.11。

子网掩码∶255.255.255.0。

默认网关∶172.168.1.254。

公共网络的网卡不需要配置 IP 地址,编辑/etc/sysconfig/network/ifcfg-INTERFACE_NAME文件,添加以下信息∶

STARTMODE='auto'

BOOTPROTO='static'按照以上修改完成后,可以重启机器或者重启网络服务生效。

# reboot 或:

# systemct1 restart network,service 2)名字解析

首先为控制节点设置主机名,然后编辑/etc/hosts文件。

配置如下∶

#controller

172.168.1.11 Controller

#compute01

172.168.1.12 Compute01

#compute02

172.168.1.13 Compute02

#NTPServer

172.168.1.1 NTPServer

#Object-sto01

172.168.1.14 object_sto01

#Object-sto02

172.168.1.15 Object_sto02

Linux操作系统版本的不同可能导致/etc/hosts文件内容的不同,一定要注释或者删除影响名字解析的内容(如127.0.1.1)。但是不要删除127.0.0.1的名字解析。

为了减少部署的复杂性和增加部署的完整性,该文件(/etc/hosts)包含了所有主机节点的名字解析内容,即使可能不会使用的节点信息(如Object存储节点部分)也包含其中。

计算节点配置:

1)网络配置

首先配置管理/数据网络的网卡信息。

IP地址∶172.168.1.12/13(第一个节点IP是172.168.1.12,第二个节点IP是172.168.1.13)

子网掩码∶255.255.255.0。

默认网关∶172.168.1.254。

公共网络的网卡不需要配置IP 地址,编辑/etc/sysconfig/network/ifefg-INTERFACE_NAME文件,添加以下信息∶

STARTMODE='auto'

BOOTPROTO='static'按照以上修改完成后,可以重启机器或者重启网络服务生效。

#reboot 或:

# systemctl restart network.service 2)名字解析

首先为计算节点设置主机名,然后编辑/etc/hosts文件。配置如下∶

#controller

172.168.1.11 Controller

#compute01

172.168.1.12 Compute01

#compute02

172.168.1.13 Compute02

#NTPServer

172.168.1.1 NTPServer

#Object-sto01

172.168.1.14 Object_sto01

#Object-sto02

172.168.1.15 Object_sto02块存储节点配置(可选):

由于块存储节点和计算节点在同一节点上,关于块存储节点的配置已经在计算节点配置部分完成,在此不再赘述。

对象存储节点配置(可选):

1)网络配置

首先配置管理/数据网络的网卡信息。

IP地址∶172.168.1.14/15(第一个节点IP是172.168.1.14,第二个节点IP是172.168.1.15)。子网掩码∶255.255.255.0。默认网关∶172.168.1.254。

按照以上修改完后,可以重启机器或者重启网络服务生效。

#reboot 或:

systemctl restart network.service 2)名字解析

首先为对象存储节点设置主机名,然后编辑/etc/hosts文件。配置如下∶

#controller

172.168.1.11 Controller

#compute01

172.168.1.12 compute01

#compute02

172.168.1.13 compute02

#NTPServer

172.168.1.1 NTPServer

#Object-sto01

172.168.1.14 object_sto01

#Object-sto02

172.168.1.15 object_sto02检查配置:

以上各主机节点信息配置完成后,务必检查并确认所有主机节点均可以访问互联网和相互访问。

● 在控制节点测试是否可以访问互联网。

# ping -c 4 openstack.org

PING openstack.org (162.242.140.107) 56(84) bytes of data.

64 bytes from 162.242.140.107:icmp_seq=1 ttl=37 time=204 ms

64 bytes from 162.242.140.107: icmp_seq=2 ttl=37 time=204 ms

64 bytes from 162,242.140.107: icmp_seq=3 ttl=37 time=204 ms

64 bytes from 162.242.140.107: icmp_seq=4 ttl=37 time=204 ms

--- openstack.org ping statistics ---

4 packets transmitted,4 received,0号 packet loss,time 3001ms

rtt min/avg/max/mdev = 204.213/204.483/204.634/0.479 ms● 在控制节点测试是否可以访问计算节点。

# ping -c 4 Compute01

PING Compute01 (172.168.1.12) 56(84) bytes of data.

64 bytes from Compute01 (172.168.1.12):icmp_seq=1 ttl=64 time=0.606 ms

64 bytes from Compute01 (172.168.1.12): icmp_seq-2 ttl=64 time=0.530 ms

64 bytes from Compute01 (172.168.1.12): icmp_seq=3 ttl=64 time=0.552 ms

64 bytes from Compute01(172.168.1.12):icmp_seq=4 ttl=64 timem0.566 ms

--- Compute01 ping statistics ---

4 packets transmitted, 4 received, 0% packet loss, time 300ms

rtt min/avg/max/mdev = 0.530/0.563/0.606/0.036 ms● 在计算节点测试是否可以访问互联网。

# ping -c 4 openstack.org

PING openstack.org (162.242.140.107) 56(84)bytes of data.

64 bytes from 162.242.140.107: icmp_seq=1 ttl=37 time=206 ms

64 bytes from 162.242.140.107: icmp_seq=2 ttl-37 time=205 ms

64 bytes from 162,242,140.107:icmp_seq=3 ttl=37 time=205 ms

64 bytes from 162.242.140.107:icmp_seq=4 ttl=37 time=205 ms

--- openstack.org ping statistics ---

4 packets transmitted, 4 received, 0% packet loss, time 3003ms

rtt min/avg/max/mdev = 205.258/205.682/206.132/0.551 ms● 在计算测试是否可以访问控制节点。

# ping -c 4 Controller

PING Controller (172.168.1.1) 56(84) bytes of data.

64 bytes from Controller(172.168.1.11):icmp_seq=1 ttl=64 time=0.34 ms

64 bytes from Controller(172.168.1.11):icmp_seq=2 ttl=64 time=0.613ms

64 bytes from Controller(172.168.1.11):icmp_seq-3 ttl-64 time-0.576 ms

64 bytes from Controller (172.168.1.11): icmp_seq=4 ttl=64 time=1.03 ms

--- Controller ping statistics --

4 packets transmitted, 4 received, 0% packet loss, time 3003ms

rtt min/avg/max/mdev = 0.344/0.641/1.034/0.250 ms注意∶

所有Linux 操作系统都有严格的防火墙规则,在安装部署过程中,可能需要修改防火墙规则。基于测试和学习的目的,为了避免操作错误和繁杂,建议关闭防火墙。

3. 节点时钟同步

整个 OpenStack 环境中所有主机节点的时间必须是相同的,因此需要安装一个时间同步软件Chrony,用于在节点间实现时钟同步。建议选择控制节点作为时钟同步服务器(如果使用虚拟机作为物理主机节点部署OpenStack环境,则选择宿主机作为时钟同步服务器),既可以获得良好的网络时延性,又能保证思维逻辑的正确性。

控制节点安装和配置:

(1)使用zypper命令安装Chrony。

# zypper addrepo -f obs://network:time/SLE_12 network_time

# zypper refresh

# zypper install chrony(2)编辑/etc/chrony.conf文件,添加、修改和删除内容以匹配当前的环境。

server NTPServer iburst使用合适的主机名或者IP地址替换NTPServer,文件中可以配置多个时钟同步服务器。(3)启动Chrony服务,并配置Chrony服务开机自启动。

其他节点安装和配置:

(1)使用 zypper命令安装 Chrony。

# zypper addrepo -f obs://network:time/SLE_12 network_time

# zypper refresh

# zypper install chrony(2)编辑 /etc/chrony.conf 文件,添加、修改和删除内容以匹配当前的环境。

server NTPServer iburst使用合适的主机名或者IP地址替换NTPServer,文件中可以配置多个时钟同步服务器。

(3)启动Chrony服务,并配置Chrony服务开机自启动。

# systemcl enable chronyd.service

# systemctl start chronyd.service检查配置:

以上全部配置完成后,务必检查并确认所有的主机节点都已经完成时钟同步。

(1)检查并确认控制节点是否完成时钟同步。

# chronyc sources

210 Number of sources = 1

MS Name/IP address Stratum Poll Reach LastRx Last sample

============================--

^?NTPServer 1 10 377 154 -120.7s[-120.7s] +/- 10.9s(2)检查并确认其他节点是否完成时钟同步。

# chronyc sources

210 Number of sources = 1

MS Name/IP address Stratum Poll Reach LastRx Last sample

=====

^? NTPServer1 10 377 601 -120.5s[-120.5s] +/- 10.9s4. 配置OpenStack 安装源和运行环境

在运行以下操作之前,一定要确认 OpenStack 环境中主机节点的Linux 操作系统已经正确安装完毕。以下步骤需要在所有主机节点上运行。

注意:

由于操作系统中的自动更新会影响 OpenStack 的正常运行,所以务必关闭操作系统的自动更新功能。

(1)配置OpenStack安装源。

# zypper addrepo -f obs://Cloud:OpenStack:Liberty/SLE_12 Liberty (2)更新操作系统软件包。如果包含操作系统Kernel升级,则必须重启操作系统使其生效。

# zypper refresh && zypper dist-upgrade (3)安装 OpenStack 运行环境软件包。

# zypper install python-openstackclient5. 安装和配置SQL数据库

OpenStack 中的大部分服务组件都需要使用 SQL数据库,它们通常运行在控制节点上。

我们使用MariaDB,当然也可以使用MySQL或者PostgreSQL,根据操作系统不同可以选择不同的数据库。

(1)安装MariaDB。

# zypper install mariadb-client mariadb python-PyMySQL(2)创建并编辑/etc/my.cnf.d/mariadb_openstack.cnf文件。在文件的【mysqld】部分,设置bind-address地址为控制节点的IP地址,使其他节点能够通过管理/数据网络与其通信。设置正确的字符编码规则。

[mysqld]

bind-address = 172.168.1.11

default-storage-engine = innodb

innodb_file_per_table

collation-server = utf8_general_ci

character-set-server = utf8(3)启动数据库服务并设置为开机自启动。# systemctl enable mysql.service # systemctl start mysql.service

6. 安装和配置NoSQL数据库

由于Ceilometer计量服务组件需要使用NoSQL数据库,所以我们选择在控制节点安装MongoDB。

NoSQL数据库是Ceilometer计量服务组件必需的。如果不使用Ceilometer服务,则可以不安装NoSQL数据库。

(1)在操作系统上配置MongoDB安装源。

# zypper addrepo -f obs://server:database/SLE_12 Database (2)安装MongoDB。

# zypper install mongodb(3)编辑/etc/mongodb.conf文件,增加或者修改以下内容。

bind_ip = 172.168.1.11,::1

smallfiles = trueMongoDB 数据库默认在 /var/lib/mongodb/journal 目录中创建一些1GB大小的日志文件。为了避免单个日志文件过大和使用过多的文件系统空间,可以打开smallfiles参数,使每个日志文件大小控制在128MB,并且文件系统空间最多使用512MB。

(4)启动MongoDB服务并设置为开机自启动。

# systemctl enable mongodb.service

# systemctl start mongodb.service7. 安装和配置消息队列

OpenStack 中的多个服务组件间需要互相协调运作和更新状态信息,因此需要有一个消息队列完成这些工作。OpenStack支持多种消息队列软件,如RabbitMQ、Qpid和ZeroMQ,消息队列一般运行在控制节点上。由于大部分OpenStack版本都支持RabbitMQ,所以本次试验我们使用RabbitMQ。如果使用其他类型的消息队列,则务必确认 OpenStack 版本与消息队列软件的兼容性。

(1)安装RabbitMQ。

# zypper install rabbitmq-server (2)启动RabbitMQ并设置为开机自启动。

# systemctl enable rabbitmq-server.service

# systemctl start rabbitmq-server.service如果RabbitMQ不能正常启动,并且报错"nodedown",请执行以下操作∶

● 复制文件/usr/lib/systemd/system/epmd.socket到/etc/systemd/system目录。

●编辑文件/etc/systemd/system/epmd.socket,增加以下内容。

[Socket]

ListenStream-MANAGEMENT_INTERFACE_IP_ADDRESS:4369替换MANAGEMENT_INTERFACE_IP_ADDRESS为控制节点的管理/数据IP地址。

● 重新启动RabbitMQ。

(3)在RabbitMQ中创建用户。

#rabbitmqctl add_user openstack RABBIT_PASS替换RABBIT_PASS为合适的密码。

一定要记录好将要或已经创建的用户及其密码。在后续操作中,会频繁使用这些信息。

(4)设置OpenStack用户可以配置、写和读RabbitMQ。

rabbitmqetl set permissions openstack ".*" ".*" ".*"十、Keystone服务安装配置

Keystone 身份认证服务组件是OpenStack项目中默认使用的身份认证管理系统。安装完Keystone身份认证服务组件后,可以通过/etc/keystone/keystone.conf文件进行配置。在设计架构允许的情况下,可以配置独立的日志记录文件,方便问题跟踪与解决。

1、安装和配置

本节详细描述如何在控制节点上安装和配置Keystone 身份认证服务组件。

(1)创建数据库。

① 在操作系统终端连接数据库。

# mysql -u root -p因为我们使用root用户登录,所以在提示输入密码时,按回车键即可建立连接。

② 创建Keystone数据库。

MariaDB [(none)]> CREATE DATABASE keystone;③ Keystone 数据库的访问权限设置。

GRANT ALL PRIVILEGES ON keystone.* TO 'keystone'@'localhost' \

IDENTIFIED BY 'KEYSTONE_DBPASS';

GRANT ALL PRIVILEGES ON keystone.* TO 'keystone'@'%' \

IDENTIFIED BY 'KEYSTONE_DBPASS';替换KEYSTONE_DBPASS为合适的密码。

④ 退出数据库。

MariaDB [(none)]> exit(2)生成一串随机值作为管理Token。

# openssl rand -hex 10(3)安装 Apache HTTP Server和MemCached。

# zypper install openstack-keystone apache2-mod_wsgi \

memcached python-python-memcached (4)启动MemCached并设置为开机自启动。

# systemctl enable memcached.service

# systemctl start memcached.service(5)修改文件 /etc/keystone/keystone.conf 并增加以下内容。

①在【DEFAULT】项,定义管理令牌值。

[DEFAULT]

····

admin_token - ADMIN_TOKEN使用第(2)步生成的管理令牌值替换ADMIN_TOKEN。

②在【database】项,配置数据库连接。

[database]

····

connection = mysql+pymysql://keystone:KEYSTONE_DBPASS@Controller/ keystone 使用已经定义的Keystone数据库密码替换KEYSTONEDBPASS。

③ 在【memcache】项,配置MemCached服务。

[memcache]

····

servers = localhost:11211 ④ 在【token】项,增加以下内容。

[token]

····

provider = uuid

driver = memcache⑤在【revoke】项,增加以下内容。

[revoke]

····

driver = sql⑥(可选)在【DEFAULT】项,打开日志功能,方便问题处理。

[DEFAULT]

····

verbose = True(6)将Keystone身份认证服务信息同步到Keystone的数据库中。

# su -s /bin/sh -c "keystone-manage db_sync" keystone 执行此步骤时,报错:

“error∶CRITICAL keystone【-】OperationalError∶(pymysql.err. OperationalError)(1045, u"Access denied for user 'keystone'@'Controller'(using password:YES)")"。从错误信息分析,大概是权限问题。仔细分析,发现进行信息同步是Keystone 用户与Controller服务器进行交互,在进行数据库访问权限设置时,并没有Controller,因而问题可能存在于此。对Controller设置以下权限∶

mysql -u -root -p

GRANT ALL PRIVILEGES ON keystone.* TO 'keystone'@' Controller' \

IDENTIFIED BY 'KEYSTONE_DBPASS';再次执行第(6)步,成功。

(7)编辑/etc/sysconfig/apache2文件,设置APACHE_SERVERNAME为控制节点名字(与/etc/hosts定义的控制节点名字一致)。

APACHE_SERVERNAME="Controller"(8)创建文件/etc/apache2/conf.d/wsgi-keystone.conf,并添加以下内容。

Listen 5000

Listen 35357

WSGIDaemonProcess keystone-public processes=5 threads=1 user=keystone group=keystone display-name=8{GROUP}

WsGIProcessGroup keystone-public

WSGIScriptAlias / /usr/bin/keystone-wsgi-public

WSGIApplicationGroup %(GLOBAL)

WSGIPassAuthorization On

= 2.4>

ErrorLogFormat "&(cu)t 8M"

ErrorLog/var/log/apache2/keystone.log

CustomLog /var/log/apache2/keystone_access.log combined

= 2.4>

Require all granted

Order allow,deny

Allow from all

WSGIDaemonProcess keystone-admin processes-5 threads-1 user-keystone group=keystone display-name=$(GROUP)

WSGIProcessGroup keystone-admin

WsGIScriptAlias //usr/bin/keystone-wsgi-admin

WSGIApplicationGroup &[GLOBAL]

WSGIPassAuthorization On

=2.4>

ErrorLogFormat "S(cu)t $M"

ErrorLog/var/log/apache2/keystone.log

CustomLog /var/log/apache2/keystone_access.log combined

= 2.4>

Require all granted

Order allow,deny

Allow from all

(9)修改 /etc/keystone目录及该目录下所有文件的属主

# chown -R keystone:keystone /etc/keystone (10)激活Apache组件mod_version。

# a2enmod version(11)启动Apache HTTP服务并设置为开机自启动。

# systemctl enable apache2.service

# systemctl start apache2.service2、创建 service entity 和 API endpoint

Keystone 身份认证服务组件为 OpenStack 项目中其他服务组件的使用和操作提供了服务目录,任何一个OpenStack项目中的服务组件都需要注册一个service entity和提供多个API endpoint。

1)service entity

OpenStack 中有多个service entity,如Nova计算服务组件、Cinder块存储服务组件、Glance镜像服务组件。它们提供多个endpoint,用户可以通过endpoint访问资源和执行操作。

2)API endpoint

API endpoint 可以是某个进程或者服务,用户可以通过这些进程或者服务访问OpenStack项目中服务组件的API。

1. 准备

首先配置用户操作的环境变量。

(1)配置admin_token。

# export OS_TOKEN=ADMIN_TOKEN之前生成的ADMIN_TOKEN值替换这里的ADMIN_TOKEN。

(2)配置endpoint的通信地址。

export OS_URL=http://controller:35357/v3 (3)配置Keystone 身份认证服务组件的API版本。

# export OS_IDENTITY_API_VERSION=32. 创建过程

创建Keystone身份认证服务组件的service entity:

# openstack service create \

--name keystone --description "OpenStack Identity" identity

Field value

description openstack Identity

enabled True

id 57ecb08c130f4632ac606396a66701ef

name keystone

type identity

注意:此例中的id值是随机生成的,可能不尽相同。

创建Keystone身份认证服务组件的API endpoint:

OpenStack为每个服务组件都提供了三种API endpoint,分别是admin、internal和public。admin API endpoint默认允许修改用户和租户,但是internal和public API endpoint不能。在生产环境中,出于安全考虑,会将三种API endpoint的通信放在独立的网络环境中,public API endpoint用于互联网中的用户管理虚拟机实例,admin API endpoints用于内部管理员管理自己的基础设施,internal API endpoint 用于管理 OpenStack 项目中的各个服务组件。OpenStack项目也支持多个region,简便起见,本例中默认使用一个region(RegionOne)。

接下来开始创建 API endpoint:

# openstack endpoint create --region RegionOne \

identity public http://controller:5000/v2.0

Field value

enabled True

interface 7c0140a19bfb4548bfc086808d14e534

region Regionone

region_id Regionone

service_id 57ecb08c130f4632ac606396a66701ef

service_name keystone

service_type identity

url http://controller:5000/v2.0

# openstack endpoint create --region RegionOne \

identity internal http://controller:5000/v2.0

Field value

enabled True

id bc5bec379c4f4013916df873de7a02d3

interface internal

region Regionone

region_id Regionone

service_id 57ecb08c130f4632ac606396a66701ef

service_name keystone

service_type identity

url http://controller:5000/v2.0#openstack endpoint create --region RegionOne \

identity admin http://controller:35357/v2.0

Field Value

enabled True

id c23227eb685d4d90982f80f6ae48c062

interface admin

region Regionone

region_id Regionone

service_id 57ecb08c130f4632ac606396a66701ef

service_name keystone

service_type identity

url http://controller:35357/v2.0

3、创建项目、用户和角色

Keystone 身份认证服务组件为OpenStack项目中的每个服务组件提供认证服务,这些功能是通过域(domain)、项目(project or tenant)、用户(user)和权限(role)实现的。

注意:

出于简单的目的,本例中使用default domain。

下文对域、项目、用户和权限均使用英文单词,方便学习。

(1)创建一个管理员权限的project、user和role。

● 创建 admin project。

# openstack project create --domain default \

--description "Admin Project" admin

Field value

description Admin Project

domain_id default

enabled True

id efb33dccf25b40b399e92d6351fc7ea9

is_domain False

name admin

parent_id None ● 创建 admin user。

# openstack user create --domain default \

--password-prompt admin

User Password:

Repeat User Password:

Field value

domain_id default

enabled True

id fc3820e9803f46308092b409d6323392

name admin

务必记录好将要或已经创建的用户及其密码。在后续操作中,会频繁使用这些信息。

● 创建 admin role。

# openstack role create admin

Field value

id e089ff227c504e07bda544bc07b0b989

name admin● 将 admin role 赋予 admin project和 admin user。

# openstack role add --project admin --user admin admin(2)创建 service project。

service project 包含 OpenStack 项目中已添加的服务组件的唯一用户。

# openstack project create --domain default \

--description "Service Project" service

Field value

description servige

domain_id default

enabled True

id 8af2565380aa40f1828423d892b60a7e

is_domain False

name service

parent_id None

(3)创建一个非管理员权限 project、user和 role。

● 创建 demo project。

# openstack project create --domain default \

--description "Demo Project" demo

Field value

description Demo Project

domain_id default

enabled True

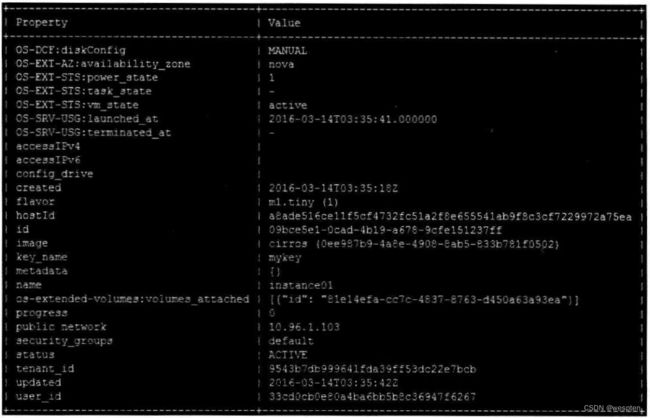

id 9543b7db999641fda39ff53dc22e7bcb

is_domain False

name demo

parent_id None 为 demo project添加 user时,不要重复创建 demo project。

● 创建 demo user。

# openstack user create --domain default \

--password-prompt demo

User Password:

Repeat User Password:

Field value

domain_id default

enabled True

id 33cd0cb0e80a4ba6bb5b8c36947f6267

name demo

● 创建 user role。

# openstack role create user

Field value

id 361c58c26c8c46b49315fb33a3ad5870

name user● 将user role赋予demo project和demo user。

# openstack role add --project demo --user demo user4、检查配置

在进行下一步操作之前,必须确认之前的操作是否正确。以下操作均在控制节点上运行。

(1)出于安全因素的考虑,关闭以下功能。

编辑/etc/keystone/keystone-paste.ini 文件,在[pipeline∶public_api]、[pipeline∶admin_api]和[pipeline∶api_v3]三项删除admin_token_auth。

(2)删除OS_TOKEN和OS_URL两个变量。

# unset OS_TOKEN OS_URL(3)使用 admin 用户申请 authentication token。

# openstack --os-auth-url http://controller:35357/v3 \

--os-project-domain-id default --os-user-domain-id default \

--os-project-name admin --os-username admin \

--os-auth-type password token issue

Password:注意:

在Password处输入admin用户的密码,之前章节已经创建。(4)使用 demo用户申请 authentication token。

# openstack --os-auth-url http://controller:5000/v3 \

--os-project-domain-id default --os-user-domain-id default \

--os-project-name demo --os-username demo --os-auth-type \

password token issue

Password:注意:

在Password处输入demo用户的密码,之前章节已经创建。

同时可以观察到,demo(non-admin)用户和 admin(admin)用户在控制节点上所使用的通信端口号是不同的。

另外,在使用 OpenStack 客户端操作命令输入时,需要定义大量的环境变量,操作复杂。

5、定义 OpenStack 客户端环境变量脚本

在此之前,在 OpenStack 客户端通过环境变量和操作命令相互组合完成了与Keystone 身份认证服务组件的通信。为了提高可操作性和工作效率,可以创建一个统一而完整的openRC文件,其涵盖了通用变量和特殊变量。

1. 创建环境变量脚本

创建 admin project、demo project和用户的环境变量脚本。

(1)创建文件 admin-openrc.sh并添加以下内容。

export OS_PROJECT_DOMAIN_ID=default

export OS_USER_DOMAIN_ID=default

export OS_PROJECT_NAME=admin

export OS_TENANT_NAME=admin

export OS_USERNAME=admin

export OS_PASSWORD=ADMIN_PASS

export OS_AUTH_URL=http://controller:35357/v3

export OS_IDENTITY_API_VERSION=3使用已经生成的 admin user密码替换 ADMIN_PASS。

(2)创建文件demo-openrc.sh并添加以下内容。

export OS_PROJECT_DOMAIN_ID=default

export OS_USER_DOMAIN_ID=default

export OS_PROJECT_NAME=demo

export OS_TENANT_NAME=demo

export OS_USERNAME=demo

export OS_PASSWORD=DEMO_PASS

export OS_AUTH_URL=http://controller:5000/v3

export OS_IDENTITY_API_VERSION=3使用已经生成的demo user密码替换DEMO_PASS。

2. 验证

选择已创建完成的环境变量脚本,进行测试。

(1)加载 admin-openrc.sh 文件,自动生成环境变量。

# source admin-openrc.sh(2)请求 authentication token。

# openstack token issue十一、Glance服务安装配置

Glance镜像服务组件对OpenStack项目很重要,它接收各种API请求,包括磁盘或服务器镜像、用户的元数据定义和Nova计算服务组件调用等。对于保存镜像的存储,存储形式有很多,其中就包括Swift对象存储。

Glance 镜像服务组件中运行很多周期性的进程支持缓存,副本服务保证了数据的一致性和可用性。

1、安装和配置

本节详细描述如何在控制节点上安装和配置Glance镜像服务组件。简单起见,我们使用普通文件系统作为存储镜像的介质。

1. 准备

在安装和配置 Glance 镜像服务组件之前,首先创建数据库、服务证书(service credential)和API endpoint。

(1)创建数据库。

① 在操作系统终端连接数据库。

# mysql -u root -P因为我们使用root用户登录,所以在提示输入密码时,按回车键即可建立连接。

② 创建Glance数据库。

MariaDB [(none)]> CREATE DATABASE glance;③ Glance 数据库的访问权限设置。

GRANT ALL PRIVILEGES ON glance.* TO 'glance'@'localhost' \

IDENTIFIED BY 'GLANCE_DBPASS';

GRANT ALL PRIVILEGES ON glance.* TO 'glance'@'%' \

IDENTIFIED BY 'GLANCE_DBPASS';替换GLANCE_DBPASS为合适的密码。

④ 退出数据库。

(2)加载admin user的环境变量。

# source admin-openrc.sh (3)创建Identity服务凭据。

① 创建Glance用户。

# openstack user create --domain default --password-prompt glance

User Password:

Repeat User Password:

Field value

domain_id default

enabled True

id 2c27875abf014b33949cf5de9ebdf578

name glance② 将 admin role 赋予glance user和service project。

# openstack role add --project service --user glance admin③ 创建Glance镜像的service entity。

# openstack service create --name glance \

--description "OpenStack Image service" image

Field Value

description openstack Image service

enabled True

id bccb49da242d4e3f806f0ca563c19584

name glance

type image(4)创建Glance镜像服务组件的API endpoint。

# openstack endpoint create --region RegionOne \

image public http://Controller:9292

Field Value

enabled True

id db66e030c61144f4a02dff90612dca7b

interface public

region Regionone

region_id Regionone

service_id bccb49da242d4e3f806f0ca563c19584

service_name glance

service_type image

url http://controller:9292

# openstack endpoint create --region Regionone \

image internal http://Controller:9292

Field Value

enabled True

id 8453e2db71ce47cc8ec91f7275fbe464

interface internal

region Regionone

region_id Regionone

service_id bccb49da242d4e3f806f0ca563c19584

service_name glance

service_type image

url http://controller:9292

# openstack endpoint create --region Regionone \

image admin http://Controller:9292

Field Value

enabled True

id 6d42fac1296d47dda665f4ec36b105c1

interface admin

region Regionone

region_id Regionone

service_id bccb49da242d4e3f806f0ca563c19584

service_name glance

service_type image

url http://controller:9292

2. 安装和配置Glance镜像服务组件

下面开始安装和配置Glance镜像服务组件,由于版本不同,可能一些配置文件的内容也不同,需要修改或者添加一些内容。省略号(…)代表配置文件中需要保留的默认配置信息。

(1)安装软件包。

# zypper install openstack-glance python-glanceclient (2)编辑文件/etc/glance/glance-api.conf,完成以下操作。

①在【database】项,配置数据库连接。

[database]

···

connection = mysql+pymysql://glance:GLANCE_DBPASS@Controller/glance 使用已经定义的Glance数据库密码替换GLANCE_DBPASS。

② 在【keystone_authtoken】和【paste_deploy】项,配置Keystone身份认证服务组件访问。

[keystone_authtoken]

···

auth_uri = http://controller:5000

auth_url = http://controller:35357

auth_plugin = password

project_domain_id = default

user_domain_id = default

project_name = service

username = glance

password = GLANCEPASS

[paste_deploy]

···

flavor = keystone使用已经定义的Glance用户密码替换GLANCE_PASS

注意∶

注释或者删除【keystone_authtoken】项中的其他内容。

③ 在【glance_store】项,配置虚拟机镜像的存储形式和存储路径。

[glance_store]

···

default_store = file

filesystem_store_datadir = /var/lib/glance/images/④ 在【DEFAULT】项,关闭 notification driver 功能,设置值为 noop。配置Ceilometer 计量服务组件需要打开该功能。

[DEFAULT]

···

notification_driver = noop⑤ 打开日志记录功能,方便问题跟踪和解决。

[DEFAULT]

···

verbose = True(3)编辑文件/etc/glance/glance-registry.conf,完成以下操作。

① 在[database]项,配置数据库连接。

[database]

…

connection = mysql+pymysql://glance:GLANCE_DBPASS@Controller/glance使用已经定义的Glance数据库密码替换GLANCE_DBPASS。

② 在【keystone_authtoken】和【paste_deploy】项,配置Keystone身份认证服务组件连接。

[keystone_authtoken]

···

auth_uri = http://controller:5000

auth_url = http://controller:35357

auth_plugin = password

project_domain_id = default

user_domain_id = default

project_name = service

username = glance

password = GLANCE_PASS

[paste_deploy]

···

flavor = keystone使用已经定义的Glance用户密码替换GLANCE_PASS。

注意:

注释或者删除【keystone_authtoken】项中的其他内容。

在【DEFAULT】项,关闭 notification_driver 功能,设置值为 noop。配置Ceilometer 计量服务组件需要打开该功能。

[DEFAULT]

···

notification_driver = noop④ 打开日志记录功能,方便问题跟踪和解决。

[DEFAULT]

···

verbose = True3. 安装完成

启动Glance镜像服务组件并设置为开机自启动。

# systemctl enable openstack-glance-api.service \

openstack-glance-registry.service

systemctl start openstack-glance-api.service \

openstack-glance-registry.service2、验证

下面使用一个简单的Linux镜像文件CirrOS测试配置完成的Glance镜像服务组件。以下操作均在控制节点上进行。

(1)在操作系统终端执行以下命令,在admin-openrc.sh和demo-openre.sh文件中增加环境变量值。

# echo "export OS_IMAGE_API_VERSION=2" \

| tee -a admin-openrc,sh demo-openrc.sh (2)加载 admin-openrc.sh文件,自动生成环境变量。

# source admin-openrc.sh(3)下载CirrOS镜像。

# wget \

http://download.cirros-cloud.net/0.3.4/cirros-0.3.4-x86_64-disk.img注意∶

如果wget不能使用,则可能是因为wget软件包没有安装。可以使用rpm-qalgrep-I wget命令检查wget软件包是否安装。

(4)上传CirrOS镜像文件到Glance镜像服务组件中。

# glance image-create --name "cirros" \

--file cirros-0.3.4-x86_64-disk,img \

--disk-format qcow2 --container-format bare \

--visibility public --progress

Property value

checksum eeleca47dc88f4879d8a229cc70a07c6

container_format bare

created_at 2016-02-23T15:04:07Z

disk_format qcow2

id 0ee987b9-4a8e-4908-8ab5-833b781f0502

min_disk 0

min_ram 0

name cirros

owner efb33dccf25b40b399e92d6351fc7ea9

protected False

size 13287936

status active

tags []

updated_at 2016-02-23T15:04:08Z

virtual_size None

visibility public

注意∶

此例中的id值是随机生成的,可能不尽相同。

(5)确认镜像。

# glance image-list

ID Name

Oee987b9-4a8e-4908-8ab5-833b781f0502 cirros十二、Nova服务安装配置

OpenStack项目中的Nova计算服务是Infrastructure as a Service(IaaS)云计算平台的核心服务组件,控制着虚拟机实例和网络功能。通过对用户和项目的设置,管理对OpenStack 云资源的访问。

Nova计算服务组件没有创造新的虚拟化技术(如KVM或Xen等虚拟化技术),而是定义了与底层虚拟化技术进行交互的各种驱动,从而实现更多的功能,通过基于Web的API将这些功能公开。

1、安装和配置(控制节点)

本节详细描述如何在控制节点上安装和配置Nova计算服务组件。

1. 准备

在安装和配置Nova计算服务组件之前,首先创建数据库、服务证书(service credential)和 API endpoint。

(1)创建数据库。

① 在操作系统终端连接数据库。

# mysql -u root -p因为我们使用root用户登录,所以在提示输入密码时,按回车键即可自动建立连接。

② 创建Nova数据库。

MariaDB [(none)]> CREATE DATABASE nova;③ Nova 数据库的访问权限设置。

GRANT ALL PRIVILEGES ON nova,* TO "nova"@'localhost' \

IDENTIFIED BY 'NOVA_DBPASS';

GRANT ALL PRIVILEGES ON nova.* TO 'nova'@'@'%

IDENTIFIED BY 'NOVA_DBPASS';替换NOVA_DBPASS为合适的密码。

④ 退出数据库。

(2)加载admin用户的环境变量。

# source admin-openrc.sh (3)创建认证服务凭据。

① 创建Nova用户。

# openstack user create --domain default --password-prompt nova ② 将 admin role 赋予 glance user和 service project。

# openstack role add --project service --user nova admin③ 创建Nova计算服务service entity。

# openstack service create --name glance \

--description "OpenStack Image service" image (4)创建Nova计算服务组件的API endpoint。

# openstack endpoint create --region RegionOne \

compute public http://Controller:8774/v2/%\(tenant_id\)s# openstack endpoint create --region RegionOne \

compute internal http://Controller:8774/v2/%\(tenant_id\)s# openstack endpoint create --region Regionone \

compute admin http://Controller:8774/v2/%\(tenant_id\)s 2. 安装和配置Nova计算服务组件

下面开始安装和配置 Nova 计算服务组件,由于版本的不同,可能一些配置文件的内容也不同,需要修改或者添加一些内容。省略号(…)代表配置文件中需要保留的默认配置信息。

(1)安装软件包。

#zypper install openstack-nova-api openstack-nova-scheduler \

openstack-nova-cert openstack-nova-conductor \

openstack-nova-consoleauth openstack-nova-novncproxy \

python-novaclient iptables(2)编辑文件/etc/nova/nova.conf,完成以下操作。

① 在【database】项,配置数据库连接。

[database]

···

connection = mysql+pymysql://nova:NOVA_DBPASS@controller/nova 使用已经定义的Nova数据库密码替换NOVA_DBPASS。

② 在【DEFAULT】和【oslo_messaging_rabbit】项,配置RabbitMQ消息队列连接。

[DEFAULT]

···

rpc_backend = rabbit

[oslo_messaging_rabbit]

···

rabbit_host = Controller

rabbit_userid = openstack

rabbit_password = RABBIT_PASS 使用已经在RabbitMQ中定义的OpenStack用户密码替换RABBIT_PASS。

③在【DEFAULT】和【keystone_authtoken】项,配置Keystone身份认证服务组件访问。

[DEFAULT]

···

auth_strategy = keystone

[keystone_authtoken]

···

auth_uri = http://controller:5000

auth_url = http://controller:35357

auth_plugin = password

project_domain_id = default

user_domain_id = default

project_name = service

username = nova

password = NOVA_PASS使用已经定义的Nova用户密码替换NOVA_PASS。

注意:

注释或者删除【keystone_authtoken】项中的其他内容。

④ 在【DEFAULT】项,配置my_ip参数为控制节点的管理/数据网络IP地址。

[DEFAULT]

···

my_ip = 172.168.1.11⑤ 在【DEFAULT】项,定义Nova支持Neutron网络服务组件。

[DEFAULT]

···

network_api_class = nova.network.neutronv2.api.API

security_group_api = neutron

linuxnet_interface_driver = nova.network.linux_net.NeutronLinuxBridge InterfaceDriver

firewall_driver=nova.virt.firewall.NoopFirewallDriver 注意∶

在默认情况下,Nova计算服务组件使用自己的防火墙功能,但是Neutron 网络服务组件也有自己的防火墙,为避免冲突和规则重复设置,需要关闭Nova计算服务组件的防火墙功能。

⑥ 在【vnc】项,配置VNC使用控制节点的管理/数据网络IP地址。

[vnc]

···

vncserver_listen = Smy_ip