Python 爬虫学习笔记(十(5))scrapy的POST请求

创建scrapy文件的步骤和之前一样:

- 创建项目 scrapy startproject 项目的名字

- 跳转到scrapy文件夹的目录下

- 创建爬虫文件

scrapy genspider 爬虫文件的名字

生成文件如图

不难发现,start_url这个链接是无法访问的,原因是它是一个POST请求,POST请求必须依赖参数才能执行。

start_url没有意义了,导致parse方法也没用了

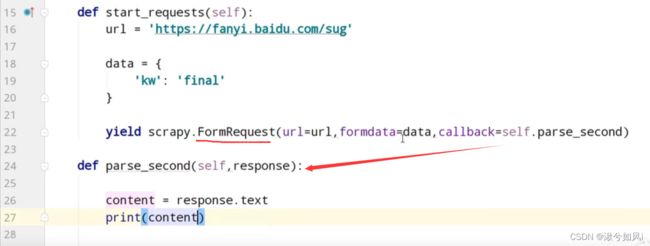

我们必须重新定义一个函数,然后用scrapy的POST请求方法,也就是scrapy.FormRequest去请求这个url,并且传入参数。之后回调parse_second函数来获取内容。

总结

- scrapy的POST请求中start_url没有意义,因为POST请求必须依赖于参数。

- 需自定义函数,使用scrapy.FormRequest来传参数进行POST请求。

- 可以指定callback来对相应内容进行操作。