[Web安全]信息收集

[Web安全]信息收集

- 信息收集

-

- 域名信息的收集

- 网站指纹识别

- 整个网站的分析

- 主机扫描、端口扫描

- 网站敏感目录和文件

- 旁站和C段扫描

- 网站漏洞扫描

信息收集

域名信息的收集

一、真实IP:核心点在CDN上,CDN的存在是为了使用户的网络体验效果更佳,CDN是可以存放一些动态/静态页面的,但是价钱也会更高,同时可以部署WAF等,寻找的真实IP的思路就是绕过CDN,那么绕过CDN又有很多种方式:

step1确定是否存在CDN,很简单,使用不同地方的 ping 服务,查看对应 IP 地址是否唯一,如果不唯一则极有可能是使用了CDN。

ping测试网站:

超级ping

爱站ping

国外ping有些网站不会在国外设置CDN

全球ping

step2 绕过方式

1、查看网站的DNS历史解析记录,然后IP反查看能否解析出域名。也许目标很久之前没有使用CDN,所以可能会存在使用 CDN 前的记录 。

DNS解析

2、可能只会对主站或者流量大的子站点做了 CDN,而很多小站子站点又跟主站在同一台服务器或者同一个C段内,此时就可以通过查询子域名对应的 IP 来辅助查找网站的真实IP。

3、www有cdn,无3w没有cdn。

4、邮件服务器,通过对目标网站注册或者RSS订阅,查看邮件,寻找邮件头中的邮件服务器IP,ping这个邮件服务器域名,可以获得真实IP。

5、Nslookup查询看域名的NS记录、MX记录、TXT记录等很可能指向真实IP或C段服务器。

![[Web安全]信息收集_第1张图片](http://img.e-com-net.com/image/info8/fcd0724d15a64a51bad168018a934e73.jpg)

6、扫描全网

一些站点在搭建之初,会用一些文件测试站点,例如“phpinfo()”文件,此类文件里就有可能包含了真实的IP地址。可以利用Google搜索引擎搜索关键字“site:xxx.com inurl:phpinfo.php”,搜索站点是否有遗留文件。

7、黑暗引擎搜索

shodan

zoomeye

fofa

三、子域名:

eg : www.baidu.com的子域名:www.news.baidu.com

微步在线

提取码:8189挖掘机

网站指纹识别

在渗透测试中,对目标服务器进行指纹识别是相当有必要的,因为只有识别出相应的Web容器或者CMS,才能查找与其相关的漏洞,然后才能进行相应的渗透操作。CMS又称整站系统。常见的CMS有:WordPress、Dedecms、Discuz、PhpWeb、PhpWind、Dvbbs、PhpCMS、ECShop、、SiteWeaver、AspCMS、帝国、Z-Blog等。

BugScaner

云悉指纹

WhatWeb

![[Web安全]信息收集_第3张图片](http://img.e-com-net.com/image/info8/b50cebba0e9a4880b29319818a4338ef.jpg)

整个网站的分析

1、服务器类型

Windows,Linux

一个简单的判断办法就是更改url中英文字母的大小写,如果仍然可以正常访问就是windows,因为在windows中是不做大小写区分的,而linux是严格区分的。

然后我们可以使用nmap扫描OS信息

nmap -O xx.xx.xx.xx

2、数据库类型

Mysql、Access、SQL Sever、Oracle、MongoDB

不同数据库的存储格式是不同的,同一数据库的不同版本会有不同的漏洞以及不同的注入方式。

3、脚本类型

Asp、jsp、php、aspx、python

我们首先可以观察url来判断,我们还可以使用火狐的插件Wappalyzer。

![[Web安全]信息收集_第5张图片](http://img.e-com-net.com/image/info8/820efd5309e648f3811d7b4e88363599.jpg)

4、第三方软件

同样的,我们可以使用nmap扫描到,也可以使用上面的火狐插件。

常见搭配:

ASP+Access;

php+mysql ;

aspx+mysql;

jsp+mysql/oracle;

python+mongodb;

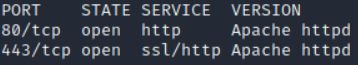

主机扫描、端口扫描

Nessus使用教程

Nmap使用教程

每个人都有自己喜欢的工具,具体选择要根据自身以及实际情况

常见漏洞端口

网站敏感目录和文件

扫描网站目录结构,看看是否可以遍历目录,或者敏感文件泄漏

后台目录:弱口令,万能密码,爆破

安装包:获取数据库信息,甚至是网站源码

上传目录:截断、上传图片马等

mysql管理接口:弱口令、爆破,万能密码,然后脱裤,甚至是拿到shell

安装页面 :可以二次安装进而绕过

phpinfo:会把你配置的各种信息暴露出来

编辑器:fck、ke、等

iis短文件利用:条件比较苛刻 windows、apache等

提到了网站敏感目录我们就不得不提 robots.txt 文件了

robots.txt 文件是专门针对搜索引擎机器人robot 编写的一个纯文本文件。我们可以在这个文件中指定网站中不想被robot访问的目录。这样,我们网站的部分或全部内容就可以不被搜索引擎收录了,或者让搜索引擎只收录指定的内容。因此我们可

以利用robots.txt让Google的机器人访问不了我们网站上的重要文件,GoogleHack的威胁也就不存在了。

假如编写的robots.txt文件内容如下:

User-agent: *

Disallow: /data/

Disallow: /db/

Disallow: /admin/

Disallow: /manager/

Allow:/images/

其中“Disallow”参数后面的是禁止robot收录部分的路径,例如我们要让robot禁止收录网站目录下的“data”文件夹,只需要在Disallow参数后面加上 /data/ 即可。如果想增加其他目录,只需按此格式继续添加。文件编写完成后将其上传到网站的根目录,就可以让网站远离Google Hack了。

虽然robots文件目的是让搜索蜘蛛不爬取想要保护的页面,但是如果我们知道了robots文件的内容的话,我们就可以知道目标网站哪些文件夹不让访问,从侧面说明这些文件夹是很重要的了。

御剑+大量字典下载 提取码:8189

网站目录扫描工具博客

旁站和C段扫描

旁站:同服务器不同站点 百度工具查询 C站 百度工具查询

前提条件:多个站点服务器

服务器:

192.168.1.100

www.a.com(目标)

www.b.com(打他也行)

独立站点服务器

C段:同网段的不同服务器不同站点

192.168.1.100

www.a.com(目标)

www.b.com(也搞不了)

192.168.1.101

www.c.com(可以搞他)

www.d.com(可以搞他)

旁站和C段在线查询地址:

webscan

站长之家同IP查询

网站漏洞扫描

AWVS

Goby

Xray

Nessus

SqlMap

…

![[Web安全]信息收集_第2张图片](http://img.e-com-net.com/image/info8/b6e8628c4a85476b8c27454937e47eb2.jpg)

![[Web安全]信息收集_第4张图片](http://img.e-com-net.com/image/info8/1bf426e435fb4dc08d83fc3d6ef56bd8.jpg)