抱抱脸(hugging face)教程-中文翻译-模型概要

模型概要

这是一个总结的模型可在Transformers。假设您熟悉最初的Transformers模型。或者温柔的介绍,看看有注释的Transformers。在我们关注模特之间的高度差异之前。你可以在他们各自的文件中,更详细地检查他们。查看 Model Hub,在这里可以根据模型体系结构查看checkpoints。

Each one of the models in the library falls into one of the following categories:

library 的每一个模型都属于以下类别之一:

- autoregressive-models 自回归模型

- autoencoding-models 自动编码模型

- seq-to-seq-models seq-to-seq-models

- multimodal-models 多模式模型

- retrieval-based-models 基于检索的模型

自回归模型在经典的语言建模任务上进行了预训练: 在阅读了所有前面的标记之后,猜测下一个标记。它们对应于原始变换模型的解码器,并且在整个句子的顶部使用了一个mask,这样注意力头脑只能看到文本中的前面,而不是后面。尽管可以对这些模型进行微调,并在许多任务上取得很好的结果,但最自然的应用程序是文本生成。这种模型的一个典型例子是 GPT。

自动编码模型通过以某种方式损坏输入标记并尝试重构原始句子来进行预训练。他们对应的编码器的原始Transformers模型的意义上,他们得到的全部输入没有任何掩码。这些模型通常构建整个句子的双向表示。它们可以进行微调,并在文本生成等许多任务上取得很好的效果,但它们最自然的应用是句子分类或标记分类。这种模型的一个典型例子是 BERT。

注意,自回归模型和自编码模型之间的唯一区别在于模型的预训练方式。因此,同样的体系结构可以用于自回归和自编码模型。当一个给定的模型被用于这两种类型的预训练时,我们已经将它放在与第一次介绍它的文章相对应的类别中。

序列到序列模型使用原始转换器的编码器和解码器,用于转换任务或将其他任务转换为序列到序列问题。它们可以很好地适应许多任务,但它们最自然的应用是翻译、摘要和问答。原始的转换器模型就是这种模型的一个示例(仅用于转换) ,t5是一个可以针对其他任务进行微调的示例。

多模态模型将文本输入与其他类型(例如图像)混合在一起,并且对于给定的任务更加具体。

译码器或自回归模型

如前所述,这些模型依赖于原始Transformers的解码部分,并使用注意力掩码,因此在每个位置上,模型只能在注意力头部之前查看令牌。

GPT

Improving Language Understanding by Generative Pre-Training, Alec Radford et al.

第一个基于Transformers架构的自回归模型数据库,以书本语料库数据集为基础进行预先训练。

该库为语言建模和多任务语言建模/多选择分类提供模型版本。

GPT-2

Language Models are Unsupervised Multitask Learners, Alec Radford et al.

一个更大更好的 GPT 版本,在 WebText 上预先训练(从 Reddit 的外部链接获得的网页,有3个或更多的功效)。

该库为语言建模和多任务语言建模/多选择分类提供模型版本。

CTRL

CTRL: A Conditional Transformer Language Model for Controllable Generation, Nitish Shirish Keskar et al.

与 GPT 模型相同,但增加了控制代码的思想。文本由一个提示符(可以是空的)和一个(或多个)控制代码生成,然后用于影响文本生成: 以维基百科文章、书籍或电影评论的风格生成。

该库仅提供了一个用于语言建模的模型版本。

Transformer-XL

Transformer-XL: Attentive Language Models Beyond a Fixed-Length Context, Zihang Dai et al.

与规则 GPT 模型相同,但引入了两个连续段的递归机制(类似于两个连续输入的规则 RNNs)。在这个上下文中,一个段是许多可能跨越多个文档的连续标记(例如512) ,并且段被提供给模型。

基本上,前一个片段的隐藏状态被连接到当前的输入来计算注意力分数。这使得模型能够关注前一个片段中的信息以及当前片段中的信息。通过叠加多个注意层,感受野可以增加到多个先前的部分。

这将位置嵌入改为位置相对嵌入(因为规则的位置嵌入将在当前输入和给定位置的当前隐藏状态中给出相同的结果) ,并且需要对计算注意力得分的方式进行一些调整。

该库仅提供了一个用于语言建模的模型版本。

Reformer

Reformer: The Efficient Transformer, Nikita Kitaev et al .

这是一个自回归Transformers模型,它有许多减少内存占用和计算时间的技巧,包括:

- 使用轴向位置编码(详见下文)。这是一种机制,通过将序列长度分解成更小的矩阵来避免拥有一个庞大的位置编码矩阵(当序列长度非常大时)。

- 用 LSH (局部敏感散列)注意力代替传统注意力(详见下文)。这是一种避免在注意力层计算完整产品查询键的技术。

- 避免存储每一层的中间结果,使用可逆的Transformers层在后向通过期间获得它们(从下一层的输入减去残差返回它们)或重新计算结果在一个给定的层(低于存储它们的效率,但节省内存)。

- 按块而不是整个批处理计算前馈操作。

有了这些技巧,该模型可以输入比传统的Transformers自回归模型大得多的句子。

这个模型可以很好地用于自动编码设置,但是还没有这样的预训练checkpoints。

该库仅提供了一个用于语言建模的模型版本。

XLNet

XLNet: Generalized Autoregressive Pretraining for Language Understanding, Zhilin Yang et al.

不是一个传统的自回归模型,但是使用了一个基于此的培训策略。它改变句子中的记号,然后允许模型使用最后的 n 记号来预测记号 n + 1。由于所有这些都是通过掩码完成的,所以句子实际上是按照正确的顺序在模型中输入的,但是 XLNet 使用了一个掩码来隐藏前面的标记,这个掩码在给定的1,… ,序列长度的排列中隐藏了前面的标记。

XLNet 还使用与 Transformer-XL 相同的递归机制来构建长期依赖关系。

该模型库提供了语言建模、标记分类、句子分类、多项选择分类和问题回答模型的一个版本。

Encoders or autoencoding models

如前所述,这些模型依赖于原始Transformers的编码器部分,并且不使用掩码,因此模型可以查看注意头中的所有令牌。对于预训练,目标是原始的句子,输入是其损坏的版本。

BERT 伯特

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding, Jacob Devlin et al.

通过使用随机掩蔽来破坏输入,更准确地说,在预训练期间,掩蔽给定百分比的令牌(通常为15%) :

- 一个概率为0.8的特殊掩码令牌

- 一个不同于0.1概率掩码的随机令牌

- 概率为0.1的同样的符号

模型必须预测原始句子,但有第二个目标: 输入是两个句子 a 和 b (中间有一个分离标记)。概率为50% 时,语料库中的句子是连续的,其余50% 的句子是无关的。该模型必须预测句子是否是连续的。

该库提供了语言建模(传统的或掩蔽的)、下一个句子预测、标记分类、句子分类、多项选择分类和问题回答模型的一个版本。

ALBERT

ALBERT: A Lite BERT for Self-supervised Learning of Language Representations, Zhenzhong Lan et al.

和 BERT 一样,只是稍微调整了一下:

- 嵌入大小 e 不同于隐藏大小 h,因为嵌入是上下文无关的(一个嵌入向量代表一个令牌) ,而隐藏状态是上下文无关的(一个隐藏状态代表一系列令牌) ,所以嵌入矩阵 h > e 更符合逻辑。如果 e < h,则参数较少。

- 层被分成共享参数的组(以节省内存)。

- 下一个句子的预测被一个句子的顺序预测所取代: 在输入中,我们有两个句子 a 和 b (是连续的) ,我们要么给 a 加上 b,要么给 b 加上 a。模型必须预测它们是否被交换。

该库提供了一个模型的版本,用于掩码语言建模、标记分类、句子分类、多项选择分类和问题回答。

RoBERTa 罗伯塔

RoBERTa: A Robustly Optimized BERT Pretraining Approach, Yinhan Liu et al.

和 BERT 一样,有更好的训练前技巧:

- 动态屏蔽: 每个纪元的屏蔽标记都不同,而 BERT 一劳永逸地做到这一点

- 没有 NSP (下一句预测)的丢失,而不是把两个句子放在一起,把一块连续的文本一起达到512个标记(所以句子的顺序比可能跨越几个文档)

- 大批量的训练

- 使用带字节的 BPE 作为子单元,而不是字符(因为 unicode 字符)

该库提供了一个模型的版本,用于掩码语言建模、标记分类、句子分类、多项选择分类和问题回答。

DistilBERT

DistilBERT, a distilled version of BERT: smaller, faster, cheaper and lighter, Victor Sanh et al.

和 BERT 一样,但是更小。通过提取预先训练的 BERT 模型进行训练,这意味着它被训练来预测与较大模型相同的概率。实际目标是:

- 找到与老师模型相同的概率

- 正确地预测掩码符号(但没有下一句目标)

- 学生隐藏状态和教师模型之间的余弦距离

该模型库提供了掩码语言建模、标记分类、句子分类和问答模型的一个版本。

ConvBERT

ConvBERT: Improving BERT with Span-based Dynamic Convolution, Zihang Jiang, Weihao Yu, Daquan Zhou, Yunpeng Chen, Jiashi Feng, Shuicheng Yan.

像 BERT 及其变体这样事先训练过的语言模型最近在各种自然语言理解任务中取得了令人印象深刻的表现。然而,BERT 在很大程度上依赖于全局自注意块,因此会产生大量的内存占用和计算开销。虽然所有的注意力都集中在从全局角度生成注意力图的整个输入序列上,但我们观察到一些注意力只需要学习局部依赖性,这意味着存在计算冗余。因此,我们提出了一种新的基于广度的动态卷积来替代这些自注意头,直接对局部相关性建模。新的卷积头和其他自注意头构成了一个新的混合注意块,在全局和局部上下文学习中都更有效。我们用这种混合注意设计装备了 BERT,并建立了一个 ConvBERT 模型。实验表明,ConvBERT 在各种下游任务中的训练成本较低,模型参数较少,显著优于 BERT 及其变种。显著地,ConvBERTbase 模型获得了86.4 GLUE 评分,比 ELECTRAbase 高0.7分,而使用的训练成本低于1/4。

该模型库提供了掩码语言建模、标记分类、句子分类和问答模型的一个版本。

XLM

Cross-lingual Language Model Pretraining, Guillaume Lample and Alexis Conneau

用多种语言训练的Transformers模型。这个模型有三种不同类型的培训,library为所有这些培训提供了checkpoints:

- 因果语言建模(CLM)是传统的自回归训练(因此该模型也可以放在前面的部分)。为每个训练样本选择一种语言,并且模型输入是一个包含256个标记的句子,这些标记可以跨越这些语言中的一种语言的多个文档。

- 蒙面语言建模(MLM) ,类似于 RoBERTa。为每个训练样本选择一种语言,模型输入是一个包含256个标记的句子,这些标记可以跨越多个文档,使用其中一种语言,并动态屏蔽标记。

- 结合传销和翻译语言建模(TLM)。这包括用随机屏蔽连接两种不同语言的句子。为了预测其中一个屏蔽标记,模型可以同时使用语言1中周围的上下文和语言2给出的上下文。

checkpoints是指以 clm、 mlm 或 mlm-tlm 的名字命名的用于预训练的方法。除了位置嵌入之外,模型还有语言嵌入。当训练使用传销/CLM,这给了模型一个指示的语言使用,当训练使用传销 + tlm,一个指示的语言使用的每个部分。

该库为语言建模、标记分类、句子分类和问答提供了模型的一个版本。

XLM-RoBERTa

Unsupervised Cross-lingual Representation Learning at Scale, Alexis Conneau et al.

在 XLM 方法上使用 RoBERTa 技巧,但不使用翻译语言建模目标。它只对来自一种语言的句子使用掩蔽语言模型。然而,该模型受训于更多的语言(100) ,并且没有使用语言嵌入,因此它能够自行检测输入语言。

该库提供了一个模型的版本,用于掩码语言建模、标记分类、句子分类、多项选择分类和问题回答。

FlauBERT

FlauBERT: Unsupervised Language Model Pre-training for French, Hang Le et al.

像罗伯塔,没有句子顺序的预测(所以只是训练传销的目标)。

该库为语言建模和句子分类提供了模型的一个版本。

ELECTRA

ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators, Kevin Clark et al.

ELECTRA 是一个使用另一个(小)掩码语言模型预先训练的Transformers模型。输入被该语言模型损坏,该语言模型接受一个随机屏蔽的输入文本,并输出一个文本,其中 ELECTRA 必须预测哪个标记是原始标记,哪个标记已被替换。与 GAN 培训一样,对小语言模型进行几个步骤的培训(但以原始文本为目标,不要像在传统 GAN 设置中那样欺骗 ELECTRA 模型) ,然后对 ELECTRA 模型进行几个步骤的培训。

该库提供了模型的一个版本,用于掩码语言建模、标记分类和句子分类。

Funnel Transformer

Funnel-Transformer: Filtering out Sequential Redundancy for Efficient Language Processing, Zihang Dai et al.

漏斗Transformers是一个使用池的Transformers模型,有点像 ResNet 模型: 层以块分组,在每个块的开始(除了第一个) ,隐藏状态在序列维之间池。这样,它们的长度除以2,这加快了下一个隐状态的计算。所有预先训练的模型都有三个块,这意味着最终的隐藏状态的序列长度是原始序列长度的四分之一。

对于诸如分类之类的任务,这不是问题,但是对于屏蔽语言建模或令牌分类之类的任务,我们需要一个与原始输入具有相同序列长度的隐藏状态。在这些情况下,最终的隐状态被提取到输入序列长度,并通过另外两层。这就是为什么每个checkpoints有两个版本的原因。后缀为“-base”的版本只包含三个块,而没有后缀的版本包含三个块和上采样头及其附加层。

现有的预训练模型使用与 ELECTRA 相同的预训练目标。

该库提供了一个模型的版本,用于掩码语言建模、标记分类、句子分类、多项选择分类和问题回答。

Longformer

Longformer: The Long-Document Transformer, Iz Beltagy et al.

用稀疏矩阵代替注意矩阵的变换器模型。通常是本地上下文(例如,左右两个标记是什么?)就足以对一个给定的标记采取行动。一些预选输入标记仍然给予全局关注,但是关注矩阵的参数少,导致了速度的提高。更多信息请参见本地注意部分。

它的预先训练方式与 RoBERTa 相同。

这个模型可以很好地用于自回归设置,但是还没有这样的预训练checkpoints。

该库提供了一个模型的版本,用于掩码语言建模、标记分类、句子分类、多项选择分类和问题回答。

Sequence-to-sequence models

如前所述,这些模型保留了原始Transformers的编码器和解码器。

BART

BART: Denoising Sequence-to-Sequence Pre-training for Natural Language Generation, Translation, and Comprehension, Mike Lewis et al.

带有编码器和解码器的序列到序列模型。编码器被输入一个损坏的令牌版本,解码器被输入原始令牌(但是有一个掩码来隐藏未来的单词,就像一个普通的Transformers解码器)。对编码器的预训练任务采用以下变换组合:

- 掩码随机标记(如 BERT)

- 删除随机符号

- 使用一个掩码令牌掩码一个跨度为 k 的令牌(跨度为0的令牌是一个掩码令牌的插入)

- 置换句子

- 旋转文档使其从特定的标记开始

该库提供了该模型的一个版本,用于条件生成和序列分类。

Pegasus

PEGASUS: Pre-training with Extracted Gap-sentences forAbstractive Summarization, Jingqing Zhang, Yao Zhao, Mohammad Saleh and Peter J. Liu on Dec 18, 2019.

序列到序列模型与 BART 具有相同的编解码器模型结构。Pegasus 是在两个自监督目标函数(掩蔽语言建模(MLM)和一个新的摘要特定的预训练目标(GSG)上联合训练的。

- MLM: 编码器输入令牌被掩码令牌随机替换,必须由编码器预测(如 BERT)

- 整个编码器输入的句子被第二个掩码标记替换并输入到解码器,但是它有一个因果掩码来隐藏未来的单词,就像一个常规的自回归变换器解码器。

与 BART 不同的是,Pegasus 的预训练任务有意地类似于摘要: 重要的句子被屏蔽,并作为剩余句子的一个输出序列生成在一起,类似于提取性摘要。

该库为条件生成提供了这个模型的一个版本,应该用于摘要。

MarianMT

Marian: Fast Neural Machine Translation in C++, Marcin Junczys-Dowmunt et al.

一个翻译模型框架,使用与 BART 相同的模型

该库为条件生成提供了这个模型的一个版本。

T5

Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer, Colin Raffel et al.

使用传统的转换器模型(在每个层中学习的位置嵌入略有更改)。为了能够操作所有的 NLP 任务,它通过使用特定的前缀将它们转换为文本到文本的问题: “ summarize:”,“ question:”,“ translate English To German:”等等。

预训包括监督训练和自我监督训练。对 GLUE 和 SuperGLUE 基准测试提供的下游任务进行监督培训(如上所述,将其转换为文本到文本的任务)。

自我监督训练使用损坏的代币,随机删除15% 的代币,代之以单独的哨兵代币(如果若干个连续的代币被标记要删除,则整组代币将被一个哨兵代币所替代)。编码器的输入是损坏的句子,解码器的输入是原始句子,然后目标是由它们的哨兵符号分隔的掉出的标记。

例如,如果我们有句子“我的狗非常可爱。”,我们决定删除令牌: “ dog”、“ is”和“ cute”,编码器输入变为“ My < x > very < y >”目标输入变成“ < x > 狗狗 < y > 可爱。< z >

该库为条件生成提供了这个模型的一个版本。

MT5

mT5: A massively multilingual pre-trained text-to-text transformer, Linting Xue et al.

模型体系结构与 t5相同。Mt5的前期训练目标包括 t5的自我监督训练,而不包括 t5的监督训练。Mt5接受了101种语言的培训。

该库为条件生成提供了这个模型的一个版本。

MBart

Multilingual Denoising Pre-training for Neural Machine Translation by Yinhan Liu, Jiatao Gu, Naman Goyal, Xian Li, Sergey Edunov Marjan Ghazvininejad, Mike Lewis, Luke Zettlemoyer.

模型体系结构和预训练目标与 BART 相同,但 MBart 接受过25种语言的训练,主要用于有监督和无监督的机器翻译。MBart 是第一个通过去除多语言全文中的噪声来预训练完全序列到序列模型的方法之一,

该库为条件生成提供了这个模型的一个版本。

Mbart-large-en-ro checkpoints可用于英语-罗马尼亚语翻译。

Mbart-large-cc25checkpoints可以使用示例/pytorch/translation/中的代码来完成其他翻译和摘要任务,但是如果不使用 finetuning,它就不是很有用。

ProphetNet

ProphetNet: Predicting Future N-gram for Sequence-to-Sequence Pre-training, by Yu Yan, Weizhen Qi, Yeyun Gong, Dayiheng Liu, Nan Duan, Jiusheng Chen, Ruofei Zhang, Ming Zhou.

先知网引入了一种新的序列到序列的预训练目标,称为未来 n 元预测。在未来的 n-gram 预测中,该模型在每个时间步骤中根据前一个上下文标记同时预测下一个 n 个标记,而不是仅仅预测下一个标记。未来的 n 元预测显式地鼓励模型为未来的标记做计划,并防止对强的局部相关性的过度拟合。该模型结构基于原有的 Transformer,但是通过一个主要的自注意机制和一个自我和 n 流(预测)自注意机制取代了解码器中的“标准”自注意机制。

该库为条件生成提供了该模型的预训练版本,为摘要提供了精调版本。

XLM-ProphetNet

ProphetNet: Predicting Future N-gram for Sequence-to-Sequence Pre-training, by Yu Yan, Weizhen Qi, Yeyun Gong, Dayiheng Liu, Nan Duan, Jiusheng Chen, Ruofei Zhang, Ming Zhou.

Xlm-preformtnet 的模型体系结构和预训练目标与 preventnet 相同,但是 xlm-preventnet 是在跨语言数据集 XGLUE 上预训练的。

该库为多语言条件生成提供了该模型的预训练版本,为标题生成和问题生成分别提供了微调版本。

Multimodal models

There is one multimodal model in the library which has not been pretrained in the self-supervised fashion like the others.

library存在一个多模态模型,它没有像其他模型一样以自监督的方式进行预训练。

MMBT

Supervised Multimodal Bitransformers for Classifying Images and Text, Douwe Kiela et al.

一种用于多通道设置的Transformers模型,将文本和图像结合起来进行预测。转换器模型的输入为标记文本的嵌入以及经过线性层(从转换器末端的特征数到转换器的隐藏状态维)的预训练图像资源(在汇聚层之后)的最终激活。

不同的输入被连接起来,并且在位置嵌入的顶部添加了一个段嵌入,让模型知道输入向量的哪一部分对应文本,哪一部分对应图像。

预先训练的模型只适用于分类。

Retrieval-based models

例如,一些模型在(预)训练过程中使用文档检索和推理来进行开放域问题回答。

DPR

Dense Passage Retrieval for Open-Domain Question Answering, Vladimir Karpukhin et al.

面向开放域问答的密文检索。

密集段检索(DPR)是一组用于开放领域问答研究的工具和模型。

DPR 包括三种模式:

- 问题编码器: 将问题编码为向量

- 上下文编码器: 将上下文编码为向量

- Reader: 在检索到的上下文中提取问题的答案,以及相关性得分(如果推断的跨度实际上回答了问题,那么相关性得分会很高)。

DPR 的管道(尚未实现)使用一个检索步骤来查找给定问题的前 k 上下文,然后它调用带有问题的读者和检索到的文档来获得答案。

RAG

Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks, Patrick Lewis, Ethan Perez, Aleksandara Piktus, Fabio Petroni, Vladimir Karpukhin, Naman Goyal, Heinrich Küttler, Mike Lewis, Wen-tau Yih, Tim Rocktäschel, Sebastian Riedel, Douwe Kiela

检索增强生成(RAG)模型结合了预训练稠密检索(DPR)和 Seq2Seq 模型的优点。RAG 模型检索文档,将其传递给 seq2seq 模型,然后边缘化以生成输出。检索器和 seq2seq 模块由预先训练的模型初始化,并联合进行微调,允许检索和生成适应下游任务。

两个模型 RAG-Token 和 RAG-Sequence 可用于生成。

更多的技术方面

全神贯注 vs 疏忽注意

大多数Transformers模型在注意力矩阵是正方形的意义上使用全部注意力。当你有很长的文本时,这可能是一个很大的计算瓶颈。Longformer 和 reformer 模型是利用注意矩阵的稀疏性来提高训练效率的模型。

LSH attention

改革者应注意 LSH。在软极大(QK ^ t)中,只有矩阵 QK ^ t 的最大元素(在软极大维数中)才能给出有用的贡献。所以对于 q 中的每个查询,我们只能考虑 k 中接近 q 的键。哈希函数用于确定 q 和 k 是否接近。注意掩码被修改为屏蔽当前令牌(除了第一个位置) ,因为它将提供一个查询和一个相等的键(因此彼此非常相似)。由于哈希可以是有点随机的,所以在实践中使用了几个哈希函数(由 n _ rounds 参数确定) ,然后将它们平均在一起。

Local attention

Longformer 使用本地注意力: 通常是本地上下文(例如,左右两个标记是什么?)就足以对一个给定的标记采取行动。另外,通过将有一个小窗口的注意力层叠加起来,最后一层将有一个比窗口中的标记更多的接受域,允许它们构建一个整个句子的表示。

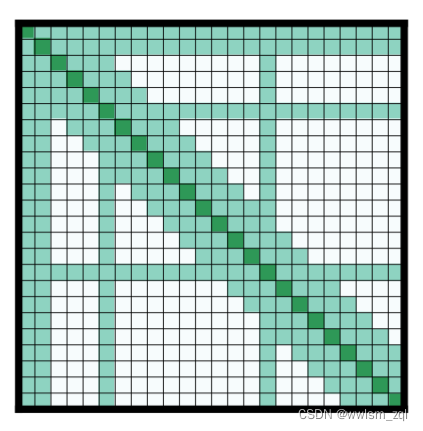

一些预选输入令牌也得到了全局关注: 对于这些少数令牌,关注矩阵可以访问所有令牌,这个过程是对称的: 所有其他令牌都可以访问这些特定令牌(在其本地窗口中的令牌之上)。如图2d 所示,下面是一个注意力蒙版的例子:

使用那些参数较少的注意力矩阵,然后允许模型有更大的序列长度的输入。

其他技巧

轴向位置编码

重整器采用轴向位置编码: 在传统的Transformers模型中,位置编码 e 是一个尺寸 l 乘以 d 的矩阵,l 是序列长度,d 是隐藏状态的维数。如果你有很长的文本,这个矩阵可以是巨大的,占用太多的 GPU 空间。为了改善这种情况,轴向位置编码包括对两个较小的矩阵 e1和 e2中的大矩阵 e 进行因式分解,其维数 l _ {1}乘以 d _ {1}乘以 d _ {1}乘以 d _ {1 × d _ 1,l _ {2}乘以 d _ {2 × d _ 2,使得 l _ {1}乘以 l _ {2} = l _ 1 × l _ 2 = l,d _ {1} = d _ 1 + d _ 2 = d _ 1 + d _ 2 = d (长度的乘积最终小得多)。将时间步长 j% l1 j% l1在 e1中和时间步长 j/l1 j/l1在 e2中的嵌入连接起来,得到了时间步长 j 在 e 中的嵌入。

本文是抱抱脸(Hugging Face)教程中文翻译,仅学习使用

原文链接