CBAM: Convolutional Block Attention Module

原文

代码

引用

https://blog.csdn.net/u013289254/article/details/99607860

思考

在Resnet50中插入attention机制提高了网络的特征提取能力

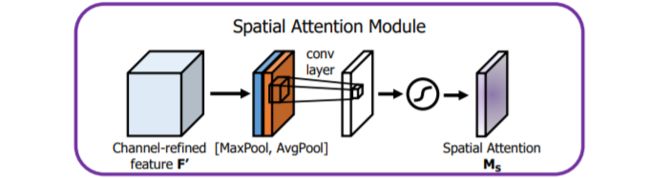

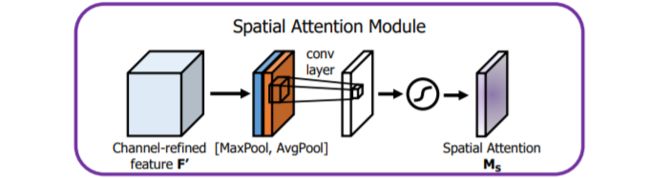

空间注意力机制:在下图中,MaxPool的操作就是在通道上提取最大值,提取的次数是高乘以宽;AvgPool的操作就是在通道上提取平均值,提取的次数也是是高乘以宽;接着将前面所提取到的特征图(通道数都为1)合并得到一个2通道的特征图,后面的操作比较简单,就不介绍了。