改进YOLOv7系列:23.YOLOv7添加CBAM注意力机制

-

统一使用 YOLOv5 代码框架,结合不同模块来构建不同的YOLO目标检测模型。

-

本项目包含大量的改进方式,降低改进难度,改进点包含

【Backbone特征主干】、【Neck特征融合】、【Head检测头】、【注意力机制】、【IoU损失函数】、【NMS】、【Loss计算方式】、【自注意力机制】、【数据增强部分】、【标签分配策略】、【激活函数】等各个部分, -

可以排列组合上千种模块 不同的搭配 (推荐)

-

同时

附带各种改进点原理及对应的代码改进方式教程,用户可根据自身情况快速排列组合,在不同的数据集上实验, 应用组合写论文!

fork 和 star,持续同步更新完善

文章目录

-

- YOLOv5、YOLOv7 + 注意力机制一览

-

- 之后继续更新

- 第一种、YOLOv7使用CBAM注意力机制

-

- CBAM注意力机制原理图

- 1.1增加以下CBAM.yaml文件

- 1.2common.py配置

- 1.3yolo.py配置

- 1.4训练模型

- 往期YOLO改进教程导航

YOLOv5、YOLOv7 + 注意力机制一览

YOLOv5 + ShuffleAttention注意力机制

博客链接:改进YOLOv5系列:12.添加ShuffleAttention注意力机制

YOLOv5 + CrissCrossAttention注意力机制

博客链接:改进YOLOv5系列:13.添加CrissCrossAttention注意力机制

YOLOv5 + S2-MLPv2注意力机制

博客链接:改进YOLOv5系列:14.添加S2-MLPv2注意力机制

YOLOv5 + SimAM注意力机制

博客链接:改进YOLOv5系列:15.添加SimAM注意力机制

YOLOv5 + SKAttention注意力机制

博客链接:改进YOLOv5系列:16.添加SKAttention注意力机制

YOLOv5 + NAMAttention注意力机制

博客链接:改进YOLOv5系列:17.添加NAMAttention注意力机制

YOLOv5 + SOCA注意力机制

博客链接:改进YOLOv5系列:18.添加SOCA注意力机制

YOLOv5 + CBAM注意力机制

博客链接:改进YOLOv5系列:18.添加CBAM注意力机制

YOLOv5 + SEAttention注意力机制

博客链接:改进YOLOv5系列:19.添加SEAttention注意力机制

YOLOv5 + GAMAttention注意力机制

博客链接:改进YOLOv5系列:20.添加GAMAttention注意力机制

YOLOv5 + CA注意力机制

博客链接:github

YOLOv5 + ECA注意力机制 博客链接:github

更多模块详细解释持续更新中。。。

之后继续更新

第一种、YOLOv7使用CBAM注意力机制

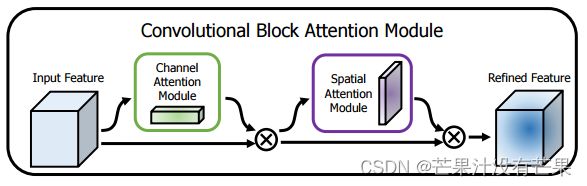

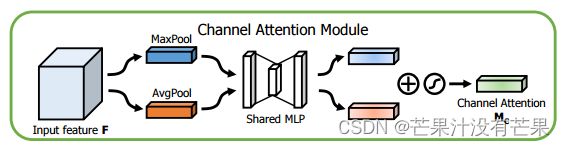

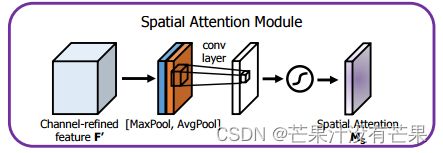

CBAM注意力机制原理图

1.1增加以下CBAM.yaml文件

# YOLOv7 , GPL-3.0 license

# parameters

nc: 80 # number of classes

depth_multiple: 0.33 # model depth multiple

width_multiple: 1.0 # layer channel multiple

# anchors

anchors:

- [12,16, 19,36, 40,28] # P3/8

- [36,75, 76,55, 72,146] # P4/16

- [142,110, 192,243, 459,401] # P5/32

# yolov7 backbone by yoloair

backbone:

# [from, number, module, args]

[[-1, 1, Conv, [32, 3, 1]], # 0

[-1, 1, Conv, [64, 3, 2]], # 1-P1/2

[-1, 1, Conv, [64, 3, 1]],

[-1, 1, Conv, [128, 3, 2]], # 3-P2/4

[-1, 1, CNeB, [128]],

[-1, 1, Conv, [256, 3, 2]],

[-1, 1, MP, []],

[-1, 1, Conv, [128, 1, 1]],

[-3, 1, Conv, [128, 1, 1]],

[-1, 1, Conv, [128, 3, 2]],

[[-1, -3], 1, Concat, [1]], # 16-P3/8

[-1, 1, Conv, [128, 1, 1]],

[-2, 1, Conv, [128, 1, 1]],

[-1, 1, Conv, [128, 3, 1]],

[-1, 1, Conv, [128, 3, 1]],

[-1, 1, Conv, [128, 3, 1]],

[-1, 1, Conv, [128, 3, 1]],

[[-1, -3, -5, -6], 1, Concat, [1]],

[-1, 1, Conv, [512, 1, 1]],

[-1, 1, MP, []],

[-1, 1, Conv, [256, 1, 1]],

[-3, 1, Conv, [256, 1, 1]],

[-1, 1, Conv, [256, 3, 2]],

[[-1, -3], 1, Concat, [1]],

[-1, 1, Conv, [256, 1, 1]],

[-2, 1, Conv, [256, 1, 1]],

[-1, 1, Conv, [256, 3, 1]],

[-1, 1, Conv, [256, 3, 1]],

[-1, 1, Conv, [256, 3, 1]],

[-1, 1, Conv, [256, 3, 1]],

[[-1, -3, -5, -6], 1, Concat, [1]],

[-1, 1, Conv, [1024, 1, 1]],

[-1, 1, MP, []],

[-1, 1, Conv, [512, 1, 1]],

[-3, 1, Conv, [512, 1, 1]],

[-1, 1, Conv, [512, 3, 2]],

[[-1, -3], 1, Concat, [1]],

[-1, 1, CNeB, [1024]],

[-1, 1, Conv, [256, 3, 1]],

]

# yolov7 head by yoloair

head:

[[-1, 1, SPPCSPC, [512]],

[-1, 1, Conv, [256, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[31, 1, Conv, [256, 1, 1]],

[[-1, -2], 1, Concat, [1]],

[-1, 1, C3C2, [128]],

[-1, 1, Conv, [128, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[18, 1, Conv, [128, 1, 1]],

[[-1, -2], 1, Concat, [1]],

[-1, 1, C3C2, [128]],

[-1, 1, MP, []],

[-1, 1, Conv, [128, 1, 1]],

[-3, 1, CBAM, [128]],

[-1, 1, Conv, [128, 3, 2]],

[[-1, -3, 44], 1, Concat, [1]],

[-1, 1, C3C2, [256]],

[-1, 1, MP, []],

[-1, 1, Conv, [256, 1, 1]],

[-3, 1, Conv, [256, 1, 1]],

[-1, 1, Conv, [256, 3, 2]],

[[-1, -3, 39], 1, Concat, [1]],

[-1, 3, C3C2, [512]],

# 检测头 -----------------------------

[49, 1, RepConv, [256, 3, 1]],

[55, 1, RepConv, [512, 3, 1]],

[61, 1, RepConv, [1024, 3, 1]],

[[62,63,64], 1, IDetect, [nc, anchors]], # Detect(P3, P4, P5)

]

1.2common.py配置

./models/common.py文件增加以下模块

class ChannelAttentionModule(nn.Module):

def __init__(self, c1, reduction=16):

super(ChannelAttentionModule, self).__init__()

mid_channel = c1 // reduction

self.avg_pool = nn.AdaptiveAvgPool2d(1)

self.max_pool = nn.AdaptiveMaxPool2d(1)

self.shared_MLP = nn.Sequential(

nn.Linear(in_features=c1, out_features=mid_channel),

nn.LeakyReLU(0.1, inplace=True),

nn.Linear(in_features=mid_channel, out_features=c1)

)

self.act = nn.Sigmoid()

#self.act=nn.SiLU()

def forward(self, x):

avgout = self.shared_MLP(self.avg_pool(x).view(x.size(0),-1)).unsqueeze(2).unsqueeze(3)

maxout = self.shared_MLP(self.max_pool(x).view(x.size(0),-1)).unsqueeze(2).unsqueeze(3)

return self.act(avgout + maxout)

class SpatialAttentionModule(nn.Module):

def __init__(self):

super(SpatialAttentionModule, self).__init__()

self.conv2d = nn.Conv2d(in_channels=2, out_channels=1, kernel_size=7, stride=1, padding=3)

self.act = nn.Sigmoid()

def forward(self, x):

avgout = torch.mean(x, dim=1, keepdim=True)

maxout, _ = torch.max(x, dim=1, keepdim=True)

out = torch.cat([avgout, maxout], dim=1)

out = self.act(self.conv2d(out))

return out

class CBAM(nn.Module):

def __init__(self, c1,c2):

super(CBAM, self).__init__()

self.channel_attention = ChannelAttentionModule(c1)

self.spatial_attention = SpatialAttentionModule()

def forward(self, x):

out = self.channel_attention(x) * x

out = self.spatial_attention(out) * out

return out

1.3yolo.py配置

在 models/yolo.py文件夹下

- 定位到parse_model函数中

for i, (f, n, m, args) in enumerate(d['backbone'] + d['head']):内部- 对应位置 下方只需要新增以下代码

elif m is CBAM:

c1, c2 = ch[f], args[0]

if c2 != no:

c2 = make_divisible(c2 * gw, 8)

args = [c1, c2]

1.4训练模型

python train.py --cfg CBAM.yaml

往期YOLO改进教程导航

11.改进YOLOv5系列:11.ConvNeXt结合YOLO | CVPR2022 多种搭配,即插即用 | Backbone主干CNN模型

10.改进YOLOv5系列:10.最新HorNet结合YOLO应用首发! | ECCV2022出品,多种搭配,即插即用 | Backbone主干、递归门控卷积的高效高阶空间交互

9.改进YOLOv5系列:9.BoTNet Transformer结构的修改

8.改进YOLOv5系列:8.增加ACmix结构的修改,自注意力和卷积集成

7.改进YOLOv5系列:7.修改DIoU-NMS,SIoU-NMS,EIoU-NMS,CIoU-NMS,GIoU-NMS

6.改进YOLOv5系列:6.修改Soft-NMS,Soft-CIoUNMS,Soft-SIoUNMS

5.改进YOLOv5系列:5.CotNet Transformer结构的修改

4.改进YOLOv5系列:4.YOLOv5_最新MobileOne结构换Backbone修改

3.改进YOLOv5系列:3.Swin Transformer结构的修改

2.改进YOLOv5系列:2.PicoDet结构的修改

1.改进YOLOv5系列:1.多种注意力机制修改