阿旭机器学习实战【1】K-近邻算法(KNN)模型应用实例,以及图像表征方式

目录

- 引言

-

- 如何进行电影分类

- 1. k-近邻算法原理

- 2. K-近邻算法的步骤

- 3. k-近邻算法实战--【基于scikit-learn库】

-

- 3.1 实战示例1--演示如何使用

- 3.2 实战示例2--鸢尾花分类

-

- 导入数据集并查看形状

- 模型训练及预测过程

- 用图像表征分类的过程

- 总结

引言

如何进行电影分类

众所周知,电影可以按照题材分类,然而题材本身是如何定义的?由谁来判定某部电影属于哪个题材?也就是说同一题材的电影具有哪些公共特征?这些都是在进行电影分类时必须要考虑的问题。

没有哪个电影人会说自己制作的电影和以前的某部电影类似,但我们确实知道每部电影在风格 上的确有可能会和同题材的电影相近。那么动作片具有哪些共有特征,使得动作片之间非常类似, 而与爱情片存在着明显的差别呢?

动作片中也会存在接吻镜头,爱情片中也会存在打斗场景,我们不能单纯依靠是否存在打斗或者亲吻来判断影片的类型。但是爱情片中的亲吻镜头更多,动作片中 的打斗场景也更频繁,基于此类场景在某部电影中出现的次数可以用来进行电影分类。

本文介绍的机器学习算法–

K-近邻算法(也叫KNN算法),来解决这个类分类问题。

1. k-近邻算法原理

存在一个样本数据集合,即训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每一数据与所属分类的对应关系。输入没有标签的新数据后,将新数据的每个特征与样本集中数据对应的特征进行比较,然后算法提取样本集中特征最相似数据(最近邻)的分类标签。

一般来说,我们只选择样本数据集中前K个最相似的数据,这就是K-近邻算法中K的出处,通常K是不大于20的整数。最后 ,选择K个最相似数据中出现次数最多的分类,作为新数据的分类。

那么上面提到的数据之间的相似性如何描述呢?

K-近邻算法采用测量不同特征值之间的距离方法来进行解决的。通常采用的是欧式距离进行计算。取前K个距离最近的数据,然后类别最多的一类胜出。

- 优点:精度高、对异常值不敏感、无数据输入假定。

- 缺点:时间复杂度高、空间复杂度高。

- 适用数据范围:数值型和标称型。

回到引言中电影分类的例子,使用K-近邻算法分类爱情片和动作片。有人曾经统计过很多电影的打斗镜头和接吻镜头,下图显示了6部电影的打斗和接吻次数。假如有一部未看过的电影,如何确定它是爱情片还是动作片呢?我们可以使用K-近邻算法来解决这个问题。

首先我们需要知道这个未知电影存在多少个打斗镜头和接吻镜头,上图中问号位置是该未知电影出现的镜头数图形化展示,具体数字参见下表。

现在假如我们给定一个未知电影分类的打斗镜头与接吻镜头数,我们可以计算得到样本集中所有电影与未知电影的距离,按照距离递增排序,可以找到K个距离最近的电影,然后在这K个电影中最多的分类数即为该电影的类别。

假定k=3,计算得到三个最靠近的电影依次是California Man、He’s Not Really into Dudes、Beautiful Woman。K-近邻算法按照距离最近的三部电影的类型,决定未知电影的类型,而这三部电影全是爱情片,因此我们判定未知电影是爱情片。

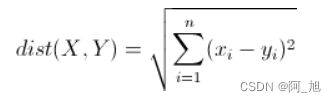

欧几里得距离(Euclidean Distance)

针对上述不同样本之间的距离计算方式有很多种,其中欧氏距离是最常见的距离度量方式,衡量的是多维空间中各个点之间的绝对距离。公式如下:

2. K-近邻算法的步骤

1、我们求未知点到所有样本点的距离

2、对以上求的距离进行排序(从小到大)

3、对排序号的样本点取前K个(注意K值一般不大于20)

4、对这前K个样本的标签进行分析,如果某一样本标签占优势那么未知点就属于该标签的类别

3. k-近邻算法实战–【基于scikit-learn库】

-

分类问题:from sklearn.neighbors import KNeighborsClassifier

-

回归问题:from sklearn.neighbors import KNeighborsRegressor

3.1 实战示例1–演示如何使用

根据一个人的身高、体重和鞋子尺码来判断性别

import numpy as np

# 构造特征数据

x = np.array([[172,60,42],

[168,56,40],

[189,70,44],

[160,45,36],

[163,50,42],

[170,65,41]])

# 给上面的特征数据加标签

y = np.array(["男","女","男","女","男","女"])

# 构造一组未知的特征数据,用于后续预测

x_test = np.array([[175,75,43],[170,60,38],[165,50,40]])

# 导入相关的算法

from sklearn.neighbors import KNeighborsClassifier

# 1、创建算法模型,k-近邻分类器模型:n_neighbors代表k-近邻算法取的前k个邻居,默认为5,一般不超过20

knn = KNeighborsClassifier(n_neighbors=3)

# 2、用创建好的算法模型,取对已有的数据进行训练:在k-近邻里面,训练过程就是告诉knn对象,x里面的数据对应到y中代表谁

knn.fit(x,y)

# 3、根据已有的数据基础对未知的数据进行预测

# 分别拿x_test中的每一条数据和已知数据进行k-近邻运算,进而推测出每一条数据分类归属

knn.predict(x_test)

# 我们可以看到,依据该算法预测出的3组数据结果为['男', '女', '女']。

# 4、性能检测

# 此处由于未设置测试数据的标签,因此无法性能检测

预测输出的结果为:array(['男', '女', '女'], dtype='3.2 实战示例2–鸢尾花分类

导入数据集并查看形状

# 导入sklearn的官方数据库

from sklearn import datasets

iris = datasets.load_iris()

# 提取出特征数据

data = iris.data

# 提取标签数据

target = iris.target

print(data.shape)

print(target.shape)

(150, 4)

(150,)

target

array([0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 0, 0, 0, 0, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1,

1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1,

1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2,

2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2,

2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2])

数据形状为:(150, 4),说明该数据集有150条数据,每条数据包含4个特征。

通过打印出的标签数据,我们可以看到该标签分为3个类别:0,1,2。

模型训练及预测过程

# 切分数据:将数据分为训练集和测试集,使用train_test_split方法

from sklearn.model_selection import train_test_split

# rain_test_split方法首先会把data和target随机打乱,提取出给出比例的数据(包括特征和标签)作为测试数据,下面使用的10%数据作为测试集

x_train, x_test, y_train, y_test = train_test_split(data,target,test_size=0.1)

# 创建模型

knn = KNeighborsClassifier(n_neighbors=5)

# 训练

knn.fit(x_train,y_train)

# 预测:y_为预测出的结果

y_ = knn.predict(x_test)

# 性能评测:查看准确率

knn.score(x_test,y_test)

1.0

我们可以看到模型预测出的结果准确率为100%。

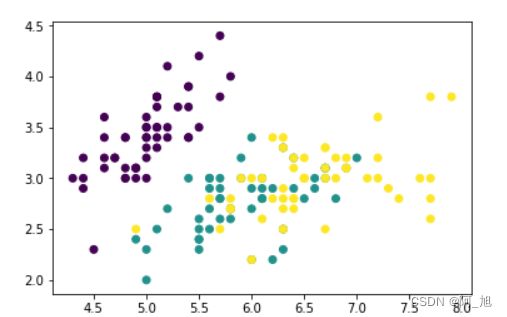

用图像表征分类的过程

由于4个特征用二维图像无法表述,因此我们取前两个特征,来进行图像分类过程表述,仅用于演示分类的过程。

# 取前两个特征

x_train = data[:,:2]

x_train.shape

(150, 2)

import matplotlib.pyplot as plt

import numpy as np

# 画出这150个样本对应标签的散点图

plt.scatter(x_train[:,0],x_train[:,1],c=target)

plt.show()

上图中的水平与竖直坐标表征鸢尾花数据集中的前两个特征,3种颜色的散点代表着鸢尾花的3种分类。

下面我们通过KNN模型,把整个平面中所有的点根据KNN模型来划分所属类别,确定他们的范围区域。

# 测试数据是平面上所有的点(取150000个点),300*500个点:水平:500,竖直:300

# 找所有样本点的最小值和最大值,以确定坐标区域范围

xmin,xmax = x_train[:,0].min(),x_train[:,0].max()

ymin,ymax = x_train[:,1].min(),x_train[:,1].max()

# 切分,水平分500等份,竖直分300等份

x = np.linspace(xmin,xmax,500)

y = np.linspace(ymin,ymax,300)

# 把x和y组合

xx,yy = np.meshgrid(x,y)

# yy.ravel()

# 将300*500个点的坐标当做需要预测的样本,赋值给x_test

x_test = np.c_[xx.ravel(),yy.ravel()]

x_test.shape

(150000, 2)

x_test[:5]

array([[4.3 , 2. ],

[4.30721443, 2. ],

[4.31442886, 2. ],

[4.32164329, 2. ],

[4.32885772, 2. ]])

x_test

array([[4.3 , 2. ],

[4.30721443, 2. ],

[4.31442886, 2. ],

...,

[7.88557114, 4.4 ],

[7.89278557, 4.4 ],

[7.9 , 4.4 ]])

# 画出需要进行预测的15000一个样本点

plt.scatter(x_test[:,0],x_test[:,1])

# 创建模型

knn = KNeighborsClassifier()

# 训练

knn.fit(x_train,target)

# 预测

y_ = knn.predict(x_test)

plt.scatter(x_test[:,0],x_test[:,1],c=y_)

plt.scatter(x_train[:,0],x_train[:,1],c=target,cmap="rainbow")

通过上图我们可以很清楚的看到平面上15000个测试样本点各自所在的类别,即3种类别的鸢尾花在平面上的区域范围。

模型准确率:

# 通过训练出的模型对训练数据进行预测,得到预测准确率为83%

knn.score(x_train,target)

输出结果:0.83333333333333337

总结

本文主要介绍了以下几点内容:

- 机器学习中K-近邻算法的原理,

- K-近邻算法的使用步骤

- 依据鸢尾花分类问题,详细介绍了K-近邻算法的使用。同时用图像的方式对分类过程进行了描述。

如果内容对你有帮助,感谢记得点赞+关注哦!

更多干货内容持续更新中…