OFT-Orthographic Feature Transform

1.主要工作:

- 引入了正交特征变换(OFT),它将基于透视图像的特征映射到正交鸟瞰图中,使用积分图像有效地实现快速平均池化。

- 描述了一种用于从单眼RGB图像预测3D边界框的深度学习架构。

2.相关工作:

- 绝大多数3D对象检测方法都采用2D目标检测中两阶段目标检测的思路,部分原因是难以从3D空间中的固定大小区域映射到图像空间中的可变大小区域。本文利用OFT变换克服了这一限制,能够实现单级架构的所谓速度和精度优势[18]。

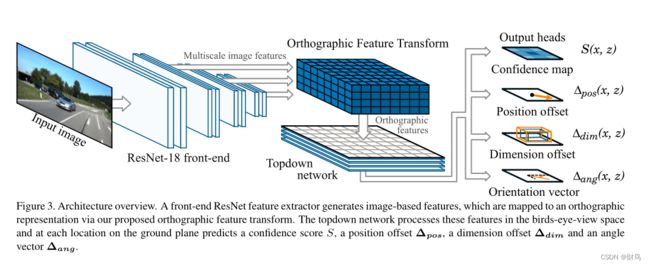

3.模型架构:

-

前端ResNet特征提取器,从输入图像中提取多尺度特征图。

-

正交特征变换,将每个比例的基于图像的特征图变换为正交鸟瞰图表示

-

自上而下的网络,由一系列ResNet残差单元组成,以类似于处理透视图像的方式处理鸟瞰图特征图。

-

一组输出头,用于为每个对象类和地平面上的每个位置生成置信度分数、位置偏移、尺寸偏移和方向向量。

-

非极大值抑制和解码阶段,识别置信图中的最大值并生成离散边界框预测。

3.1 特征提取阶段

前端网络除了负责对图片特征进行编码生成多尺度特征图外,还负责基于图像特征的大小推断深度信息,因为架构的后续阶段旨在消除尺度变化。

3.2 正交特征变换

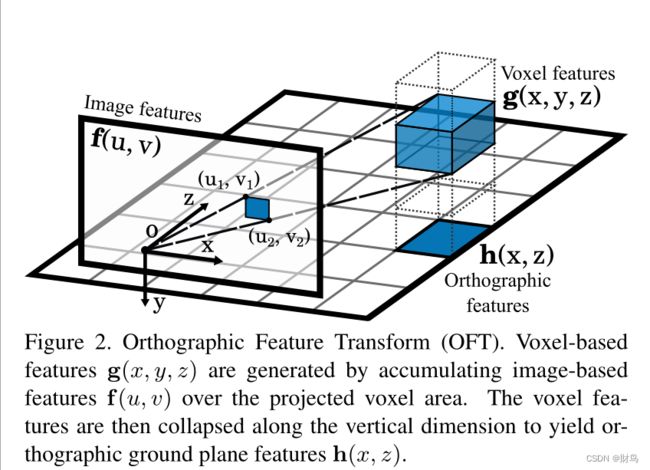

所谓正交变换(OFT)即将从图像空间中提取的特征图映射到世界空间中的正交特征图。

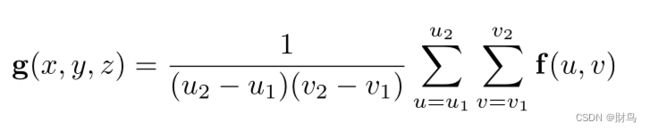

目标:利用2D特征图f(u,v)生成特征维度相同的基于体素的3D特征图g(x,y,z)。

流程:

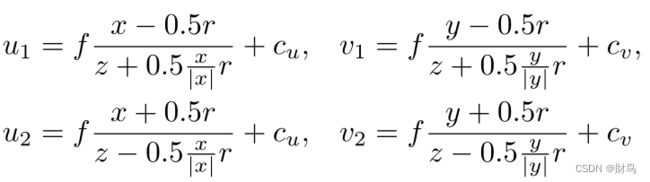

图像到体素位置映射:对于给定的体素栅格位置(x、y、z)∈ g, 通过在对应于体素的2D投影的图像特征图f的区域上累加特征来获得体素特征g(x,y,z)。在体素(边长为r的立方体)向像素平面映射时,得到的是一个六边形,通常用矩形来近似,即取立方体最外围的两个投影点。

图像到体素特征映射:

将体素对应区域的像素特征平均池化,然后分配给该体素。

体素映射到鸟瞰图:

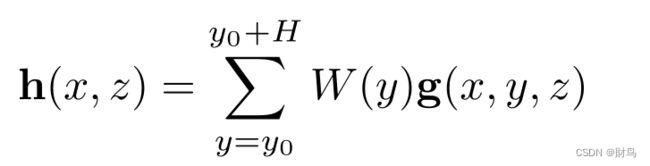

正交特征图即鸟瞰图是通过在一组学习的权重j矩阵W(y)(R∈n*n)相乘之后沿垂直轴对体素特征求和而获得的,就是每一个平面位置(x,z)的竖直方向(y)对各高度特征按权重求和。

分析:

在折叠到最终正交特征图之前转换为中间体素表示具有保留关于场景的垂直配置的信息的优点。这对于下游任务(如估计对象边界框的高度和垂直位置)至关重要。

方法:

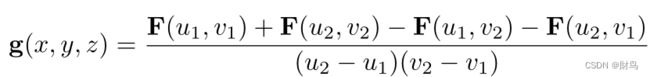

1-利用积分图像进行快速平均池化

问题:典型的体素网格设置生成大约150k个边界框,远远超过Faster R-CNN架构使用的2k个感兴趣区域。

方法:使用递归关系从输入特征图F构造积分图像,构造方式如下(图片另寻的,可将I等效于F),公式中F代表积分图,f代表特征图。

![]()

优势:该池化操作的复杂度与对应区域的大小无关,也就是与体素距离相机远近位置无关。而且在原始特征图中可微分。

3.3 自上而下的网络

这是一个简单的卷积网络,具有ResNet类型的跳跃连接,由于自上而下网络的滤波器是卷积应用的,所以所有处理都对地平面上特征的位置不变。

输入:OFT阶段生成的2D鸟瞰图。

分析:意味着距离相机较远的特征图与距离较近的特征图得到完全相同的处理,尽管对应的图像区域要小得多。

3.4 置信图预测

置信度指的是表示存在一个以位置(x,y0,z)为中心的边界框的物体的概率。

置信度的预测公式如下,就是每一个点都与真实置信图中存在的n个物体进行关联比较,最大值为该点的置信度。

其中x,z是鸟瞰图每个位置,xi,zi是真实值。通过地面真实置信图得到每个物体中心周围宽度为σ的平滑高斯区域。(这个σ应该是一个超参数,此处应该就是一个归一化吧,不太确定,有误谅解。)

在计算损失时按照 L1范数回归计算,但是由于真实值太少,正负样本差距太大,所以对负样本进行降权重,即了将对应于负位置(定义为S(x,z)<0.05的位置)的损失缩放为0.01。

3.5 位置和边界框估计

位置确定

上阶段置信图峰值给出的物体位置估计精度与鸟瞰图分辨率r一致,本阶段进行进一步微调,用Δpos估计出鸟瞰图单元格中心与真实中心位置的偏移量。

如果地面真实对象实例i边界框的任何部分与给定网格单元相交,则将地面真实对象实例i指定给网格位置(x,z)。在训练期间,不与任何地面真实对象相交的单元格将被忽略。一句话就是有相交才有回归比较的必要。现在只是大致确定了中心位置,但是边界框大小和方向还不知道。

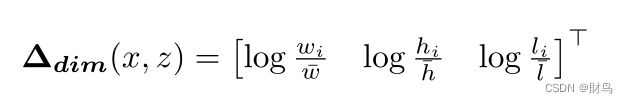

边界框大小确定

角度确定

以上三种偏移量统统采用L1 loss进行训练。后两个偏移量论文里说的模糊,要看代码确定一下定义。

3.6 非极大值抑制

通过在置信图上应用非极大值抑制,大大减少了计算复杂度,在3*3的方格里选择最大值作为局部峰值,然后再通过阈值t对这些峰值进行进一步筛选。

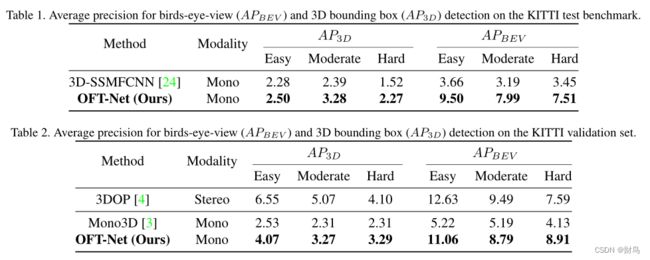

4.实验结果