卷积神经网络——RPN(Region Proposal Network)介绍

RPN,从字面上理解区域候选网络,是用来生成候选区域的网络。

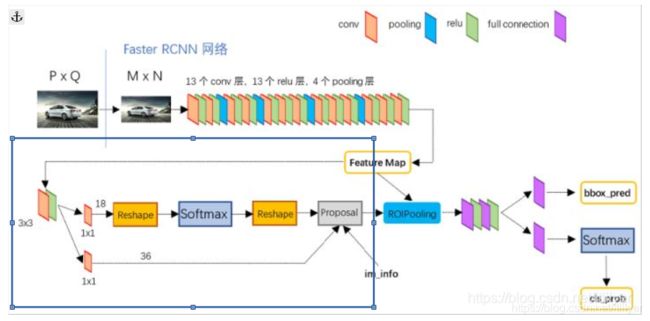

这个网络的输入输出是什么呢?看一下Faster RCNN的网络结构(下图中框内的部分)就可以看出,输入是前面backbone得到的特征图,输出是一些Proposal。

RPN网络可以分为这么几部分:生成anchor;对anchor进行二分类;边框回归;生成最终的Proposal。下面分别介绍一下。

生成anchor box

anchor可以翻译为锚,这个anchor指的是输入图像上的点,是生成候选框的基础,有了anchor后就可以为每个anchor生成不同大小和长宽比的box,用这些box来覆盖输入图片中要检测的物体(当然,会生成很多很多的box, 在图片上密密麻麻的,需要后续的操作进行筛选)。筛选过后剩下的就是最终的Proposal。Proposal会给ROIPooling然后进行分类和回归。

生成anchor box分为两步:第一先从Feature map的点对应回输入图像感受野的中心点;第二以该点为中心点创建不同面积和长宽比的box,这个也是输入图像上的box。

从Feature map到图像中的anchor

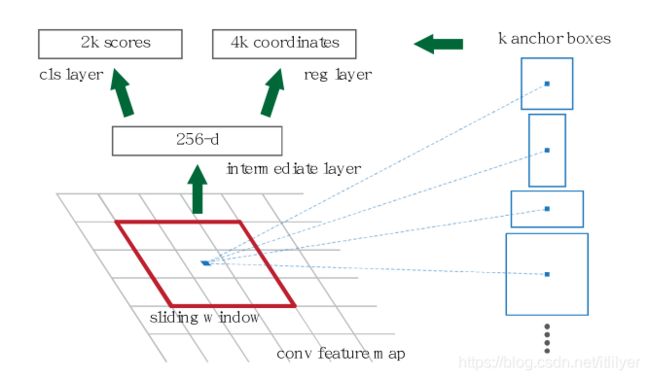

FPN会用一个大小为3x3,padding=2,stride=1的卷积核遍历特征图(只取一个维度为例),这样就会将backbone输出的特征图中每一个点(也就是每一个值)都作为3x3的中心点遍历了一遍。

遍历过程中会找到3x3窗口的中心点对应到输入图片的感受野的中心点,该点就是anchor。

为什么可以对应会输入图片中的点呢?因为backbone中都是卷积和池化的操作。所以是可以将特征图中的点对应到原图的,也就是该点的感受野,感受野的计算这里就不再描述了。

生成anchor box

有了anchor点后就可以为每个点生成anchor box了,Faster R-CNN中设置了三种面积的box,每一个面积又有三种长宽比,也就是每一个点会有9个anchor box。

分类和边框回归

在第一步生成了很多很多的anchor box,后面就是要对这些anchor box进行分类和边框回归的操作。

分类操作就是上图中上面的那个分支,首先通过一个1x1的卷积,将维度降为18(因为是9个框,每个框进行二分类),通过softmax进行二分类(框中有没有目标,也就是前景和背景),来生成后面的正负样本。

边框回归的目的是使anchor box更接近ground truth。首先也会通过一个1x1的卷积,维度降为36(和之前的类似每个框四个值来确定)。

生成Proposal

有了前面生成的anchor box后下一步就是利用各种方法剔除我们不需要的那些box,主要分一下几步:

第一步:先将anchor box利用feat_stride和im_info(这个里面保存了原始图像的大小,注意这个不是网络输入的图像,是原始图像)将box映射会原始图像,将严重超出边界的box剔除;

第二步:按照上面说的二分类的分支得到的score得分进行排序,提取前2000个;

第三步:对得到的2000个box执行NMS(非极大值抑制);

第四步:将得到的结果再进行排序,取前300个作为最终的Proposal,给后面进行分类和回归。

整个的RPN流程就是这样了,有很多细节没有讲,有时间再慢慢补充吧.