基于pytorch搭建VGGNet神经网络用于花类识别

作者简介:秃头小苏,致力于用最通俗的语言描述问题

往期回顾:卡尔曼滤波系列1——卡尔曼滤波 基于pytorch搭建AlexNet神经网络用于花类识别

近期目标:拥有5000粉丝

支持小苏:点赞、收藏⭐、留言

文章目录

- 基于pytorch搭建VGGNet神经网络用于花类识别

-

- 写在前面

- VGGNet网络模型搭建

- 训练结果展示

- 小结

基于pytorch搭建VGGNet神经网络用于花类识别

写在前面

上一篇写过基于pytorch搭建AlexNet神经网络用于花类识别项目实战,建议阅读此篇前先弄明白上篇所述之事此外本节搭建的网络模型是VGG,需要你对VGG的网络结构有较深入的了解,还不清楚的戳此图标☞☞☞了解详情。

这篇文章同样是对花的类别进行识别,和上一篇使用AlexNet进行识别整体步骤是完全类似的,主要区别就是网络的结构有所不同,因此,本节将只针对VGG的网络结构搭建进行详细的讲解,其余部分基本和上一篇一致,不再赘述,大家可自行下载代码进一步研究。

VGGNet网络模型搭建

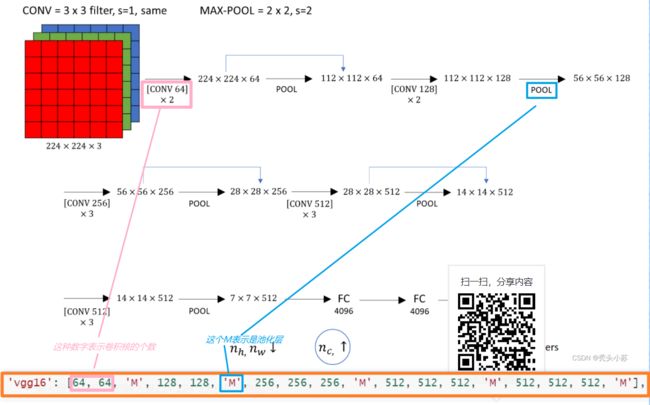

这一部分的代码可能真的能让你感受到代码之美,写的确实太漂亮了首先我们知道VGG一共有四种结构,分别为VGG11、VGG13、VGG16、VGG19。我想若是让我们单独的构建一种VGG网络是不难办到的,VGG这种直筒型的结构用代码实现是较容易的。官方的demo中通过一个字典将4中结构的VGG网络放在了一起,只需要我们在调用的时候传入相关参数就可以了,实在是太妙了!!!下面让我们一起来学习一下

首先我们定义了一个字典cfgs,字典中有四个键值对,每个键对应VGG的一种结构,每个值是对应结构中的一些参数。

cfgs = {

'vgg11': [64, 'M', 128, 'M', 256, 256, 'M', 512, 512, 'M', 512, 512, 'M'],

'vgg13': [64, 64, 'M', 128, 128, 'M', 256, 256, 'M', 512, 512, 'M', 512, 512, 'M'],

'vgg16': [64, 64, 'M', 128, 128, 'M', 256, 256, 256, 'M', 512, 512, 512, 'M', 512, 512, 512, 'M'],

'vgg19': [64, 64, 'M', 128, 128, 'M', 256, 256, 256, 256, 'M', 512, 512, 512, 512, 'M', 512, 512, 512, 512, 'M'],

}

具体的,我们拿vgg16来进行相关解释:

有了这个字典之后,我们就可以通过传入相关参数来构建特征提取层:

# 在cfgs传入"vgg16",得到一个列表cfg

#cfg = [64, 64, 'M', 128, 128, 'M', 256, 256, 256, 'M', 512, 512, 512, 'M', 512, 512, 512, 'M']

cfg = cfgs["vgg16"]

#定义特征提取层函数make_features,将cfg作为参数传入

def make_features(cfg: list):

layers = []

in_channels = 3

#遍历整个cfg列表

for v in cfg:

#若v的值为"M",则在层结构layers中添加一个最大池化层,其kernel_size=2, stride=2

if v == "M":

layers += [nn.MaxPool2d(kernel_size=2, stride=2)]

#若v值为数字,则在层结构layers中添加一个卷积层核和Relu激活函数

else:

conv2d = nn.Conv2d(in_channels, v, kernel_size=3, padding=1)

layers += [conv2d, nn.ReLU(True)]

in_channels = v

return nn.Sequential(*layers)

通过上面程序,我们可以来看一下得到的layers内部的部分结构【只选了前几个层】,如下图所示:

接下来我们可以来构建我们的分类层,即全连接层的部分:

self.classifier = nn.Sequential(

nn.Linear(512*7*7, 4096),

nn.ReLU(True),

nn.Dropout(p=0.5),

nn.Linear(4096, 4096),

nn.ReLU(True),

nn.Dropout(p=0.5),

nn.Linear(4096, num_classes)

)

这些都准备好之后,我们就可以来定义我们的网络模型了,如下所示:

class VGG(nn.Module):

def __init__(self, features, num_classes=1000):

super(VGG, self).__init__()

self.features = features

self.classifier = nn.Sequential(

nn.Linear(512*7*7, 4096),

nn.ReLU(True),

nn.Dropout(p=0.5),

nn.Linear(4096, 4096),

nn.ReLU(True),

nn.Dropout(p=0.5),

nn.Linear(4096, num_classes)

)

if init_weights:

self._initialize_weights()

def forward(self, x):

# N x 3 x 224 x 224

x = self.features(x)

# N x 512 x 7 x 7

x = torch.flatten(x, start_dim=1)

# N x 512*7*7

x = self.classifier(x)

return x

至此,我们的模型就创建完毕,最后让我们来看看我们刚刚创建的VGG模型结构:

训练结果展示

本篇文章不再详细讲解训练步骤,和基于pytorch搭建AlexNet神经网络用于花类识别基本一致。这里展示一下训练结果,如下图所示:

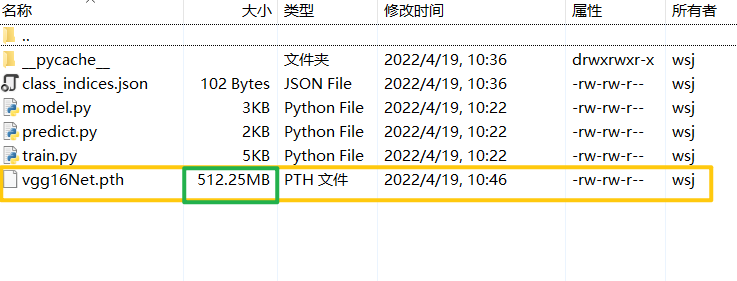

其准确率达到了0.761,我们可以再来看看我们保存的VGG模型,如下图,可以看出VGG用到的参数还是很多的,有500+M,这和我们的理论部分也是契合的。

小结

对于这一部分我强烈建议大家去使用Pycharm的调试功能,一步步的看每次运行的结果,这样你会发现代码结构特别的清晰。

参考视频:https://www.bilibili.com/video/BV1i7411T7ZN/?spm_id_from=333.788

如若文章对你有所帮助,那就

咻咻咻咻~~duang~~点个赞呗