综述--2020--联邦学习--全文翻译

A survey on security and privacy of federated learning

Viraaji Mothukuri a, Reza M. Parizi a, Seyedamin Pouriyeh b, Yan Huang a, Ali Dehghantanha c, Gautam Srivastava d,e,∗

a The Department of Software Engineering and Game Development, Kennesaw State University, GA 30060, USA

b The Department of Information Technology, Kennesaw State University, GA 30060, USA

c Cyber Science Lab, School of Computer Science, University of Guelph, Ontario, Canada

d Department of Math and Computer Science, Brandon University, MB, Canada

e Research Center for Interneural Computing, China Medical University, Taichung 40402, Taiwan, Republic of China

摘要:联邦学习(FL)是一种新型的人工智能(AI),它建立在分散数据和培训的基础上,将学习带到边缘或直接在设备上。FL是一个新的研究领域,通常被称为人工智能的新曙光,它还处于起步阶段,还没有在社区中获得很多信任,主要是因为它的(未知的)安全性和隐私含义。为了推进这一领域的研究状态,并实现对FL方法的广泛利用和大规模采用,其安全性和隐私问题必须首先被识别、评估和记录。在安全性和隐私是关键关注点的用例中,FL是首选,并且拥有清晰的视角和对风险因素的理解可以使FL的实现者/采用者成功地构建一个安全的环境,并使研究人员对可能的研究领域有清晰的视野。本文旨在提供一项关于FL安全和隐私方面的全面研究,有助于弥合联邦人工智能的当前状态和大规模采用是可能的未来之间的差距。我们对方法和各种实现风格进行了说明性的描述,并对FL当前面临的挑战进行了审查,并对需要在一个彻底和清晰的背景下考虑的安全和隐私问题进行了详细的审查。我们的研究结果表明,总体而言,与安全威胁相比,与FL相关的特定于隐私的威胁较少。目前最具体的安全威胁是通信瓶颈、中毒和后门攻击,而推理攻击对网络隐私的影响最为严重。

1.引言

在传统的机器学习(ML)中,模型的效率和准确性依赖于集中式服务器的计算能力和训练数据。简单地说,在传统的ML中,用户数据存储在中央服务器上,用于培训和测试过程,以便最终开发全面的ML模型。通常,基于集中的ML方法与不同的挑战有关,包括计算能力和时间,最重要的是用户数据的安全性和隐私性,这些问题已经被忽视了很长时间。最近,[1]提出的联合学习作为解决此类问题的技术解决方案出现了。

联邦学习(FL)[2]提供了一种通过将数据从中央服务器分散到终端设备来保护用户隐私的方法,并使AI受益于具有敏感数据和异构性的领域。这种范式的出现主要有两个原因:(1)由于对数据的直接访问限制,无法获得集中驻留在服务器端的足够数据(与传统机器学习相反);(2)使用来自边缘设备(即客户端)的本地数据来保护数据隐私,而不是将敏感数据发送到需要进行网络异步通信的服务器。保护数据隐私为有效利用机器学习模型在多个领域实现的人工智能优势提供了可行性。此外,计算能力在感兴趣的各方之间共享,而不是依赖于在终端设备上迭代的本地模型训练过程的集中式服务器。FL具有去中心化数据的概念,是近年来ML领域中不断发展的领域之一,因为它具有安全和隐私特性,承诺遵守新兴的用户数据保护法[3,4]。除了隐私之外,FL还使ML受益于较小的领域,这些领域没有足够的训练数据来构建独立的ML模型。

正如[1]FL的作者所言,“FL将代码带到数据中,而不是数据带到代码中,并解决了隐私、所有权和数据位置等基本问题”。之前我们可以完全理解这一事实在FL,数据保持完整的用户设备和传统的上传数据通过网络可以优雅地跳过,我们与每个客户共享模型参数和全局ML模型,将众多FL环境中利用漏洞的方法。由于FL的研究还处于起步阶段,不同领域的许多研究人员都在积极改进现有的框架,确保FL内用户数据的隐私和安全。

每当引入一项新技术,创建一个新的生态系统时,一系列的技术涟漪效应通常会随着时间的推移而产生。在一种不那么积极和好的方式下,FL的引入可能需要更深入的研究来确认,特别是在安全和隐私方面。因此,我们可以提出这样的问题:我们现在面临着什么样的安全和隐私问题?我们能想象未来由于采用这项技术而发生的事情吗?本文旨在为这些类型的问题提供答案,并阐明我们应该注意和准备的可能不必要的未来安全和隐私状态。

FL保护隐私的承诺吸引了可能包含敏感数据的不同领域。在某种程度上,FL解决隐私问题的敏感数据ML然而同时环境模型参数共享和和通讯公开训练迭代次数增加一套新的联邦环境风险和打开黑客[5]的新途径以及好奇的攻击者跟踪漏洞操纵毫升模型输出或获得敏感的用户数据。以确保我们拐弯FL的好处超过风险,利用正常FL的特点,我们立即需要在这一领域的研究调查所有可能的安全和隐私攻击FL。没有精确的信息和清晰的愿景,FL可能推迟没有给一个公平的机会去探索和利用它的好处。

FL保护隐私的承诺吸引了可能包含敏感数据的不同领域。在某种程度上,FL确实解决了ML环境中敏感数据的隐私问题。然而,与此同时,模型参数共享和训练迭代和通信数量的增加使联邦环境暴露在一组新的风险中,并为攻击[5]开辟了新的途径,以及好奇的攻击者跟踪漏洞以操纵ML模型输出或访问敏感的用户数据。为了确保我们将FL的好处凌驾于风险之上,并正确地利用FL的特性,我们迫切需要在这一研究领域之上,调查所有可能针对FL的安全和隐私攻击。如果没有准确的信息和清晰的视野,FL可能会被推到后面,而不给一个公平的机会来探索和利用它的好处。

正如在最近的出版物中所看到的,FL空间中提出的大部分工作旨在以某种形式将这种新的框架应用到不同的领域。我们的工作涉及到FL内部的问题,并可作为促进未来网络安全相关研究的参考,以促进这一框架的接受。为此,我们通过识别和评估开放的安全和隐私威胁,以及通过回答几个具体的研究问题来解决FL的缓解策略,来实现研究目标。

1.1贡献

虽然这方面的研究已经存在,但在理解FL的安全和隐私风险方面还没有足够的进展。本研究希望从正式定义、成就和挑战等方面对FL安全性做出全面的概述,使其与之前的工作相比脱颖而出。通过这样做,这项工作可以为数据科学家和网络安全研究设计基于FL的解决方案,以缓解未来的挑战提供一个总体蓝图。本文对近年来该领域相关文献的贡献概述如下:

- 对FL实现的方法和技术进行了分类和概述。

- 识别和检查FL环境中的安全漏洞和威胁,包括与FL相关的特定FL和一般基于ML的攻击。

- 识别和评估FL环境中的隐私威胁、其缓解技术,以及与隐私保护技术相关的权衡成本。

- 提供对现有防御机制和未来方向的见解,以增强FL实现的安全性和隐私性。

1.2 论文组织

本文其余部分的结构如下。第2部分给出了FL的背景信息及其基本的工作过程。第3节对网络安全的相关方法和技术进行了分类,第4节提出了网络安全的研究问题和研究成果。同样,第5节给出了FL隐私的研究问题和研究结果。第6节给出了相关的工作。第7节总结了FL领域的安全性和隐私的未来方向。最后,第8节给出结束语。

2. Federated learning landscape

近年来,有三个主要因素帮助ML取得了成功。第一个也是主要的因素是多年来收集的大量数据的可用性(多亏了大数据!)。第二是计算能力,技术已经发展了很多,我们已经从传统的计算设备转移到高度可扩展和集成的微电路设备,这有助于更快地训练模型,并以更少的计算成本直接部署在设备上。例如,我们现在有了预装了人工智能芯片的智能手机,让智能手机变得越来越智能,有效地帮助人类完成日常任务。第三个贡献因素是深度学习模型,它为ML模型增加了亟需的智能。通过自学的深度学习算法训练的模型显示出了值得称赞的成功率。例如,alphago的[6]棋类游戏战胜了世界冠军,它掌握游戏的能力和赢得人类智慧的能力让人们惊叹。尽管ML[7]取得了巨大的成功,但由于两个主要障碍,许多领域只能希望利用它的好处,但不能这样做:

- 关注用户数据隐私和机密性以及监管它们的法律。

- 由于训练ML模型所涉及的计算成本在ML实现上的数据或训练成本不足,无法建立ML模型。

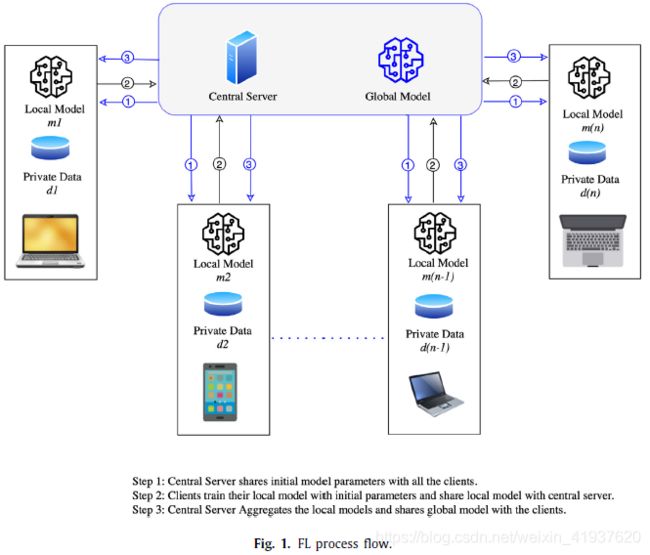

多家基于云的公司正在提供训练良好的ML模型[8],这些模型能够以一定的成本带来ML知识和计算能力,然而我们仍然看到隐私和机密性问题没有得到解决[9-14]。为了努力解决这些障碍,社区已经看到了一个有前途的基于ML的框架,称为联邦学习。FL通过提供一个高度训练的ML模型来解决这些问题,而没有暴露训练数据的风险。FL还通过在异构域之间提供信任因子来解决数据不足的问题。FL的这种隐私保护技术吸引了不同的社区专门利用它,保护客户数据隐私,并利用在更大的景观数据上训练的模型的好处。FL被认为是一个迭代过程,每次迭代都对中心ML模型进行改进。FL的实现可以概括为以下三个步骤:

- 模型选择:在这个步骤中,首先启动中央预训练的ML模型(即全局模型)及其初始参数,然后将全局ML模型与FL环境中的所有客户端共享。

- 局部模型训练:在与所有客户共享初始ML模型和参数后,在客户层的初始ML模型(称为局部ML模型)用个人训练数据进行训练。

- 本地模型的聚合:本地模型在客户端级别进行训练,更新被发送到中央服务器,以聚合和训练全局ML模型。全局模型将被更新,改进后的模型将在各个客户机之间为下一次迭代共享。

FL处于一个持续的迭代学习过程中,重复上述2和3的训练步骤,以保持所有客户端的全局ML模型更新。图1将FL架构和培训方法可视化,正如上面的步骤所讨论的。

事实上,FL已经在键盘上的下一个单词预测的移动应用程序中显示了它的足迹[15-18],比如Android手机上谷歌的Gboard,以及唤醒词检测[19],它可以让语音辅助应用程序检测唤醒词而不需要冒暴露用户敏感数据的风险。在医疗领域,FL可用于保持患者数据的私密性,并增强ML能力,以帮助医疗从业者,类似于[20]的工作,这表明了FL在医疗领域的好处。

除了现场生产应用程序之外,还有一些研究建议,其中有一些有用的应用程序用例试验使用FL在不同领域构建保护隐私(甚至安全)的机器学习解决方案。例如,[21,22]中的研究通过避免通信开销,总结了使用FL进行无线通信的可能应用。在安全领域的应用用例中,FL已经提出了恶意软件分类[23]、人类活动识别[24]、异常检测[25]、入侵检测[26]等。对于智能交通行业中的应用程序用例,有几个使用基于FL方法的建议。自动驾驶汽车与驾驶之间的数据共享[27,28],防止车辆信息物理系统[29]中的数据泄漏,交通流预测[30],检测空中车辆[31]中的攻击都是这类工作的例子。针对计算机视觉领域的应用实例,微众银行在[32]中提出了基于安全FL的Fedvision目标检测方法。在医疗领域的应用用例中,维护患者健康记录[33]敏感信息的医疗网络物理系统中的攻击检测,以及利用FL[34]管理数字健康记录都是FL应用的例子。值得一提的是,本文的主要关注点是研究FL内部潜在的安全和隐私相关问题。因此,考察FL在不同领域的应用有点超出了本文的目的。

3.FL技术/方法的分类

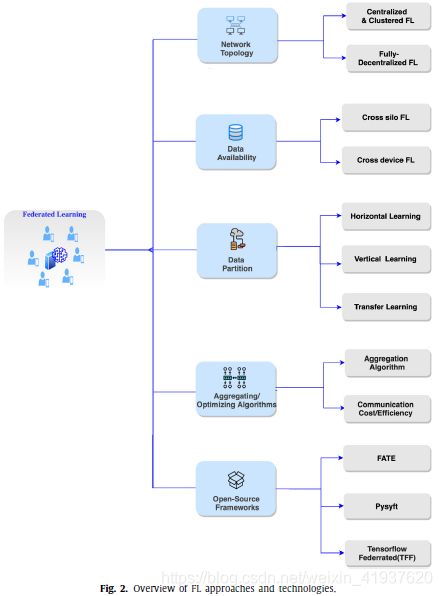

FL正在积极发展,并使用各种技术和方法来实现其底层技术在实践中。对于一种新兴技术,对其技术和方法的分类是至关重要的第一步,有助于理解和探索超出概述的大图景。本节从不同的角度收集并概述这些技术的内部工作原理,在后面的章节中,我们将使用这些技术来更深入地理解安全性和隐私方面的内容。图2显示了我们的分类。在这个分类中,我们将介绍FL实现网络拓扑用于构建FL环境,基于数据可用性和分区分类,聚合/优化算法建立在中央服务器保存通信带宽/成本和聚合逻辑,和开源框架在实践中实现FL。请注意,这个列表并不是详尽无遗的,它只包含了FL领域中一些最常用的技术和方法。图2给出了每个分类的详细描述,包括感兴趣的读者参考资料。

3.1 网络拓扑结构

这个类别的重点是FL的底层架构,即构建组件以实现FL环境的方式。根据网络拓扑结构,FL可以分为集中式和完全分散式[35]。

3.1.1 集中式和集群式FL

尽管FL从根本上是基于分散的数据方法,仍然依赖于一个集中的服务器来管理从FL环境中涉及的客户端收集训练模型的责任,建立一个全局模型,并与所有客户端共享它。这主要倾向于建立第三方体系,以建立客户之间的信任因素。采用单服务器和多客户端拓扑/hub-and-spoke拓扑[36],确保了一个集中的权威机构来监视和管理持续学习过程。与传统的集中式服务器不同,集中式服务器承载数据并在共享数据上训练给定模型,FL环境中的集中式服务器仅通过客户机的同步或异步更新在共享模型上工作。使用来自谷歌的Tensorflow联合开发的Android键盘Gboard可以作为FL的集中式方法。图1代表了这种方法的典型步骤。目前FL的通用实现在实践中使用的是集中式方法。

针对集中式网络拓扑结构中网络客户端数据的异构性问题,提出了一种基于聚类技术的网络优化算法。聚类是一种有助于检测恶意更新的技术。[37]中谷歌的研究工作提出了三种算法,以最小的通信轮数实现本地模型的个性化版本。作者建议根据用户聚类、数据插值和模型插值的用例组合或单独使用这些算法。在用户聚类算法中,用一组数据分布相似的客户端建立聚类,对每个客户端建立一个中间模型,有助于全局模型更快地收敛。采用基于假设的聚类方法进行聚类识别。在[38]中提出了一种基于联合多任务学习的方法,利用局部模型的余弦相似度识别客户端的FL簇。根据计算出的余弦相似度的停止条件集,获取初始客户端集并递归划分为集群。

[39]的研究工作提出了联邦随机期望最大化(federingstochastic Expectation Maximization, federsem)来训练多个全局ML模型并得到一个解决方案。损失函数称为基于距离的联邦损失(DF-Loss),是多中心FL的目标,它是在多聚类环境下,在不同的全局模型中寻找最优全局模型。在[40]中,作者提出了迭代联合聚类算法(IFCA)框架,该框架试图最小化每个FL客户端的损失函数,并在每轮训练中将客户端标记到一个聚类中。根据平均IFCA的来源,提出了模型平均和梯度平均两种方法。IFCA应用随机初始化和多次重启来识别具有特定集群的客户端,并达到最优值。实验结果表明,该方法在线性模型、凸神经网络和非凸神经网络中均有良好的效果。

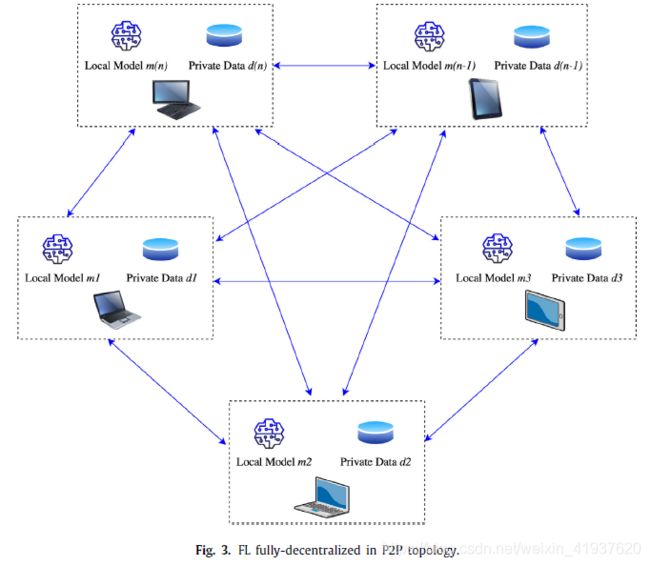

3.1.2 全分散控制FL

完全分散的方法排除了模型聚合对中央服务器的依赖。集中授权被建立信任和可靠性的算法所取代。正如在[41]中所展示的,没有全局模型的概念,每个参与者通过与邻居共享信息来改进他们的模型。Peer-2-peer拓扑被遵循,中央机构被使用一次来建立一个协议,在网络训练回合中被遵循。对于完全分散学习的实用方法,提出了各种附加技术或算法。[42]的作者提出了一种基于拜占庭概念的自适应平均算法,该算法假设FL中超过2/3的系统是诚实的。通过这种方法,一组来自不同领域、具有共同目标的客户可以协作共享数据和建立ML模型,并利用高精度的好处[43,44],而不需要依赖第三方集中式服务器。[45]的作者提出了一个名为MATCHA的框架,通过为客户端之间的通信提供关键链接来解决网络延迟问题。在[46]中的研究工作证明了FL在对等网络中的作用。为了使这种FL方法更加清晰,我们将其过程可视化在图3中。

3.2 数据划分

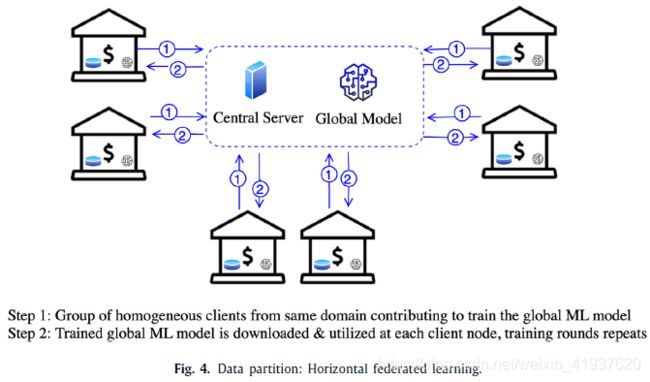

FL在构建跨不同领域共享数据的ML模型时非常有用。FL在整个培训过程中保持数据私密性的魔法带来了各种领域来利用ML的智能特性。通过协作,FL有助于克服由于特定领域对用户数据的限制和ML可获得的智能好处所造成的限制,并使用可能有相似/不同兴趣领域的不同域/客户机增强数据的好处。实时的信息,或者更确切地说,来自一组用户数据的统计信息,被用于不同领域的许多应用程序。在这个数字化时代,用户在网络空间的每一次点击都被捕获,用来生成派生统计信息,这些派生数据的用例可能属于相同领域的应用程序,也可能属于不同领域的应用程序。类似地,用于开发此类派生统计信息的用户数据可以从属于不同领域的领域收集。这部分的分类可以被认为是建立FL环境的前期工作。对一组有价值的用户数据的感兴趣的各方所做的前期工作对于FL过程的整体来说是至关重要的。数据分布特征,即参与FL的异构数据和客户之间的分化和碰撞因素,可大致分为水平学习、垂直学习和迁移学习(HFL, VFL, TFL)。这些子类别根据FL环境中涉及的各方之间的数据流而有所不同。图4,5,6说明了FL中的数据分区。

[水平联合学习(HFL) 垂直联合学习(VFL) 迁移联合学习(TFL)]

3.2.1 水平联邦学习

水平联邦学习4定义为设备上的数据集与不同实例共享相同特征的情况。在FL的这一类别中,客户端在领域、派生统计信息的使用风格或FL的任何其他结果方面具有类似的特征。从谷歌[47]发布的FL的经典版本属于这一类别。当用户输入文本时,ML模型可以预测下一个可能的单词,与来自用户的真实数据输入一起工作更准确。在这个场景中,谷歌键盘应用程序(称为Gboard)通过不断向Android移动设备用户学习来增强自身。FL方法巧妙地实现了从用户使用统计数据中获取平均更新,而不标记用户身份。另一个例子来自医学领域,其中一组研究人员正在研究ML模型,该模型可以分析医学图像并预测癌细胞可能发生的概率。医学图像被认为是用户敏感数据,由于私人医学数据的限制和法律规定,无法共享。然而,使用FL,可以通过每个客户机的安全聚合更新安全地共享此类私人数据的信息。

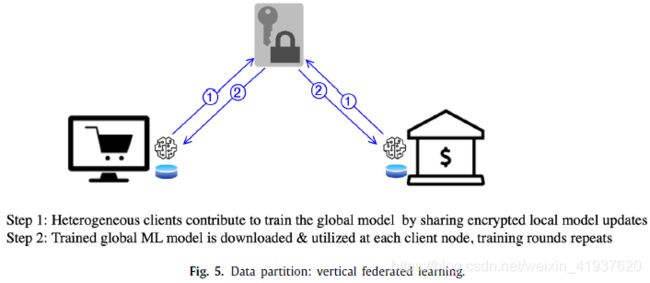

3.2.2 垂直联合学习

垂直联邦学习5是一种FL方法,使用不相关领域之间的公共数据来训练全局ML模型。使用这种方法的参与者希望有一个中间的第三方组织/资源来提供加密逻辑,以确保共享唯一的公共数据统计。然而,并不是必须有一个第三方中间实体,[48]中的研究工作演示了在没有第三方参与加密的情况下实现垂直联邦学习。垂直联合学习方法的实时用例是这样一种场景:银行信用卡部门的营销团队想通过学习在线购物领域中购买的大多数商品来增强他们的ML模型。只有银行和购物网站的普通用户的详细信息被共享来训练ML模型,中间加密逻辑确保这种安全且受限制的派生统计信息共享。通过这种信息交流的联系方式,银行域名可以为客户提供更好的相关优惠,而在线购物域名可以为使用信用卡的客户修改积分分配。

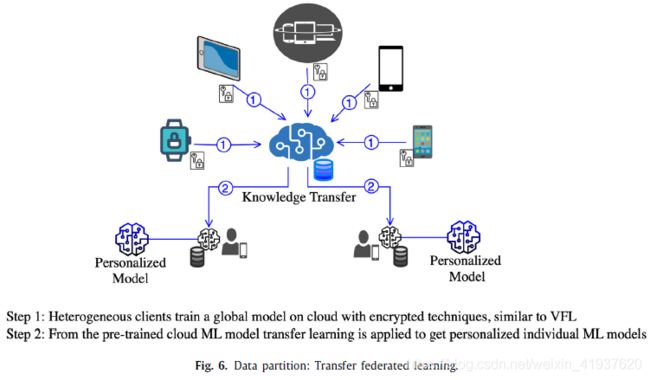

3.2.3 联邦迁移学习

联邦迁移学习6是现有经典的ML迁移学习技术的一个实现,该技术是一种对预先训练过的模型训练新的需求的方法,该模型已经在类似的数据集上训练过,以解决完全不同的问题。在ML世界中,与在全新的模型上进行训练相比,在预先训练过的模型上进行训练的结果要好得多。在[49-53]中,作者解释了FL在迁移学习模式中的实施。一个实时的例子类似于垂直联合学习,只需要做一些修改。参与者可以从更大的数据集和训练有素的ML模型统计中获益,以满足他们各自的需求,而不是限制条件来只共享匹配的数据信息。正如[49]中解释的那样,一个实时的例子是将云上的全球模型应用到个性化用户,该模型可进一步用于为特定用户的可穿戴物联网设备提供个性化模型。这个例子如图6所示。在针对个性化AI的应用中,将强化ML算法与FL相结合的FedRL研究工作很少[54-56]。FedRL利用FL从一个训练良好的安全模型中应用迁移学习,该模型不允许直接迁移学习。

3.3 数据可用性

正如谷歌[36]中讨论的那样,根据数据的可用性和客户端节点的数量,FL可以分为跨筒仓FL和跨设备FL(Cross-silo FL and Cross-device FL)。

3.3.1 Cross-silo FL

在这种情况下,客户端通常是小规模的数字,范围从2到100个设备,通常进行索引,并且几乎总是在培训轮中可用。训练数据可以分为水平学习和垂直学习。计算和通信瓶颈是主要问题。与跨设备FL相比,跨筒仓FL更加灵活,可以在组织或组织组的场景中使用它们的机密数据来训练ML模型。在垂直和传输学习实现中,首选加密技术来限制来自每个客户机的信息推断。基于FATE[57]框架,研究了同态加密的跨筒仓加密算法,提出了基于梯度量化[59]的批处理加密算法,降低了FL环境[60]的计算和通信成本。

3.3.2. Cross-device FL

FL方法具有来自全局模型的相似领域的大量具有相似兴趣的客户机,称为跨设备FL。由于客户机数量庞大,很难跟踪和维护事务历史日志。大多数客户使用不可靠的网络连接,在这些网络中,选择/参与培训是随机发生的。与水平联邦学习中的数据分区类似,资源分配策略[61]如客户端选择/重要性[62],设备调度[63]用于选择来自更好贡献的客户端的更新。像博弈论[64]这样的激励机制旨在激励客户对FL做出贡献。对于拥有大量客户的用例,如物联网或移动应用[16],这种类型非常适合。

3.4 聚合/优化算法

根据FL的优先级和架构,从客户端更新绑定以实现目标全局ML模型的算法会有所不同。配置这个逻辑是至关重要的,因为它解决了客户端的异构性、每个客户端更新的权重变化以及通信问题。在FL的集中版本中,有一种聚合算法,从编排训练到优化更新。很少有提出的算法关注于客户的最佳选择,优化培训轮以实现高效的沟通和FL的成本。本节涵盖了FL不同方法中用于整合、增强、优化、聚合和达成共识的算法。

3.4.1 聚合算法

聚合算法在任何集中式拓扑和水平联合学习风格的环境中都起着关键作用。它的逻辑[65]结合了来自所有参与培训的客户端的本地模型更新。许多提出的算法的目标是增强本地模型更新的隐私性,或保持通信带宽,或促进来自客户端的异步更新。基于预配置参数,联邦平均在FL的每个实现中都有所不同。目前的算法讨论如下:

- FedAvg:FL的[1]实现,引入了基于SGD优化算法的联邦平均算法(称为FedAvg)。作为FedAvg算法逻辑的一部分,中央服务器充当协调者或协调器开始FL训练的过程中通过分享全球模型参数和一组选定的客户称为mini-batch,它使用局部训练数据和全局模型参数训练ML模型,并与集中式服务器共享训练后的模型权重。全局模型是利用平均逻辑来计算所有接收到的集中服务器上的局部模型更新的加权和而生成的。可配置的标准,训练轮数是协调器停止训练轮和平均本地模型更新的停止条件。[Stochastic gradient descent 随机梯度下降 (SGD)]

- SMC-Avg:正如在[66]中所解释的,安全聚合基于安全多方计算(SMC)算法的概念,该算法聚合相互不信任的各方的私有值,而不揭示其私有值的信息。设计用于解决基于移动设备的FL环境的挑战。该算法具有容错极限,即即使有1/3的用户没有参与设计的协议,该算法也能很好地工作。

- FedProx:文献[67]提出了一种改进的FedAvg[1]算法来处理FL中的异构性。本文的实验结果表明FedProx在异构网络中的有效性。然而,对FedAvg和FedProx进行的实验研究[65]表明,在联邦平均算法中,FedAvg的精度最高。

FedProx考虑了参与FL训练的设备的计算能力和不同因素的变化。FedProx还引入了一个近端术语来处理本地更新中的不一致性。 - FedMA:作者在[68]中提出了在FL环境中构建基于CNNs和LSTM的ML模型更新的共享模型。FedMA通过分层匹配和平均隐藏元素(如神经网络中的神经元和通道)来对中央服务器上的模型进行平均。与[69]中提出的工作类似,该方法基于相同的神经元匹配概念,并且仅在简单的神经网络(如全连接网络)上有效。正如他们各自的论文[68]所示,FedMA方法在异构客户中工作得很好,并且在几轮培训中表现优于FedAvg和FedProx。FedMA还可以使用通信作为一种变体,在每一轮训练开始时将全局模型匹配结果发送给客户端,并在局部模型中添加新的神经元作为全局模型的更新,而不是匹配,以获得更好的整体性能。

- Scaffold:随机控制平均FL(脚手架)提出了[70]地址梯度不同/ client-drift问题面临联邦平均算法3.4.1 FL方法,客户是有状态的,算法可以在客户端和服务器端维护/控制变异,以确保客户端更新与全局收敛性向。

- Tensor Factorization:在医学领域,很少有应用倾向于张量因子分解[71,72]来限制共享信息的数量。张量因子分解将大量的医疗记录转换为有意义的表型。作者在[72]提出了张量因子分解用于隐私保护计算表型(TRIP)应用使用张量因子分解。TRIP共享总结数据和表现型,这有助于保护用户数据的隐私。

- Personalization-based algorithms:文献[73]的研究工作提出了一种方法,将神经网络层分离为每个客户节点的基础层和个性化层。在这种方法中,联邦平均仅应用于来自FL客户机的基层更新,这有助于忽略FL客户机的异质性,并将重点放在实际的学习任务上。在[74]中提出的自适应个性化联邦学习(APFL)建议从全局模型和局部模型的结合中学习,以在每个FL客户端实现ML模型的个性化版本。与传统的共享单一局部模型的FL方法不同,该方法在每个FL客户端上提出了三个模型,一个基于局部数据训练的局部模型,第二个是全局模型的局部副本,第三个是使用混合参数建立的个性化ML模型。基于数据在FL客户机上的平均分布,在每个客户机节点上计算混合参数,该节点根据三个模型(本地、全局和个性化)之间的距离不断变化。在为每个FL客户建立个性化模型方面,APFL的实验结果优于联邦平均算法(即FedAvg)。

3.4.2. Communication efficiency and costs

本部分将分别讨论关于降低通信效率和成本的算法。

- FedBCD:在[75]中提出了联邦随机块坐标下降(federal Stochastic Block Coordinate Descent, FedBCD)算法,它类似于FedAvg算法。提出了两种不同的FedBCD-p和FedBCP-s算法用于并行和连续地更新梯度。FedBCD的目标是通过跳过每次迭代的更新来减少总沟通轮数。客户端共享样本参数的单个值而不是模型参数,并在与其他客户端共享参数之前执行许多本地更新。对这一方法的评估表明在达到预期的准确率方面有希望取得成果。

- FedAttOpt:在[76]中提出的注意联邦聚合(FedAttOpt)增加了一种注意力增强机制,在FL的中央服务器上对聚合进行模型化,根据每个客户端的贡献计算注意力得分。客户的注意力分数或贡献因子是根据客户与全球模型之间的共同知识差距来计算的。FedAttOpt利用注意力评分帮助客户节点训练和积累有用的公共知识到所有客户节点。

- Asynchronous FL Training Rounds:客户端数量越多,通信瓶颈和计算成本的风险就越大。很少有研究工作是通过在FL的培训轮中以最小的通信成本为目标来解决通信效率问题。[77]中的研究工作探讨了通过使用神经网络的分层异步更新来最小化FL通信成本的策略。同样,TOR[78]是基于模型的异步聚合和很少的策略来执行,即使是在低通信带宽。异步聚合指的是中央服务器等待客户端设备在线以异步共享更新的过程。[79]的作者探讨了Co-op算法,该算法是为异步实现中的FL设计的,在异步实现中,基于客户机的可用性在离线的基础上进行本地模型的聚合。

- Communication costs:[80]中提出的方法设置了在FL培训轮中选择客户端更新的预定义规则,这有助于通过消除贡献最少的FL客户端更新来最小化通信成本。联邦精馏(FD)和联邦加法(fag)在[81]中被提出,以减轻FL训练回合的通信开销和成本。FD共享本地模型输出,而不是整个本地模型,每个客户端充当学生,从所有其他客户端的聚合知识中学习。对于训练中的每个标签,数据的平均logit向量与服务器共享,以计算全局平均值。FAug在每个客户端使用GANs进行数据增强,生成一个可共享的IID训练数据。

3.5. Open-source frameworks

目前有一些开源框架供研究人员和开发人员探索FL解决方案。下面列出了主要的最新工具的简要介绍。

- Tensorflow Federated:谷歌的TensorFlowFederated (TFF:https://www.tensorflow.org/federated/federated_learning)在Gboard上有一个产品版本,它可以让Android手机用户在使用手机键盘时预测下一个单词[82-86],这是社区中将FL变成现实的第一个尝试。TFF提供与谷歌Kubernetes引擎(GKE)[87]或Kubernetes集群集成,以协调与客户端和FL的中央服务器的交互。它还提供docker映像来部署客户端并通过gRPCs[88]调用连接。TFF使用Tensorflow API中提供的LEAF[89]生成的FL特定训练数据集。

- PySyft:Pysyft (Pysyft:https://blog.openmined.org/tag/pysyft/)是在PyTorch框架之上用Python编写的,它提供了一个虚拟钩子,可以通过WebSocket端口连接到客户端[90,91]。聚合器或协调服务器维护指向ML模型的指针,并将其发送给每个参与的客户机,以使用它们的本地数据进行训练,然后将其返回来进行联合平均。联邦平均算法对模型权重进行平均,并对其进行缩放,以在跨客户的不规则数据覆盖中保持一致性。除了FL的基本方法之外,PySyft还支持FL的异步和同步方法,以及与现有加密策略(如差分隐私)的集成。

- FATE:来自微众银行开发人员名为FATE(FATE https://fate.fedai.org)的软件,每一次发布都在即兴创作。FATE提供了一个在水平、垂直和迁移学习模式下实施FL的框架。它可以通过docker镜像或手动步骤实现。有一个开源的GitHub代码,它提供了训练数据集来模拟已知的对FL的攻击。[57,92]中的作者利用这些恶意用户数据集来探索攻击对FL的影响。这个框架提供了集成了Kubernetes的可生产API。

有更多用于实现FL的框架[93-97]正在试验中。根据该领域研究人员的经验,与处于早期实验阶段的TFF相比,PySyft似乎为开发FL解决方案提供了一个更稳定的环境。

4. 联邦学习中的安全性

FL技术的采用者和开发人员应该坚持信息安全的基本原则,如机密性、完整性和可用性。拥有大量客户进行协作训练和暴露模型参数的分散方法使FL容易受到各种攻击和风险。目前在探索漏洞和提出框架以减轻风险方面的研究非常有限。

我们着手调查以下关于FL安全方面的研究问题(Research Security Question (RSQ)):

- RSQ1:FL生态系统的脆弱性来源是什么?

- RSQ2:FL域的安全威胁/攻击有哪些?

- RSQ3:与分布式ML解决方案相比,FL特有的安全威胁是什么?

- RSQ4:FL的安全漏洞有哪些防御技术?

在下面的章节中,我们讨论了基于每个研究问题的结果,并提供了当前工作的优势和劣势的分析。

4.1. RSQ1: What are the source of vulnerabilities in the FL ecosystem?

漏洞可以定义为系统中的一个弱点,它给好奇的/恶意的攻击者机会获得未经授权的访问[98]。了解系统或框架的(公开的)漏洞有助于管理和防御可能的攻击。通过实现防御漏洞的先决条件,识别漏洞将有助于构建一个更安全的环境。未能保护个人身份信息(PII)的使用和暴露,或未能遵守数据保护法,不仅会造成不良宣传,还会导致法律规定的更多后果。对于FL开发人员来说,扫描所有的漏洞来源并加强防御以确保数据的安全性和私密性是一个强制性的步骤。为了更好地了解漏洞,我们对FL过程中的漏洞来源进行了分类。我们的结果显示,下面列出的五种不同的资源可以被认为是开发的弱点。

- 通信协议:FL使用随机选择的客户端实现迭代学习过程,这涉及到给定网络上的大量通信。FL方法提出了一种混合网络[78],它基于公开密钥加密,在整个通信过程中保持源和消息内容的匿名性。由于FL的训练轮次较多,非安全通信通道是一个开放的漏洞。

- 客户端数据操作:在一个更大的环境中,FL拥有大量的客户端,这些客户端对攻击者开放,以便攻击者利用模型参数和训练数据。对全局模型的访问可能更容易受到数据重构攻击。

- 中央服务器:中央服务器应该是健壮和安全的,中央服务器负责共享初始模型参数,聚合本地模型,并向所有客户端共享全局模型更新。应该检查用于此任务的基于云的或物理服务器,以确保服务器的公开漏洞不会被好奇的攻击者利用。

- 较弱的聚合算法:聚合算法是中心权威。换句话说,随着本地模型s的更新,它应该能够智能地识别客户端更新的异常情况,并且它应该有一个配置来删除来自可疑客户端的更新。没有配置标准化的聚合算法将使全局模型变得脆弱。3.4节给出了FL聚合逻辑的一系列算法。

- FL环境的实现者:有意或无意地,参与FL实现的架构师、开发人员和部署人员团队可能会成为安全风险的来源。无论是由于混乱或缺乏对哪些被认为是敏感用户数据和哪些不是敏感用户数据的理解,都可能是违反安全性和隐私的原因。来自实现者的风险可能是由于这样一个基本事实,即他们没有采取适当的措施来扫描敏感数据并计划其使用,在获得用户对数据使用的同意的同时隐藏事实。

4.2. RSQ2: What are the security threats/attacks in FL domain?

威胁/攻击是恶意/好奇的攻击者利用漏洞影响系统安全性并违反其隐私政策的可能性。在FL中,恶意代理通常利用漏洞[99]控制一个或多个参与者(即客户端),以便最终操纵全局模型。在这种情况下,攻击者针对不同的客户端,希望访问本地静止数据、训练过程、超参数或传输中更新的权值[100],在全局模型中修改并发动攻击。对安全威胁/攻击进行分类,并在下面的小节中讨论它们各自的描述。

4.2.1. Poisoning

在FL中发生的攻击被称为中毒[101,102],因为FL中的每个客户都可以访问训练数据,因此被篡改的数据权重添加到全局ML模型的可能性非常高。中毒可能发生在训练阶段,可以影响训练数据集或局部模型,反过来/间接篡改全局ML模型的性能/准确性。在FL中,模型更新是从大量的客户端获取的。也就是说,来自一个或多个客户机训练数据的中毒攻击的概率很高,威胁的严重程度也很高。在FL过程中在不同的工件上投毒攻击目标。下面我们简要介绍一下中毒发作的分类:

- 数据中毒Data Poisoning:数据中毒攻击ML算法的概念被首次提出了作者在[103]攻击者的目标支持向量机算法的脆弱性,并试图将恶意数据点在培训阶段,希望最大化分类错误。从那时起,人们提出了各种各样的方法来减轻ML算法在不同环境下(分别包括集中式和分布式环境)中的数据中毒攻击。虽然FL环境允许客户端积极贡献训练数据并向服务器发送模型参数,但它为恶意客户端提供了通过操纵训练过程来毒害全局模型的机会。FL中的数据中毒定义为生成浑浊样本来训练全局模型,从而产生伪造的模型参数并将其发送到服务器。数据注入也可以看作是数据中毒的一个子类,恶意客户端可以将恶意数据注入到客户端的本地模型处理中。因此,恶意代理可以控制多个客户机的本地模型,并最终使用恶意数据操纵全局模型。

- 模型投毒Model Poisoning:在数据投毒中,恶意代理的目的是利用假数据操纵全局模型,而在模型投毒中,恶意代理直接针对全局模型。最近的研究表明,模型中毒攻击比数据中毒攻击更有效[100,104,105]。事实上,在客户较多的地方,当FL产品规模较大时,模型中毒发作的有效性往往会上升。一般情况下,在模型投毒攻击中,恶意方可以修改更新后的模型,然后将其发送到中心服务器进行聚合,从而很容易毒死全局模型。

- 数据修改Data Modification:数据篡改/修改攻击可能包括改变/改变训练数据集,比如feature collision[106],它合并数据集中的两个类,试图愚弄ML模型,从而总是对目标类进行错误分类。一些技术包括简单地将另一个类的阴影或模式添加到可能混淆ML模型的目标类中。另一种技术是对训练数据集进行随机标签交换。数据注入和数据修改攻击可以被认为是FL中ML数据中毒攻击的一种[107]。

4.2.2. 推理

推理攻击更隐私的威胁(如5.1节中指出)然而我们在这里包括整体对比FL的威胁。推理攻击的严重程度是非常类似于中毒攻击有一个非常高的可能性推理攻击参与者或恶意FL过程中集中式服务器。

4.2.3. 后门攻击

与后门攻击相比,投毒和推理攻击更加透明。后门攻击是一种将恶意任务注入现有模型的方式,同时保持实际任务的准确性。识别后门攻击是困难和耗时的,因为实际ML任务的准确性可能不会立即受到影响。作者在[92,100]实验如何实施后门攻击。此外,[108,109]的作者建议模型修剪和微调作为一种解决方案,以减轻后门攻击的风险。后门攻击的严重性较高,识别攻击的发生需要相当长的时间。此外,后门攻击的影响是高的,因为后门攻击具有混淆ML模型和自信地预测假阳性的能力。木马威胁[100,110 113]是一类类似的后门攻击,它试图保留ML模型的现有任务,同时以隐身模式执行恶意任务。

4.2.4. GANs

许多研究者对FL中的生成对抗网络攻击进行了实验和分析[114]。基于GAN的攻击能够发起中毒和推理攻击,对给定系统的安全性和私密性构成威胁,在5.1.3节中详细讨论。文献[115]中的研究工作演示了如何通过推理使用GANs来获取训练数据,并使用GANs来毒害训练数据。由于基于GAN的威胁的所有可能性都无法预见,它被归类为高影响和优先级威胁。关于GAN攻击的更多信息可以在[116,117]中找到。

4.2.5. 系统中断IT停机时间

生产系统停机是信息技术(IT)行业不可避免的威胁。经常观察到,由于后端服务器上的计划外或计划中的活动,高度配置和安全的应用程序需要停机阶段。在FL中,这种威胁的严重程度很低,因为我们在每个客户节点上都有一个局部全局模型,而且在中断后,训练过程可以恢复。即使严重性很低,这也是一个相当大的威胁,因为停机可以是一种精心策划的攻击,从FL环境中窃取信息。

4.2.6. 恶意服务器

在跨设备FL中,大部分工作在中央服务器上完成。从选择模型参数到部署全局模型。被破坏的或恶意的服务器会产生巨大的影响,诚实但好奇的或恶意的服务器可以很容易地提取私有客户端数据或操纵全局模型,以利用共享的计算能力在全局ML模型中构建恶意任务。

4.2.7. 通信瓶颈

从多个异构设备的数据训练ML模型的挑战之一是通信带宽。在FL方法中,通过传输训练过的模型而不是发送大量的数据来降低通信成本,但我们仍然需要保留通信带宽。很少有基于模型异步聚合的算法[1,78,118],也很少有策略能够在低通信带宽的情况下表现良好。关于在FL环境中保持通信带宽的研究有很多[119,120],见3.4.2节。这种威胁的严重性是很高的,因为通信瓶颈可以显著破坏FL环境。

4.2.8. Free-riding attacks搭便车的攻击

很少有客户扮演被动的角色,只是为了利用全球ML模型的好处而连接到环境中,而没有对培训过程做出贡献。这样的被动客户端也可以插入虚拟更新,而不需要用它们的本地数据来训练ML模型。[121]的研究探讨了FL环境中的搭便车攻击,并提出了一种使用自动编码器的异常检测技术的增强版本[122]来识别搭便车者。在较小的景观环境中,这种攻击的影响会更大,因为客户的缺席会对全球模型培训产生负面影响。由于这种攻击的概率较低,所以这种攻击的严重程度为中等。

4.2.9. Unavailability不可用性

在培训过程之间,客户不可用或中途退出可能会导致培训全局模型的效率低下。这类似于搭便车攻击,但在这种情况下,由于网络问题或任何其他意想不到的障碍,客户无意中错过了参与培训过程。这种威胁的严重程度是中等,因为概率较低,并且可以选择可以异步工作的聚合算法。

4.2.10. Eavesdropping窃取

在FL,我们有一个迭代的学习过程,包括从客户端到中央服务器的交流轮。攻击者可以窃听和提取数据通过一个弱通信通道,如果有的话。窃听可以被认为是攻击FL模型的中等严重威胁,因为黑盒模型通常很难攻击。攻击者宁愿接管安全性较弱的客户端,后者很容易提供模型参数和白盒全局模型。

4.2.11. Interplay with data protection laws与数据保护法相互作用

这种威胁发生的可能性很小,因为数据科学家在配置FL环境时,要确保全局模型的部署在所有客户端投入生产之前得到了良好的分析。威胁的严重程度很低,但它仍然是一个相当大的威胁,因为在FL中有意或无意的错误配置可能导致安全漏洞。

4.3. RSQ3 What are the unique security threats to FL in comparison to distributed ML solutions?

目前提出的分布式机器学习(DML)解决方案旨在解决大数据和计算能力的挑战,同时训练ML模型。共享数据和计算能力来训练一个通用的ML模型。配置一个参数服务器或多个服务器节点,分发数据或将任务分配给DML的客户节点。从体系结构的角度来看,DML与FL有一些共同的特性,并且有一些研究工作解决了DML中的安全和隐私问题。然而,FL不同于现有的DML解决方案,在默认情况下具有更高的安全性和隐私级别。本节旨在讨论FL的独特威胁和FL与DML之间共享的共同威胁。这有助于理解现有的关于DML的研究[123,124],并探索从DML到FL的可重用/可适应的研究思路。DML的安全性和隐私风险不在本文讨论的范围内,我们只关注FL和DML的共同风险因素。

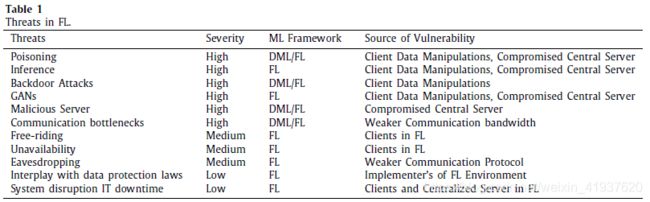

表1对安全威胁/攻击的分类进行了深入的总结。投毒威胁、后门攻击都是针对DML[125]和FL的,因为在FL和DML架构中,客户端节点上的数据可以在客户端节点上修改。DML和中心服务器的参数服务器[126,127]容易受到攻击,导致安全漏洞。由于DML和FL两种框架都需要与各自的客户端节点通信,因此需要关注它们之间的通信瓶颈威胁。

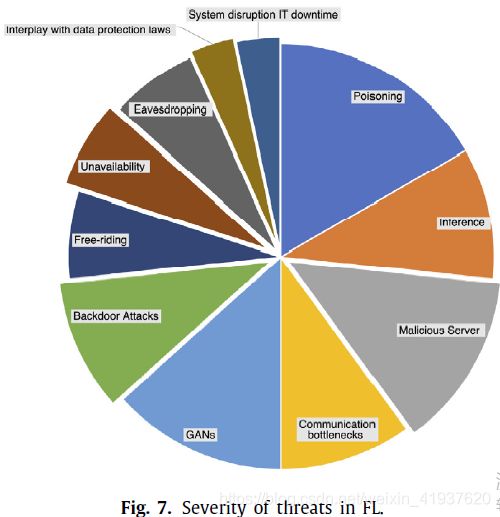

此外,图7显示了威胁的严重程度。严重性的计算是基于对手利用漏洞发起威胁的概率,并由研究人员直接研究该领域的现有工作得出。从图7可以看出,中毒发作是最严重的。这可能是由于全局模型可能受到许多来源的毒害,比如本地模型更新、恶意服务器和其他许多来源。威胁的可能性越高,攻击对FL的影响就越高。与中毒威胁类似,推断威胁具有较高的严重性,因为它可以发起的漏洞来源相当多样化。后门攻击的威胁也比较严重,因为这种攻击很难识别,而且影响有可能破坏全局模型的真实性。基于GAN的攻击由于其不可预测性和影响用户数据安全和隐私的能力,也具有很高的严重性。基于云/物理服务器的开放漏洞,恶意服务器威胁级别较高。系统中断和IT停机被标记为较低的严重级别,因为每个客户机单独持有全局模型时,影响会更小。FL中的沟通瓶颈是一个研究得很好的话题,因为它可能是学习过程中的一个突出问题。在FL环境中,这种威胁的影响和优先级总是被认为很高,大量的客户在学习过程的每次迭代中更新。在更少的情况下,搭便车威胁的影响被设置为尽可能中等,而且随着与其他客户的学习过程的继续,它的影响也不会太严重。不可用性会停止学习过程,当聚合算法不能处理dropouts时,威胁的影响被标记为媒介,因为有算法[66]是设计来处理dropouts。窃听也有中等的严重性和优先级。这样做的原因是,从对手的角度通过通信信道窃听至少会首选方法窃取信息,有一个选项来接管客户终端,并获得现成的训练数据集,全球模型参数和全局模型本身。与数据保护法的相互作用可能是FL环境的实现者在知道或不知道的情况下创建的初始漏洞,并且由于可能性较小且可纠正,影响较小。

4.4. RSQ4: What are the defensive techniques for security vulnerabilities of FL?

防御技术有助于防范已知的攻击,并降低风险的可能性。防御分为两类,即主动防御和被动防御。主动防御是一种猜测威胁和风险的方法,并采用一种经济有效的防御技术。反应性防御是稍后识别攻击并作为缓解过程的一部分进行的工作,其中防御技术作为补丁部署到生产环境中。除了上述的防御技术之外,还存在一些新的研究工作,通过新的附加技术/算法来增强FL的安全能力。这种增强的例子是FL与一种更成功的技术(如区块链[128])的集成。

许多研究工作[129-131]将FL与一个更加分散的应用程序相结合,主要是区块链,它提供了一个不可变的分类帐来保存和持久化信息。在FL中,使用区块链技术主要有两个目的。一是为全球ML模型的主要贡献者提供激励,作为从客户那里获得更多贡献者的激励。第二个目的是保存全局模型参数,区块链分类账上的权重,以确保全局ML模型的安全性。在[129,130]中,作者演示了如何通过使用区块链技术在联邦客户端之间实现协调和信任。对于ML培训管理中心通过给予激励鼓励客户主动贡献学习过程的激励机制概念,目前已有研究[132-135]。

表2总结了当前FL的防御技术和它们所减轻的威胁类型。

- Sniper:长期以来,人们在FL集中环境下研究了不同类型的中毒攻击,包括数据和模型中毒。然而,只有少数研究在分布式环境下的中毒攻击,其中多个恶意参与者具有相同的攻击目标,旨在将中毒的训练样本合并到训练过程中。虽然分布式中毒攻击在FL中似乎是一个更大的威胁,但与传统的单一攻击者的中毒相比,多攻击者的分布式中毒的有效性仍不清楚。最近,作者在[136]中提出了Sniper方法,它可以识别合法用户,并显著降低中毒攻击的成功率,即使涉及多个攻击者。

- Knowledge distillation:它是模型压缩技术的一种变体,在这种技术中,一个经过充分训练的神经网络将需要做的事情的知识一步一步地转移到一个小模型。知识精馏节省了训练模型所涉及的计算成本。在FL中,只共享知识而不共享模型参数的概念可以用来增强客户机数据的安全性。作者在[137]中提出了一个联邦模型精馏框架,该框架提供了使用个性化ML模型的灵活性,并使用翻译人员收集与每个客户共享的知识。

- Anomaly detection:这种技术经常使用统计和分析方法来识别不符合预期模式或活动的事件。一个有效的异常检测系统需要一个正常行为或事件的概要来检测攻击是否偏离正常行为概要。在FL环境中,可以使用不同的异常检测技术检测不同的攻击,如数据中毒、模型中毒或木马威胁。例如,[139]的作者建议Auror作为一种防御恶意客户端更新的方法,在聚合步骤之前对每个客户端更新执行集群操作。这有助于检测恶意客户端更新。[138]使用欧几里德距离作为Krum模型来检测来自每个客户的输入参数的偏差。在一项类似的工作中,[147]的作者讨论了在FL中识别来自客户端的异常更新。[105,148]提出了使用自动编码器的异常检测防御,有助于识别恶意的本地模型更新。文献[148]的研究工作使用了基于变分自编码器的光谱异常检测[149-151]。此外,[105]的研究工作提出了LFR(Loss function based rejection)和ERR(Error rate based rejection),它们的灵感来自于现有的ML防御,如RONI((reject on negative impact)[152]和TRIM[153],以识别来自客户的消极影响更新。

- Moving target defense:移动目标防御概念是在2009年美国国家网络闰年峰会上提出的[154]。联邦网络安全研究与发展计划[155]将移动目标防御定义为一种部署各种机制和策略的方式,这些机制和策略会随着时间的推移不断变化,从而增加攻击者的成本和复杂性。移动目标防御也增加了系统的弹性,同时限制了系统漏洞的泄露和攻击的机会。移动目标防御是在服务器级、网络级和应用程序级保护入侵的最佳防御类型。它是一种主动防御体系结构,旨在掩盖漏洞来源,不让攻击者发现。防御技术,如IP跳跃,为DNS ping汇集虚拟IP是移动目标防御技术的有效方法。[141]的作者讨论了网络级移动目标防御来防止基于窃听的攻击。

- Federated MultiTask Learning:联邦学习在考虑到本地数据隐私的大量移动设备上提供协作训练ML模型。这种设置也可以扩展到联合多任务学习环境,在该环境中,多任务学习驱动个性化但共享的设备模型。例如,在[146]中提出的MOCHA框架旨在通过容错来加快学习过程,使其即使在设备丢失的情况下也能工作。该框架旨在解决FL环境中的统计和系统挑战,如高通信成本、掉线和容错问题。实验结果表明,该框架能够处理系统异质性中的变异性,对系统下降具有鲁棒性。关于联邦多任务学习的其他研究文献[156-159]很少给出。

- Trusted Execution Environment (TEE):一般来说,可信执行环境(TEE)被定义为执行代码的高级可信环境。这种技术也被用于不同的ML模型的隐私保护,其中计算资源的私有区域被隔离为一个特定的任务[160]。这种方法也适用于计算资源非常有限的联邦学习。TEE是一个抗篡改的处理环境,它提供了在主处理器的安全区域中执行的代码的完整性和保密性。文献[143]的作者讨论了这种主动防御技术。[144,161]中的作者提出了一个在联邦环境中使用TEE的框架。

- Data Sanitization:[142]首次提出的清洗训练数据主要用作异常检测器,以过滤出看起来可疑的训练数据点。[162,163]最近的工作旨在通过利用不同的稳健统计模型来改进数据消毒技术。在FL环境中,数据消毒技术是针对数据中毒攻击的常见防御技术之一,但是[164]的研究报告指出,更强的数据中毒攻击有可能打破数据消毒防御。

- Foolsgold:恶意客户端创建多个假身份,并向中央服务器发送伪造的更新。这种类型的攻击可能会破坏FL环境的安全性和真实性。作者在[145]中提出了一个傻瓜黄金的方法,这是有效的对抗基于Sybilbased,label flipping标签翻转,后门中毒攻击。

- Pruning:它是FL中的一种技术,它通过最小化ML模型的大小来降低复杂度和提高精度。在FL中,客户端具有相对较低的计算能力和通信带宽。当我们在FL环境中训练大型深度神经网络时,问题就出现了,因为与大型数据中心中的机器相比,客户机通常具有相对较低的计算能力和通信带宽。为了解决这些问题,作者在[108,109]中提出了一种剪枝技术。由于它不需要在这种方法中共享成熟的模型,它有助于更有效地解决后门攻击和通信瓶颈。

另一种基于GAN的针对FL安全性提出的防御技术称为PDGAN,它在[165]中提出,用于帮助防御来自FL恶意客户端的数据中毒攻击。还有一种防御技术,使用[166]中提出的垂直联邦学习方法,称为Secureboost框架,它基于梯度增强树算法。

5. Privacy in federated learning

默认情况下,FL通过减少网络(中央服务器)中的用户数据占用空间来提高隐私性。虽然这种隐私感知的机器学习框架(即FL)在理论上听起来很理想,但它也不能免受攻击,而且目前其使能技术的发展也足够成熟,可以预计在默认情况下解决所有的隐私问题,至少目前还不能。受此启发,本节旨在探讨联邦学习技术中存在的隐私问题和目前的相关成果,以期为联邦学习技术的未来发展提供更多的见解。

除了动机和既定目标之外,本节还专门回答以下与隐私有关的研究问题Research Privacy Question (RPQ):

- RPQ1:FL领域的隐私威胁/攻击是什么?

- RPQ2:在RPQ1中有哪些技术可以减轻已识别的威胁,并增强FL的一般隐私保护功能?

- RPQ3:与分布式ML解决方案相比,FL有哪些独特的隐私威胁?

- RPQ4:在RPQ2中识别的隐私保护技术的相关成本是什么?

在下面的章节中,我们将讨论基于每个研究问题的结果,从FL领域的所有当前工作的彻底分析中获得。

5.1. RPQ1: What are the privacy threats/attacks in FL domain?

FL的目的是通过要求参与者共享局部训练模型参数而不是他们的实际数据来保证参与者的隐私。然而,根据最近的研究,FL仍然存在一些隐私威胁,因为对手可以根据每个参与者上传的参数部分揭示原始训练数据集中的每个参与者的训练数据。FL中的这些关键威胁可以概括为不同类型的推理攻击。

5.1.1. Membership inference attacks

顾名思义,推理攻击是一种推断训练数据细节的方法。成员推理攻击[167]的目的是通过检查训练集上是否存在数据来获取信息。攻击者滥用全局模型来获取其他用户的训练数据。

在这种情况下,通过猜测来推断训练数据集上的信息,并训练预测模型来预测原始训练数据。[107]的作者探讨了神经网络在记忆训练数据时的脆弱性,这些数据容易受到被动和主动推理攻击。

5.1.2. Unintentional data leakage & reconstruction through inference

在这种情况下,来自客户机的更新或渐变会意外地泄露中央服务器上的信息。[168]作者利用了无意的数据泄露漏洞,并通过推理攻击成功地重构了其他客户端的数据。

[117]中的研究工作探讨了如何使用基于GANs的推理攻击无意中揭示来自诚实客户的私人数据。咨询客户使用GANs生成类似于培训数据的数据,并从FL中的其他客户处检索敏感信息。[169]中的恶意/好奇客户使用全局模型和参数重建其他客户的培训数据。

5.1.3. GANs-based inference attacks

GANs是近年来在大数据领域非常流行的生成式对抗网络,也适用于基于FL的方法。针对FL,[114]中的作者提出了mGAN-AI框架,用于探索基于GAN的对FL的攻击。mGAN-AI攻击是在FL环境的恶意中央服务器上进行的实验。它研究了针对来自恶意服务器的攻击的联邦学习的用户级隐私泄漏。mGAN-AI框架的被动版本分析所有客户端输入,而主动版本通过只向被隔离的实例发送全局更新来隔离客户端。利用mGAN-AI框架,推理攻击获得了最高的准确性,因为它不干扰训练过程。

然而,在FL客户中可能存在潜在的对手,这些客户可能只使用旧的本地数据作为其贡献,以换取全局模型。在获得全局模型后,可以使用推理技术推断其他客户信息。由于对客户概况和声誉的了解有限,这种行为很难辨别。此外,只有参数更新的协同训练也使得FL服务器难以评估每个客户端贡献的效果。

5.2. RPQ2: What are the techniques to mitigate identified threats in RPQ1 and enhance the general privacy-preserving feature of FL?

本节介绍已确定的隐私威胁的缓解策略。在客户端设备级保留数据的方法是FL的主要内置隐私特性,目前在FL中增强隐私保护和减少威胁的算法主要基于两类:安全多方计算(SMC)和差分隐私(DP)。

5.2.1. Secure multi-party computation

安全多方计算(SMC) (Secure Multi-party Computation,简称MPC)的概念最早被引入,是为了在多参与者共同计算一个模型或函数时保证输入的安全[170]。在SMC中,通信采用密码学方法进行保护。最近,SMC已经被用来在FL框架中保护来自客户端的更新。与传统的SMC算法不同,FL算法只需要对参数进行加密,无需对大量的数据输入进行加密,大大提高了计算效率。这一性能特点使SMC在FL环境中成为一个较好的选择。

[171]的作者探讨了中央服务器的客户端更新导致信息泄露的可能性。它们将加密与异步随机梯度下降相结合,有效地防止了中央服务器客户端的数据泄露。加密客户端更新,以确保没有信息泄漏。值得注意的是,在较大的景观环境中使用加密技术是昂贵的,并可能影响ML模型的效率。

[172]中的工作结合了两种隐私保护方法的优点,以减少客户数据暴露的风险。主要技术是同态加密和差分隐私的集成。针对FL环境下的隐私问题,提出了应用客户端级差分隐私并对模型更新进行加密的建议。使用该方法进行的实验声称具有较高的准确性,同时确保对诚实但好奇的服务器和其他FL用户的保护。[173]的作者提出了一种隐私增强的FL方法,即使在训练过程完成后也能提供隐私。这种方法类似于[172]中提出的加密和客户端级DP的集成。

因此,作为一种有前景的解决方案,基于SMC的解决方案仍存在一些挑战。主要的挑战是效率和隐私之间的平衡。与典型的FL框架相比,基于SMC的解决方案需要更多的时间,这可能会对模型训练产生负面影响。这一问题在具有数据新鲜度意识的训练任务中会得到加强,因为训练时间越长意味着数据价值的丢失。此外,如何为FL客户端设计一个轻量级的SMC解决方案仍然是一个开放的问题。

5.2.2. Differential privacy

差分隐私(DP)是一种广泛应用于工业和学术界的隐私保护技术。DP的主要概念是通过对个人敏感属性添加噪声来保护隐私[174]。因此,每个用户的隐私都受到了保护。同时,与增加隐私保护相比,每个用户增加的噪声造成的统计数据质量损失相对较低。在FL中,为了避免数据的反向检索,引入了DP对参与者上传的参数添加噪声。在[175]中提出了DPGAN框架,利用DP使基于GAN的攻击在推断深度学习网络中其他用户的训练数据时效率低下。同样,对于FL特定的环境也有DPFedAvg- GAN框架[176]。在[177]的作者解释了DP的好处和DP特性的定义,如随机化、组成,并举例说明了DP在多智能体系统、强化学习、迁移学习和分布式ML中的实现。[172,178]中的两项工作都结合了安全多方计算和差分隐私,实现了一个具有较高精度的安全FL模型。[179]的作者通过将变换技术与DP相结合,改进了FL模型的隐私保障,并使用一种隐形斗篷算法来掩盖用户数据。但是,这样的解决方案会给上传参数带来不确定性,可能会影响训练的效果。此外,这些技术使FL服务器更难评估客户端的行为来计算收益。

5.2.3. VerifyNet

VerifyNet[180]是一个隐私保护和可验证的FL框架。它被列为保护隐私的首选缓解策略,因为它提供了双重屏蔽协议,这使得攻击者很难推断出训练数据。为客户端验证中心服务器的结果提供了一种方法,保证了中心服务器的可靠性。除了提供安全性和隐私增强,VerifyNet框架是健壮的,可以处理多次退出。这个框架的唯一问题是通信开销,因为中央服务器必须向每个客户机发送可验证的证明。

5.2.4. Adversarial training

来自敌对用户的规避攻击旨在通过向机器学习模型中注入敌对样本来欺骗ML模型。对抗性数据的例子是对现实世界数据的不完善的预测。攻击者试图用扰动数据来影响FL模型的鲁棒性。对抗性训练是一种主动防御技术,从训练阶段开始就尝试攻击的所有排列,以使FL全局模型对已知的对抗性攻击具有鲁棒性。文献[181]的作者讨论了如何通过对抗性训练使学习模型对攻击具有鲁棒性。评估结果表明,对抗性训练对黑箱攻击仍然是脆弱的。因此,他们进一步引入了集合对抗训练,这是一种利用扰动来增强训练数据的技术。对抗性训练提高了用户数据的隐私性,因为增加了对抗性样本,最大限度地减少了通过推理揭示实际训练数据的威胁。

为保护FL的隐私而提出的其他防御工作很少,包括FEDXGB[182],它提出了针对FL的用户退出和重构/泄漏私人训练数据问题的防御。FEDXGB利用秘密共享技术,提出了训练轮的安全增强协议和对训练后的全局模型进行安全预测的安全预测协议。还有一些基于GANs的防御技术,如[183]中称为Anti-GAN,它有助于防止使用WGANs[184,185]生成假训练数据的推理攻击。这种情况发生在每个客户节点上,这使得很难从全局ML模型中推断实际的训练数据。FedGP[186]提出了类似的在客户端节点产生假数据的防御技术,但稍加修改,允许数据共享而不是模型共享。

5.3. RPQ3: What are the unique privacy threats to FL compared to distributed ML solutions?

FL在默认情况下提供了用户数据的隐私保护,因此很少有针对FL的隐私威胁。正如[187]所讨论和实验的,在保护用户数据隐私方面,FL比DML表现得更好。在有参数服务器的DML解决方案中,发起推理攻击(如5.1节所述)从其他客户端窃取信息将是最不可取的方法,因为数据很容易在参数服务器上或通过客户端更新访问。然而,对于DML应用程序,例如[8],训练良好的ML模型被外包为付费服务,因此很有可能受到基于推理的攻击[188,189]。

基于GANs的推理攻击(在第5.1.3节中讨论)在FL环境中是可行的,但对于DML解决方案是不太合适的方法。这使得基于GANs的推理攻击仅针对FL。GANs涉及两个神经网络来发起攻击,DML为攻击者提供了空间来发起更简单直接的攻击。GANs比较复杂,需要更多的计算资源,这使得它在DML解决方案中不太受欢迎。

然而,在FL的高级隐私环境中,基于GANs的推理攻击[114]值得付出努力,产生预期的结果,而对于DML提出的不那么复杂的策略,则无法实现这些结果。使用集中式数据解决方案的FL和ML中推理攻击的详细策略在[107]中进行了讨论。这项研究的结果表明,在独立的ML和FL环境中,可能的被动和主动推断攻击策略。在FL版本中,攻击者可以在聚合器服务器或客户端观察全局模型的更新,试图从其他客户端推断数据。在独立版本中,攻击者利用黑盒推断来检索敏感信息。

很少有FL提案[190]包括只使用FL最终产品而不涉及FL培训的买家/最终用户。对于FL的这些第三方终端用户,可以在FL中利用和调整关于独立和分布式ML解决方案的隐私的现有研究工作,以保护托管ML模型的隐私。我们建议读者阅读第5.2节和第5.4节,探讨FL附加隐私的防御措施和建议的费用,并在需要时结合附加隐私保护措施。此外,FL的培训阶段跳过了DML解决方案中观察到的大多数隐私威胁,从而为用户数据提供了急需的隐私,使得现有的DML隐私方面的工作不太适合FL的适应。

5.4. RPQ4: What is the associated cost with the privacy-preserving techniques identified in RPQ2?

每一个附加的增强都伴随着它自己的一组额外的成本和影响。这里的成本定义了由于实现了增强方法而产生的开销或结果。安全的多方计算和差分隐私增强了FL的隐私保护能力,但代价是在准确性和效率方面有较高的成本。在基于加密的安全多方计算方法中,每个客户端都需要对上传的所有参数进行加密。因此,每个客户机都需要花费额外的计算资源来执行加密。如果客户端设备受计算限制(如物联网设备常见的情况),这可能会引起关注。因此,为了使用加密来增强用户数据的隐私性,ML模型的效率可能会受到折衷。

在一项与FL成本分析相关的实证研究[191]中,作者在Reddit数据集上模拟,以了解dp支持的FL全局模型的准确性。他们的实验结果显示了不同的结果,DP-FL和nonDPFL环境对词汇大小相似的数据集显示了几乎相同的准确性。在词汇长度不同的实验中,DP-FL的准确性低于非DP-FL。该文的实验表明,在非均匀环境下,DP对精度有负面影响。

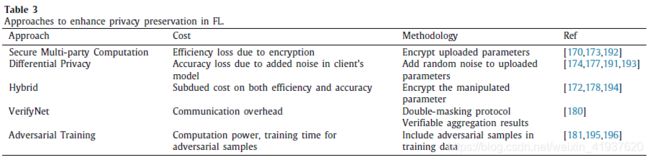

基于DP的方式对上传的参数进行噪声处理,增强通信和服务器上的隐私保护。然而,附加的噪声不可避免地会影响精度。它还可能进一步影响全球的聚合。这意味着在隐私保护的强度和精度损失以及效率(收敛时间)之间需要权衡。如果FL模型保持更多的隐私,它会失去更多的精度和花费更多的时间来收敛。相反,如果FL模型需要保持一定的精度或收敛时间,则需要估计隐私保护水平是否可以接受。表3总结了本节中讨论的隐私保护技术及其相关特征。

6. Other literature review work

文献中提出了一些类似调查的研究,目的是通过提供集体的见解和观点,探索局限于挑战/问题的方面,FL的架构风格用于联邦学习的不同领域/用例。

文献[197]的作者关注FL中的四个挑战,即昂贵的通信、系统异构性、统计异构性和隐私问题。作者提出了应对每个挑战的方法,但缺乏对FL环境完整性中可能出现的破坏进行深入分类的方法。作者在[198]中对现有的FL模型进行了分类,并对每个类别进行了总结。它强调从系统的角度来评估围绕FL的问题,从而建立一个健壮的FL环境。该文从数据隐私级别、机器模型、跨域数据划分和数据隐私的基本构建块等方面对数据隐私进行了分类,并对数据隐私进行了简要概述。[199]中的另一项调查工作给出了FL在水平、垂直和迁移学习方法以及相关用例中的详细架构和实现。这项工作对FL空间中现有研究工作的定义和信息进行了很好的总结,并详细介绍了垂直联邦学习方法中使用的加密技术的实现。然而,重点仍然放在不同场景下FL的实现细节上,而缺乏对FL中可能存在的风险的洞见。

很少有论文关注与FL相关的领域特定领域,它们的目的只是在不同的现实世界领域中引入可能有用的用例场景。其中一项工作是[200]中关于移动设备中的FL的全面调查,它给出了关于移动边缘网络中的FL以及诸如通信成本、隐私和其他问题的见解;针对FL实现的移动物联网设备中的数据安全和资源分配。这项调查的作者提供了使用不同方法实现FL的比较。很少有其他著作提出基于重要性的更新[201]、模型压缩[202,203]在FL的物联网具体实现中。探讨了在更大的景观物联网环境中,FL客户端的资源分配和参与选择策略,以缓解通信瓶颈和通信成本。自动驾驶汽车中的FL使得ML模型能够从其他在FL环境中配置的自动驾驶汽车中学习,而不是依赖于中央数据库,从而提高人工智能决策技能的效率。[204]的研究工作集中在FL的车载物联网设备上,并对该领域最近的成就和挑战进行了审查。

在谷歌发表的论文[36]中对FL的开放性问题进行了广泛的讨论。作者首先总结各种工作,方法和FL和总结开放挑战的定义与有趣的建议/问题研究人员进一步加强FL的效率。实现神经结构的一些建议搜索(NAS)[205]在FL解决冗余神经结构的一些客户可能会导致额外的计算。FL特有的超参数优化[206]以解决每一轮训练中的通信效率和成本,以及联邦公平性以避免FL中的偏差[207]是未来研究的其他建议领域。虽然本文详细探讨了FL的开放问题,但作者并没有像我们在本研究中那样深入讨论FL的隐私和安全风险。

综上所述,目前该领域最先进的研究调查和综述,从不同的角度、不同的目标和关注点为FL提供了卓越的研究成果。尽管对网络安全和隐私的审查很重要,但在文献中并没有得到充分的阐述,这导致了对网络安全方面深入研究的有组织的研究回顾工作的缺失。我们的研究工作致力于提供这一重点研究,以填补空白,以帮助社区和新来者深入了解FL安全和隐私。

7. Future directions in FL security and privacy

联邦学习有一系列需要进一步研究的挑战。基于我们的观察和结果,我们确定了以下可能形成未来研究途径的问题。

7.1. Zero-day adversarial attacks and their supporting techniques

目前,FL的防御措施旨在防范已知的漏洞和特定的预定义恶意活动,在测试时,它们在检测设计参数之外的攻击方面的作用较小。尽管这种现象适用于几乎任何ML应用程序的防御机制,但在FL中这种可能性更大,因为我们在生产中没有很多版本能够证明各种攻击的可能性。利用先进的深度学习技术取得的最新成果已经为对抗此类攻击提供了有希望的解决方案[208,209]。

7.2. Trusted traceability

FL的一个主要挑战是在底层ML过程的整个生命周期中跟踪全局ML模型。例如,如果一个预测值在全局ML模型中发生了更改,我们将需要具有回溯跟踪能力,以识别哪些客户端聚合值导致了该更改。如果ML模型行为背后的逻辑是一个黑盒子,那么我们将被迫失去对逻辑现实的掌控,盲目地依赖人工智能。有一些初步的工作是利用区块链技术[210-212]和FL来提供和跟踪事务更新到全局ML模型[129-131],希望在深度学习ML模型中实现对训练过程更透明的跟踪。

7.3. Well-defined process with APIs

FL是一种相当新的方法,它需要对不同方法的优缺点进行详细的分析。需要定义标准化的技术,以支持不同领域的FL的新兴需求。由于隐私是FL的关键因素,进一步的研究需要集中在增强隐私和为每个需求标准化方法上,并定义一个过程(使用通用API)来实现这些增强的方法。

7.4. Optimize trade-off between privacy protection enhancement and cost

目前的研究工作表明了如何以牺牲效率和准确性为代价来加强FL中的隐私保护。然而,对于SMC的适当加密级别和添加的噪声量,目前还没有相关的研究。如果加密水平或噪声量不够,参与者仍然存在隐私泄露的风险。反之,如果加密级别过高或参数中加入了过多的噪声,则FL模型的精度都很低。

7.5. Build FL privacy protection enhanced frameworks in practice

目前有一些FL框架可以用来实现基于FL的系统,如TensorFlow Federated、PySyft和FATE(在3.5节中讨论)。除了PySyft,目前还没有框架、库或工具箱可以集成和执行SMC或DP。因此,开发FL隐私保护增强框架可能是一个紧迫的研究方向,既有利于学术研究,也有利于FL在业界的采用。

7.6. Client selection and training plan in FL

在FL中,为培训轮选择客户的培训计划和策略至关重要。[213]的研究工作提出了最佳方法,但对于FL中的每个ML算法用例,仍然需要有一个标准化的方法。

7.7. Optimization techniques for different ML algorithms

基于不同的ML算法,需要有预定义的、标准化的优化算法来建立FL模型。有许多建议的聚合/优化算法(如3.4节所讨论的)建议优化或增强FL,但仍然需要专门的研究为所有当前ML应用/用例提供FL特定的优化算法。这有助于FL的未来实现者/适配器轻松开发FL特定的解决方案。

7.8. Vision on training strategies and parameters

[214]中的研究工作提出了一个最佳策略,帮助中央服务器设置一个最佳触发点来停止/重新开始训练回合。类似的研究工作需要针对不同的模型进行。ML应用领域,可以帮助理解FL特定超参数和可能的触发条件配置在FL训练回合。由于FL的培训需要时间、成本和计算成本,因此,在设置最优值方面有远见将有助于建立鲁棒且具有成本效益的FL解决方案。

7.9. Ease in migrating and productionising

值得注意的是,没有简单直接的方法来生产FL环境。[215]中的研究工作提出了在转向生产时需要考虑的许多因素,但是,仍然需要建立完善的指导方针,以便在FL中实现新的用例或将现有的ML环境迁移到分散的FL方法。

8. Conclusion

联合学习是一种通过分散学习来提倡设备上AI的新技术。FL被提议将机器学习的好处扩展到具有敏感数据的领域。在本文中,我们提供了一个全面的研究安全和隐私的成就,问题,以及在FL环境中的影响。通过对安全性和隐私的评估和结果,我们希望能提供新的视角,并引起社区对建立适合大众采用的无风险FL环境的关注。通过未来方向部分,我们概述了FL中需要深入研究和调查的领域。FL是市场上一个相对较新的框架,需要进一步的研究来确定适合不同FL环境风格的增强补充。