【Learning RAW-to-sRGB Mappings with Inaccurately Aligned Supervision通过不准确对齐的监督学习 RAW 到 sRGB 的映射】

摘要

学习 RAW 到 sRGB 映射近年来引起了越来越多的关注,其中训练输入的原始图像以模仿另一台相机捕获的目标 sRGB 图像。然而,严重的颜色不一致使得生成输入原始和目标 sRGB 图像的良好对齐训练对非常具有挑战性。虽然使用不准确对齐的监督进行学习很容易导致像素偏移并产生模糊的结果。在本文中,我们通过提出一种用于图像对齐和 RAW 到 sRGB 映射的联合学习模型来规避这个问题。为了减少图像对齐中颜色不一致的影响,我们引入了使用全局颜色映射(GCM)模块在给定输入原始图像的情况下生成初始 sRGB 图像,该图像可以保持像素的空间位置不变,并且目标 sRGB图像用于引导 GCM 将颜色转换为它。然后部署预训练的光流估计网络 flow estimation network (例如 PWC-Net)来扭曲目标 sRGB 图像以与 GCM 输出对齐。为了减轻不准确对齐监督的影响,利用扭曲的目标 sRGB 图像来学习 RAWto-sRGB 映射。训练完成后,可以将 GCM 模块和光流网络分离,从而不会为推理带来额外的计算成本。实验表明,我们的方法在 ZRR 和 SR-RAW 数据集上表现出色。通过我们的联合学习模型,轻量级主干可以在 ZRR 数据集上实现更好的定量和定性性能。代码可在 https://github.com/cszhilu1998/RAW-to-sRGB

1. Introduction

图像信号处理 (ISP) 管道是指对原始传感器图像进行处理以产生高质量的显示参考 sRGB 图像,因此对于相机系统至关重要。具有代表性的 ISP 管道通常涉及一系列步骤,包括去马赛克、白平衡、色彩校正、色调映射、去噪、锐化、伽马校正等 [40]。虽然目前的相机系统通常采用手工制作的 ISP 解决方案,但卷积网络 (CNN) 在以端到端方式学习深度 ISP 模型方面表现出巨大潜力 [22, 29, 45]。

深度 ISP 的端到端特性使得学习 RAW 到 sRGB 映射以生成用于移动相机的高质量图像 [22] 非常具有竞争力。尽管移动相机已成为主要的照片来源,但与 DSLR 相机相比,它的传感器尺寸更小,光圈也有限。通过学习 RAW 到 sRGB 映射以从移动原始图像生成类似 DSLR 的 sRGB 图像,深度 ISP 模型因此可以提供一种令人鼓舞的方法来缩小移动相机和 DSLR 相机之间的差距。此外,与 8 位 sRGB 图像相比,原始图像通常具有更高的位(例如,10-14 位)并且可以传达更丰富的细节。因此,即使对于其他低级视觉任务,例如图像超分辨率 [62]、低光图像去噪 [8] 和高动态范围成像 (HDR) [6],学习 RAW 到 sRGB 映射也有利于性能提升.

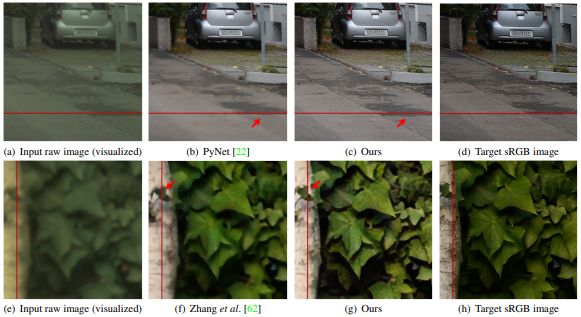

然而,在准备训练数据时,输入的原始图像和目标sRGB图像通常是用不同的相机(例如,智能手机和数码单反相机)或不同的相机配置(例如,焦距)拍摄。因此,颜色不一致和空间错位通常是不可避免的。一方面,颜色不一致使得生成排列整齐的输入原始图像和目标sRGB图像的训练对变得非常困难。输入的原始图像和目标sRGB图像通常不能被现有的方法完全对齐[34, 49],从而导致轻微的对齐。另一方面,在不准确对齐的监督下学习,容易出现像素偏移,产生模糊的结果(见图1(b))。为了缓解不准确对齐的不利影响,AWNet[9]采用了全局上下文块[5],代价是增加推理时间,而Zhang等人[62]提出了一个上下文双边(CoBi)损失来搜索监督的最佳匹配补丁。然而,基于补丁的对齐方式无法恰当地处理由物体之间的深度差异引起的空间变化错位。因此,他们的方法仍然容易产生模糊的结果,如图1(f)所示。

为了规避不准确对齐的监督问题,本文提出了一个用于图像对齐和RAW到sRGB映射的联合学习模型。我们认为,解释不准确/轻微对齐的一个主要原因是输入的原始图像和目标sRGB图像之间存在严重的颜色不一致。否则,现有的光流网络[10, 23, 46]可以很容易地被用来完成图像对齐的任务。因此,我们建议通过将精心设计的全局色彩映射(GCM)模块与预先训练好的光流估计网络(如PWC-Net[46])连接起来来进行图像配准。特别是,GCM模块涉及一个1×1卷积层的堆叠,以确保映射在空间上是独立的。为了克服颜色不一致的障碍,我们将GCM的输出限制在接近对齐的目标sRGB图像。值得注意的是,GCM仅在训练期间被部署为对齐目标sRGB图像。因此,我们也可以利用目标sRGB图像和坐标图来生成条件指导,以调节GCM的特征,从而减少颜色不一致的情况。然后,一个预先训练好的光流估计网络(例如PWC-Net[46])可以用来将目标sRGB图像与GCM的输出对准,从而得到对准好的sRGB图像。

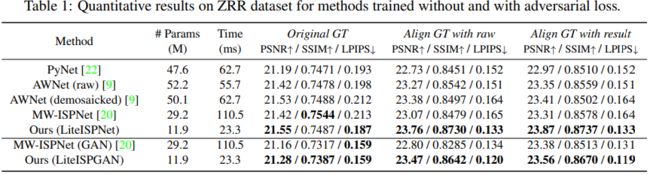

经过调整的目标sRGB图像可以作为训练RAW到sRGB映射的一个更好的监督。特别是,我们通过减少 MW-ISPNet [20] 中的剩余通道注意块 (RCAB) 来提出 LiteISPNet。 GCM 和 LiteISPNet 联合训练目标 sRGB 图像的对齐(即 GCM 和 PWC-Net)和 RAW 到 sRGB 的映射(即 LiteISPNet)。训练完成后,GCM 和 PWC-Net 可以分离,只需要 LiteISPNet 来处理测试原始图像,从而不会带来额外的推理成本。在 Zurich RAW 到 RGB(ZRR)数据集 [22] 上的实验表明,我们的解决方案在学习不准确对齐的监督和产生更精细的细节方面是有效的。我们提出的方法在定量指标、感知质量和计算效率方面也优于最先进的方法。此外,使用 SRResNet 作为主干,实验还表明了我们的方法在 SR-RAW 数据集上实现图像超分辨率的有效性 [62]。

图1:ZRR和SR-RAW数据集的数据对实例,可以观察到与参考线的明显空间错位。对于这种不准确对齐的训练数据,PyNet[22]和Zhang等人[62]容易产生空间错位的模糊结果,而我们的结果与输入的数据对齐良好。请放大以便更好地观察。

这项工作的主要贡献有三个方面。

- 提出了一种有效的方法,以规避在不准确对齐的监督下学习RAW到sRGB映射的任务。

- 一个全局色彩映射(GCM)模块被巧妙地设计出来,以解决色彩不一致对图像对齐的影响。利用空间保护网络 spatially preserving network(SPN)来避免像素的空间移动,并采用目标sRGB图像来调节GCM特征,以减少颜色不一致。

- 在ZRR和SRRAW数据集上的定量和定性结果显示,我们的方法优于最先进的方法,而且没有额外的推理成本。

2. Related Work

2.1. Deep Networks for ISP

相机 ISP 管道被部署来从原始图像生成显示参考的 sRGB 图像。为此,经典的 ISP 得到了广泛的研究,它通常涉及一系列子任务 [40],包括去马赛克、白平衡、色彩校正、色调映射、去噪、锐化、伽马校正等。对于每个子任务,许多方法文献[2,17,42,48]中提出了。受深度学习空前成功的推动,CNN 也被研究用于解决几个困难的 ISP 子任务,如图像去噪 [57、59、60]、去马赛克 [12、30、47]、自动白平衡 (AWB) [1 , 18, 33, 54] 和色调映射 [3, 13, 16, 58]。

最近,已经进行了几次尝试来学习具有深度模型的完整 ISP 管道。施瓦茨等人。 [45] 设计了一个 DeepISP 模型,以在给定在低光环境下捕获的原始图像的情况下生成光线充足的 sRGB 图像。 CameraNet [29] 明确地将子任务分为两类(即恢复和增强),并通过商业软件提取基本事实。伊格纳托夫等人。 [22] 收集了包含配对原始和 sRGB 图像的数据集,这些图像分别由华为 P20 智能手机和佳能 5D Mark IV 数码单反相机捕获。对于[22]中提出的数据集,提出了两个挑战[20,21]。在参与者提出的不错的方法中,MW-ISPNet [20] 利用 MWCNN [32] 和残差通道注意块residual channel attention blocks (RCAB) [63],AWNet [9] 采用全局上下文块 [5] 来学习非局部颜色映射,并且他们在感知轨道上获得了前两个名次[20]。在这项工作中,我们通过减少 MW-ISPNet [20] 中 RCAB 的数量来展示 LiteISPNet,以学习完整的 ISP 模型。通过将 LiteISPNet 与联合学习模型相结合,与 MW-ISPNet [20] 和 AWNet [9] 相比,可以获得更好的定量结果和感知质量。

2.2. RAW-to-sRGB Mappings for More Tasks

在[22]中,原始传感器和sRGB图像是用不同的相机拍摄的。这使得通过模仿其他相机或不同配置的相机来赋予低质量的原始传感器以产生高质量的sRGB图像是可行的。此外,原始图像的像素通常具有较高的位数(如10∼14位),在空间上是独立的,并且与亮度呈线性关系,因此可以传达更丰富的细节,有利于图像的增强。Chen等人[8]开创了这一工作思路,利用配对的低光原始图像和不同ISO设置的长曝光sRGB图像进行极端低光图像增强。他们还在[7]中进一步探索了极端低光下的视频增强。 类似地,原始图像也被用于其他低水平视觉任务,如HDR[6]和图像超级分辨率(SR)[55, 62]。在这项工作中,我们的方法也通过使用SRResNet[27]作为骨干对图像SR[62]进行了测试,并取得了更好的定量和定性结果。

此外,也有研究给出了重新利用或合并RAW-to-sRGB映射与高级视觉任务的方法。Wu等人[53]设计了一个visionISP模型,为物体检测生成更好的输入。Schwartz等人[44]通过提炼ISP管道和sRGB图像分类模型的知识,学习了一个用于原始图像分类的模型。

2.3. Alignment of Paired Raw and sRGB Images

为了学习 RAW 到 sRGB 的映射,输入的原始和目标 sRGB 图像通常使用不同的相机或不同的相机配置拍摄 [22, 62]。因此,由多个摄像机和场景中的运动引起的错位是不可避免的,阻碍了 RAW 到 sRGB 映射的学习,并导致模糊甚至像素偏移的结果。为了抑制场景中运动的影响,部署了双摄像头或多摄像头同时拍摄一些数据集,如 KITTI [11, 38] 和 MultiPIE [15]。还引入了分束器以在“相同位置”收集图像对,并为现实世界的超分辨率 [25] 和去模糊 [41] 设置不同的设置。尽管有这样的设备,错位仍然是不可避免的。

已经提出了几种方法来对齐来自不同来源的图像。在[19,22,52]中,SIFT关键点[34]被用于图像配准,其中同源性可以通过RANSAC算法[49]估计。Cai等人[4]设计了一种考虑亮度调整的像素级配方法,用于真实世界的超分辨率数据集。 Li等人[28]通过基于光流的方法[10, 23, 46]对引导图像进行了翘曲,用于面部图像修复。 然而,输入的原始图像和目标sRGB图像通常有严重的颜色不一致,无法通过现有的方法进行完美的对齐,从而导致轻度对齐。 全局上下文块[5,9]和CoBi损失[62]已经被引入,以缓解轻度对齐的影响,但仍然容易产生模糊的结果。在这项工作中,我们引入了一个全局色彩映射(GCM)模块来解决色彩不一致的问题,并提出了一个联合学习模型,用于图像对齐和RAW到sRGB的映射。

3. Proposed Method

在本节中,我们首先概述我们用于联合学习图像对齐和 RAW 到 sRGB 映射的模型。然后,详细设计了全局颜色映射 (GCM) 模块和 LiteISPNet,并提出了学习目标。我们还将我们提出的方法扩展到其他图像增强任务,例如图像 SR。

3.1. Joint Learning Model

用 x 和 y 表示原始图像和相应的目标 sRGB 图像。 RAW-to-sRGB 映射用于从 x 生成 sRGB 图像 y^,以近似目标 sRGB 图像 y 的颜色特征,

其中 表示参数为

表示参数为 的 RAW 到 sRGB 映射(例如,第 3.3 节中的LiteISPNet)。

的 RAW 到 sRGB 映射(例如,第 3.3 节中的LiteISPNet)。

然而,x 和 y 通常是使用不同的相机或不同的相机配置拍摄的,这会导致它们之间不可避免的空间错位。此外,x 和 y 之间严重的颜色不一致进一步使图像对齐更加困难。另一方面,RAW-to-sRGB 映射旨在模仿目标 sRGB 图像的颜色特征和精细细节。 x 和 y 之间的错位不利于 RAW 到 sRGB 映射的学习,因此容易产生具有不利像素偏移的模糊输出。已经提出了几种方法来提高对齐或学习鲁棒性,但仍然不足以抑制模糊输出。

图像对齐和 RAW 到 sRGB 映射的联合学习可以提供一些新的机会来规避此类问题。一方面,RAW-to-sRGB 映射有助于减少 x 和 y 之间的颜色不一致,从而减轻图像对齐的难度。另一方面,更好的图像对齐也有利于 RAW 到 sRGB 的映射,以抑制模糊输出和像素偏移。不幸的是,RAW-to-sRGB 映射(例如,[22])不能完全避免像素偏移(见图 1),因此将 y 与 y^ 对齐不能解决错位问题。

我们的联合学习模型不是将 y 与 y^ 对齐,而是利用精心设计的全局颜色映射 (GCM) 模块来生成颜色调整后的图像 y~ 以扭曲 y。首先使用一种简单的去马赛克方法(例如,双三次)通过填充 x 的缺失值来获得 x^ 。然后,引入 GCM 模块作为 x^ 的逐像素映射,因此可以保证在颜色校正中不引入任何像素偏移。此外,仅在训练期间才需要 GCM。因此,我们可以将目标 sRGB 图像和坐标图作为输入,以生成用于调制 GCM 特征以减少颜色不一致性的条件指导。因此,GCM 模块可以由下式给出.

其中 C 表示 GCM 模块,τ ∈ R (2×H×W) 是包含像素坐标的 2D 坐标图,归一化为 [-1, 1]。给定 y~ 和 y,我们使用预训练的光流网络(用 F 表示),例如 PWCNet [46],来估计光流 Ψ,

然后,估计的光流被用来对y进行扭曲,以形成一个扭曲的目标sRGB图像。

其中W是一种扭曲操作 warping operation(例如双线性插值)[46]。然后, 可以作为一个良好对齐的目标sRGB图像,用于监督公式(1)中RAW到sRGB的映射

可以作为一个良好对齐的目标sRGB图像,用于监督公式(1)中RAW到sRGB的映射 ,从而形成我们的联合学习模型(见图2)。

,从而形成我们的联合学习模型(见图2)。

图 2:提议的联合学习框架的图示。 (a) 联合学习模型的管道,其中 GCM 模块转换 x^ 的颜色(通过简单插值从 x 去马赛克)以获得更准确的光流,然后扭曲的 sRGB (y w ) 可以为 GCM 的联合训练提供对齐的监督和LiteISPNet。 (b) GCM 模块的结构,由 GuideNet 和 SPN 组成。目标 sRGB (y) 和坐标图 (τ) 用于指导颜色转换。 © LiteISPNet 的结构,请参考 Sec. 3.3 了解更多详情。 (d) © 中使用的残差组的结构。

3.2. GCM Module

对于光流估计,颜色调整后的图像y˜需要满足两个先决条件。(i) y˜应该模仿y的颜色以减少严重的颜色不一致。 (ii) 像素的空间位置应该与输入图像xˆ保持一致。根据[16],一些常用的图像处理操作可以用多层感知器(MLP)来近似或制定,而像素的性质确保了输入和输出是严格一致的。因此,我们部署了一个空间保护网络(SPN)作为我们GCM模块的骨干,它由1×1的卷积层堆积而成。

值得注意的是,仅在训练期间才需要 GCM。因此,目标 sRGB 图像也可以安全地输入 GCM,以便更好地将 y~ 转换为目标 sRGB 图像。为此,我们构建了一个 GuideNet,以从原始 (x^) 和目标 sRGB (y) 对生成条件引导向量(见图 2(b))。为了减轻未对齐对生成引导向量的影响,我们在 GuideNet 中使用了一个相对较大的内核(即 7×7),并部署了全局平均池来获取整体信息。

此外,在一些数据集(如ZRR[20])的原始图像中可以观察到暗角(又称渐晕),即从图像中心到边缘的亮度逐渐减弱。然而,标准的全局色彩映射并不足以补偿暗角的不利影响。幸运的是,暗角的影响可以通过二维坐标图的一个像素级函数(即公式(2)中的τ)来建模[56]。作为一种补救措施,我们只需将τ输入到SPN和GuideNet中,以便在学习颜色映射的同时处理反渐晕问题

使用 GCM 输出 y~ ,我们使用 PWC-Net [46] 来估计扭曲 warping 目标 sRGB 图像 y 的光流。然后可以采用扭曲的 sRGB 图像 ![]() 作为训练 GCM 的监督。此外,我们注意到像素级映射使 GCM 无法去除

作为训练 GCM 的监督。此外,我们注意到像素级映射使 GCM 无法去除![]() 中的噪声。尽管如此,受益于 PWC-Net [46],我们仍然可以稳健地估计 y~ 和 y 之间的光流。

中的噪声。尽管如此,受益于 PWC-Net [46],我们仍然可以稳健地估计 y~ 和 y 之间的光流。

3.3. LiteISPNet

为了减轻轻微对齐,现有方法通常构建大型模型并利用特定模块 [9,22],以增加推理时间为代价提高性能。考虑到通过联合学习可以获得更好的对齐,我们可以采用更有效的网络来学习 RAW-to-sRGB 映射,以实现可比甚至更好的性能。因此,我们通过简化 MW-ISPNet [20] 来呈现 LiteISPNet,这是一个基于 UNet [43] 的多级小波 ISP 网络。特别是,我们参考[31]将卷积层和残差组[63]放在每个小波分解之前。此外,我们还将每个残差组中的 RCAB 数量从 20 个减少到 4 个,以构建 LiteISPNet 主干网。图 2© 说明了 LiteISPNet 的网络结构。受益于结构修改和联合学习,LiteISPNet 在数量和质量上都优于 MW-ISPNet [20],模型大小约为 40%,运行时间约为 20%。

3.4. Learning Objectives

使用预训练的 PWC-Net [46] 来计算光流,可以联合训练 GCM 和 LiteISPNet 来学习图像对齐和 RAW 到 sRGB 的映射。下面,我们分别介绍 GCM 和 LiteISPNet 的损失项。

Loss Term for GCM

用y˜表示方程2中的GCM输出,用![]() 表示方程4中的扭曲目标sRGB图像。 GCM的损失项由以下方式给出。

表示方程4中的扭曲目标sRGB图像。 GCM的损失项由以下方式给出。

![]()

其中 ◦ 表示逐项乘积,![]() 是

是 ![]() 损失,m 是表示光流有效位置的掩码。这里,m 的每个元素 mi 定义为:

损失,m 是表示光流有效位置的掩码。这里,m 的每个元素 mi 定义为:

![]()

其中 1 表示全 1 矩阵,![]() 是设置为 0.001 的阈值,

是设置为 0.001 的阈值,![]() 表示矩阵的第 i 个元素。

表示矩阵的第 i 个元素。

Loss Terms for LiteISPNet.

用yˆ表示公式1中的LiteISPNet输出。LiteISPNet是用![]() 损失和(基于VGG的)感知损失的组合来训练的[36],可以写成:

损失和(基于VGG的)感知损失的组合来训练的[36],可以写成:

其中 ![]() 表示预训练的 VGG-19 [36] 网络,我们设置

表示预训练的 VGG-19 [36] 网络,我们设置![]() 。此外,为了进一步提高视觉质量,我们还训练了具有对抗性损失的 LiteISPNet [14]。在 LSGAN [37] 之后,损失函数定义为,

。此外,为了进一步提高视觉质量,我们还训练了具有对抗性损失的 LiteISPNet [14]。在 LSGAN [37] 之后,损失函数定义为,

其中,D表示判别器(详细结构配置见附录),它是通过以下方式训练的

然后,LiteISPGAN 由带有损失的训练提供,

![]()

![]()

Learning Objective

使用上述损失项,我们模型的整体学习目标可以定义为:

![]()

3.5.扩展到其他图像增强任务

正如之前在第2.2节中所讨论的,RAW到sRGB的映射已经与许多其他任务结合在一起,在这些任务中,人们付出了大量的努力来减轻错位的影响[6,55,62]。在这些场景中,对准的主要障碍与ISP问题相似[22],因此,所提出的联合训练框架可以自然地扩展到许多图像增强任务中。在本文中,我们对原始图像SR[62]任务进行了实验,以显示我们方法的泛化能力。

图 3:ZRR 数据集的视觉比较。请放大以便更好地观察。

4. Experiments

4.1. Implementation Details