天池-金融风控训练营-task1-赛题理解

金融风控训练营传送门:

AI训练营金融风控-阿里云天池阿里云天池龙珠计划,继承天池“让全世界没有能力access到大数据的人可以公平地access到大数据”的信念,让全世界想自学AI人工智能的人可以一起学习。训练营金融风控,15天30小时,6个任务,分为赛题解析、EDA、特征工程、建模与调参和模型融合五大主块,最后一部分是参与实际竞赛,快来为简历加分吧。https://tianchi.aliyun.com/specials/activity/promotion/aicampfrtask1传送门:

金融风控-Task1-天池实验室-实时在线的数据分析协作工具,享受免费计算资源天池实验室中的:金融风控-Task1实验介绍及https://tianchi.aliyun.com/notebook-ai/detail?spm=5176.20850282.J_3678908510.2.f2984d574Roye1&postId=170948

一、学习知识概要

1. 熟悉评分体系(模型评价指标公式、利用python计算这些模型评价指标)

2. 熟悉比赛流程 零基础入门金融风控-贷款违约预测赛题与数据-天池大赛-阿里云天池

二、学习内容

1. 评分体系(贷款违约预测是个分类问题,故下面只介绍分类算法常见的评估指标):

1.1 混淆矩阵(Confuse Matrix):

- (1)若一个实例是正类,并且被预测为正类,即为真正类TP(True Positive )

- (2)若一个实例是正类,但是被预测为负类,即为假负类FN(False Negative )

- (3)若一个实例是负类,但是被预测为正类,即为假正类FP(False Positive )

- (4)若一个实例是负类,并且被预测为负类,即为真负类TN(True Negative )

1.2 准确率(Accuracy)

准确率是常用的一个评价指标,但是不适合样本不均衡的情况。

1.3 精确率(Precision)

又称查准率,正确预测为正样本(TP)占预测为正样本(TP+FP)的百分比。

1.4 召回率(Recall=TPR)

又称为查全率,正确预测为正样本(TP)占正样本(TP+FN)的百分比。

1.5 F1score

精确率和召回率是相互影响的,精确率升高则召回率下降,召回率升高则精确率下降,如果需要兼顾二者,就需要精确率、召回率的调和平均F1 Score。

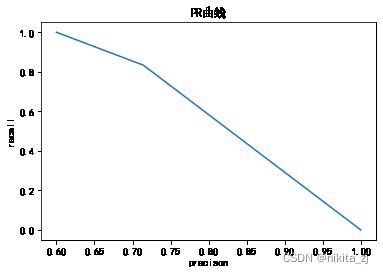

1.6 P-R曲线

P-R曲线是描述精确率和召回率变化的曲线。

性能评估之PR曲线与ROC曲线 - 简书冒泡!又是周末啦~小李上线啦!放假瘫在家里做咸鱼真的好快落诶,但也要坚持输出。今天主要叙述在二分类问题中性能评估的两个曲线。———————————————————— PR曲线...https://www.jianshu.com/p/ac46cb7e6f87

1.7 ROC

- ROC空间将假正例率(FPR)定义为 X 轴,真正例率(TPR)定义为 Y 轴。

TPR:在所有实际为正例的样本中,被正确地判断为正例之比率。

![]()

FPR:在所有实际为负例的样本中,被错误地判断为正例之比率。

1.8 AUC(Area Under Curve)

被定义为 ROC曲线 下与坐标轴围成的面积,显然这个面积的数值不会大于1。又由于ROC曲线一般都处于y=x这条直线的上方,所以AUC的取值范围在0.5和1之间。AUC越接近1.0,检测方法真实性越高;等于0.5时,则真实性最低,无应用价值。

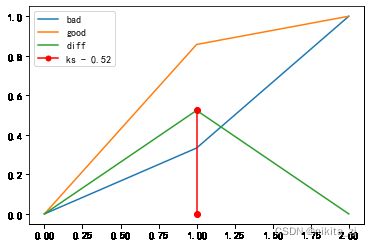

1.9 KS

KS统计量由两位苏联数学家A.N. Kolmogorov和N.V. Smirnov提出。在风控中,KS常用于评估模型区分度。区分度越大,说明模型的风险排序能力(ranking ability)越强。 K-S曲线与ROC曲线类似,不同在于

- ROC曲线将真正例率和假正例率作为横纵轴

- K-S曲线将真正例率和假正例率都作为纵轴,横轴则由选定的阈值来充当。公式如下:

![]()

FPR、cum(bad_rate)的等价以及其他更多ks相关信息可参考:

风控模型—区分度评估指标(KS)深入理解应用 - 知乎 (zhihu.com)![]() https://zhuanlan.zhihu.com/p/79934510

https://zhuanlan.zhihu.com/p/79934510

KS不同代表的不同情况,一般情况KS值越大,模型的区分能力越强,但是也不是越大模型效果就越好,如果KS过大,模型可能存在异常,所以当KS值过高可能需要检查模型是否过拟合。以下为KS值对应的模型情况,但此对应不是唯一的,只代表大致趋势。

| KS(%) | 好坏区分能力 |

|---|---|

| 20以下 | 不建议采用 |

| 20-40 | 较好 |

| 41-50 | 良好 |

| 51-60 | 很强 |

| 61-75 | 非常强 |

| 75以上 | 过于高,疑似存在问题 |

remark:

其中,金融风控预测中常用ROC\AUC\KS作为评估指标。

2. 分类指标评价计算示例

2.1 混淆矩阵

## 混淆矩阵

import numpy as np

from sklearn.metrics import confusion_matrix

y_pred = [0, 1, 0, 1]

y_true = [0, 1, 1, 0]

print('混淆矩阵:\n',confusion_matrix(y_true, y_pred))混淆矩阵:

[[1 1]

[1 1]]2.2 accuracy

## accuracy

from sklearn.metrics import accuracy_score

y_pred = [0, 1, 0, 1]

y_true = [0, 1, 1, 0]

print('ACC:',accuracy_score(y_true, y_pred))ACC: 0.52.3 precision\recall\f1-score

## Precision,Recall,F1-score

from sklearn import metrics

y_pred = [0, 1, 0, 1]

y_true = [0, 1, 1, 0]

print('Precision',metrics.precision_score(y_true, y_pred))

print('Recall',metrics.recall_score(y_true, y_pred))

print('F1-score:',metrics.f1_score(y_true, y_pred))Precision 0.5

Recall 0.5

F1-score: 0.52.4 PR曲线

## P-R曲线

import matplotlib.pyplot as plt

from sklearn.metrics import precision_recall_curve

plt.rcParams['font.sans-serif']=['SimHei']

plt.rcParams['axes.unicode_minus'] = False

y_pred = [0, 1, 1, 0, 1, 1, 0, 1, 1, 1]

y_true = [0, 1, 1, 0, 1, 0, 1, 1, 0, 1]

precision, recall, thresholds = precision_recall_curve(y_true, y_pred)

plt.title(r'PR曲线')

plt.plot(precision, recall)

plt.xlabel('precison')

plt.ylabel('recall')

plt.show()2.5 ROC曲线

## ROC曲线

from sklearn.metrics import roc_curve

y_pred = [0, 1, 1, 0, 1, 1, 0, 1, 1, 1]

y_true = [0, 1, 1, 0, 1, 0, 1, 1, 0, 1]

FPR,TPR,thresholds=roc_curve(y_true, y_pred)

plt.title('ROC')

plt.plot(FPR, TPR,'b')

plt.plot([0,1],[0,1],'r--')

plt.ylabel('TPR')

plt.xlabel('FPR')

plt.show()2.6 AUC

## AUC

import numpy as np

from sklearn.metrics import roc_auc_score

y_true = np.array([0, 0, 1, 1])

y_scores = np.array([0.1, 0.4, 0.35, 0.8])

print('AUC socre:',roc_auc_score(y_true, y_scores))AUC socre: 0.752.7 KS值

## KS值 在实际操作时往往使用ROC曲线配合求出KS值

from sklearn.metrics import roc_curve

y_pred = [0, 1, 1, 0, 1, 1, 0, 1, 1, 1]

y_true = [0, 1, 1, 0, 1, 0, 1, 1, 1, 1]

FPR,TPR,thresholds=roc_curve(y_true, y_pred)

KS=abs(FPR-TPR).max()

print('KS值:',KS)

# 画图,画出曲线

plt.plot(FPR, label='bad')

plt.plot(TPR, label='good')

plt.plot(abs(FPR-TPR), label='diff')

# 标记ks

x = np.argwhere(abs(FPR-TPR) == KS)[0, 0]

plt.plot((x, x), (0, KS), label='ks - {:.2f}'.format(KS), color='r', marker='o', markerfacecolor='r', markersize=5)

plt.scatter((x, x), (0, KS), color='r')

plt.legend()

plt.show()KS值: 0.5238095238095237补充下ks和auc的其他画法(调用制作评分卡的包scorecardpy):

# ks\roc其他画法

import scorecardpy as sc

y_true = np.array([0, 0, 1, 1])

y_scores = np.array([0.1, 0.4, 0.35, 0.8])

sc.perf_eva(y_true, y_scores)

plt.show()但是不得不说,这个包虽然用着简单,但是good和bad两条曲线的颜色无法区分,可能带来一些看图的障碍。从这个角度来讲,可能还是手动画图好些。

三、学习问题与解答

过程主要遇到一个问题,即阅读不同资料时,有些地方告诉我ks等于tpr和fpr的差的最大值,有些地方告诉我,ks等于累计好人比-累计坏人比的最大值,一直无法通过自己的思考将二者进行统一。直到看到了风控模型—区分度评估指标(KS)深入理解应用 - 知乎,此文解答了我的疑惑,我愿称之为ks深度好文!

四、学习思考与总结

task1主要还是在介绍各种评价指标的概念并给出计算示例。其他部分,如数据读取、评分卡等都是简单介绍。计划在完成金融风控训练营所有内容后,基于比赛数据集,制作一个评分卡(考虑使用scorecard和toad进行尝试)。