Win RTX3070+cuda11.4+cuDNNv8.2.2+torch-gpu离线安装+tensorflow-gpu安装

查看cuda版本:鼠标右键,NVIDIA控制面板——系统信息——组件查看cuda版本

或者 Win+R ——cmd——输入命令:

nvidia-smi 查看cuda版本

下载cuda11.4:下载cuda_11.4.0_471.11_win10安装程序,可以官网下载,下载比较快,如果你的cuda是其他版本需要下载对应版本,下载到哪个盘都可以

官网网址:https://developer.nvidia.com/cuda-toolkit-archive

安装cuda: 默认安装路径即可,不用更改,记住你的安装路径待会需要这个路径配置环境变量

出现以下界面,安装完成

配置cuda的环境变量:

CUDA_BIN_PATH C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4\bin CUDA_LIB_PATH C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4\lib\Win64 CUDA_SDK_BIN C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4\cudasdk\common\bin\Win64

CUDA_SDK_LIB C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4\cudasdk\common\common\lib\Win64

标注蓝色的意思是cuda的默认安装路径 安装地址:C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4

验证cuda安装是否成功: 重启电脑——Win+R——cmd——输入命令:

nvcc -V 出现以下界面证明安装成功

下载cuDNN: 官网可以查看跟cuda11.4相匹配的cuDNN版本

官网网址:https://developer.nvidia.com/zh-cn/cudnn(打开很慢下载还需要注册,按照步骤注册即可,邮箱登录) 可以先登录再打开下载网址:https://developer.nvidia.com/rdp/cudnn-download 查找cuda对应的cuDNN版本,但是有时候打不开下载界面,建议知道版本后还是去csdn搜一下有没有相应版本的cuDNN安装包

cuDNN v8.2.2 百度网盘链接:https://pan.baidu.com/s/1dPk732KfiYCQlpeA3d1noA

提取码:qwer

安装cuDNN: 下载cuDNN安装包之后解压得到三个文件夹

安装cuDNN: 下载cuDNN安装包之后解压得到三个文件夹

找到cuda的安装路径:C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4

1.找到这三个跟cuDNN解压后同名的文件夹

2.把cuDNN三个文件夹里面的内容,也就是这些LIB文件分别对应复制到cuda安装路径的三个文件夹中

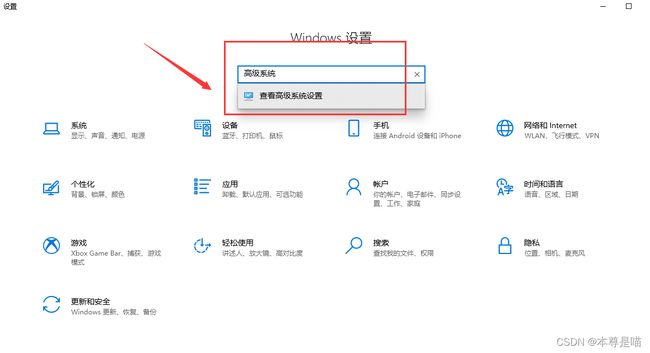

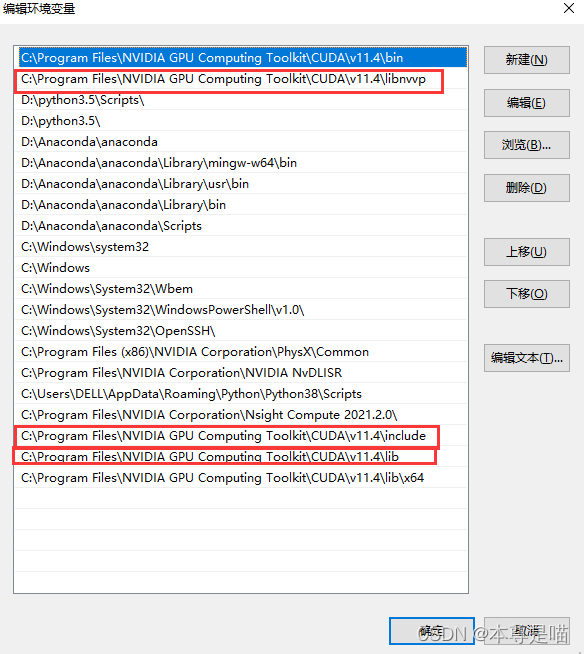

配置cuDNN环境变量: 设置——高级系统设置——环境变量——系统变量——path——编辑——新建

配置cuDNN环境变量:

需要path添加的环境变量:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4\include

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4\lib

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4\libvvp

验证cuDNN安装成功: 进入到cuda安装路径文件夹——extras——deno_suite文件夹下,找到 deviceQuery.exe 和 bandwidthTest.exe

Win+R——cmd依次输入命令:

cd C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4\extras\demo_suitedeviceQuery.exe出现以下界面证明安装成功

继续输入命令:

bandwidthTest.exe 出现以下界面证明安装成功

Anaconda Prompt新建环境名为gpu的虚拟环境:

conda create -n gpu python=3.8激活环境:

conda activate gpupytorch安装: 建议离线安装 pytorch官网:https://pytorch.org/get-started/locally/

查看自己cuda版本的torch、torchvision和torchaudio具体版本,记下来待会下载对应的离线安装包

离线安装包下载网址:https://download.pytorch.org/whl/torch_stable.html 注意下载gpu版本的,而且需要跟自己建的环境的python版本对应

下载安装包到哪个盘都行,我一般先放在桌面上,然后到新建的环境下 pip install 加完整离线安装包的路径,如果放在桌面上直接把安装包拖到Anaconda Prompt里面路径自己就出现了,torch、torchvision和torchaudio具体版本离线安装都是一样的过程

把桌面上的安装包拖到pip install 后面即可出现完整路径

pytorch安装成功验证: 打开Pycharm自己新建的环境(安装pytorch), 运行以下代码,True证明成功,如果步骤没有问题Flase可以重启看看, 一般Flase都是因为版本不匹配导致的,就需要重新下载对应版本安装包重新安装 直接复制代码如下:

#判断是否安装了cuda

import torch

print(torch.cuda.is_available()) #返回True则说明已经安装了cuda

#判断是否安装了cuDNN

from torch.backends import cudnn

print(cudnn.is_available()) #返回True则说明已经安装了cuDNN

tensorflow-gpu安装: Anaconda Prompt到自己的新建环境下寻找可安装的tensorflow-gpu版本:

conda search tensorflow-gpu然后命令行安装tensorflow-gpu相应版本即可,版本号相应改一下即可

例如:

pip install tensorflow-gpu==2.3.0 --default-timeout=10000 -i https://pypi.doubanio.com/simpletensorflow-gpu验证安装是否成功: 打开Pycharm自己新建的环境(已安装pytorch), 运行以下2种代码1种即可: 直接复制代码即可,出现GPU相关信息即可证明成功

import tensorflow as tf

gpu_device_name = tf.test.gpu_device_name()

print(gpu_device_name)

# 返回True或者False

tf.test.is_gpu_available()

或者

from tensorflow.python.client import device_lib

# 列出所有的本地机器设备

local_device_protos = device_lib.list_local_devices()

# 打印

print(local_device_protos)

# 只打印GPU设备

# [print(x) for x in local_device_protos if x.device_type == 'GPU']

本文可能有些图片来源于网络,我也记不清了,侵权及时删。