机器学习特征工程总结

1.什么是特征工程

有这么一句话在业界广泛流传,数据和特征决定了机器学习的上限,而模型和算法只是逼近这个上限而已。那特征工程到底是什么呢?顾名思义,其本质是一项工程活动,目的是最大限度地从原始数据中提取特征以供算法和模型使用。

特征工程主要分为三部分:

1.数据预处理 对应的sklearn包:sklearn-Processing data

2.特征选择 对应的sklearn包: sklearn-Feature selection

3.降维 对应的sklearn包: sklearn-Dimensionality reduction

本文中使用sklearn中的IRIS(鸢尾花)数据集来对特征处理功能进行说明,首先导入IRIS数据集的代码如下:

1 from sklearn.datasets import load_iris

2

3 #导入IRIS数据集

4 iris = load_iris()

5

6 #特征矩阵

7 iris.data

8

9 #目标向量

10 iris.target

2. 数据预处理

通过特征提取,我们能得到未经处理的特征,这时的特征可能有以下问题:

- 不属于同一量纲:即特征的规格不一样,不能够放在一起比较。无量纲化可以解决这一问题。

- 信息冗余:对于某些定量特征,其包含的有效信息为区间划分,例如学习成绩,假若只关心“及格”或不“及格”,那么需要将定量的考分,转换成“1”和“0”表示及格和未及格。二值化可以解决这一问题。

- 定性特征不能直接使用:通常使用哑编码的方式将定性特征转换为定量特征,假设有N种定性值,则将这一个特征扩展为N种特征,当原始特征值为第i种定性值时,第i个扩展特征赋值为1,其他扩展特征赋值为0。哑编码的方式相比直接指定的方式,不用增加调参的工作,对于线性模型来说,使用哑编码后的特征可达到非线性的效果。

- 存在缺失值:填充缺失值。

- 信息利用率低:不同的机器学习算法和模型对数据中信息的利用是不同的,之前提到在线性模型中,使用对定性特征哑编码可以达到非线性的效果。类似地,对定量变量多项式化,或者进行其他的数据变换,都能达到非线性的效果。

我们使用sklearn中的preproccessing库来进行数据预处理。

2.1 无量纲化

无量纲化使不同规格的数据转换到同一规格

2.1.1 标准化(也叫Z-score standardization)(对列向量处理)

将服从正态分布的特征值转换成标准正态分布,标准化需要计算特征的均值和标准差,公式表达为:

使用preproccessing库的StandardScaler类对数据进行标准化的代码如下:

1 from sklearn.preprocessing import StandardScaler

2

3 #标准化,返回值为标准化后的数据

4 StandardScaler().fit_transform(iris.data)

2.1.2 区间缩放(对列向量处理)

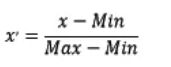

区间缩放法的思路有多种,常见的一种为利用两个最值进行缩放,公式表达为:

使用preproccessing库的MinMaxScaler类对数据进行区间缩放的代码如下:

1 from sklearn.preprocessing import MinMaxScaler

2

3 #区间缩放,返回值为缩放到[0, 1]区间的数据

4 MinMaxScaler().fit_transform(iris.data)

在什么时候使用标准化比较好,什么时候区间缩放比较好呢?

- 在后续的分类、聚类算法中,需要使用距离来度量相似性的时候、或者使用PCA、LDA这些需要用到协方差分析进行降维的时候,同时数据分布可以近似为正太分布,标准化方法(Z-score

standardization)表现更好。 - 在不涉及距离度量、协方差计算、数据不符合正太分布的时候,可以使用区间缩放法或其他归一化方法。比如图像处理中,将RGB图像转换为灰度图像后将其值限定在[0

255]的范围。

2.1.3 归一化(对行向量处理)

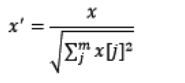

归一化目的在于样本向量在点乘运算或其他核函数计算相似性时,拥有统一的标准,也就是说都转化为“单位向量”。规则为l2的归一化公式如下:

使用preproccessing库的Normalizer类对数据进行归一化的代码如下:

1 from sklearn.preprocessing import Normalizer

2

3 #归一化,返回值为归一化后的数据

4 Normalizer().fit_transform(iris.data)

2.2 对定量特征二值化(对列向量处理)

定性与定量区别

定性:博主很胖,博主很瘦

定量:博主有80kg,博主有60kg

一般定性都会有相关的描述词,定量的描述都是可以用数字来量化处理

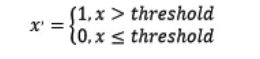

定量特征二值化的核心在于设定一个阈值,大于阈值的赋值为1,小于等于阈值的赋值为0,公式表达如下:

使用preproccessing库的Binarizer类对数据进行二值化的代码如下:

1 from sklearn.preprocessing import Binarizer

2

3 #二值化,阈值设置为3,返回值为二值化后的数据

4 Binarizer(threshold=3).fit_transform(iris.data)

2.3 对定性特征哑编码(对列向量处理)

因为有些特征是用文字分类表达的,或者说将这些类转化为数字,但是数字与数字之间是没有大小关系的,纯粹的分类标记,这时候就需要用哑编码对其进行编码。IRIS数据集的特征皆为定量特征,使用其目标值进行哑编码(实际上是不需要的)。使用preproccessing库OneHotEncoder类对数据进行哑编码的代码如下:

1 from sklearn.preprocessing import OneHotEncoder

2

3 #哑编码,对IRIS数据集的目标值,返回值为哑编码后的数据

4 OneHotEncoder().fit_transform(iris.target.reshape((-1,1)))

2.4 缺失值计算(对列向量处理)

由于IRIS数据集没有缺失值,故对数据集新增一个样本,4个特征均赋值为NaN,表示数据缺失。使用preproccessing库的Imputer类对数据进行缺失值计算的代码如下:

1 from numpy import vstack, array, nan

2 from sklearn.preprocessing import Imputer

3

4 #缺失值计算,返回值为计算缺失值后的数据

5 #参数missing_value为缺失值的表示形式,默认为NaN

6 #参数strategy为缺失值填充方式,默认为mean(均值)

7 Imputer().fit_transform(vstack((array([nan, nan, nan, nan]), iris.data)))

2.5 数据变换

2.5.1 多项式变换(对行向量处理)

常见的数据变换有基于多项式的、基于指数函数的、基于对数函数的。4个特征,度为2的多项式转换公式如下:

使用preproccessing库的PolynomialFeatures类对数据进行多项式转换的代码如下:

1 from sklearn.preprocessing import PolynomialFeatures

2

3 #多项式转换

4 #参数degree为度,默认值为2

5 PolynomialFeatures().fit_transform(iris.data)

2.5.1 自定义变换

基于单变元函数的数据变换可以使用一个统一的方式完成,使用preproccessing库的FunctionTransformer对数据进行对数函数转换的代码如下:

1 from numpy import log1p

2 from sklearn.preprocessing import FunctionTransformer

3

4 #自定义转换函数为对数函数的数据变换

5 #第一个参数是单变元函数

6 FunctionTransformer(log1p).fit_transform(iris.data)

当数据预处理完成后,我们需要选择有意义的特征输入机器学习的算法和模型进行训练。通常来说,从两个方面考虑来选择特征:

- 特征是否发散:如果一个特征不发散,例如方差接近于0,也就是说样本在这个特征上基本上没有差异,这个特征对于样本的区分并没有什么用。

- 特征与目标的相关性:这点比较显见,与目标相关性高的特征,应当优选选择。除方差法外,本文介绍的其他方法均从相关性考虑。

根据特征选择的形式又可以将特征选择方法分为3种:

-

Filter:过滤法,不用考虑后续学习器,按照发散性或者相关性对各个特征进行评分,设定阈值或者待选择阈值的个数,选择特征。

-

Wrapper:包装法,需考虑后续学习器,根据目标函数(通常是预测效果评分),每次选择若干特征,或者排除若干特征。

-

Embedded:嵌入法,是Filter与Wrapper方法的结合。先使用某些机器学习的算法和模型进行训练,得到各个特征的权值系数,根据系数从大到小选择特征。

我们使用sklearn中的feature_selection库来进行特征选择。

3.1 Filter

先进行特征选择,然后去训练学习器,所以特征选择的过程与学习器无关相当于先对特征进行过滤操作,然后用特征子集来训练分类器。

主要思想:对每一维特征“打分”,即给每一维的特征赋予权重,这样的权重就代表着该特征的重要性,然后依据权重排序。

主要方法:

Chi-squared test(卡方检验)

Information gain(信息增益)

Correlation coefficient scores(相关系数)

优点:运行速度快,是一种非常流行的特征选择方法。

缺点:无法提供反馈,特征选择的标准/规范的制定是在特征搜索算法中完成,学习算法无法向特征搜索算法传递对特征的需求。另外,可能处理某个特征时由于任意原因表示该特征不重要,但是该特征与其他特征结合起来则可能变得很重要。

3.1.1 方差选择法

使用方差选择法,先要计算各个特征的方差,然后根据阈值,选择方差大于阈值的特征。使用feature_selection库的VarianceThreshold类来选择特征的代码如下:

1 from sklearn.feature_selection import VarianceThreshold

2

3 #方差选择法,返回值为特征选择后的数据

4 #参数threshold为方差的阈值

5 VarianceThreshold(threshold=3).fit_transform(iris.data)

3.1.2 卡方检验

卡方检验是一种用途很广的计数资料的假设检验方法,由卡尔•皮尔逊提出。卡方值描述两个事件的独立性或者描述实际观察值与期望值的偏离程度。卡方值越大,表名实际观察值与期望值偏离越大,也说明两个事件的相互独立性越弱。

检验特征对标签的相关性,选择其中K个与标签最相关的特征。使用feature_selection库的SelectKBest类结合卡方检验来选择特征的代码如下:

1 from sklearn.feature_selection import SelectKBest

2 from sklearn.feature_selection import chi2

3

4 #选择K个最好的特征,返回选择特征后的数据

5 SelectKBest(chi2, k=2).fit_transform(iris.data, iris.target)

只适用于分类问题中离散型特征筛选,不能用于分类问题中连续型特征的筛选,也不能用于回归问题的特征筛选。

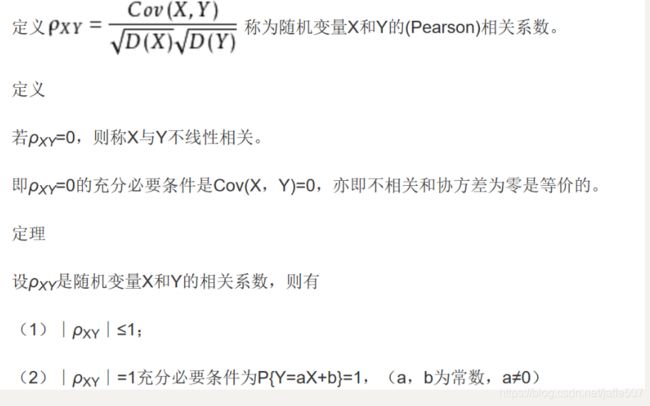

3.1.3 Pearson相关系数(Pearson Correlation)

皮尔森相关系数是一种最简单的,能帮助理解特征和响应变量之间关系的方法,该方法衡量的是变量之间的线性相关性。

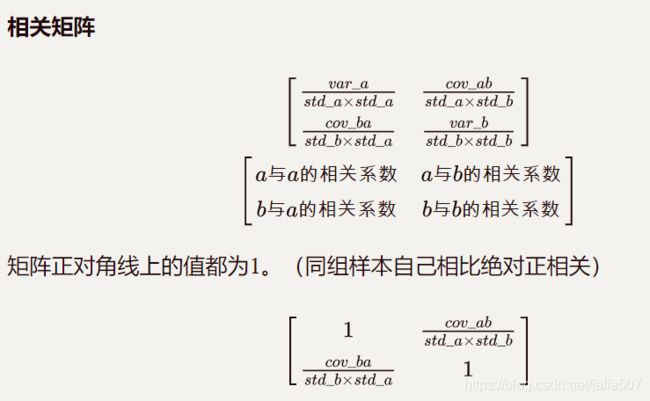

协方差是度量各个维度偏离其均值的程度,协方差的值为正值时说明两者是正相关,否则是负相关的。结果的取值区间为[-1,1],-1表示完全的负相关,+1表示完全的正相关,0表示没有线性相关,绝对值表示相关性的强度。

标准差也称均方差,是方差的算术平方根,能反映一个数据集的离散程度。

# 相关矩阵

numpy.corrcoef(a, b)

# 相关矩阵的分子矩阵 (协方差矩阵)

# [[a方差,ab协方差], [ba协方差, b方差]]

numpy.cov(a, b)

3.2 Wrapper

3.2.1 递归特征消除法

递归消除特征法使用一个基模型来进行多轮训练,每轮训练后,消除若干权值系数的特征,再基于新的特征集进行下一轮训练。使用feature_selection库的RFE类来选择特征的代码如下:

1 from sklearn.feature_selection import RFE

2 from sklearn.linear_model import LogisticRegression

3

4 #递归特征消除法,返回特征选择后的数据

5 #参数estimator为基模型

6 #参数n_features_to_select为选择的特征个数

7 RFE(estimator=LogisticRegression(), n_features_to_select=2).fit_transform(iris.data, iris.target)

3.3 Embedded

3.3.1 基于惩罚项的特征选择法

使用带惩罚项的基模型,除了筛选出特征外,同时也进行了降维。使用feature_selection库的SelectFromModel类结合带L1惩罚项的逻辑回归模型,来选择特征的代码如下:

1 from sklearn.feature_selection import SelectFromModel

2 from sklearn.linear_model import LogisticRegression

3

4 #带L1惩罚项的逻辑回归作为基模型的特征选择

5 SelectFromModel(LogisticRegression(penalty="l1", C=0.1)).fit_transform(iris.data, iris.target)

3.3.2 基于树模型的特征选择法

树模型中GBDT可用来作为基模型进行特征选择,使用feature_selection库的SelectFromModel类结合GBDT模型,来选择特征的代码如下:

1 from sklearn.feature_selection import SelectFromModel

2 from sklearn.ensemble import GradientBoostingClassifier

3

4 #GBDT作为基模型的特征选择

5 SelectFromModel(GradientBoostingClassifier()).fit_transform(iris.data, iris.target)

总结

当特征选择完成后,可以直接训练模型了,但是可能由于特征矩阵过大,导致计算量大,训练时间长的问题,因此降低特征矩阵维度也是必不可少的。常见的降维方法除了以上提到的基于L1惩罚项的模型以外,另外还有主成分分析法(PCA)和线性判别分析(LDA),线性判别分析本身也是一个分类模型。PCA和LDA有很多的相似点,其本质是要将原始的样本映射到维度更低的样本空间中,但是PCA和LDA的映射目标不一样:PCA是为了让映射后的样本具有最大的发散性;而LDA是为了让映射后的样本有最好的分类性能。所以说PCA是一种无监督的降维方法,而LDA是一种有监督的降维方法。

4.1 主成分分析法(PCA)

使用decomposition库的PCA类选择特征的代码如下:

1 from sklearn.decomposition import PCA

2

3 #主成分分析法,返回降维后的数据

4 #参数n_components为主成分数目

5 PCA(n_components=2).fit_transform(iris.data)

4.2 线性判别分析法(LDA)

使用LDA进行降维的代码如下:

1 from sklearn.discriminant_analysis import LinearDiscriminantAnalysis as LDA

2

3 #线性判别分析法,返回降维后的数据

4 #参数n_components为降维后的维数

5 LDA(n_components=2).fit_transform(iris.data, iris.target)

以上方法用代码实现:

encoding=utf-8

'''

用sklearn做特征工程,分为三部分:

1.数据预处理

2.特征选择

3.降维

'''

import pandas as pd

import numpy as np

from numpy import vstack, array, nan

from sklearn.datasets import load_iris

from sklearn import preprocessing

from sklearn import feature_selection

from sklearn.linear_model import LogisticRegression

from sklearn.ensemble import GradientBoostingClassifier

from sklearn.decomposition import PCA

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis as LDA

if __name__ == '__main__':

# 导入IRIS数据集

iris = load_iris()

features = iris.data

labels = iris.target

'''

1.数据预处理

'''

# 1.1 无量纲化:将不同规格的数据转换到同一规格

# 1.1.1 标准化:将服从正态分布的特征值转换成标准正态分布(对列向量处理)

# print(np.mean(features, axis=0))

# print(np.std(features, axis=0))

features_new = preprocessing.StandardScaler().fit_transform(features)

# print(np.mean(features_new, axis=0))

# print(np.std(features_new, axis=0))

# 1.1.2 区间缩放:将特征值缩放到[0, 1]区间的数据(对列向量处理)

features_new = preprocessing.MinMaxScaler().fit_transform(features)

# 1.1.3 归一化:将行向量转化为“单位向量”(对每个样本处理)

features_new = preprocessing.Normalizer().fit_transform(features)

# 1.2 对定量特征二值化:设定一个阈值,大于阈值的赋值为1,小于等于阈值的赋值为0

features_new = preprocessing.Binarizer(threshold=3).fit_transform(features)

# 1.3 对定性(分类)特征编码(也可用pandas.get_dummies函数)

enc = preprocessing.OneHotEncoder()

enc.fit([[0, 0, 3],

[1, 1, 0],

[0, 2, 1],

[1, 0, 2]])

# print(enc.transform([[0, 1, 3]]))

# print(enc.transform([[0, 1, 3]]).toarray())

# 1.4 缺失值计算(也可用pandas.fillna函数)

imp = preprocessing.Imputer(missing_values='NaN', strategy='mean', axis=0)

features_new = imp.fit_transform(vstack((array([nan, nan, nan, nan]), features)))

# 1.5 数据变换

# 1.5.1 基于多项式变换(对行变量处理)

features_new = preprocessing.PolynomialFeatures().fit_transform(features)

# 1.5.2 基于自定义函数变换,以log函数为例

features_new = preprocessing.FunctionTransformer(np.log1p).fit_transform(features)

'''

2.特征选择

'''

# 2.1 Filter

# 2.1.1 方差选择法,选择方差大于阈值的特征

features_new = feature_selection.VarianceThreshold(threshold=0.3).fit_transform(features)

# 2.1.2 卡方检验,选择K个与标签最相关的特征

features_new = feature_selection.SelectKBest(feature_selection.chi2, k=3).fit_transform(features, labels)

# 2.2 Wrapper

# 2.2.1 递归特征消除法,这里选择逻辑回归作为基模型,n_features_to_select为选择的特征个数

features_new = feature_selection.RFE(estimator=LogisticRegression(), n_features_to_select=2).fit_transform(features, labels)

# 2.3 Embedded

# 2.3.1 基于惩罚项的特征选择法,这里选择带L1惩罚项的逻辑回归作为基模型

features_new = feature_selection.SelectFromModel(LogisticRegression(penalty="l1", C=0.1)).fit_transform(features, labels)

# 2.3.2 基于树模型的特征选择法,这里选择GBDT模型作为基模型

features_new = feature_selection.SelectFromModel(GradientBoostingClassifier()).fit_transform(features, labels)

'''

3.降维

'''

# 3.1 主成分分析法(PCA),参数n_components为降维后的维数

features_new = PCA(n_components=2).fit_transform(features)

# 3.2 线性判别分析法(LDA),参数n_components为降维后的维数

features_new = LDA(n_components=2).fit_transform(features, labels)

其他特征选择的方法

5.去掉取值变化小的特征(Removing features with low variance)

该方法一般用在特征选择前作为一个预处理的工作,即先去掉取值变化小的特征,然后再使用其他特征选择方法选择特征。

考察某个特征下,样本的方差值,可以认为给定一个阈值,抛弃哪些小于某个阈值的特征。

1.实现原理

-

离散型变量:假设某特征的特征值只有0和1,并且在所有输入样本中,95%的实例的该特征取值都是1,那就可以认为这个特征作用不大。如果100%都是1,那这个特征就没意义了。

-

连续型变量:需要将连续变量离散化之后才能用。

而且实际当中,一般不太会有95%以上都取某个值的特征存在,所以这种方法虽然简单但是不太好用。可以把它作为特征选择的预处理,先去掉那些取值变化小的特征,然后再从接下来提到的的特征选择方法中选择合适的进行进一步的特征选择。

2.实现代码

from sklearn.feature_selection import VarianceThreshold

X = [[0, 0, 1], [0, 1, 0], [1, 0, 0], [0, 1, 1], [0, 1, 0], [0, 1, 1]]

sel = VarianceThreshold(threshold=(.8 * (1 - .8)))

sel.fit_transform(X)

#array([[0, 1],

[1, 0],

[0, 0],

[1, 1],

[1, 0],

[1, 1]])

6.随机森林选择

随机森林具有准确率高、鲁棒性好、易于使用等优点,这使得它成为了目前最流行的机器学习算法之一。随机森林提供了两种特征选择的方法:mean decrease impurity和mean decrease accuracy。

6.1.平均不纯度减少(mean decrease impurity)

1)原理介绍

-

随机森林由多颗CART决策树构成,决策树中的每一个节点都是关于某个特征的条件,为的是将数据集按照不同的响应变量一分为二。

-

CART利用不纯度可以确定节点(最优条件),对于分类问题,通常采用基尼不纯度,对于回归问题,通常采用的是方差或者最小二乘拟合。

-

当训练决策树的时候,可以计算出每个特征减少了多少树的不纯度。对于一个决策树森林来说,可以算出每个特征平均减少了多少不纯度,并把它平均减少的不纯度作为特征选择的标准。

-

随机森林基于不纯度的排序结果非常鲜明,在得分最高的几个特征之后的特征,得分急剧的下降。

2)代码实现

from sklearn.datasets import load_boston

from sklearn.ensemble import RandomForestRegressor

import numpy as np

#Load boston housing dataset as an example

boston = load_boston()

X = boston["data"]

Y = boston["target"]

names = boston["feature_names"]

# 训练随机森林模型,并通过feature_importances_属性获取每个特征的重要性分数。

rf = RandomForestRegressor()

rf.fit(X, Y)

print("Features sorted by their score:")

print(sorted(zip(map(lambda x: round(x, 4), rf.feature_importances_), names),

reverse=True))

6.2.平均精确度减少(mean decrease accuracy)

1)原理介绍

-

通过直接度量每个特征对模型精确率的影响来进行特征选择。

-

主要思路是打乱每个特征的特征值顺序,并且度量顺序变动对模型的精确率的影响。

- 对于不重要的变量来说,打乱顺序对模型的精确率影响不会太大。

- 对于重要的变量来说,打乱顺序就会降低模型的精确率。

2)代码实现

from sklearn.cross_validation import ShuffleSplit

from sklearn.metrics import r2_score

from collections import defaultdict

X = boston["data"]

Y = boston["target"]

rf = RandomForestRegressor()

scores = defaultdict(list)

#crossvalidate the scores on a number of different random splits of the data

for train_idx, test_idx in ShuffleSplit(len(X), 100, .3):

X_train, X_test = X[train_idx], X[test_idx]

Y_train, Y_test = Y[train_idx], Y[test_idx]

# 使用修改前的原始特征训练模型,其acc作为后续混洗特征值后的对比标准。

r = rf.fit(X_train, Y_train)

acc = r2_score(Y_test, rf.predict(X_test))

# 遍历每一列特征

for i in range(X.shape[1]):

X_t = X_test.copy()

# 对这一列特征进行混洗,交互了一列特征内部的值的顺序

np.random.shuffle(X_t[:, i])

shuff_acc = r2_score(Y_test, rf.predict(X_t))

# 混洗某个特征值后,计算平均精确度减少程度。

scores[names[i]].append((acc-shuff_acc)/acc)

print("Features sorted by their score:")

print(sorted([(round(np.mean(score), 4), feat) for feat, score in scores.items()], reverse=True))

7.顶层特征选择

顶层特征选择发建立在基于模型的特征选择方法基础之上的,例如线性回归和SVM等,在不同的子集上建立模型,然后汇总最终确定特征得分。

7.1.稳定性选择(Stability selection)

稳定性选择常常是一种既能够有助于理解数据又能够挑出优质特征的这种选择。

1)原理介绍

-

稳定性选择是一种基于二次抽样和选择算法相结合较新的方法,选择算法可以是回归、SVM或其他类似的方法。

-

它的主要思想是在不同的数据子集和特征子集上运行特征选择算法,不断的重复,最终汇总特征选择结果。比如可以统计某个特征被认为是重要特征的频率(被选为重要特征的次数除以它所在的子集被测试的次数)。

-

理想情况下,重要特征的得分会接近100%。稍微弱一点的特征得分会是非0的数,而最无用的特征得分将会接近于0。

2)代码实现

from sklearn.linear_model import RandomizedLasso

from sklearn.datasets import load_boston

boston = load_boston()

#using the Boston housing data.

#Data gets scaled automatically by sklearn's implementation

X = boston["data"]

Y = boston["target"]

names = boston["feature_names"]

rlasso = RandomizedLasso(alpha=0.025)

rlasso.fit(X, Y)

print("Features sorted by their score:")

print(sorted(zip(map(lambda x: round(x, 4), rlasso.scores_), names),

reverse=True))

7.2.递归特征消除(Recursive feature elimination,RFE)

1)原理介绍

-

递归特征消除的主要思想是反复的构建模型(如SVM或者回归模型)然后选出最好的(或者最差的)的特征(可以根据系数来选),把选出来的特征放到一遍,然后在剩余的特征上重复这个过程,直到所有特征都遍历了。

-

这个过程中特征被消除的次序就是特征的排序。因此,这是一种寻找最优特征子集的贪心算法。

-

RFE的稳定性很大程度上取决于在迭代的时候底层用哪种模型。

假如RFE采用的普通的回归,没有经过正则化的回归是不稳定的,那么RFE就是不稳定的。

假如RFE采用的是Ridge,而用Ridge正则化的回归是稳定的,那么RFE就是稳定的。

2)代码实现

from sklearn.feature_selection import RFE

from sklearn.linear_model import LinearRegression

boston = load_boston()

X = boston["data"]

Y = boston["target"]

names = boston["feature_names"]

#use linear regression as the model

lr = LinearRegression()

#rank all features, i.e continue the elimination until the last one

rfe = RFE(lr, n_features_to_select=1)

rfe.fit(X,Y)

print("Features sorted by their rank:")

print(sorted(zip(map(lambda x: round(x, 4), rfe.ranking_), names)))

结果输出

Features sorted by their rank:

[(1, 'NOX'), (2, 'RM'), (3, 'CHAS'), (4, 'PTRATIO'), (5, 'DIS'),

(6, 'LSTAT'), (7, 'RAD'), (8, 'CRIM'), (9, 'INDUS'), (10, 'ZN'),

(11, 'TAX'), (12, 'B'), (13, 'AGE')]

8.线性模型与正则化

8.1.主要思想

当所有特征在相同尺度上时,最重要的特征应该在模型中具有最高系数,而与输出变量不相关的特征应该具有接近零的系数值。即使使用简单的线性回归模型,当数据不是很嘈杂(或者有大量数据与特征数量相比)并且特征(相对)独立时,这种方法也能很好地工作。

8.2.正则化模型

正则化就是把额外的约束或者惩罚项加到已有模型(损失函数)上,以防止过拟合并提高泛化能力。损失函数由原来的E(X,Y)变为E(X,Y)+alpha||w||,w是模型系数组成的向量(有些地方也叫参数parameter,coefficients),||·||一般是L1或者L2范数,alpha是一个可调的参数,控制着正则化的强度。当用在线性模型上时,L1正则化和L2正则化也称为Lasso和Ridge。

1)L1正则化/Lasso regression

L1正则化将系数w的l1范数作为惩罚项加到损失函数上,由于正则项非零,这就迫使那些弱的特征所对应的系数变成0。因此L1正则化往往会使学到的模型很稀疏(系数w经常为0),这个特性使得L1正则化成为一种很好的特征选择方法。

Lasso能够挑出一些优质特征,同时让其他特征的系数趋于0。当如需要减少特征数的时候它很有用,但是对于数据理解来说不是很好用。

2)L2正则化/Ridge regression

L2正则化将系数向量的L2范数添加到了损失函数中。

- 由于L2惩罚项中系数是二次方的,这使得L2和L1有着诸多差异,最明显的一点就是,L2正则化会让系数的取值变得平均。

- 对于关联特征,这意味着他们能够获得更相近的对应系数。

- Ridge将回归系数均匀的分摊到各个关联变量上。

L2正则化对于特征选择来说一种稳定的模型,不像L1正则化那样,系数会因为细微的数据变化而波动。所以L2正则化和L1正则化提供的价值是不同的,L2正则化对于特征理解来说更加有用:表示能力强的特征对应的系数是非零。

8.3.代码实现

1)普通线性模型

#获取boston数据

boston=datasets.load_boston()

x=boston.data

y=boston.target

#过滤掉异常值

x=x[y<50]

y=y[y<50]

reg=LinearRegression()

reg.fit(x,y)

#求排序后的coef

coefSort=reg.coef_.argsort()

#featureNameSort: 按对标记值的影响,从小到大的各特征值名称

#featureCoefSore:按对标记值的影响,从小到大的coef_

featureNameSort=boston.feature_names[coefSort]

featureCoefSore=reg.coef_[coefSort]

print("featureNameSort:", featureNameSort)

print("featureCoefSore:", featureCoefSore)

# 输出:featureNameSort: ['NOX' 'DIS' 'PTRATIO' 'LSTAT' 'CRIM' 'INDUS' 'AGE' 'TAX' 'B' 'ZN' 'RAD' 'CHAS' 'RM']

featureCoefSore: [-1.24268073e+01 -1.21088069e+00 -8.38888137e-01 -3.50952134e-01

-1.05574295e-01 -4.35179251e-02 -2.36116881e-02 -1.37702943e-02 7.93577159e-03

3.52748549e-02 2.50740082e-01 4.55405227e-01 3.75411229e+00]

结果分析:

正相关影响系数最大的特征值是"RM":房间的平均数量,系数值为3.75。

负相关影响系数最大的特征值是"NOX":一氧化氮浓度,系数值为-1.24。

2)L1正则化线性模型

#A helper method for pretty-printing linear models

def pretty_print_linear(coefs, names = None, sort = False):

if names == None:

names = ["X%s" % x for x in range(len(coefs))]

lst = zip(coefs, names)

if sort:

lst = sorted(lst, key = lambda x:-np.abs(x[0]))

return " + ".join("%s * %s" % (round(coef, 3), name)

for coef, name in lst)

from sklearn.linear_model import Lasso

from sklearn.preprocessing import StandardScaler

from sklearn.datasets import load_boston

boston = load_boston()

scaler = StandardScaler()

X = scaler.fit_transform(boston["data"])

Y = boston["target"]

names = boston["feature_names"]

lasso = Lasso(alpha=.3)

lasso.fit(X, Y)

print("Lasso model: {}".format(

pretty_print_linear(lasso.coef_, names, sort = True)))

# 输出:Lasso model: -3.707 * LSTAT + 2.992 * RM + -1.757 * PTRATIO

+ -1.081 * DIS + -0.7 * NOX + 0.631 * B + 0.54 * CHAS + -0.236 * CRIM

+ 0.081 * ZN + -0.0 * INDUS + -0.0 * AGE + 0.0 * RAD + -0.0 * TAX

许多特征具有系数0。L1正则化回归的稳定性与非正则化线性模型类似,这意味着当数据中存在相关特征时,系数(以及特征等级)即使在小数据变化时也会发生显着变化。

3)L2正则化线性模型

from sklearn.linear_model import Ridge

from sklearn.metrics import r2_score

size = 100

#We run the method 10 times with different random seeds

for i in range(10):

print("Random seed {}".format(i))

np.random.seed(seed=i)

X_seed = np.random.normal(0, 1, size)

X1 = X_seed + np.random.normal(0, .1, size)

X2 = X_seed + np.random.normal(0, .1, size)

X3 = X_seed + np.random.normal(0, .1, size)

Y = X1 + X2 + X3 + np.random.normal(0, 1, size)

X = np.array([X1, X2, X3]).T

lr = LinearRegression()

lr.fit(X,Y)

print("Linear model: {}".format(pretty_print_linear(lr.coef_)))

ridge = Ridge(alpha=10)

ridge.fit(X,Y)

print("Ridge model: {}".format(pretty_print_linear(ridge.coef_)))

# 输出

Random seed 0

Linear model: 0.728 * X0 + 2.309 * X1 + -0.082 * X2

Ridge model: 0.938 * X0 + 1.059 * X1 + 0.877 * X2

Random seed 1

Linear model: 1.152 * X0 + 2.366 * X1 + -0.599 * X2

Ridge model: 0.984 * X0 + 1.068 * X1 + 0.759 * X2

Random seed 2

Linear model: 0.697 * X0 + 0.322 * X1 + 2.086 * X2

Ridge model: 0.972 * X0 + 0.943 * X1 + 1.085 * X2

Random seed 3

Linear model: 0.287 * X0 + 1.254 * X1 + 1.491 * X2

Ridge model: 0.919 * X0 + 1.005 * X1 + 1.033 * X2

Random seed 4

Linear model: 0.187 * X0 + 0.772 * X1 + 2.189 * X2

Ridge model: 0.964 * X0 + 0.982 * X1 + 1.098 * X2

Random seed 5

Linear model: -1.291 * X0 + 1.591 * X1 + 2.747 * X2

Ridge model: 0.758 * X0 + 1.011 * X1 + 1.139 * X2

Random seed 6

Linear model: 1.199 * X0 + -0.031 * X1 + 1.915 * X2

Ridge model: 1.016 * X0 + 0.89 * X1 + 1.091 * X2

Random seed 7

Linear model: 1.474 * X0 + 1.762 * X1 + -0.151 * X2

Ridge model: 1.018 * X0 + 1.039 * X1 + 0.901 * X2

Random seed 8

Linear model: 0.084 * X0 + 1.88 * X1 + 1.107 * X2

Ridge model: 0.907 * X0 + 1.071 * X1 + 1.008 * X2

Random seed 9

Linear model: 0.714 * X0 + 0.776 * X1 + 1.364 * X2

Ridge model: 0.896 * X0 + 0.903 * X1 + 0.98 * X2

从示例中可以看出,线性回归的系数变化很大,具体取决于生成的数据。然而,对于L2正则化模型,系数非常稳定并且密切反映数据的生成方式(所有系数接近1)。

(1) 单变量特征选择可以用于理解数据、数据的结构、特点,也可以用于排除不相关特征,但是它不能发现冗余特征。

(2) 正则化的线性模型可用于特征理解和特征选择。相比起L1正则化,L2正则化的表现更加稳定,L2正则化对于数据的理解来说很合适。由于响应变量和特征之间往往是非线性关系,可以采用basis expansion的方式将特征转换到一个更加合适的空间当中,在此基础上再考虑运用简单的线性模型。

(3) 随机森林是一种非常流行的特征选择方法,它易于使用。但它有两个主要问题:

-

重要的特征有可能得分很低(关联特征问题)

-

这种方法对特征变量类别多的特征越有利(偏向问题)

(4)特征选择在很多机器学习和数据挖掘场景中都是非常有用的。在使用的时候要弄清楚自己的目标是什么,然后找到哪种方法适用于自己的任务。

-

当选择最优特征以提升模型性能的时候,可以采用交叉验证的方法来验证某种方法是否比其他方法要好。

-

当用特征选择的方法来理解数据的时候要留心,特征选择模型的稳定性非常重要,稳定性差的模型很容易就会导致错误的结论。

-

对数据进行二次采样然后在子集上运行特征选择算法能够有所帮助,如果在各个子集上的结果是一致的,那就可以说在这个数据集上得出来的结论是可信的,可以用这种特征选择模型的结果来理解数据。

(5)关于训练模型的特征筛选,建议的实施流程 :

-

数据预处理后,先排除取值变化很小的特征。如果机器资源充足,并且希望尽量保留所有信息,可以把阈值设置得比较高,或者只过滤离散型特征只有一个取值的特征。

-

如果数据量过大,计算资源不足(内存不足以使用所有数据进行训练、计算速度过慢),可以使用单特征选择法排除部分特征。这些被排除的特征并不一定完全被排除不再使用,在后续的特征构造时也可以作为原始特征使用。

-

如果此时特征量依然非常大,或者是如果特征比较稀疏时,可以使用PCA(主成分分析)和LDA(线性判别)等方法进行特征降维。

-

经过样本采样和特征预筛选后,训练样本可以用于训练模型。但是可能由于特征数量比较大而导致训练速度慢,或者想进一步筛选有效特征或排除无效特征(或噪音),我们可以使用正则化线性模型选择法、随机森林选择法或者顶层特征选择法进一步进行特征筛选。

最后,特征筛选是为了理解数据或更好地训练模型,我们应该根据自己的目标来选择适合的方法。为了更好/更容易地训练模型而进行的特征筛选,如果计算资源充足,应尽量避免过度筛选特征,因为特征筛选很容易丢失有用的信息。如果只是为了减少无效特征的影响,为了避免过拟合,可以选择随机森林和XGBoost等集成模型来避免对特征过拟合。