决策树之剪枝处理、连续值处理

1.剪枝处理

剪枝是一种可以提高算法时间和空间效率的技巧,经过剪枝的算法在执行效率上远超过未经剪枝处理的算法。有些算法甚至可以通过剪枝优化降低计算的时间复杂度等级,突破应用瓶颈。

首先剪枝(pruning)的目的是为了避免决策树模型的过拟合。因为决策树算法在学习的过程中为了尽可能的正确的分类训练样本,不停地对结点进行划分,因此这会导致整棵树的分支过多,也就导致了过拟合。决策树的剪枝策略最基本的有两种:预剪枝(pre-pruning)和后剪枝(post-pruning)

1.1剪枝策略

决策树算法是机器学习中的经典算法。如果要解决分类问题,决策树算法再合适不过了。不过决策树算法并非至善至美,决策树分类算法最容易出现的问题就是“过拟合”。什么是“过拟合”我们在教程的开篇已经提及过,它指的机器学习模型对于训练集数据能够实现较好的预测,而对于测试集性能较差。

“过拟合”使决策树模型学习到了并不具备普遍意义的分类决策条件,从而导致模型的分类效率、泛化能力降低。

决策树出现过拟合的原因其实很简单,因为它注重细节。决策树会根据数据集各个维度的重要性来选择 if -else 分支,如果决策树将所有的特征属性都用完的情况下,那么过拟合现象就很容易出现。

我们知道,每个数据集都会有各种各样的属性维度,总会出现一些属性维度样本分类实际上并不存在关联关系的情况。因此,在理想情况下决策树算法应尽可能少地使用这些不相关属性,但理想终归是理想,在现实情况下很难实现。那么我们要如何解决这种过拟合问题呢?这时就要用到“剪枝策略”。

1.2预剪枝

预剪枝(pre-pruning):预剪枝就是在构造决策树的过程中,先对每个结点在划分前进行估计,若果当前结点的划分不能带来决策树模型泛华性能的提升,则不对当前结点进行划分并且将当前结点标记为叶结点。

1.2.1代码实现

在上一篇中已经完成了创建数据集、计算数据集的信息熵、计算数据集的信息增益并根据最优属性进行划分的决策树创建https://blog.csdn.net/lullaby_UUN/article/details/127872437?spm=1001.2014.3001.5502

在这里我们将仅展示预剪枝的代码。

创建数据集

def createDataSet():

"""

传入要处理的数据集

:return: 数据集内容,数据集标签

"""

dataSet = [[1, 1, 1, 'yes'],

[1, 1, 1, 'yes'],

[0, 1, 0, 'no'],

[1, 0, 1, 'yes'],

[1, 0, 1, 'yes'],

[0, 0, 1, 'no'],

[1, 0, 0, 'no'],

[1, 0, 1, 'yes'],

[0, 0, 1, 'no']]

labels = ['十一点前睡觉', '每天运动', '每天护肤']

# print(f'dataset:\n{dataSet}')

return dataSet, labels

划分训练集和测试集

def splitcreatDataSet(myData, myLabel):

myDataTrain = myData[[0, 1, 2, 5, 6, 9],:]

myDataTest = myData[[3, 4, 7, 8],:]

myLabelTrain = myLabel[[0, 1, 2, 5, 6, 9]]

myLabelTest = myLabel[[3, 4, 7, 8]]

return myDataTrain, myLabelTrain, myDataTest, myLabelTest预剪枝代码

def createTreePrePruning(dataTrain, labelTrain, dataTest, labelTest, names, method = 'id3'):

trainData = np.asarray(dataTrain)

labelTrain = np.asarray(labelTrain)

testData = np.asarray(dataTest)

labelTest = np.asarray(labelTest)

names = np.asarray(names)

# 如果结果为单一结果

if len(set(labelTrain)) == 1:

return labelTrain[0]

# 如果没有待分类特征

elif trainData.size == 0:

return voteLabel(labelTrain)

# 其他情况则选取特征

bestFeat, bestEnt = bestFeature(dataTrain, labelTrain, method = method)

# 取特征名称

bestFeatName = names[bestFeat]

# 从特征名称列表删除已取得特征名称

names = np.delete(names, [bestFeat])

# 根据最优特征进行分割

dataTrainSet, labelTrainSet = splitFeatureData(dataTrain, labelTrain, bestFeat)

# 预剪枝评估

# 划分前的分类标签

labelTrainLabelPre = voteLabel(labelTrain)

labelTrainRatioPre = equalNums(labelTrain, labelTrainLabelPre) / labelTrain.size

# 划分后的精度计算

if dataTest is not None:

dataTestSet, labelTestSet = splitFeatureData(dataTest, labelTest, bestFeat)

# 划分前的测试标签正确比例

labelTestRatioPre = equalNums(labelTest, labelTrainLabelPre) / labelTest.size

# 划分后 每个特征值的分类标签正确的数量

labelTrainEqNumPost = 0

for val in labelTrainSet.keys():

labelTrainEqNumPost += equalNums(labelTestSet.get(val), voteLabel(labelTrainSet.get(val))) + 0.0

# 划分后 正确的比例

labelTestRatioPost = labelTrainEqNumPost / labelTest.size

# 如果没有评估数据 但划分前的精度等于最小值0.5 则继续划分

if dataTest is None and labelTrainRatioPre == 0.5:

decisionTree = {bestFeatName: {}}

for featValue in dataTrainSet.keys():

decisionTree[bestFeatName][featValue] = createTreePrePruning(dataTrainSet.get(featValue), labelTrainSet.get(featValue)

, None, None, names, method)

elif dataTest is None:

return labelTrainLabelPre

# 如果划分后的精度相比划分前的精度下降, 则直接作为叶子节点返回

elif labelTestRatioPost < labelTestRatioPre:

return labelTrainLabelPre

else :

# 根据选取的特征名称创建树节点

decisionTree = {bestFeatName: {}}

# 对最优特征的每个特征值所分的数据子集进行计算

for featValue in dataTrainSet.keys():

decisionTree[bestFeatName][featValue] = createTreePrePruning(dataTrainSet.get(featValue), labelTrainSet.get(featValue)

, dataTestSet.get(featValue), labelTestSet.get(featValue)

, names, method)

return decisionTree

划分结果可视化

def plotTree(decisionTree, parentPt, parentValue):

# 计算宽与高

leafNum, treeDepth = getTreeSize(decisionTree)

# 在 1 * 1 的范围内画图,因此分母为 1

# 每个叶节点之间的偏移量

plotTree.xOff = plotTree.figSize / (plotTree.totalLeaf - 1)

# 每一层的高度偏移量

plotTree.yOff = plotTree.figSize / plotTree.totalDepth

# 节点名称

nodeName = list(decisionTree.keys())[0]

# 根节点的起止点相同,可避免画线;如果是中间节点,则从当前叶节点的位置开始,

# 然后加上本次子树的宽度的一半,则为决策节点的横向位置

centerPt = (plotTree.x + (leafNum - 1) * plotTree.xOff / 2.0, plotTree.y)

# 画出该决策节点

plotNode(nodeName, centerPt, parentPt, decisionNodeStyle)

# 标记本节点对应父节点的属性值

plotMidText(centerPt, parentPt, parentValue)

# 取本节点的属性值

treeValue = decisionTree[nodeName]

# 下一层各节点的高度

plotTree.y = plotTree.y - plotTree.yOff

# 绘制下一层

for val in treeValue.keys():

# 如果属性值对应的是字典,说明是子树,进行递归调用; 否则则为叶子节点

if type(treeValue[val]) == dict:

plotTree(treeValue[val], centerPt, str(val))

else:

plotNode(treeValue[val], (plotTree.x, plotTree.y), centerPt, leafNodeStyle)

plotMidText((plotTree.x, plotTree.y), centerPt, str(val))

# 移到下一个叶子节点

plotTree.x = plotTree.x + plotTree.xOff

# 递归完成后返回上一层

plotTree.y = plotTree.y + plotTree.yOff

# 画出决策树

def createPlot(decisionTree):

fig = plt.figure(1, facecolor="white") # 创建一个新图形

fig.clf() # 清空绘图区

font = {'family': 'Songti SC'}

matplotlib.rc("font", **font)

axprops = {"xticks": [], "yticks": []}

createPlot.ax1 = plt.subplot(111, frameon=False, **axprops)

# 定义画图的图形尺寸

plotTree.figSize = 1.5

# 初始化树的总大小

plotTree.totalLeaf, plotTree.totalDepth = getTreeSize(decisionTree)

# 叶子节点的初始位置x 和 根节点的初始层高度y

plotTree.x = 0

plotTree.y = plotTree.figSize

plotTree(decisionTree, (plotTree.figSize / 2.0, plotTree.y), "")

plt.show()剪枝前的树

剪枝后的树

1.3后剪枝

# 将数据分割为测试集和训练集

myDataTrain, myLabelTrain, myDataTest, myLabelTest = splitMyData20(myData, myLabel)

# 生成不剪枝的树

myTreeTrain = createTree(myDataTrain, myLabelTrain, myName, method = 'id3')

# 生成预剪枝的树

myTreePrePruning = createTreePrePruning(myDataTrain, myLabelTrain, myDataTest, myLabelTest, myName, method = 'id3')

# 画剪枝前的树

print("剪枝前的树")

createPlot(myTreeTrain)

# 画剪枝后的树

print("剪枝后的树")

createPlot(myTreePrePruning)后剪枝(post-pruning):后剪枝就是先把整颗决策树构造完毕,然后自底向上的对非叶结点进行考察,若将该结点对应的子树换为叶结点能够带来泛华性能的提升,则把该子树替换为叶结点。

周志华老师《机器学习》中述说如下:后剪枝则是先从训练集生成一颗完整的决策树,然后自底向上地对非叶结点进行考察,若将该结点对应的子树替换为叶结点能带来泛化性能提升,则将该子树替换为叶结点。

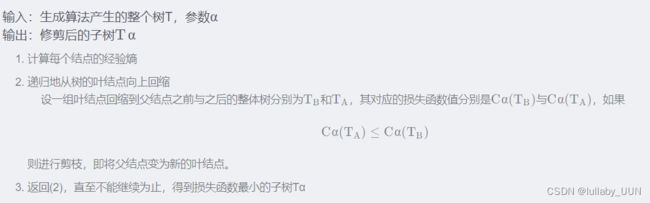

李航《统计学习方法》中述说如下:

1.3.1代码实现

# 创建决策树 带预划分标签

def createTreeWithLabel(data, labels, names, method = 'id3'):

data = np.asarray(data)

labels = np.asarray(labels)

names = np.asarray(names)

# 如果不划分的标签为

votedLabel = voteLabel(labels)

# 如果结果为单一结果

if len(set(labels)) == 1:

return votedLabel

# 如果没有待分类特征

elif data.size == 0:

return votedLabel

# 其他情况则选取特征

bestFeat, bestEnt = bestFeature(data, labels, method = method)

# 取特征名称

bestFeatName = names[bestFeat]

# 从特征名称列表删除已取得特征名称

names = np.delete(names, [bestFeat])

# 根据选取的特征名称创建树节点 划分前的标签votedPreDivisionLabel=_vpdl

decisionTree = {bestFeatName: {"_vpdl": votedLabel}}

# 根据最优特征进行分割

dataSet, labelSet = splitFeatureData(data, labels, bestFeat)

# 对最优特征的每个特征值所分的数据子集进行计算

for featValue in dataSet.keys():

decisionTree[bestFeatName][featValue] = createTreeWithLabel(dataSet.get(featValue), labelSet.get(featValue), names, method)

return decisionTree

# 将带预划分标签的tree转化为常规的tree

# 函数中进行的copy操作,原因见有道笔记 【YL20190621】关于Python中字典存储修改的思考

def convertTree(labeledTree):

labeledTreeNew = labeledTree.copy()

nodeName = list(labeledTree.keys())[0]

labeledTreeNew[nodeName] = labeledTree[nodeName].copy()

for val in list(labeledTree[nodeName].keys()):

if val == "_vpdl":

labeledTreeNew[nodeName].pop(val)

elif type(labeledTree[nodeName][val]) == dict:

labeledTreeNew[nodeName][val] = convertTree(labeledTree[nodeName][val])

return labeledTreeNew

# 后剪枝 训练完成后决策节点进行替换评估 这里可以直接对xgTreeTrain进行操作

def treePostPruning(labeledTree, dataTest, labelTest, names):

newTree = labeledTree.copy()

dataTest = np.asarray(dataTest)

labelTest = np.asarray(labelTest)

names = np.asarray(names)

# 取决策节点的名称 即特征的名称

featName = list(labeledTree.keys())[0]

# print("\n当前节点:" + featName)

# 取特征的列

featCol = np.argwhere(names==featName)[0][0]

names = np.delete(names, [featCol])

# print("当前节点划分的数据维度:" + str(names))

# print("当前节点划分的数据:" )

# print(dataTest)

# print(labelTest)

# 该特征下所有值的字典

newTree[featName] = labeledTree[featName].copy()

featValueDict = newTree[featName]

featPreLabel = featValueDict.pop("_vpdl")

# print("当前节点预划分标签:" + featPreLabel)

# 是否为子树的标记

subTreeFlag = 0

# 分割测试数据 如果有数据 则进行测试或递归调用 np的array我不知道怎么判断是否None, 用is None是错的

dataFlag = 1 if sum(dataTest.shape) > 0 else 0

if dataFlag == 1:

# print("当前节点有划分数据!")

dataTestSet, labelTestSet = splitFeatureData(dataTest, labelTest, featCol)

for featValue in featValueDict.keys():

# print("当前节点属性 {0} 的子节点:{1}".format(featValue ,str(featValueDict[featValue])))

if dataFlag == 1 and type(featValueDict[featValue]) == dict:

subTreeFlag = 1

# 如果是子树则递归

newTree[featName][featValue] = treePostPruning(featValueDict[featValue], dataTestSet.get(featValue), labelTestSet.get(featValue), names)

# 如果递归后为叶子 则后续进行评估

if type(featValueDict[featValue]) != dict:

subTreeFlag = 0

# 如果没有数据 则转换子树

if dataFlag == 0 and type(featValueDict[featValue]) == dict:

subTreeFlag = 1

# print("当前节点无划分数据!直接转换树:"+str(featValueDict[featValue]))

newTree[featName][featValue] = convertTree(featValueDict[featValue])

# print("转换结果:" + str(convertTree(featValueDict[featValue])))

# 如果全为叶子节点, 评估需要划分前的标签,这里思考两种方法,

# 一是,不改变原来的训练函数,评估时使用训练数据对划分前的节点标签重新打标

# 二是,改进训练函数,在训练的同时为每个节点增加划分前的标签,这样可以保证评估时只使用测试数据,避免再次使用大量的训练数据

# 这里考虑第二种方法 写新的函数 createTreeWithLabel,当然也可以修改createTree来添加参数实现

if subTreeFlag == 0:

ratioPreDivision = equalNums(labelTest, featPreLabel) / labelTest.size

equalNum = 0

for val in labelTestSet.keys():

equalNum += equalNums(labelTestSet[val], featValueDict[val])

ratioAfterDivision = equalNum / labelTest.size

# print("当前节点预划分标签的准确率:" + str(ratioPreDivision))

# print("当前节点划分后的准确率:" + str(ratioAfterDivision))

# 如果划分后的测试数据准确率低于划分前的,则划分无效,进行剪枝,即使节点等于预划分标签

# 注意这里取的是小于,如果有需要 也可以取 小于等于

if ratioAfterDivision < ratioPreDivision:

newTree = featPreLabel

return newTree

2.连续值处理

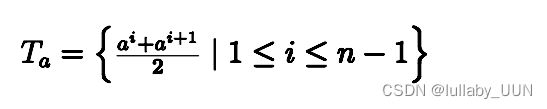

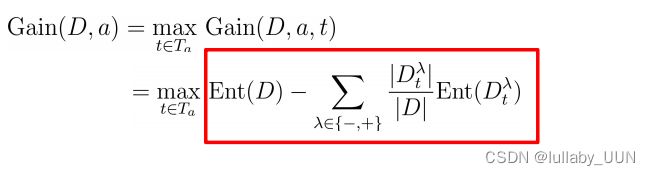

在现实学习任务中会遇到连续属性的情况,这种情况下需如何处理呢?最简单的策略是采用二分法对连续属性进行处理。这也是C4.5决策树算法中采用的机制。

2.1连续属性离散化(二分法)