- C# 建造者模式(Builder Pattern)详细讲解

江沉晚呤时

设计模式C#java数据库开发语言.netcorec#netjavascript

一、什么是建造者模式?建造者模式(BuilderPattern)是一种创建型设计模式,它通过将一个复杂对象的构建过程与其表示分离,使得同样的构建过程可以创建不同的表示。这个模式主要应用于那些构建过程复杂且涉及多个步骤的场景,特别适合于需要灵活配置且逐步构建的对象。1.1.设计模式分类设计模式(DesignPatterns)分为三大类:创建型模式(CreationalPatterns):关注如何创建

- pytorch中的DataLoader

朋也透william

pytorch人工智能python

在PyTorch中,DataLoader是一个工具类,用于高效地加载数据并准备数据输入到模型中。它支持数据的批量加载、随机打乱、并行加载和迭代操作,是训练深度学习模型的关键组件之一。1.基本功能DataLoader的主要职责是从数据集中提取样本,并根据设置返回一个批次的数据。它与Dataset类结合使用:Dataset:定义数据集的来源、结构以及如何获取单个数据样本。DataLoader:负责从D

- pytorch 天花板级别的知识点 你可以不会用 但是不能不知道

小赖同学啊

人工智能pytorch人工智能python

PyTorch的高级知识涵盖了从模型优化到分布式训练的广泛内容,适合已经掌握基础知识的开发者进一步提升技能。以下是PyTorch的高级知识点,详细且全面:1.模型优化与加速1.1混合精度训练定义:使用半精度(FP16)和单精度(FP32)混合训练,减少内存占用并加速计算。实现:使用torch.cuda.amp模块。示例:fromtorch.cuda.ampimportautocast,GradSc

- 情感分析任务的概述

阿你不是

python开发语言

一、情感分析的概述1、什么是情感分析情感分析,也称为情感分类,是一种自然语言处理的任务,用于分析文本、语音或其他形式的数据中所包含的情感倾向。其目标是判断数据表达的情感是积极的(Positive)、消极的(Negative)还是中立的(Neutral),或者进一步细化为更复杂的情感类别(如愤怒、喜悦、悲伤等)。2、情感分析的主要应用场景1)商业领域:情感分析主要进行产品评价分析,从客户和买家的评价

- Pytorch Dataloader入门

gy-7

pytorch深度学习机器学习

PytorchDataloadercode:torch/utils/data/dataloader.py#L71PytorchDatasettutorial:tutorials/beginner/basics/data_tutorial.html理论:在训练模型时,我们通常希望:以“mini-batch”方式传递样本,能够加速训练。每个epoch都shuffle数据,能够减少模型过拟合。使用Pyt

- 【深度学习基础】第二十四课:softmax函数的导数

x-jeff

深度学习基础深度学习人工智能

【深度学习基础】系列博客为学习Coursera上吴恩达深度学习课程所做的课程笔记。1.softmax函数softmax函数详解。2.softmax函数的导数假设神经网络输出层的激活函数为softmax函数,用以解决多分类问题。在反向传播时,就需要计算softmax函数的导数,这也就是本文着重介绍的内容。我们只需关注输出层即可,其余层和之前介绍的二分类模型一样,不再赘述。我们先考虑只有一个样本的情况

- 202年充电计划——自学手册 网络安全(黑客技术)

网安康sir

web安全安全网络pythonlinux

基于入门网络安全/黑客打造的:黑客&网络安全入门&进阶学习资源包前言什么是网络安全网络安全可以基于攻击和防御视角来分类,我们经常听到的“红队”、“渗透测试”等就是研究攻击技术,而“蓝队”、“安全运营”、“安全运维”则研究防御技术。如何成为一名黑客很多朋友在学习安全方面都会半路转行,因为不知如何去学,在这里,我将这个整份答案分为黑客(网络安全)入门必备、黑客(网络安全)职业指南、黑客(网络安全)学习

- PyTorch中,将`DataLoader`加载的数据高效传输到GPU

大霸王龙

pytorch人工智能python

一、数据加载到GPU的核心步骤数据预处理与张量转换若原始数据为NumPy数组或Python列表,需先转换为PyTorch张量:X_tensor=torch.from_numpy(X).float()#转换为浮点张量y_tensor=torch.from_numpy(y).long()#分类任务常用长整型显式指定设备:通过.to(device)将数据移至GPU(需提前定义device对象):devi

- 【sklearn 05】sklearn功能模块

@金色海岸

sklearn人工智能python

sklearn功能模块分类:识别某个对象属于那个类别回归:预测与对象相关联的连续值属性聚类:将相似对象自动分组降维:减少要考虑的随机变量的数量模型选择:比较、验证、选择参数和模型预处理:特征提取和归一化

- 【sklearn 03】逻辑回归、决策树、支持向量机

@金色海岸

sklearn逻辑回归决策树

逻辑回归、决策树、支持向量机-逻辑回归logisticsregression(逻辑回归)算法是经典的分类算法,基本思想是构造一个概率的拟合函数。决策树决策树的基本思想是根据样例去推断其背后的树形知识表征支持向量机支持向量机SVM(supportvectormachine)的基本思想是寻找最大的间隔的分割超平面。离分割超平面最近的这些样本点称为支持向量机

- PyTorch中tensor赋值运算符

华zyh

强化学习pytorch

t=torch.ones((3,3))t0=tt1=t.dataprint(id(t),id(t0),id(t1),id(t.data))运行结果:2132926456040213292645604021332763196402132924110392t0与t完全相同。t1与t.data地址不一样(但是,t1.data与t.data地址相同)

- MV-EB435i立体相机对垃圾分类

开哥kg

pytorch深度学习卷积神经网络分类人工智能

最近在v社区发了一篇文章,懒得转移过来了链接:V社区-机器视觉技术交流社区-MV-EB435i立体相机对垃圾分类我觉得这篇文章对于刚入门深度学习想看点项目学点代码的刚刚好,因为我也是新手,嘻嘻嘻!希望这篇文章对大家有所帮助,如有错误请大家指正。

- C语言基础知识05---必背+函数

努力做小白

C语言学习算法数据结构c语言

目录必备知识点1、C语言5大分区1.1局部变量1.2全局变量1.3静态局部变量1.4外部声明变量2、关键字2.1static2.2extern3、局部变量和全局变量能不能同名?4、实参&&形参函数1、函数的作用2、函数的分类2.1主函数2.2子函数3、函数命名4、函数定义格式5、函数传参5.1值传参5.2地址传参6、函数类型6.1函数的声明6.2函数调用6.3递归函数7、指针函数&&函数指针7.1

- 【AI】使用Python实现机器学习小项目教程

丶2136

AI人工智能python机器学习

引言在本教程中,我们将带领您使用Python编程语言实现一个经典的机器学习项目——鸢尾花(Iris)分类。通过这个项目,您将掌握机器学习的基本流程,包括数据加载、预处理、模型训练、评估和优化等步骤。论文AIGC检测,降AIGC检测,AI降重,三连私信免费获取:ReduceAIGC9折券!DetectAIGC立减2元券!AI降重9折券!目录引言一、项目背景与目标二、开发环境准备2.1所需工具2.2环

- 无人机学习入门

一颗微竹

无人机无人机

设备:电脑+遥控器+小飞机+fpv+充电器+各种工具配件设备最开始只有电脑,慢慢的东西越来越多。学习理论知识空域与航空法律法规、安全教育无人机基础(在mooc平台和智慧职教平台上很多课程,当然B站也很多,自学基础内容)目录大概如下:1)无人机的历史2)无人机分类3)无人机系统组成(直升机、多旋翼、固定翼无人机、其他特殊结构)4)无人机飞行原理、空气动力学5)飞行控制、导航系统6)任务载荷学习实践知

- 系统架构师备考——软件可靠性基础知识篇(上)

牛马程序员小邓

系统架构师备考笔记系统架构

系统架构师备考日记(3.11)第9章软件可靠性基础知识篇(上)文章目录系统架构师备考日记(3.11)考点一、软件可靠性基本概念1.1软件可靠性定义1.2软件可靠性的定量描述1.3可靠性目标1.4可靠性测试的意义1.5广义的可靠性测试与狭义的可靠性测试二、软件可靠性建模2.1影响软件可靠性的因素2.2软件可靠性的建模方法2.3软件可靠性模型分类三、软件可靠性管理总结考点软件可靠性基本概念、建模、管理

- Vue-Echarts图表组件性能优化

mao1632471875

echartsvue.js性能优化

页面在渲染的时候出现了卡顿的情况。页面上的秒数从1-2-3秒-直接从1变成了5核心原因js单线程原因每次1秒轮询请求接口拿到数据一直重新渲染页面负荷不起。解决方案。定位电视机性能,取消轮询-页面是可以流畅加载的。说明电视机性能还是可以的-只是因为数据实时变化导致的卡顿。优化的本质是什么-那就是分类-如果还有那就是加载优先级。位置固定右上角和各个图表位置固定减少重排弄两个变量一个flag一个coun

- 2025年三个月自学手册 网络安全(黑客技术)

网安kk

web安全安全网络网络安全python

基于入门网络安全/黑客打造的:黑客&网络安全入门&进阶学习资源包什么是网络安全网络安全可以基于攻击和防御视角来分类,我们经常听到的“红队”、“渗透测试”等就是研究攻击技术,而“蓝队”、“安全运营”、“安全运维”则研究防御技术。如何成为一名黑客很多朋友在学习安全方面都会半路转行,因为不知如何去学,在这里,我将这个整份答案分为黑客(网络安全)入门必备、黑客(网络安全)职业指南、黑客(网络安全)学习导航

- 机器学习 [白板推导](三)[线性分类]

神齐的小马

机器学习分类人工智能

4.线性分类4.1.线性分类的典型模型硬分类:输出结果只有0或1这种离散结果;感知机线性判别分析Fisher软分类:会输出0-1之间的值作为各个类别的概率;概率生成模型:高斯判别分析GDA、朴素贝叶斯,主要建模的是p(x⃗,y)p(\vec{x},y)p(x,y)概率判别模型:逻辑回归,主要建模的是p(y∣x⃗)p(y|\vec{x})p(y∣x)4.2.感知机4.2.1.基本模型 模型:f(x

- 存储器与内存的区别:深入理解二者差异在现代计算机系统中的应用

Wx功课师

计算机系统存储器内存计算机系统存储器与内存的区别

在计算机技术飞速发展的今天,存储器与内存作为计算机系统的重要组成部分,扮演着至关重要的角色。然而,很多人对存储器与内存的概念混淆不清,误以为它们是同一种东西。事实上,存储器与内存有着本质的区别。本文将详细阐述存储器与内存的差异,并探究它们在现代计算机系统中的应用。目录1、存储器与内存的定义及分类1.1、存储器1.2、内存2、存储器与内存的差异3、存储器与内存在现代计算机系统中的应用4、总结1、存储

- ChatGPT智能聊天机器人实现

云端源想

chatgpt机器人

以下是一个从零实现类ChatGPT智能聊天机器人的完整开发指南,包含技术选型、核心代码逻辑和推荐学习资源:—云端平台整理一、技术架构与工具核心模型基座模型:HuggingFaceTransformers库(如GPT-2/GPT-3.5TurboAPI/LLaMA2)轻量化方案:微软DeepSpeed或MetaFairScale(降低显存占用)训练框架PyTorchLightning+Acceler

- 【动手学深度学习】#1PyTorch基础操作

-一杯为品-

机器学习深度学习人工智能

主要参考学习资料:《动手学深度学习》阿斯顿·张等著【动手学深度学习PyTorch版】哔哩哔哩@跟李牧学AI目录1.1数据操作1.1.1入门1.1.2运算符1.1.3广播机制1.1.4索引和切片1.1.5节省内存1.1.6转换为其他Python对象1.2数据预处理1.2.1读取数据集1.2.2处理缺失值1.2.3转换为张量格式1.3线性代数1.3.1标量1.3.2向量1.3.3矩阵1.3.4张量1.

- 38份DeepSeek核心资料汇总|可下载

航锦234

人工智能pdf

资料链接:https://pan.quark.cn/s/b469ed4018ff为了方便大家查找和使用,我们对之前发布过的DeepSeek系列学习资料进行了分类和汇总。内容包括但不限于清北浙DeepSeek课件资料汇总manus学习资料DeepSeek实操变现指南DeepSeek本地部署教学等等点击最上方链接即可保存下载~

- 从零开始学机器学习——构建一个推荐web应用

努力的小雨

机器学习机器学习前端人工智能

首先给大家介绍一个很好用的学习地址:https://cloudstudio.net/columns今天,我们终于将分类器这一章节学习完活了,和回归一样,最后一章节用来构建web应用程序,我们会回顾之前所学的知识点,并新增一个web应用用来让模型和用户交互。所以今天的主题是美食推荐。美食推荐Web应用程序首先,请不要担心,本章节并不会涉及过多的前端知识点。我们此次的学习重点在于机器学习本身,因此我们

- 计算机信息安全

若水心境

软件架构师知识库信息安全

等保2.0与等保1.0区别※等保2.0在2019年12月1日正式实施。等级保护制度2.0在1.0的基础上,注重全方位主动防御、动态防御、整体防控和精准防护,实现对云计算、移动互联网、物联网、工业控制信息系统等保护对象全覆盖。对象范围扩大将云计算、移动互联网、物联网、工业控制系统等技术列入标准中。分类结构统一“基本要求、设计要求和测评要求”分类框架统一,形成了“安全通信网络”、“安全区域边界”、“安

- 初识C语言之函数(上)

乞丐1469

C语言学习c语言学习开发语言

一.函数的概念1.函数的定义:在C语言中函数就是一个完成某项特定任务的一小段代码。2.函数的作用:一个大的计算机任务可以分为若干个较小的函数来完成。(同一个函数如果能完成某项特定任务的话,这个函数就可以重复使用,从而提高开发软件的效率)3.函数的分类:①库函数:由C语言库直接提供②自定义函数:由自己创造的函数二.库函数标准库和头文件:库函数的相关信息主要详见于下方链接http://zh.cppre

- 构造函数的分类

cuikebinpau

c++开发语言

C++构造函数的分类与调用方式详解在C++中,构造函数(Constructor)是类的特殊成员函数,在对象创建时自动调用,用于对对象进行初始化。根据使用场景和实现方式,构造函数可以分为不同的类型,且调用方式也各有不同。本文将详细介绍C++构造函数的分类及其调用方式。1.1默认构造函数(无参构造函数)定义:默认构造函数是不带参数的构造函数,在创建对象时会自动调用。如果程序员没有定义任何构造函数,编译

- Ubuntu安装开发者平台Backstage

xuhss_com

计算机计算机

Python微信订餐小程序课程视频https://edu.csdn.net/course/detail/36074Python实战量化交易理财系统https://edu.csdn.net/course/detail/35475Ubuntu安装开发者平台Backstage什么是Backstage?Backstage是一个构建开发者门户的开源平台。通过支持一个集中的软件分类,Backstage可以保存

- K8S之QoS详解

RedCong

云原生k8sOpenshiftkubernetes容器云原生

PodQoS类服务质量(QualityofService,QoS)类,阐述Kubernetes如何根据为Pod中的容器指定的资源约束为每个Pod设置QoS类。Kubernetes依赖这种分类来决定当Node上没有足够可用资源时要驱逐哪些Pod。QoS类(QualityofServiceclasses)Kubernetes对你运行的Pod进行分类,并将每个Pod分配到特定的QoS类中。Kuberne

- 从零开始大模型开发与微调:PyCharm的下载与安装

AI天才研究院

AI大模型企业级应用开发实战AI大模型应用入门实战与进阶DeepSeekR1&大数据AI人工智能大模型计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

从零开始大模型开发与微调:PyCharm的下载与安装1.背景介绍随着人工智能和深度学习技术的不断发展,大型语言模型(LargeLanguageModels,LLMs)已经成为当前最引人注目的研究热点之一。LLMs能够在各种自然语言处理任务上展现出惊人的性能,例如机器翻译、文本生成、问答系统等。PyTorch和TensorFlow等深度学习框架为训练和微调大型语言模型提供了强大的支持。PyCharm

- 强大的销售团队背后 竟然是大数据分析的身影

蓝儿唯美

数据分析

Mark Roberge是HubSpot的首席财务官,在招聘销售职位时使用了大量数据分析。但是科技并没有挤走直觉。

大家都知道数理学家实际上已经渗透到了各行各业。这些热衷数据的人们通过处理数据理解商业流程的各个方面,以重组弱点,增强优势。

Mark Roberge是美国HubSpot公司的首席财务官,HubSpot公司在构架集客营销现象方面出过一份力——因此他也是一位数理学家。他使用数据分析

- Haproxy+Keepalived高可用双机单活

bylijinnan

负载均衡keepalivedhaproxy高可用

我们的应用MyApp不支持集群,但要求双机单活(两台机器:master和slave):

1.正常情况下,只有master启动MyApp并提供服务

2.当master发生故障时,slave自动启动本机的MyApp,同时虚拟IP漂移至slave,保持对外提供服务的IP和端口不变

F5据说也能满足上面的需求,但F5的通常用法都是双机双活,单活的话还没研究过

服务器资源

10.7

- eclipse编辑器中文乱码问题解决

0624chenhong

eclipse乱码

使用Eclipse编辑文件经常出现中文乱码或者文件中有中文不能保存的问题,Eclipse提供了灵活的设置文件编码格式的选项,我们可以通过设置编码 格式解决乱码问题。在Eclipse可以从几个层面设置编码格式:Workspace、Project、Content Type、File

本文以Eclipse 3.3(英文)为例加以说明:

1. 设置Workspace的编码格式:

Windows-&g

- 基础篇--resources资源

不懂事的小屁孩

android

最近一直在做java开发,偶尔敲点android代码,突然发现有些基础给忘记了,今天用半天时间温顾一下resources的资源。

String.xml 字符串资源 涉及国际化问题

http://www.2cto.com/kf/201302/190394.html

string-array

- 接上篇补上window平台自动上传证书文件的批处理问卷

酷的飞上天空

window

@echo off

: host=服务器证书域名或ip,需要和部署时服务器的域名或ip一致 ou=公司名称, o=公司名称

set host=localhost

set ou=localhost

set o=localhost

set password=123456

set validity=3650

set salias=s

- 企业物联网大潮涌动:如何做好准备?

蓝儿唯美

企业

物联网的可能性也许是无限的。要找出架构师可以做好准备的领域然后利用日益连接的世界。

尽管物联网(IoT)还很新,企业架构师现在也应该为一个连接更加紧密的未来做好计划,而不是跟上闸门被打开后的集成挑战。“问题不在于物联网正在进入哪些领域,而是哪些地方物联网没有在企业推进,” Gartner研究总监Mike Walker说。

Gartner预测到2020年物联网设备安装量将达260亿,这些设备在全

- spring学习——数据库(mybatis持久化框架配置)

a-john

mybatis

Spring提供了一组数据访问框架,集成了多种数据访问技术。无论是JDBC,iBATIS(mybatis)还是Hibernate,Spring都能够帮助消除持久化代码中单调枯燥的数据访问逻辑。可以依赖Spring来处理底层的数据访问。

mybatis是一种Spring持久化框架,要使用mybatis,就要做好相应的配置:

1,配置数据源。有很多数据源可以选择,如:DBCP,JDBC,aliba

- Java静态代理、动态代理实例

aijuans

Java静态代理

采用Java代理模式,代理类通过调用委托类对象的方法,来提供特定的服务。委托类需要实现一个业务接口,代理类返回委托类的实例接口对象。

按照代理类的创建时期,可以分为:静态代理和动态代理。

所谓静态代理: 指程序员创建好代理类,编译时直接生成代理类的字节码文件。

所谓动态代理: 在程序运行时,通过反射机制动态生成代理类。

一、静态代理类实例:

1、Serivce.ja

- Struts1与Struts2的12点区别

asia007

Struts1与Struts2

1) 在Action实现类方面的对比:Struts 1要求Action类继承一个抽象基类;Struts 1的一个具体问题是使用抽象类编程而不是接口。Struts 2 Action类可以实现一个Action接口,也可以实现其他接口,使可选和定制的服务成为可能。Struts 2提供一个ActionSupport基类去实现常用的接口。即使Action接口不是必须实现的,只有一个包含execute方法的P

- 初学者要多看看帮助文档 不要用js来写Jquery的代码

百合不是茶

jqueryjs

解析json数据的时候需要将解析的数据写到文本框中, 出现了用js来写Jquery代码的问题;

1, JQuery的赋值 有问题

代码如下: data.username 表示的是: 网易

$("#use

- 经理怎么和员工搞好关系和信任

bijian1013

团队项目管理管理

产品经理应该有坚实的专业基础,这里的基础包括产品方向和产品策略的把握,包括设计,也包括对技术的理解和见识,对运营和市场的敏感,以及良好的沟通和协作能力。换言之,既然是产品经理,整个产品的方方面面都应该能摸得出门道。这也不懂那也不懂,如何让人信服?如何让自己懂?就是不断学习,不仅仅从书本中,更从平时和各种角色的沟通

- 如何为rich:tree不同类型节点设置右键菜单

sunjing

contextMenutreeRichfaces

组合使用target和targetSelector就可以啦,如下: <rich:tree id="ruleTree" value="#{treeAction.ruleTree}" var="node" nodeType="#{node.type}"

selectionChangeListener=&qu

- 【Redis二】Redis2.8.17搭建主从复制环境

bit1129

redis

开始使用Redis2.8.17

Redis第一篇在Redis2.4.5上搭建主从复制环境,对它的主从复制的工作机制,真正的惊呆了。不知道Redis2.8.17的主从复制机制是怎样的,Redis到了2.4.5这个版本,主从复制还做成那样,Impossible is nothing! 本篇把主从复制环境再搭一遍看看效果,这次在Unbuntu上用官方支持的版本。 Ubuntu上安装Red

- JSONObject转换JSON--将Date转换为指定格式

白糖_

JSONObject

项目中,经常会用JSONObject插件将JavaBean或List<JavaBean>转换为JSON格式的字符串,而JavaBean的属性有时候会有java.util.Date这个类型的时间对象,这时JSONObject默认会将Date属性转换成这样的格式:

{"nanos":0,"time":-27076233600000,

- JavaScript语言精粹读书笔记

braveCS

JavaScript

【经典用法】:

//①定义新方法

Function .prototype.method=function(name, func){

this.prototype[name]=func;

return this;

}

//②给Object增加一个create方法,这个方法创建一个使用原对

- 编程之美-找符合条件的整数 用字符串来表示大整数避免溢出

bylijinnan

编程之美

import java.util.LinkedList;

public class FindInteger {

/**

* 编程之美 找符合条件的整数 用字符串来表示大整数避免溢出

* 题目:任意给定一个正整数N,求一个最小的正整数M(M>1),使得N*M的十进制表示形式里只含有1和0

*

* 假设当前正在搜索由0,1组成的K位十进制数

- 读书笔记

chengxuyuancsdn

读书笔记

1、Struts访问资源

2、把静态参数传递给一个动作

3、<result>type属性

4、s:iterator、s:if c:forEach

5、StringBuilder和StringBuffer

6、spring配置拦截器

1、访问资源

(1)通过ServletActionContext对象和实现ServletContextAware,ServletReque

- [通讯与电力]光网城市建设的一些问题

comsci

问题

信号防护的问题,前面已经说过了,这里要说光网交换机与市电保障的关系

我们过去用的ADSL线路,因为是电话线,在小区和街道电力中断的情况下,只要在家里用笔记本电脑+蓄电池,连接ADSL,同样可以上网........

- oracle 空间RESUMABLE

daizj

oracle空间不足RESUMABLE错误挂起

空间RESUMABLE操作 转

Oracle从9i开始引入这个功能,当出现空间不足等相关的错误时,Oracle可以不是马上返回错误信息,并回滚当前的操作,而是将操作挂起,直到挂起时间超过RESUMABLE TIMEOUT,或者空间不足的错误被解决。

这一篇简单介绍空间RESUMABLE的例子。

第一次碰到这个特性是在一次安装9i数据库的过程中,在利用D

- 重构第一次写的线程池

dieslrae

线程池 python

最近没有什么学习欲望,修改之前的线程池的计划一直搁置,这几天比较闲,还是做了一次重构,由之前的2个类拆分为现在的4个类.

1、首先是工作线程类:TaskThread,此类为一个工作线程,用于完成一个工作任务,提供等待(wait),继续(proceed),绑定任务(bindTask)等方法

#!/usr/bin/env python

# -*- coding:utf8 -*-

- C语言学习六指针

dcj3sjt126com

c

初识指针,简单示例程序:

/*

指针就是地址,地址就是指针

地址就是内存单元的编号

指针变量是存放地址的变量

指针和指针变量是两个不同的概念

但是要注意: 通常我们叙述时会把指针变量简称为指针,实际它们含义并不一样

*/

# include <stdio.h>

int main(void)

{

int * p; // p是变量的名字, int *

- yii2 beforeSave afterSave beforeDelete

dcj3sjt126com

delete

public function afterSave($insert, $changedAttributes)

{

parent::afterSave($insert, $changedAttributes);

if($insert) {

//这里是新增数据

} else {

//这里是更新数据

}

}

- timertask

shuizhaosi888

timertask

java.util.Timer timer = new java.util.Timer(true);

// true 说明这个timer以daemon方式运行(优先级低,

// 程序结束timer也自动结束),注意,javax.swing

// 包中也有一个Timer类,如果import中用到swing包,

// 要注意名字的冲突。

TimerTask task = new

- Spring Security(13)——session管理

234390216

sessionSpring Security攻击保护超时

session管理

目录

1.1 检测session超时

1.2 concurrency-control

1.3 session 固定攻击保护

- 公司项目NODEJS实践0.3[ mongo / session ...]

逐行分析JS源代码

mongodbsessionnodejs

http://www.upopen.cn

一、前言

书接上回,我们搭建了WEB服务端路由、模板等功能,完成了register 通过ajax与后端的通信,今天主要完成数据与mongodb的存取,实现注册 / 登录 /

- pojo.vo.po.domain区别

LiaoJuncai

javaVOPOJOjavabeandomain

POJO = "Plain Old Java Object",是MartinFowler等发明的一个术语,用来表示普通的Java对象,不是JavaBean, EntityBean 或者 SessionBean。POJO不但当任何特殊的角色,也不实现任何特殊的Java框架的接口如,EJB, JDBC等等。

即POJO是一个简单的普通的Java对象,它包含业务逻辑

- Windows Error Code

OhMyCC

windows

0 操作成功完成.

1 功能错误.

2 系统找不到指定的文件.

3 系统找不到指定的路径.

4 系统无法打开文件.

5 拒绝访问.

6 句柄无效.

7 存储控制块被损坏.

8 存储空间不足, 无法处理此命令.

9 存储控制块地址无效.

10 环境错误.

11 试图加载格式错误的程序.

12 访问码无效.

13 数据无效.

14 存储器不足, 无法完成此操作.

15 系

- 在storm集群环境下发布Topology

roadrunners

集群stormtopologyspoutbolt

storm的topology设计和开发就略过了。本章主要来说说如何在storm的集群环境中,通过storm的管理命令来发布和管理集群中的topology。

1、打包

打包插件是使用maven提供的maven-shade-plugin,详细见maven-shade-plugin。

<plugin>

<groupId>org.apache.maven.

- 为什么不允许代码里出现“魔数”

tomcat_oracle

java

在一个新项目中,我最先做的事情之一,就是建立使用诸如Checkstyle和Findbugs之类工具的准则。目的是制定一些代码规范,以及避免通过静态代码分析就能够检测到的bug。 迟早会有人给出案例说这样太离谱了。其中的一个案例是Checkstyle的魔数检查。它会对任何没有定义常量就使用的数字字面量给出警告,除了-1、0、1和2。 很多开发者在这个检查方面都有问题,这可以从结果

- zoj 3511 Cake Robbery(线段树)

阿尔萨斯

线段树

题目链接:zoj 3511 Cake Robbery

题目大意:就是有一个N边形的蛋糕,切M刀,从中挑选一块边数最多的,保证没有两条边重叠。

解题思路:有多少个顶点即为有多少条边,所以直接按照切刀切掉点的个数排序,然后用线段树维护剩下的还有哪些点。

#include <cstdio>

#include <cstring>

#include <vector&

![]()

![]() 函数或者

函数或者![]() 函数将网络的输出转换为概率值。

函数将网络的输出转换为概率值。![]() ,网络输出分布为

,网络输出分布为![]() ,总的类别数为

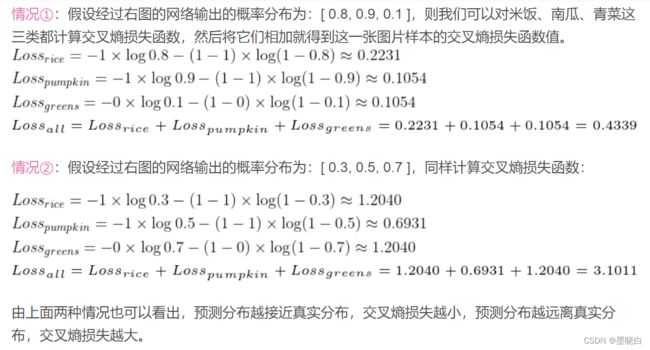

,总的类别数为![]() ,则在这种情况下,交叉熵损失函数的计算方法如下所示,我们可以看出,实际上也就是计算了标签类别为1的交叉熵的值,使得对应的信息量越来越小,相应的概率也就越来越大了。

,则在这种情况下,交叉熵损失函数的计算方法如下所示,我们可以看出,实际上也就是计算了标签类别为1的交叉熵的值,使得对应的信息量越来越小,相应的概率也就越来越大了。![]()

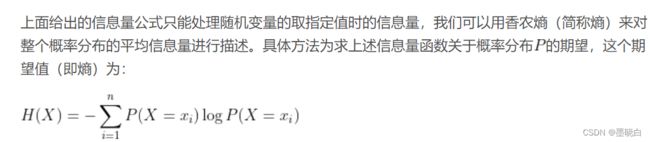

![]() 函数作为网络最后一层的输出,得出每个类别预测为1的概率。以图像识别任务为例,网络最后一层的输出应该理解为:网络认为图片中含有这一类别物体的概率。而每一类的真实标签都只有两种可能值,即“图片中含有这一类物体”和“图片中不含有这一类物体”,这是一个二项分布。综上所述,对多标签类任务中的每一类单独分析的话,真实分布是一个二项分布,可能的取值为0或者1,而网络预测的分布可以理解为标签是1的概率。此外,由于多标签分类任务中,每一类是相互独立的,所以网络最后一层神经元输出的概率值之和并不等于1。对多标签分类任务中的一类任务来看,交叉熵损失函数为:

函数作为网络最后一层的输出,得出每个类别预测为1的概率。以图像识别任务为例,网络最后一层的输出应该理解为:网络认为图片中含有这一类别物体的概率。而每一类的真实标签都只有两种可能值,即“图片中含有这一类物体”和“图片中不含有这一类物体”,这是一个二项分布。综上所述,对多标签类任务中的每一类单独分析的话,真实分布是一个二项分布,可能的取值为0或者1,而网络预测的分布可以理解为标签是1的概率。此外,由于多标签分类任务中,每一类是相互独立的,所以网络最后一层神经元输出的概率值之和并不等于1。对多标签分类任务中的一类任务来看,交叉熵损失函数为:![]()