Prior Attention Enhanced Convolutional Neural Network Based Automatic Segmentation of Organs at Risk

Prior Attention Enhanced Convolutional Neural Network Based Automatic Segmentation of Organs at Risk for Head and Neck Cancer Radiotherapy

发表期刊:IEEE Access(大类:计算机3区)

发表时间:2020年

Abstract

为了在头颈部 (H&N) 癌症放射治疗中自动分割风险器官 (OAR),我们在全尺寸计算机断层扫描(CT) 图像上开发了一种新的基于先验注意增强卷积神经网络 (PANet) 的逐步细化分割框架 (SRSF)。SRSF 采用多尺度分割概念构建,其中 OAR 从粗到细进行分割。 PANet 是一种金字塔结构,具有初始块和优先注意的元素。在本研究中,开发的基于 PANet 的 SRSF 应用于 H&N 放射治疗中的 OAR 分割。从 139 名 H&N 患者中收集了 139 个 CT 系列和由经验丰富的肿瘤学家手动描绘的 22 个 OAR 的轮廓,用于训练和评估提议的基于 PANet 的 SRSF。 39 个 CT 系列的平均测试Dice相似系数 (DSC) 范围从 76.1±8.3%(左中耳)到 91.9±1.4%(右下颌骨),大体积 OAR(平均体积 >1cc),相应范围为 63.4± 12.3%(交叉)至 81.0±14.1%(右晶状体),适用于小型且具有挑战性的 OAR(平均体积 ≤1cc)。此外,所提出的方法还在 MICCAI 2015 H&N 数据集上实现了优于参考方法的分割,平均 DSC 为 95.6±0.7%、81.3±4.0%、77.6±4.5%、77.5±4.6% 和 69.2±7.6%,在分别为下颌、左下颌下、左右视神经和交叉。在自行收集的测试数据和公共测试数据集上都获得了 OAR 的准确分割,这意味着所提出的方法可以用作 H&N 癌症放射治疗中自动 OAR 轮廓的实用且有效的工具。

Index items:Artificial intelligence, image segmentation,supervised learning,image processing,organ at risk,radiotherapy,head and neck cancer

Introduction

计算机断层扫描 (CT) 中的风险器官 (OAR) 描绘是放射治疗计划中的关键步骤,以实现器官剂量保留以最大限度地减少辐射引起的毒性 [1]、[2]。目前的临床实践中通常采用人工勾画,该方法耗时且操作者内部和操作者之间的差异较大[3]。另一方面,OARs的勾画质量直接影响OARs的剂量分布,尤其是头颈部(H&N)癌症放疗,它涉及到许多重要的OARs,如脑干、视神经、垂体等。Amore鲁棒和准确的自动 OAR 分割在临床上对于 H&N 癌症放射治疗是可取的 [1]。

在过去的几十年中,许多自动 OAR 分割方法,如分水岭分割算法 [4]、[5]、基于活动轮廓模型的算法 [6]、[7] 和基于区域增长的分割算法 [8] , [9] 是为 H&N 癌症放射治疗而开发的。研究和使用最广泛的传统方法是基于图谱的自动分割(ABAS)方法,该方法在商业治疗计划系统中广泛采用,用于辅助轮廓描绘。 ABAS方法可以分为两类:单图集[10]、[11]和基于多图集的方法[12]-[15]。基于单一图谱的方法对所选图谱很敏感,如果目标图像和图谱之间存在很大的解剖差异,则可能会失败[16],[17]。相比之下,基于多图集的方法对图集的敏感性较低,但由于涉及更多的配准程序,效率也较低,这可能会引入更多的配准错误[15]。然而,由于 CT 图像中软组织对比度低和患者间差异,ABAS 方法在分割上往往精度低。因此,通常需要更多的手动修改来满足放射治疗计划的临床要求。

最近,基于卷积神经网络(CNN)的深度学习方法被认为是医学图像分割任务的最新方法。许多深度学习研究已经在用于放射治疗的 H&N OARs 分割中进行了 [18]-[23]。 Ibragimov 和 Xing [19] 将 CNN 应用于 H&N 癌症放射治疗 CT 图像中的 13 个 OAR 分割,并且在大多数 OAR 中实现了比传统 ABAS 方法更高的精度,而在低对比度和小器官(如视神经)中的分割效果较差。 视神经和视交叉,Dice 相似系数 (DSC) 分别为 63.9% 和 37.4%。梁等人[20] 提出了一种两阶段(检测和分割)方法,用于 DSC 从 68.9% (ONs) 到 93.4% (eyes) 的 18 个 H&N OARs 分割,优于全卷积神经网络 (FCN) 的结果。然而,分割精度受到仅使用 2D 图像信息的限制,ON 的平均 DSC <70%。童等人[21] 开发了一个形状表示模型来约束 9 个 H&N OAR 分割的 3D FCN,实现了从 58.5%(交叉)到 93.7%(下颌骨)的平均 DSC。然而,这项研究是对体素大小为 2mm×2mm×2mm(2×2×2mm3) 的下采样 CT 图像进行的,不适合临床使用 [21]。陈等人[22] 开发了一个基于集成 UNet [24] 的递归分割框架,用于在磁共振图像上进行脑干、眼睛、ON 和交叉分割,即使在视神经和视交叉的平均 DSC 为 80.1% 和 71.1% 的小型 OAR 中,它的性能也优于 UNet。然而,MRI 的描绘仍需要通过图像配准外推到 CT 以进行放射治疗计划,这将引入配准的不确定性。朱等人[23] 为全体积 CT 图像上的 9 个 OAR 构建了一个基于挤压和激励残差块的 AnatomyNet。 AnatomyNet 实现的平均分割 DSC 范围从 53.5%(交叉)到 91.3%(下颌骨)。然而,由于边界模糊和图像信息有限,上述方法在低对比度和小 OAR 上仍然表现不佳。此外,没有考虑所提出的方法在颞叶、垂体和交叉等非常大和小的 OARS 上的兼容性。高等人[25] 提出了一个 FocusNet 来平衡大型和小型 OAR 分割。它通过训练 OAR 特定模型在小型 OAR 上实现了更准确的分割,这非常耗时。此外,FocusNet 通过简单地连接来自 OAR 定位的特征图来使用先验信息,这可能会削弱模型的稳定性。

在这项研究中,22 个用于 H&N 癌症放射治疗的 OAR 参与了分割任务,包括 4 个单器官:脑干、脊髓、交叉和垂体,以及 9 个成对器官:颞叶(TL)、眼睛、视神经( ONs)、晶状体、中耳 (ME)、乳突、下颌骨、颞下颌关节 (TMJ)、腮腺。在下面的段落中,成对的 OAR 的左右部分分别表示为 OAR_l、OAR_r。为了在 H&N 癌症放射治疗的全容积 CT 图像中实现大小 OAR 的全自动准确分割,我们开发并评估了一种新的逐步细化分割框架 (SRSF),其核心模型是新的先验注意力增强卷积神经网络 (PANet) .基于 PANet 的 SRSF(SRSFPANet) 探索和利用 OAR 之间固有的稳定相对位置,通过三个连续的分割步骤实现 OAR 由粗到细的分割:OAR 组分割 (OGS)、大/易 OAR 分割 (LOS) ,以及小/困难的 OAR 分割(SOS)。为了提高每一步的分割精度,将先验和可学习空间注意力的新组合注意力应用于合理的初始块,以便在 PANet 中进行更准确和有效的特征提取。

Methods and materials

Methods

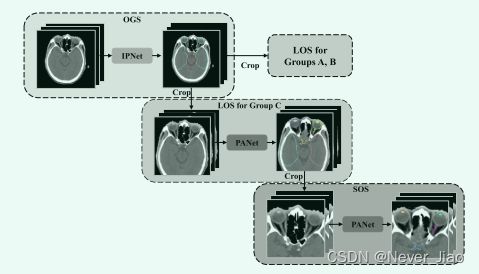

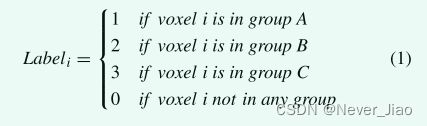

在这项研究中,开发了一种基于 PANet 的新型 SRSF:SRSFPANet,用于在常见的大体积 CT 图像中进行大量 OAR 的分割。 22 个要勾画的 OAR 分为三组: A 组:脑干和脊髓; B组:乳突、下颌骨、颞下颌关节、腮腺、中耳; C 组:颞叶、眼睛和相邻的小 OAR(平均体积 ≤1cc):晶状体、视神经、交叉和垂体。如图 1 所示,SRSF 包括三个连续的分割步骤:OGS、LOS 和 SOS。首先,OGS 模型在半分辨率的下采样 CT 图像上进行训练,用于 OAR 组分割。每个 OAR 组的标签通过公式 1 获得。这意味着每个组中的 OAR 被视为一个单独的目标。

**Fig.1 **用于 H&N OAR 分割的 SRSFPANet 概述。 SRSF 在本研究中包括三个部分:OGS、LOS 和 SOS。标记为“IPNet”和“PANet”的方框代表 SRSF 的核心模型。

然后,对相应的感兴趣区域 (ROI) 进行定位,并分别粗略 OGS 预测LOS的先验概率图。同样,每组中的小 OAR(如果存在)也被分割为一个整体结构,用于 ROI 定位和先验概率获取。对于 LOS 和 SOS,除了 LOS C中的小 OAR 组之外的每个 OAR 都被视为一个单独的目标(意思是,对于LOS中的器官,把所有的小器官也就是C组中的器官看作一个目标,剩余的每一个器官都看作一个单独的目标)。

对于OGS,基于经典金字塔网络UNet [24]构建了一个合理的初始金字塔网络(IPNet)。与 UNet 相比,IPNet 的核心特征提取器是一个没有池化路径的合理初始块。如图 2 所示,justified inception 块通过使用具有不同内核大小的多个卷积路径来改进各自的感受野和特征多样性。然而,为了避免图像特征丢失,池化路径被移除。然后,一个卷积块用于组合多核提取的特征图。卷积块依次包括内核大小为 3×3×3 的卷积层、批归一化(BN)层 [26] 和 ReLu 激活层。使用 justified inception 块,金字塔网络的深度也可以减少以避免图像特征丢失,特别是对于小目标。

Fig.2 提出的 IPNet 架构及其核心模块:起始和输出模块。

为了约束网络更加关注有效和信息丰富的空间区域,在 PANet 中设计了一个 Prior Attention 增强 Inception (PAI) 块。如图 3 所示,可学习的 PAI 首先通过先验注意 (PA) 和卷积空间注意调整空间位置的特征图。最后,所有注意力细化的特征图都与未细化的特征图逐元素相加,以避免梯度消失问题。在这项研究中,PANet 中深度 i 的先验注意力图 Pi 是通过平均池化生成的。在本研究中,IPNet 和 PANet 在 OGS 和 LOS 中为 C 组预测的概率图分别被视为后续 OAR 分割的先验信息。

Fig.3 提议的 PANet 架构及其核心块:PA 和 PAI 块。起始块和输出块与 IPNet 中的相同。

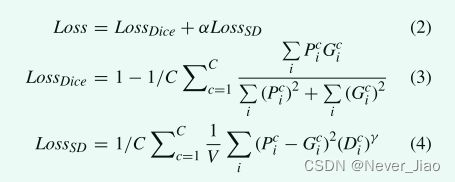

考虑到表面距离(SD)比Dice系数对形状变化更敏感。本研究采用 Dice 损失 [27] 和 SD 损失 [28] 的组合损失进行分割模型训练,其定义为:

其中 P_ic 和 G_ic 分别表示通道 c 的体素 i 中的预测 SoftMax 概率和黄金标准标签。 D_ic 是到金标准表面的相应归一化距离。 γ和α是调整大表面误差惩罚的参数,LossSD的权重设置为1,参考[28]。选择 Adam 优化器 [29] 来最小化损失函数。

所提出的 SRSFPANet 是使用 Python 3.5 中的 Pytorch 深度学习库实现的。模型训练和验证在两张 12GB 内存的 GPU 卡(NVIDIA GeForce GTX 1080)上完成。模型的超参数如表 1 所示。最大训练 epoch 设置为 50,并采用提前停止策略(10 个 epoch 不减少验证损失)以避免过度拟合。

Materials

在中国中山大学肿瘤中心收集了来自 139 名鼻咽癌患者的 139 个独立 CT 系列的手动轮廓。所有轮廓均由经验丰富的肿瘤科医生手动勾画,并由其他经验丰富的肿瘤科医生进行审查和调整,这被视为本研究的金标准。 CT图像的分辨率在横切面0.7mm~1.2mm之间变化。所有情况下的切片厚度均为 3mm。切片数量从 90 到 172 不等,平均为 111。从自收集数据集中提取了 15,443 个切片。

所有 CT 图像被裁剪到 [WL-WW/2, WL+WW/2] 的范围内,然后归一化到 [-1, 1] 的范围内,其中 WW 和 WL 分别表示窗口宽度和水平。所有 139 名患者中的 100 名被随机分成用于训练,其余用于测试。在训练过程中,将 10% 的训练集随机划分为内部验证数据,以避免过度拟合。平移、旋转和噪声添加应用于训练数据增强。通过数据增强,模型训练使用了 360 张三维图像。为了获得训练数据的粗略预测概率,OGS 和 LOS C 中采用了五折交叉验证。

Evaluation

DSC [30] 和 Hausdorff 距离 (HD95) [31] 的 95 个百分位数被用作分割精度评估的定量指标。给定两个体积 G(黄金标准)和 P(预测或分割),以及它们对应的轮廓点 G = {g0, . . . . . . , gn} 和 P = {p0, . . . . . . , pn}。 DSC 和 HD95 定义为:

其中 h (G, P) = max g∈G min g∈P ||g − p||。 DSC 的范围从 0 到 1,分别对应最差和最好的分割。 HD95 范围从 0 到正无穷大。较高的 DSC 和较低的 HD95 表示更准确的分割。在这项研究中,DSC 和 HD95 是在三维基础上为每位患者计算的。此外,体积覆盖率(VCR)定义为 VCR = Vin/Vgt ,其中 Vin 和 Vgt 分别是提取的 ROI 内的覆盖体积和目标 OAR 的黄金标准体积。 VCR 用于评估 ROI 定位精度。 100% 的 VCR 意味着本地化的 ROI 可以覆盖所有目标 OAR。

由于图形处理单元(GPU)占用较大,一般硬件条件难以直接支持在原始CT图像上对二十二个器官进行分割。因此,在评估研究中,将所提出的 SRSFPANet 与基于 UNet 和 IPNet 的 SRSF(SRSFUNet 和 SRSFIPNet)进行了比较。上述三种方法中使用的核心模型如表2所示。Kolmogorov-Smirnov检验用于正态分布检验(p>0.05)。然后,分别使用 Wilcoxon 秩和检验和配对 t 检验对具有异常和正态分布的数据集进行统计显着性分析。本研究采用SPSS 19.0软件进行统计分析。显着差异由 p < 0.05 定义。

为了将所提出的方法与其他最先进的方法进行比较,SRSFPANet 还在 MICCAI 2015 H&N OARs 分割数据集 [32] 上与五种已发表的方法 [23]、[25]、[32]-[34] 进行了比较,表示为 MICCAI '15 数据集 (http://www.imagenglab.com/newsite/pddca/)。 MICCAI’15 数据集由 38 个训练样本和 10 个测试样本组成。五种参考方法包括MICCAI’15挑战赛的冠军方法[32]和其他四种基于深度学习的最新方法[23]、[25]、[33]、[34]。为了将提议的 SRSFPANet 用于该 MICCAI’15 分割任务,在本比较研究中,将 TMJ 的原始输出通道替换为 B 组 LOS 中的下颌下分割。 SRSFPANet 的其他设置与在自收集数据集的实验中使用的设置相同。

Results

表3说明了OGS和LOS C中OARs组的分割精度。OGS中大OARs组的平均DSC>83%,对应的HD95<4.8mm,变化很小。 LOS C 中小 OAR 的平均 DSC 和 HD95 分别为 68.3±4.7% 和 6.3±2.6mm。此外,100% 的 VCR 显示所有 OAR 都覆盖在大小设置下的相应 ROI 中。结果表明,OAR 组的分割精度和 ROI 大小设置对于本研究中的 SRSF 来说已经足够了。如图 4 所示的分割示例,在 SRSFUNet 获得的分割结果中观察到欠分割和过度分割,特别是对于下颌骨和 TL。得益于 inception 模块更大的各自领域,SRSFIPNet 取得了比 SRSFUNet 更好的性能,但仍然无法在 TL、乳突和 ONs 等非常大的器官和低对比度的器官上实现准确的分割。相比之下,SRSFPANet 的表现优于 SRSFUNet 和 SRSFIPNet,与医生划定的黄金标准具有最佳一致性。在 ONs 和 chiasm 等小型 OAR 上,SRSFPANet 也取得了最好的分割结果。

Fig.4 SRSFUNet、SRSFIPNet 和 SRSFPANet 之间的分割比较。黄色箭头表示过度和不足分割。第一列和最后一列是原始CT图像和人工分割。

表 4 列出了 SRSFUNet、SRSFIPNet 和 SRSFPANet 的测试结果。对于 SRSFUNet,平均 DSC 高于 70.0%,在大体积 OAR 上的范围从 72.8%(ME_r) 到 89.1%(mandible_l),在小 OAR 上的范围从 51.2%(chiasm) 到 75.2%(ON_r)。对于几乎所有的 OAR,SRSFUNet 都可以取得很好的结果,除了体积非常大的 OAR,例如 TL 和下颌骨。随着各个领域的改进,SRSFIPNet 在 TL_l/r、parotid_l/r、ME_r、mastoid_l、TNJ_l/r、lens_l/r、ON_l/r、交叉和垂体上取得了显着更好的分割结果,并且在 eye_l/r 上的结果没有显着差异, ME_l, mastoid_r,但在脊髓和 TMJ_l/r 上的结果明显更差。与 SRSFUNet 相比,SRSFPANet 在 19 个 OAR 上取得了明显更好的分割结果,而在 ME_l、TMJ_l/r 上的结果没有显着差异。与 SRSFIPNet 相比,SRSFPANet 在 17 个 OAR 上也取得了明显更好的分割结果,并且在 5 个 OAR(mastoid_l、mandible_l、lens_l、ON_l 和垂体)上的结果没有显着差异。在 HD95 的比较中,SRSFIPNet 在 22 个 OAR 中的 10 个上实现了明显优于 SRSFUNet 的性能。此外,SRSFPANet 在 13 个和 7 个 OAR 上的性能分别优于 SRSFUNet 和 SRSFIPNet。总体而言,SRSFIPNet 实现了性能提升,而 SRSFPANet 在所有三种方法中取得了最好的结果。

图 5 描绘了测试数据中 DSC 和 HD95 比较的箱线图。我们可以观察到: 1)在所有三种方法中,SRSFPANet 在 DSC 和 HD95 上总体上取得了最好的结果; 2) 与 SRSFUNet 相比,SRSFIPNet 在 11 个 OAR 上表现显着优于,但在 2 个 OAR(ME_l 和 Mandible_r)上显着逊色; 3) SRSFPANet 在交叉和垂体上取得的最差结果比 SRSFUNet 和 SRSFIPNet 差。一般来说,SRSFPANet 对 H&N OAR 的分割比 SRSFUNet 和 SRSFIPNet 更准确。

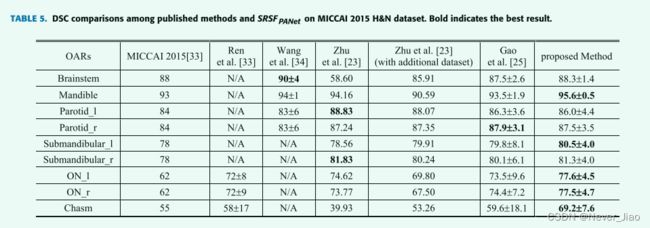

表 5 说明了我们提出的方法和五种最先进的方法在 MICCAI’15 数据集上的分割比较。相比之下,所提出的方法在大容量 OAR 上实现了比较且略胜一筹的(下颌骨)分割精度。对于小型 OAR,通过所提出的方法实现了最准确的分割,在 ON_l、ON_r 和 chiasm 上的均值 DSC 分别为 77.6±4.5%、77.5±4.6% 和 69.2±7.6%。应该指出的是,朱等人 [23] 在他们的研究中使用了一个额外的训练数据集。公共数据集的分割结果表明:(1)SRSFPANet的分割精度优于这些参考方法; (2) SRSF 和 PANet 都可以很容易地转移到不同的 OARs 分割场景中。

Discussion

本研究开发并验证了一种基于 PANet 的新型 SRSF:SRSFPANet,用于自动分割 CT 图像中的 OAR,用于 H&N 癌症放射治疗。 SRSF 被提出来缓解多目标分割中的体积不平衡,特别是对于本研究中的视神经、交叉和垂体等微小目标。排除更多背景区域是解决此问题的直接有效方法。因此,我们通过 SRSF 逐步实现了多个 OAR 分割。主要步骤用于实现粗分割、OAR 定位和先验注意,这对于下一次在不同方面的分割细化很有用。因此,所提出的 SRSF 与不同的基本网络兼容,例如用于多目标分割的 PANet、IPNet 和 UNet。此外,我们在 PANet 中提出了优先注意,以在先前的分割中利用预测的置信概率图。为了提高小器官的分割精度,在 IPNet 和 PANet 中采用了合理的初始块来进行更大规模的特征提取,同时减少了池化操作。

在 39 个测试用例和 MICCAI’15 公共数据集上取得的定量和定性评估结果(表 4、图 5、表 5)证明了该方法的有效性。此外,与 SRSFUNet 和 SRSFIPNet 相比,所提出的 SRSFPANet 在大多数 OAR 上取得了显着更好的性能。此外,为一个新病例分割所有22个OAR的同时成本约为30s,可有效支持临床勾画工作。

如表 5 和图 5 所示的定量和定性评估结果,我们可以观察到:(1)SRSFUNet 实现的分割精度低于 SRSFIPNet 和 SRSFPANet,特别是对于非常大的 OAR(TL)和小 OAR(ON) ,和交叉)。有两个原因:IPNet 和 PANet 中的网络较浅和各自领域较大。为了避免小型 OAR 分割的特征缺失,我们减少了池化操作。因此,网络较浅,会削弱 UNet 等网络的能力,但不会影响各自领域较大的 IPNet 和 PANet。从 inception 块中受益的较大的各个感受野有助于 IPNet 和 PANet 提取更多有用的全局特征进行分割。这样,IPNet 和 PANet 在池化操作和更多全局特征之间取得了平衡。 (2) 即使在相同的领域,SRSFPANet 仍然比 SRSFIPNet 实现了优越的分割性能,这得益于先验注意力和卷积空间注意力的组合机制。首先,所提出的 SRSF 提供了一种实用的方法来利用从先前的分割步骤中获得的信息。它不仅用于 ROI 定位,还可以用作 PANet 中的优先注意力。因此,OGS 和 LOS 对 C 组的优先关注可以提供额外的全局信息,其中涉及 OAR 之间的关系。其次,可学习的卷积空间注意力可以在特征图上实现特定于案例的空间调整。此外,可学习的空间注意力是软的,可以从先验调整硬注意力。因此,所提出的 SRSFPANet 在理论和实践上都是可靠的。

此外,如表 5 所示,Wang 的方法 [34] 在脑干和下颌骨上的表现最好,但在腮腺上表现不佳。原因是他们使用了基于在所有地图集中检测到的形状对应关系构建的形状回归模型。然而,腮腺的形状变化远大于脑干和下颌骨。由于形状对应检测的误差较大,腮腺的分割精度降低。此外,Zhu 的模型 [23] 在左腮腺和右下颌下骨上的表现最好,但在脑干和视交叉上的表现尤其差。通过对额外数据集的训练,脑干和交叉的分割精度得到了提高,但下颌神经和视神经的分割精度降低了。这些结果暗示了朱的方法的不稳定性,该方法通过单个模型在整个 CT 图像上实现了多个 OAR。相比之下,所提出的 SRSFPANet 更加准确和稳定,这得益于三个创新:SRSF、具有更大感受野的合理初始块和先验注意机制。

然而,这项研究也有一些局限性。 1)如图 3 所示,SRSFPANet 在交叉和垂体上取得的最差结果比 SRSFUNet 和 SRSFIPNet 差,尽管 SRSFPANet 在大多数情况下表现更好。考虑到光学交叉和垂体非常小,通常只出现在一到两个CT切片中,先验信息往往会误导进一步的分割。因此,可以认为所提出的模型在一定程度上仍然对小目标分割的先验敏感。 2) PANet 训练依赖于先验概率图,它来自之前的分割步骤。为了提高模型的稳定性,所有训练数据的先验概率图都是通过内部五折交叉验证获得的。因此,训练过程比一般模型更复杂。在本研究中,模型训练的时间成本约为 70 小时。在未来的工作中,可以采用其他快速的常规方法来避免这种缺点。 3)初始块不是实现更大感受野的唯一方法。例如,空洞卷积也可以用更少的参数实现与初始块类似的多尺度效果。然而,空洞卷积中的网格化问题不利于小目标分割。因此,更可行的修改方法,例如结合了初始块和空洞卷积理想的感受野块,也值得在未来的工作中应用于类似的分割任务。 4) 本研究仅考虑在非对比 CT 图像中对 H&N 上的 OAR 进行分割。我们计划将所提出的方法应用于更多的分割应用,以协助未来工作中的放射治疗计划。 5)评估数据集的大小是有限的。我们计划在不同解剖部位的更多临床数据上评估所提出的方法,以提供更多临床支持。

总之,为 H&N OAR 的自动顺序分割开发了一个 SRSF 框架。基于 SRSF,提出了一种新的 PANet,通过平衡各自的 felid 和池化操作,并结合软空间注意力和硬先验注意力,实现更准确的分割。 SRSFPANet 在独立和公共测试数据集上取得的良好评估结果都表明,所提出的 SRSFPANet 可以成为 H&N 癌症放射治疗中自动 OAR 轮廓的潜在工具。