图像融合概述

多源图像融合简述

图像融合的概念:融合是一种图像增强方法,应用于摄影可视化、物体跟踪、医学诊断、遥感监测等诸多领域。

图像融合的意义:图像融合是理解图像和计算机视觉领域重要的技术,进行多源数据智能融合,可以实现比单一传感器数据决策更精确,融合的图像更符合人和机器的视觉特性,也有利于更进一步对图像进行目标识别和检测。

图像融合的层次分类(按照融合时间):

基于像素的融合;

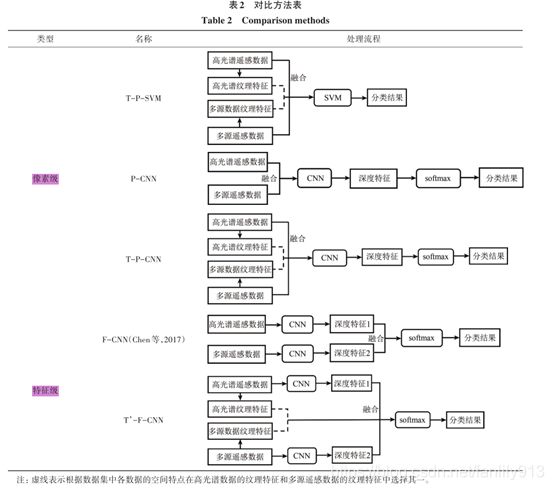

基于特征的融合;(特征融合是对多源图像进行特征提取、再进行特征拼接融合。该融合方法具有较高的可信度和准确度。)

基于决策的融合;

图像融合方法分类:

基于像素的空间域的融合;

基于多尺度多频率的变换域的融合;

基于模型的融合方法以及多种方法融合;

图像融合的数据来源:

多聚焦的图像的融合(如:数码摄影影像)

多模态图像融合(如:红外和可见光图像的融合;医学图像的融合)

数据来源–传感器:

遥感数据:全色相机、彩色/多光谱相机,高光谱相机、热红外相机、夜光相机、立体相机、视频相机、合成孔径雷达SRA、激光测量仪。(同一场景多源遥感图像观测的地物对象相同,但观测的维度不同,图像的空间、光谱与时间分辨率存在差异。不同源获取的遥感图像原理不同,图像的空间分辨率、观测尺度预计反映的目标特性也会存在差异)

视觉相机:是必不可少的传感器,它们是廉价的传感器,并且可以为周围场景提供密集的像素信息。

红外和热成像:对比度显著,即使在恶劣天气下也能有效地从背景中突出目标。可见图像包含丰富的纹理细节,更符合人类的视觉感知。红外和可见光图像融合就是将这两种特性结合起来,产生对比度高、纹理丰富的结果。在不利的光线条件和夜视中用于环境感知应用。

激光雷达LiDAR:激光束狭窄,隐蔽性好,被截获的概率很低。(点云数据能够提供地物的空间三维信息,尤其是高精度的高程信息,弥补遥感图像无法有效表示建筑物的侧面墙体、植被高度等立面信息的缺陷,而且点云数据可以直接应用于三维模型重构。缺点:点云数据点集离散分布,无法有效表示地物的轮廓线,并且缺少光谱、纹理信息。融合二者优势,用于地物分类。)

SRA是合成孔径雷达成像: SRA是一种主动微波成像,穿透作用强,能够有效的探测伪装目标,成像不受光线、气候和云雾的限制。多应用于军事侦探、地理测绘、灾害监测等领域。优势:在方位和距离上都能获得很高的几何分辨力,突破经典雷达的分辨率极限。SRA机载卫星具有全天时、全天候的优势,在军事中应用广泛。

全色、多光谱、高光谱图像融合。高分辨和低分辨率的高光谱图像融合,可以极大地提升高光谱图像的空间分辨率。空谱融合是遥感图像融合领域的热点问题。

全色/多光谱与SRA合成孔径雷达图像融合。SRA成像容易受到噪声的影响。SRA图像与全色、多光谱图像融合,综合二者优势,可以生成更高质量的图像。

SRA与红外图像的融合。SAR图像在边缘点处表现出孤立的不连续性。红外图像可以近似反映观察对象的温度梯度和辐射梯度,能够提供比较完整的边缘和纹理信息。将SAR图像与红外图像进行融合,可以将红外图像得到的边缘和纹理信息加入到SAR图像中,融合图像的边缘和纹理将更加融合,同时保持了SAR图像的频率特性,这使得融合图像更具可读性。

激光雷达点云数据与RGB 图形的融合:激光点云数据具有精确的集合信息,但是数据非常稀疏如图1。图像数据分辨率高、具有丰富的纹理特征。二者融合,可以互补如图2。

图1. 激光雷达点云数据对应的深度图

点云数据—>二维坐标转换为深度图-深度图密集处理

RGB图像–>

图2. 激光雷达点云数据对应的深度图与RGB融合

深度图:

计算机视觉系统中,三维场景信息为图像分割、目标检测、物体跟踪等各类计算机视觉应用提供了更多的可能性,而深度图像(Depth map)作为一种普遍的三维场景信息表达方式得到了广泛的应用。深度图像的每个像素点的灰度值可用于表征场景中某一点距离摄像机的远近如图3。深度图像的像素值反映场景中物体到相机的距离,获取深度图像的方法=被动测距传感+主动深度传感。被动测距传感中最常用的方法是双目立体视觉。主动深度传感的方法主要包括了TOF(Time of Flight)、结构光、激光扫描等。

图3 激光雷达转换2维度深度图

高光谱图像与多源遥感数据融合分类:

高光谱数据通道数多(几十到数百),高光谱图像可以探测到宽波段遥感中不能被探测的特征。但是高光谱图像空间分辨率较低使得空间特征不够丰富,不能全面反映目标特征。

遥感图像:如高空间分辨率数据可以提供丰富的空间信息,以及激光雷达LiDAR能实时获取地形表面三维空间信息。有必要融合进行信息补充,提高数据的完整性和可靠性如图4。

图4 高光谱分与多源遥感数据融合的流程图

图5 基于分类任务的高光谱的流程图

图形融合的应用领域:

数码摄影影像融合主要包括多曝光图像融合和多焦点图像融合。方法:CNN和GAN;

由于多焦点图像融合可以看作是对清晰像素的选择,因此这些深度学习方法可以分为基于决策图的方法和基于整体重建的方法。

多模态图像融合 如:红外和可见光图像的融合;医学图像的融合;锐化融合(多光谱锐化、高光谱锐化);人工智能的方法:AE(自动编码器),CNN,GAN

**医学图像的融合:**医学图像融合将两种不同类型的医学图像结合起来,生成信息更丰富的单一图像,有利于对疾病进行更准确的诊断 方法:CNN 和 GAN。

锐化融合:克服光谱分辨率与空间分辨率矛盾的有效技术。在空间图像的引导下,致力于在保持光谱分辨率的同时,在空间维度上实现超分辨率。两个典型的锐化融合任务是多光谱图像锐化和高光谱图像锐化。

多光谱锐化是将低空间分辨率(LRMS)的多光谱图像与全色(PAN)图像融合,生成高空间分辨率(HRMS)的多光谱图像。方法:CNN 和 GAN。

高光谱图像具有更高的光谱分辨率和更低的空间分辨率。因此,可以通过将低空间分辨率(LRHS)的高光谱图像与多光谱图像或全色图像融合来实现高光谱锐化,从而产生高空间分辨率(HRHS)的高光谱图像。方法:CNN 和 GAN。

统一(普适性)图像融合方法

一些方法具有很好的通用性,可以使用统一的框架实现各种图像融合任务。虽然这些方法的思路往往大相径庭,但它们的特点是可以找到不同融合任务的共性。

U2Fusion, PMGI、IFCNN、类似统一方法包括SGRFR CU-Net,DIF-Net,SDNet。

存在的问题:

- 融合之前的图像需要经过配准,(融合前默认都已经配准) 不同分辨率的源图像实现融合的问题。

- 面向任务的图形融合的性能问题(在许多图像融合任务中,现有的基于深度学习的方法在设计损失函数时没有考虑融合与后续应用之间的相关性,这往往会导致非常主观的融合结果。)如分类任务、定位任务等

- 实时的图像融合场景需求。 融合质量的评估问题(由于在大多数图像融合任务中没有真正的ground truth,因此评估融合结果的质量非常具有挑战性。)

自动驾驶中融合:

虽然LiDAR 是最强大的相机,但价格昂贵,研究人员认为,在某些条件下,使用 RGB 相机拍摄的图像足以用于自动驾驶应用。正在研究制造低成本激光雷达。

自动驾驶中的传感器分类:

感受传感器:GPS、编码器、陀螺仪和加速度计

外部感受器:相机、无线电探测和测距雷达、激光雷达等

主被动传感器融合实现:

环境感知:(RGB相机、红外相机、激光雷达、测距雷达)用于道路车辆检测与跟踪、行人检测、跟踪、路面检测、道路车道检测、道路标志检测。

定位:通过全球导航卫星系统(GNSS)、惯性测量单元(IMU)、惯性导航系统(INS)、里程表、摄像头、激光雷达获得车辆的相对位置和绝对位置。

视觉相机:是必不可少的传感器,可生成AV环境的详细环境视图。它们是廉价的传感器,并且可以以相对较低的成本为周围场景提供密集的像素信息。普通的基于视觉的系统无法提供建模3D环境所需的深度信息。一种替代方法是使用由多个位于不同位置的摄像机组成的立体视觉系统。然而,这些系统对外部环境条件也极其敏感,例如光强度(弱光和直射阳光)。

双目相机:一种替代方法是使用由多个位于不同位置的摄像机组成的立体视觉系统,系统对外部环境条件也极其敏感。

激光雷达LiDAR: 提供深度信息,同时对外部天气条件具有鲁棒性。

红外和热成像的使用是研究人员经常研究的另一个活跃领域,用于环境感知应用,尤其是在不利的光线条件和夜视中。

融合:热像仪已与RGB-D或LiDAR传感器融合以增加深度,从而提高系统性能。定位和地图绘制通常使用不同传感器组合:GPS,IMU、LiDAR和相机。

推荐文章:

[1] Deep Learning Sensor Fusion for Autonomous Vehicle Perception and Localization: A Review 文章链接

[2] Deep Learning for Object Detection and Scene Perception in Self-Driving Cars: Survey, Challenges, and Open Issues 文章链接