Python: KNN算法的实现

1、KNN介绍

K最近邻(k-Nearest Neighbor,KNN)分类算法是最简单的机器学习算法。

机器学习,算法本身不是最难的,最难的是:

1、数学建模:把业务中的特性抽象成向量的过程;

2、选取适合模型的数据样本。

这两个事都不是简单的事。算法反而是比较简单的事。

本质上,KNN算法就是用距离来衡量样本之间的相似度。

2、算法图示

◊ 从训练集中找到和新数据最接近的k条记录,然后根据多数类来决定新数据类别。

◊算法涉及3个主要因素:

1) 训练数据集

2) 距离或相似度的计算衡量

3) k的大小

![]()

◊算法描述

1) 已知两类“先验”数据,分别是蓝方块和红三角,他们分布在一个二维空间中

2) 有一个未知类别的数据(绿点),需要判断它是属于“蓝方块”还是“红三角”类

3) 考察离绿点最近的3个(或k个)数据点的类别,占多数的类别即为绿点判定类别

3、算法要点

3.1、计算步骤

1)算距离:给定测试对象,计算它与训练集中的每个对象的距离

2)找邻居:圈定距离最近的k个训练对象,作为测试对象的近邻

3)做分类:根据这k个近邻归属的主要类别,来对测试对象分类

3.2、相似度的度量

◊距离越近应该意味着这两个点属于一个分类的可能性越大。

但,距离不能代表一切,有些数据的相似度衡量并不适合用距离

◊相似度衡量方法:包括欧式距离、夹角余弦等。

(简单应用中,一般使用欧氏距离,但对于文本分类来说,使用余弦(cosine)来计算相似度就比欧式(Euclidean)距离更合适)

3.3、类别的判定

◊简单投票法:少数服从多数,近邻中哪个类别的点最多就分为该类。

◊加权投票法:根据距离的远近,对近邻的投票进行加权,距离越近则权重越大(权重为距离平方的倒数)

3.4、算法不足

- 样本不平衡容易导致结果错误

◊如一个类的样本容量很大,而其他类样本容量很小时,有可能导致当输入一个新样本时,该样本的K个邻居中大容量类的样本占多数。

◊改善方法:对此可以采用权值的方法(和该样本距离小的邻居权值大)来改进。

- 计算量较大

◊因为对每一个待分类的文本都要计算它到全体已知样本的距离,才能求得它的K个最近邻点。

◊改善方法:事先对已知样本点进行剪辑,事先去除对分类作用不大的样本。

该方法比较适用于样本容量比较大的类域的分类,而那些样本容量较小的类域采用这种算法比较容易产生误分。

python实现最邻近算法案例:

这里我构造了一个150*5的矩阵,分别代表三类数据。每行的前四个值代表数据的特征,第五个值代表数据的类别。如图:

这三类数据分别属于apple、banana、orange

第一步:加载数据。以split参数传来的参数为限,将小于split的随机数对应的数据划分到训练集,将大于split的随机数划分到测试集

def loadDataset(self,filename, split, trainingSet, testSet): # 加载数据集 split以某个值为界限分类train和test

with open(filename, 'r') as csvfile:

lines = csv.reader(csvfile) #读取所有的行

dataset = list(lines) #转化成列表

for x in range(len(dataset)-1):

for y in range(4):

dataset[x][y] = float(dataset[x][y])

if random.random() < split: # 将所有数据加载到train和test中

trainingSet.append(dataset[x])

else:

testSet.append(dataset[x])

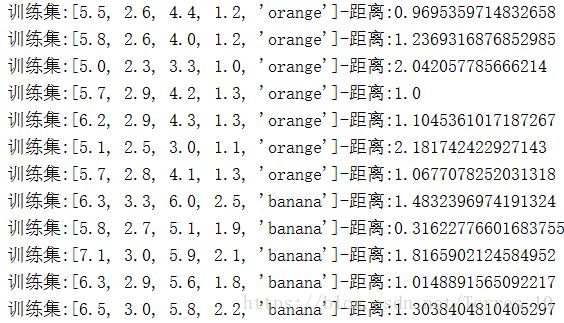

第二步:对每个测试集中的数据进行迭代,取其临近点。

计算测试集中每个点到训练集中每个点的距离,将这些距离按从小到大进行排序,取最近的k个点作为归类点

def getNeighbors(self,trainingSet, testInstance, k): # 返回最近的k个边距

distances = []

length = len(testInstance)-1

for x in range(len(trainingSet)): #对训练集的每一个数计算其到测试集的实际距离

dist = self.calculateDistance(testInstance, trainingSet[x], length)

print('{}--{}'.format(trainingSet[x], dist))

distances.append((trainingSet[x], dist))

distances.sort(key=operator.itemgetter(1)) # 把距离从小到大排列

neighbors = []

for x in range(k): #排序完成后取前k个距离

neighbors.append(distances[x][0])

return neighbors

计算距离函数

def calculateDistance(self,testdata, traindata, length): # 计算距离

distance = 0 # length表示维度 数据共有几维

for x in range(length):

distance += pow((testdata[x]-traindata[x]), 2)

return math.sqrt(distance)

length表示维度,这里数据是4维

第三步:判断那k个点所属的类别,选择出现频率最大的类标号作为测试集的类标号

def getResponse(self,neighbors): # 根据少数服从多数,决定归类到哪一类

classVotes = {}

for x in range(len(neighbors)):

response = neighbors[x][-1] # 统计每一个分类的多少

if response in classVotes:

classVotes[response] += 1

else:

classVotes[response] = 1

print(classVotes.items())

sortedVotes = sorted(classVotes.items(), key=operator.itemgetter(1), reverse=True) #reverse按降序的方式排列

return sortedVotes[0][0]

计算距离:

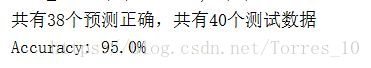

结果: