统计决策

先验概率 p(x)

条件概率p(x|w)

贝叶斯公式 p(w|x)=$\frac{p(x|w)*p(w)}{p(x)}$

决策规则(最小错误率贝叶斯决策):p(w1|x)>p(w2|x), 为w1;反之,为w2。

求最小错误率分界点:p(x|w1)*p(w1)=p(x|w2)*p(w2), 解得x=t,t为分界点。

最小风险贝叶斯决策:

条件风险:R(a1|x)=$\lambda11*p(w1|x)+\lambda12*p(w2|x)$

$\lambda12$表示类别为2,判别为1的损失;R(a1|x)为判决为1的条件风险。

接收机特性曲线(ROC曲线):

击中率+虚警率>=1;

x*为判决边界。x

当存在外部脉冲但是x

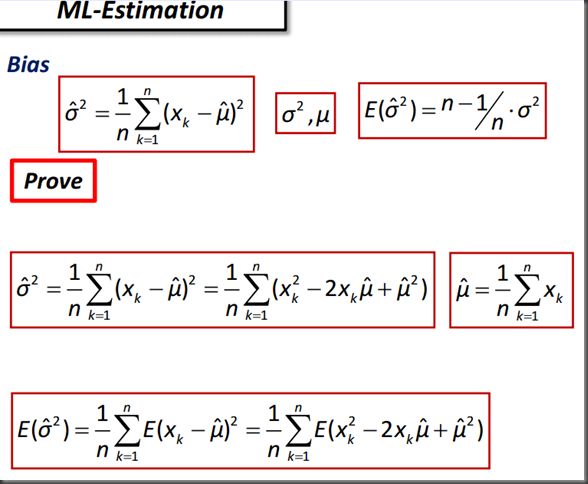

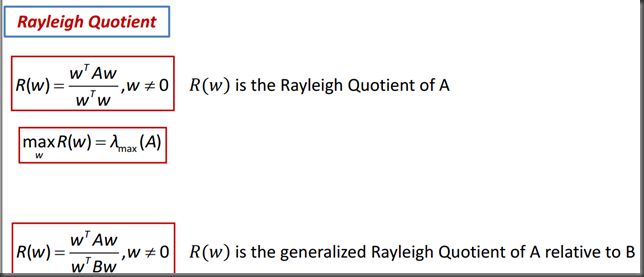

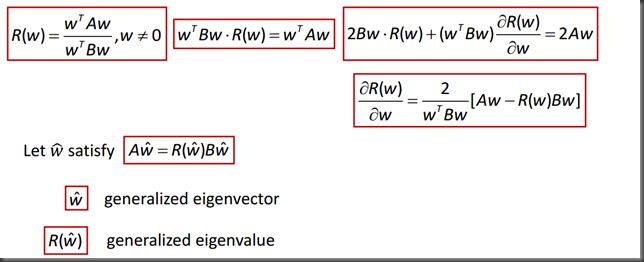

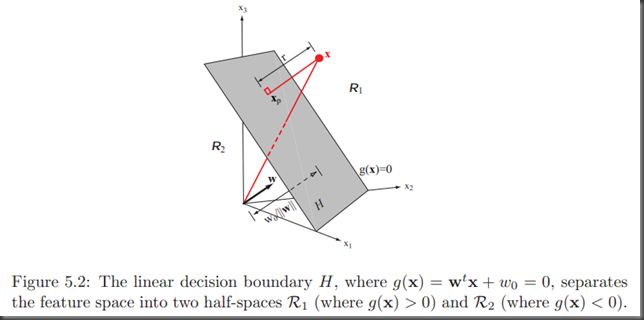

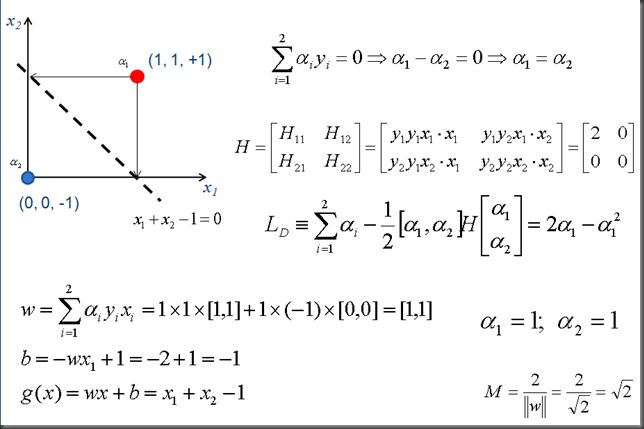

当不存在外部脉冲但是x>x*,则虚警(false alarm),若x 击中率(灵敏度):tp/(tp+fn) 虚警率(假阳性):fp/(tn+fp) ROC曲线为击中率和虚警率随x*在坐标上移动的变化。 当x*为最小可能值时,所有样本都呈阳性,此时坐标为(1,1);当x*为最大可能值时,所有样本阴性,坐标(0,0); 当接收机为理想的,即无脉冲和有脉冲同为冲激且没有重叠,击中率始终为1,虚警率始终为0. 极小极大准则: $R_{minimax}=\lambda22+(\lambda12-\lambda22)\int_{R1}{p(x|w2)}dx=\lambda12\int_{R1}{p(x|w2)}dx$ 第二类判为第一类,对第一类区间积分,再乘以条件风险 $=\lambda11+(\lambda21-\lambda11)\int_{R2}{p(x|w1)}dx=\lambda21\int_{R2}{p(x|w1)}dx$ PCA: 计算x所有样本的协方差矩阵,求其特征向量作为方差最小投影方向。 $\Sigma u_{i}=\lambda u_{i}$ $u_{i}^{T}x为x在u_{i}方向的投影。$ 依次选取特征值最大的主方向,U=[u1 u2 … (后面可以取零,起到降维的作用)],$U^{T}x为$投影后数据。 白化:对PCA所得的特征值进行归一。特征值向量为h=[$\lambda1\space \lambda2…$],U*=$Uh^{-1/2}$,新的协方差矩阵为$U*^{T}\Sigma U*=I$. 贝叶斯置信网:看作业 最大似然估计:已知分布,根据样本求分布函数的参数,使样本概率最大。通常取对数求导,使导数为0。高斯方差最大似然估计有偏。 贝叶斯估计:根据贝叶斯定理,根据训练样本求测试样本概率,模型参数是隐含的,已经包含在条件分布的积分里了。难点是积分。通过选择合适的先验分布,如指数分布族,使积分容易求得。 PCA: 计算x所有样本的协方差矩阵,求其特征向量作为方差最小投影方向。 $\Sigma u_{i}=\lambda u_{i}$ $u_{i}^{T}x为x在u_{i}方向的投影。$ 依次选取特征值最大的主方向,U=[u1 u2 … (后面可以取零,起到降维的作用)],$U^{T}x为$投影后数据。参考PCA程序,后续》》》 白化:对PCA所得的特征值进行归一。特征值向量为h=[$\lambda1\space \lambda2…$],U*=$Uh^{-1/2}$,新的协方差矩阵为$U*^{T}\Sigma U*=I$. LDA(Fisher Linear Discriminant Analysis):将数据降到一维,同时具有最大的区分度。 类内散度矩阵:$Si=\Sigma(x-mi)(x-mi)^T, Sw=S1+S2(总类内散布矩阵)$ 类间散度矩阵:$S_{B}=(m1-m2)(m1-m2)^T (总类间散布矩阵,秩小于等于1)$ 准则函数:$J(w)=\frac{w^tS_{B}w}{w^tS_{w}w}$ 最大化准则函数时,$S_{B}w=\lambda S_{w}w$ ,而$S_{B}w总在m1-m2方向上$,$w=S_{w}^{-1}(m1-m2)$,此w即为使类间散布和类内散布的比值达到最大的线性函数。 KFD-Kernel Fisher’s Discriminant x=$\phi (x)$ 曼哈顿距离:马氏距离(Mahalanobis distance)表示数据的协方差距离。它是一种有效的计算两个未知样本集的相似度的方法。与欧氏距离不同的是它考虑到各种特性之间的联系(例如:一条关于身高的信息会带来一条关于体重的信息,因为两者是有关联的)并且是尺度无关的(scale-invariant),即独立于测量尺度。对于一个均值为μ,协方差矩阵为Σ的多变量向量,其马氏距离为(x-μ)'Σ^(-1)(x-μ)。马氏距离也可以定义为两个服从同一分布并且其协方差矩阵为Σ的随机变量与的差异程度。 For identity matrix S: For diagonal matrix S: 3. 非参数估计和隐马尔可夫模型 1. 线性分类器基本概念 判别函数:由x的各分量的线性组合而成的函数。$g( x)=w^tx+w0$,g( x)>0,判定w1;g(x)<0,判定w2;g( x)=0为判定面。 若g( x)为线性,判定面为超平面,比特征空间少一个维度。(a point is a hyper plane in 1-dimensional space, a line is a hyperplane in 2-dimensional space, and a plane is a hyperplane in 3-dimensional space. A line in 3-dimensional space is not a hyperplane, and does not separate the space into two parts (the complement of such a line is connected).) $x=x_{p}+r\frac{w}{||w||}$,r为代数距离(algebraic distance) $g(x)=w^Tx+w0,x_{p}在超平面上,w^Tx_{p}+w0=0, 所以g(x )=r\frac{w^Tw}{||w||}=r||w||$,r有符号。 多类情况:P179。。。。 广义线性判别函数:对x的各分量进行非线形组合,映射到高维空间。 增广特征向量a=[w0;w],使新的判定面经过原点,而且简化问题为求解一个权向量a。 梯度下降:更新规则$a(k+1)=a( k)-\eta(k )\nabla J(a(k ))$ 牛顿下降:更新规则$a(k+1)=a( k)-H^{-1}\nabla J(a(k ))$ 感知机:$J( a)=\Sigma _{y\in M} {-a^ty}$,其中M(a)为被a错分的样本集。 $\nabla J(a )=\Sigma_{y \in M}{-y}$,迭代公式$a(k+1)=a( k)+\eta ( k) \Sigma_{y \in M}{y}$ 2. 最优超平面与支持向量机 超平面:wx+b=0 到超平面距离: g(x)=wx+b, x’为样本到超平面上投影 间隔M=||x-x’||=||$\lambda w$||=|g(x )|/||w||. 因为w和b可以按任意比例放缩,所以可以令g(x)=1。正样本与负样本间隔为M=2/||w||. 最大间隔就是使M最大,即让||w||最小,等价于$min\frac{1}{2}w^Tw$. 所有样本正确分类条件为: 所以为 $L(w,a)=\frac{1}{2}||w||^2-\sum\limits_{k=1}^n{a_k[y_k(wx_k +b)-1]}$ 对偶形式,仍为二次最优化问题。 KKT conditions: $L(x,\lambda)=f(x ) +\lambda g(x ) $ $g(x )\geq 0$ $\lambda \geq 0$ $\lambda g(x ) = 0$ example: Soft Margin 对比没有soft margin的形式, vc dimension: 维度数加1? kernel: $g(x)=\sum\limits_{i=1}^{l}{a_iy_iK(x_i,x)+b}$ SMO算法(序列最小优化算法): SVR: 3. 多类线性分类器 1.第一种情况:每一模式类与其它模式类间可用单个判别平面把一个类分开。这种情况,M类可有M个判别函数,且具有以下性质: 如果某个X使二个以上的判别函数 gi(x) >0 。则此模式X就无法作出确切的判决。 判别函数都为负值,为不确 定区域。 第二种情况: 每个模式类和其它模式类间可分别用判别平面分开,一个判别界面只能分开两个类别,不一定能把其余所有的类别分开。 这样有 M(M _ 1)/2个判别平面。 判别函数都为负值,为不确 定区域。 结论:判别区间增大,不确定区间减小,比第一种情况小的多。 第三种情况: 每类都有一个判别函数,存在M个判别函数。 就是说,要判别模式X属于那一类,先把X代入M个判别函数中,判别函数最大的那个类别就是X所属类别。类与 类之间的边界可由gi(x) =gj(x) 或gi(x) -gj(x) =0来确定。 结论:不确定区间没有了,所以这种是最好情况。 1. 近邻法 k近邻 knn(k取奇数): vThe algorithm procedure: §Given a set of n training data in the form of §Given an unknown sample x′. §Calculate the distance d(x′, xi) for i=1 … n. §Select the K samples with the shortest distances. §Assign x′ the label that dominates the K samples. v vIt is the simplest classifier you will ever meet (I mean it!). v vNo Training (literally) §A memory of the training data is maintained. §All computation is deferred until classification. § vProduces satisfactory results in many cases. §Should give it a go whenever possible. Properties of KNN Instance-Based Learning No explicit description of the target function Can handle complicated situations. Challenges of KNN vThe Value of K §Non-monotonous impact on accuracy §Too Big vs. Too Small §Rule of thumbs v vWeights §Different features may have different impact … v vDistance §There are many different ways to measure the distance. §Euclidean, Manhattan … v vComplexity §Need to calculate the distance between X′ and all training data. §In proportion to the size of the training data. KL变换 也是正交基,与pca不同在于pca是协方差矩阵的特征向量,kl变换是x*x'的特征向量。有监督时,k-l坐标系的产生矩阵相应改变。 mds多维尺度法 使用低维来表示高维样本间的相关关系。 1. 基于模型的方法 决定聚类算法好坏的因素 C-均值(C/K- means)聚类(Clustering) vDetermine the value of K. vChoose K cluster centres randomly. vEach data point is assigned to its closest centroid. vUse the mean of each cluster to update each centroid. vRepeat until no more new assignment. vReturn the K centroids. vPros §Simple and works well for regular disjoint clusters. §Converges relatively fast. §Relatively efficient and scalable O(t·k·n) •t: iteration; k: number of centroids; n: number of data points v vCons §Need to specify the value of K in advance. •Difficult and domain knowledge may help. §May converge to local optima. •In practice, try different initial centroids. §May be sensitive to noisy data and outliers. •Mean of data points … §Not suitable for clusters of •Non-convex shapes 核(Kernel)动态聚类 欧式距离只适用于样本分布为超球或接近超球状,即在各维特征上 的样本方差接近。 模糊(Fuzzy) C 均值聚类 Fuzzy c-means (FCM) is a method of clustering which allows one piece of data to belong to two or more clusters 谱(Spectral)聚类 谱聚类算法的物理解释和数学解释:由于特征矢量不相关,所以由特征矢量构成的训练空间中的点可分性 会改善。 Boosting方法是一种用来提高弱分类算法准确度的方法,这种方法通过构造一个预测函数系列,然后以一定的方式将他们组合成一个预测函数。他是一种框架算法,主要是通过对样本集的操作获得样本子集,然后用弱分类算法在样本子集上训练生成一系列的基分类器。他可以用来提高其他弱分类算法的识别率,也就是将其他的弱分类算法作为基分类算法放于Boosting 框架中,通过Boosting框架对训练样本集的操作,得到不同的训练样本子集,用该样本子集去训练生成基分类器;每得到一个样本集就用该基分类算法在该样本集上产生一个基分类器,这样在给定训练轮数 n 后,就可产生 n 个基分类器,然后Boosting框架算法将这 n个基分类器进行加权融合,产生一个最后的结果分类器,在这 n个基分类器中,每个单个的分类器的识别率不一定很高,但他们联合后的结果有很高的识别率,这样便提高了该弱分类算法的识别率。在产生单个的基分类器时可用相同的分类算法,也可用不同的分类算法,这些算法一般是不稳定的弱分类算法,如神经网络(BP) ,决策树(C4.5)等。 最后的强分类器是通过多个基分类器联合得到的,因此在最后联合时各个基分类器所起的作用对联合结果有很大的影响,因为不同基分类器的识别率不同,他的作用就应该不同,这里通过权值体现他的作用,因此识别率越高的基分类器权重越高,识别率越低的基分类器权重越低。

概率密度函数的估计

线性分类器

![]()

![]()

![]()

![]()

非线性分类器

1. 神经网络

2. 支持向量机

其它分类方法

2. 随机方法

3. 非度量方法

特征选择和特征提取

1. 特征选择

2. 特征提取

核分析方法

非监督模式识别

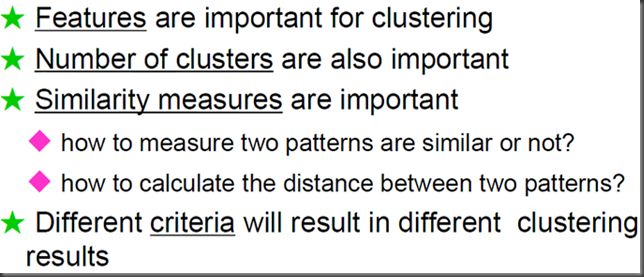

2. 聚类

独立于算法的机器学习(boosting)

模式识别系统的评价