ECCV 2020 论文大盘点-动作检测与识别篇

![]()

本文盘点 ECCV 2020 所有动作检测与识别(Action Detection and Recognition)相关论文,总计 26 篇。

包含动作识别(Action Recognition)、动作检测(Action Detection)、时序动作检测(Temporal Action Detection)、动作定位(Action Localization)、群组活动识别、基于骨架的动作识别等。

下载包含这些论文的 ECCV 2020 所有论文:

ECCV 2020 论文合集下载,分类盘点进行中

动作识别 Action Recognition

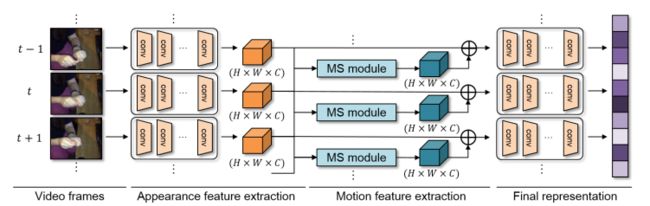

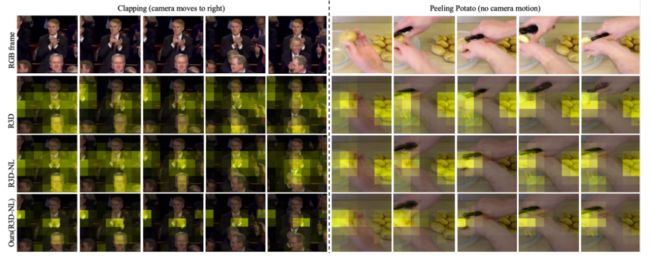

MotionSqueeze: Neural Motion Feature Learning for Video Understanding

作者 | Heeseung Kwon, Manjin Kim, Suha Kwak, Minsu Cho

单位 | 浦项科技大学;NPRC

论文 | https://arxiv.org/abs/2007.09933

代码 | https://github.com/arunos728/MotionSqueeze

主页 | http://cvlab.postech.ac.kr/research/MotionSqueeze/

备注 | ECCV2020

Few-shot Action Recognition with Permutation-invariant Attention

作者 | Hongguang Zhang, Li Zhang, Xiaojuan Qi, Hongdong Li, Philip H. S. Torr, Piotr Koniusz

单位 | 澳大利亚国立大学;牛津大学;Data61/CSIRO;香港大学等

论文 | https://arxiv.org/abs/2001.03905

备注 | ECCV 2020 Spotlight

本文作者提出了一种新的少样本动作识别网络(ARN),由一个编码器、比较器和一个注意机制组成,来模拟短期和长期时空模式。作者研究了自监督的作用,通过空间和时间增强/辅助任务。

此外,作者还提出了一种新的机制:attention by alignment ,解决了所谓的判别性长期块的时间位置的分布迁移问题。

通过结合 self-supervision(自监督) 和 attention by alignment 的损失,得到高达6%的准确性的收益。

Directional Temporal Modeling for Action Recognition

作者 | Xinyu Li, Bing Shuai, Joseph Tighe

单位 | Amazon Web Service

论文 | https://arxiv.org/abs/2007.11040

备注 | ECCV 2020 Spotlight

Adversarial Self-Supervised Learning for Semi-Supervised 3D Action Recognition

作者 | Chenyang Si, Xuecheng Nie, Wei Wang, Liang Wang, Tieniu Tan, Jiashi Feng

单位 | 国科大;中科院;新加坡国立大学

论文 | https://arxiv.org/abs/2007.05934

备注 | ECCV 2020

本文提出了一种用于半监督式3D动作识别的对抗自监督学习(ASSL)框架,通过 adversarial learning(对抗学习)和 neighbor relation exploration ,将SSL和半监督方案紧密耦合。

提供了一种新的自监督策略:neighborhood consistency(邻域一致性),用于半监督的3D动作识别。通过探索邻域内的数据关系,该模型可以学习判别性的运动表示,显著提高半监督3D动作识别的性能。

作者表示,直接将SSL应用于半监督学习会受到标记和未标记样本的表示错位的影响。因此开创了一种新型的对抗式正则化,将SSL耦合到半监督算法中,使其特征分布对齐,从而进一步提升泛化能力。

AR-Net: Adaptive Frame Resolution for Efficient Action Recognition

作者 | Yue Meng, Chung-Ching Lin, Rameswar Panda, Prasanna Sattigeri, Leonid Karlinsky, Aude Oliva, Kate Saenko, Rogerio Feris

单位 | MIT-IBM Watson AI Lab;波士顿大学;麻省理工学院

论文 | https://arxiv.org/abs/2007.15796

代码 | https://github.com/mengyuest/AR-Net

主页 | https://mengyuest.github.io/AR-Net/

备注 | ECCV 2020

动作识别是计算机视觉中的一个开放性和挑战性问题。现有的最先进的模型已经实现了很好的识别效果,但其昂贵的计算代码限制了其许多现实应用。

本文中,提出一种新的方法:AR-Net(Adaptive Resolution Network),它可以根据输入条件为每一帧选择最佳的分辨率,以实现在长的未修剪视频中高效的动作识别。

具体来说,给定一个视频帧,使用策略网络来决定动作识别模型应该使用什么样的输入分辨率进行处理,目的是提高准确性和效率。使用标准的反向传播有效地训练了策略网络与识别模型的联合。

在几个具有挑战性的动作识别基准数据集上的广泛实验很好地证明了提出的方法比最先进的方法更有效。

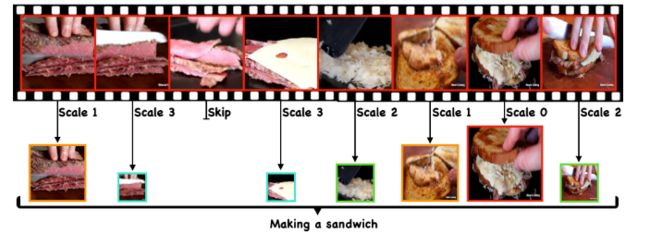

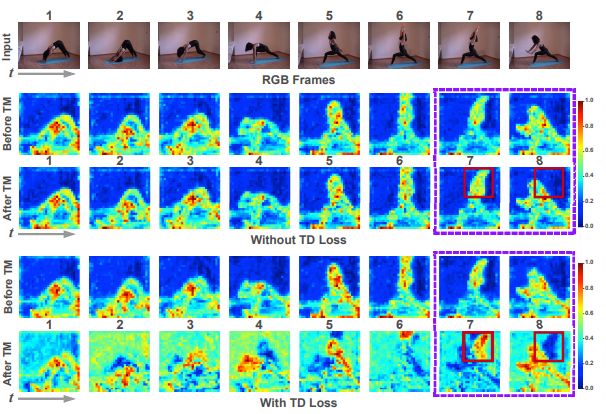

Temporal Distinct Representation Learning for Action Recognition

作者 | Junwu Weng, Donghao Luo, Yabiao Wang, Ying Tai, Chengjie Wang, Jilin Li, Feiyue Huang, Xudong Jiang, Junsong Yuan

单位 | 腾讯AI;腾讯优图;南洋理工大学;纽约州立大学

论文 | https://arxiv.org/abs/2007.07626

备注 | ECCV 2020

本文提出渐进式增强模块,用于 channel-level 信息滤波,有效地激发了不同帧的鉴别通道,同时避免了重复信息提取。

另外,提出一个时序多样性损失来训练网络。该损失可以校准卷积核,从而使网络可以专注于并捕捉帧之间的变化。也提高了识别精度,且不增加额外的网络复杂性。

RubiksNet: Learnable 3D-Shift for Efficient Video Action Recognition

作者 | Linxi Fan, Shyamal Buch, Guanzhi Wang, Ryan Cao, Yuke Zhu, Juan Carlos Niebles, Li Fei-Fei

单位 | SVL;德州大学奥斯汀分校;英伟达

论文 | https://www.ecva.net/papers/eccv_2020/

papers_ECCV/papers/123640494.pdf

代码 | https://github.com/StanfordVL/rubiksnet

备注 | ECCV 2020

本文作者提出RubiksNet,一种新型的高效的视频动作识别架构,基于提出的可学习的3D时空移位操作(RubiksShift),效果与先前工作相当或更好,参数减少了2.9 - 5.9倍,FLOP减少了2.1 - 3.7倍。

DDGCN: A Dynamic Directed Graph Convolutional Network for Action Recognition

作者 | Matthew Korban, Xin Li

单位 | 路易斯安那州立大学

论文 | https://www.ecva.net/papers/eccv_2020/

papers_ECCV/papers/123650749.pdf

备注 | ECCV 2020

本文作者提出一种动态定向图卷积网络(DDGCN),从人类行动的骨骼表征中对其空间和时间特征进行建模。

DDGCN由三个新的特征建模模块组成。

(1)动态卷积采样(DCS)。

(2)动态卷积权重(DCW)分配。

(3)定向图空间-时间(DGST)特征提取。

综合实验表明,DDGCN在各种测试数据集中的表现优于现有的最先进的动作识别方法。

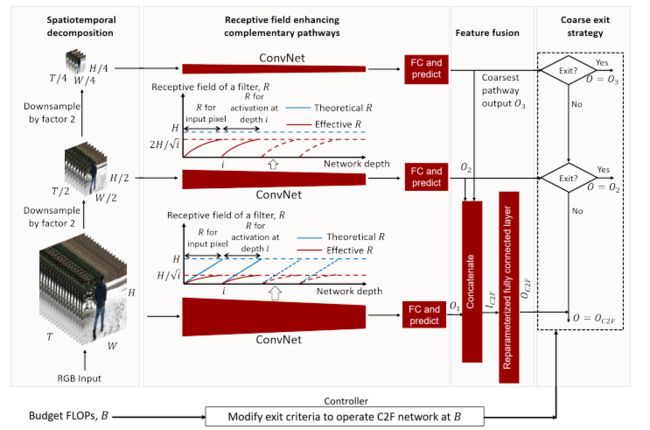

Towards Efficient Coarse-to-Fine Networks for Action and Gesture Recognition

作者 | Niamul Quader, Juwei Lu, Peng Dai, Wei Li

单位 | 华为诺亚方舟实验室

论文 | https://www.ecva.net/papers/eccv_2020/

papers_ECCV/papers/123750035.pdf

备注 | ECCV 2020

实现动作和手势识别的高效粗细网络

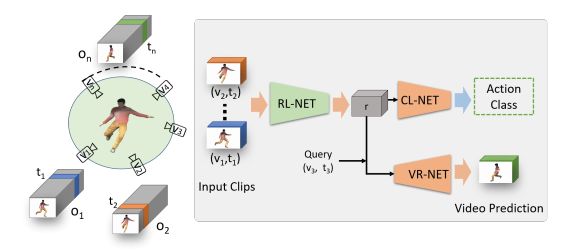

Multi-view Action Recognition using Cross-view Video Prediction

作者 | Shruti Vyas, Yogesh S Rawat, Mubarak Shah

单位 | 中佛罗里达大学

论文 | https://www.ecva.net/papers/eccv_2020/

papers_ECCV/papers/123720426.pdf

代码 | https://github.com/svyas23/cross-view-action

主页 | https://www.crcv.ucf.edu/research/projects/multi-view-action-recognition-using-cross-view-video-prediction/

备注 | ECCV 2020

框架将不同视角和时间的短视频片段作为输入,并学习一个整体的内部表示,用于预测未见视角和时间的视频片段。

时序动作检测 Temporal Action Detection

SF-Net: Single-Frame Supervision for Temporal Action Localization

作者 | Fan Ma, Linchao Zhu, Yi Yang, Shengxin Zha, Gourab Kundu, Matt Feiszli, Zheng Shou

单位 | 悉尼科技大学;Facebook

论文 | https://arxiv.org/abs/2003.06845

代码 | https://github.com/Flowerfan/SF-Net

备注 | ECCV 2020 Spotlight

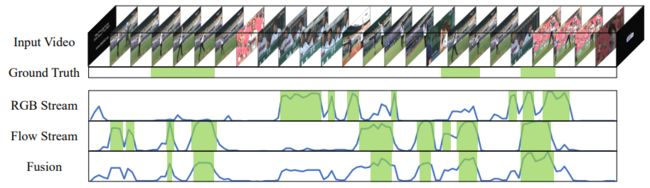

Two-Stream Consensus Network for Weakly-Supervised Temporal Action Localization

作者 | Yuanhao Zhai, Le Wang, Wei Tang, Qilin Zhang, Junsong Yuan, Gang Hua

单位 | 西安交通大学;伊利诺伊大学芝加哥分校;HERE Technologies等

论文 | https://www.ecva.net/papers/eccv_2020/

papers_ECCV/papers/123510035.pdf

备注 | ECCV 2020 Spotlight

弱监督时空动作定位(W-TAL)目的是仅在视频级监督下对未修剪视频中的所有动作实例进行分类和定位。但是,如果没有帧级标注,识别 false positive action proposals(假阳性动作proposals)和 generate action proposals(生成具有精确时间边界的动作 proposals)仍具有挑战性。

本文作者提出了一个W-TAL的双流共识网络(TSCN),所提出的TSCN的特点是采用迭代细化训练方法,对帧级 pseudo ground truth 进行迭代更新,并用于提供帧级监督,以改进模型训练和消除假阳性动作 proposals。

此外,还提出了一种新的注意力归一化损失,以鼓励预测的注意力像二元选择一样,并促进行动实例边界的精确定位。在THUMOS14和ActivityNet数据集上进行的实验表明,所提出的TSCN优于当前最先进的方法,甚至可以达到与最近一些完全监督方法相当的结果。

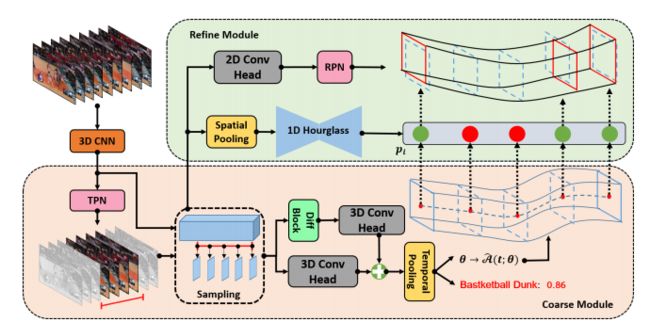

CFAD: Coarse-to-Fine Action Detector for Spatiotemporal Action Localization

作者 | Yuxi Li, Weiyao Lin, John See, Ning Xu, Shugong Xu, Ke Yan, Cong Yang 单位 | 上海交通大学;上海大学;多媒体大学;Adobe Research;Clobotics, China

论文 | https://arxiv.org/abs/2008.08332

备注 | ECCV 2020

所提出方法推理速度快 3.3倍

动作定位 Action Localization

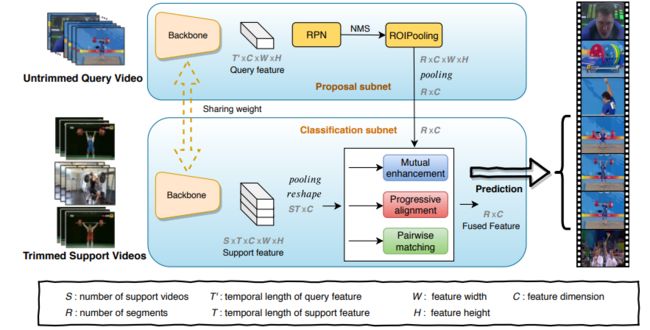

Localizing the Common Action Among a Few Videos

作者 | Pengwan Yang, Vincent Tao Hu, Pascal Mettes, Cees G. M. Snoek

单位 | 北大;阿姆斯特丹大学

论文 | https://arxiv.org/abs/2008.05826

代码 | https://github.com/PengWan-Yang/commonLocalization(404)

备注 | ECCV 2020

本文致力于在未修剪的长视频中定位动作的时间范围

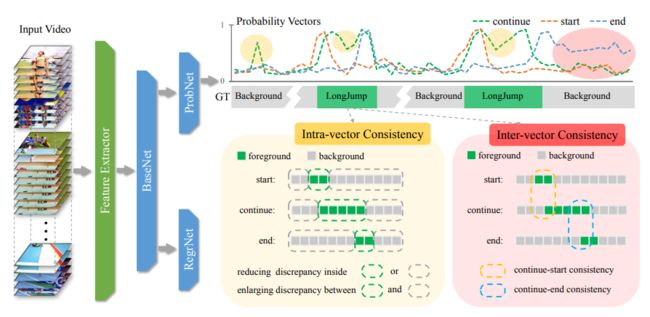

Bottom-Up Temporal Action Localization with Mutual Regularization

作者 | Peisen Zhao, Lingxi Xie, Chen Ju, Ya Zhang, Yanfeng Wang, Qi Tian

单位 | 上海交通大学;华为

论文 | https://arxiv.org/abs/2002.07358

代码 | https://github.com/PeisenZhao/Bottom-Up-TAL-with-MR

备注 | ECCV 2020

Weakly-Supervised Action Localization with Expectation-Maximization Multi-Instance Learning

作者 | Zhekun Luo, Devin Guillory, Baifeng Shi, Wei Ke, Fang Wan, Trevor Darrell, Huijuan Xu

单位 | 加州伯克利;北大;卡内基梅隆大学;中科院

论文 | https://arxiv.org/abs/2004.00163

代码 | https://github.com/airmachine/EM-MIL-WeaklyActionDetection(未开源)

备注 | ECCV 2020

动作检测 Action Detection

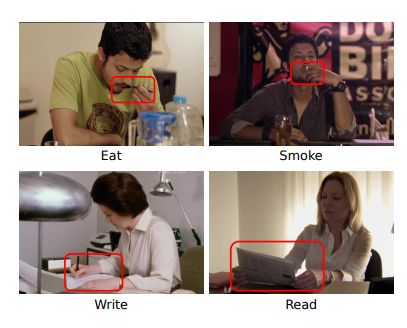

Uncertainty-Aware Weakly Supervised Action Detection from Untrimmed Videos

作者 | Anurag Arnab, Chen Sun, Arsha Nagrani, Cordelia Schmid

单位 | 谷歌

论文 | https://arxiv.org/abs/2007.10703

备注 | ECCV 2020

针对未裁剪的视频提出一种不确定性感知的弱监督动作检测算法。

动作检测--视频理解

Asynchronous Interaction Aggregation for Action Detection

作者 | Jiajun Tang, Jin Xia, Xinzhi Mu, Bo Pang, Cewu Lu

单位 | 上海交通大学

论文 | https://arxiv.org/abs/2004.07485

代码 | https://github.com/MVIG-SJTU/AlphAction

备注 | ECCV 2020

本文提出了异步交互聚合网络(AIA),利用不同的交互方式来提升动作检测。其中有两个关键的设计:一个是交互聚合结构(IA)采用统一的范式,对多种类型的交互进行建模和整合;另一个是异步内存更新算法(AMU),通过对非常长期的交互进行动态建模,可以在没有巨大计算成本的情况下实现更好的性能。

Context-Aware RCNN: A Baseline for Action Detection in Videos

作者 | Jianchao Wu, Zhanghui Kuang, Limin Wang, Wayne Zhang, Gangshan Wu

单位 | 南京大学;商汤

论文 | https://arxiv.org/abs/2007.09861

代码 | https://github.com/MCG-NJU/CRCNN-Action

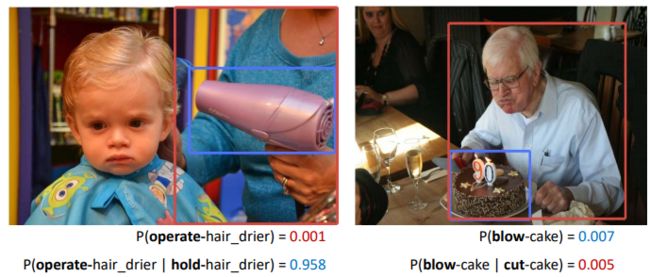

Detecting Human-Object Interactions with Action Co-occurrence Priors

作者 | Dong-Jin Kim, Xiao Sun, Jinsoo Choi, Stephen Lin, In So Kweon

单位 | 韩国科学技术院;微软

论文 | https://arxiv.org/abs/2007.08728

代码 | https://github.com/Dong-JinKim/ActionCooccurrencePriors/

备注 | ECCV 2020

基于骨架的动作识别 Skeleton-Based

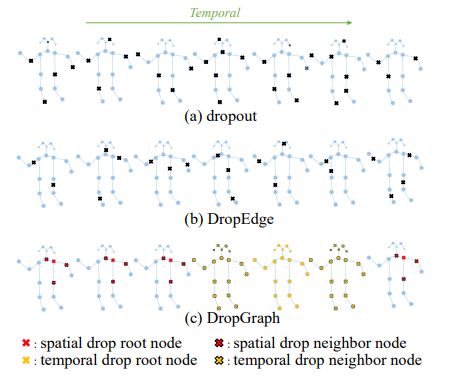

Decoupling GCN with DropGraph Module for Skeleton-Based Action Recognition

作者 | Ke Cheng, Yifan Zhang, Congqi Cao, Lei Shi, Jian Cheng, Hanqing Lu

单位 | 中科院;国科大等

论文 | https://www.ecva.net/papers/eccv_2020/

papers_ECCV/papers/123690528.pdf

代码 | https://github.com/kchengiva/DecoupleGCN-DropGraph

备注 | ECCV 2020

所提出方法提升了 spatial-temporal 图卷积网络性能,并且没有额外的 FLOPs,没有额外的延迟,没有额外的GPU内存成本。

时序动作分割

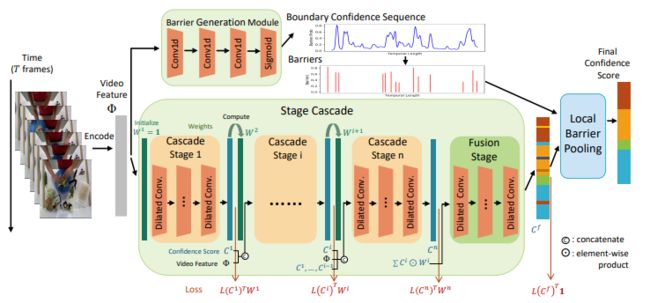

Boundary-Aware Cascade Networks for Temporal Action Segmentation

作者 | Zhenzhi Wang, Ziteng Gao, Limin Wang, Zhifeng Li, Gangshan Wu

单位 | 南京大学;腾讯

论文 | https://www.ecva.net/papers/eccv_2020/

papers_ECCV/papers/123700035.pdf

代码 | https://github.com/MCG-NJU/BCN

解读 | https://zhuanlan.zhihu.com/p/199403632

备注 | ECCV 2020

动作合成

A Recurrent Transformer Network for Novel View Action Synthesis

作者 | Kara Marie Schatz, Erik Quintanilla, Shruti Vyas, Yogesh S Rawat

单位 | 泽维尔大学;伊利诺伊理工大学;中佛罗里达大学

论文 | https://www.ecva.net/papers/eccv_2020/

papers_ECCV/papers/123720409.pdf

代码 | https://github.com/schatzkara/cross-view-video

备注 | ECCV 2020

从一个视角提供相同的动作时,所提出的方法可以从一个未知的视角合成一个动作视频。

时序动作提名生成 Temporal action proposal generation

Boundary Content Graph Neural Network for Temporal Action Proposal Generation

作者 | Yueran Bai, Yingying Wang, Yunhai Tong, Yang Yang, Qiyue Liu, Junhui Liu

单位 | 北大;爱奇艺

论文 | https://arxiv.org/abs/2008.01432

备注 | ECCV 2020

通过图神经网络对边界和内容预测之间的关系进行建模,生成更精确的时序边界和可靠的内容置信度分数。

行为估计 Action Assessment

An Asymmetric Modeling for Action Assessment

作者 | Jibin Gao, Wei-Shi Zheng, Jia-Hui Pan, Chengying Gao, Yaowei Wang, Wei Zeng, Jianhuang Lai

单位 | 中山大学;北大;鹏城实验室;琶洲实验室等

论文 | https://www.ecva.net/papers/eccv_2020/

papers_ECCV/papers/123750222.pdf

代码 | https://www.isee-ai.cn/~gaojibin/ProjectAIM.html

备注 | ECCV2020

群组活动识别

Joint Learning of Social Groups, Individuals Action and Sub-group Activities in Videos

作者 | Mahsa Ehsanpour, Alireza Abedin, Fatemeh Saleh, Javen Shi, Ian Reid, Hamid Rezatofighi

单位 | 阿德莱德大学;澳大利亚国立大学等

论文 | https://arxiv.org/abs/2007.02632

代码 | https://github.com/mahsaep/Social-human-activity-understanding-and-grouping

备注 | ECCV 2020

针对社交任务提出一个端到端可训练框架,提出的方法还在传统群体活动识别任务的两个广泛采用的基准上设定了最先进的结果(假设场景中的个体形成一个单一的群体,并为场景预测一个单一的群体活动标签)。在现有的群体活动数据集上引入了新的标注,将其重新用于社交任务。

推荐阅读:

CVPR 2020 论文大盘点-动作检测与动作分割篇

本文为我爱计算机视觉公众号整理,转载请注明出处。

![]()

备注:动作

![]()

人体动作检测与识别交流群

动作识别、动作检测等技术,

若已为CV君其他账号好友请直接私信。

我爱计算机视觉

微信号:aicvml

QQ群:805388940

微博知乎:@我爱计算机视觉

网站:www.52cv.net

![]()

在看,让更多人看到 ![]()