论文笔记:ALA loss:Adaptive Logit Adjustment Loss for Long-Tailed Visual Recognition

论文地址:https://arxiv.org/abs/2104.06094

论文源代码地址:暂无

文章目录

-

- 1、动机

- 2、改进

-

- 2.1 CE Loss(交叉熵损失)

- 2.2 LDAM Loss

- 2.3、 ALA Loss

-

- 2.3.1 DF因子

- 2.3.2QF因子

- 2.3.3 最终表达形式

- 3、优势

- 4、性能对比

- 5、消融实验

-

- 5.1 定量分析

- 5.2 定性分析

- 6、参考文献:

作者在

CE、LDAM的基础进行改进,提出使用Difficulty Factor(难度因子)和Quantity Factor(数量因子)达到在不需要过多的牺牲头部类的性能的前提下提升尾部类的性能的目的。

1、动机

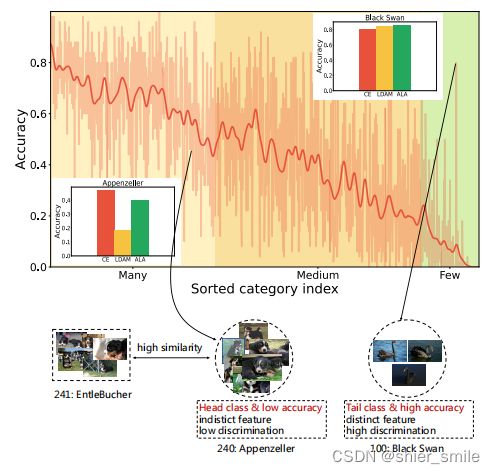

作者通过对ImageNet-LT数据进行分析,发现并不是样本多得类分类效果就越好,样本少的类分类效果就越差。

比如对于头部类中的Appenzeller(阿彭策尔山犬)和EntleBucher(恩特布赫山犬)这两个类别特征很相似虽然样本多,但是分类精度并不高,而对于

尾部类中的Black Swan(黑天鹅)虽然样本少,但是因为其特征比较突出/明显如(黑色的羽毛, 细长的脖子, 红色的喙)比较容易区分,分类精度高。

除了样本数量这一原因之外,还存在样本分类难易程度这一重要因素

2、改进

作者在CE和LDAM的基础上进行了改进。

2.1 CE Loss(交叉熵损失)

其中:

- x x x: 输入样本。

- y ∈ 1 , 2 , ⋅ ⋅ ⋅ , C y∈ {1, 2, · · · , C} y∈1,2,⋅⋅⋅,C:目标类。

- f θ ( x ) [ y ] f_\theta(x)[y] fθ(x)[y]: 网络输出的y类别的概率

- σ C E ( y , f θ ( x ) ) σCE(y, f_\theta(x)) σCE(y,fθ(x)):分类器输出的类别概率

2.2 LDAM Loss

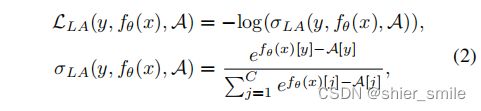

论文《Learning imbalanced datasets with label-distribution-aware margin loss》(地址:https://arxiv.org/pdf/1906.07413)中提出对于长尾分布中类别样本不同的情况,使用样本数量来修正CE。具体公式为:

其中A是每一个类别的修正量,只与样本数量有关。对修正过的![]()

求偏导可得:

对于修正量A, 原论文中证明:

令: f θ ( x ) [ y h ] 为一个头部类(样本数量多的类)的 l o g i t 值, f θ ( x ) [ y t ] 为一个尾部类(样本数量少的类)的 l o g i t 值,且 f θ ( x ) [ y h ] = f θ ( x ) [ y t ] 而 A [ y h ] < A [ y t ] 可得: σ L A ( y h , f θ ( x ) , A ) > σ L A ( y t , f θ ( x ) , A ) , 又因为: σ L A ( y , f θ ( x ) [ y ] , A ) − 1 < 0 , 所以 : ∣ α L L A α f θ ( x ) ∣ y h < ∣ α L L A α f θ ( x ) ∣ y t 令:f_θ(x)[y_h]为一个头部类(样本数量多的类)的logit值,f_θ(x)[y_t]为一个尾部类(样本数量少的类)的logit值,且 \\ f_θ(x)[y_h] = f_θ(x)[y_t] \\ 而A[y_h] < A[y_t]\\ 可得:σ_LA(y_h, f_θ(x), A)>σ_LA(y_t, f_θ(x), A),又因为:σ_LA(y, f_θ(x)[y], A) − 1 < 0,所以:\\ \vert\dfrac{\alpha L_{LA}}{\alpha f_θ(x)}\vert_{y_h}<\vert\dfrac{\alpha L_{LA}}{\alpha f_θ(x)}\vert_{y_t} 令:fθ(x)[yh]为一个头部类(样本数量多的类)的logit值,fθ(x)[yt]为一个尾部类(样本数量少的类)的logit值,且fθ(x)[yh]=fθ(x)[yt]而A[yh]<A[yt]可得:σLA(yh,fθ(x),A)>σLA(yt,fθ(x),A),又因为:σLA(y,fθ(x)[y],A)−1<0,所以:∣αfθ(x)αLLA∣yh<∣αfθ(x)αLLA∣yt

在迭代过程中头部类的梯度要小于尾部类的梯度,从而让模型更加注重与尾部类的表现。

2.3、 ALA Loss

作者认为传统的CE和LDAM只考虑了类别之间数量上差异,而没有考虑在类别之间的分类的难易程度,对于尾部类中容易分类的实例存在过优化现象,而对于头部类中难以分类的实例存在欠优化现象,因此在CE和LDAM的基础上提出了ALA loss,添加难度因子DF和数量因子QF。调整网络在注重尾部类的同时,增强其在难样本分类上的性能。将修正量A改为:

2.3.1 DF因子

DF因子用来使模型更加注重于难以分类实例。作者指出最终概率和模型输出的logit值都可以用来描述DF因子,作者选择使用模型输出的logit值,理由是:

-

相较于logit值,最终概率经过了softmax计算。这使得最终概率比logit值更加尖锐。

-

预测的logit和原始的logit具有相同的形式,更加具有连惯性和一致性。

为了解决神经网络输出的值具有无界性这一问题,作者参照LDAM,通过权重归一化和特征归一化将 f θ ( x ) f_\theta(x) fθ(x)放缩到[-1, 1]之间。

其中:

-

x i x_i xi表示第i个样本

-

W j W_j Wj第j个类别的权重向量

-

θ i j \theta_{ij} θij表示 x i x_i xi样本到j类别中心的夹角

而DF最终被定义为:

其中 θ i y θ_{iy} θiy表示 x i x_i xi到其目标类别中心y的角度,对于容易分类的样本 θ i y θ_{iy} θiy小,DF越小,对于难以分类的样本 θ i y θ_{iy} θiy大,DF越大。增加模型对于难分类样本的回归。

2.3.2QF因子

QF因子增加模型对于尾部类的注意。作者提出使用:

并与LDAM中使用的 1 x n \frac{1}{x^n} xn1进行了比较。

对于样本数量少的情况,QF显然比LDAM具有更强的修正能力。

2.3.3 最终表达形式

ALA Loss:

fllow LDAM,ALA Loss也只对目标logit进行了修正。对于 i ≠ j i\neq j i=j情况 A [ j ] = 0 A[j]=0 A[j]=0。不进行修正。

3、优势

- ALA loss更加全面和精细,其中的DF因子缓解了尾部易分类实例过优化和头部难分类实例欠优化现象,QF因子虽然设计原理和之前的LDAM相同,但经过重新设计使其能在尾部类上进行更大的修正。

- ALA loss是自适应的,ALA loss能给予更大的正则化来自适应的关注当前表现不佳的实例,更加合理、有效。

4、性能对比

这部分就不说了,直接看表格

5、消融实验

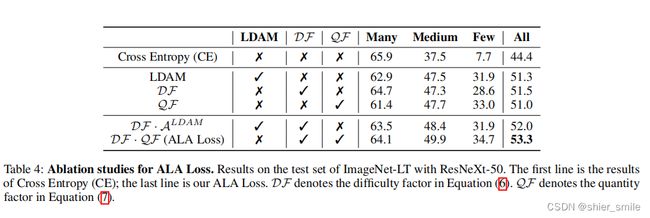

作者从对DF因子和QF因子分别进行了定量分析和定性分析

5.1 定量分析

作者在ResNeXt-50网络上进行实验,证明DF因子在头部类中分类难实例上的提升是有效的,QF因子在尾部类上比LDAM更有效。

5.2 定性分析

作者将预测概率<0.2定为难样本,>0.8定为易样本,可以发现在样本数量少时(如图3-c),LDAM和ALA在所有样本上都比CE有效,在数量多时(如图3-a),ALA比LDAM的难样本更少。

6、参考文献:

《Adaptive Logit Adjustment Loss for Long-Tailed Visual Recognition》

如有错误请即使指出,非常感谢!

本帖写于2022年8月2号, 未经本人同意,不得转载。