NLP-生成模型-2019:TransformerXL【对Vanilla Transformer的改进:片段级递归机制、相对位置编码】【超出固定长度上下文的注意力语言模型】

《原始论文:Transformer-XL: Attentive Language Models Beyond a Fixed-Length Context》

一、概述

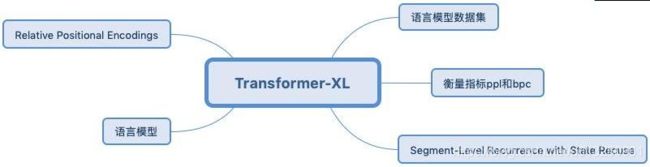

一句话简介:Transformer-XL架构在vanilla Transformer的基础上引入了两点创新:循环机制(Recurrence Mechanism)和相对位置编码(Relative Positional Encoding),以克服vanilla Transformer的长距离获取弱的缺点。

要正确理解一篇文章,有时需要参考出现在几千个单词前面的一个单词或一个句子。这是一个长期依赖性(long-range dependence)的例子,这是序列数据中常见的现象,处理许多现实世界的任务都必须理解这种依赖。

虽然人类很自然地就会这样做,但是用神经网络建模长期依赖关系仍然很具挑战性。

基于Gating的RNN和梯度裁剪(gradient clipping)技术提高了对长期依赖关性建模的能力,但仍不足以完全解决这个问题。

应对这个挑战的一种方法是使用Transformers,它允许数据单元之间直接连接,能够更好地捕获长期依赖关系。

Transformer 是谷歌在 17 年做机器翻译任务的 “Attention is all you need” 论文中提出的,引起了相当大的反响,业内有“每一位从事 NLP 研发的同仁都应该透彻搞明白 Transformer”的说法。

1、Transformer结构特点:

- 全部用self-attention的自注意力机制。

- 在self-attention的基础上改进了Multi-Attention和Mask Multi-Attention两种多头注意力机制。

- 网络由多个层组成,每个层都由多头注意力机制和前馈网络构成。

- 由于在全局进行注意力机制的计算,忽略了序列中最重要的位置信息,添加了位置编码(Position Encoding),使用正弦函数完成,为每个部分的位置生成位置向量。

Transformer模型在输入时采用的是固定长度序列输入,且Transformer模型的时间复杂度和句子/序列长度的平方成正比(每一层的复杂度: O ( n 2 ⋅ d ) O(n^2·d) O(n2⋅d), n n n 为句子/序列长度, d d d 为词向量维度),因此一般序列长度都限制在最大512,因为太大的长度,模型训练的时间消耗太大。

此外Transformer模型又不像RNN这种结构,可以将最后时间输出的隐层向量作为整个序列的表示,然后作为下一序列的初始化输入。所以用Transformer训练语言模型时,不同的序列之间是没有联系的,因此这样的Transformer在长距离依赖的捕获能力是不够的,此外在处理长文本的时候,若是将文本分为多个固定长度的片段,对于连续的文本,这无异于将文本的整体性破坏了,导致了文本的碎片化,这也是Transformer-XL被提出的原因。

2、Vanilla Transformer

Transformer 作为一种特征提取器,在NLP中有广泛的应用。但是 Transformer 需要对输入序列设置一个固定的长度,比如在BERT中,默认长度是512。如果文本序列长度短于固定长度,可以通过填充的方式来解决。如果序列长度超过固定长度,处理起来就比较麻烦。

一种处理方式,就是将文本划分为多个segments。

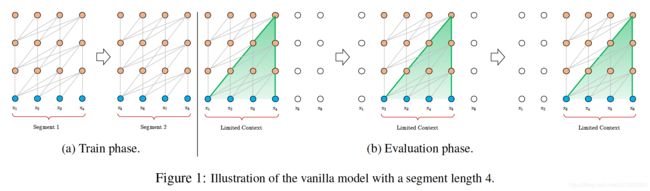

- 训练的时候,对每个segment单独处理,segments之间没有联系,如下图(a)所示。

- 在预测的时候,会对固定长度的segment做计算,一般取最后一个位置的隐向量作为输出。为了充分利用上下文关系,在每做完一次预测之后,就对整个序列向右移动一个位置,再做一次计算,如下图(b)所示,这导致计算效率非常低。

- 上下文长度受限:字符之间的最大依赖距离受输入长度的限制,模型看不到出现在几个句子之前的单词。

- 上下文碎片:对于长度超过512个字符的文本,都是从头开始单独训练的。段与段之间没有上下文依赖性,会让训练效率低下,也会影响模型的性能。

- 推理速度慢:在测试阶段,每次预测下一个单词,都需要重新构建一遍上下文,并从头开始计算,这样的计算速度非常慢。

- Vallina model不同segement对应的相同的位置如果采用同样的 positonal encoding就会导致难以区分。

- Vallina model在预测的时候每次都只能预测一个postion 的概率,这样预测的效率低下。

在语言建模中,Transformers目前使用固定长度的上下文来实现,即将一个长的文本序列截断为几百个字符的固定长度片段,然后分别处理每个片段。

如下图所示,VanillaTransformer模型在训练时具有固定长度上下文:

这造成了两个关键的限制:

- 算法无法建模超过固定长度的依赖关系。

- 被分割的片段通常不考虑句子边界,导致上下文碎片化,从而导致优化低效。即使是对于长期依赖性不显著的较短序列,这也是特别麻烦的。

为了解决这些限制,谷歌提出一个新的架构:Transformer-XL,它使自然语言的理解超出了固定长度的上下文。Transformer-XL是基于Vanilla Transformer这个模型进行的改进。

3、TransformerXL的历史意义

Transformer-xl采用了片段级递归机制,从而提高了语言模型的长距离依赖,对长文本的编码更加有效。 Transformer-xl在文本生成任务上具有不错的效果。

- Transformer在获取长度依赖上受制于固定长度,本文提出了Transformer-xl模型能解决该问题。

- Transformer-xl模型提出了片段级递归机制 和 相对位置编码,并且能够解决片段之间联系丢失的问题。

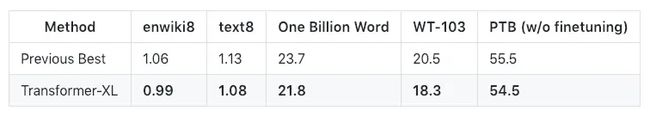

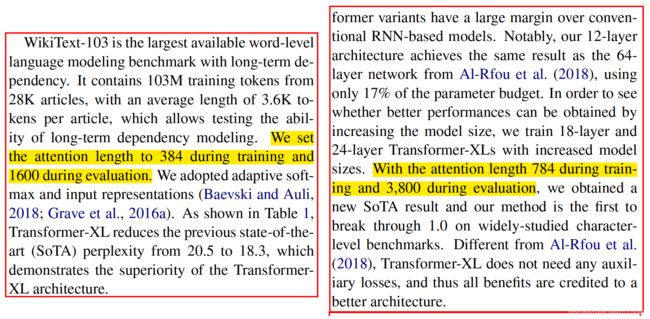

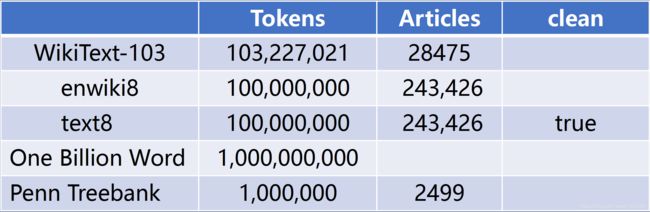

- Transformer-xl模型在学习长度依赖的问题上比rnn要长80%、比vallina transformer要长450%,和start-of-the-art的bpc/ppl结果相比,在enwiki8上的结果0.99、在text8上的结果为1.08、在WikiText-103上的结果为18.3、在one-billion上的结果为21.8、在Penn Treebank上的结果为54.5。

Transformer-XL在各种主要的语言建模(LM)基准测试中获得新的最优(SoTA)结果,包括长序列和短序列上的字符级和单词级任务。实验证明, Transformer-XL 有以下优势:

- Transformer-XL学习的依赖关系比RNN长约80%,比vanilla Transformers模型长450%,尽管后者在性能上比RNN好,但由于固定长度上下文的限制,对于建模长期依赖关系并不是最好的。

- 由于不需要重复计算,Transformer-XL在语言建模任务的评估期间比vanilla Transformer快1800+倍。

- 由于建模长期依赖关系的能力,Transformer-XL在长序列上具有更好的困惑度(Perplexity, 预测样本方面更准确),并且通过解决上下文碎片化问题,在短序列上也具有更好的性能。

- Transformer-XL在5个数据集上的结果如下:

- Transformer-xl模型预测时的Attention的长度可以和训练时的长度不一样;比如训练时设置为384,预测时设置为1600,这样预测的速度会更快;

二、TransformerXL结构解析

Transformer-XL架构在vanilla Transformer的基础上引入了两点创新来克服vanilla Transformer的缺点。:

- 片段级递归机制(Segment-Level Recurrence Mechanism);

- 相对位置编码(Relative Positional Encoding);

与vanilla Transformer相比,Transformer-XL的另一个优势是它可以被用于单词级和字符级的语言建模。

| VanillaTransformer模型在训练时具有固定长度上下文 | TransformerXL训练阶段为新段前面的token提供了必要的上下文 |

|---|---|

|

|

当这两种方法结合使用时,在评估时, Transformer-XL比vanilla Transformer模型具有更长的有效上下文。

| 在评估期间具有固定长度上下文的vanilla Transformer | 在评估期间具有segment-level 递归的Transformer-XL |

|---|---|

|

|

| 移动步长为1个token | 移动步长为一个segment |

1、Segment 循环机制

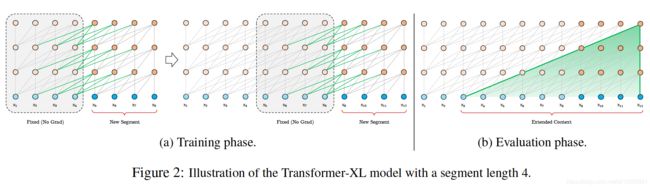

与vanilla Transformer的基本思路一样,Transformer-XL仍然是使用分段的方式进行建模,但其与vanilla Transformer的本质不同是在于引入了段与段之间的循环机制,使得当前段在建模的时候能够利用之前段的信息来实现长期依赖性。如下图所示:

在训练期间,为前一个 Segment 计算的 Representation 被修复并缓存,以便在模型处理下一个新的 Segment 时作为扩展上下文重新利用。这个额外的连接将最大可能依赖关系长度增加了N倍(N个Segment的长度),其中N表示网络的深度,因为上下文信息现在可以跨片段边界流动。

在训练阶段,处理后面的段时,每个隐藏层都会接收两个输入:

- 该段的前面隐藏层的输出,与vanilla Transformer相同(上图的灰色线)。

- 前面段的隐藏层的输出(上图的绿色线),可以使模型创建长期依赖关系。

此外,这种递归机制还解决了上下文碎片问题,为新段前面的token提供了必要的上下文。

RNN 的语言模型的 Recurrence Dependency在同一层layer之间,而TransformerXL可以在不同layer之间,因此 Depency Length为 O ( N × L ) O(N×L) O(N×L)

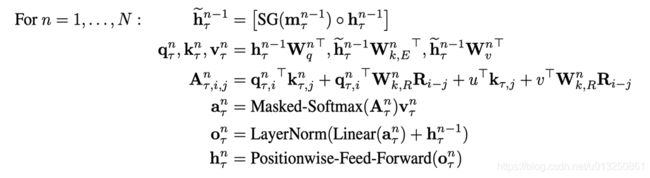

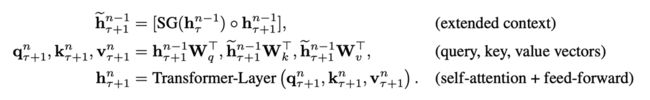

这两个输入会被拼接,然后用于计算当前段的Key和Value矩阵。对于某个段的某一层的具体计算公式如下:

- 第一个式子:

- τ τ τ 表示上一片段, τ + 1 τ+1 τ+1 表示下一片段。

- 将上一片段的输出缓存起来,然后直接和下一片段的隐层拼接在一起,得到上面的第一个式子。

- 在这里SG()的含义是stop-gradient。当进行到 τ + 1 τ+1 τ+1 时间步时,不再对 τ τ τ Segment的梯度再次计算,因为在 τ τ τ 时刻已经计算过了;

- 第二个式子

- 计算Query的时候只是用本segment的信息 h τ + 1 n − 1 h_{\tau+1}^{n-1} hτ+1n−1,而计算Key和Value的时候用的是 h ~ τ + 1 n − 1 \tilde{h}_{\tau+1}^{n-1} h~τ+1n−1;

- 引入了上一片段的隐层表示只会用在key和value上,对于query还是保持原来的样子(得到中间的表达式形态)。

- 这样做也好理解,query只是表示查询的词,而key,value表示的是这个查询的词的相关信息,我们要改变的是只是信息,因此只要在key,value中引入上一片段的信息就可以了。

- 第三个式子

- 将 τ + 1 τ+1 τ+1 时间步的 Q、K、V喂给 Transformer-Layer;剩下的就和Transformer一致

原则上只要 GPU 内存允许,该方法可以利用前面更多段的信息,测试阶段也可以获得更长的依赖(类似于 DenseNet)。

在测试阶段,与vanilla Transformer相比,其速度也会更快:在vanilla Transformer中,一次只能前进一个step,并且需要重新构建段,并全部从头开始计算;而在Transformer-XL中,每次可以前进一整个段,并利用之前段的数据来预测当前段的输出。

2、相对位置编码

天真地应用 segment-level recurrence是行不通的,因为当我们重用前面的段时,位置编码是不一致的。

例如,考虑一个具有上下文位置[0,1,2,3]的旧段。当处理一个新的段时,我们将两个段合并,得到位置[0,1,2,3,0,1,2,3],其中每个位置id的语义在整个序列中是不连贯的。

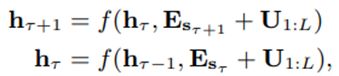

在Transformer中,一个重要的地方在于其考虑了序列的位置信息。在分段的情况下,如果仅仅对于每个段仍直接使用Transformer中的位置编码,即每个不同段在同一个位置上的表示使用相同的位置编码,就会出现问题。(下式中U表示位置向量)

为此,我们提出了一种新的相对位置编码方案,使递归机制成为可能。

此外,与其他相对位置编码方案不同,我们的公式使用具有learnable transformations的固定嵌入,而不是earnable embeddings,因此在测试时更适用于较长的序列。

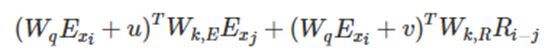

论文对于这个问题,提出了一种新的位置编码的方式,即会根据词之间的相对距离而非像Transformer中的绝对位置进行编码。Transformer中的attention权重计算公式如下:

将其展开可以分解成下面四个部分。 第一层的计算查询和键之间的attention分数的方式为:

E表示embedding,U 表示位置向量。在Transformer-XL中,对上述的attention计算方式进行了变换,转为相对位置的计算,而且不仅仅在第一层这么计算,在每一层都是这样计算。

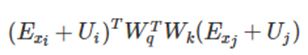

对比来看:

- 在(b)和(d)这两项中,将所有绝对位置向量都转为相对位置向量 ,与Transformer一样,这是一个固定的编码向量,不需要学习。

- 在(c)这一项中,将查询的向量 U i T W q T U_i^TW_q^T UiTWqT 转为一个需要学习的参数向量 u u u,因为在考虑相对位置的时候,不需要查询绝对位置 i i i,因此对于任意的 i i i,都可以采用同样的向量。同理,在(d)这一项中,也是一样

- 将Key的权重变换矩阵 W k W_k Wk 转为 W k , E W_{k,E} Wk,E 和 W k , R W_{k,R} Wk,R,分别作为 Content-based key vectors和 Location-based key vectors。

从另一个角度来解读这个公式的话,可以将attention的计算分为如下四个部分:

- 基于内容的"寻址",即没有添加原始位置编码的原始分数。

- 基于内容的位置偏置,即相对于当前内容的位置偏差。

- 全局的内容偏置,用于衡量key的重要性。

- 全局的位置偏置,根据query和key之间的距离调整重要性。

将上面的式子合并后,可以得到:

上面整个即使Transformer-XL的两个改变:前面是内容,后面是位置。

3、整体公式计算

结合上面两个创新点,将Transformer-XL模型的整体计算公式整理如下,这里考虑一个N层的只有一个注意力头的模型:

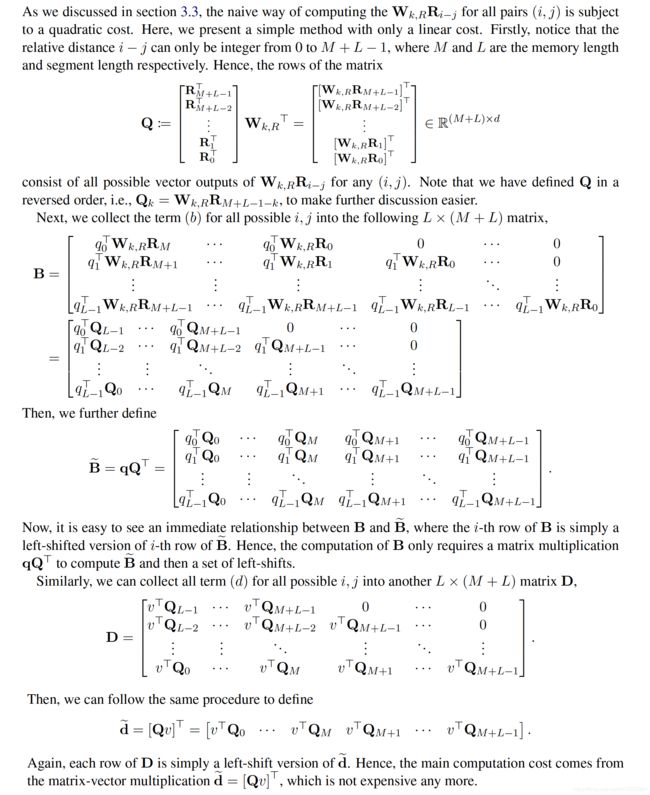

4、计算小Trick:Efficient Computation of the Attention with Relative Positional Embedding

四、论文相关

1、模型特点

在 AI-Rfou 等人提出的vanilla Transformer上做了两点创新:

- 引入循环机制(Recurrence Mechanism)

- 相对位置编码(Relative Positional Encoding),这个是解决上面创新带来的问题而产生的。

2、优点

- 与vanilla Transformer相比,Transformer-XL的另一个优势是它可以被用于单词级和字符级的语言建模【说明:这个没有理解从哪方面体现的】。在几种不同的数据集(大/小,字符级别/单词级别等)均实现了最先进的语言建模结果。

- 结合了深度学习的两个重要概念——循环机制和注意力机制,允许模型学习长期依赖性,且可能可以扩展到需要该能力的其他深度学习领域,例如音频分析(如每秒16k样本的语音数据)等。

- 在inference阶段非常快,比之前最先进的利用Transformer模型进行语言建模的方法快300~1800倍。

- 有详尽的源码!含TensorFlow和PyTorch版本的,并且有TensorFlow预训练好的模型及各个数据集上详尽的超参数设置。

3、不足

尚未在具体的NLP任务如情感分析、QA等上应用。

没有给出与其他的基于Transformer的模型,如BERT等,对比有何优势。

在Github源码中提到,目前的sota结果是在TPU大集群上训练得出,对于我等渣机器党就只能玩玩base模式了。

enwik8和text8数据集

参考资料:

The Transformer Family

【NLP-16】Transformer-XL

7. Transformer-XL原理介绍

一文看懂 9 种Transformer结构!

谷歌升级版Transformer官方解读:更大、更强,解决长文本问题(开源)

Transformer一统江湖:自然语言处理三大特征抽取器比较

谷歌升级版Transformer官方解读:更大、更强,解决长文本问题(开源)

Transformer-XL: Unleashing the Potential of Attention Models