强化学习简介

强化学习简介

参考链接:强化学习系列(一):强化学习简介

感谢原博宝贵的学习资料!

一、强化学习是什么?

1.RL描述的是一个与环境交互的学习过程

2.以人开车为例,分析agent、environment、action、state、reward。其中,reward指导agent的action。

二、强化学习特性

1.与监督学习和非监督学习比较

(1)监督学习:学习的数据都有labels。常用于回归、分类问题。

(2)无监督学习:学习的数据都没有labels,通过学习无标签的数据探索数据的特性。常用于聚类。

2.reward和labels是不一样的:

labels是在学习前就已存在于数据中;reward是在当前时刻t的状态st下,执行了相应的动作at,才会在下一时刻(t+1时刻)获得一个对t时刻的reward Rt+1。就好像有延迟一样。

reward是一种延迟奖励的机制。

有些action通过对环境的state影响,可以影响到好多步之后的rewar。RL的目标是最大化reward之和,而不是单步reward。

3.RL特点总结

- 没有监督者,只有一系列reward

- 反馈不及时,有延迟

- 算法接受的数据是有时间顺序的(强化学习是一种与环境交互的学习问题,这意味着state和action的时序性是很重要的,他所获得的一系列state很大程度上是有联系的,并不是独立存在的)

- agent的动作可以对environment产生持续影响

三、强化学习问题

介绍除了reward外其他几个组成部分是如何影响RL工作的

1.agent and environment

注意到agent收到的是t-1时刻environment更新的Ot,environment在t时刻更新的是下一个时间t+1时刻的Ot+1。reward同observation。

2.state

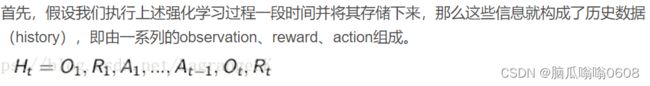

(1)state是用来决定下一步做什么的信息量。将state看做history的函数

则St=f(Ht)。

(2)state分为environment state、agent state、information state。其中agent state是RL算法直接采用的信息,可表示为历史的任意函数,Sat=f(Ht) 。information state包括历史数据中所有有用的信息,如果state满足Markov条件,则下一时刻状态完全由当前时刻决定。

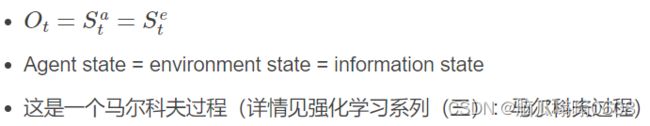

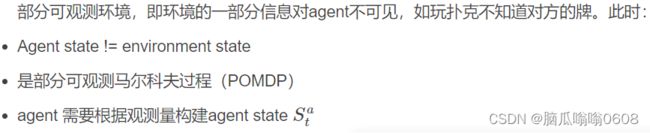

(3)environment分为可完全观测环境(Fully Observation Environment)和部分可观测环境(Partially Observation Environment)。

- 当fully observation,有如下特点:

- 当partly observation,有如下特点:

四、agent组成要素

1.policy

(1)agent的行为准则,对应着action和state之间的关系

(2)种类

- 确定性策略(deterministic policy)a=π(s) ,即一个action为state的函数

- 随机策略(stochastic policy)π(a|s)=P[At=a|St=s] ,对应action相对state的条件概率

2.value function

(1)how good is each state and/ or action

(2)RL的目标是reward之和最大化,但reward之和不能简单计算,需要用一个value function估计,后续详细讲

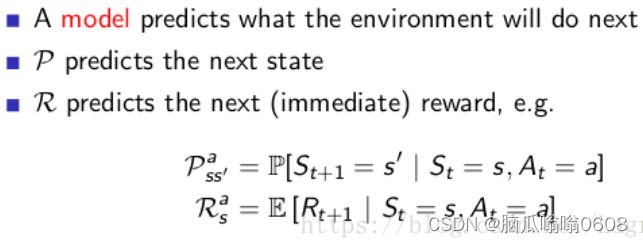

3.model

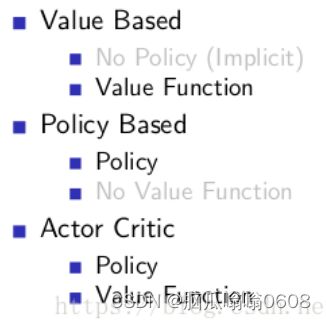

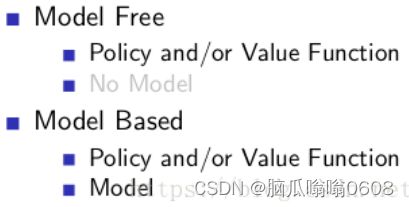

五、RL分类

根据包不包含policy和value function,分类

根据是否建模,分类

六、exploration和exploitation

个人理解:exploration是不断探索新的领域,扩展state(state包含了历史数据),通过action完成。exploitation是在已搜索到的state中开发出reward最大的action。