hdfs shell操作

文章目录

- HDFS 的shell操作

-

- 一、三种Shell命令方式

- 二、常用HDFS的shell命令

- 三、HDFS常用命令操作实例

-

- 1、创建单层目录

- 2、创建多层目录

- 3、查看目录

- 4,上传本地文件到hdfs

- 5、查看文件内容

- 6、下载hdfs文件到本地

- 7、删除hdfs文件

- 8、删除hdfs目录

- 9、移动目录或文件

- 10、文件合并下载

- 11、检查文件信息

- 12、创建时间戳文件

- 13、复制文件或目录

- 14,查看文件大小

- 15、上传文件

- 16,下载文件

- 17、查看某目录下文件个数

- 18,检查hadoop 本地库

- 19、进入和退出安全模式

- 四、Shell定时采集数据到HDFS(案例)

-

- 1、编程思路与步骤

-

- 1) 配置环境变量

- 2) 准备日志存放目录和待上传文件

- 3) 设置日志文件上传的路径

- 4) 实现文件上传

- 2、编写脚本,实现功能

- 3、运行脚本,查看结果

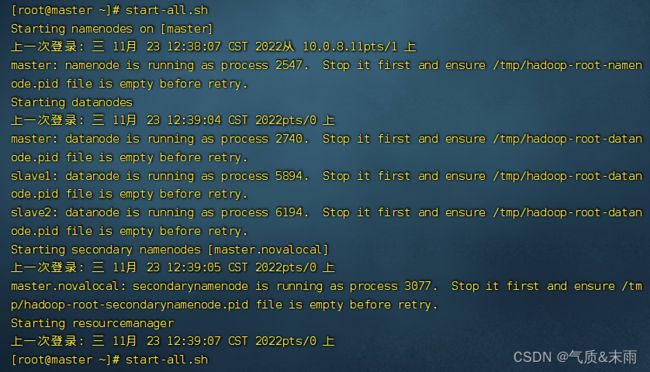

HDFS 的shell操作

Shell在计算机科学中俗称“壳”,是提供给使用者使用界面的进行与系统交互的软件,通过接收用户输入的命令执行相应的操作,Shell分为图形界面Shell和命令行式Shell。文件系统(FS)Shell包含了各种的类Shell的命令,可以直接与Hadoop分布式文件系统以及其他文件系统进行交互。

一、三种Shell命令方式

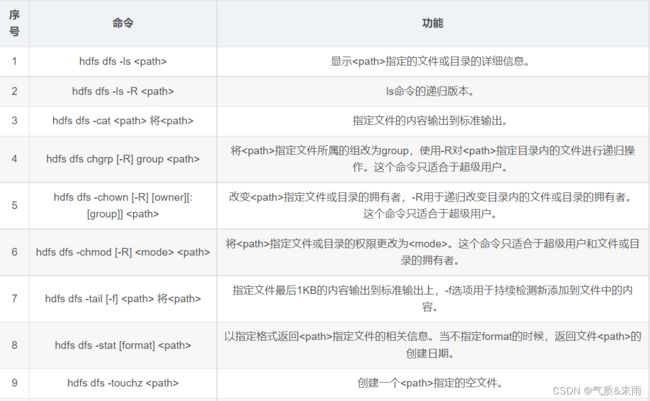

二、常用HDFS的shell命令

三、HDFS常用命令操作实例

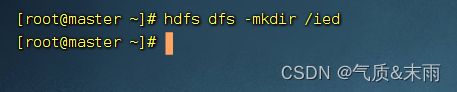

1、创建单层目录

输入命令:hdfs dfa -mkdir /ied 在hdfs上创建一个/ied 目录

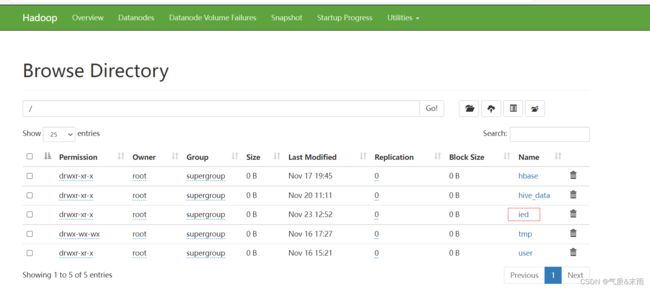

在webUI 界面查看刚刚创建的/ied 目录

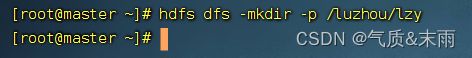

2、创建多层目录

输入命令:hdfs dfs -mkdir -p /luzhou/lzy

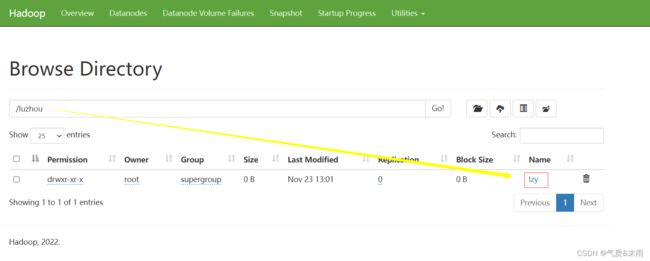

在webUI 界面查看刚刚创建的 /luzhou/lzy文件

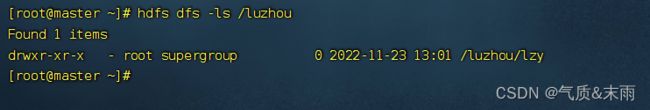

3、查看目录

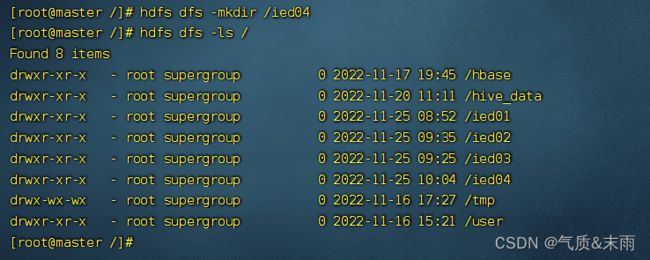

输入命令:hdfs dfs -ls / hdfs根目录下的所有目录

输入命令:hdfs dfs -ls /luzhou 可以看到/luhzou 下面的目录

如果我们要查看根目录里的全部资源,那么要用到递归参数 -R (大写)

输入命令:hdfs dfs -ls -R / 把hdfs 根目录上所有的文件都递归显示出来了(采用递归算法遍历树结构)

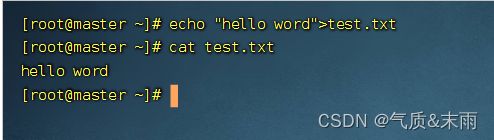

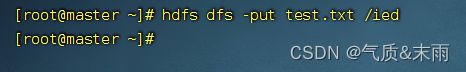

4,上传本地文件到hdfs

创建test.txt 文件,输入命令:echo "hello word" > test.txt (> 重定向命令)

上传test.txt 文件到hdfs 的/ied目录,执行命令:hdfs dfs -put test.txt /ied

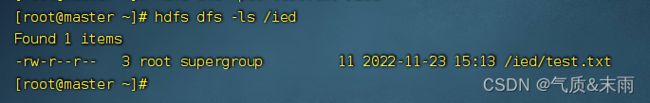

查看是否上传成功 输入命令:hdfs dfs -ls /ied

在webUI界面上进行查看

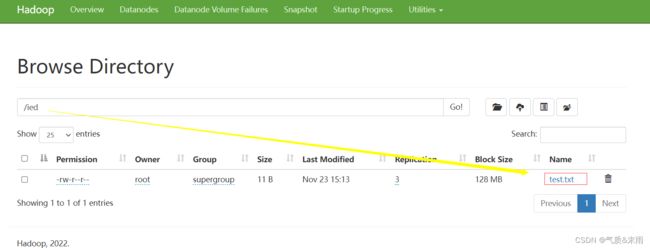

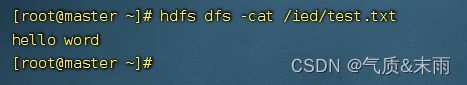

5、查看文件内容

输入命令:hdfs dfs -cat /ied/test.txt

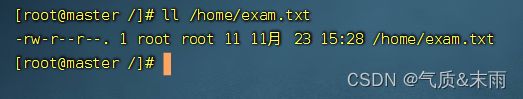

6、下载hdfs文件到本地

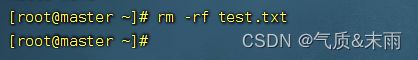

先删除本文的test.txt文件,输入命令:rm -rf test.txt

下载hdfs文件系统的/ied/test.txt到本地目录不改名

输入命令:hdfs dfs -get /ied/test.txt

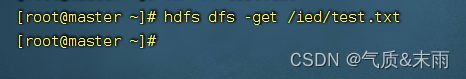

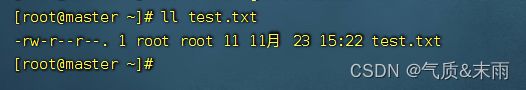

查看是否下载成功

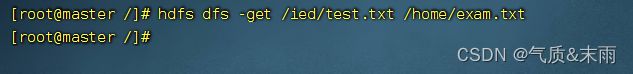

可以将hdfs上的文件下载到本地指定位置,并且可以更改文件名

输入命令:hdfs dfs -get /ied/test.txt /home/exam.txt

查看是否下载成功

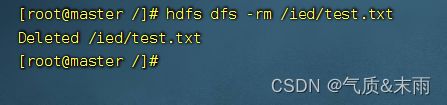

7、删除hdfs文件

输入命令:hdfs dfs -rm /ied/test.txt 把hdfs的/ied下的test.txt 文件删除

查看是否删除成功

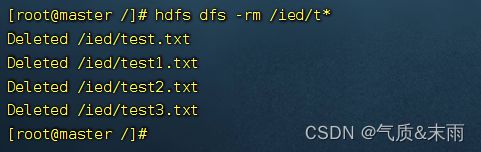

使用通配符,可以删除满足一定特征的文件

删除/ied 目录下,所有文件名t开头的文件

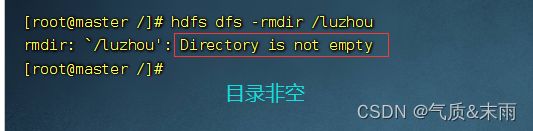

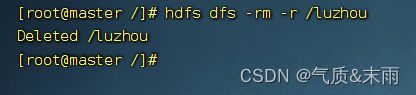

8、删除hdfs目录

- 提示:rmdir命令删除不了非空目录

- 要递归删除才能删除非空目录:

hdfs dfs -rm -r /luzhou(r:recursive)

输入命令:hdfs dfs -rm -r /luzhou

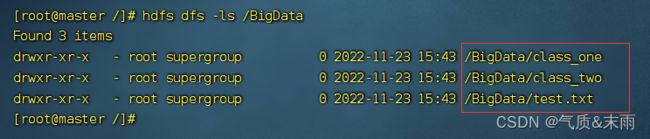

将/BigData变成一个空目录,(删除里面的空子目录class_one,class_two和文件test.txt)

输入命令:hdfs dfs -rm -r /BigData/*使用通配符* 和 递归方式删除/BigData里的所有东西

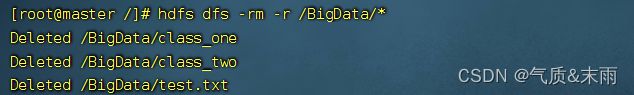

此时删除非空目录,输入命令:hdfs dfs -rmdir /BigData (-rmdir 专门用来删除非空目录,删除目录之前先用递归把目录里的数据删除了,再把目录删除了)

查看是否删除成功

9、移动目录或文件

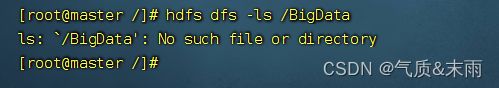

-mv 具有移动和更名的双重功能

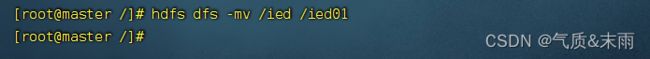

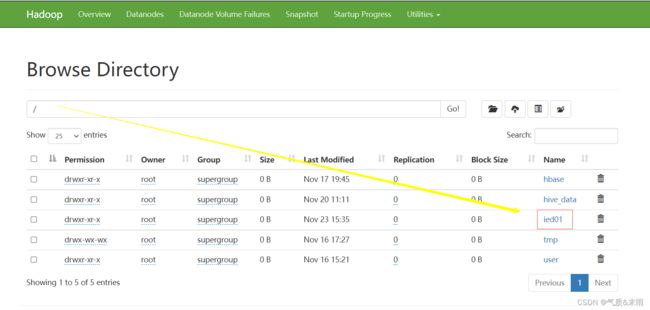

将/ied 目录更名为/ied01,执行命令:hdfs dfs -mv /ied /ied01

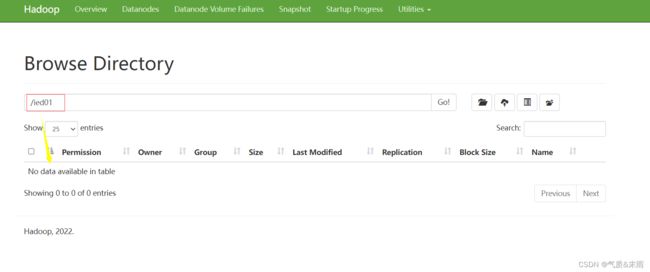

在webUI界面查看是否更名成功

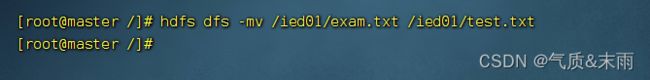

将/ied01/exam.txt 改名为 /ied01/test.txt

输入命令:hdfs dfs -mv /ied01/exam.txt /ied01/test.txt

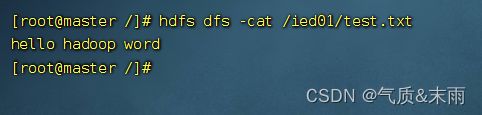

查看更名后的 test.txt 文件的内容

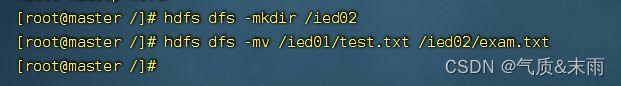

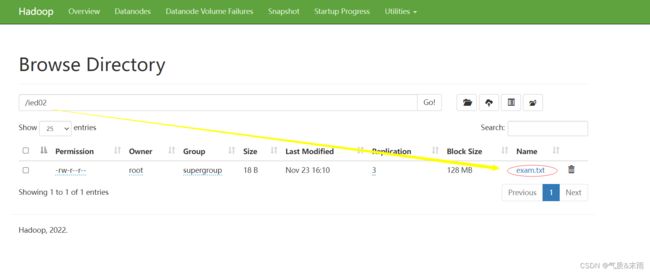

创建/ied02 目录,将/ied01/test.txt 移动到 /ied02目录,并且改名为 exam.txt

输入命令:hdfs dfs -mv /ied01/test.txt /ied02/exam.txt

在webUI 界面查看 文件已经移动到/ied02 目录下,原目录的文件已经为空

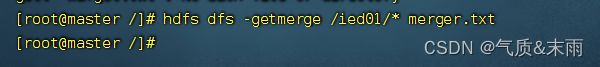

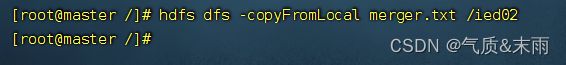

10、文件合并下载

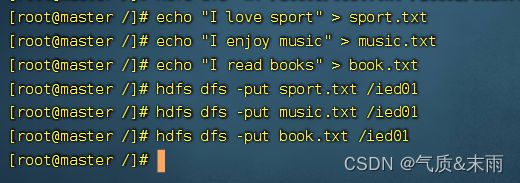

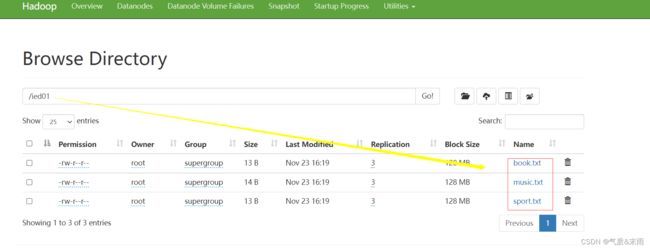

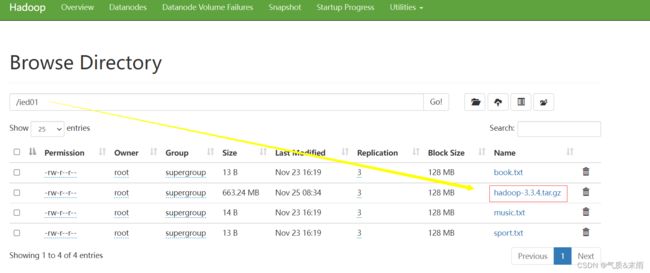

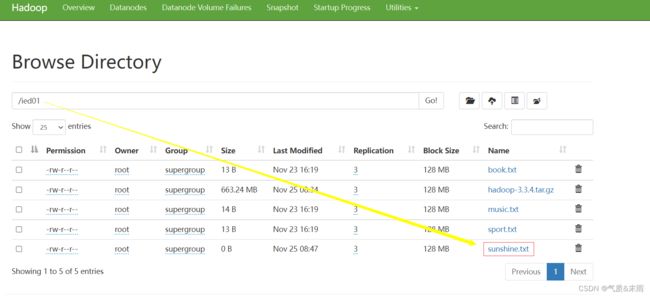

创建sport.txt、music.txt和book.txt 并上传到 /ied01 目录下

在webUI界面上查看,注意文件是按照字典字母顺序排好了的

合并/ied01目录的文件下载到本地当前目录的merger.txt

输入命令:hdfs dfs -getmerge /ied01/* marge.txt

使用 -getmerge 命令,下载合并数据导本地,然后合并为文件 merger.txt

查看刚刚下载的 merger.txt 文件 里面是三个文件合并的数据

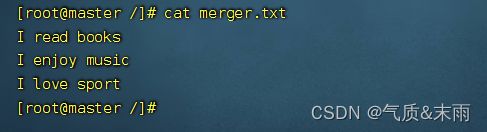

11、检查文件信息

fask: file system check —— 文件系统

检查 /ied01/book.txt 文件,输入命令:hdfs dfs fask /ied01/book.txt -files -blocjs -locations -racks

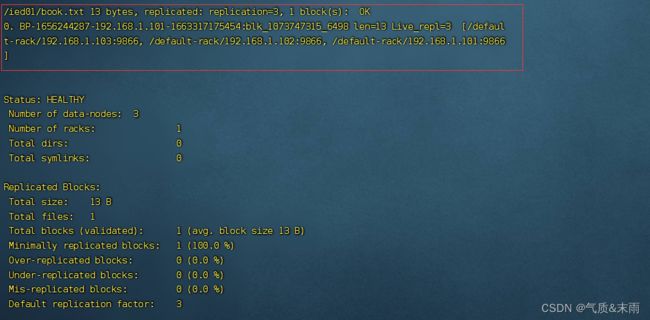

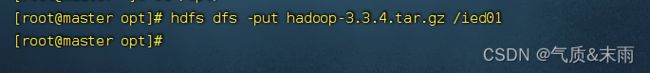

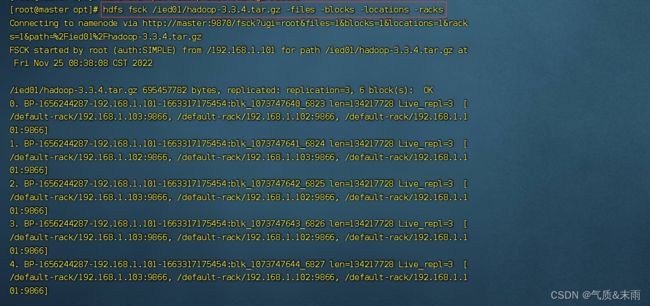

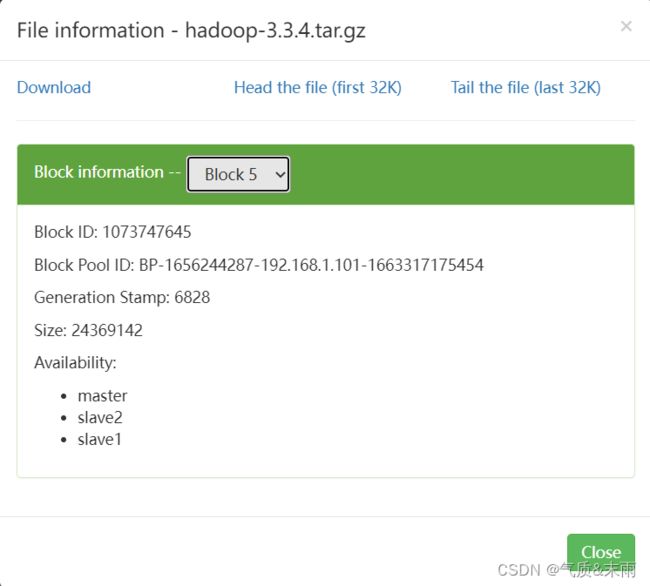

HDFS 里面一个文件快大概是128MB,上传一个大于128MB的文件,hadoop-3.3.4.tar.gz 大概是663.21MB 128MB X 5 = 640MB < 663 MB 所以 HDFS会将文件分为6块

将这个hadoop 压缩包文件上传到HDFS上

执行命令:hdfs dfs -put hadoop-3.3.4.tar.gz /ied01

在webUI界面上查看是否成功

查看HDFS上hadoop-3.3.4.tar.gz 的文件信息,输入命令:hdfs fsck /ied01/hadoop-3.3.4.tar.gz files -blocks -locations -racks

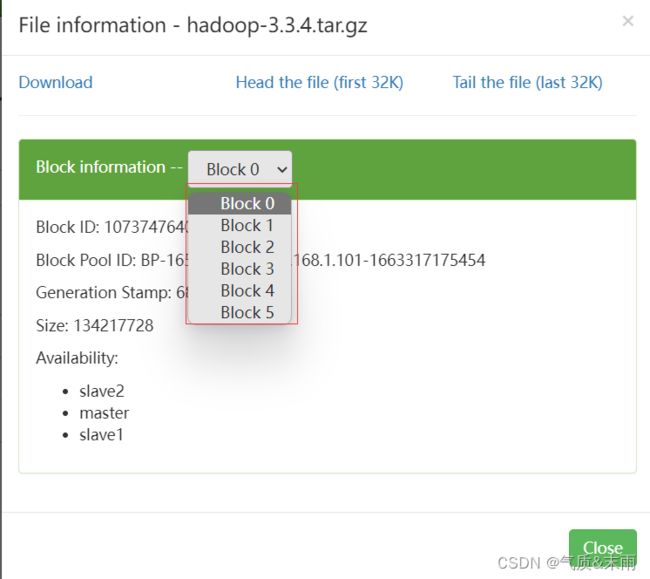

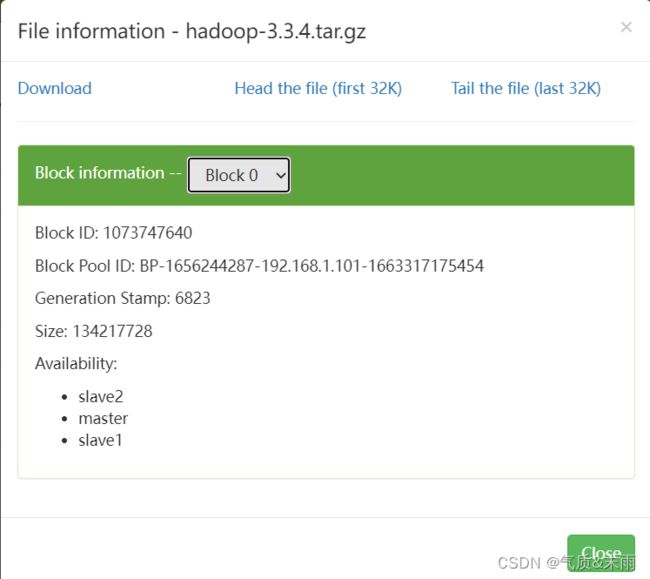

在webUI界面上查看更加的方便,总共有六个文件快:Block0 Block1 Block2 Block3 Block4 Block5

第一个文件快信息

第六个文件快信息

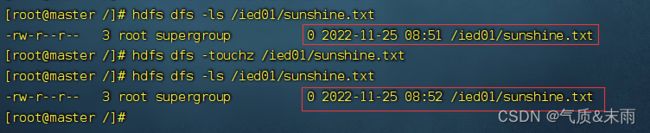

12、创建时间戳文件

在 /ied01 目录里创建一个文件,sunshine.txt,执行命令:hdfs dfs -touchz /ied01/sunshine.txt

创建的是一个空文件,大小为0字节

这种空文件,一般叫做标识文件,也叫做时间戳文件,再次在/ied01目录下创建sunshine.txt 文件,两个相同文件的时间戳不一样

注意:如果touchz命令的路径指定的文件不存在,那就创建一个空文件,如果指定的文件存在,那就改变该文件的时间戳

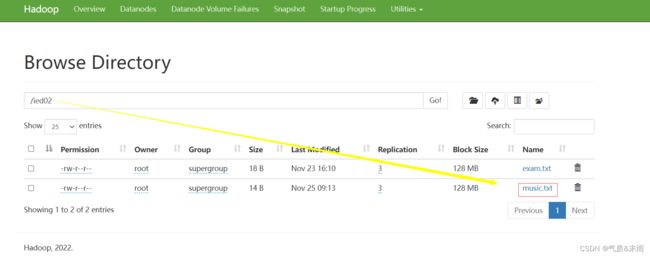

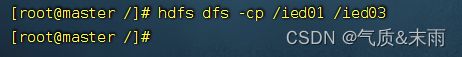

13、复制文件或目录

cd: copy 拷贝或者复制

- 同名复制文件

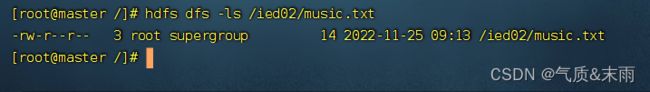

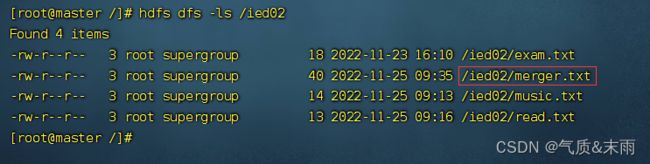

将 /ied01/music.txt 复制到 /ied02 里,输入命令:hdfs dfs -cp /ied01/music.txt /ied02

查看拷贝生成的文件

hdfs dfs -ls /ied02/music.txt

- 改名复制文件

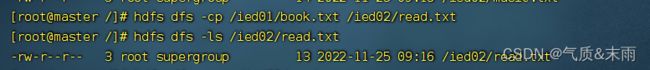

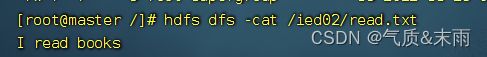

将/ied01/book.txt复制到/ied02目录下,改名为read.txt,执行命令:`hdfs dfs -cp /ied01/book.txt /ied02/read.txt

查看拷贝之后的内容

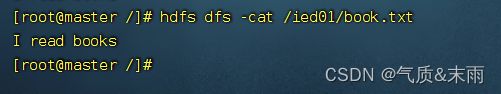

拷贝之后,原文件依然存在

- 复制目录

将 /ied01 目录复制到 /ied03 目录,输入命令:hdfs dfs -cp /ied01 /ied03

查看拷贝之后的/ied03的内容,跟/ied01的完全相同

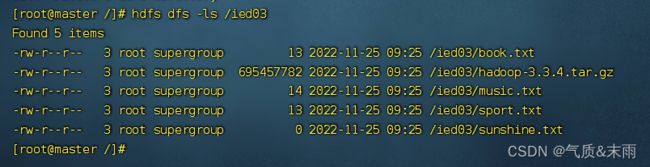

14,查看文件大小

du:disk usage(查看文件)

输入命令:hdfs dfs -du /ied01/book.txt 一共有13个字符,10个字母和两个空格,包含一个看不见的结束符,一个字符是三个字节,所以是39个字节

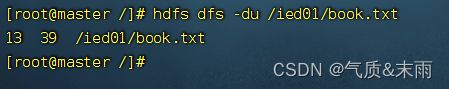

15、上传文件

-copyFromLocal 类似于 -put,执行命令:hdfs dfs -copyFromLocal mergar.txt /ied02

查看是否上传成功

16,下载文件

copyToLocal 类似于 -get ,执行命令:hdfs dfs -copyToLocal /ied01/sunshine.txt sunlight.txt

将hdfs 上 /ied01 目录下的 sunshine.txt 文件下载到linux 本地,并且把文件更名为 sunlight.txt

![]()

查看下载并改名的sunlight.txt 文件

![]()

17、查看某目录下文件个数

输入命令:hdfs dfs -count /ied01 count: 计数 /ied01 目录下有5个文件

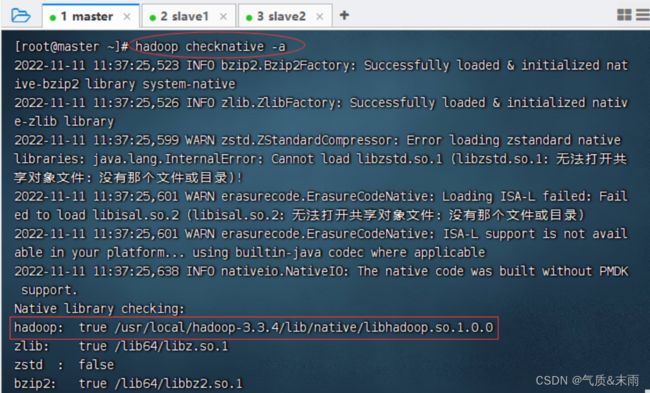

18,检查hadoop 本地库

输入命令:hdfs checknative -a

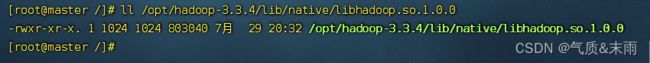

查看hadoop本地库文件

输入命令:ll /opt/hadoop-3.3.4/lib/native/libhadoop.so.1.0.0

19、进入和退出安全模式

哪些情况下HDFS 会进入安全模式 (只能读不能写)

(1) 名称节点启动时,进入安全模式,直到fsimage用edits更新完毕才退出安全模式

(2) 当文件块的副本数量少于设置的副本数量,会进入安全模式,直到生成符合要求的副本数,才会退出安全模式,其实也可以通过命令方式进入或退出安全模式

- 进入安全模式

执行命令:hdfs dfsadmin -safemode enter

注意:进入安全模式之后,只能读不能写

此时,如果要创建目录,就算报错

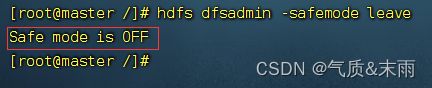

- 退出安全模式

输入命令:hdfs dfsadmin -safemode leave

此时,创建/ied04就没有任何问题

四、Shell定时采集数据到HDFS(案例)

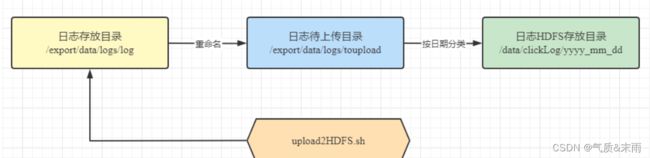

服务器每天会产生大量日志数据,并且日志文件可能存在于每个应用程序指定的data目录中,在不使用其他工具的情况下,将服务器中的日志文件规范地放进HDFS中,通过编写简单的Shell脚本,用于每天自动采集服务器上的日志文件,并将海量的日志上传到HDFS中

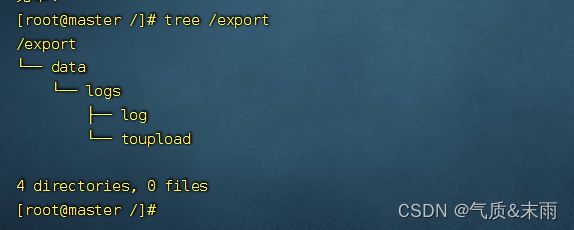

创建日志存放的目录 /export/data/logs/log,执行命令:mkdir -p /export/data/logs/log

创建待上传文件存放的目录/export/data/logs/toupload

执行命令:mkdir -p /export/data/logs/toupload

查看创建的目录树结构

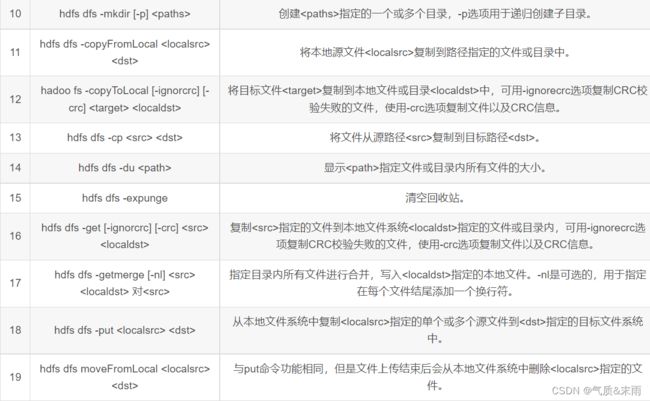

1、编程思路与步骤

1) 配置环境变量

首先在/export/data/logs目录下(如果目录不存在,则需要提前创建) 使用 vim 命令创建 upload2HDFS.sh 脚本文件,在编写Shell脚本时,需要设置Java环境变量和Hadoop环境变量,这样做是用来提高系统的可靠性,保障运行程序的机器在没有配置环境变量的情况下,依然能够运行脚本

2) 准备日志存放目录和待上传文件

为了让开发者便于控制上传文件的流程,可以在脚本中设置一个日志存放目录和待上传文件目录,若上传过程中发生错误只需要查看该目录就能直到文件的上传进度

3) 设置日志文件上传的路径

设置上传的HDFS目标路径,命名格式以时间结尾,并且输出打印信息

4) 实现文件上传

上传文件的过程就是遍历文件目录的过程,将文件首先移动到待上传目录,再从待上传目录中上传到HDFS中。若是在每天12点凌晨执行一次,我们可以使用Linux Crontab表达式执行定时任务

2、编写脚本,实现功能

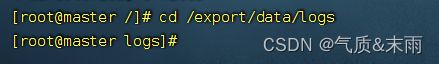

进入 /export/data/logs 目录

执行命令:vim upload2HDFS.sh 编写以下代码

#!/bin/bash

JAVA_HOME=/opt/jdk1.8.0_162

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

export HADOOP_HOME=/opt/hadoop-3.3.4/

export PATH=${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:$PATH

#日志文件存放的目录,需手动创建

log_src_dir=/export/data/logs/log/

#待上传文件存放的目录,需手动创建

log_toupload_dir=/export/data/logs/toupload/

#设置日期

date1=`date +%Y_%m_%d`

#日志文件上传到hdfs的根路径

hdfs_root_dir=/data/clickLog/$date1/

#打印环境变量信息

echo "envs: hadoop_home: $HADOOP_HOME"

#读取日志文件的目录,判断是否有需要上传的文件

echo "log_src_dir: $log_src_dir"

ls $log_src_dir | while read fileName

do

if [[ "$fileName" == access.log.* ]]; then

date=`date +%Y_%m_%d_%H_%M_%S`

#将文件移动到待上传目录并重命名

echo "moving $log_src_dir$fileName to $log_toupload_dir"lzy_click_log_$fileName"$date"

mv $log_src_dir$fileName $log_toupload_dir"lzy_click_log_$fileName"$date

#将待上传的文件path写入一个列表文件willDoing,

echo $log_toupload_dir"lzy_click_log_$fileName"$date >> $log_toupload_dir"willDoing."$date

fi

done

#找到列表文件willDoing

ls $log_toupload_dir | grep will | grep -v "_COPY_" | grep -v "_DONE_" | while read line

do

#打印信息

echo "toupload is in file: $line"

#将待上传文件列表willDoing改名为willDoing_COPY_

mv $log_toupload_dir$line $log_toupload_dir$line"_COPY_"

#读列表文件willDoing_COPY_的内容(一个一个的待上传文件名)

#此处的line 就是列表中的一个待上传文件的path

cat $log_toupload_dir$line"_COPY_" | while read line

do

#打印信息

echo "puting...$line to hdfs path...$hdfs_root_dir"

hdfs dfs -mkdir -p $hdfs_root_dir

hdfs dfs -put $line $hdfs_root_dir

done

mv $log_toupload_dir$line"_COPY_" $log_toupload_dir$line"_DONE_"

done

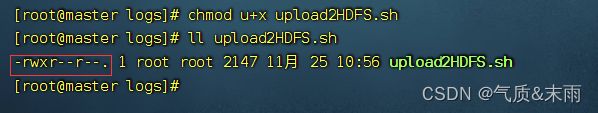

编辑权限,执行命令:chomd u+x upload2HDFS.sh

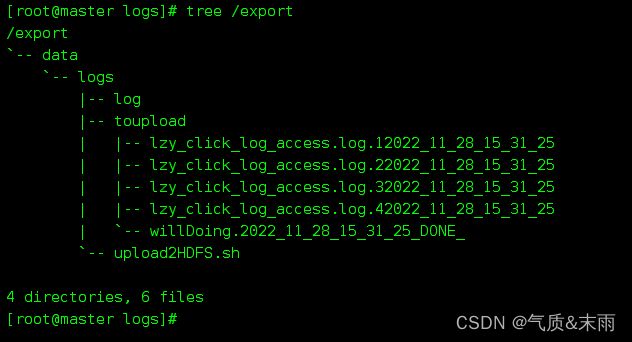

查看 /export 目录树结构

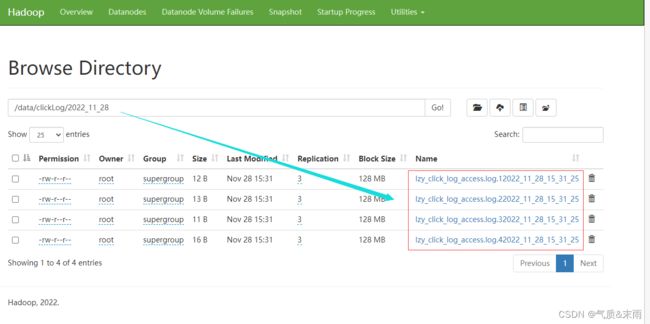

3、运行脚本,查看结果

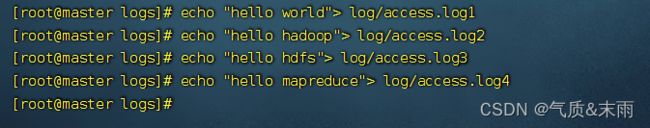

- 为了模拟生产环境,在日志存放目录/export/data/logs/log/中,手动创建日志文件,access.log表示正在源源不断的产生日志的文件,access.log.1、access.log.2等表示已经滚动完毕的日志文件,即为待上传日志文件

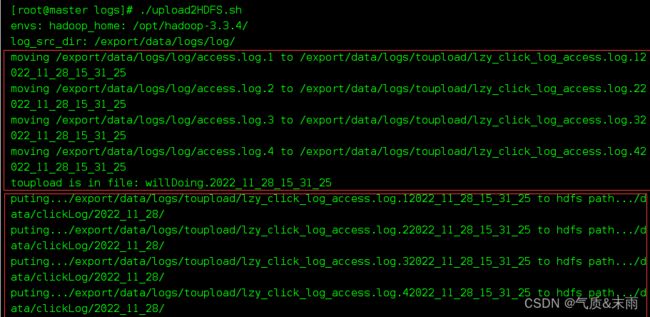

- 在upload2HDFS.sh文件路径下运行脚本,先将日志存放目录log中的日志文件移到待上传toupload目录下,并根据业务需求重命名;然后脚本执行“hdfs

dfs -put”上传命令,将待上传目录下的所有日志文件上传至HDFS;最后通过HDFS

WebUI界面可看到需要采集的日志文件已按照日期分类,上传至HDFS中。 - 创建四个日志文件(必须以access.log.打头)

查看 /export 目录树结构

输入命令:./upload2HDFS.sh 可以看到目录后面出现了时间,那就是日志的时间

查看/export 目录树解构

在webUI界面上查看上传的日志文件