清华提出自适应决策边界用于开放意图分类

近日,清华大学智能信息处理实验室的一篇论文被人工智能顶级会议AAAI 2021(CCF A类)接收,标题为《Deep Open Intent Classification with Adaptive Decision Boundary》。

论文一作为清华大学计算机系一年级博士研究生张瀚镭,通讯作者为清华大学计算机系徐华副教授。

论文链接: https://arxiv.org/pdf/2012.10209.pdf

代码链接:https://github.com/thuiar/Adaptive-Decision-Boundary

1

任务介绍

识别并理解用户意图是对话系统中十分关键的任务,有利于推测用户进一步的行为并进行有效决策。然而,现有的对话系统往往需要事先定义好用户意图的类别,对于真实场景下用户说话内容中存在的开放(未知)意图处理能力仍较为有限。识别开放意图不仅能帮助提升服务质量,对挖掘用户潜在意图也有重要意义。

因此,在这篇文章中,我们定义了一个开放意图分类问题。以任务导向型对话系统为例,如图1所示,我们有两个任务型意图,订机票和订餐馆。

图1 开放意图分类举例

为了实现系统目标,我们希望拥有任务型意图的语句被准确地识别出来。但是,由于用户说话内容的随机性,一些与设定任务无关的句子(存在开放意图),也应该被有效地检测出来。我们把这个问题看作m+1分类问题,即训练阶段只给定m类已知意图样本;测试阶段给定全部意图样本,将除m类之外的开放类意图看作一类。希望在保证准确识别m类已知意图的同时,有效检测剩余一类开放意图。

2

研究背景

然而,目前关于开放意图分类相关工作仍比较少,根据特点我们将其主要分为两类。其中一类方法通过设定概率阈值,将最大分类置信度低于阈值的样本看作开放类意图检测出来[1,2,3]; 另外一类则结合意图样本几何特征(如欧式距离)通过决策边界或者分布密度将异常类样本检测出来[4,5]。

然而,现有方法主要存在以下两个问题:

(1) 大多方法需要利用开放类样本进行训练或调参,但是在我们的任务中,训练阶段只存在已知类意图,无法获取这部分开放类样本。

(2) 开放域样本决策条件(概率阈值和决策边界)往往是通过复杂的人工调参和经验筛选得到的,对结果影响较大且不稳定。

为解决上述问题,我们提出了一种后处理方法ADB (Adaptive Decision Boundary),能自动学习决策边界用于识别已知意图并发现开放意图。该方法在训练阶段不需要开放类意图样本,只需结合意图特征分布自适应地学习每类已知意图决策边界,最终将位于全部决策边界之外的样本识别为开放类意图样本。

我们在三个文本意图基准数据集上进行实验,均取得了最好结果,相比基线方法有了显著提升,在不同已知意图比例和有标注数据比例设置下也表现得十分鲁棒。

3

论文方法

图2 ADB: 基于适应性决策边界进行开放意图分类

如图2所示,我们的模型主要分为三个部分,意图特征提取,簇中心和决策边界定义,决策边界学习。

首先,我们利用BERT [6]作为特征提取器,通过有标签已知意图样本预训练模型并初始化意图特征。

然后,我们假设每类已知意图样本位于球状区域内,对于每类已知意图簇,定义簇中心和半径用于确定决策边界。

此外,我们提出了一个新的损失函数,在每类已知意图特征欧式空间内,同时平衡经验风险和开放空间风险[6],学习合适的决策边界兼顾已知意图分类和开放域意图检测性能。在测试阶段,我们利用训练阶段学习到的簇中心和决策边界识别已知意图和开放意图。

3.1 意图表示和预训练

我们利用BERT语言模型提取意图特征。对于输入BERT的一句话,经过全部Transformer编码层之后,提取最后一层输出的词嵌入表示。然后,通过平均池化(mean-pooling)操作获得句向量表示,再经过一层致密层(Dense Layer)获得意图特征:

由于决策边界依赖于已知意图特征分布适应性学习,我们首先需要对已知意图特征进行初始化。为了更好地验证决策边界的作用,这里我们只选取简单的交叉熵损失函数,结合有标签已知意图分类任务对模型进行预训练:

3.2 决策边界定义

决策边界是影响开放意图分类的关键性因素,合适的决策边界不仅能保证更多的已知类识别正确(减少经验风险),同时能保证较少的开放类被误识别成已知类(降低开放空间风险)。在保证已知类识别准确性的前提下,定义的开放空间越大、检测开放类性能越好。

如图3所示,相较于线性决策边界[7],球状决策边界通过缩小封闭空间区域,极大地降低开放空间风险[8],因此我们希望利用球状决策边界区分已知类和开放类。

定义球状决策边界,需要确定中心和半径。针对每类已知意图,我们将相同标签的样本集合作为一簇,通过计算每一簇的平均特征向量确定簇中心:

针对每一类簇,我们希望通过模型学习到合适的半径,进而确定其决策边界。我们通过神经网络初始化半径参数,为了保证半径可微,我们利用SoftPlus激活函数作为半径与半径参数之间的映射。

SoftPlus激活函数作为半径有以下优点:

(1) 具有ReLU函数线性性质(在自变量大约超过2之后)

(2) 在整个实数范围内半径均为正值且可微

(3) 半径取值可扩展到无穷。半径定义如下:

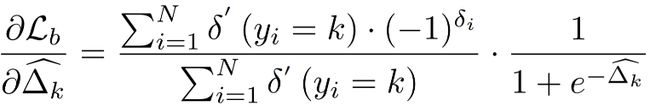

3.3 决策边界学习

由于训练阶段没有开放意图,我们结合已知意图特征分布学习决策边界。正如3.2节所提到的,学习决策边界需要同时平衡经验风险和开放空间风险,即,一方面希望决策边界能够包围大部分已知意图,过于紧凑会导致已知类识别性能下降、引入较多的经验风险; 另一方面希望决策边界距离簇中心不能太远,过于宽松会导致开放意图落入已知范围内、引入较多的开放空间风险。因此,我们提出了如下边界损失函数:

其中,

利用随机梯度下降优化半径参数:

边界目标损失函数直观的物理意义在于,对于同一类的全部样本,计算其特征表示距离对应决策边界的欧式距离,将其作为目标损失。当位于球形决策边界内部的损失比外部大时,累计梯度为正,决策边界向内靠拢; 同理,当位于决策边界外部的意图特征带来的损失更大,累计梯度为负,决策边界向外扩张,从而实现决策边界自适应学习。

3.4 利用决策边界进行开放意图分类

在学习到每一类已知意图的簇中心与决策边界半径之后,我们计算当前意图与全部簇中心的距离,当距离大于全部决策区域半径(落在所有球形决策边界之外),判断为开放类意图;否则识别成距离最近的簇中心对应的意图。表达式如下:

4

实验及结果

4.1 实验设置

我们选取了三个真实场景下比较有挑战性的文本意图数据集BANKING, OOS和StackOverflow。训练集只包含已知意图,测试集同时包含已知和开放意图。

实验评价指标为macro F1-score和ACC,其中macro F1-score通过将全部开放类看作一类,和已知意图若干类共同计算得到。

4.2 主实验结果

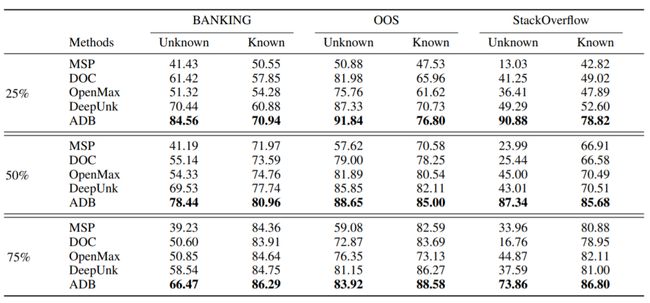

我们在已知意图比例分别为25%, 50%和75%条件下实验,实验结果见表1。我们的方法ADB在全部数据集和评价指标中均取得了最佳结果,在25%已知意图比例下相比基线方法取得了6%~40%的提升。

我们同样分别观察了已知类和未知类(开放类)的模型表现,实验结果见表2。ADB在识别已知类和检测未知类意图两个方面均取得了最佳结果,相比基线方法取得了3%~40%的显著提升。

4.3 对比实验结果

图4展示了已知意图有标注比例对模型性能的影响。我们的方法几乎在全部设置下均取得了最好结果,相比其他基线方法有大幅提升。即使在少量有监督比例(20%)条件下,ADB仍保持着良好性能,相比其他基线方法具有更加鲁棒。

4.4 决策边界的学习过程及影响

图5绘制了决策边界学习状态,可以看出,模型初始化决策边界半径为较小值,随着训练的进行,决策边界向外扩张直到平衡,每类簇最终学习到对应半径确定决策边界用于开放意图分类。

图6绘制了决策边界对开放意图分类的影响,可以看出,决策边界对模型性能影响较大,决策边界过大或者过小都会导致性能下降,我们学习到的决策边界较为合适,取得了接近最好的性能。

5

结论

ADB算法能够自适应性地结合已知意图信息确定簇中心和决策半径,进而确定决策边界用于区分已知类意图和开放意图。该方法无需开放类样本用于训练,避免了人工筛选决策参数的耗时性和不稳定性。ADB作为后处理方法无需修改原始模型结构,方法简单且可扩展性较强。我们使用多个数据集进行实验,ADB在不同已知意图和有标注比例设置下,均取得了最好且鲁棒性的结果。

同时推荐我们另外一篇和对话新意图发现相关的文章《Discovering New Intents with Deep Aligned Clustering》,同样被AAAI 2021收录,欢迎大家关注!(论文链接: https://arxiv.org/pdf/2012.08987.pdf )。

此外,我们结合开放意图分类相关工作,整理并扩展了一个开放知识发现阅读清单: Open Knowledge Discovery (后续会持续补充并完善相关内容),欢迎大家关注并提出宝贵建议!

阅读清单链接: https://github.com/thuiar/OKD-Reading-List

如有任何问题请联系 [email protected]

参考文献:

[1] Bendale, A.; and Boult, T. E. 2016. Towards open set deep networks. CVPR.

[2] Shu, L.; Xu, H.; and Liu, B. 2017. DOC: Deep Open Classification of Text Documents. EMNLP.

[3] Hendrycks, D.; and Gimpel, K. 2017. A Baseline for Detecting Misclassified and Out-of-Distribution Examples in Neural Networks. ICLR.

[4] Lin, T.-E.; and Xu, H. 2019. Deep Unknown Intent Detection with Margin Loss. ACL.

[5] Yan, G.; Fan, L.; Li, Q.; Liu, H.; Zhang, X.; Wu, X.-M.; and Lam, A. Y. 2020. Unknown Intent Detection Using Gaussian Mixture Model with an Application to Zero-shot Intent Classification. ACL.

[6] Devlin, J.; Chang, M.-W.; Lee, K.; and Toutanova, K. 2019. BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. NAACL.

[7] Scheirer, W. J.; de Rezende Rocha, A.; Sapkota, A.; and Boult, T. E. 2013. Toward Open Set Recognition. TPAMI.

[8] Fei, G.; and Liu, B. 2016. Breaking the Closed World Assumption in Text Classification. NAACL.

AI TIME欢迎AI领域学者投稿,期待大家剖析学科历史发展和前沿技术。针对热门话题,我们将邀请专家一起论道。同时,我们也长期招募优质的撰稿人,顶级的平台需要顶级的你,

请将简历等信息发至[email protected]!

微信联系:AITIME_HY

AI TIME是清华大学计算机系一群关注人工智能发展,并有思想情怀的青年学者们创办的圈子,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法、场景、应用的本质问题进行探索,加强思想碰撞,打造一个知识分享的聚集地。

更多资讯请扫码关注

我知道你“在看”哟~

点击 阅读原文 了解更多精彩