字符识别

文章目录

-

- CRNN

- RARE

- ESIR

- What Is Wrong With Scene Text Recognition Model Comparisons? Dataset and Model Analysis (CVPR2019)

- 2D Attention Network for Scene Text Recognition(2019)

- SEED (CVPR2020)

- Towards Accurate Scene Text Recognition with Semantic Reasoning Networks(CVPR2020)

- 端到端 检测+识别

-

- FOT

- STN—OCR

- Integrated Framwork

- MORAN

- AON

- 数据集

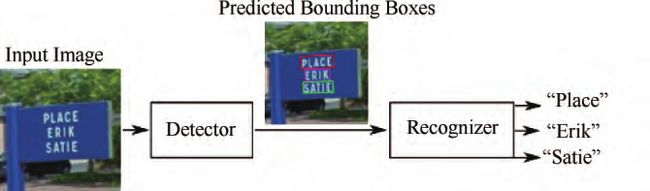

字符识别是基于文字序列识别

大多是检测+识别的两个步骤

检测模型大多基于Faster R-CNN、 SSD 、 FCN 等通用模型针对区域候选网络 、 多目标协同训练 、 特征提取 、 非极大值抑制 、 半监督式学习等方向进行改进

字符识别,指的是对已分割出的文字区域进行识别文字内容

CRNN

( Convolutional Recurrent Neural Network)

42 Shi Baoguang,Bai Xiang,Yao Cong. An end - to - end trainable neural network for image-based sequence recognition and its application to scene text recognition[J] . 2015

特征提取层包含 CNN和 BLSTM,可进行端到端的训练。

RARE

( Robust text recognizer with Automatic Rectification)

43 Shi Baoguang, Wang Xinggang, Lyu Pengyuan, et al. Roust scene text recognition with automatic rectification CVPR2016

ESIR

44 ESIR: End - to - end scene text recognition via iterative image rectification CVPR2016

包含两部分,一个是迭代的文本校正网络 , 另一个是序列识别网络

What Is Wrong With Scene Text Recognition Model Comparisons? Dataset and Model Analysis (CVPR2019)

http://cn.arxiv.org/pdf/1904.01906v4

大佬写的综述类似物

2D Attention Network for Scene Text Recognition(2019)

继 Transformer-based-OCR 后又一篇基于语言、翻译模型架构的不规则文字识别的paper,主要贡献如下:

论文 http://cn.arxiv.org/pdf/1906.05708v1

attention部分使用多层双向transformer的block(BERT)替代了单transformer block;

label只用于计算loss,不用作网络输入,因此output过程是一次性输出整个字符串,精度和inference速度较之Transformer-based OCR都有所改善;

decoder部分串联了一个BERT attention模块,增强了输出节点间(每个字符作为一个节点)的依赖关系;

支持多行字符识别;

SEED (CVPR2020)

CVPR2020, SEED: Semantics Enhanced Encoder-Decoder Framework for Scene Text Recognition,中科院;国科大

Zhi Qiao, Yu Zhou, Dongbao Yang, Yucan Zhou, Weiping Wang

作者认为许多encoder-decoder模型都只利用了局部视觉特征而没有考虑全局的语义信息,无法处理遮挡,模糊.

文本识别可看做交叉形态的任务,语义信息可以减少专注于视觉特征的encoder和专注于语言信息的decoder之间的分歧。

1 使用NLP的词嵌入(word embedding)来进行监督。(监督编码模块,初始化解码模块)

2. 将ASTER方法整合进模型中

encoder decoder + attention + NLP的语义模型进行字符识别

使用FastText模型解决了Out-of-vocabulary(OOV)问题(OOV就是测试集中出现了训练集没有的单词组合)

NLP中FastText:

仅考虑字符级别,无法对于一个单词的高层次语义进行有效表征,因此NLP模型就考虑通过一个语句中的上下文信息来训练词嵌入模型。

FastText是一种skip-gram的词嵌入模型,简单而言就是通过一个词语来预测其上下文来训练一个词嵌入模型。

语义增强模型:四个部分

1 纠正模块,纠正倾斜文字。

2编码器:用于提取视觉特征,包括:45-layer的Resnet和2-layer的双向LSTM。它的输出是一个特征序列,shape为L x C,L是CNN最后一层特征width,C是depth

3语义模块:预测视觉特征的语义信息,语义特征序列又两个线性函数产生:

![]()

4解码器:用于记录最终的识别结果,使用Bahdanau-Attention mechanism,它包括一个GRU,有512 个隐藏单元和512个注意力单元。

Loss部分

SE-ASTER是端对端训练,loss函数如下:

![]()

Lrec是交叉熵loss,是目标的预测概率,Lsem就是cosine embeding loss预测语义信息。\lambda是超参数用于平衡两个loss,作者设定值为1.

![]()

S是预测的语义信息,em来自与FastText模型的词嵌入;

Towards Accurate Scene Text Recognition with Semantic Reasoning Networks(CVPR2020)

Towards Accurate Scene Text Recognition With Semantic Reasoning Networks国科大;百度;中科院

Deli Yu, Xuan Li, Chengquan Zhang, Tao Liu, Junyu Han, Jingtuo Liu, Errui Ding

代码https://github.com/chenjun2hao/SRN.pytorch

SRN四个组成部分:

1.Backbone

2.并行的视觉特征提取模型PVAM

3.全局语义推理模块GSRM

4.视觉语义融合的解码器VSFD

为了打破传统Attention机制的时间依赖特性,PVAM会针对文本行中的每个字符,计算出相应attention map ,通过将其与feature map逐像素加权求和,我们便得到每个目标字符对应的的视觉特征 。另外,PVAM也用字符的阅读顺序 取代上一时刻隐变量 来引导计算当前时刻的attention map ,如下公式。这样PVAM打破了时间依赖,实现了并行提取视觉特征的目的。

端到端 检测+识别

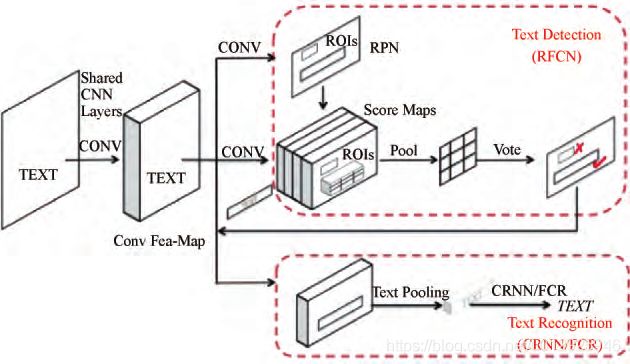

FOT

45 Liu Xuebo,Liang Ding,Yan Shi,et al. FOTS: Fast oriented text spotting with a unified network CVPR2018

端到端,检测识别共享卷积,引入旋转ROI,支持倾斜

STN—OCR

46 paper:Christian Bartz,Yang Haojin,Christoph Meinel. STN -OCR: A single neural network for text detection and text recognition[ CVPR) ,2017

内嵌STN等同于数据增强,半监督学习,只需标注文本内容,不需要文本位置信息

Integrated Framwork

47 Sui Wanchen, Zhang Qing, Yang Jun, et al. A novel integrated framework for learning both text detection and recognition ICPR 2018

MORAN

48 Luo Canjie,Jin Lianwen,Sun Zenghui. MORAN: A multi-object rectified attention network for scene text recognition 2019

校正自网络MORN+识别自网络ASRN。

MORN使用像素级弱监督,纠正形状

ASRN二者端到端学习,不需标记字符位置

AON

49 (Arbitrary Orientation Network)提取四个方向场景文本信息,,滤波门FG , Attention-Based解码,端到端训练

Cheng Zhanzhan,Xu Yangliu,Bai Fan,et al. AON: Towards arbitrarily - oriented text recognition 2018

数据集

大型图文识别训练和测 试 数 据 集 如 下 :

CTW( Chinese Text in the Wild) 数 据 集 [53 ] 、

RCTW - 17( Reading Chinese Text in the Wild) 数据集 [54 ] 、

ICPR MWI 2018 挑 战 赛 数 据 集 、

Total - Text 数 据 集 [55 ] 、

Google FSNS ( 谷 歌 街 景 文 本 数 据 集 ) 数 据 集 [56 ] 、

COCO -TEXT 数据集 [57 ] 、

Synthetic Data for Text Localization 自 然 场 景 文 本 数 据 [58 ] 、

Synthetic Word Dataset、

Caffe - ocr 中 文 合 成 数 据 、

ICDAR15 数 据[59 ]、

SVT - Perspective [60 ] 数据集和

CUTE80 [61 ] 数据集等 。

47]Sui Wanchen, Zhang Qing, Yang Jun, et al. A novel integrated framework for learning both text detection and recognition 2018

48 [ 48] Luo Canjie,Jin Lianwen,Sun Zenghui. MORAN: A multi-object rectified attention network for scene text recognition 2019

49 Cheng Zhanzhan,Xu Yangliu,Bai Fan,et al. AON: Towards arbitrarily - oriented text recognition 2018