逻辑回归( LogisticRegression)和线性支持向量机(LinearSVC)

最近在自学图灵教材《Python机器学习基础教程》,在csdn以博客的形式做些笔记。

线性分类模型

线性模型不仅用于回归问题,也广泛应用于分类问题。我们首先来看二分类。这时可以利用下面的公式进行 预测:

ŷ = w[0] * x[0] + w[1] * x[1] + …+ w[p] * x[p] + b > 0

这个公式看起来与线性回归的公式非常相似,但我们没有返回特征的加权求和,而是为预 测设置了阈值0。如果函数值小于 0,我们就预测类别 -1;如果函数值大于 0,我们就预测类别 +1。对于所有用于分类的线性模型,这个预测规则都是通用的。同样,有很多种不同的方法来找出系数(w)和截距(b)。 对于用于回归的线性模型,输出 ŷ 是特征的线性函数,是直线、平面或超平面(对于更高维的数据集)。对于用于分类的线性模型,决策边界是输入的线性函数。换句话说,(二元)线性分类器是利用直线、平面或超平面来分开两个类别的分类器。

线性模型有很多种算法。这些算法的区别在于以下两点: 系数和截距的特定组合对训练数据拟合好坏的度量方法;是否使用正则化,以及使用哪种正则化方法。

逻辑回归和线性支持向量机

最常见的两种线性分类算法是 Logistic 回归(logistic regression)和线性支持向量机(linear support vector machine,线性 SVM),前者在 linear_model.LogisticRegression 中实现, 后者在 svm.LinearSVC(SVC 代表支持向量分类器)中实现。

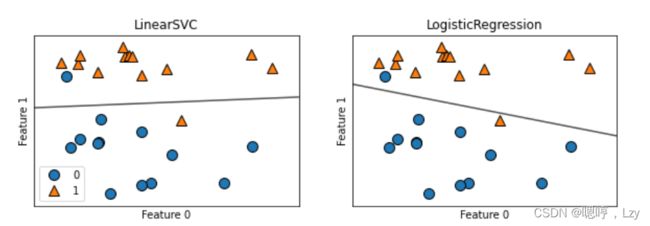

下面我们来看看这两个模型在同一数据上的决策边界情况

两个模型得到了相似的决策边界。注意,两个模型中都有两个点的分类是错误的。两个模 型都默认使用 L2 正则化,就像岭回归所做的那样。

对于 LogisticRegression 和 LinearSVC,决定正则化强度的权衡参数叫作 C。C 值越 大,对应的正则化越弱。换句话说,如果参数 C 值较大,那么 LogisticRegression 和 LinearSVC 将尽可能将训练集拟合到最好,而如果 C 值较小,那么模型更强调使系数向量 (w)接近于 0。

参数 C 还有另一个作用。较小的 C 值可以让算法尽量适应“大多数”数据点, 而较大的 C 值更强调每个数据点都分类正确的重要性。

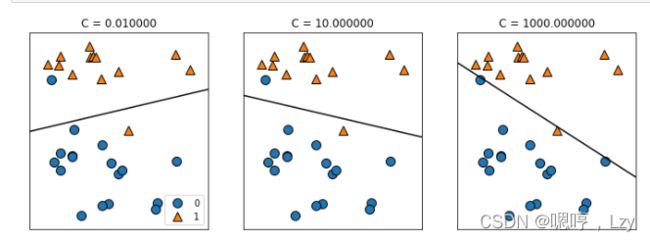

我们来看看不同的c对LinearSVC决策边界的影响

在左侧的图中,C 值很小,对应强正则化。大部分属于类别 0 的点都位于底部,大部分属 于类别 1 的点都位于顶部。强正则化的模型会选择一条相对水平的线,有两个点分类错 误。在中间的图中,C 值稍大,模型更关注两个分类错误的样本,使决策边界的斜率变大。 最后,在右侧的图中,模型的 C 值非常大,使得决策边界的斜率也很大,现在模型对类 别 0 中所有点的分类都是正确的。类别 1 中仍有一个点分类错误,这是因为对这个数据集 来说,不可能用一条直线将所有点都分类正确。右侧图中的模型尽量使所有点的分类都正 确,但可能无法掌握类别的整体分布。换句话说,这个模型很可能过拟合。

与回归的情况类似,用于分类的线性模型在低维空间中看起来可能非常受限,决策边界只 能是直线或平面。同样,在高维空间中,用于分类的线性模型变得非常强大,当考虑更多特征时,避免过拟合变得越来越重要。

多分类线性模型

许多线性分类模型只适用于二分类问题,不能轻易推广到多类别问题(除了 Logistic 回归)。将二分类算法推广到多分类算法的一种常见方法是“一对其余”(one-vs.-rest)方 法。在“一对其余”方法中,对每个类别都学习一个二分类模型,将这个类别与所有其 他类别尽量分开,这样就生成了与类别个数一样多的二分类模型。在测试点上运行所有 二类分类器来进行预测。在对应类别上分数最高的分类器“胜出”,将这个类别标签返回 作为预测结果。 每个类别都对应一个二类分类器,这样每个类别也都有一个系数(w)向量和一个截距 (b)。下面给出的是分类置信方程,其结果中最大值对应的类别即为预测的类别标签:

w[0] * x[0] + w[1] * x[1] + … + w[p] * x[p] + b

多分类 Logistic 回归背后的数学与“一对其余”方法稍有不同,但它也是对每个类别都有 一个系数向量和一个截距,也使用了相同的预测方法。

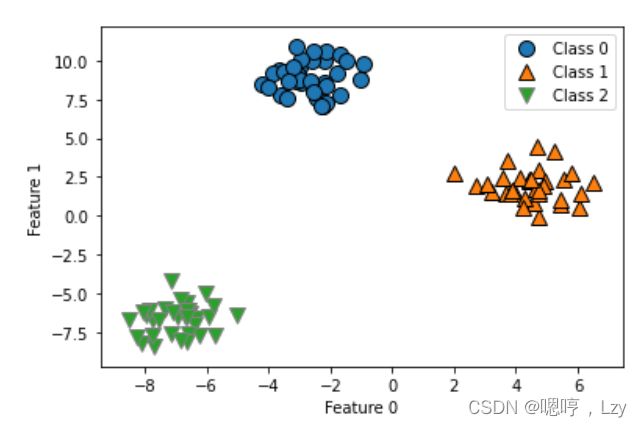

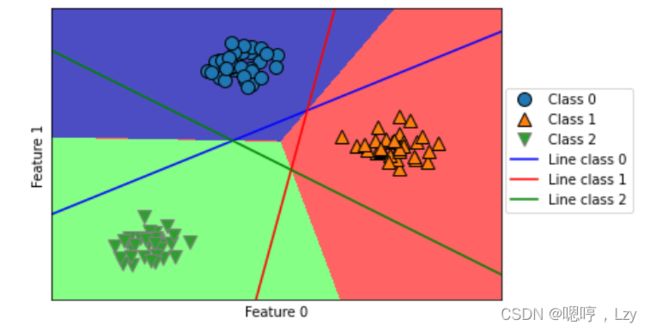

我们将“一对其余”方法应用在一个简单的三分类数据集上。我们用到了一个二维数据 集,每个类别的数据都是从一个高斯分布中采样得出的(该数据集来自sklearn.datasets)下图为该数据集的可视化:

现在,在这个数据集上训练一个 LinearSVC 分类器:

from sklearn.datasets import make_blobs

X, y = make_blobs(random_state=42)

linear_svm = LinearSVC().fit(X, y)

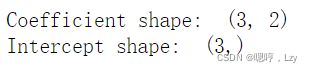

print("Coefficient shape: ", linear_svm.coef_.shape)

print("Intercept shape: ", linear_svm.intercept_.shape)我们看到,coef_ 的形状是 (3, 2),说明 coef_ 每行包含三个类别之一的系数向量,每列 包含某个特征(这个数据集有 2 个特征)对应的系数值。现在 intercept_ 是一维数组,保 存每个类别的截距。

你可以看到,训练集中所有属于类别 0 的点都在与类别 0 对应的直线上方,这说明它们位 于这个二类分类器属于“类别 0”的那一侧。属于类别 0 的点位于与类别 2 对应的直线上方,这说明它们被类别 2 的二类分类器划为“其余”。属于类别 0 的点位于与类别 1 对应 的直线左侧,这说明类别 1 的二元分类器将它们划为“其余”。因此,这一区域的所有点 都会被最终分类器划为类别 0(类别 0 的分类器的分类置信方程的结果大于 0,其他两个 类别对应的结果都小于 0)。 但图像中间的三角形区域属于哪一个类别呢,3 个二类分类器都将这一区域内的点划为 “其余”。这里的点应该划归到哪一个类别呢?答案是分类方程结果最大的那个类别,即最 接近的那条线对应的类别。

下图为二维空间中所有区域的预测结果:

总结

线性模型的主要参数是正则化参数,在回归模型中叫作 alpha(见岭回归(Ridge)和Lasso 回归),在 LinearSVC 和 LogisticRegression 中叫作 C。alpha 值较大或 C 值较小,说明模型比较简单。特别是对于回归模型 而言,调节这些参数非常重要。通常在对数尺度上对 C 和 alpha 进行搜索。你还需要确定 的是用 L1 正则化还是 L2 正则化。如果你假定只有几个特征是真正重要的,那么你应该用 L1 正则化,否则应默认使用 L2 正则化。如果模型的可解释性很重要的话,使用 L1 也会 有帮助。由于 L1 只用到几个特征,所以更容易解释哪些特征对模型是重要的,以及这些 特征的作用。 线性模型的训练速度非常快,预测速度也很快。这种模型可以推广到非常大的数据集,对 稀疏数据也很有效。如果你的数据包含数十万甚至上百万个样本,你可能需要研究如何使 用 LogisticRegression 和 Ridge 模型的 solver='sag' 选项,在处理大型数据时,这一选项 比默认值要更快。其他选项还有 SGDClassifier 类和 SGDRegressor 类。 线性模型的另一个优点在于,利用我们之间见过的用于回归和分类的公式,理解如何进 行预测是相对比较容易的。不幸的是,往往并不完全清楚系数为什么是这样的。如果你的数据集中包含高度相关的特征,这一问题尤为突出。在这种情况下,可能很难对系数做出解释。 如果特征数量大于样本数量,线性模型的表现通常都很好。它也常用于非常大的数据集, 只是因为训练其他模型并不可行。但在更低维的空间中,其他模型的泛化性能可能更好。