挑战 Google 搜索?OpenAI 发布最强 AI 对话系统 ChatGPT

GPT-3 发布的两年后,我们没等来它的亲弟弟 GPT-4,而是在今天亲眼见证了 OpenAI 带来了一种全新的 AI 聊天机器人——ChatGPT,也可以称之为是 GPT-3 家族里面的亲戚,它不仅可以解释代码、编写情景喜剧脚本,也可以为用户的查询提供对话式回答,而且回答几乎能够满足网友的”小心思“。

目前,ChatGPT 处于测试阶段(chat.openai.com),只要有 OpenAI 账户就可以免费使用。万万没想到,此超级对话模型一经开放,很多人便深陷其中,无法自拔。就连 OpenAI 背后的投资者马斯克不忘调侃一句,”很多人疯狂地陷入了 ChatGPT 循环中。“

ChatGPT 的背后

对此,我们不禁好奇,ChatGPT 到底有什么样的魔力,吸引这么多人去尝试?它与 GPT-3 又有什么不同之处?

根据 OpenAI 官方介绍,与 GPT-3 最大的不同应该就是 ChatGPT 提供了一个用户友好的对话界面,并且非常有道德,即可以强烈限制一些有害的输出,如暴力、脏话等不当的请求。

ChatGPT 是 InstructGPT 的兄弟模型,它被训练为在提示中遵循指令并提供详细的响应。

之前了解过 OpenAI 的工程师们,想必对 InstructGPT 还有印象。今年年初,OpenAI 为了好好调教 GPT-3,便给它带来了”调教师“—— InstructGPT,它采用了”从人类反馈中强化学习“(RLHF)来训练这个模型,可以让彼时的 GPT-3 输出的更为准确。

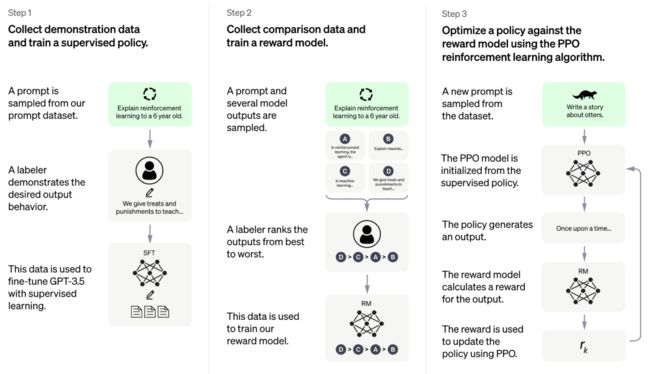

最新的 ChatGPT 使用的方法与 InstructGPT 相同,也是使用了 RLHF,有些不同的地方主要体现在数据收集设置上。

对此,OpenAI解释道,”ChatGPT 使用监督微调训练了一个初始模型:人类 AI 培训师提供对话,他们在对话中扮演双方--用户和 AI 助手。AI培训师通过由模型生成的建议,以帮助 AI 不断调整回复的内容。“

当然,为了创建一个用于强化学习的奖励模型,OpenAI 也需要收集比较数据,其中包括两个或更多按质量排名的模型回复。为了收集这些数据,OpenAI 收集了 AI 培训师与聊天机器人的对话,并随机选择了一个模型编写的消息,抽查了几个备选的回复,再让 AI 培训师对这些回复进行排名。此外,利用这些奖励模型,这项研究使用近似策略优化算法对模型进行微调,并对这个过程进行了多次迭代。

根据官方介绍,ChatGPT 是对 GPT-3.5 系列中的一个模型微调而成,该模型在 2022 年初完成了训练。值得注意的是,ChatGPT 和 GPT-3.5 是在 Azure AI 超级计算基础设施上训练的。

百态横生的 ChatGPT,玩出新花样

到目前为止,很多人对 ChatGPT 进行了各种测试,发现了各种潜在的用途。比如说:

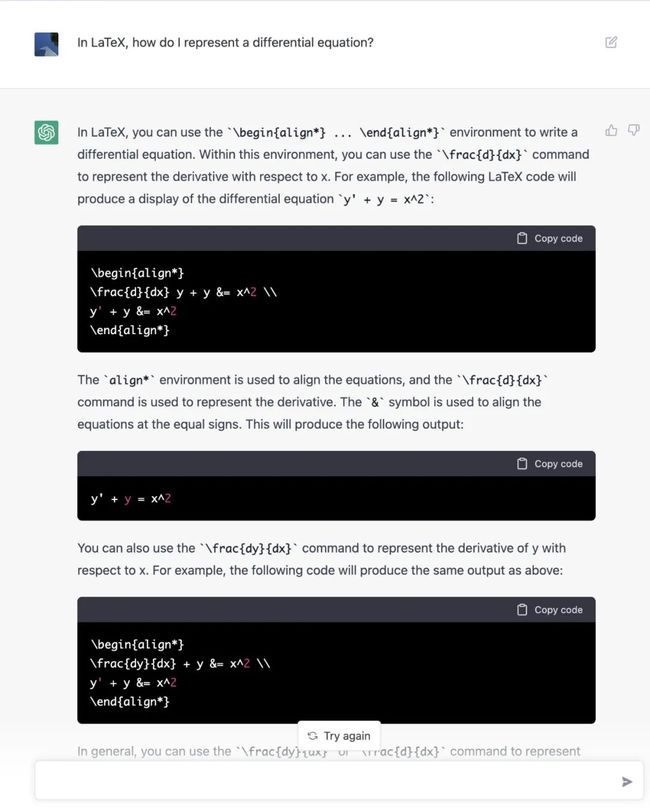

它可以是程序员得力小助手,帮助开发者解决编码问题:

就像这样:

甚至还能解释冒泡排序算法:

它也是很好的调试小伙伴,程序员再也不用害怕 Debug 了?

它也能充当诗人。当问及”能否写一首关于埃隆-马斯克接管 Twitter 的押韵诗?“时,它能流畅自然地分享道(不知大家能打几分):

埃隆·马斯克现在至高无上

在 Twitter,他是终极国王

他拇指一弹就发推文

他的追随者想要屈服

充满想法和计划的头脑

他总是大步前进

......

对艺术家也有一定的启发:

还能进入影视圈,写写剧情脚本:

另外,它也能”一本正经“地解释各种科学概念,比如说”热力学“:

甚至它还能写一篇学术论文。当然在学术圈的论文上面,还是不建议大家使用的,或许接下来 ChatGPT 也会成为高校老师们颇为头疼的产品工具。

除此之外,根据 OpenAI 分享的官方示例中,其表示还能为日常提供一些实质性的建议。

用户:帮我写一封简短的说明,向我的邻居介绍自己。

ChatGPT:

你好呀,

我的名字是 [你的名字],我刚搬到隔壁。我想伸出手来介绍自己。我期待着认识你和附近的人。如果您有任何需要或只是想聊天,请随时过来或给我打电话。

最好的,

[你的名字]

用户:你能让它更正式吗?

ChatGPT:

亲爱的邻居,

我写信是为了自我介绍。我的名字是 [你的名字],我最近搬到了隔壁。我想花点时间伸出手打个招呼。我期待着结识您和附近地区。

如果有什么我可以做的好邻居,或者如果您有任何需要,请随时告诉我。我很乐意尽我所能提供帮助。

此致,[你的名字]

用户:你能帮我寄吗?

ChatGPT:

很抱歉,我是一个基于文本的 AI 助手,没有能力为您发送一封实体信件。我只能提供关于写什么的建议和建议。您可以接受该建议并自己发送这封信。

可以说上知天文下知地理,前能写代码,后能编剧本,ChatGPT 比 GPT-3 强得不止这些。

局限性与挑战

当然,现实来看,ChatGPT 毕竟依然是由人训练出来的,其虽然智能,但也依然避不开一些无厘头以及错误。

在 Twitter 上,当计算生物学教授CarlBergstrom要求 ChatGPT 写一篇关于他生活的维基百科条目时,ChatGPT沉着冷静地做到了这一点,但不妨碍它写的内容里面包含了几个完全虚假的传记细节。

针对这种错误,OpenAI 也在官方公告中强调,当前的 ChatGPT 存在一定的局限性,其直言「想要完全解决这个问题是非常有挑战性的」,因为:

(1) 在 RL 训练期间,目前没有真实世界的数据来源;

(2) 模型被训练得更加谨慎,导致它拒绝回答它可以正确回答的问题;

(3) 监督训练误导了模型,因为理想的答案取决于模型知道什么,而不是人类演示者知道什么。

ChatGPT 对输入措辞的调整或多次尝试同一”提示“很敏感。例如,给定一个问题的措辞,模型可以声称不知道答案,但只要对问题的措辞稍加修改,它就可以给出正确回答。

该模型的回答内容往往过分啰嗦,并过度使用某些短语。例如重申它是由 OpenAI 训练的语言模型。这些问题来自于训练数据的偏差(训练者更喜欢看起来更全面的长篇答案)和众所周知的过度优化问题。

理想情况下,当用户提供了一个模棱两可的问题时,模型会提出质疑。然而与之相反的现实是,如今的模型往往会猜测用户的意图。

对此,OpenAi 解释称,「虽然我们已经努力使模型拒绝不适当的请求,但它有时会对有害的指令作出回应或给出有偏见的回答。我们正在使用 Moderation API 来警告或阻止某些类型的不安全内容,但我们预计它目前不一定会立即见效。因此,我们渴望收集用户的反馈,以帮助我们正在进行的工作,改善这个系统。」

将向 Google 搜索发起挑战?

尽管如此,不可否认的是,ChatGPT 的输出质量似乎比之前 GPT-3 模型有了显著的改进,而且回答的内容覆盖多维度,甚至在一定程度上,可以直面”搜索引擎“与”问答社区“。

为此,也有网友将 Google 和 ChatGPT 进行了对比:

其分别在 Google 搜索和 ChatGPT 中提出了同一个问题:

几番比对下来,这位网友表示,Google 的搜索结果都可以不用贴上来了,因为这些问题在它的平台上没有什么好的结果。与此同时,其附上了来自 ChatGPT 详细的结果。

虽然对于这样的结果,来自 Google 母公司 Alphabet 的一位工程师 @hncel 解释道:

我在 Alphabet 工作,最近我去参加了一个内部技术讲座,是关于在谷歌部署这样的大型语言模型。作为免责声明,我首先要说明这不是我的专业领域,我只是参加了这个技术讲座,因为它听起来很有趣。

像 GPT 这样的大型语言模型是谷歌在 ML 维度主要研究的领域之一,而且有大量相当明显的应用,它们可以被用来回答查询、索引信息等。

在谷歌,有一个巨大的预算,用于配备人员来研究这些类型的模型并进行实际的训练,这非常昂贵,因为需要大量的计算能力来训练这些超级巨大的语言模型。然而,我从讲座中了解到,在谷歌最大的产品(如搜索、Gmail)中实际使用这些语言模型的经济性还不太成熟。放置一个演示,让感兴趣的人们玩玩是一回事,但如果考虑到服务成本、增加的延迟以及像谷歌搜索本身收入已经接近无限小的事实,试图将它深入地整合到一个每天提供数十亿次请求的系统中是另一回事。我想我记得演讲者说过这样的话:在将这样的模型整合到搜索等产品中之前,他们至少要将成本降低 10 倍。

在未来几年,10 倍甚至 100 倍的改进显然是一个可实现的目标,所以我认为这样的技术将在未来几年出现。

就现下而言,ChatGPT 的出现,是否会在未来短短几年内吸引大量使用 Google 搜索这类工具的开发者、创作者、设计者们,或许还需要看看 ChatGPT 正式上线之后的效果,我们也将拭目以待。

参考:

https://openai.com/blog/chatgpt/

https://news.ycombinator.com/item?id=33817682

https://www.theverge.com/23488017/openai-chatbot-chatgpt-ai-examples-web-demo