OFT论文精读

一、前期准备

3D目标检测集合:https://blog.csdn.net/unbekannten/article/details/127989929

Orthographic Feature Transform for Monocular 3D Object Detection

论文地址:https://arxiv.org/abs/1811.08188

代码地址:https://github.com/tom-roddick/oft

二、核心思想

(有点类似于基于体素的网格法)

2.1 引入基于透视图像的特征映射为鸟瞰图视角的正交特征变换,并使用积分图像对平均池化进行高效处理;

2.2 构建了DL结构用于预测单目RGB图像目标的3D框;

2.3 强调3D推理在目标检测任务中的重要性

三、相关工作

暂略

四、本文方法

网络架构

通过投影提取正交特征的方式:将卷积网络对图像卷积得到的特征,经过3D到2D的投影和平均池化的操作取到3D鸟瞰图上,从而构成3D鸟瞰图的特征图。即可在该特征图上回归各种3D目标属性。

1、前端由Resnet特征提取器来提取输入图像的多尺度特征图;

2、一种正交特征变换,它将每个尺度上基于图像的特征转换为鸟瞰图的正交表述法

3、一种由一系列Resnet残差单元组成的自上而下的网络,它以不受图像中观察到的透视效果影响的方式来处理鸟瞰视角的特征图;

4、一组输出分别生成每个对象类和每个类别在地平面的位置,置信度得分,位置偏移量,尺度偏移量和方向向量

5、非极大值抑制和解码阶段,该阶段识别出峰值,并生成离散边界框预测

4.1 特征提取

利用Resnet生成多级多尺度特征图

4.2 正交特征变换

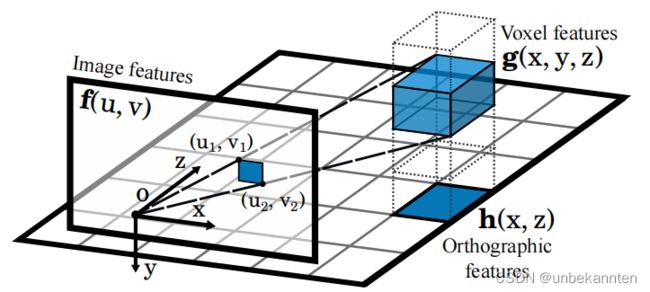

OFT目的是用前端特征提取器提取的基于图像的特征f(u,v) 中的n维特征填充到3D体素特征图g(x, y, z)。立体像素特征图定义在一个均匀间隔的3D网格 G,它与地平面距离是固定的,在相机坐标 y0以下,维度为W,H,D,体素大小为 r 。对于给定的体素网格位置 (x, y, z) (不能确定是否是体素中心点),通过对对应与体素的2D投影的图像特征图 f的区域进行特征累加,得到体素特征 g(x, y, z)。一般情况下,每一个体素(大小为r 的立方体)都会投射到像平面上的六边形区域,作者用一个矩形包围框来近似它。

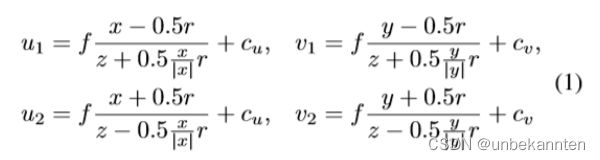

其中左上角 (u1, v1),右下角(u2,v2)坐标如下:

其中, f 是相机焦距,(cu,cv)是图像坐标系原点

然后,可以通过在图像特征图f 中投影的体素包围框(上面说的近似矩形包围框)上进行平均池化,将该特征值分配到体素特征图 g 中的适当位置。

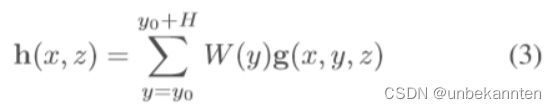

将3D体素特征图分解到另一个2D表示图上,我们称为正交特征图 h(x,z). 正交特征图是通过将学习得到的权重矩阵沿着垂直轴与体素特征图相乘后求和得到:

在转换到最终正交特征图之前的中间体素表述的优点是保留了场景的垂直配置信息,这对于随后的任务,例如估计目标边界框的高度和垂直位置来说是至关重要的。

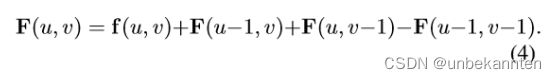

利用一个基于积分图的快速平均池化操作。积分图 F, 由输入特征图 f 用如下递归方式得到:

给定积分特征图 F, 由(u1,v1)和(u2,v2)定义的边界框,其对应的输出特征为 g(x,y,z) :

4.3 自上而下的网络

使用ResNet风格的skip连接,它在之前描述的OFT阶段生成的2D特征图 h 上运行

4.4 置信度预测

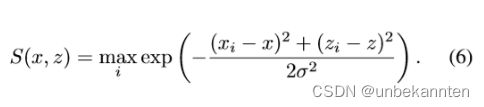

置信度图S(x,z)是个平滑函数,它表示在(x,y0,z)位置是否存在以该位置为中心带边界框的目标存在可能性。其中y0 表示在相机下方距离地面的距离。给定N个真实目标的真实边界框中心 pi=[xi,yi,zi]^T, i=1,…,N,我们计算GT置信度图为一个平滑的高斯区域,其以目标中心为中心,宽度为\sigma,在位置(x,z)置信度公式为:

网络置信度图预测分支头使用 L1 loss来训练的,回归到正交网格 H上每个位置的GT 置信度上。由于正样本(高置信度的位置)要远远少于负样本,为了克服该问题,作者引入常量因子0.01 ,将其乘以负样本位置(S(x,z)得分<0.05的位置)这样减少大量负样本的影响。

4.5 位置和检测框的预测

在对应的目标pi 的中心追加了一个额外的网络输出,输出头可以预测距离地面网格单元位置(x, y0, z)的相对偏移

尺寸输出,预测目标 i 的尺寸 di=[wi, hi, li]和给定类别所有目标的平均尺寸![]() 之间的对数尺度偏移 :

之间的对数尺度偏移 :

方向输出,预测目标绕y轴的方向角\theta _i 的sin和cos值:

注意,因为我们在正交鸟瞰图空间,我们能直接预测绕y轴的方向角θ(全剧角),不像其他人的工作考虑角度和相对视角的问题预测所谓的观察角度α的影响。文中的位置偏移、尺寸偏移、方向向量 都是用 L1 loss训练的。

4.6 非极大值抑制

在三维世界中,两个物体不能占据相同体积,这意味着置信度图上的峰值是分离的。为了减轻噪音对预测的影响,我们首先用高斯核(其宽度为\sigma _N_M_S)来平滑置信度图

五、损失函数

暂略

六、实验实施

暂略

七、相关参考链接

https://zhuanlan.zhihu.com/p/277948425

https://blog.csdn.net/zyw2002/article/details/127906810

https://blog.csdn.net/c20081052/article/details/99540933

https://zhuanlan.zhihu.com/p/60117934