【20210713】【机器/深度学习】Python SVM模型学习笔记

一、处理步骤

(参考:【机器学习】python使用支持向量机SVM)

第一步:导入 svm 模块

from sklearn import svm第二步:导入数据集

data = np.loadtxt(filename, dtype=float, delimiter=',', converters=None)

# ===== 【loadtxt 库函数常用的参数有:】======

# filename:文件路径,例 path='F:/Python_Project/SVM/data/Iris.data'

# dtype:样本的数据类型 例 dtype=float

# delimiter:分隔符。例 delimiter=','

# converters:将数据列与转换函数进行映射的字典。例 converters={4:Iris_label}含义是将第5列的数据对应转换函数进行转换。第三步:划分训练集和测试集

data_x, label_y = np.split(data, indices_or_sections=(4,), axis=1) # data_x是数据,label_y是标签

train_data, test_data, train_label, test_label = sklearn.model_selection.train_test_split(data_x, label_y, random_state=1, train_size=0.6, test_size=0.4)

# 1. np.split(数据,分割位置,轴=1(水平分割) or 0(垂直分割))。

# 2. sklearn.model_selection.train_test_split 随机划分训练集与测试集。

#

# train_test_split(train_data, train_label, test_size=数字, random_state=0)

#

# 【参数解释】

# train_data:所要划分的样本特征集

# train_label:所要划分的样本类别

# test_size:样本占比,如果是整数的话就是样本的数量.(注意:)

# -- test_size:测试样本占比。 默认情况下,该值设置为0.25。 默认值将在版本0.21中更改。 只有train_size没有指定时,它将保持0.25,否则它将补充指定的train_size,例如train_size=0.6,则test_size默认为0.4。

# -- train_size:训练样本占比。

# random_state:是随机数的种子。随机数种子:其实就是该组随机数的编号,在需要重复试验的时候,保证得到一组一样的随机数。比如你每次都填1,其他参数一样的情况下你得到的随机数组是一样的。但填0或不填,每次都会不一样。随机数的产生取决于种子,随机数和种子之间的关系遵从以下两个规则:种子不同,产生不同的随机数;种子相同,即使实例不同也产生相同的随机数。第四步:训练 SVM 分类器

classifier = svm.SVC(C, kernel=, gamma, decision_function_shape=''ovr)

classifier.fit(train_data, train_label.ravel())

# 【参数解释】

# kernel='linear'时,为线性核。C 越大,分类效果越好,但有可能会过拟合(defaul C=1)。

# kernel='rbf'时(default),为高斯核。gamma值越小,分类界面越连续;gamma值越大,分类界面越“散”,分类效果越好,但有可能会过拟合。

# decision_function_shape='ovr'时,为 one v rest(一对多),即一个类别与其他类别进行划分,

# decision_function_shape='ovo'时,为 one v one(一对一),即将类别两两之间进行划分,用二分类的方法模拟多分类的结果。第五步:计算准确率

# 方法一:使用 model.score

train_score = classifier.score(train_data, train_label)

test_score = classifier.score(test_data, test_label)

# 方法二:使用 accuracy_score

from sklearn.metrics import accuracy_score

train_label_pre = classifier.predict(train_data)

test_label_pre = classifier.predict(test_data)

train_score = accuracy_score(train_label, train_label_pre)

test_score = accuracy_score(test_label, test_label_pre)

# 实际上,classifier.score() 内部也是先 predict 得到 test_label_pre, 然后调用了 accuracy_score(test_label, test_label_pre) 方法来计算准确率的。第六步:查看决策函数

train_decision_function = classifier.decision_function(train_data)

train_label_pre = classifier.predict(train_data)第七步:结果可视化

二、完整代码

# 第一步:导入 svm 模块

from sklearn import svm

from sklearn.metrics import accuracy_score

import sklearn

import numpy as np

import matplotlib

from matplotlib import pyplot as plt

# 第二步:读取数据集

def Iris_label(s):

it = {b'Iris-setosa': 0, b'Iris-versicolor': 1, b'Iris-virginica': 2}

return it[s]

filename = 'D:\Program Files (x86)\PyCharm\PyCharm Community Edition 2021.1.1\My project\learn Algorithm\learn SVM\iris.data'

data = np.loadtxt(filename, dtype=float, delimiter=',', converters={4:Iris_label})

# 第三步:划分训练集和测试集

data_x, label_y = np.split(data,indices_or_sections=(4,), axis=1) # x为数据,y为标签

data_x = data_x[:, 0:2]

train_data, test_data, train_label, test_label = sklearn.model_selection.train_test_split(data_x, label_y, random_state=1, train_size=0.6, test_size=0.4)

# 第四步:训练 SVM 分类器

classifier = svm.SVC(C=2, kernel='rbf', gamma=10, decision_function_shape='ovr')

classifier.fit(train_data, train_label.ravel())

# 第五步:计算 svc 分类器的准确率

# ====== 方法一:classifier.score ======

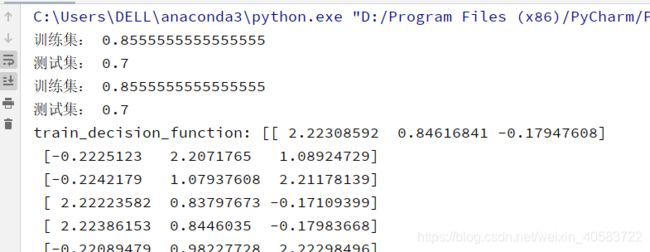

print('训练集:', classifier.score(train_data, train_label))

print('测试集:', classifier.score(test_data, test_label))

# ===== 方法二:accuracy_score =====

train_label_pre = classifier.predict(train_data)

test_label_pre = classifier.predict(test_data)

print('训练集:', accuracy_score(train_label, train_label_pre))

print('测试集:', accuracy_score(test_label, test_label_pre))

# 第六步:查看内部决策函数(返回的是样本到超平面的距离)

train_decision_function = classifier.decision_function(train_data)

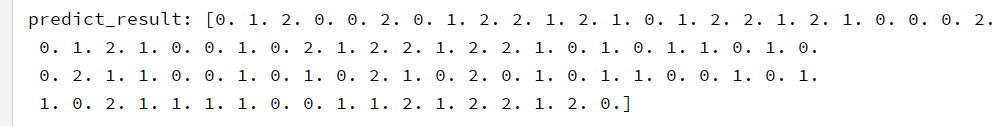

predict_result = classifier.predict(train_data)

print('train_decision_function:', classifier.decision_function(train_data))

print('predict_result:', classifier.predict(train_data))

# 第七步:绘图

# 确定坐标轴范围

x1_min, x1_max = data_x[:, 0].min(), data_x[:, 0].max() # 第0维特征的范围

x2_min, x2_max = data_x[:, 1].min(), data_x[:, 1].max() # 第1维特征的范围

x1, x2 = np.mgrid[x1_min:x1_max:200j, x2_min:x2_max:200j] # 生成网络采样点

grid_test = np.stack((x1.flat, x2.flat), axis=1) # 测试点

# 指定默认字体

matplotlib.rcParams['font.sans-serif'] = ['SimHei']

# 设置颜色

cm_light = matplotlib.colors.ListedColormap(['#A0FFA0', '#FFA0A0', '#A0A0FF'])

cm_dark = matplotlib.colors.ListedColormap(['g', 'r', 'b'])

grid_hat = classifier.predict(grid_test) # 预测分类值

grid_hat = grid_hat.reshape(x1.shape) # 使之与输入的形状相同

plt.pcolormesh(x1, x2, grid_hat, cmap=cm_light) # 预测值的显示

plt.scatter(data_x[:, 0], data_x[:, 1], c=label_y[:, 0], s=30, cmap=cm_dark) # 样本

plt.scatter(test_data[:, 0], test_data[:, 1], c=test_label[:, 0], s=30, edgecolors='k', zorder=2,

cmap=cm_dark) # 圈中测试集样本点

plt.xlabel('花萼长度', fontsize=13)

plt.ylabel('花萼宽度', fontsize=13)

plt.xlim(x1_min, x1_max)

plt.ylim(x2_min, x2_max)

plt.title('鸢尾花SVM二特征分类')

plt.show()运行结果:

三、知识点

1.