matlab无参考图像质量评价,无参考屏幕内容图像质量评价

1 引言

1.1 研究背景及意义

随着计算机和移动互联网技术的快速发展, 多屏互动[、视频游戏[、远程教育等多客户端通信系统也得到了飞速的发展.在这类系统中, 各类终端之间可以相互通信, 以实现屏幕内容图像(终端设备绘制并显示在屏幕上的视觉内容, 包括网页、邮件、地图、动画、文档和图像等)的分发和处理.与传统自然图像相比, 屏幕内容图像包含的多媒体形式更多, 蕴含着较多的信息, 具有非常大的应用价值.例如, 消费者可以在好友圈中直播购物体验, 并直接分享商品的图片和文字介绍信息; 汽车追尾现场, 事主可直接分享手机摄像头内容给车险理赔员, 远程完成理赔的认定和文件签署; 远程教育中, 教师可实时批阅学生的随堂练习并完成答疑等.屏幕内容图像一般同时包含图像和文本[.传统的自然图像和屏幕内容图像的例子如

图 1

Fig. 1

Fig. 1 Examples of traditional natural images and screen content images

图 1 传统自然图像和屏幕内容图像的示例

在实时多客户端通信系统中, 屏幕内容图像的分发和处理通常涉及到获取、压缩[和传输等环节.然而, 由于系统资源有限, 各类处理环节都可能在屏幕内容图像中引入失真, 影响用户体验.例如, 在图像获取过程中, 由于视频采集设备的缺陷, 屏幕内容图像包含噪声; 由于硬件设备资源的约束, 屏幕内容图像的分辨率有限.在带宽约束下, 屏幕内容图像的压缩处理会引入压缩失真, 降低图像的视觉质量.在传输过程中, 比特位错误会引起图像内容的随机丢失, 引入难以预测的失真.以上失真会影响屏幕内容图像的画质, 进而影响到用户体验.当前图像质量评价的研究主要针对传统自然图像, 为了能够反映系统中各环节对最终用户体验的影响, 进而实现系统优化的目的, 需要研究和设计针对屏幕内容图像的质量评价方法.

1.2 图像质量评价方法研究现状

图像质量评价方法分为主观评价方法和客观评价方法[55-.主观评价方法由观察者来对图像评分, 一般采用平均主观得分(mean opinion score, 简称MOS)或平均主观得分差异(differential mean opinion score, 简称DMOS)作为失真图像的质量指标.观察者是图像视觉信息的最终接收者, 因此主观评价方法是最准确的方法.但是, 主观评价方法需要耗费大量人力、物力以及时间代价并且不能嵌入到实时系统, 因此, 它主要在建立标准数据库时使用.客观评价方法是由相应的计算模型计算得到图像的质量指标.客观评价方法在计算机视觉和图像处理等领域中扮演着重要角色.一些图像处理和传输系统的参数需要根据图像的质量来进行调节, 可以将客观评价方法嵌入到系统之中实时地优化系统的参数.图像检索系统可以根据图像的质量来排列检索的结果.图像处理算法的性能可以根据图像质量来评估, 因此客观评价方法可以作为图像处理算法的基准.客观评价方法也可以动态监测和调节图像处理系统输出图像的质量.

客观评价方法根据所需无失真参考图像信息量的多少进一步可以分为全参考(full reference, 简称FR)方法、部分参考(reduced reference, 简称RR)方法和无参考(no reference, 简称NR)方法.全参考方法在计算失真图像的质量指标时需要获取失真图像的整幅无失真参考图像的全部信息, 通过对比计算二者的差异得到失真图像的质量指标.部分参考方法在计算失真图像的质量指标时不需要整幅无失真参考图像的全部信息, 仅需从无失真参考图像中提取的某些特征信息即可.无参考方法不需要无失真参考图像的任何信息即可计算失真图像的质量指标.由于没有无失真参考图像, 无参考方法是这3类方法中最困难的方法.

当前图像质量评价研究的重点是传统自然图像, 针对屏幕内容图像质量评价的研究较少.传统自然图像质量评价的全参考方法经过几十年的发展已具有坚实的理论基础和许多成熟的评价算法.其中, 思想最简单且应用最广泛的是均方误差算法(MSE)和峰值信噪比算法(PSNR), 这两种算法直接将失真图像对应于无失真参考图像的像素差异作为失真图像的质量指标.虽然这两种方法计算简便、快捷, 但是它们计算得到的结果与人的视觉感知相关性较低.Chandler等人通过对人类视觉系统的认知并建模提出了VSNR[算法.Wang等人提出的SSIM[算法将计算得到的无失真参考图像和失真图像的结构相似度作为失真图像的质量指标.在文献[[方法.

部分参考方法多用于通信系统中.在发送端提取无失真参考图像的部分信息, 比如特征等, 然后将这部分信息通过辅助信道传送到接收端或者先将这部分数据以水印的形式嵌入到发送端的无失真参考图像之后, 再与无失真参考图像一起传送到接收端以节省带宽.对于在接收端收到的失真图像, 提取同样的信息.最后将在发送端提取的无失真参考图像的信息和接收端提取的失真图像的信息结合起来计算失真图像的质量指标.

传统自然图像质量评价无参考方法可以分为针对如模糊、噪声和块状效应等特定失真类型的方法及通用的方法.针对特定失真类型利用到了特定失真的某种特性, 它们因此也只能用于计算受到特定失真影响的失真图像的质量指标.然而, 在现实应用情景中, 失真绝不会仅局限于某种特定的失真, 因此, 这类无参考方法的应用范围有限.但通用的方法可以应用于多种失真类型, 并且进行简单的扩充之后, 通用的方法就具有针对新的失真类型的能力.通用的方法主要分为基于自然场景统计[的方法和基于学习或训练[的方法.

理论研究发现自然场景具有某些统计特性, 当失真存在时会改变这些统计特性, 并且不同的失真以及不同的失真程度对统计特性的改变也不同.基于自然场景统计的方法将失真图像偏离自然场景统计特性程度的多少作为失真图像的质量指标.Moorthy等人提出的DIIVINE[方法首先对图像进行小波变换, 然后对变换得到的系数进行统计分布的拟合, 并将得到的系数作为特征.Liu等人提出的SSEQ[方法首先将图像划分为许多小块, 然后分别在这些小块上计算特征, 最后将在所有小块上计算得到的特征聚集起来进行池化得到统计特征.这类方法在计算得到特征后再利用回归方法建立起特征与失真图像质量分数之间的关系.

基于学习或训练的方法与基于自然场景统计的方法类似, 但其直接提取与图像质量相关的特征, 而不是自然场景统计特征, 最后利用支持向量机或神经网络等机器学习技术建立起图像特征和图像质量指标之间的关系.Li等人[首先提取与图像质量相关的相位一致性、熵和梯度等特征, 然后利用广义回归神经网络建立起图像特征和图像质量指标之间的关系.Ye等人首先利用提取的40维的Gabor特征向量集构建码本, 然后将码字直方图作为图像特征建立起与图像质量指标之间的关系, 基于此而提出了CODEBOOK[方法.Gao[等人受到机器学习排序思想的启发, 先从可明显区分的图像对入手提取差特征向量, 然后利用多核学习算法建立起差特征向量和图像质量指标之间的关系, 该方法的明显优点是不需要图像的主观得分(MOS或DMOS).

目前, 屏幕内容图像质量评价的研究还处于起步阶段, Yang[等人构建了第一个大规模屏幕内容图像质量评价数据库SIQAD.基于此数据库, 他们得出屏幕内容图像的文本区域和图像区域带给人的视觉感知特性是不同的这一结论.基于此结论, 他们提出了分开考虑文本区域和图像区域, 针对屏幕内容图像的全参考方法SPQA. Ni等人[基于图像梯度的局部信息提取梯度方向特征, 提出了针对屏幕内容图像的GSS全参考方法.Gu[等人利用简单的卷积操作凸显失真引起的结构失真以及失真更容易引起的显著性区域这一结论而提出了SQMS全参考方法.Wang等人[根据屏幕内容图像不同于自然图像的视觉感知特性提出了RRS部分参考方法.

综上可以得出结论:目前针对屏幕内容图像的研究还较少, 并且提出的方法大部分都是全参考方法.在许多应用情景中很难获取无失真参考图像, 因此, 屏幕内容图像的无参考评价方法研究就变得非常有意义.

本文第2节介绍IML-SCIQD数据库的构建过程, 主要包括参考图像和失真类型的选取、主观评价方法的确认、具体实验的进行以及最后主观数据的处理.第3节介绍本文提出的针对屏幕内容图像的无参考算法的相关细节.具体有图像区域和文本区域的划分、不同区域的统计特征以及提取的区域统计特征等细节.第4节介绍进行算法评估时所用到的数据库以及最后的评估结果.最后对本文工作进行总结并提出未来的展望.

2 IML-SCIQD数据库的构建

2.1 标准图像质量评价数据库的重要性及概况

标准图像质量评价数据库的建立是客观图像质量评价算法研究的基础, 新提出的算法需要在数据库上进行性能评估, 不同的算法也需要在数据库上进行性能优劣比较.目前, 图像质量评价的研究主要还是针对传统自然图像, 针对屏幕内容图像的研究还处在起步阶段.因此, 目前已公开发表的图像质量评价数据库大部分都是针对传统自然图像的, 例如LIVE数据库[、CSIQ数据库[、TID 2008数据库[、TID 2013数据库[.SIQAD数据库是目前唯一一个公开发表的大规模屏幕内容图像数据库[.

LIVE数据库包含29幅参考图像和经过5种失真处理的779幅失真图像, 数据库中失真图像的主观分数为DMOS.TID 2008数据库包含25幅参考图像和经过17种失真类型处理的1 700幅失真图像.数据库中失真图像的主观分数为MOS.TID 2013数据库是TID 2008数据库的扩展, 它包含25幅参考图像和经过24种失真类型处理的3 000幅失真图像.数据库中失真图像的主观分数为MOS.CSIQ数据库包含30幅参考图像和经过6种失真类型处理的866幅失真图像.数据库中失真图像的主观分数为DMOS.SIQAD数据库包含20幅参考图像和经过7种失真类型处理的980幅失真图像.数据库中失真图像的主观评分为DMOS.SIQAD数据库中参考图像的来源主要有新闻网页、电子杂志、幻灯片和PDF文件等.在真实的应用环境中, 可能出现各种各样的情况, 单一数据库难以覆盖.因此, 屏幕内容图像质量评价数据库的构建就显得非常有必要.

图像质量评价数据库的构建通常涉及到参考图像的选取, 失真类型的确定和失真图像的生成, 主观评价方法的选取、主观实验平台的搭建以及招募主观实验人员进行主观实验, 最后将得到的初始主观数据进行处理得到失真图像的主观分数.

2.2 IML-SCIQD数据库概况

IML-SCIQD数据库包含25幅参考图像以及25幅参考图像经过10种失真每种失真5个失真等级处理的1250=25×10×5幅失真图像.这25幅参考图像都是通过屏幕截图得到的, 它们主要来自于社交网站、购物网站、生活服务网站、电子地图、电子杂志、PDF文件、幻灯片、电影、动画和新闻网页等, 因此, 参考图像的视觉内容具有一定的代表性.25幅参考图像视觉内容布局和分辨率也不尽相同.IML-SCIQD数据库中的10种失真类型是:(1) JPEG压缩(JPEG); (2) JPEG 2000压缩(JP2K); (3)高斯模糊(GB); (4)运动模糊(MB); (5)高斯白噪声(GWN); (6)椒盐噪声(SPN); (7)乘性噪声(MN); (8)对比度变化(CC); (9) JPEG 2000比特流经过快速衰落瑞丽信道时产生的比特位传输错误(FF); (10)屏幕内容压缩(SCC).

10种失真类型既包含了传统自然图像相关应用中经常遇到的失真, 也包含了屏幕内容图像所特有的失真.第1种~第9种失真经常出现在与自然图像相关的应用中, 当然也会出现在屏幕内容图像中.例如, 图像获取、图像压缩、图像传输等.这9种失真也经常被其他数据库选作失真类型.最后一种失真是为提高屏幕内容压缩效率而特别针对屏幕内容而设计的压缩算法.

2.3 主观实验

选择合适的主观实验方法是获得稳定主观实验结果的重要基础.国际电信联盟(ITU)[推荐了几种不同的主观评价方法, 不同的方法适用于不同的情景.这些方法可以大致分为单刺激方法和双刺激方法.对于单刺激方法, 在进行主观实验时, 每次屏幕上仅出现1幅图像供实验者评分.但是对于双刺激方法, 在进行主观实验时, 每次屏幕上会出现两幅图像, 它们是同一幅图像的不同失真版本, 实验者仅需判断这两幅图像是否有视觉感知差异或哪一幅图像的视觉感知更好或更差即可.但当需要评估的图像数量较大时, 需要对比的图像对的数量将难以接受.为了操作方便, 本文选用单刺激连续质量评估方法(SSCQE)作为主观实验方法.每次只有1幅图像显示在屏幕上, 主观实验者需要根据他自己的视觉感知, 在一个连续的区间内对图像进行评分.

WEST[开源软件平台为从多个地点上的多个设备上收集主观数据提供了解决方案, 其优点是多个主观实验者可以同时参加主观测试, 只要他们参加测试的设备满足实验条件且连接在实验的本地服务器上即可.它原本是为视频数据设计的, 本文对其进行简单修改之后作为本次主观实验的软件平台.主观实验的一大缺点是耗时, 随着WEST软件平台的应用将大大缩短主观实验的时间.在本文的主观实验中, 所有参考图像也被包含在主观测试之中, 因此整个主观实验过程一共有1 275幅图像需要进行评分.这1 275幅图像根据参考图像被划分为5个子集, 每个子集有255幅图像, 也就是5幅参考图像以及与其对应的失真图像.每一位参加实验的人员必须一次完成一个子集中所有255幅图片的评分.完成一个子集的评分工作大概耗时30分钟左右.每位实验者必须完成所有5个子集的评分工作.为了防止实验者的疲劳对实验数据造成的影响, 一个实验者完成的两个子集评分之间的时间间隔必须大于1小时.

本次实验招募的35位实验者均来自于深圳大学的研究生和本科生, 年龄在18岁~28岁之间.他们都没有图像处理和图像质量评价的相关经验.在正式的实验开始之前, 每一位实验者都将接受简单的培训, 以此向他们介绍图像质量评价的背景以及如何对图像评分.整个主观实验在4台安装有WIN 7操作系统和谷歌CHROME网络浏览器的台式机上并行进行.所有实验图像都以原始分辨率在联想LT2223wA LED显示器上加以显示.

实验者登录WEST本地服务器之后, 可开始一个子集的实验, 之后, 子集中的255幅图像会一张接一张地出现, 直到这个子集中的最后一幅图像.每当出现一幅图像, 实验者观看后鼠标单击图像即可出现

图 2

Fig. 2

Fig. 2 Quality judgement interface of subjective experiment

图 2 主观实验评分界面

2.4 数据处理

在得到初始主观数据之后, 为了使得主观分数能够更好地表示图像的视觉感知质量, 初始主观数据还要根据文献[Sijk表示主观实验人员i对在子集k中失真图像j的初始主观评分.第1步将每一个子集内的初始主观评分Sijk转变为差异分数dijk:

$

{d_{ijk}} = {S_{i{j_{ref}}k}} - {S_{ijk}}

$

(1)

这里, Sijk表示主观实验人员i对子集k内的失真图像j对应的参考图像的初始主观评分.接下来, 我们将每个子集内的差异分数dijk转变为z分数zijk:

$

{\mu _{ik}} = \frac{1}{{250}}\sum\nolimits_{j = 1}^{250} {{d_{ijk}}}

$

(2)

$

{\sigma _{ik}} = \frac{1}{{250}}\sum\nolimits_{j = 1}^{250} {{{({d_{ijk}} - {\mu _{ijk}})}^2}}

$

(3)

$

{z_{ijk}} = \frac{{({d_{ijk}} - {\mu _{ijk}})}}{{{\sigma _{ik}}}}

$

(4)

每个子集内失真图像的总数是250.最后, 我们可以得到一个z分数矩阵, 行是主观实验人员的索引, 列是失真图像的索引.

并不是所有主观实验人员的评分数据都是可信的, 不可信的主观人员的评分数据将会对最后得到的失真图像的主观评分对失真图像视觉感知的表示带来偏差.得到z分数矩阵之后, 本文采用文献[z分数数据(即上述得到的z分数矩阵的对应的某一行)是否服从正态分布.这可以通过计算该行数据的峰度值得到, 如果计算得到的峰度值位于2~4以内, 则认为该实验人员的评分数据服从正态分布, 这时, 若实验人员给出的1 250幅失真图像中多于5%的评分数据位于相对于数据均值2倍的标准差的范围之外, 则丢弃该实验人员的全部数据.反之, 则保留.如果实验人员的主观评分数据的峰度值不在区间2~4以内, 即不服从正态分布, 这时, 若实验人员给出的1 250幅失真图像多于5%的数据位于相对于数据均值4.47倍的标准差的范围之外, 则丢弃该实验人员的全部数据.反之, 则保留.经过上述处理, 本次实验招募的35位实验人员中有3个人的数据被丢弃.为了使得最后得到的失真图像的主观分数位于区间1~100以内, 本文对最后丢弃相应主观实验人员评分数据后的z分数矩阵进行简单的线性变换, 使得z分数矩阵中的数据均位于区间1~100以内.数据库中失真图像最后的主观评分DMOS可以通过以下公式计算得到:

$

DMO{S_j} = \frac{1}{{32}}\sum\nolimits_{i = 1}^{32} {{z_{ij}}}

$

(5)

至此, 整个数据库的构建工作全部完毕.

图 3

Fig. 3

Fig. 3 Histogram of quality scores of distorted images in the IML-SCIQD database

图 3 IML-SCIQD数据库中失真图像质量分数的直方图

3 NSNRS无参考算法

3.1 算法框架

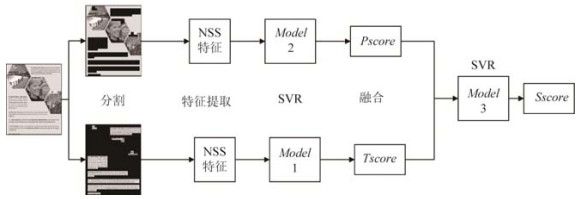

屏幕内容图像的文本区域和图像区域带给人的视觉感受是不同的, 这一点已在文献中得到证实.本文进一步发现图像区域和文本区域的统计特性也是不同的, 甚至对于同一区域, 当图像区域或者文本区域遭受不同失真的时候, 这一区域的统计特性也是不同的.基于上述结论以及自然场景统计的无参考算法的思想, 本文提出了针对屏幕内容图像的NSNRS无参考算法.算法框架如

图 4

Fig. 4

Fig. 4 Framework of our proposed no reference metric

图 4 本文提出的无参考算法框架

本文提出的方法是基于学习的, 因此包含训练和测试阶段.在训练阶段训练, Model 1, Model 2和Model 3一共3个模型.Model 1是文本区域质量分数模型, 用来预测文本区域的质量分数.Model 2是图像区域质量分数模型, 用来预测图像区域质量分数.Model 3是结合模型, 用来结合文本区域和图像区域的质量分数而得到失真图像的质量分数.NSNRS无参考算法首先将屏幕内容图像划分为图像区域和文本区域, 然后在划分的两个区域上分别提取自然场景统计特征, 区域的具体划分后面会加以介绍.在每一个区域上, 用提取的自然场景统计特征以及对应的整幅失真图像的主观质量分数DMOS, 利用支持向量回归(support vector regression, 简称SVR)可以训练得到Model 1和Model 2.反过来, 分别在两个区域上提取的自然场景统计特征还要再次输入, 利用它们训练的对应的模型来得到训练集中失真图像文本区域和图像区域的质量分数T_score和P_score.将T_score和P_score组合成二维向量, 将它们对应的整幅失真图像的主观质量分数DMOS作为标签, 利用支持向量回归可以训练得到Model 3.

在测试阶段, 首先, 屏幕内容图像同样被划分为图像区域和文本区域.然后, 分别在两个区域上提取与训练阶段同样的统计特征.将提取的统计特征输入Model 1或Model 2就可以得到两个区域的质量分数.最后, 将得到的两个区域的质量分数组合成二维向量输入到Model 3, 就可以得到失真图像的质量分数.

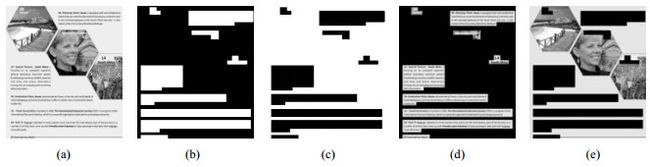

3.2 图像区域和文本区域的划分

本文基于文献[T.给定一幅屏幕内容图像, 其文本区域索引图T是与屏幕内容图像的灰度图一样大小的矩阵, 本文的工作都是在灰度级上进行的.在文本区域, 索引图T中对应着屏幕内容图像中文本区域的值全为1, 其他地方的值全为0.得到屏幕内容图像的文本区域索引图之后, 可以非常容易地得到屏幕内容图像的图像区域索引图P, 它仅仅是屏幕内容图像文本区域索引图的取反, 也就是屏幕内容图像文本区域索引图T中1值变0值, 0值变1值就可以得到对应的屏幕内容图像的图像区域索引图P.当得到屏幕内容图像的文本区域索引图和图像区域索引图之后, 文本区域和图像区域可以通过相应的区域索引图和屏幕内容图像的点积得到.一幅屏幕内容图像和对应的文本区域索引图、图像区域索引图以及文本区域和图像区域如

图 5

Fig. 5

Fig. 5

图 5

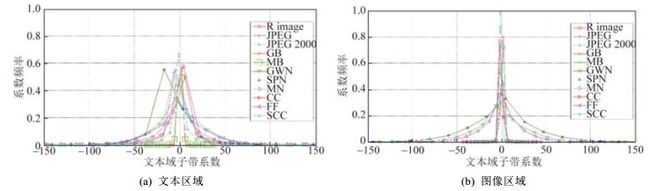

3.3 图像区域和文本区域的统计差异性

屏幕内容图像不同于自然图像, 它一般同时包含图像和文本, 然而人们对这两个区域的视觉感知是不一样的.为了探究屏幕内容图像文本区域和图像区域的统计差异性, 本文选择了IML-SCIQD数据库中的一幅参考图像以及与其对应的10幅分别经过10种失真类型最高失真级别处理的失真图像.该参考图像如

图 6

Fig. 6

Fig. 6 Reference image selected for research of statistical properties

图 6 选作统计特性研究的参考图像

图 7

Fig. 7

Fig. 7 Histogram of transform coefficients of textual region and pictorial region of screen content image and corresponding 10 distorted ones

图 7 屏幕内容图像以及与其对应的10种失真图像的文本区域和图像区域变换系数的直方图

从

3.4 算法中提取的自然场景统计特征

目前已有大量基于自然场景统计思想的算法被提了出来, 因而在这些算法中包含了各种各样的自然场景统计特征.自然场景统计特征的设计非常耗时, 而且需要足够强大的背景知识.本文没有自己设计自然场景统计特征, 而是选取他人的适合于本文的自然场景统计特征.正如上面提到的划分得到的区域图像中存在大量的零灰度值, 这会严重影响提取的特征对区域图像视觉感知质量的表示, 因此, 选取的自然场景统计特征应该可以较好地避开这些零值的影响.就如本文在探究屏幕内容图像文本区域和图像区域统计特性时所做的那样.

不论是文本区域图像还是图像区域图像, 本文都提取同样的90个自然场景统计特征.这90个自然场景统计特征来自于4种经典的基于自然场景统计的无参考评价方法:SSEQ、BLIINDS-Ⅱ[、BIQI[和BRISQUE[.SSEQ方法提取12个自然场景统计特征, BLIINDS-Ⅱ方法提取24个自然场景统计特征, BIQI方法提取18个自然场景统计特征, BRISQUE方法提取36个自然场景统计特征.这些特征可以排除大量零灰度值的影响.

SSEQ算法先将图像分为许多小块, 之后分别在每个小块上计算特征, 然后将在所有小块上计算得到的相同的特征聚成一个向量, 最后对得到的特征向量进行池化, 将池化后得到的特征作为图像最后的特征.为了摆脱零灰度值的影响, 在提取SSEQ方法的特征时, 在图像小块上计算完特征之后, 先丢弃那些图像小块上计算得到的零值或奇异值特征, 这是因为, 由包含大量零值的图像小块计算得到的特征肯定也是零值或是一些奇异值.在丢弃这些图像小块上计算得到的零值或奇异值特征之后, 再进行最后的池化操作, 这样就可以摆脱零值的影响.BLIINDS-Ⅱ方法也是先将图像分为许多小块, 然后分别在这些小块上计算特征, 最后将在所有小块上计算得到的相同的特征聚成一个向量进行池化, 以得到最后的特征.这里摆脱上面提到的零灰度值的影响的方法与SSEQ方法一样.

BIQI方法先将图像在3个尺度和3个方向上进行小波变换, 然后将变换得到的系数利用广义高斯分布进行拟合, 最后将广义高斯分布拟合得到的参数作为特征.为了摆脱上面提到的零灰度值的影响, 在提取BIQI方法的特征时, 对于图像小波变换之后的系数先丢弃那些零值和奇异值系数, 再去进行拟合, 这是因为, 区域图像矩阵中大量的零灰度值经过小波变换后会产生大量零值和奇异值, 这样就可以摆脱零灰度值的影响.BRISQUE方法和BIQI方法类似, 只不过它没有将图像先进行类似于小波变换这样的频域处理, 而只是在空间域中进行了相应的处理, 然后将处理得到的系数进行拟合, 最后将拟合的系数作为特征.为了摆脱上面提到的零灰度值的影响, 在提取BRISQUE方法的特征时的处理方法与BIQI方法类似, 这里不再赘述.

4 实验结果

4.1 测试数据库及评估标准

为了探究提出的无参考算法的性能, 本文将提出的NSNRS无参考算法与12种客观评价算法在IML-SCIQD数据库以及SIQAD数据库上进行了性能对比, 这12种客观评价算法分别是:(1) GSS; (2) SQMS; (3) RSS; (4) PSNR; (5) FSIM; (6) SSIM; (7) VIF; (8) SSEQ; (9) BIQI; (10) DIIVINE; (11) BLIINDS-Ⅱ; (12) BRISQUE.前两种算法是专门针对屏幕内容图像的全参考评价方法, 第3种算法是专门针对屏幕内容图像所提出来的部分参考评价算法, 第4种~第7种是经典的针对自然图像提出来的全参考算法, 最后5种是经典的基于自然场景统计的无参考评价算法.IML-SCIQD数据库包含参考图像25幅, 10种失真类型, 每种失真类型又有5个失真等级, 因此一共有25×10×5=1250幅失真图像.SIQAD数据库包含参考图像20幅, 7种失真类型, 每种失真类型又有7个失真等级, 因此一共有20×7×7=980幅失真图像.这7种失真类型是:(1)高斯噪声(GN); (2)高斯模糊(GB); (3)运动模糊(MB); (4)对比度变化(CC); (5) JPEG压缩(JPEG); (6) JPEG 2000压缩(JPEG 2000);(7)基于层划分的压缩(LSC).前6种失真经常出现在与自然图像相关的应用中, 最后一种失真是为提高屏幕内容压缩效率的压缩算法.

人是图像视觉信息的最终接收者, 客观评价方法性能的评估需要通过对比客观评价算法预测得到的质量分数和主观分数的相关性而得到.本文用到的评估标准有斯皮尔曼等级相关系数(the Spearman rank-order correlation coefficient, 简称SROCC)、皮尔森线性相关系数(Pearson product-moment correlation coefficient, 简称PLCC)和根均方误差(root mean square error, 简称RSME).斯皮尔曼等级相关系数衡量算法预测的单调性, 其值位于0~1之间, 值越大表示算法的性能越好.皮尔森线性相关系数衡量算法预测值与主观分数之间的线性相关程度, 其值位于0~1之间, 值越大表明算法的性能越好.根均方误差衡量算法预测值和主观分数之间的绝对差异, 值越小表明算法的性能越好.

4.2 结果分析

所有参与比较的12种客观算法的源代码均来自于相关作者和项目的网站.因为本文所提出的算法和最后5种方法都是基于学习的算法, 因此在数据库上进行测试时, 数据库中80%的失真图像用于训练, 20%的失真图像用于测试.在IML-SCIQD数据库上进行测试时, 20幅参考图像对应的失真图像用于训练, 剩下的5幅参考图像对应的失真图像用于测试.在SIQAD数据库上进行测试时, 16幅参考图像对应的失真图像用于训练, 剩下的4幅参考图像对应的失真图像用于测试.由于图像内容的不同可能对算法的性能产生影响, 因此, 这种根据图像内容而进行的训练和测试集划分随机进行1 000次, 最后所有1 000次的平均性能作为算法最后的性能.因为本文提出的算法是基于学习的, 我们使用LIBSVM软件包实现SVR[.在Model 1和Model 2的训练中, 使用径向基核函数.在Model 3的训练中使用线性核函数.

为了消除主观评价过程中的非线性以及便于不同的图像质量评价算法之间的性能对比, MATLAB中的非线性最小二乘回归函数nlinfit被用来先将客观算法的预测分数映射到DMOSp, 然后再与主观分数进行相关系数的计算.映射函数是具有5个参数的逻辑斯蒂函数:

$

DMO{S_p} = \frac{{{p_1}}}{2} - \frac{{{p_1}}}{{1 + \exp ({p_2} \cdot (q - {p_3}))}} + {p_4} \cdot q + {p_5}

$

(6)

p1, p2, p3, p4和p5是逻辑斯蒂函数的参数.

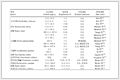

在IML-SCIQD数据库和SIQAD数据库上的测试结果分别见

表 1(Table 1)

Table 1 Test result on the IML-SCIQD database

表 1 IML-SCIQD数据库上的测试结果

Distortion

GSS1

SQMS1

RRS2

PSNR3

FSIM3

SSIM3

VIF3

SSEQ4

BIQI4

DIIVINE4

BLIINDS-Ⅱ4

BRISQUE4

NSNRS

SROCC

JPEG

0.821

0.888

0.788

0.851

0.863

0.899 1

0.906 3

0.2533

0.243 8

0.110 5

0.331 7

0.155

0.461 8

JP2K

0.867 7

0.946 3

0.887 2

0.917 4

0.943 5

0.922 2

0.945 7

0.3758

0.137 2

0.225 1

0.589 8

0.385 2

0.636 9

GB

0.932 5

0.918 8

0.952 7

0.892

0.887

0.938 4

0.925 3

0.1377

0.744 4

0.607 4

0.202

0.697

0.624 2

MB

0.886 5

0.864 8

0.944 9

0.778 3

0.785 9

0.919 8

0.847 5

0.1348

0.621 6

0.574 3

0.163 6

0.623 2

0.576 5

GWN

0.847 2

0.916 9

0.922 8

0.882 8

0.849 6

0.904

0.918 6

0.8197

0.907 7

0.810 8

0.694 2

0.886 3

0.884 8

SPN

0.278 6

0.862 3

0.862 3

0.778 5

0.737 3

0.842 4

0.847 9

0.7693

0.826 7

0.755 9

0.659 7

0.816

0.868

MN

0.796

0.862

0.889 4

0.804 3

0.827 9

0.824

0.872 5

0.7184

0.856 6

0.729

0.629 4

0.796 9

0.835 5

CC

0.219 3

0.493 7

0.438

0.606 7

0.554 2

0.257 9

0.485 3

0.2006

0.514 5

0.361 5

0.166 7

0.189 5

0.398 7

FF

0.680 7

0.860 5

0.763 9

0.839 8

0.877 1

0.857 8

0.869 4

0.517

0.322 5

0.329

0.363 8

0.405 4

0.543 4

SCC

0.726 5

0.817 7

0.736 7

0.797 1

0.794 2

0.792 7

0.809 1

0.13

0.155 3

0.182

0.178

0.225 8

0.266 4

ALL

0.833 1

0.890 6

0.842 3

0.762 1

0.807 9

0.881 4

0.862 9

0.5597

0.665 6

0.630 3

0.555

0.651 6

0.731 6

PLCC

JPEG

0.837

0.902 3

0.825 6

0.719 9

0.872

0.891 5

0.941 3

0.3426

0.266 5

0.224 2

0.444 7

0.225 8

0.439 2

JP2K

0.884 7

0.961 4

0.894 9

0.841 1

0.953 1

0.930 2

0.956 8

0.4063

0.256

0.288 6

0.594 1

0.405 1

0.645 8

GB

0.952 5

0.932 4

0.969 9

0.777 7

0.885 7

0.957 7

0.945 2

0.2313

0.780 6

0.622 4

0.337

0.744 2

0.661 4

MB

0.898 1

0.890 2

0.950 6

0.783 9

0.803 5

0.921

0.876 5

0.2046

0.616 6

0.565 8

0.282 9

0.655 7

0.586 5

GWN

0.872 7

0.959

0.954 5

0.949 4

0.934 1

0.944 7

0.960 1

0.8709

0.942 2

0.902 2

0.72

0.942 2

0.903 9

SPN

0.678 3

0.901 1

0.891 4

0.870 7

0.808 9

0.882 6

0.893 3

0.8123

0.897 6

0.832 4

0.724 4

0.895 2

0.899 2

MN

0.88

0.940 3

0.945

0.917 7

0.923 9

0.919 4

0.948 9

0.7863

0.901 7

0.848 1

0.677 8

0.850 9

0.821 7

CC

0.292 1

0.597 9

0.430 4

0.739 4

0.685

0.379 7

0.505 2

0.2438

0.694 7

0.500 9

0.226

0.251 7

0.615 6

FF

0.86

0.942 6

0.914 9

0.915 8

0.951 8

0.940 1

0.940 3

0.6439

0.422 6

0.398 2

0.491 5

0.429 4

0.648 2

SCC

0.816 8

0.897 2

0.814 9

0.873 4

0.905 7

0.868 1

0.931 4

0.2081

0.225 9

0.242 5

0.317 1

0.273 3

0.387 4

ALL

0.863 8

0.897 5

0.856 3

0.777 6

0.815 6

0.886 1

0.871 9

0.5921

0.455 1

0.567 1

0.556 3

0.602 4

0.710 3

RMSE

JPEG

4.164 9

3.281 1

4.295 4

5.282 7

3.725 8

3.448 7

2.570 4

6.8723

7.080 6

7.211 4

6.558 5

7.272 4

6.552 3

JP2K

5.754 8

3.396 6

5.507 5

6.676 9

3.737 1

4.530 5

3.587 4

10.768

11.68 7

11.384

9.193 1

10.751

8.743 5

GB

3.254

3.861

2.603 4

6.715 4

4.959 6

3.074 4

3.487 7

10.218

6.053 8

7.285 6

9.735 2

6.604 4

7.462 9

MB

3.655 6

3.786 3

2.581 2

5.161

4.947 9

3.238

4.000 7

7.9817

6.082 4

6.066 6

7.754 1

5.767 3

6.368 6

GWN

5.242 9

3.042 6

3.203 8

3.373 5

3.834 5

3.520 9

3.001 7

4.8147

3.323 1

4.381 9

6.814 8

3.173 3

3.589 1

SPN

5.877 6

3.469 1

3.625 2

3.939 6

4.703 7

3.760 2

3.596

4.2604

3.360 9

4.164 6

5.145 5

3.393

3.337 3

MN

4.725 7

3.385 6

3.254 6

3.954 1

3.807 4

3.914 4

3.140 1

5.7079

3.480 8

5.047 5

6.833 8

4.502 8

4.267 6

CC

6.281 2

5.264 4

5.928 4

4.421 5

4.785

6.075 8

5.667 8

6.1562

4.192 4

4.976 2

6.247 3

6.143 9

4.703 6

FF

5.875 1

3.845 2

4.647 1

4.625 1

3.532 8

3.923 5

3.917 3

8.1352

9.814 9

9.957 1

9.301 6

9.665 9

7.926 6

SCC

4.493 8

3.440 2

4.514 7

3.793 6

3.301 6

3.865 8

2.835

7.4015

7.414

7.255 6

7.050 3

7.208 1

6.870 8

ALL

6.170 8

5.401 7

6.325 7

7.699 9

7.086 3

5.675 8

5.996 7

9.2651

9.589

9.186 3

9.489

8.963

8.045 7

说明:注1为针对屏幕内容图像的全参考评价算法; 注2为针对屏幕内容图像所提出来的部分参考评价算法; 注3为经典的针对自然图像提出来的全参考算法; 注4为经典的基于自然场景统计的无参考评价算法

Table 1 Test result on the IML-SCIQD database

表 1 IML-SCIQD数据库上的测试结果

表 2(Table 2)

Table 2 Test result on the SIQAD database

表 2 SIQAD数据库上的测试结果

Distortion

GSS1

SQMS1

RRS2

PSNR3

FSIM3

SSIM3

VIF3

SSEQ4

BIQI4

DIIVINE4

BLIINDS-Ⅱ4

BRISQUE4

NSNRS

SROCC

GN

0.852

0.886

0.866 4

0.879

0.737 3

0.869 4

0.888 8

0.816 1

0.870 9

0.878 7

0.780 2

0.887 5

0.855 4

GB

0.904 9

0.914 9

0.871 5

0.857 3

0.728 6

0.892 1

0.905 9

0.809 6

0.812 9

0.862 6

0.703 8

0.871 5

0.892 5

MB

0.839

0.869 5

0.843 4

0.713

0.664 1

0.804 1

0.849 2

0.774 1

0.661 9

0.840 7

0.501 8

0.865 3

0.825 3

CC

0.449 7

0.694 9

0.529 1

0.682 8

0.717 5

0.640 5

0.643 3

0.215 4

0.414 4

0.386 8

0.333 8

0.313 5

0.461 8

JPEG

0.795 9

0.789 3

0.760 5

0.756 9

0.587 9

0.757 6

0.792 4

0.321

0.327 3

0.292 2

0.219 8

0.220 8

0.466 4

JP2K

0.813 7

0.819 4

0.661 7

0.774 6

0.636 3

0.760 3

0.813 1

0.269 2

0.443 4

0.491 5

0.498 4

0.301 8

0.584 4

LSC

0.814 2

0.829 3

0.711 6

0.793

0.597 9

0.737 1

0.846 3

0.193 8

0.230 2

0.217 4

0.185 9

0.184 4

0.412 6

ALL

0.835 6

0.880 3

0.765 5

0.560 4

0.527 9

0.756 6

0.806 5

0.569 6

0.639 5

0.655 8

0.526

0.662 2

0.737 4

PLCC

GN

0.879 9

0.900 4

0.879 8

0.905 3

0.742 8

0.880 6

0.901 1

0.827 2

0.884 6

0.904 4

0.727 2

0.904 5

0.871 7

GB

0.908 5

0.912 6

0.881

0.860 3

0.720 6

0.901 4

0.910 2

0.826 9

0.84

0.869 6

0.695 8

0.890 9

0.910 4

MB

0.839 9

0.867 3

0.846 5

0.704 4

0.687 4

0.806

0.849

0.786 5

0.682 9

0.841 2

0.515 5

0.857 1

0.839 6

CC

0.61

0.802 7

0.681 2

0.740 1

0.750 7

0.743 5

0.707 6

0.307 7

0.533 2

0.522 2

0.445 2

0.541 7

0.554 4

JPEG

0.793 5

0.785 7

0.763 8

0.754 5

0.556 6

0.748 7

0.798 6

0.414 9

0.323 3

0.337 8

0.319 8

0.288 7

0.492

JP2K

0.820 8

0.826 3

0.680 7

0.789 3

0.667 5

0.774 9

0.820 5

0.363 7

0.49

0.515 2

0.512 1

0.350 9

0.595

LSC

0.806 8

0.812 5

0.711

0.780 5

0.596 4

0.730 7

0.838 5

0.337 8

0.279

0.287 6

0.258 6

0.286 5

0.442 4

ALL

0.851 5

0.887 2

0.801 4

0.586 9

0.538 9

0.756 1

0.819 8

0.595

0.492 1

0.520 5

0.534 6

0.359 1

0.784 8

RMSE

GN

7.085 8

6.490 6

7.089 5

6.337 2

9.986

7.067 9

6.467 3

7.507

6.350 9

6.150 4

9.006 5

6.013 7

6.957 7

GB

6.341

6.204 1

7.179 2

7.737 6

10.523

6.570 1

6.285 9

7.958 9

7.617 2

6.935 2

9.934 5

6.479 2

5.931 6

MB

7.054 7

6.472 2

6.921 2

9.228 7

9.443 2

7.696 7

6.870 4

7.541 6

8.815 2

6.515 8

10.353

6.198 2

6.676 3

CC

9.966 6

7.501 3

9.208 4

8.459 1

8.319

8.411 6

8.887 6

11.486

9.817 4

9.586 9

10.65

9.966

9.694 2

JPEG

5.717 7

5.812 4

6.065 4

6.166 5

7.807 2

6.229 5

5.655 1

8.134 3

8.388 3

8.412 7

8.443 9

8.603 7

7.572 3

JP2K

5.935 5

5.854

7.614 1

6.381 9

7.740 4

6.569 1

5.941 2

8.988 2

8.202 3

8.154 1

7.983 5

9.094

7.422 6

LSC

5.039 7

4.973 3

5.999 2

5.333 6

6.848 6

5.825 3

4.649 7

7.716

7.852 8

7.854 2

7.980 3

7.871 2

7.266 2

ALL

7.504 5

6.603 9

8.562

11.589

12.058

9.367 6

8.196 9

10.888

11.287

10.871

11.538

11.717

8.694 1

说明:注1为针对屏幕内容图像的全参考评价算法; 注2为针对屏幕内容图像所提出来的部分参考评价算法; 注3为经典的针对自然图像提出来的全参考算法; 注4为经典的基于自然场景统计的无参考评价算法

Table 2 Test result on the SIQAD database

表 2 SIQAD数据库上的测试结果

5 总结与展望

目前屏幕内容图像质量评价的研究还处于起步阶段, SIQAD数据库是目前仅有的一个大规模的屏幕内容图像质量评价数据库, 单一数据库难以覆盖实际应用中出现的各种可能的情况.图像质量评价数据库是客观图像质量评价算法研究的基础, 本文因此首先构建了一个大规模的具有一定代表性的屏幕内容图像质量评价数据库IML-SCIQD.在参考图像的视觉内容、视觉内容分布以及失真类型种类等属性上, IML-SCIQD数据库都具有一定的代表性.IML-SCIQD数据库中所有失真图像的质量分数覆盖了分数区间的大部分区域, 这说明, IML-SCIQD数据库中的失真图像都考虑到了各种可能的失真等级的情况.通过对失真图像主观质量分数和失真参数之间关系的分析, 本文了解到图像的视觉质量与图像的视觉内容之间具有一定的关系.在进行屏幕内容图像相关课题, 如针对屏幕内容图像的压缩算法的研究时需要将其考虑进来.

基于在构建IML-SCIQD数据库过程中的主观经验, 本文进一步证实了屏幕内容图像的文本区域和图像区域带给人们的视觉感知特性的不同, 并且发现屏幕内容图像的文本区域和图像区域的统计特性也是不同的.单个区域的统计特性在不同失真情况下所受到的影响也随之变化.与12种客观评价算法的性能对比表明, 本文提出的算法与5种无参考评价算法相比在性能上有一定提升.相比7种全参考算法, 本文提出的算法的性能虽然还有一定差距, 但仍然具有相当的性能, 并且在个别情况之下的性能甚至超越了全参考方法.

本文利用基于自然场景统计的无参考方法的思想来评估单个区域的视觉质量, 以后的工作中可以考虑其他的方法.将屏幕内容图像分区域分析是考虑到了各自区域不同的视觉感知特性.未来的工作中可以从屏幕内容图像整体的视觉感知特性出发.深度学习方法目前已被广泛应用于计算机视觉、语音识别、自然语言处理、音频识别与生物信息学等领域, 并获取了令人满意的效果.未来的工作中运用深度学习的方法来进行屏幕内容图像质量评价的研究也是一个不错的方向.