【图像超分辨率】Deep Learning for Multiple-Image Super-Resolution

Deep Learning for Multiple-Image Super-Resolution

-

- 摘要

- I. 引言

-

- A. 相关工作

- B. 贡献

- II. 提议的EVONET算法

- III. 实验

- IV. 结论

摘要

超分辨率(SR)重建是一个旨在提高图像空间分辨率的过程,可以是基于低分辨率和高分辨率之间的学习关系的单一观测,也可以是呈现同一场景的多个图像。如果不能以期望的分辨率获取图像,而有单个或多个低分辨率的观测数据,那么SR就特别重要–这是各种遥感场景所固有的。最近,我们见证了单幅图像SR的大幅改进,这归功于使用深度神经网络来学习低分辨率和高分辨率之间的关系。重要的是,深度学习还没有被广泛用于多图像超分辨率,而多图像超分辨率得益于信息融合,一般来说可以实现更高的重建精度。在这封信中,我们介绍了一种新的方法,将多图像融合的优势与使用深度网络学习低分辨率到高分辨率的映射相结合。我们广泛的实验结果表明,提出的框架优于最先进的SR方法。

关键词:卷积神经网络(CNN),深度学习,图像处理,超级分辨率(SR)。

I. 引言

超分辨率(SR)重建的目的是从单个或多个低分辨率(LR)观测值中生成一个高分辨率(HR)图像。在许多情况下,SR算法是获得足够空间分辨率图像的唯一可能性,因为HR数据可能由于高采集成本或传感器限制而无法获得。这种情况是遥感的一个固有问题,特别是关于地球观测的卫星成像。

A. 相关工作

现有的SR方法包括单图像和多图像方法。前者包括从大量的例子中学习LR-HR关系–这一领域的最新进展主要归功于深度卷积神经网络(CNN)的使用;然而,稀疏编码[1]和字典学习[17]也经常被认为是一种低复杂度的选择。

SRCNN[6],以及随后的快速版本(FSRCNN)[7],是第一个被提出来用于从一些LR-HR图像对中学习LR-HR地图平的CNN,并且它被证明超越了基于稀疏编码的方法,尽管结构相对简单。SRCNN的某些局限性被一个非常深的SR网络[12]所解决,该网络可以依靠快速残差学习进行有效的训练。使用稀疏编码网络[15],利用领域专业知识,实现了高训练速度和模型的紧凑性。最近,一个带有渐进式上采样的深度拉普拉斯金字塔SR网络(LapSRN)[13]被证明可以在高处理速度下提供有竞争力的结果。另外,由生成器和判别器组成的生成对抗网络(GANs)也被积极探索用于SR[14]。虽然GANs产生了高视觉质量的结果,但它们对恢复地面真实信息没有很大帮助。

多图像SR包括融合来自许多LR观测的互补信息,这些观测以亚像素位移的方式呈现同一场景[20]。由于多个观测点提供了更多从分析场景中提取的数据,因此重建可以比单一图像方法更准确。现有的多图像SR技术是基于这样一个前提:I(l)={I(l)i : i∈{1,2,–, N}}中的每个LR观测值I(l)i是从原始HR图像I(h)中提取的,使用假设的成像模型进行退化,通常包括图像扭曲、模糊环、脱灰和噪声污染。重建包括逆转这一退化过程,这需要解决一个不确定的优化问题。在梯度投影算法(GPA)中,层次化的子像素位移估计与贝叶斯重建相结合[18]。快速稳健的SR(FRSR)[8]是基于最大似然估计加上简化的正则化–IT重要的是,误差是在HR坐标中测量的,从而避免了昂贵的缩放操作。自适应细节增强(SR-ADE)[22]被提出用于重建卫星图像–采用双边滤波器来分解输入图像并放大高频细节信息。

在提高视频序列分辨率的背景下,也对多图像SR进行了探索,最近为此目的利用了深度网络工程–在[9]中,一个深度CNN被输入了三个连续的运动补偿视频帧,因此在空间和时间域中运行,而在[19]中,一个循环神经网络被用于视频SR。然而,视频SR技术是基于与输入流有关的明确或隐含的假设,例如,与固定和相当高的采样频率或移动物体的存在有关,其分辨率可以通过估计运动场来提高。因此,它们不能直接应用于卫星图像的SR。最近,我们提出了进化成像模型(EvoIM)[10],它采用遗传算法来优化FRSR[8]的超参数,并进化卷积核而不是FRSR中使用的高斯模糊。我们表明,重建可以有效地适应不同的成像条件,包括应用于人工降级(AD)图像的不同噪声水平,以及处理原始分辨率的真实(非降级)Sentinel-2卫星图像。

B. 贡献

在这封信中,我们展示了如何将基于学习的单图像SR的优点与多图像重建提供的信息融合的优点结合起来。我们介绍了EvoNet框架(第二节),它利用单图像SR(我们考虑了几种基于深度CNN的不同方法)来预处理多图像SR的输入数据(我们为此使用了我们的EvoIM技术[10])。我们对AD图像和真实的卫星(RS)数据进行了广泛的实验验证(第三部分),并以平均意见得分(MOS)作为支持,结果证实EvoNet增强了多图像SR的能力,它在质量和数量上都比最先进的技术要好。

II. 提议的EVONET算法

所提方法的流程图见图1。首先,每个LR输入图像(I(l)i)都要经过单一图像SR。这一步产生了一组N个图像I(l+) = {I(l+) i },其尺寸比I(l) i大2倍。与此同时,输入的LR图像I(l)要进行图像登记,以确定它们之间的子像素移动。这些移位允许使用中位移位加算法(由于I(l+)i的尺寸比I(l)i的尺寸大2倍,计算出的移位值乘以2)从多个单图像SR结果(I(l+))中进行信息融合。这就产生了初始的超分辨率图像X0–其尺寸比I(l+)大2倍,因此比I(l)i大4倍。随后,X0经过EvoIM处理,产生超分辨率图像I(sr)。与最初的EvoIM方法[10]相比,使用单图像SR对输入的LR图像进行预处理是主要的区别,该方法直接从输入的LR图像组成X0。

A. 用单图像SR对输入图像进行预处理 每个LR图像I(l)i都用单图像SR独立增强,以获得更高质量的输入I(l+)i用于EvoIM,从而用学到的LR-HR关系支持后者。为此,我们研究了几种架构,即FSRCNN[7]和SRResNet[14],后者被用作GAN和LapSRN[13]中的生成器。我们将这些网络的放大系数设置为2倍,以避免引入过多的伪影,这在具有较大放大系数的单图像SR中是很常见的。

B. 多图像融合 我们用于多图像融合的EvoIM过程包括对由注册的LR输入组成的HR图像X0进行迭代过滤。在EvoNet中,我们对原始I(l)i图像进行注册,然后再进行单幅图像的SR(它不会引入任何可能有助于更好地评估位移值的信息)。随后,EvoIM解决了优化问题(如FRSR)。更新步骤X = Xn+1 - Xn计算为X = -β B AT sgn(ABXn - AX0) + λ δU(X) δX (Xn) (1) 其中β控制更新步骤,A是一个对角矩阵,表示与X0相关的LR测量的数量,U(X )是用λ超参数控制的正则化项,而B和B是5×5卷积核。FRSR超参数和卷积核在EvoIM进化训练中被优化,这可以在EvoNet框架之外独立完成(在本研究中,我们使用在[10]中得到的值)。

III. 实验

为了验证,我们在测试集中使用了两种类型的数据,即。1)AD图像和2)同一地区的RS图像,以不同的分辨率获取。在AD中,我们使用了六个数据集,包括我们的10张500×500像素的Sentinel-2图像集(Sentinel-AD)和五个通常用于评估SR的基准数据集:Set5[4]、Set14[21]、BSD100[2]、Manga109[16]和Urban100[13]。对于这些数据集中的每张图像,作为I(h)处理,我们生成了一组N=4的LR图像,在进一步退化(高斯模糊,然后是降尺度,还可以选择用噪声污染)之前,应用了不同的子像素移动。对于RS,我们使用了三个Sentinel-2场景作为LR(每个场景中N=10个LR图像),其中两个与SPOT图像相匹配(呈现在伊朗的Bushehr,LR尺寸为300×291像素,以及伊朗的Bandar Abbas,240×266像素),一个与Digital Globe WorldView-4图像(澳大利亚悉尼,92×90像素)相匹配。

EvoNet与双三次插值和五种单图像SR方法进行了比较。基于离散小波变换的SR(SR-DWT)[5]、SRCNN[6]、FSRCNN[7]、SRResNet[14]和LapSRN[13],以及三种多图像SR技术。GPA[18]、SR-ADE[22]和EvoIM[10]。此外,我们对I(l)中的所有LR图像运行每个单图像方法,并从重建结果中计算出平均图像–这样,这些方法的数据与多图像SR的数据相同。如文献[10]所述,EvoIM分别针对AD图像和RS数据进行训练,使用PSNRhf[3]作为适配函数(训练集和测试集之间没有重叠)。深度CNN使用DIV2K数据集的图像进行训练。1 我们用C++实现了所有的调查算法,我们用Python和Keras来实现CNN。实验在英特尔i9 4-GHz计算机上运行,配有64-GB内存和两个RTX 2080 8-GB图形处理单元(GPU)。

我们根据I(h)和I(sr)之间的相似性来量化重建质量,用峰值信噪比(PSNR)、结构相似性指数(SSIM)、视觉信息保真度(VIF)、通用图像质量指数(UIQI),以及用高通滤波器处理的图像的PSNR(PSNRhf)和局部标准偏差(PSNRls)来衡量,我们发现这些指标对评估SR很有力[3](对于所有指标,较高数值表明图像之间的相似性更高)。重建结果是在比输入LR图像大2倍的维度上进行定量评估的(EvoNet将LR图像放大了4倍,所以我们将这些结果缩小了2倍,以便与其余方法进行公平比较)。对于RS,I(sr)与数字地球仪和SPOT图像进行了比较,缩小了尺寸以适应I(sr)的尺寸。我们还进行了一项调查2,包括15个关于AD(10个问题)和RS(5个问题)测试集的图像质量的问题。我们收到了307份回复,在此基础上,我们报告了四种方法的MOS值:双三次插值、LapSRN、EvoIM和EvoNet-LapSRN。

在表一中,我们报告了六个数据集的AD图像的重建精度。带有不同CNN的EvoNet可以实现最准确的重建,呈现出持续的最佳分数。值得注意的是,在大多数情况下,即使在EvoNet中用于预处理的双三次插值也能提高EvoIM的得分(除了Manga109和Urban100);然而,基于CNN的EvoNet允许更大的改进(在大多数情况下,LapSRN是最佳选择)。我们还报告了归因于EvoNet的准确度增益(与最好的多图像方法相比)–Sentinel-AD的增益最大,而Manga109的增益最小(可能是因为它不包含自然图像)。在图2中,我们展示了一个Sentinel-AD图像的SR实例。可以看出,EvoNet与SRResNet和LapSRN都比EvoIM和底层CNN产生了更好的结果–注意,对于EvoNet,可以区分更多的树木和道路线的细节。在表二中,我们显示了CNN(SRResNet和LapSRN)、EvoIM和EvoNet在噪声存在下的表现。可以看出,EvoNet是最敏感的,然而,对于中等程度的噪声(σ=0.01的高斯和1%概率翻转像素值的盐和胡椒),它仍然比基础CNN和EvoIM表现得更好。重要的是,正如文献[11]所报道的,EvoIM可以有效地适应不同的噪声特征,这也应该改善用EvoNet获得的分数(在这里,我们用EvoIM训练的图像没有应用任何噪声)。

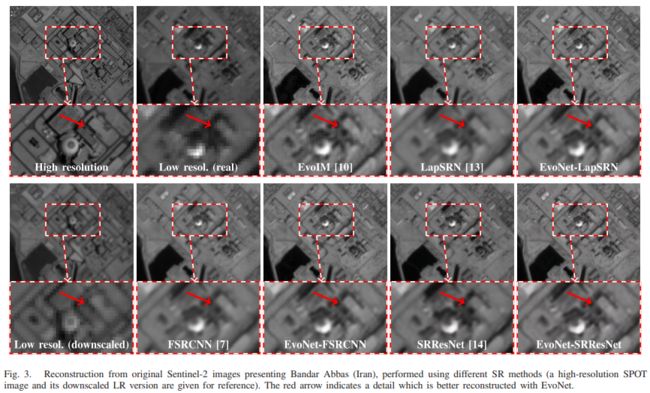

表三中报告了RS图像的得分。对于每一个分数,我们都报告了排名(在括号里),最右边一栏显示了总体排名。EvoNet变体的排名很高,但分数与通过结合多个CNN结果得到的分数相似。相似度值比AD低得多的原因是LR和HR图像是用不同的传感器获取的,所以即使是极好的重建,其结果也会与地面真实的HR图像有视觉上的差异。为了更好地说明这一点,我们以与AD集相同的方式对HR图像进行降级,并将降级后的LR图像与LR图像进行比较–数值显示在最下面一行,它们与其余分数相似。另外,在图3中,我们展示了这两个版本的LR图像。从图中也可以看出,EvoNet比CNN和EvoIM更好地重建了细节。

在表四中,我们报告了Sentinel-AD和RS图像的MOS(分数被归一化,所以它们的总和等于1)。可以看出,用EvoNet-LapSRN得到的图像在AD和RS图像中都被认为是信息量最大和最自然的。

IV. 结论

在这封信中,我们提出了一个新颖的EvoNet框架,用于将单图像SR方法与基于多图像融合的方法结合起来。重要的是,我们表明我们的方法可以通过利用最近由于使用深度CNN而在单图像SR方面取得的进展来改进多图像SR。我们表明,在进行多图像融合之前,采用不同的深度架构来增强每一个单独的LR图像,可以从本质上改善最终的超分辨率图像。所报告的定量和定性结果,在平均意见分数的支持下,表明所提出的方法比最先进的SR方法表现得更好。

我们已经表明,EvoNet与不同的单图像方法(包括双三次插值和三个深度CNN)配合良好,但潜在的其他方法[17]也可以在我们的框架中得到利用。重要的是,这也意味着未来在单图像SR方面的潜在进展可以很容易地被利用来进一步改进所提出的方法。