这个疯子整理的十万字Java面试题汇总,终于拿下40W offer!(JDK源码+微服务合集+并发编程+性能优化合集+

爆肝一周,不眠不休!就为 点赞+好评+收藏 三连

收藏党可以通过百度网盘下载全部文档:

链接:https://pan.baidu.com/s/1nwlBO2tYXDDl7OjGhs4e4Q

提取码:1111

目录

爆肝一周,不眠不休!就为 点赞+好评+收藏 三连

Java JDK源码合辑

HashMap篇

ConcurrentHashMap篇

常用主流框架面试合辑

Spring框架篇

SpringMVC原理篇

MyBatis框架篇

Netty篇

微服务面试合辑

Spring Boot篇

Dubbo篇

Spring Cloud篇

并发编程面试篇合辑

并发编程(上)

并发编程(下)

分布式中间件面试合辑

分布式调用RPC篇

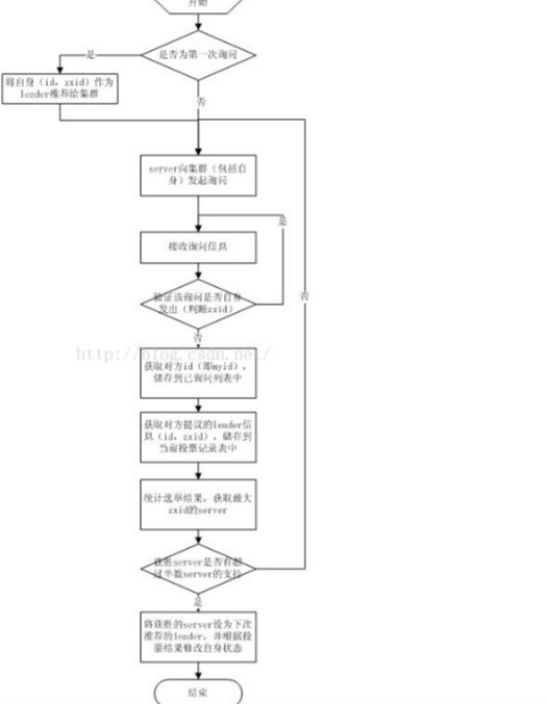

分布式限流Zookeeper篇

分布式负载均衡Nginx篇

分布式消息通讯RabbitMQ篇

分布式消息通讯Kafka篇

分布式消息通讯ActiveMQ篇

分布式数据库Reids篇

分布式数据库MongoDB篇

分布式数据库Memcached

性能调优合集

JVM性能优化面试篇

Tomcat调优面试篇

MySQL调优面试篇

word文档下载地址:链接:https://pan.baidu.com/s/1BaUi8KUjvjJ6RPN7CmMSyw?

提取码:1111爆肝一周,不眠不休!就为 点赞+好评+收藏 三连

HashMap篇

1、并发修改异常

原因

迭代器中修改数 和hashmap中的 modCount 不相等

目的

暴露异常,快速失败

出现场景

- 多线程,一个迭代器迭代,一个线程增删操作

- 迭代器迭代的时候,使用hashmap本身的remove方法

解决方案

- 多个线程,操作使用ConcurrentHashMap,或者hashTable

- 在迭代的时候,使用迭代器中的remove方法。保存修改数和modCount一致

2、HashMap底层数据结构

1.7:数组+链表

1.8:数组+链表+红黑树(其中红黑树,也是用了双向链表,主要是为了链表操作方便,在扩容,链表转红黑树,红黑树转链表的过程中都要操作链表。)

3、hash 数组的最大值

1 << 30

- 首先必须是2的倍数,方便计算对应的table下标,

- 为什么不是32位 高1位 为正负标识,不能占有。

- 为什么不是31位 他达不到231,因为Integer的最大值就是231-1,如果threadhold超过2^30,会把Integer的最大值赋给他。

4、hash 寻址算法

hash值 和 数组长度 -1 做与运算。

- 数组长度为2的幂次方

- 长度-1,那么低位全部为1,做运算那么下标 肯定落到数组长度范围内。

5、1.7 HashMap的put方法的实现过程

- 判断当前的数组是否为空,如果为空则初始化该数组

- 判断key是否为null

- 遍历tab[0],如果有key为null的entry,重新设置新值,返回oldValue。

- 没有找到则将key,value封装成entry,存到数组下标0的位置。返回null。

- 根据key做hash运算得到hashcode

- 根据hashCode和数组长度-1,逻辑与运算,算出hashcode基于当前数组对应的数组下标i

- 遍历tab[i]位置的链表,当找到节点的key和传入的key相同时,则重新设置为新值,返回oldValue。

- 没有找到这,说明是新的key,modCount++

- 再将hashcode,key,value,i 封装成Entry对象,通过头插法插入到改tab[i]位置

- 如果当前size是否大于等于阈值**,并且当前桶位不为null** 则进行扩容。

6、HashMap1.7 扩容机制

扩容条件:

当前容量大于等于阈值 并且 当前桶位不为null

扩容流程

- rehash,当容量大于等于我们设置的hash阈值,生成一个新的hash种子

- new 一个2倍长度的新数组

- 循环每个桶上的链表

- 重新计算hashcode,然后再和新的数组长度-1做与运算,得到新数组下标

- 判断新数组当tab[i]位置是否有元素

- 没有元素则直接封装成Entry对象赋值到当前tab[i]位置

- 有元素,则通过头插法插入到链表中,再赋值到tab[i]位置

8、HashMap1.7 扩容产生循环链表

场景

- 两个(多)线程同时转移同一个桶对应的链表

- 线程1依次将链表倒序方式转移到新数组中,

- 线程2此时转移比如当前指针指向 1节点,下个指针指向2节点。 而链表中2的next节点指向的是1节点。

- 当插入的时候会1节点会指向2节点,2节点指向1节点,形成环形链表。

影响

- put时候,会造成死循环。(需要循环判断链表中是否有相同的key)

- get时候,会造成死循环。

9、1.8 hash运算的实现方式

将hashcode 高16 和 低16位 异或,算出hash值。

然后再和 数组的长度 -1 比较。

要 高16和低16异或?

目的是当数组的的长度为 2的 小于等于 16次方,也是就是2进制 小于等于 16位,。两个key的hashcode运算出的低16位一样,而高16位不一样,如果高16低16位不做运算,那么他们做与运算等到的是通过样的数组下标。对每个hash值,在他的低16位中,让高低16位进行了异或,让他的低16位同时保持了高低16位的特征,尽量避免一些hash值后续出现冲突,大家可能会进入数组的同一个位置, key 更加散列。

10、1.8 HashMap的put方法的实现过程

- 根据key生成hash 值

- 判断当前hashMap对象的数组是否为空,如果为空则初始化该数组

- 根据逻辑与运算,算出hashcode基于当前数组对应的数组下标i

- 判断数组的第i个位置的元素(tab[i])是否为空

- 如果为空,则将key,value封装成Node对象赋值给tab[i]

- 如果不为空

- 如果put方法传入进来的key等于tab[i].key,那么证明存在相同的key

- 如果不等于tab[i].key,则:

- 如果tab[i]的类型是TreeNode,则表示数组的第i位置上是一颗红黑树,那么将key和value插入到红黑树中,并且在插入之前会判断在红黑树中是否存在相同的key

- 如果tab[i]的类型不是TreeNode,则表示数组的第i位子上是一个链表,那么遍历循环找是否存在相同的key,并且在遍历的过程中会对链表中的节点数进行计数,当遍历到最后一个节点时,会将key,value封装成Node插入到链表的尾部,同时判断在插入新节点之前的链表节点个数是不是大于等于8,并且table长度大于等64,如果是,则将链表改为红黑树

- 如果上述步骤中发现存在相同的key,则根据onlyIfAbsent标记来判断是否需要更新value值,然后返回oldValue

- modCount++

- hashMap的元素个数size加1

- 如果size大于扩容的阈值,则进行扩容

11、1.8 HashMap 扩容机制

扩容条件:

- 当前容量大于等于阈值

- 或 在树化之前,当前数组的长度小于64,链表长度大于等于8 也会发生扩容。

扩容流程:

- new 2倍数组长度的,新数组

- 节点对应的hashcode和新数组长度做与运算

- 结果为0,为低位链表,不为0为高位链表

- 低位插入新数组老下标位置(i),高位插入新数组的老数组长度+老下标位置。(oldLength+i)

- 判断是否进行树化。

12、1.8 HashMap 树化过程

树化条件:

链表的长度大于等于8 且 数组的长度大于等于64

树化实现:

- 现将单向链表转变为双向链表

- 再将双向链表,将头结点作为root节点,然后依次将next节点插入到根节点,转变红黑树。

- 再插入时候key比较

- 如果key实现了comparable接口,通过实现方式比较

- 否则比较key的hashCode

- 否则比较key的class.getName

- 否则比较key的System.identityHashCode比较

- 最后树化后,取出root节点(TreeNode),放到entry位置

13、1.8 HashMap 的get实现过程

- 根据key生成hashcode

- 如果数组为空,则直接返回空

- 如果数组不为空,则利用hashcode和数组长度-1通过逻辑与操作算出key所对应的数组下标i

- 如果数组的第i个位置上没有元素,则直接返回空

- 如果数组的第i个位置的元素的key等于get方法锁传进来的key,则返回该元素,并获取该元素的value。

- 如果不等于则判断该元素还有没有下个元素,如果没有返回空

- 如果有则判断钙元素的类型是链表节点还是红黑树节点

- 如果是链表则遍历链表

- 如果是红黑树则遍历红黑树

- 找到即返回元素,没找到则返回空

14、1.8 HashMap 的Remove实现过程

- 找到对应的位置(和get方式类似)

- 链表节点直接删除

- 红黑树节点

- 先删除链表的对应的节点,实现方式将上个节点指向下下个节点

- 然后再维护红黑树上的节点,可能会发生退化成链表

- modCount–

- size–

15、1.8 HashMap 为什么使用红黑树,不使用AVL树,二分查找树,链表

- 因为AVL树插入节点或者删除节点,整体的性能是不如红黑树的。AVL每个左右节点的高度是不能大于1的。所以维持这种结构比较消耗性能。

- 二分查找树,他的左右节点不平衡,一开始就固定了root,那么极端的情况下会成为链表结构。

- 链表长度越长,那么他的插入和查询效率都很低。

- 而红黑树他的整体查找,增删节点的效率都是比较高的。

16、1.8 HashMap 什么时候将链表转化成红黑树

- 当发现链表的元素个数大于8

- 并且当前的数组长度大于等于64的时候。

因为当数组比较小的时候,我们可以通过扩容的方式,将链表的长度变短。这样就用树化。

17、1.7 和 1.8 HashMap 不同点

- 结构:1.8使用了红黑树

- 插入法:1.7使用了头插法(多线程情况会出现循环链表,导致CPU飙升),1.8是用来尾插法(1.8中反正要去计算链表当前节点的个数,需要遍历链表,所以直接使用了尾插法。)

- hash算法复杂度:1.7 的hash算法比1.8钟的更复杂,hash算法越复杂,生成hashcode则更散列,那么hashmap中的元素则更散列,更散列则hashmap的查询性能更好,jdk7中没有红黑树,所以只能优化hash算法使元素更散列。1.8中重甲了红黑树,查询性能得到了保障,所以可以简化一下hash算法,毕竟hash算法越复杂越消耗CPU。

- 扩容的过程中:1.7可能会重新对key进行哈希(重新hash跟哈希种子有关系。),而1.8中没有这部分逻辑

- 扩容的条件不一样:1.7除了判断是否大于等于阈值,同时还判断了tab[i]是否为空,不为空才会进行扩容。1.8则没有这部分逻辑。

- 扩容的转移逻辑不一样:jdk7是每次转移一个元素,jdk8是先算出当前位置,高低位链表,再一次性转移过去

- jdk8 多了一个api :putIfAbsent(key,value)。

ConcurrentHashMap篇

1、JDK7 ConcurrentHashMap是怎么保证并发安全的?

主要利用了Unsafe操作+ReentrantLock+分段思想。

主要使用了Unsafe操作中的:

- compareAndSwapObject:通过cas的方式修改对象的属性

- putOrderedObeject:并发安全的给数组的某个位置赋值

- getObjectVolatile:并发安全的获取数组某个位置的元素

分段思想:

为了提高ConcurrentHashMap的并发量,分段数越高则支持的最大并发量越高,程序员可以通过concurrencyLevel参数来指定并发量。ConcurrentHashMap的内部类Segment就是用来表示某一个段的。

ReentrantLock:

每个Segement就是一个小型的 HashMap,当调用ConcurrentHashMap的put方法时,最终会调用到Segment的put方法,而Segment类继承了ReentrantLock,所以Segment自带可重入锁,当调用到Segment的put方法时,会先利用可重入锁加锁,加锁成功后再将待插入的key,value插入到小型HashMap中,插入完成后解锁。

2、JDK7 ConcurrentHashMap的底层原理

ConcurrentHashMap底层是由两层嵌套数组来实现的

- ConcurrentHashMap对象中有一个属性segments,类型为segment[];

- Segment对象中有一个属性table,类型为hashEntry[];

当调用ConcurrentHashMap的put方法时,先根据key计算出对应的Segment[]数组下标j,确定好当前key,value应该插入到哪个segment对象中,如果segments[j] 为空,则利用自旋锁的方式在j位置生成一个Segment对象。

然后调用Segment对象的put方法。

Segment对象的put方法会先加锁,然后也根据key计算出对应的HashEntry[]数组下标i,然后将key,value封装为Entry对象放入该位置,此过程和1,.7的put方法一样,然后解锁。

3、JDK7 ConcurrentHashMap的put实现过程

- 判断key不能为null

- 通过hashcode和segment数组长度-1,算出segment下标

- 判断segement是否为空,如果为空,从segment[0]原型中获取segment初始化的属性,用来初始化segment对象。

- tryLock,

- 获取锁,走类似put的插入逻辑。

- 没有获取锁,通过自旋的方式,找到head节点。

- 算出key对应的HashEntry数组下标i,走类似put的插入逻辑

4、JDK7 ConcurrentHashMap的扩容

特点:

局部扩容,只扩容segment中的hashEntry数组。并且在单线程下扩容,不会有并发问题。

条件:

当segment中hashEntry数组容量大于等于阈值就会发生扩容。

流程:

- new 2倍数组长度,得到新数组

- 循环hashEntry,处理每一个桶位链表。

- 循环链表,计算出每个节点新的数组的下标。这里会找到不间断的局部链表都在同一个下标位置。将从不变化的开始位置,到链表的尾部,一次性到转移到新的数组下标上。

- 再循环链表将其他的节点依次转移到新的数组中。

5、JDK7 ConcurrentHashMap的Size

- 第一层死循环

- 为每个segment加锁

- 第二层循环累加每个segment的modCount 和 size。

- 然后比较上次循环中的modCount总数和当前循环的modCount总和。

- 相等则跳出死循环,返回size总和

6、JDK8 ConcurrentHashMap是怎么保证并发安全的

主要利用Unsafe操作+synchronized关键字

主要使用了Unsafe操作中的:

- compareAndSwapObject:通过cas的方式修改对象的属性

- putOrderedObeject:并发安全的给数组的某个位置赋值

- getObjectVolatile:并发安全的获取数组某个位置的元素

Synchronized主要负责在需要操作某个位置时进行加锁(该位置不能为空),比如向某个位置的链表进行插入节点,向某个位置的红黑树插入节点

JDK中其实仍然有分段锁的思想,只不过JDK7中段数是可以控制的,而JDK8中是数组的每一个位置都有一把锁。

7、JDK8 ConcurrentHashMap的put实现过程

- 首先根据key计算对应的数组下标i,如果该位置没有元素,则通过自旋的方式去向该位置赋值

- 如果该位置有元素,则通过synchronized将tab[i] 元素加锁

- 加锁成功之后,再判断该元素的类型

- 如果是链表节点则进行添加节点到链表中

- 如果是红黑树则添加到红黑树中

- 添加成功后,走出了同步块,判断是否需要进行树化

- addCount,这个方法的意思是ConcurrentHashMap的元素个数加1,但是这个操作也是需要并发安全的,并且元素个数加1成功后,会继续判断是否需要进行扩容,如果需要,则会进行扩容,所以这个方法很重要。

- 同时一个线程在put时如果发现当前ConcurrentHashMap正则进行扩容则会去帮助扩容

8、JDK8 ConcurrentHashMap的树化

树化条件:

当发现链表的元素个数大于等于8 (hashmap还会判断数组大小大于等于64)

树化流程:

- 对当前tab[i]加锁,锁TreeBin对象

- 将链表转变成双向链表,目的是方便红黑树操作

- 将双向链表插入到TreeBin中

9、JDK8 ConcurrentHashMap的TreeBin

相当于红黑树的壳子,他本身就是红黑树,他有属性root表示根节点,无论树结构怎么变,treebin都不会变。

10、JDK8 ConcurrentHashMap的addCount

- 判断是否初始化了baseCount,没有通过自旋的方式去初始化

- 通过随机数,计算出对应的countCells下标i

- countCells数组不为空,判断当前conuntCells[i] 是否有值,有值自旋方式 conuntCells[i] 值+1.

- 为空,循环

- 先自旋方式 baseCount+1

- 不成功则初始化countCells数组

- 找到对应的countCells数组下标自旋方式 conuntCells[i] 值+1.

- 再不成功再自旋 baseCount+1

11、JDK8 ConcurrentHashMap的扩容

扩容条件

- 当一个线程自旋2次 为counterCells +1都失败

- 或 元素个数大于等于了阈值

特点

- 当线程在put的时候,发现有正在扩容标记的时候,他会加入协助扩容

- 扩容到一定程度就不会扩容了

扩容流程

- new 2倍数组长度,得到新数组

- 首先为线程设置固定长度的步长,分配起始位置和结束位置。每个线程都会扩容自己那部分

- 每个线程先锁住桶,依次将自己负责的桶转移到新数组中

- 节点对应的hashcode和新数组长度做与运算

- 结果为0,为低位链表,不为0为高位链表

- 低位插入新数组老下标位置(i),高位插入新数组的老数组长度+老下标位置。(oldLength+i)

- 这里会先找局部链表,该链表从头到尾节点的下标都一致,对应新数组的位置,直接转移过去。再将其他的节点转移过去。

- 判断是否进行树化。

12、JDK8 ConcurrentHashMap的size

累加countCells数组每个元素值,再加上baseCount。

13、JDK8 ConcurrentHashMap的remove

减size,不减容量

14、JDK7和JDK8 ConcurrentHashMap的区别

- jdk8中没有分段锁,而是使用了synchronize的来进行控制

- jdk8中的扩容性能更高,支持多线程同时扩容,实际上jdk7中也支持多线程扩容,因为jdk7中的扩容是针对每个Segment的,所以也可能多线程扩容,但是性能没有jdk8高,因为jdk8中对于任何一个线程都可以去帮助扩容

- jdk8的元素个数统计实现不一样,jdk8是 counterCell数组元素+baseCount。jdk7是通过循环 遍历每个segment对象加锁统计累加的modCount和累加的size,和上次得出modCount的结果比较。

- 外加hashmap中的不同点

Java JDK源码 word文档下载地址:链接:https://pan.baidu.com/s/1BaUi8KUjvjJ6RPN7CmMSyw?

提取码:1111爆肝一周,不眠不休!就为 点赞+好评+收藏 三连

常用主流框架面试合辑

Spring框架篇

1、什么是 Spring 框架Spring 框架有哪些主要模块

Spring 框架是一个为 Java 应用程序的开发提供了综合、广泛的基础性支持的 Java 平台。Spring 帮助开发者解决了开发中基础性的问题,使得开发人员可以专注于应用程序的开发。

Spring 框架本身亦是按照设计模式精心打造,这使得我们可以在开发环境中安心的集成 Spring 框架,不必担心 Spring 是如何在后台进行工作的。Spring 框架至今已集成了 20多个模块。这些模块主要被分如下图所示的核心容器、数据访问/集成,、Web、AOP(面向切面编程)、工具、消息和测试模块。

2、使用 Spring 框架能带来哪些好处

下面列举了一些使用Spring 框架带来的主要好处:

Dependency Injection(DI)方法使得构造器和 JavaBean properties 文件中的依赖关系一目了然。

与 EJB 容器相比较,IoC 容器更加趋向于轻量级。这样一来 IoC 容器在有限的内存和 CPU 资源的情况下进行应用程序的开发和发布就变得十分有利。

Spring 并没有闭门造车,Spring利用了已有的技术比如ORM 框架、logging 框架、J2EE、Q uartz和JDK Timer,以及其他视图技术。

Spring 框架是按照模块的形式来组织的。由包和类的编号就可以看出其所属的模块,开发者仅仅需要选用他们需要的模块即可。

要测试一项用 Spring 开发的应用程序十分简单,因为测试相关的环境代码都已经囊括在框架中了。更加简单的是,利用 JavaBean 形式的 POJO 类,可以很方便的利用依赖注入来写入测试数据。

Spring 的 Web 框架亦是一个精心设计的 Web MVC 框架,为开发者们在web 框架的选择上提供了一个除了主流框架比如 Struts、过度设计的、不流行 web 框架的以外的有力选项。

Spring 提供了一个便捷的事务管理接口,适用于小型的本地事物处理(比如在单 DB 的环境下)和复杂的共同事物处理(比如利用 JTA 的复杂 DB 环境)。

3、什么是控制反转(IOC)什么是依赖注入

控制反转是应用于软件工程领域中的,在运行时被装配器对象来绑定耦合对象的一种编程技巧,对象之间耦合关系在编译时通常是未知的。在传统的编程方式中,业务逻辑的流程是由应用程序中的早已被设定好关联关系的对象来决定的。在使用控制反转的情况下,业务逻辑的流程是由对象关系图来决定的,该对象关系图由装配器负责实例化,这种实现方式还可以将对象之间的关联关系的定义抽象化。而绑定的过程是通过“依赖注入”实现的。

控制反转是一种以给予应用程序中目标组件更多控制为目的设计范式,并在我们的实际工作中起到了有效的作用。

依赖注入是在编译阶段尚未知所需的功能是来自哪个的类的情况下,将其他对象所依赖的功能对象实例化的模式。这就需要一种机制用来激活相应的组件以提供特定的功能,所以依赖注入是控制反转的基础。否则如果在组件不受框架控制的情况下,框架又怎么知道要创建哪个组件

在Java 中依然注入有以下三种实现方式:

1.构造器注入

2.Setter方法注入

3.接口注入

4、请解释下 Spring 框架中的 IoC

Spring中的org.springframework.beans包和org.springframework.context包构成了 Spring 框架 IoC 容器的基础。BeanFactory 接口提供了一个先进的配置机制,使得任何类型的对象的配置成为可能。

ApplicationContex 接口对 BeanFactory(是一个子接口)进行了扩展,在 BeanFactory 的基础上添加了其他功能,比如与 Spring 的AOP 更容易集成,也提供了处理 message resource 的机制(用于国际化)、事件传播以及应用层的特别配置,比如针对 Web 应用的WebApplicationContext。

org.springframework.beans.factory.BeanFactory 是 Spring IoC 容器的具体实现,用来包装和管理前面提到的各种 bean。BeanFactory 接口是 Spring IoC 容器的核心接口。

IOC:把对象的创建、初始化、销毁交给 spring 来管理,而不是由开发者控制,实现控制反转。

5、BeanFactory 和 ApplicationContext 有什么区别

BeanFactory 可以理解为含有 bean 集合的工厂类。BeanFactory 包含了种bean 的定义,以便在接收到客户端请求时将对应的 bean 实例化。BeanFactory 还能在实例化对象的时生成协作类之间的关系。此举将 bean 自身与 bean 客户端的配置中解放出来。BeanFactory 还包含了 bean 生命周期的控制,调用客户端的初始化方法(initialization methods)和销毁方法(destruction methods)。

从表面上看,application context 如同 bean factory 一样具有 bean 定义、bean 关联关系的设置,根据请求分发 bean 的功能。但 applicationcontext 在此基础上还提供了其他的功能。

1.提供了支持国际化的文本消息

2.统一的资源文件读取方式

3.已在监听器中注册的bean的事件

以下是三种较常见的ApplicationContext 实现方式:

1、ClassPathXmlApplicationContext:从 classpath 的 XML 配置文件中读取上下文,并生成上下文定义。应用程序上下文从程序环境变量中

ApplicationContext context = new ClassPathXmlApplicationContex t(“bean.xml”);

2、FileSystemXmlApplicationContext:由文件系统中的XML配置文件读取上下文。

ApplicationContext context = new FileSystemXmlApplicationConte xt(“bean.xml”);

3、XmlWebApplicationContext:由 Web 应用的 XML 文件读取上下文。

4、AnnotationConfigApplicationContext(基于 Java 配置启动容器)

![]()

6、Spring 有几种配置方式

将Spring 配置到应用开发中有以下三种方式:

1.基于XML的配置

2.基于注解的配置

3.基于Java的配置

7、如何用基于 XML 配置的方式配置 Spring

在Spring 框架中,依赖和服务需要在专门的配置文件来实现,我常用的XML 格式的配置文件。这些配置文件的格式通常开头,然后一系列的bean 定义和专门的应用配置选项组成。

SpringXML 配置的主要目的时候是使所有的 Spring 组件都可以用 xml 文件的形式来进行配置。这意味着不会出现其他的 Spring 配置类型(比如声明的方式或基于 Java Class 的配置方式)

Spring 的 XML 配置方式是使用被 Spring 命名空间的所支持的一系列的XML 标签来实现的。Spring 有以下主要的命名空间:context、beans、jdbc、tx、aop、mvc 和 aso。

如:

![]()

下面这个web.xml仅仅配置了DispatcherServlet,这件最简单的配置便能满足应用程序配置运行时组件的需求

![]()

![]()

8、如何用基于 Java 配置的方式配置 Spring

Spring 对 Java 配置的支持是由@Configuration 注解和@Bean 注解来实现的。由@Bean 注解的方法将会实例化、配置和初始化一个新对象,这个对象将由 Spring 的 IoC 容器来管理。@Bean 声明所起到的作用与 元素类似。被@Configuration 所注解的类则表示这个类的主要目的是作为 bean 定义的资源。被@Configuration 声明的类可以通过在同一个类的内部调用@bean 方法来设置嵌入 bean 的依赖关系。

最简单的@Configuration 声明类请参考下面的代码:

![]()

对于上面的@Beans 配置文件相同的 XML 配置文件如下:

上述配置方式的实例化方式如下:利用 AnnotationConfigApplicationContext

public static void main(String[] args)

{ ApplicationContext ctx = new

AnnotationConfigApplicationContext(AppConfig.class);

MyService myService = ctx.getBean(MyService.class);

myService.doStuff();

}

要使用组件组建扫描,仅需用@Configuration 进行注解即可:

@Configuration

@ComponentScan(basePackages = "com.somnus")

public class AppConfig {

... }

在上面的例子中,com.acme 包首先会被扫到,然后再容器内查找被@Component 声明的类,找到后将这些类按照 Sring bean 定义进行注册。

如果你要在你的web 应用开发中选用上述的配置的方式的话,需要用

AnnotationConfigWebApplicationContext 类来读取配置文件,可以用来配置Spring的Servlet监听器ContextLoaderListener或者Spring MVC 的

contextClass

org.springframework.web.context.support.AnnotationConfigWebApp licatio

nContext

contextConfigLocation

com.howtodoinjava.AppConfig

contextClass

org.springframework.web.context.support.AnnotationConfigWebApp

licatio nContext

contextConfigLocation

com.howtodoinjava.AppConfig

9、怎样用注解的方式配置 Spring

Spring 在 2.5 版本以后开始支持用注解的方式来配置依赖注入。可以用注解的方式来替代 XML 方式的 bean 描述,可以将 bean 描述转移到组件类的内部,只需要在相关类上、方法上或者字段声明上使用注解即可。注解注入将会被容器在 XML 注入之前被处理,所以后者会覆盖掉前者对于同一个属性的处理结果。

注解装配在 Spring 中是默认关闭的。所以需要在 Spring 文件中配置一下才能使用基于注解的装配模式。如果你想要在你的应用程序中使用关于注解的方法的话,请参考如下的配置。

在context:annotation-config/标签配置完成以后,就可以用注解

的方式在 Spring 中向属性、方法和构造方法中自动装配变量。下面是几种比较重要的注解类型:

1. @Required:该注解应用于设值方法。

2. @Autowired:该注解应用于有值设值方法、非设值方法、构造方法和变量。

3. @Qualifier:该注解和@Autowired 注解搭配使用,用于消除特定 bean 自动装配的歧义。

4.JSR-250Annotations:Spring支持基于JSR-250注解的以下注解,

@Resource、 @PostConstruct 和 @PreDestroy。

10、请解释 Spring Bean 的生命周期

Spring Bean 的生命周期简单易懂。在一个 bean 实例被初始化时,需要执行一系列的初始化操作以达到可用的状态。同样的,当一个 bean 不在被调用时需要进行相关的析构操作,并从 bean 容 器中移除。

Spring bean factory 负责管理在 spring 容器中被创建的 bean 的生命周期。Bean 的生命周期由两组回调(call back)方法组成。

1. 初始化之后调用的回调方法。

2. 销毁之前调用的回调方法。

Spring 框架提供了以下四种方式来管理 bean 的生命周期事件:

InitializingBean和DisposableBean回调接口

针对特殊行为的其他Aware接口

Bean配置文件中的Custominit()方法和destroy()方法

@PostConstruct和@PreDestroy注解方式

使用customInit()和customDestroy()方法管理bean生命周期的代码样例如下:

11、Spring Bean 的作用域之间有什么区别

Spring 容器中的 bean 可以分为 5 个范围。所有范围的名称都是自说明的,但是为了避免混淆,还是让我们来解释一下:

1. singleton:这种 bean 范围是默认的,这种范围确保不管接受到多少个请求,每个容器中只有一个 bean 的实例,单例的模式由 bean factory 自身来维护。

2. prototype:原形范围与单例范围相反,为每一个 bean 请求提供一个实例。

3. request:在请求 bean 范围内会每一个来自客户端的网络请求创建一个实例,在请求完成以后,bean 会失效并被垃圾回收器回收。

4.Session:与请求范围类似,确保每个session中有一个bean的实例,在

session 过期后,bean 会随之失效。

5. global- session:global-session 和 Portlet 应用相关。当你的应用部署在Portlet 容器中工作时,它包含很多 portlet。如果你想要声明让所有的portlet 共用全局的存储变量的话,那么这全局变量需要存储在 global- session 中。

全局作用域与 Servlet 中的 session 作用域效果相同。

12、什么是 Spring inner beans

在 Spring 框架中,无论何时 bean 被使用时,当仅被调用了一个属性。一个明智的做法是将这个 bean 声明为内部 bean。内部 bean 可以用 setter 注入“属性”和构造方法注入“构造参数”的方式来实现。

比如,在我们的应用程序中,一个 Customer 类引用了一个 Person 类, 我们的要做的是创建一个 Person 的实例,然后在 Customer 内部使用。

public class Customer{ private Person person;

//Setters and Getters

}

public class

Person{ private String name; private String address; private int age

内部bean 的声明方式如下:

13、Spring 框架中的单例 Beans 是线程安全的么

Spring 框架并没有对单例 bean 进行任何多线程的封装处理。关于单例bean 的线程安全和并发问题需要开发者自行去搞定。但实际上,大部分的 Spring bean 并没有可变的状态(比如 Serview 类和 DAO 类),所以在某种程度上说 Spring 的单例 bean 是线程安全的。如果你的 bean 有多种状态的话(比如 View Model 对象),就需要自行保证线程安全。

最浅显的解决办法就是将多态 bean 的作用域由“singleton”变更为“prototype”。

14、请举例说明如何在 Spring 中注入一个 Java Collection

Spring 提供了以下四种集合类的配置元素:

- 该标签用来装配可重复的 list 值。

- 该标签用来装配没有重复的 set 值。

- 该标签可用来注入键和值可以为任何类型的键值对

- 该标签支持注入键和值都是字符串类型的键值对。

下面看一下具体的例子:

INDIA

Pakistan

USA

UK

INDIA

Pakistan

USA

UK

[email protected]

[email protected]

15、如何向 Spring Bean 中注入一个 Java.util.Properties

第一种方法是使用如下面代码所示的标签:

[email protected]

[email protected]

也可用”util:”命名空间来从 properties 文件中创建出一个 propertiesbean,然后利用 setter 方法注入 bean 的引用。

16、请解释 Spring Bean 的自动装配

在 Spring 框架中,在配置文件中设定 bean 的依赖关系是一个很好的机制,Spring 容器还可以自动装配合作关系 bean 之间的关联关系。这意味着 Spring 可以通过向 Bean Factory 中注入的方式自动搞定 bean 之间的依赖关系。自动装配可以设置在每个 bean 上,也可以设定在特定的 bean 上。下面的XML 配置文件表明了如何根据名称将一个 bean 设置为自动装配:

除了 bean 配置文件中提供的自动装配模式,还可以使用@Autowired 注解来自动装配指定的 bean。在使用@Autowired 注解之前需要在按照如下的配置方式在 Spring 配置文件进行配置才可以使用。

也可以通过在配置文件中配置 AutowiredAnnotationBeanPostProcessor 达到相同的效果。

配置好以后就可以使用@Autowired 来标注了。

@Autowired

public EmployeeDAOImpl ( EmployeeManager manager ) { this.manager = manager;

}

17、请解释自动装配模式的区别

在 Spring 框架中共有 5 种自动装配,让我们逐一分析。

1. no:这是 Spring 框架的默认设置,在该设置下自动装配是关闭的,开发者需要自行在 bean 定义中用标签明确的设置依赖关系。

2. byName:该选项可以根据 bean 名称设置依赖关系。当向一个 bean 中自动装配一个属性时,容器将根据 bean 的名称自动在在配置文件中查询一个匹配的 bean。如果找到的话,就装配这个属性,如果没找到的话就报错。

3. byType:该选项可以根据 bean 类型设置依赖关系。当向一个 bean 中自动装配一个属性时,容器将根据 bean 的类型自动在在配置文件中查询一个匹配的 bean。如果找到的话,就装配这个属性,如果没找到的话就报错。

4. constructor:构造器的自动装配和 byType 模式类似,但是仅仅适用于与有构造器相同参数的 bean,如果在容器中没有找到与构造器参数类型一致的 bean,那么将会抛出异常。

5. autodetect:该模式自动探测使用构造器自动装配或者 byType 自动装配。首先,首先会尝试找合适的带参数的构造器,如果找到的话就是用构造器自动装配,如果在 bean 内部没有找到相应的构造器或者是无参构造器,容器就会自动选择 byTpe 的自动装配方式。

18、如何开启基于注解的自动装配

要使用@Autowired,需要注册AutowiredAnnotationBeanPostProcessor,可以

有以下两种方式来实现:

引入配置文件中的下引入context:annotation-config

class="org.springframework.beans.factory.annotation.AutowiredA nnotati

onBeanPostProcessor"/>

在bean配置文件中直接引入AutowiredAnnotationBeanPostProcessor

19、请举例解释@Required 注解

在产品级别的应用中,IoC容器可能声明了数十万了bean,bean与bean

之间有着复杂的依赖关系。设值注解方法的短板之一就是验证所有的属性

是否被注解是一项十分困难的操作。可以通过在中设置“dependency-check”来解决这个问题。

在应用程序的生命周期中,你可能不大愿意花时间在验证所有 bean 的属性是否按照上下文件正确配置。或者你宁可验证某个 bean 的特定属性是否被正确的设置。即使是用“dependency- check”属性也不能很好的解决这个问题,在这种情况下,你需要使用@Required 注解。

需要用如下的方式使用来标明bean 的设值方法:

public class EmployeeFactoryBean extends AbstractFactoryBean{

private String designation; public String getDesignation() {

return designation;

}

@Required

public void setDesignation(String designation)

{ this.designation = designation;

}

//more code here

}

RequiredAnnotationBeanPostProcessor 是 Spring 中的后置处理用来验证被@Required 注解的 bean 属性是否被正确的设置了。在使用RequiredAnnotationBeanPostProcesso 来验证 bean 属性之前,首先要在IoC 容器中对其进行注册:但是如果没有属性被用@Required 注解过的话,后置处理器会抛出一个BeanInitializationException 异常。

20、请举例解释@Autowired 注解

@Autowired 注解对自动装配何时何处被实现提供了更多细粒度的控制。@Autowired 注解可 以像@Required 注解、构造器一样被用于在 bean 的设置方法上自动装配 bean 的属性,一个参数或者带有任意名称或带有多个参数的方法。比如,可以在设值方法上使用@Autowired 注解来替代配置文件中的元素当Spring容器在setter方法上找到@Autowired 注解时,会尝试用 byType 自动装配。当然我们也可以在构造方法上使用@Autowired 注解。带有@Autowired 注解的构造方法意味着在创建一个bean时将会被自动装配,即便在配置文件中使用元素。

public class TextEditor {

private SpellChecker spellChecker; @Autowired

public TextEditor(SpellChecker spellChecker)

{

System.out.println("Inside TextEditor constructor." );

this.spellChecker = spellChecker;

}

public void spellCheck(){ spellChecker.checkSpelling();

下面是没有构造参数的配置方式:

21、请举例说明@Qualifier 注解

@Qualifier 注解意味着可以在被标注 bean 的字段上可以自动装配。Qualifier 注解可以用来取消 Spring 不能取消的 bean 应用。下面的示例将会在Customer 的 person 属性中自动装配 person 的值

public class Customer{ @Autowired

private Person person

下面我们要在配置文件中来配置 Person 类。

Spring 会知道要自动装配哪个 person bean 么不会的,但是运行上面的示例时,会抛出下面的异常:

Caused by: org.springframework.beans.factory.NoSuchBeanDefinitionExceptio n:

No unique bean of type [com.howtodoinjava.common.Person] is de fined: expected single matching bean but found2: [personA, pe rsonB]

要解决上面的问题,需要使用@Quanlifier注解来告诉Spring容器要装配哪个bean:

public class Customer{ @Autowired @Qualifier("personA") private Person person;

}

22、构造方法注入和设值注入有什么区别 请注意以下明显的区别:

1. 在设值注入方法支持大部分的依赖注入,如果我们仅需要注入int、 string和long型的变量,我们不要用设值的方法注入。对于基本类型,如果我们没有注入的话,可以为基本类型设置默认值。在构造方法 注入不支持大部分的依赖注入,因为在调用构造方法中必须传入正确的构造参数,否 则的话为报错。

2. 设值注入不会重写构造方法的值。如果我们对同一个变量同时使用了构造方法注入又使用了设置方法注入的话,那么构造方法将不能覆盖由设值方法注入的值。很明显,因为构造方法在对象被创建时调用。

3. 在使用设值注入时有可能还不能保证某种依赖是否已经被注入,也就是说这时对象的依赖关系有可能是不完整的。而在另一种情况下,构造器注入则不允许生成依赖关系不完整的对象。

4. 在设值注入时如果对象A和对象B互相依赖,在创建对象A时Spring会抛出 sObjectCurrentlyInCreationException 异常,因为在 B 对象被创建之前A 对象是不能被创建的,反之亦然。所以 Spring 用设值注入的方法解决了循环依赖的问题,因对象的设值方法是在对象被创建之前被调用的。

23、Spring 框架中有哪些不同类型的事件

Spring的ApplicationContext 提供了支持事件和代码中监听器的功能。我们可以创建bean用来监听在ApplicationContext 中发布的事件。ApplicationEvent类和在ApplicationContext接口中处理的事件,如果一个bean实现了ApplicationListener接口,当一个ApplicationEvent 被发布以后,bean 会自动被通知。

public class AllApplicationEventListener implements Applicatio nListener < ApplicationEvent >{

@Override

public void onApplicationEvent(ApplicationEvent applicatio nEvent)

{

//process event

}

}

Spring 提供了以下 5 种标准的事件:

1.上下文更新事件(ContextRefreshedEvent):该事件会在ApplicationContext被初始化或者更新时发布。也可以在调用 ConfigurableApplicationContext接口中的 refresh()方法时被触发。

2. 上下文开始事件(ContextStartedEvent):当容器调用ConfigurableApplicationContext的 Start()方法开始/重新开始容器时触发该事件。

3.上下文停止事件(ContextStoppedEvent):当容器调用ConfigurableApplicationContext的 Stop()方法停止容器时触发该事件。

4. 上下文关闭事件(ContextClosedEvent):当ApplicationContext被关闭时触发该事件。容器被关闭时,其管理的所有单例 Bean 都被销毁。

5.请求处理事件(RequestHandledEvent):在Web应用中,当一个http请求(request)结束 触发该事件。

public class CustomApplicationEvent extends ApplicationEvent{ public CustomApplicationEvent ( Object source, final String ms g ){

super(source);

System.out.println("Created a Custom event");

}

}

为了监听这个事件,还需要创建一个监听器:

public class CustomEventListener implements ApplicationListene r <

CustomApplicationEvent >{ @Override

public void onApplicationEvent(CustomApplicationEvent applicationEvent) {

//handle event

}

}

之后通过 applicationContext 接口的 publishEvent()方法来发布自定义事件。

CustomApplicationEvent customEvent = new

CustomApplicationEvent(applicationContext, "Test message");

applicationContext.publishEvent(customEvent);

24、FileSystemResource 和 ClassPathResource 有何区别

在 FileSystemResource 中需要给出 spring-config.xml 文件在你项目中的相对路径或者绝对路径。在 ClassPathResource 中 spring 会在 ClassPath 中自动搜寻配置文件,所以要把 ClassPathResource 文件放在 ClassPath下。

如果将 spring-config.xml 保存在了 src 文件央下的话,只需给出配置文件的名称即可,因为 src 文件央是默认。

简而言之,ClassPathResource 在环境变量中读取配置文件,

FileSystemResource 在配置文件中读取配置文件。

25、Spring 框架中都用到了哪些设计模式

Spring 框架中使用到了大量的设计模式,下面列举了比较有代表性的:

- 代理模式—在AOP和remoting中被用的比较多。

- 单例模式—在spring配置文件中定义的bean默认为单例模式。

- 模板方法—用来解决代码重复的问题。比如.RestTemplate,JmsTemplate,JpaTempl ate。

- 前端控制器—Spring提供了DispatcherServlet来对请求进行分发。

- 视图帮助(ViewHelper)—Spring提供了一系列的JSP标签,高效宏来辅助将分散的代码整合在视图里。

- 依赖注入—贯穿于BeanFactory/ApplicationContext接口的核心理念。

- 工厂模式—BeanFactory用来创建对象的实例

26、开发中主要使用 Spring 的什么技术

1.IOC容器管理各层的组件

2.使用AOP配置声明式事务

3.整合其他框架.

27、简述 AOP 和 IOC 概念 AOP:

Aspect Oriented Program, 面向(方面)切面的编程;Filter(过滤器) 也是一种AOP. AOP 是一种新的方法论, 是对传统 OOP(Object-Oriented Programming, 面向对象编程) 的补充. AOP 的 主要编程对象是切面(aspect), 而切面模块化横切关注点.可以举例通过事务说明.

IOC: Invert Of Control, 控制反转.也成为DI(依赖注入)其思想是反转资源获取的方向.传统的资源查找方式要求组件向容器发起请求查找资源.作为回应,容器适时的返回资源.而应用了IOC 之后,则是容器主动地将资源推送给它所管理的组件,组件所要做的仅是选择一种合适的方式来接受资源.这种行为也被称为查找的被动形式

28、在 Spring 中如何配置 Bean

Bean的配置方式:

- 通过全类名(反射)

- 通过工厂方法(静态工厂方法&实例工厂方法)

- FactoryBean

29、IOC 容器对 Bean 的生命周期:

1.通过构造器或工厂方法创建Bean实例

2.为Bean的属性设置值和对其他Bean的引用

3.将Bean实例传递给Bean后置处理器的postProcessBeforeInitialization方法

4.调用Bean的初始化方法(init-method)

5.将Bean实例传递给Bean后置处理器的postProcessAfterInitialization方法

6.Bean可以使用了

7.当容器关闭时,调用Bean的销毁方法(destroy-method)

下载链接:https://pan.baidu.com/s/1nwlBO2tYXDDl7OjGhs4e4Q

提取码:1111

SpringMVC原理篇

1、什么是 SpringMvc

SpringMvc 是 spring 的一个模块,基于 MVC 的一个框架,无需中间整合层来整合。

2、Spring MVC 的优点:

1.它是基于组件技术的.全部的应用对象,无论控制器和视图,还是业务对象之类的都是java组件.并且和Spring提供的其他基础结构紧密集成.

2.不依赖于ServletAPI(目标虽是如此,但是在实现的时候确实是依赖于Servlet的)

3.可以任意使用各种视图技术,而不仅仅局限于JSP

4.支持各种请求资源的映射策略

5.它应是易于扩展的

3、SpringMVC 工作原理

1.客户端发送请求到DispatcherServlet

2.DispatcherServlet查询handlerMapping找到处理请求的Controller

3.Controller调用业务逻辑后,返回ModelAndView 4.DispatcherServlet查询ModelAndView,找到指定视图5.视图将结果返回到客户端

4、SpringMVC 流程

1.用户发送请求至前端控制器 DispatcherServlet。

2.DispatcherServlet 收到请求调用 HandlerMapping 处理器映射器。

3. 处理器映射器找到具体的处理器(可以根据 xml 配置、注解进行查找),生成处理器对象及处理器拦截器(如果有则生成)一并返回给 DispatcherServlet。

4. DispatcherServlet 调用 HandlerAdapter 处理器适配器。

5.HandlerAdapter 经过适配调用具体的处理器(Controller,也叫后端控制器)。

6.Controller 执行完成返回 ModelAndView。

7.HandlerAdapter 将 controller 执行结果 ModelAndView 返回给DispatcherServlet。

8. DispatcherServlet 将 ModelAndView 传给 ViewReslover 视图解析器。

9. ViewReslover 解析后返回具体 View。

10. DispatcherServlet 根据 View 进行渲染视图(即将模型数据填充至视图中)。

11. DispatcherServlet 响应用户。

5、SpringMVC的控制器是不是单例模式,如果是,有什么问题,怎么解决

是单例模式,所以在多线程访问的时候有线程安全问题,不要用同步,会影响性能的,解决方案是在控制器里面不能写字段。

6、如果你也用过 struts2.简单介绍下 springMVC 和 struts2 的区别有哪些

1.springmvc的入口是一个servlet即前端控制器,而struts2 入口是一个

filter 过滤器。

2. springmvc 是基于方法开发(一个 url 对应一个方法),请求参数传递到方法的形参,可以设计为单例或多例(建议单例),struts2 是基于类开发,传递参数是通过类的属性,只能设 计为多例。

3. Struts 采用值栈存储请求和响应的数据,通过 OGNL 存取数据, springmvc 通过参数解析器是将 request 请求内容解析,并给方法形参赋值,将数据和视图封装成 ModelAndView 对象,最后又将 ModelAndView 中的模型数据通过 reques 域传输到页面。Jsp 视图解析器默认使用 jstl。

7、SpringMVC中的控制器的注解一般用那个,有没有别的注解可以替代

一般用@Conntroller 注解,表示是表现层,不能用用别的注解代替。

8、 @RequestMapping 注解用在类上面有什么作用

是一个用来处理请求地址映射的注解,可用于类或方法上。用于类上,表示类中的所有响应请求的方法都是以该地址作为父路径。

9、怎么样把某个请求映射到特定的方法上面

答:直接在方法上面加上注解@RequestMapping,并且在这个注解里面写上要拦截的路径

10、如果在拦截请求中,我想拦截 get 方式提交的方法,怎么配置

可以在@RequestMapping 注解里面加上 method=RequestMethod.GET

11、怎么样在方法里面得到 Request,或者 Session

直接在方法的形参中声明 request,SpringMvc 就自动把 request 对象传入

12、我想在拦截的方法里面得到从前台传入的参数,怎么得到

答:直接在形参里面声明这个参数就可以,但必须名字和传过来的参数一样

13、如果前台有很多个参数传入,并且这些参数都是一个对象的,那么怎么样快速得到这个对象

直接在方法中声明这个对象,SpringMVC 就自动会把属性赋值到这个对象里面。

14、SpringMVC中函数的返回值是什么

答:返回值可以有很多类型,有 String, ModelAndView,但一般用 String 比较好。

15、SpringMVC 怎么样设定重定向和转发的

在返回值前面加"forward:“就可以让结果转发,比如"forward:user.doname=method4”

在返回值前面加"redirect:"就可以让返回值重定向,比如redirect:http://www.baidu.com

16、SpringMVC用什么对象从后台向前台传递数据的

答:通过 ModelMap 对象,可以在这个对象里面用 put 方法,把对象加到里面, 前台就可以通过 el 表达式拿到。

17、SpringMVC中有个类把视图和数据都合并的一起的,叫什么

叫 ModelAndView。

18、怎么样把 ModelMap 里面的数据放入 Session 里面

可以在类上面加上@SessionAttributes 注解,里面包含的字符串就是要放入session 里面的 key

19、SpringMVC 怎么和 AJAX 相互调用的

通过Jackson 框架就可以把 Java 里面的对象直接转化成 Js 可以识别的Json 对象。

具体步骤如下 :

1.加入Jackson.jar

2.在配置文件中配置json的映射

3.在接受Ajax方法里面可以直接返回Object,List等,但方法前面要加上@ResponseBody 注解

20、当一个方法向 AJAX 返回特殊对象,譬如 Object,List 等,需要做什么处理

要加上@ResponseBody 注解

21、SpringMVC里面拦截器是怎么写的

有两种写法,一种是实现接口,另外一种是继承适配器类,然后在 SpringMvc

22、讲下 SpringMVC 的执行流程

系统启动的时候根据配置文件创建spring的容器, 首先是发送http请求到核心控制器 disPatherServlet,spring 容器通过映射器去寻找业务控制器,使用适配器找到相应的业务类,在进业务类时进行数据封装,在封装前可能会涉及到类型转换,执行完业务类后使用 ModelAndView 进行视图转发, 数据放在 model 中,用 map 传递数据进行页面显示。

MyBatis框架篇

1、什么是 MyBatis

MyBatis 是一个可以自定义 SQL、存储过程和高级映射的持久层框架。

2、讲下 MyBatis 的缓存

MyBatis的缓存分为一级缓存和二级缓存,一级缓存放在session里面,默认就有,二级缓存放在它的命名空间里,默认是不打开的,使用二级缓存属性类需要实现Serializable序列化接口(可用来保存对象的状态),可在它的映射文件中配置

3、Mybatis 是如何进行分页的分页插件的原理是什么

1. Mybatis 使用 RowBounds 对象进行分页,也可以直接编写 sql 先分页, 也可以使用 Mybatis 的分页插件。

2. 分页插件的原理:实现 Mybatis 提供的接口,实现自定义插件,在插件的拦截方法内拦截待执行的 sql,然后重写 sql。

select * from student

拦截sql 后重写为:

select t.* from (select * from student)t limit 0,10

4、简述 Mybatis 的插件运行原理以及如何编写一个插件

1. Mybatis 仅可以编写针对 ParameterHandler、ResultSetHandler、StatementHandler、 Executor 这 4 种接口的插件,Mybatis 通过动态代理,为需要拦截的接口生成代理对象以实 现接口方法拦截功能,每当执行这 4 种接口对象的方法时,就会进入拦截方法,具体就是InvocationHandler 的 invoke()方法,当然,只会拦截那些你指定需要拦截的方法。

2. 实现 Mybatis 的 Interceptor 接口并复写 intercept()方法,然后在给插件编写注解,指定要拦截哪一个接口的哪些方法即可,记住,别忘了在配置文件中配置你编写的插件。

5、Mybatis 动态 sql 是做什么的都有哪些动态 sql能简述一下动态 sql的执行原理吗

1. Mybatis 动态 sql 可以让我们在 Xml 映射文件内,以标签的形式编写动态 sql,完成逻辑 判断和动态拼接 sql 的功能。

2.Mybatis提供了9种动态sql标签:

trim|where|set|foreach|if|choose|when|otherwise|bind。

3. 其执行原理为,使用 OGNL 从 sql 参数对象中计算表达式的值,根据表达式的值动态拼接 sql,以此来完成动态 sql 的功能。

6、#{}和${}的区别是什么

1.#{}是预编译处理,${}是字符串替换。

2.Mybatis在处理#{}时,会将sql中的#{}替换为号,调用PreparedStatement的set方法来赋值;

3.Mybatis在处理 时 , 就是把 {}时,就是把 时,就是把{}替换成变量的值。

4.使用#{}可以有效的防止SQL注入,提高系统安全性。

7、为什么说 Mybatis 是半自动 ORM 映射工具它与全自动的区别在哪里

Hibernate 属于全自动 ORM 映射工具,使用 Hibernate 查询关联对象或者关联集合对象时,可以根据对象关系模型直接获取,所以它是全自动的。而 Mybatis 在查询关联对象或关联集合对象时,需要手动编写 sql 来完成,所以,称之为半自动 ORM 映射工具。

8、Mybatis是否支持延迟加载如果支持它的实现原理是什么

1.Mybatis 仅支持 association 关联对象和 collection 关联集合对象的延迟加载,association 指的就是一对一,collection 指的就是一对多查询。在Mybatis 配置文件中,可以配置是否启用延迟加载lazyLoadingEnabled=true|false

2.它的原理是,使用 CGLIB 创建目标对象的代理对象,当调用目标方法时,进入拦截器方法,比如调用a.getB().getName(),拦截器invoke()方法发现a.getB()是null值,那么就会单独发送事先保存好的查询关联B对象的sql,把B查询上来,然后调a.setB(b)于是a 的对象 b方法的属性性调用就有值了,接着完成a.getB().getName()。这就是延迟加载的基本原理。

9、MyBatis 与 Hibernate 有哪些不同

1. Mybatis 和 hibernate 不同,它不完全是一个 ORM 框架,因为 MyBatis 需要程序员自己编写 Sql 语句,不过 mybatis 可以通过 XML 或注解方式灵活配置要运行的 sql 语句,并将 java 对象和 sql 语句映射生成最终执行的sql,最后将 sql 执行的结果再映射生成 java 对象。

2.Mybatis学习门槛低,简单易学,程序员直接编写原生态 sql,可严格控制 sql 执行性能,灵活度高,非常适合对关系数据模型要求不高的软件开发,例如互联网软件、企业运营类软件等,因为这类软件需求变化频繁, 一但需求变化要求成果输出迅速。但是灵活的前提是 mybatis 无法做到数据库无关性,如果需要实现支持多种数据库的软件则需要自定 义多套 sql 映射文件,工作量大。

3. Hibernate 对象/关系映射能力强,数据库无关性好,对于关系模型要求高的软件(例如需求固定的定制化软件)如果用 hibernate 开发可以节省很多代码,提高效率。但是 Hibernate 的缺点是学习门槛高,要精通门槛更高,而且怎么设计 O/R 映射,在性能和对象模型之间如何权衡,以及怎样用好 Hibernate 需要具有很强的经验和能力才行。总之,按照用户的需求在有限的资源环境下只要能做出维护性、扩展性良好的软件架构都是好架构,所以框架只有适合才是最好。

10、MyBatis 的好处是什么

1. MyBatis 把 sql 语句从 Java 源程序中独立出来,放在单独的 XML 文件中编写,给程序的维护带来了很大便利。

2.MyBatis封装了底层JDBC API的调用细节,并能自动将结果集转换成Java Bean 对象,大大简化了 Java 数据库编程的重复工作。

3. 因为 MyBatis 需要程序员自己去编写 sql 语句,程序员可以结合数据库自身的特点灵活控制 sql 语句,因此能够实现比 Hibernate 等全自动 orm 框架更高的查询效率,能够完成复杂查询。

11、简述 Mybatis 的 Xml 映射文件和 Mybatis 内部数据结构之间的映射关系

Mybatis 将所有 Xml 配置信息都封装到 All-In-One 重量级对象Configuration内部。在Xml映射文件中,标签会被解析为ParameterMap对象,其每个子元素会 被解析为ParameterMapping对象。标签会被解析为ResultMap对象,其每个子元素会被解析为ResultMapping 对象。每一个、、、 标签均会被解析为 MappedStatement 对象,标签内的 sql 会被解析为 BoundSql 对象。

12、什么是 MyBatis 的接口绑定,有什么好处

接口映射就是在MyBatis 中任意定义接口,然后把接口里面的方法和SQL 语句绑定,我们直接调用接口方法就可以,这样比起原来了Sql Session提供的方法我们可以有更加灵活的选择和设置.

13、接口绑定有几种实现方式,分别是怎么实现的

接口绑定有两种实现方式,一种是通过注解绑定,就是在接口的方法上面加上@Select@Update等注解里面包含Sql语句来绑定,另外一种就是通过xml里面写SQL来绑定,在这种情况下,要指定xml映射文件里面的namespace必须为接口的全路径名.

14、什么情况下用注解绑定,什么情况下用 xml 绑定

当Sql 语句比较简单时候,用注解绑定;当SQL 语句比较复杂时候,用xml绑定,一般用xml 绑定的比较多

15、MyBatis 实现一对一有几种方式具体怎么操作的

有联合查询和嵌套查询,联合查询是几个表联合查询,只查询一次,通过在resultMap 里面配置 association 节点配置一对一的类就可以完成;嵌套查询是先查一个表,根据这个表里面的结果的外键 id,去再另外一个表里面查询数据,也是通过 association 配置,但另外一个表的查询通过 select 属性配置。

16、Mybatis能执行一对一、一对多的关联查询吗都有哪些实现方式以及它们之间的区别

能,Mybatis 不仅可以执行一对一、一对多的关联查询,还可以执行多对一,多对多的关联查询,多对一查询,其实就是一对一查询,只需要把selectOne()修改为 selectList()即可;多对多查询,其实就是一对多查询,只需要把 selectOne()修改为 selectList()即可。

关联对象查询,有两种实现方式,一种是单独发送一个 sql 去查询关联对象,赋给主对象,然后返回主对象。另一种是使用嵌套查询,嵌套查询的 含义为使用 join 查询,一部分列是 A 对象的属性值,另外一部分列是关联对象 B 的属性值,好处是只发一个 sql 查询,就可以把主对象和其关联对象查出来。

17、MyBatis 里面的动态 Sql 是怎么设定的用什么语法

MyBatis 里面的动态 Sql 一般是通过 if 节点来实现,通过 OGNL 语法来实现,但是如果要写的完整,必须配合 where,trim 节点,where 节点是判断包含节点有内容就插入 where,否则不插入,trim 节点是用来判断如果动态语句是以 and 或 or 开始,那么会自动把这个 and 或者 or 取掉。

18、Mybatis 是如何将 sql 执行结果封装为目标对象并返回的都有哪些映射形式

第一种是使用标签,逐一定义列名和对象属性名之间的映射关系。

第二种是使用sql 列的别名功能,将列别名书写为对象属性名,比如T_NAME AS NAME,对象属性名一般是 name,小写,但是列名不区分大小写,Mybatis 会忽略列名大小写,只能找到与之对应对象属性名,你甚至可以写成T_NAME AS NAME,MyBatis一样可以正常工作。有了列名与属性名的映射关系后,Mybatis 通过反射创建对象,同时使用反射给对象的属性逐一赋值并返回,那些找不到映射关系的属性,是无法完成赋值的。

19、Xml 映射文件中除了常见的 select|insert|updae|delete 标签之外还有哪些标签

还有很多其他的标签,、、、、 ,加上动态 sql 的 9 个标签,

trim|where|set|foreach|if|choose|when|otherwise|bind等,其中为sql片段标签,通过标签引入sql片段为不支持自增的主键生成策略标签

20、当实体类中的属性名和表中的字段名不一样如果将查询的结果封装到指定 pojo

1. 通过在查询的 sql 语句中定义字段名的别名。

2.通过来映射字段名和实体类属性名的一一对应的关系。

21、模糊查询 like 语句该怎么写

1.在java中拼接通配符,通过#{}赋值

2.在Sql语句中拼接通配符(不安全会引起Sql注入)

22、通常一个 Xml 映射文件都会写一个 Dao 接口与之对应, Dao 的工作原理是否可以重载

不能重载,因为通过 Dao 寻找 Xml 对应的 sql 的时候权限名+方法名的保存和寻找策略。接口工作原理为 jdk 动态代理原理,运行时会为 dao 生成proxy,代理对象会拦截接口方法,去执行对应的 sql 返回数据。

23、Mybatis 映射文件中如果 A标签通过include引用了B 标签的内容请问B标签能否定义在A标签的后面还是说必须定义在A标签的前面

虽然 Mybatis 解析 Xml 映射文件是按照顺序解析的,但是,被引用的 B 标签依然可以定义在任何地方,Mybatis 都可以正确识别。原理是,Mybatis 解析 A 标签,发现 A 标签引用了 B 标签,但是 B 标签尚未解析到,尚不存在,此时,Mybatis 会将 A 标签标记为未解析状态,然后继续解析余下的标签,包含 B 标签,待所有标签解析完毕,Mybatis 会重新解析那些被标记为未解析的标签,此时再解析 A 标签时,B 标签已经存在,A 标签也就可以正常解析完成了。

24、Mybatis 的 Xml 映射文件中不同的 Xml 映射文件id 是否可以重复

不同的 Xml 映射文件,如果配置了 namespace,那么 id 可以重复;如果没有配置 namespace,那么 id 不能重复;毕竟 namespace 不是必须的,只是最佳实践而已。原因就是 namespace+id 是作为Map

25、Mybatis 中如何执行批处理

使用 BatchExecutor 完成批处理。

26、Mybatis 都有哪些 Executor 执行器它们之间的区别是什么

Mybatis 有三种基本的Excutor执行器,SimpleExecutor、ReuseExecutor、 BatchExecutor。

1、SimpleExecutor:每执行一次Updata或者select就开启一个statement对象,用完立刻关闭 Statement 对象.

2、ReuseExecutor:执行update或select,以sql作为key查找Statement对象,存在就使用,不存在就创建,用完后,不关闭Statement对象,而是放置于Map

3、BatchExecutor:完成批处理。

27、Mybatis 中如何指定使用哪一种 Executor 执行器

在 Mybatis 配置文件中,可以指定默认的 ExecutorType 执行器类型,也可以手动给 DefaultSqlSessionFactory 的创建 SqlSession 的方法传递ExecutorType 类型参数。

28、Mybatis 执行批量插入能返回数据库主键列表吗

能,JDBC 都能,Mybatis 当然也能。

29、Mybatis 是否可以映射 Enum 枚举类

Mybatis 可以映射枚举类,不单可以映射枚举类,Mybatis 可以映射任何对象到表的一列上。映射方式为自定义一个 TypeHandler,实现 TypeHandler的 setParameter()和 getResult()接口方法。

TypeHandler 有两个作用,一是完成从 javaType 至 jdbcType 的转换, 二是完成 jdbcType 至 javaType 的转换,体现为 setParameter()和 getResult()两个方法,分别代表设置 sql 问号占位符参数和获取列查询结果。

30、如何获取自动生成的(主)键值

配置文件设置usegeneratedkeys 为 true

31、在 mapper 中如何传递多个参数

1.直接在方法中传递参数,xml文件用#{0}#{1}来获取

2.使用@param注解:这样可以直接在xml文件中通过#{name}来获取

32、resultType resultMap 的区别

1.类的名字和数据库相同时,可以直接设置 resultType参数为Pojo 类

2.若不同,需要设置resultMap将结果名字和Pojo名字进行转换

33、使用 MyBatis 的 mapper 接口调用时有哪些要求

类型相同

1.Mapper接口方法名和mapper.xml中定义的每个sql的id 相同

2.Mapper接口方法的输入参数类型和mapper.xml中定义的每个sql的parameterType的类型相同

3.Mapper接口方法的输出参数类型和mapper.xml中定义的每个sql的resultType 的类型相同

4. Mapper.xml 文件中的 namespace 即是 mapper 接口的类路径。

34、Mybatis 比 IBatis 比较大的几个改进是什么

1.有接口绑定,包括注解绑定sql和xml绑定Sql

2.动态sql由原来的节点配置变成OGNL表达式

3.在一对一,一对多的时候引进了association,在一对多的时候引入了collection 节点,不过都是在 resultMap 里面配置

35、IBatis 和 MyBatis 在核心处理类分别叫什么

IBatis 里面的核心处理类叫SqlMapClient,MyBatis 里面的核心处理类叫做SqlSession。

36、IBatis 和 MyBatis 在细节上的不同有哪些

1. 在 sql 里面变量命名有原来的#变量#变成了#{变量}

2.原来的 变量 变量 变量变成了${变量}

3. 原来在 sql 节点里面的 class 都换名字叫 type

4.原来的queryForObjectqueryForList变成了selectOneselectList5)原来的别名设置在映射文件里面放在了核心配置文件里

Netty篇

1.BIO、NIO 和 AIO 的区别?

BIO:一个连接一个线程,客户端有连接请求时服务器端就需要启动一个线程进行处理。线程开销大。

**伪异步 IO:**将请求连接放入线程池,一对多,但线程还是很宝贵的资源。

**NIO:**一个请求一个线程,但客户端发送的连接请求都会注册到多路复用器上,多路复用器轮询到连接有 I/O 请求时才启动一个线程进行处理。

**AIO:**一个有效请求一个线程,客户端的 I/O 请求都是由 OS 先完成了再通知服务器应用去启动线程进行处理。

- BIO 是面向流的,NIO 是面向缓冲区的;

- BIO 的各种流是阻塞的。而 NIO 是非阻塞的;

- BIO 的 Stream 是单向的,而 NIO 的 channel 是双向的。

NIO 的特点:事件驱动模型、单线程处理多任务、非阻塞 I/O,I/O 读写不再阻塞,而是返回 0、基于 block 的传输比基于流的传输更高效、更高级的 IO 函数 zero-copy、IO 多路复用大大提高了 Java 网络应用的可伸缩性和实用性。基于 Reactor 线程模型。

在 Reactor 模式中,事件分发器等待某个事件或者可应用或个操作的状态发生,事件分发器 就把这个事件传给事先注册的事件处理函数或者回调函数,由后者来做实际的读写操作。如在 Reactor 中实现读:注册读就绪事件和相应的事件处理器、事件分发器等待事件、事件到 来,激活分发器,分发器调用事件对应的处理器、事件处理器完成实际的读操作,处理读到 的数据,注册新的事件,然后返还控制权。

2.NIO 的组成

**Buffer:**与Channel进行交互,数据是从Channel读入缓冲区,从缓冲区写入Channel中的flip方法:反转此缓冲区,将position给limit,然后将position置为0,其实就是切换读写模式

**clear方法:**清除此缓冲区,将position置为0,把capacity的值给limit。

**rewind方法:**重绕此缓冲区,将position置为0

DirectByteBuffer可减少一次系统空间到用户空间的拷贝。但Buffer创建和销毁的成本更高,不可控,通常会用内存池来提高性能。直接缓冲区主要分配给那些易受基础系统的本机I/O操作影响的大型、持久的缓冲区。如果数据量比较小的中小应用情况下,可以考虑使用heapBuffer,由JVM进行管理。

Channel:表示IO源与目标打开的连接,是双向的,但不能直接访问数据,只能与Buffer进行交互。通过源码可知,FileChannel的read方法和write方法都导致数据复制了两次!

**Selector:**可使一个单独的线程管理多个Channel,open方法可创建Selector,register方法向多路复用器器注册通道,可以监听的事件类型:读、写、连接、accept。注册事件后会产生一个SelectionKey:它表示SelectableChannel和Selector之间的注册关系,wakeup方法:使尚未返回的第一个选择操作立即返回,唤醒的原因是:注册了新的channel或者事件;channel关闭,取消注册;优先级更高的事件触发(如定时器事件),希望及时处理。

Selector在Linux的实现类是EPollSelectorImpl,委托给EPollArrayWrapper实现,其中三个native方法是对epoll的封装,而EPollSelectorImpl.implRegister方法,通过调用epoll_ctl向epoll实例中注册事件,还将注册的文件描述符(fd)与SelectionKey的对应关系添加到fdToKey中,这个map维护了文件描述符与SelectionKey的映射。

fdToKey有时会变得非常大,因为注册到Selector上的Channel非常多(百万连接);过期或失效的Channel没有及时关闭。fdToKey总是串行读取的,而读取是在select方法中进行的,该方法是非线程安全的。

Pipe:两个线程之间的单向数据连接,数据会被写到sink通道,从source通道读取NIO的服务端建立过程:Selector.open():打开一个Selector;ServerSocketChannel.open():创建服务端的Channel;bind():绑定到某个端口上。并配置非阻塞模式;register():注册Channel和关注的事件到Selector上;select()轮询拿到已经就绪的事件.

3.Netty的特点?

一个高性能、异步事件驱动的NIO框架,它提供了对TCP、UDP和文件传输的支持,使用更高效的socket底层,对epoll空轮询引起的cpu占用飙升在内部进行了处理,避免了直接使用NIO的陷阱,简化了NIO的处理方式。 采用多种decoder/encoder支持,对TCP粘包/分包进行自动化处理 可使用接受/处理线程池,提高连接效率,对重连、心跳检测的简单支持 可配置IO线程数、TCP参数,TCP接收和发送缓冲区使用直接内存代替堆内存,通过内存池的方式循环利用ByteBuf 通过引用计数器及时申请释放不再引用的对象,降低了GC频率 使用单线程串行化的方式,高效的Reactor线程模型 大量使用了volitale、使用了CAS和原子类、线程安全类的使用、读写锁的使用

4.Netty的线程模型?

Netty通过Reactor模型基于多路复用器接收并处理用户请求,内部实现了两个线程池,boss 线程池和work线程池,其中boss线程池的线程负责处理请求的accept事件,当接收到accept 事件的请求时,把对应的socket封装到一个NioSocketChannel中,并交给work线程池,其中work线程池负责请求的read和write事件,由对应的Handler处理。

**单线程模型:**所有I/O操作都由一个线程完成,即多路复用、事件分发和处理都是在一个Reactor线程上完成的。既要接收客户端的连接请求,向服务端发起连接,又要发送/读取请求或应答/响应消息。一个NIO线程同时处理成百上千的链路,性能上无法支撑,速度慢,若线程进入死循环,整个程序不可用,对于高负载、大并发的应用场景不合适。

**多线程模型:**有一个NIO线程(Acceptor)只负责监听服务端,接收客户端的TCP连接请求;NIO线程池负责网络IO的操作,即消息的读取、解码、编码和发送;1个NIO线程可以同时处理N条链路,但是1个链路只对应1个NIO线程,这是为了防止发生并发操作问题。但在并发百万客户端连接或需要安全认证时,一个Acceptor线程可能会存在性能不足问题。

**主从多线程模型:**Acceptor线程用于绑定监听端口,接收客户端连接,将SocketChannel从主线程池的Reactor线程的多路复用器上移除,重新注册到Sub线程池的线程上,用于处理I/O的读写等操作,从而保证mainReactor只负责接入认证、握手等操作;

5.TCP粘包/拆包的原因及解决方法?

TCP是以流的方式来处理数据,一个完整的包可能会被TCP拆分成多个包进行发送,也可能把小的封装成一个大的数据包发送。

TCP粘包/分包的原因:

应用程序写入的字节大小大于套接字发送缓冲区的大小,会发生拆包现象,而应用程序写入数据小于套接字缓冲区大小,网卡将应用多次写入的数据发送到网络上,这将会发生粘包现象;进行MSS大小的TCP分段,当TCP报文长度-TCP头部长度>MSS的时候将发生拆包 以太网帧的payload(净荷)大于MTU(1500字节)进行ip分片。

解决方法:

消息定长:FixedLengthFrameDecoder类包尾增加特殊字符分割:行分隔符类:LineBasedFrameDecoder或自定义分隔符类:

DelimiterBasedFrameDecoder 将消息分为消息头和消息体:LengthFieldBasedFrameDecoder类。分为有头部的拆包与粘包、长度字段在前且有头部的拆包与粘包、多扩展头部的拆包与粘包。

6.了解哪几种序列化协议?

序列化(编码)是将对象序列化为二进制形式(字节数组),主要用于网络传输、数据持久化等;而反序列化(解码)则是将从网络、磁盘等读取的字节数组还原成原始对象,主要用于网络传输对象的解码,以便完成远程调用。

影响序列化性能的关键因素:序列化后的码流大小(网络带宽的占用)、序列化的性能(CPU 资源占用);是否支持跨语言(异构系统的对接和开发语言切换)。

Java默认提供的序列化:无法跨语言、序列化后的码流太大、序列化的性能差

XML

优点:人机可读性好,可指定元素或特性的名称。缺点:序列化数据只包含数据本身以及类的结构,不包括类型标识和程序集信息;只能序列化公共属性和字段;不能序列化方法;文件庞大,文件格式复杂,传输占带宽。适用场景:当做配置文件存储数据,实时数据转换。

JSON

是一种轻量级的数据交换格式,优点:兼容性高、数据格式比较简单,易于读写、序列化后数据较小,可扩展性好,兼容性好、与XML相比,其协议比较简单,解析速度比较快。缺点:数据的描述性比XML差、不适合性能要求为ms级别的情况、额外空间开销比较大。适用场景(可替代XML):跨防火墙访问、可调式性要求高、基于Webbrowser的Ajax请求、传输数据量相对小,实时性要求相对低(例如秒级别)的服务。

Fastjson

采用一种“假定有序快速匹配”的算法。优点:接口简单易用、目前java语言中最快的json库。

缺点:过于注重快,而偏离了“标准”及功能性、代码质量不高,文档不全。适用场景:协议交互、Web输出、Android客户端

Thrift

不仅是序列化协议,还是一个RPC框架。优点:序列化后的体积小,速度快、支持多种语言和丰富的数据类型、对于数据字段的增删具有较强的兼容性、支持二进制压缩编码。

缺点:使用者较少、跨防火墙访问时,不安全、不具有可读性,调试代码时相对困难、不能与其他传输层协议共同使用(例如HTTP)、无法支持向持久层直接读写数据,即不适合做数据持久化序列化协议。适用场景:分布式系统的RPC解决方案

Avro

Hadoop的一个子项目,解决了JSON的冗长和没有IDL的问题。

优点:支持丰富的数据类型、简单的动态语言结合功能、具有自我描述属性、提高了数据解析速度、快速可压缩的二进制数据形式、可以实现远程过程调用RPC、支持跨编程语言实现。

缺点:对于习惯于静态类型语言的用户不直观。适用场景:在Hadoop中做Hive、Pig和MapReduce的持久化数据格式。

Protobuf

将数据结构以.proto文件进行描述,通过代码生成工具可以生成对应数据结构的 POJO对象和Protobuf相关的方法和属性。

优点:序列化后码流小,性能高、结构化数据存储格式(XMLJSON等)、通过标识字段的顺序,可以实现协议的前向兼容、结构化的文档更容易管理和维护。

缺点:需要依赖于工具生成代码、支持的语言相对较少,官方只支持Java、C++、python。适用场景:对性能要求高的RPC调用、具有良好的跨防火墙的访问属性、适合应用层对象的持久化

protostuff

基于protobuf协议,但不需要配置proto文件,直接导包即可

Jbossmarshaling

可以直接序列化java类,无须实java.io.Serializable接口

Messagepack

一个高效的二进制序列化格式

Hessian

采用二进制协议的轻量级remotingonhttp工具

kryo

基于protobuf协议,只支持java语言,需要注册(Registration),然后序列化(Output),反序列化(Input)

7.如何选择序列化协议?

具体场景

- 对于公司间的系统调用,如果性能要求在100ms以上的服务,基于XML的SOAP协议是一个值得考虑的方案。

- 基于Webbrowser的Ajax,以及Mobileapp与服务端之间的通讯,JSON协议是首选。对于性能要求不太高,或者以动态类型语言为主,或者传输数据载荷很小的的运用场景,JSON 也是非常不错的选择。

- 对于调试环境比较恶劣的场景,采用JSON或XML能够极大的提高调试效率,降低系统开发成本。

- 当对性能和简洁性有极高要求的场景,Protobuf,Thrift,Avro之间具有一定的竞争关系。对于T级别的数据的持久化应用场景,Protobuf和Avro是首要选择。如果持久化后的数据存储在hadoop子项目里,Avro会是更好的选择。

- 对于持久层非Hadoop项目,以静态类型语言为主的应用场景,Protobuf会更符合静态类型语言工程师的开发习惯。由于Avro的设计理念偏向于动态类型语言,对于动态语言为主的应用场景,Avro是更好的选择。

- 如果需要提供一个完整的RPC解决方案,Thrift是一个好的选择。

- 如果序列化之后需要支持不同的传输层协议,或者需要跨防火墙访问的高性能场景,Protobuf可以优先考虑。protobuf的数据类型有多种:bool、double、float、int32、int64、string、bytes、enum、message。

**protobuf的限定符:**required:必须赋值,不能为空、optional:字段可以赋值,也可以不赋值、

repeated:该字段可以重复任意次数(包括0次)、枚举;只能用指定的常量集中的一个值作为其值;

**protobuf的基本规则:**每个消息中必须至少留有一个required类型的字段、包含0个或多个optional类型的字段;repeated表示的字段可以包含0个或多个数据;[1,15]之内的标识号在编码的时候会占用一个字节(常用),[16,2047]之内的标识号则占用2个字节,标识号一定不能重复、使用消息类型,也可以将消息嵌套任意多层,可用嵌套消息类型来代替组。

protobuf的消息升级原则:不要更改任何已有的字段的数值标识;不能移除已经存在的required字段,optional和repeated类型的字段可以被移除,但要保留标号不能被重用。新添加的字段必须是optional或repeated。因为旧版本程序无法读取或写入新增的required限定符的字段。编译器为每一个消息类型生成了一个.java文件,以及一个特殊的Builder类(该类是用来创建消息类接口的)

如:UserProto.User.Builder builder =UserProto.User.newBuilder();builder.build();

**Netty中的使用:**ProtobufVarint32FrameDecoder是用于处理半包消息的解码类;

ProtobufDecoder(UserProto.User.getDefaultInstance())这是创建的UserProto.java文件中的解码类;ProtobufVarint32LengthFieldPrepender对protobuf协议的消息头上加上一个长度为32 的整形字段,用于标志这个消息的长度的类;ProtobufEncoder是编码类将StringBuilder转换为ByteBuf类型:copiedBuffer()方法

8.Netty的零拷贝实现?

Netty的接收和发送ByteBuffer采用DIRECTBUFFERS,使用堆外直接内存进行Socket读写,不需要进行字节缓冲区的二次拷贝。堆内存多了一次内存拷贝,JVM会将堆内存Buffer拷贝一份到直接内存中,然后才写入Socket中ByteBuffer由ChannelConfig分配,由ChannelConfig创建ByteBufAllocator默认使用DirectBufferCompositeByteBuf类可以将多个ByteBuf合并为一个逻辑上的ByteBuf,避免了传统通过内存拷贝的方式将几个小Buffer合并成一个大的Buffer。

addComponents方法将header与body合并为一个逻辑上的ByteBuf,这两个ByteBuf在CompositeByteBuf内部都是单独存在的,CompositeByteBuf只是逻辑上是一个整体通过FileRegion包装的FileChannel.tranferTo方法实现文件传输,可以直接将文件缓冲区的数据发送到目标Channel,避免了传统通过循环write方式导致的内存拷贝问题。

通过wrap方法,我们可以将byte[]数组、ByteBuf、ByteBuffer等包装成一个NettyByteBuf对象,进而避免了拷贝操作。

**SelectorBUG:**若Selector的轮询结果为空,也没有wakeup或新消息处理,则发生空轮询,

CPU使用率100%,

**Netty的解决办法:**对Selector的select操作周期进行统计,每完成一次空的select操作进行一次计数,若在某个周期内连续发生N次空轮询,则触发了epoll死循环bug。重建Selector,判断是否是其他线程发起的重建请求,若不是则将原SocketChannel从旧的Selector上去除注册,重新注册到新的Selector上,并将原来的Selector关闭。

9.Netty的高性能表现在哪些方面?

心跳,对服务端:会定时清除闲置会话inactive(netty5),

对客户端:用来检测会话是否断开,是否重来,检测网络延迟,其中idleStateHandler类用来检测会话状态串行无锁化设计,即消息的处理尽可能在同一个线程内完成,期间不进行线程切换,这样就避免了多线程竞争和同步锁。表面上看,串行化设计似乎CPU利用率不高,并发程度不够。

但是,通过调整NIO线程池的线程参数,可以同时启动多个串行化的线程并行运行,这种局部无锁化的串行线程设计相比一个队列-多个工作线程模型性能更优。可靠性,链路有效性检测:链路空闲检测机制读/写空闲超时机制;内存保护机制:通过内存池重用ByteBuf;ByteBuf的解码保护;优雅停机:不再接收新消息、退出前的预处理操作、资源的释放操作。

Netty安全性:支持的安全协议:SSLV2和V3,TLS,SSL单向认证、双向认证和第三方CA认证。

高效并发编程的体现:volatile的大量、正确使用;CAS和原子类的广泛使用;线程安全容器的使用;通过读写锁提升并发性能。IO通信性能三原则:传输(AIO)、协议(Http)、线程(主从多线程)

流量整型的作用(变压器):防止由于上下游网元性能不均衡导致下游网元被压垮,业务流中断;防止由于通信模块接受消息过快,后端业务线程处理不及时导致撑死问题。

TCP参数配置:SO_RCVBUF和SO_SNDBUF:通常建议值为128K或者256K;

SO_TCPNODELAY:NAGLE算法通过将缓冲区内的小封包自动相连,组成较大的封包,阻止大量小封包的发送阻塞网络,从而提高网络应用效率。但是对于时延敏感的应用场景需要关闭该优化算法;

10.NIOEventLoopGroup源码?

NioEventLoopGroup(其实是MultithreadEventExecutorGroup)内部维护一个类型为EventExecutorchildren[],默认大小是处理器核数*2,

这样就构成了一个线程池,初始化EventExecutor时NioEventLoopGroup重载newChild方法,所以children元素的实际类型为NioEventLoop。

- 线程启动时调用SingleThreadEventExecutor的构造方法,执行NioEventLoop类的run方法,首先会调用hasTasks()方法判断当前taskQueue是否有元素。如果taskQueue中有元素,执行selectNow()方法,最终执行selector.selectNow(),该方法会立即返回。如果taskQueue 没有元素,执行select(oldWakenUp)方法

- select(oldWakenUp)方法解决了Nio中的bug,selectCnt用来记录selector.select方法的执行次数和标识是否执行selector.selectNow(),若触发了epoll的空轮询bug,则会反复执行selector.select(timeoutMillis),变量selectCnt会逐渐变大,当selectCnt达到阈值(默认512),则执行rebuildSelector方法,进行selector重建,解决cpu占用100%的bug。

- rebuildSelector方法先通过openSelector方法创建一个新的selector。然后将oldselector的selectionKey执行cancel。最后将oldselector的channel重新注册到新的selector中。rebuild 后,需要重新执行方法selectNow,检查是否有已ready的selectionKey。

- 接下来调用processSelectedKeys方法(处理I/O任务),当selectedKeys!=null时,调用processSelectedKeysOptimized方法,迭代selectedKeys获取就绪的IO事件的selectkey存放在数组selectedKeys中,然后为每个事件都调用processSelectedKey来处理它,processSelectedKey中分别处理OP_READ;OP_WRITE;OP_CONNECT事件。

- 最后调用runAllTasks方法(非IO任务),该方法首先会调用fetchFromScheduledTaskQueue 方法,把scheduledTaskQueue中已经超过延迟执行时间的任务移到taskQueue中等待被执行,然后依次从taskQueue中取任务执行,每执行64个任务,进行耗时检查,如果已执行时间超过预先设定的执行时间,则停止执行非IO任务,避免非IO任务太多,影响IO任务的执行。

每个NioEventLoop对应一个线程和一个Selector,NioServerSocketChannel会主动注册到某一个NioEventLoop的Selector上,NioEventLoop负责事件轮询。

Outbound事件都是请求事件,发起者是Channel,处理者是unsafe,通过Outbound事件进行通知,传播方向是tail到head。Inbound事件发起者是unsafe,事件的处理者是Channel,是通知事件,传播方向是从头到尾。

内存管理机制,首先会预申请一大块内存Arena,Arena由许多Chunk组成,而每个Chunk默认由2048个page组成。Chunk通过AVL树的形式组织Page,每个叶子节点表示一个Page,而中间节点表示内存区域,节点自己记录它在整个Arena中的偏移地址。当区域被分配出去后,中间节点上的标记位会被标记,这样就表示这个中间节点以下的所有节点都已被分配了。大于8k的内存分配在poolChunkList中,而PoolSubpage用于分配小于8k的内存,它会把一个page分割成多段,进行内存分配。

**ByteBuf的特点:**支持自动扩容(4M),保证put方法不会抛出异常、通过内置的复合缓冲类型,实现零拷贝(zero-copy);不需要调用flip()来切换读/写模式,读取和写入索引分开;方法链;引用计数基于AtomicIntegerFieldUpdater用于内存回收;PooledByteBuf采用二叉树来实现一个内存池,集中管理内存的分配和释放,不用每次使用都新建一个缓冲区对象。UnpooledHeapByteBuf每次都会新建一个缓冲区对象。

并发编程面试合辑 word文档下载地址:链接:https://pan.baidu.com/s/1nwlBO2tYXDDl7OjGhs4e4Q

提取码:1111爆肝一周,不眠不休!就为 点赞+好评+收藏 三连

微服务面试合辑

Spring Boot篇

1、什么是 Spring Boot

多年来,随着新功能的增加,spring 变得越来越复杂。只需访问https://spring.io/projects 页面,我们就会看到可以在我们的应用程序中使用的所有 Spring 项目的不同功能。如果必须启动一个新的 Spring 项目, 我们必须添加构建路径或添加 Maven 依赖关系,配置应用程序服务器, 添加 spring 配置。因此,开始一个新的 spring 项目需要很多努力,因为我们现在必须从头开始做所有事情。

Spring Boot 是解决这个问题的方法。Spring Boot 已经建立在现有 spring 框架之上。使用spring 启动,我们避免了之前我们必须做的所有样板代码和配置。因此,Spring Boot可以帮助我们以最少的工作量,更加健壮地使用现有的 Spring 功能。

2、Spring Boot 有哪些优点

Spring Boot 的优点有:

减少开发,测试时间和努力。

使用 JavaConfig 有助于避免使用 XML。避免大量的 Maven 导入和各种版本冲突。提供意见发展方法。

通过提供默认值快速开始开发。

没有单独的 Web 服务器需要。这意味着你不再需要启动 Tomcat,Glassfish 或其他任何东西。需要更少的配置因为没有 web.xml 文件。只需添加用@ Configuration 注释的类,然后添加用@Bean 注释的方法,Spring 将自动加载对象并像以前一样对其进行管理。您甚至可以将@Autowired 添加到 bean 方法中, 以使 Spring 自动装入需要的依赖关系中。基于环境的配置使用这些属性,您可以将您正在使用的环境传递到应用程序:- Dspring.profiles.active ={enviornment}。在加载主应用程序属性文件后,Spring 将在(application{environment} .properties)中加载后续的应用程序属性文件。

3、什么是 JavaConfig

Spring JavaConfig是Spring社区的产品,它提供了配置Spring IoC容器的纯Java方法。因此它有助于避免使用 XML 配置。使用 JavaConfig 的优点在于:

面向对象的配置。由于配置被定义为 JavaConfig 中的类,因此用户可以充分利用 Java 中的面向对象功能。一个配置类可以继承另一个,重写它的@Bean 方法等。

减少或消除 XML 配置。基于依赖注入原则的外化配置的好处已被证明。但是,许多开发人员不希望在 XML 和 Java 之间来回切换。JavaConfig 为开发人员提供了一种纯 Java 方法来配置与 XML 配置概念相似的 Spring 容器。从技术角度来讲,只使用 JavaConfig 配置类来配置容器是可行的,但实际上很多人认为将 JavaConfig 与 XML 混合匹配是理想的。类型安全和重构友好。JavaConfig 提供了一种类型安全的方法来配置 Spring 容器。由于 Java 5.0 对泛型的支持,现在可以按类型而不是按名称检索bean,不需要任何强制转换或 基于字符串的查找。

4、如何重新加载 Spring Boot 上的更改而无需重新启动服务器

这可以使用 DEV 工具来实现。通过这种依赖关系,您可以节省任何更改,嵌入式 tomcat 将重新启动。Spring Boot 有一个开发工具(DevTools)模块,它有助于提高开发人员的生 产力。Java 开发人员面临的一个主要挑战是将文件更改自动部署到服务器并自动重启服务器。开发人员可以重新加载Spring Boot上的更改,而无需重新启动服务器。这将消除每次手动部署更改的需要。Spring Boot 在发布它的第一个版本时没有这个功能。这是开发人员最需要的功能。DevTools 模块完全满足开发人员的需求。该模块将在生产环境中被禁用。它还提供 H2 数据库控制台以更好地测试应用程序。

org.springframework.boot spring-boot-devtools true

5、Spring Boot 中的监视器是什么

Spring boot actuator是spring启动框架中的重要功能之一。Spring boot监视器可帮助您访问生产环境中正在运行的应用程序的当前状态。有几个指标必须在生产环境中进行检查和监控。即使一些外部应用程序可能正在使用这些服务来向相关人员触发警报消息。监视器模块公开了一组可直接作为 HTTP URL 访问的 REST 端点来检查状态。

6、如何在 Spring Boot 中禁用 Actuator 端点安全性

默认情况下,所有敏感的 HTTP 端点都是安全的,只有具有 ACTUATOR 角色的用户才能访问它们。安全性是使用标准的HttpServletRequest.isUserInRole 方法实施的。我们可以使用management.security.enabled = false来禁用安全性。只有在执行机构端点在防火墙后访问时,才建议禁用安全性。

7、如何在自定义端口上运行 Spring Boot 应用程序

为了在自定义端口上运行Spring Boot 应用程序,您可以在application.properties 中指定端口。server.port = 8090

8、什么是 YAML

YAML 是一种人类可读的数据序列化语言。它通常用于配置文件。与属性文件相比,如果我们想要在配置文件中添加复杂的属性,YAML 文件就更加结构化,而且更少混淆。可以看出 YAML 具有分层配置数据。

9、如何实现 Spring Boot 应用程序的安全性

为了实现Spring Boot的安全性,我们使用 spring-boot-starter-security依赖项,并且必须添加安全配置。它只需要很少的代码。配置类将必须扩展WebSecurityConfigurerAdapter 并覆 盖其方法。

10、如何集成 Spring Boot 和 ActiveMQ

对于集成Spring Boot和ActiveMQ,我们使用spring-boot-starter-activemq

依赖关系。它只需要很少的配置,并且不需要样板代码。

11、如何使用 Spring Boot 实现分页和排序

使用 Spring Boot 实现分页非常简单。使用 Spring Data-JPA 可以实现将可分页的 org.springframework.data.domain.Pageable传递给存储库方法。

12、什么是 Swagger你用 Spring Boot 实现了它吗

Swagger 广泛用于可视化 API,使用 Swagger UI 为前端开发人员提供在线沙箱。Swagger 是用于生成 RESTful Web 服务的可视化表示的工具,规范和完整框架实现。它使文档能够以与服务器相同的速度更新。当通过Swagger 正确定义时,消费者可以使用最少量的实现逻 辑来理解远程服务并与其进行交互。因此,Swagger 消除了调用服务时的猜测。

13、什么是 Spring Profiles

Spring Profiles 允许用户根据配置文件(dev,test,prod 等)来注册 bean。因此,当应用程序在开发中运行时,只有某些 bean 可以加载,而在PRODUCTION 中,某些其他 bean 可以加载。假设我们的要求是Swagger 文档仅适用于 QA 环境,并且禁用所有其他文档。这可以使用配置文件来完成。Spring Boot 使得使用配置文件非常简单。

14、什么是 Spring Batch

Spring Boot Batch提供可重用的函数,这些函数在处理大量记录时非常重要,包括日志/跟 踪,事务管理,作业处理统计信息,作业重新启动,跳过和资源管理。它还提供了更先进的技术服务和功能,通过优化和分区技术,可以实现极高批量和高性能批处理作业。简单以及复杂的大批量批处理作业可以高度可扩展的方式利用框架处理重要大量的信息。

15、什么是 FreeMarker 模板

FreeMarker 是一个基于 Java 的模板引擎,最初专注于使用 MVC 软件架构进行动态网页生成。使用 Freemarker 的主要优点是表示层和业务层的完全分离。程序员可以处理应用程序代码,而设计人员可以处理 html 页面设计。最后使用 freemarker 可以将这些结合起来,给出最终的输出页面。

16、如何使用 Spring Boot 实现异常处理

Spring提供了一种使用ControllerAdvice处理异常的非常有用的方法。我们通过实现一个 ControlerAdvice 类,来处理控制器类抛出的所有异常。

17、您使用了哪些 starter maven 依赖项

使用了下面的一些依赖项

spring-boot-starter-activemq spring-boot-starter-security

spring-boot-starter-web 这有助于增加更少的依赖关系,并减少版本的冲突。

18、什么是 CSRF 攻击

CSRF 代表跨站请求伪造。这是一种攻击,迫使最终用户在当前通过身份验证的 Web 应用程序上执行不需要的操作。CSRF 攻击专门针对状态改变请求,而不是数据窃取,因为攻击者无法查看对伪造请求的响应。

19、什么是 WebSockets

WebSocket 是一种计算机通信协议,通过单个 TCP 连接提供全双工通信信道。

WebSocket 是双向的-使用 WebSocket 客户端或服务器可以发起消息发送。

WebSocket 是全双工的 -客户端和服务器通信是相互独立的。

单个TCP连接 -初始连接使用HTTP,然后将此连接升级到基于套接字的连接。然后这个单一连接用于所有未来的通信Light -与 http 相比,WebSocket 消息数据交换要轻得多。

20、什么是 AOP

在软件开发过程中,跨越应用程序多个点的功能称为交叉问题。这些交叉问题与应用程序的主要业务逻辑不同。因此,将这些横切关注与业务逻辑分开是面向方面编程(AOP)的 地方。

21、什么是 Apache Kafka

Apache Kafka 是一个分布式发布-订阅消息系统。它是一个可扩展的,容错的发布-订阅消息系统,它使我们能够构建分布式应用程序。这是一个Apache 顶级项目。Kafka 适合离线和在线消息消费。

22、我们如何监视所有 Spring Boot 微服务

Spring Boot 提供监视器端点以监控各个微服务的度量。这些端点对于获取有关应用程序的信息(如它们是否已启动)以及它们的组件(如数据库等)是否正常运行很有帮助。但是,使用监视器的一个主要缺点或困难是,我们必须单独打开应用程序的知识点以了解其状态或健康状况。想象一下涉及50 个应用程序的微服务,管理员将不得不击中所有 50 个应用程序的执行终端。

Dubbo篇

1、Dubbo 中 zookeeper 做注册中心如果注册中心集群都挂掉发布者和订阅者之间还能通信么

可以通信的,启动 dubbo 时,消费者会从 zk 拉取注册的生产者的地址接口等数据,缓存在本地。每次调用时,按照本地存储的地址进行调用; 注册中心对等集群,任意一台宕机后,将会切换到另一台;注册中心全部宕机后,服务的提供者和消费者仍能通过本地缓存通讯。服务提供者无状态, 任一台宕机后,不影响使用;服务提供者全部宕机,服务消费者会无法使 用,并无限次重连等待服务者恢复; 挂掉是不要紧的,但前提是你没有增加新的服务,如果你要调用新的服务,则是不能办到的。

![]()

2、dubbo 服务负载均衡策略

l Random LoadBalance

随机,按权重设置随机概率。在一个截面上碰撞的概率高,但调用量越大分布越均匀,而且按概率使用权重后也比 较均匀,有利于动态调整提供者权重。(权重可以在 dubbo 管控台配置)

l RoundRobin LoadBalance

轮循,按公约后的权重设置轮循比率。存在慢的提供者累积请求问题,比如:第二台机器很慢,但没挂,当请求调

到第二台时就卡在那,久而久之,所有请求都卡在调到第二台上。

l LeastActive LoadBalance

最少活跃调用数,相同活跃数的随机,活跃数指调用前后计数差。使慢的提供者收到更少请求,因为越慢的提供者的

调用前后计数差会越大。

l ConsistentHash LoadBalance

一致性 Hash,相同参数的请求总是发到同一提供者。当某一台提供者挂时,原本发往该提供者的请求,基于虚拟节点,平摊到其它提供者,不会引起剧烈变动。缺省只对第一个参数 Hash,如果要修改,请配置

3、 Dubbo 在安全机制方面是如何解决的

Dubbo 通过 Token 令牌防止用户绕过注册中心直连,然后在注册中心上管理授权。Dubbo 还提供服务黑白名单,来控制服务所允许的调用方。

4、dubbo 连接注册中心和直连的区别

在开发及测试环境下,经常需要绕过注册中心,只测试指定服务提供者, 这时候可能需要点对点直连,点对点直联方式,将以服务接口为单位,忽略注册中心的提供者列表,l Failsafe Cluster失败安全,出现异常时,直接忽略。通常用于写入审计日志等操作。

[AppleScript] 纯文本查看复制代码

服务注册中心,动态的注册和发现服务,使服务的位置透明,并通过在消费方获取服务提供方地址列表,实现软负载均衡和 Failover

注册中心返回服务提供者地址列表给消费者,如果有变更,注册中心将基于长连接推 送变更数据给消费者。服务消费者,从提供者地址列表中,基于软负载均衡算法,选一台提供者进行调用,如果调用失败,再选另一台调用。

注册中心负责服务地址的注册与查找,相当于目录服务,服务提供者和消费者只在启动时与注册中心交互,注册中心不转发请求,服务消费者向注册中心获取服务提供者地址列表,并根据负载算法直接调用提供者

注册中心,服务提供者,服务消费者三者之间均为长连接,监控中心除外,注册中心通过长连接感知服务提供者的存在,服务提供者宕机,注册中心将立即推送事件通知消费者注册中心和监控中心全部宕机,不影响已运行的提供者和消费者,消费者在本地缓存了提供者列表

注册中心和监控中心都是可选的,服务消费者可以直连服务提供者。

5. dubbo 服务集群配置(集群容错模式)

在集群调用失败时,Dubbo 提供了多种容错方案,缺省为 failover 重试。可以自行扩展集群容错策略 l Failover Cluster(默认)

失败自动切换,当出现失败,重试其它服务器。(缺省)通常用于读操作, 但重试会带来更长延迟。可通过 retries="2"来设置重试次数(不含第一次)。

cluster="failover"可以不用写,因为默认就是failover

l Failfast Cluster

快速失败,只发起一次调用,失败立即报错。通常用于非幂等性的写操作,比如新增记录。

dubbo:service cluster="failfast" />

或:

cluster="failfast"和把 cluster=“failover”、retries="0"是—样的效果,retries="0"就是不重试

l FailsafeCluster

失败安全,出现异常时,直接忽略。通常用于写入审计日志等操作。

l Failback Cluster

失败自动恢复,后台记录失败请求,定时重发。通常用于消息通知操作。

l Forking Cluster

并行调用多个服务器,只要一个成功即返回。通常用于实时性要求较高的读操作,但需要浪费更多服务资源。可通过 forks="2"来设置最大并行数

配置:

服务端服务级别

- Eureka:服务注册中心

- Feign:服务调用

- Ribbon:负载均衡

- Zuul/Spring Cloud Gatway:网关

这么多的系统,电商系统包含了20个子系统,每个子系统有20个核心接口,一共电商系统有400个接口,这么多的接口,直接对外暴露,前后端分离的架构,难道你让前端的同学必须记住你的20个系统的部署的机器,他们去做负载均衡,记住400个接口微服务那块,网关

灰度发布、统一熔断、统一降级、统一缓存、统一限流、统一授权认证

Hystrix、链路追踪、stream、很多组件,Hystrix这块东西,其实是会放在高可用的环节去说的,并不是说一个普通系统刚开始就必须得用的,没有用好的话,反而会出问题,Hystrix线路熔断的框架,必须得设计对应的一整套的限流方案、熔断方案、资源隔离、降级机制,配合降级机制来做

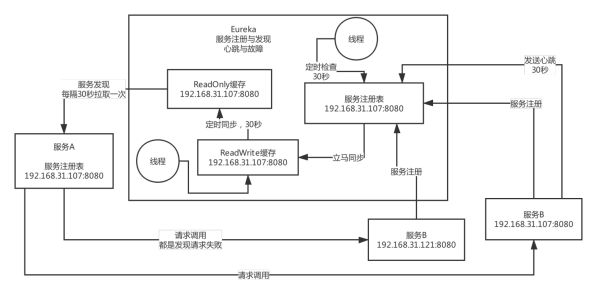

2、Spring Cloud 组件原理

eureka 原理图

Eureka 缓存的设计目的

优化并发 并发冲突,如果操作服务注册表,读时加锁防止写,写时加锁不能读,效率降低。

Feign 原理

在配置类上,加上@EnableFeginClients,那么该注解是基于@Import注解,注册有关Fegin的解析注册类,这个类是实现 ImportBeanDefinitionRegistrar 这个接口,重写registryBeanDefinition 方法。他会扫描所有加了@FeginClient 的接口,然后针对这个注解的接口生成动态代理,然后你针对fegin的动态代理去调用他方法的时候,此时会在底层生成http协议格式的请求。

Ribbo 原理

底层的话,使用HTTP通信的框架组件,HttpClient,先得使用Ribbon去本地的Eureka注册表的缓存里获取出来对方机器的列表,然后进行负载均衡,选出一台机器,接着针对那台机器发送 Http请求过去即可

Zuul 原理

配置一下不同的请求路径和服务的对应关系,你的请求到了网关,他直接查找到匹配的服务,然后就直接把请求转发给服务的某台机器,Ribbon从Eureka本地的缓存列表里获取一台机器,负载均衡,把请求直接用HTTP通信扩建发送到指定机器上去。

3、Spring Cloud 和 Dubbo 的区别

Dubbo,RPC的性能比HTTP的性能更好,并发能力更强,经过深度优化的RPC服务框架,性能和并发能力是更好一些

很多中小型公司而言,其实稍微好一点的性能,Dubbo一次请求10ms,Spring Cloud耗费20ms,对很多中小型公司而言,性能、并发,并不是最主要的因素

Spring Cloud这套架构原理,走HTTP接口和HTTP请求,就足够满足性能和并发的需要了,没必要使用高度优化的RPC服务框架

Dubbo之前的一个定位,就是一个单纯的服务框架而已,不提供任何其他的功能,配合的网关还得选择其他的一些技术

Spring Cloud,中小型公司用的特别多,老系统从Dubbo迁移到Spring Cloud,新系统都是用Spring Cloud来进行开发,全家桶,主打的是微服务架构里,组件齐全,功能齐全。网关直接提供了,分布式配置中心,授权认证,服务调用链路追踪,Hystrix可以做服务的资源隔离、熔断降级、服务请求QPS监控、契约测试、消息中间件封装、ZK封装

胜是胜在功能齐全,中小型公司开箱即用,直接满足系统的开发需求

Spring Cloud原来支持的一些技术慢慢的未来会演变为,跟阿里技术体系进行融合,Spring Cloud Alibaba,阿里技术会融入Spring Cloud里面去

4、你们的服务注册中心进行过选型调研吗?对比一下各种服务注册中心!

Eureka、ZooKeeper

Dubbo作为服务框架的,一般注册中心会选择zk

Spring Cloud作为服务框架的,一般服务注册中心会选择Eureka

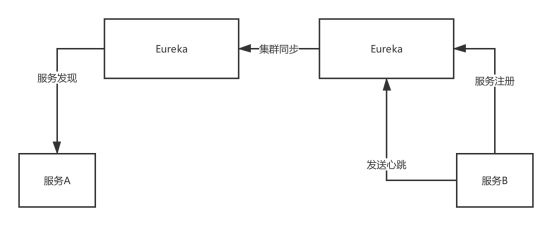

(1)服务注册发现的原理

集群模式

Eureka,peer-to-peer,部署一个集群,但是集群里每个机器的地位是对等的,各个服务可以向任何一个Eureka实例服务注册和服务发现,集群里任何一个Euerka实例接收到写请求之后,会自动同步给其他所有的Eureka实例

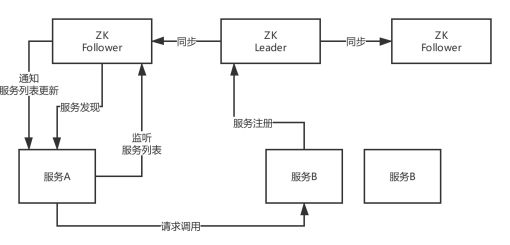

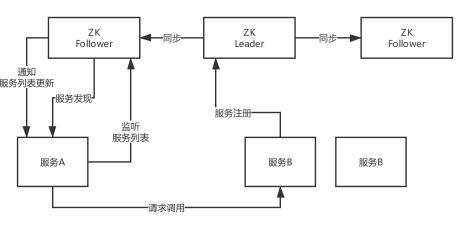

ZooKeeper,服务注册和发现的原理,Leader + Follower两种角色,只有Leader可以负责写也就是服务注册,他可以把数据同步给Follower,读的时候leader/follower都可以读

(2)一致性保障:CP or AP

CAP,C是一致性,A是可用性,P是分区容错性

CP,AP

ZooKeeper是有一个leader节点会接收数据, 然后同步写其他节点,一旦leader挂了,要重新选举leader,这个过程里为了保证C,就牺牲了A,不可用一段时间,但是一个leader选举好了,那么就可以继续写数据了,保证一致性

Eureka是peer模式,可能还没同步数据过去,结果自己就死了,此时还是可以继续从别的机器上拉取注册表,但是看到的就不是最新的数据了,但是保证了可用性,强一致,最终一致性

(3)服务注册发现的时效性

zk,时效性更好,注册或者是挂了,一般秒级就能感知到

eureka,默认配置非常糟糕,服务发现感知要到几十秒,甚至分钟级别,上线一个新的服务实例,到其他人可以发现他,极端情况下,可能要1分钟的时间,ribbon去获取每个服务上缓存的eureka的注册表进行负载均衡

服务故障,隔60秒才去检查心跳,发现这个服务上一次心跳是在60秒之前,隔60秒去检查心跳,超过90秒没有心跳,才会认为他死了,2分钟都过去

30秒,才会更新缓存,30秒,其他服务才会来拉取最新的注册表

三分钟都过去了,如果你的服务实例挂掉了,此时别人感知到,可能要两三分钟的时间,一两分钟的时间,很漫长

(4)容量

zk,不适合大规模的服务实例,因为服务上下线的时候,需要瞬间推送数据通知到所有的其他服务实例,所以一旦服务规模太大,到了几千个服务实例的时候,会导致网络带宽被大量占用

eureka,也很难支撑大规模的服务实例,因为每个eureka实例都要接受所有的请求,实例多了压力太大,扛不住,也很难到几千服务实例

之前dubbo技术体系都是用zk当注册中心,spring cloud技术体系都是用eureka当注册中心这两种是运用最广泛的,但是现在很多中小型公司以spring cloud居多,所以后面基于eureka说一下服务注册中心的生产优化

5、画图阐述一下你们的服务注册中心部署架构,生产环境下怎么保证高可用?

6、你们系统遇到过服务发现过慢的问题吗?怎么优化和解决的?

zk,一般来说还好,服务注册和发现,都是很快的

eureka,必须优化参数

·服务器到注册中心心跳时间设置

·注册中心定时检测心跳时间设置

·心跳失效时间设置

·readWrite缓存定更新到readOnly时间设置

·客户端定时拉取readWrite缓存时间设置

服务发现的时效性变成秒级,几秒钟可以感知服务的上线和下线

7、说一下自己公司的服务注册中心怎么技术选型的?生产环境中应该怎么优化?

l可用性

l时效性

l数据一致性 CP AP

l容量

通过集群保证可用性

8、你们对网关的技术选型是怎么考虑的?能对比一下各种网关技术的优劣吗?

网关的核心功能

(1)动态路由:新开发某个服务,动态把请求路径和服务的映射关系热加载到网关里去;服务增减机器,网关自动热感知

(2)灰度发布

(3)授权认证

(4)性能监控:每个API接口的耗时、成功率、QPS

(5)系统日志

(6)数据缓存

**(**7)限流熔断

几种技术选型

Kong、Zuul、Nginx+Lua(OpenResty)、自研网关

Kong:Nginx里面的一个基于lua写的模块,实现了网关的功能

Zuul:基于Java开发,核心网关功能都比较简单,但是比如灰度发布、限流、动态路由之类的,很多都要自己做二次开发。高并发能力不强,部署到一些机器上去,还要基于Tomcat来部署,Spring Boot用Tomcat把网关系统跑起来;Java语言开发,可以直接把控源码,可以做二次开发封装各种需要的功能

Nginx+Lua(OpenResty): 直接通过nginx来当做网关

自研网关:自己来写类似Zuul的网关,基于Servlet、Netty来做网关,实现上述所有的功能

9、如果网关需要抗每秒10万的高并发访问,你应该怎么对网关进行生产优化?

Zuul网关部署的是什么配置的机器,部署32核64G,对网关路由转发的请求,每秒抗个小几万请求是不成问题的,几台Zuul网关机器

每秒是1万请求,8核16G的机器部署Zuul网关,5台机器就够了

10、生产级的网关,应该具备我刚才说的几个特点和功能:

(1)动态路由:新开发某个服务,动态把请求路径和服务的映射关系热加载到网关里去;服务增减机器,网关自动热感知

(2)灰度发布:基于现成的开源插件来做

(3)授权认证

(4)限流熔断

(5)性能监控:每个API接口的耗时、成功率、QPS

(6)系统日志

(7)数据缓存

11、如果需要部署上万服务实例,现有的服务注册中心能否抗住?如何优化?

Eureka 和 ZK都是扛不住了,(可以主动说出注册中心的缺点)

eureka:peer-to-peer,每台机器都是高并发请求,有瓶颈

zookeeper:服务上下线,全量通知其他服务,网络带宽被打满,有瓶颈

1.可以加一个数据库层(或者是 redis缓存层),每个服务定时通过数据库(redis缓存层)来更新服务注册表,然后数据库(redis缓存层)定时拉取注册中心来更新注册表。

2.可以自研,类似于 redis 集群 加主备架构,将压力分散开。按需拉取局部的注册表。比如说服务A在,注册中心1,那么只用拉取注册中心1的注册表。而不用将注册中心1,2,3,4等等其他注册拉取过来。缓解压力。

12、说说生产环境下,你们是怎么实现网关对服务的动态路由的?

l通过数据库+网关定时拉取数据库 服务注册中心配置。

l首先开发注册中心配置系统,通过页面可以动态的将增加新老服务。写入到数据库。

l同时也可以通过拉取eureka来最新的服务注册中心配置。写入到数据库。

l网关定时10秒拉取数据库的最新配置。

这样好处减少了eureka的压力,同时当注册中心服务宕机,也不影响当前网关的路由。

13、你们是如何基于网关实现灰度发布的?说说你们的灰度发布方案?

1.准备一个数据库和一个表(也可以用Apollo配置中心、Redis、ZooKeeper,其实都可以),放一个灰度发布启用表

2.写一个zuul的filter,对每个请求,zuul都会调用这个filter

3.当尝试新版本发布,修改新服务的版本为 new

4.通过页面 修改配置中心,或者修改数据库表,开灰度发布。

5.开灰度发布 网关的 filter 就会随机 百分之1的请求 带上 new 版本。这样请求就会跑到新服务

6.当新服务使用一段时间没有问题,再将old服务全部替换成 new服务 版本设置为 current,关闭灰度发布。

14、说说你们一个服务从开发到上线,服务注册、网关路由、服务调用的流程?

spring cloud 原理图。

注册中心 eureka

网关 zuul

服务调用 fegin

负载均衡 ribbon

15、什么是 Spring Cloud

Spring cloud 流应用程序启动器是基于 Spring Boot 的 Spring 集成应用程序,提供与外部系统的集成。Spring cloud Task,一个生命周期短暂的微服务框架,用于快速构建执行有限数据处理的应用程序。

16、使用 Spring Cloud 有什么优势

使用Spring Boot 开发分布式微服务时,我们面临以下问题

- 与分布式系统相关的复杂性-这种开销包括网络问题,延迟开销,带宽问题,安全问题。

- 服务发现-服务发现工具管理群集中的流程和服务如何查找和互相交谈。它涉及一个服务目录,在该目录中注册服务,然后能够查找并连接到该目录中的服务。

- 冗余-分布式系统中的冗余问题。

- 负载平衡–负载平衡改善跨多个计算资源的工作负荷,诸如计算机,计算机集群,网络链路,中央 处理单元,或磁盘驱动器的分布。

- 性能-问题由于各种运营开销导致的性能问题。

- 部署复杂性-Devops 技能的要求。

17、服务注册和发现是什么意思Spring Cloud 如何实现

当我们开始一个项目时,我们通常在属性文件中进行所有的配置。随着越来越多的服务开发和部署,添加和修改这些属性变得更加复杂。有些服务可能会下降,而某些位置可能会发生变化。手动更改属性可能会产生问题。Eureka 服务注册和发现可以在这种情况下提供帮助。由于所有服务都在 Eureka 服务器上注册并通过调用 Eureka 服务器完成查找,因此无需处理服务地点的任何更改和处理。

18、负载平衡的意义什么

在计算中,负载平衡可以改善跨计算机,计算机集群,网络链接,中央处理单元或磁盘驱动器等多种计算资源的工作负载分布。负载平衡旨在优化资源使用,最大化吞吐量,最小化响应时间并避免任何单一资源的过载。使用多个组件进行负载平衡而不是单个组件可能会通过冗余来提高可靠性和可用性。负载平衡通常涉及专用软件或硬件,例如多层交换机或域名系统服务器进程。

19、什么是 Hystrix它如何实现容错

Hystrix是一个延迟和容错库,旨在隔离远程系统,服务和第三方库的访问点,当出现故障是不可避免的故障时,停止级联故障并在复杂的分布式系统中实现弹性。

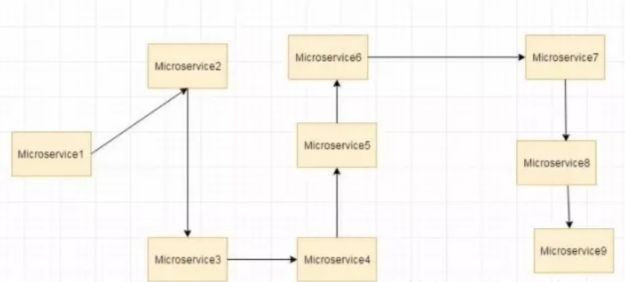

通常对于使用微服务架构开发的系统,涉及到许多微服务。这些微服务彼此协作。

思考一下微服务

假设如果上图中的微服务 9 失败了,那么使用传统方法我们将传播一个异常。但这仍然会导致整个系统崩溃。

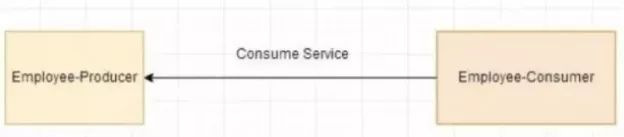

随着微服务数量的增加,这个问题变得更加复杂。微服务的数量可以高达1000.这是 hystrix 出现的地方, 我们将使用 Hystrix 在这种情况下的Fallback 方法功能。我们有两个服务 employee-consumer 使用由employee-consumer 公开的服务。

20、什么是 Hystrix 断路器我们需要它吗

由于某些原因,employee-consumer 公开服务会引发异常。在这种情况下使用 Hystrix 我们定义了一个 回退方法。如果在公开服务中发生异常,则回退方法返回一些默认值。

如果 firstPage method()中的异常继续发生,则 Hystrix 电路将中断,并且员工使用者将一起跳过 firtsPage 方法,并直接调用回退方法。断路器的目的是给第一页方法或第一页方法可能调用的其他方法留出时间,并导致异常恢复。可能发生的情况是,在负载较小的情况下,导致异常的问题有 更好的恢复机会。

21、什么是 Netflix Feign它的优点是什么

Feign 是受到 Retrofit,JAXRS-2.0和 WebSocket 启发的 java 客户端联编程序。Feign 的第一个目标是将约束分母的复杂性统一到 http apis,而不考虑其稳定性。在 employee-consumer 的例子中,我们使用了 employee- producer 使用 REST 模板公开的 REST 服务。

但是我们必须编写大量代码才能执行以下步骤

-

使用功能区进行负载平衡。

-

获取服务实例,然后获取基本 URL。

-

利用REST模板来使用服务。前面的代码如下

@Controller

public class ConsumerControllerClient {

@Autowired

private LoadBalancerClient loadBalancer;

public void getEmployee() throws RestClientException, IOExc eption {

ServiceInstance serviceInstance=loadBalancer.choose(“employ ee-producer”);

System.out.println(serviceInstance.getUri());

String baseUrl=serviceInstance.getUri().toString();

baseUrl=baseUrl+“/employee”;

RestTemplate restTemplate = new RestTemplate();

ResponseEntity response=null;

try{

response=restTemplate.exchange(baseUrl,

HttpMethod.GET, getHeaders(),String.class);

}catch (Exception ex)

{

System.out.println(ex);

}

System.out.println(response.getBody());

之前的代码,有像 NullPointer 这样的例外的机会,并不是最优的。我们将看到如何使用 Netflix Feign 使呼叫变得更加轻松和清洁。如果 Netflix Ribbon 依赖关系也在类路径中,那么 Feign 默认也会负责负载平衡。

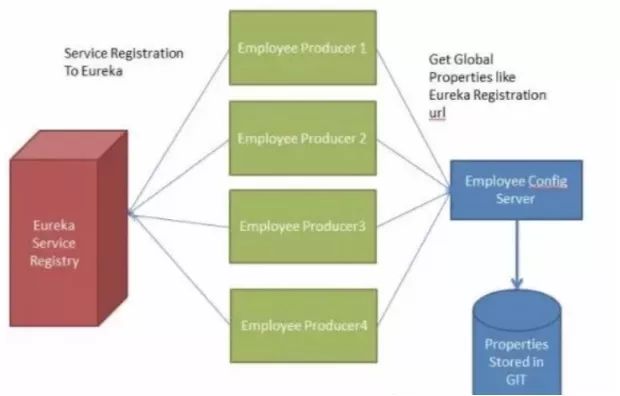

22、什么是SpringCloudBus我们需要它吗

考虑以下情况:我们有多个应用程序使用 Spring Cloud Config 读取属性, 而 Spring Cloud Config 从 GIT 读取这些属性。

下面的例子中多个员工生产者模块从 Employee Config Module 获取Eureka 注册的财产。

如果假设 GIT 中的 Eureka 注册属性更改为指向另一台 Eureka 服务器,会发生什么情况。在这种情况下,我们将不得不重新启动服务以获取更新的属性。

还有另一种使用执行器断点/刷新的方式。使我们将不得不为每个模块单独调用这个 url。例如,如果 Employee Producer1 部署在端口 8080上, 则调用 http:// localhost:8080/ refresh。同样对于 Employee Producer2 http:// localhost:8081 / refresh 等等。这又很麻烦。这就是 Spring Cloud Bus 发挥作用的地方。

Spring Cloud Bus 提供了跨多个实例刷新配置的功能。因此,在上面的示例中,如果我们刷新 Employee Producer1,则会自动刷新所有其他必需的模块。如果我们有多个微服务启动并运行,这特别 有用。这是通过将所有微服务连接到单个消息代理来实现的。无论何时刷新实例,此事件都会订阅到侦听此代理的所有微服务,并且它们也会刷新。可以通过使用端点/ 总线/刷新来实现对任何单个实例的刷新。

微服务面试合辑 word文档下载地址:链接:https://pan.baidu.com/s/1KdvrTt7bpxS2QMwlbhMErw

提取码:1111

爆肝一周,不眠不休!就为 点赞+好评+收藏 三连

并发编程面试篇合辑

并发编程(上)

1、Synchronized用过吗其原理是什么?

这是一道Java面试中几乎百分百会问到的问题,因为没有任何写过并发程序的开发者会没听说或者没接触过Synchronized。Synchronized是由JVM 实现的一种实现互斥同步的一种方式,如果你查看被Synchronized修饰过的程序块编译后的字节码,会发现,被Synchronized修饰过的程序块,在 编译前后被编译器生成了monitorenter和monitorexit两个字节码指令。这两个指令是什么意思呢2在虚拟机执行到monitorenter指令时,首先要尝试获取对象的锁:如果这个对象没有锁定,或者当前线程已经拥有了这个对 象的锁,把锁的计数器+ 1;当执行monitorexit指令时将锁计数器-1;当计数器为0时,锁就被释放了。如果获取对象失败了,那当前线程就要阻塞 等待,直到对象锁被另外一个线程释放为止。Java中Synchronize通过在对象头设置标记,达到了获取锁和释放锁的目的。

2、你刚才提到获取对象的锁这个 “锁 ”到底是什么2如何确定对象的锁2

“锁”的本质其实是monitorenter和monitorexit字节码指令的一个Reference 类型的参数,即要锁定和解锁的对象。我们知道,使用Synchronized 可以修饰不同的对象,因此,对应的对象锁可以这么确定。

1. 如果 Synchronized 明确指定了锁对象,比如 Synchronized(变量名)、Synchronized(this)等,说明加解锁对象为该对象。

2.如果没有明确指定:

若Synchronized修饰的方法为非静态方法,表示此方法对应的对象为 锁对象;

若 Synchronized 修饰的方法为静态方法,则表示此方法对应的类对象 为锁对象。

注意,当一个对象被锁住时,对象里面所有用 Synchronized 修饰的方法都将产生堵塞,而对象里非 Synchronized 修饰的方法可正常被调用,不受锁影响。

3、什么是可重入性为什么说 Synchronized 是可重入锁

可重入性是锁的一个基本要求,是为了解决自己锁死自己的情况。比如下面的伪代码,一个类中的同步方法调用另一个同步方法,假如Synchronized 不支持重入,进入 method2 方法时当前线程获得锁,method2 方法里面执行 method1 时当前线程又要去尝试获取锁,这 时如果不支持重入,它就要等释放,把自己阻塞,导致自己锁死自己。

对 Synchronized 来说,可重入性是显而易见的,刚才提到,在执行monitorenter 指令时,如果这个对象没有锁定,或者当前线程已经拥有了这个对象的锁(而不是已拥有了锁则不能继续获取),就把锁的计 数器+1, 其实本质上就通过这种方式实现了可重入性。

4、JVM 对 Java 的原生锁做了哪些优化

在 Java 6 之前,Monitor 的实现完全依赖底层操作系统的互斥锁来 实现, 也就是我们刚才在问题二中所阐述的获取/释放锁的逻辑。

由于Java 层面的线程与操作系统的原生线程有映射关系,如果要将一个线程进行阻塞或唤起都需要操作系统的协助,这就需要从用户态切换 到内核态来执行,这种切换代价十分昂贵,很耗处理器时间,现代 JDK 中做了大量的优化。一种优化是使用自旋锁,即在把线程进行阻塞操作之前先让线程自旋等 待一段时间,可能在等待期间其他线程已经解锁,这时就无需再让线程 执行阻塞操作,避免了用户态到内核态的切换。

现代JDK 中还提供了三种不同的 Monitor 实现,也就是三种不同的锁:

偏向锁(BiasedLocking)

轻量级锁

重量级锁

这三种锁使得 JDK 得以优化 Synchronized 的运行,当 JVM 检测到不同的竞争状况时,会自动切换到适合的锁实现,这就是锁的升级、 降级。

当没有竞争出现时,默认会使用偏向锁。

JVM 会利用 CAS 操作,在对象头上的 Mark Word 部分设置线程 ID,以表示这个对象偏向于当前线程,所以并不涉及真正的互斥锁,因 为在很多应用场景中,大部分对象生命周期中最多会被一个线程锁定, 使用偏斜锁可以降低无竞争开销。

如果有另一线程试图锁定某个被偏斜过的对象,JVM 就撤销偏斜锁, 切换到轻量级锁实现。

轻量级锁依赖 CAS 操作 Mark Word 来试图获取锁,如果重试成功, 就使用普通的轻量级锁;否则,进一步升级为重量级锁。

5、为什么说 Synchronized 是非公平锁

非公平主要表现在获取锁的行为上,并非是按照申请锁的时间前后给等 待线程分配锁的,每当锁被释放后,任何一个线程都有机会竞争到锁, 这样做的目的是为了提高执行性能,缺点是可能会产生线程饥饿现象。

6、什么是锁消除和锁粗化

锁消除:指虚拟机即时编译器在运行时,对一些代码上要求同步,但被 检测到不可能存在共享数据竞争的锁进行消除。主要根据逃逸分析。

程序员怎么会在明知道不存在数据竞争的情况下使用同步呢很多不是程序员自己加入的。

锁粗化:原则上,同步块的作用范围要尽量小。但是如果一系列的连续 操作都对同一个对象反复加锁和解锁,甚至加锁操作在循环体内,频繁 地进行互斥同步操作也会导致不必要的性能损耗。

锁粗化就是增大锁的作用域。

7、为什么说 Synchronized 是一个悲观锁乐观锁的实现原理 又是什么什么是CAS它有什么特性

Synchronized 显然是一个悲观锁,因为它的并发策略是悲观的:不管是否会产生竞争,任何的数据操作都必须要加锁、用户态核心态转 换、维护锁计数器和检查是否有被阻塞的线程需要被唤醒等操作。随着硬件指令集的发展,我们可以使用基于冲突检测的乐观并发策略。先进行操作,如果没 有其他线程征用数据,那操作就成功了; 如果共享数据有征用,产生了冲突,那就再进行其他的补偿措施。这种乐观的并发策略的许多实现不需要线程挂起,所以被称为非阻塞同步。乐观锁的核心算法是CAS(Compareand Swap,比较并交换),它涉及到三个操作数:内存值、预期值、新值。当且仅当预期值和内存值相等时才将内存值修改为新值。这样处理的逻辑是,首先检查某块内存的值是否跟之前我读取时的一 样, 如不一样则表示期间此内存值已经被别的线程更改过,舍弃本次操 作,否则说明期间没有其他线程对此内存值操作,可以把新值设置给此 块内存。

CAS 具有原子性,它的原子性由 CPU 硬件指令实现保证,即使用 JNI 调用 Native 方法调用由 C++编写的硬件级别指令,JDK 中提供了 Unsafe 类执行这些操作。

8、乐观锁一定就是好的吗

乐观锁避免了悲观锁独占对象的现象,同时也提高了并发性能,但它也有缺点:

1. 乐观锁只能保证一个共享变量的原子操作。如果多一个或几个变量,乐观锁将变得力不从心,但互斥锁能轻易解决,不管对象数量多少及对象颗粒度大小。

2. 长时间自旋可能导致开销大。假如 CAS 长时间不成功而一直自旋,会给 CPU 带来很大的开销。

3. ABA 问题。CAS 的核心思想是通过比对内存值与预期值是否一样而判断内存值是否被改过,但这个判断逻辑不严谨,假如内存值原来是 A, 后来被一条线程改为 B,最后又被改成了 A,则 CAS 认为此内存值并没有发生改变,但实际上是有被其他线程改过的,这种情况对依赖过程值的情景 的运算结果影响很大。解决的思路是引入版本号,每次变量更新都把版本号加一。

9、跟 Synchronized 相比可重入锁 ReentrantLock 其实现 原理有什么不同

其实,锁的实现原理基本是为了达到一个目的: 让所有的线程都能看到某种标记。

Synchronized 通过在对象头中设置标记实现了这一目的,是一种 JVM 原生的锁实现方式,而 ReentrantLock 以及所有的基于 Lock 接口的实现类,都是通过用一个 volitile 修饰的 int 型变量,并保证每个线 程都能拥有对该 int 的可见性和原子修改,其本质是基于所谓的 AQS 框架。

10 、 那 么 请 谈 谈 AQS 框 架 是 怎 么 回 事 儿

AQS(AbstractQueuedSynchronizer 类)是一个用来构建锁和同步器的框架, 各种 Lock 包中的锁(常用的有 ReentrantLock、 ReadWriteLock) ,以及其他如 Semaphore、CountDownLatch, 甚至是早期的 FutureTask 等,都是基于 AQS 来构建。

1. AQS 在内部定义了一个 volatile int state 变量,表示同步状态:当线程调用 lock 方法时 ,如果 state=0,说明没有任何线程占有共享资源 的锁,可以获得锁并将 state=1;如果 state=1,则说明有线程目前正在 使用共享变量,其他线程必须加入同步队列进行等待。

2. AQS 通过 Node 内部类构成的一个双向链表结构的同步队列,来完成线程获取锁的排队工作,当有线程获取锁失败后,就被添加到队列末尾。

Node类是对要访问同步代码的线程的封装,包含了线程本身及其状态叫

waitStatus(有五种不同取值,分别表示是否被阻塞,是否等待唤醒, 是否已经被取消等),每个 Node 结点关联其 prev 结点和 next 结点,方便线程释放锁后快速唤醒下一个在等待的线程,是一个 FIFO 的过程。

Node 类有两个常量,SHARED 和 EXCLUSIVE,分别代表共享模式和独占模式。所谓共享模式是一个锁允许多条线程同时操作(信号量Semaphore 就是基于 AQS 的共享模式实现的),独占模式是同一个时间段只能有一个线程对共享资源进行操作,多余的请求线程需要排队等待(如 ReentranLock)。

3. AQS 通过内部类 ConditionObject 构建等待队列(可有多个),当Condition 调用 wait()方法后,线程将会加入等待队列中,而当Condition 调用 signal()方法后,线程将从等待队列转移动同步队列中进行锁竞争。

4.AQS和Condition各自维护了不同的队列,在使用Lock和Condition

的时候,其实就是两个队列的互相移动。

11、请尽可能详尽地对比下 Synchronized 和 ReentrantLock 的异同

ReentrantLock 是 Lock 的实现类,是一个互斥的同步锁。从功能角度, ReentrantLock 比 Synchronized 的同步操作更精细(因为可以像普通对象一样使用),甚至实现 Synchronized 没有的高级功能,如:

等待可中断:当持有锁的线程长期不释放锁的时候,正在等待的线程可以选择放弃等待,对处理执行时间非常长的同步块很有用。

带超时的获取锁尝试:在指定的时间范围内获取锁,如果时间到了仍然无法获取则返回。

可以判断是否有线程在排队等待获取锁。

可以响应中断请求:与 Synchronized 不同,当获取到锁的线程被中断时,能够响应中断,中断异常将会被抛出,同时锁会被释放。

可以实现公平锁。

从锁释放角度,Synchronized 在 JVM 层面上实现的,不但可以通过一些监控工具监控 Synchronized 的锁定,而且在代码执行出现异常时,JVM 会自动释放锁定;但是使用 Lock 则不行,Lock 是通过代码实现的,要保证锁定一定会被释放,就必须将 unLock()放到 finally{}中。

从性能角度,Synchronized 早期实现比较低效,对比ReentrantLock,大多数场景性能都相差较大。

但是在 Java 6 中对其进行了非常多的改进,在竞争不激烈时, Synchronized 的性能要优于 ReetrantLock;在高竞争情况下, Synchronized 的性能会下降几十倍,但是 ReetrantLock 的性能能维持常态。

12、ReentrantLock 是如何实现可重入性的

ReentrantLock 内部自定义了同步器 Sync(Sync 既实现了 AQS, 又实现了 AOS,而 AOS 提供了一种互斥锁持有的方式),其实就是 加锁的时候通过CAS 算法,将线程对象放到一个双向链表中,每次获 取锁的时候,看下当前维护的那个线程 ID 和当前请求的线程 ID 是否一样,一样就可重入了。

13、除了 ReetrantLock你还接触过 JUC 中的哪些并发工具

通常所说的并发包(JUC)也就是java.util.concurrent及其子包,集中了Java并发的各种基础工具类,具体主要包括几个方面:

提供了 CountDownLatch、CyclicBarrier、Semaphore等,比Synchronized 更加高级,可以实现更加丰富多线程操作的同步结构。

提供了ConcurrentHashMap、有序的ConcunrrentSkipListMap,或者通过类似快照机制实现线程安全的动态数组CopyOnWriteArrayList等各种线程安全的容器。

提供了ArrayBlockingQueue、SynchorousQueue或针对特定场景的

PriorityBlockingQueue 等,各种并发队列实现。

强大的 Executor 框架,可以创建各种不同类型的线程池,调度任务运行等。

14、请谈谈ReadWriteLock和StampedLock)

虽然 ReentrantLock 和 Synchronized 简单实用,但是行为上有一定局限性,要么不占,要么独占。实际应用场景中,有时候不需要大量 竞争的写操作,而是以并发读取为主,为了进一步优化并发操作的粒度,Java 提供了读写锁。读写锁基于的原理是多个读操作不需要互斥,如果读锁试图锁定时,写锁是被某个线程持有,读锁将无法获得,而只好等待对方操作 结束,这样就可以自动保证不会读取到有争议的数据。

读写锁看起来比 Synchronized 的粒度似乎细一些,但在实际应用 中,其表现也并不尽如人意,主要还是因为相对比较大的开销。所以,JDK 在后期引入了 StampedLock,在提供类似读写锁的同时,还支持优化读模式。优化读基于假设,大多数情况下读操作并不会和写 操作冲突,其逻辑是先试着修改,然后通过 validate 方法确认是否进入了写模式,如果没有进入,就成功避免了开销;如果进入,则尝试获取读锁。

15、如何让 Java 的线程彼此同步你了解过哪些同步器请分别介绍下

JUC 中的同步器三个主要的成员:CountDownLatch、CyclicBarrier 和Semaphore,通过它们可以方便地实现很多线程之间协作的功能。CountDownLatch 叫倒计数,允许一个或多个线程等待某些操作完成。看几个场景:

跑步比赛,裁判需要等到所有的运动员(“其他线程”)都跑到终点(达到目标),才能去算排名和颁奖。

模拟并发,我需要启动 100个线程去同时访问某一个地址,我希望它 们能同时并发,而不是一个一个的去执行。

用法:CountDownLatch 构造方法指明计数数量,被等待线程调用countDown 将计数器减 1,等待线程使用 await 进行线程等待。一个简单的例子:

CyclicBarrier 叫循环栅栏,它实现让一组线程等待至某个状态之后再全部同时执行,而且当所有等待线程被释放后,CyclicBarrier 可以被重复使用。CyclicBarrier 的典型应用场景是用来等待并发线程结束。CyclicBarrier 的主要方法是 await(),await()每被调用一次,计数便会减少 1,并阻塞住当前线程。当计数减至0时,阻塞解除,所有在 此 CyclicBarrier 上面阻塞的线程开始运行。

在这之后,如果再次调用 await(),计数就又会变成 N-1,新一轮重新开始,这便是 Cyclic 的含义所在。CyclicBarrier.await() 带有返回值,用来表示当前线程是第几个到达这个 Barrier 的线程。

举例说明如下:

Semaphore,Java版本的信号量实现,用于控制同时访问的线程个数,来

达到限制通用资源访问的目的,其原理是通过 acquire()获取一个许可,如果没有就等待,而 release() 释放一个许可。

如果Semaphore 的数值被初始化为1,那么一个线程就可以通过 acquire进入互斥状态,本质上和互斥锁是非常相似的。

但是区别也非常明显,比如互斥锁是有持有者的,而对于 Semaphore 这种计数器结构,虽然有类似功能,但其实不存在真正意义的持有者,除非我们进行扩展包装。

16、CyclicBarrier 和 CountDownLatch 看起来很相似请对比下呢

它们的行为有一定相似度,区别主要在于:

CountDownLatch 是不可以重置的,所以无法重用,CyclicBarrier 没有这种限制,可以重用。

CountDownLatch 的基本操作组合是 countDown/await,调用 await 的线程阻塞等待 countDown 足够的次数,不管你是在一个线程还是多个线程里 countDown,只要次数足够即可。CyclicBarrier 的基本操作组合就是await,当所有的伙伴都调用了 await,才会继续进行任务,并自动进行重置。

CountDownLatch 目的是让一个线程等待其他 N 个线程达到某个条件后, 自己再去做某个事(通过 CyclicBarrier 的第二个构造方法 public CyclicBarrier(int parties, Runnable barrierAction),在新线程里做事可以达到同样的效果)。而 CyclicBarrier 的目的是让 N 多线程互相等待直到所有的都达到某个状态,然后这 N 个线程再继续执行各自后续(通过CountDownLatch 在某些场合也能完成类似的效果)。

17、Java 中的线程池是如何实现的

在Java中,所谓的线程池中的“线程”,其实是被抽象为了一个静态 内部类Worker,它基于AQS实现,存放在线程池的HashSet workers 成员变量中;

而需要执行的任务则存放在成员变量 workQueue(BlockingQueue workQueue)中。

这样,整个线程池实现的基本思想就是:从 workQueue 中不断取出 需要执行的任务,放在 Workers 中进行处理。

18、创建线程池的几个核心构造参数

Java 中的线程池的创建其实非常灵活,我们可以通过配置不同的参 数,创建出行为不同的线程池,这几个参数包括:

corePoolSize:线程池的核心线程数。

maximumPoolSize:线程池允许的最大线程数。

keepAliveTime:超过核心线程数时闲置线程的存活时间。

workQueue:任务执行前保存任务的队列,保存由execute方法提交的Runnable 任务 。

19、线程池中的线程是怎么创建的是一开始就随着线程池的启动创建好的吗

显然不是的。线程池默认初始化后不启动 Worker,等待有请求时才启动。

每当我们调用execute() 方法添加一个任务时,线程池会做如下判 断:

如果正在运行的线程数量小于corePoolSize,那么马上创建线程运行这个任务;

如果正在运行的线程数量大于或等于corePoolSize,那么将这个任务放入队列;

如果这时候队列满了,而且正在运行的线程数量小于

maximumPoolSize,那么还是要创建非核心线程立刻运行这个任务;

如果队列满了,而且正在运行的线程数量大于或等于 maximumPoolSize,那么线程池会抛出异常 RejectExecutionException。当一个线程完成任务时,它会从队列中取下一个任务来执行。当一个线程无事可做,超过一定的时间(keepAliveTime)时,线程池会判断。

如果当前运行的线程数大于 corePoolSize,那么这个线程就被停掉。所以线程池的所有任务完成后,它最终会收缩到 corePoolSize 的大小。

20、既然提到可以通过配置不同参数创建出不同的线程池那么Java中默认实现好的线程池又有哪些呢请比较它们的异同)

1.SingleThreadExecutor线程池

这个线程池只有一个核心线程在工作,也就是相当于单线程串行执行所 有任务。如果这个唯一的线程因为异常结束,那么会有一个新的线程来 替代它。此线程池保证所有任务的执行顺序按照任务的提交顺序执行。

- corePoolSize:1,只有一个核心线程在工作。

- maximumPoolSize: 1。

- keepAliveTime:0L。

- workQueue:newLinkedBlockingQueue()其缓冲队列是无界的

2.FixedThreadPool线程池

FixedThreadPool 是固定大小的线程池,只有核心线程。每次提交一个任务就创建一个线程,直到线程达到线程池的最大大小。线程池的大小一旦达到最大值就会保持不变,如果某个线程因为执行异常而结束,那么线程池会补充一个新线程。

FixedThreadPool 多数针对一些很稳定很固定的正规并发线程,多用于服务器。

- corePoolSize:nThreads

- maximumPoolSize:nThreads

- keepAliveTime:0L

- workQueue:newLinkedBlockingQueue()其缓冲队列是无界的

3.CachedThreadPool线程池

CachedThreadPool 是无界线程池,如果线程池的大小超过了处理任务所需要的线程,那么就会回收部分空闲(60秒不执行任务)线程,当 任务数增加时,此线程池又可以智能的添加新线程来处理任务。线程池大小完全依赖于操作系统(或者说 JVM)能够创建的最大线程大小。SynchronousQueue 是一个是缓冲区为 1 的阻塞队列。缓存型池子通常用于执行一些生存期很短的异步型任务,因此在一些面向连接的 daemon 型 SERVER 中用得不多。但对于生存期短的异步任务,它是 Executor 的首选。

- corePoolSize: 0

- maximumPoolSize:Integer.MAX_VALUE

- keepAliveTime: 60L

- workQueue:newSynchronousQueue()

一个是缓冲区为1 的阻塞队列。

4.ScheduledThreadPool线程池

ScheduledThreadPool核心线程池固定,大小无限的线程池。此线程池支持定时以及周期性执行任务的需求。创建一个周期性执行任务的线程池。如果闲置,非核心线程池会在DEFAULT_KEEPALIVEMILLIS时间内回收

- corePoolSize: corePoolSize

- maximumPoolSize:Integer.MAX_VALUE

- keepAliveTime:DEFAULT_KEEPALIVE_MILLIS

- workQueue:newDelayedWorkQueue()

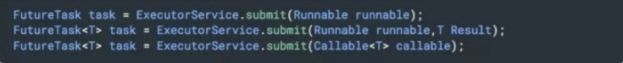

21、如何在 Java 线程池中提交线程

线程池最常用的提交任务的方法有两种:

1.execute():ExecutorService.execute方法接收一个例,它用来执行一个任务:

2. submit(): ExecutorService.submit()方法返回的是 Future 对象。可以用

isDone()来查询 Future 是否已经完成,当任务完成时, 它具有一个结果, 可以调用 get()来获取结果。也可以不用 isDone() 进行检查就直接调用get(),在这种情况下,get() 将阻塞,直至结果准备就绪。

22、什么是 Java 的内存模型Java 中各个线程是怎么彼此看到对方的变量的

Java 的内存模型定义了程序中各个变量的访问规则,即在虚拟机中将 变量存储到内存和从内存中取出这样的底层细节。此处的变量包括实例字段、静态字段和构成数组对象的元素,但是不包括局部变量和方法参数, 因为这些是线程私有的,不会被共享,所以不存在竞争问题。

Java 中各个线程是怎么彼此看到对方的变量的呢Java中定义了主内存与工作内存的概念:

所有的变量都存储在主内存,每条线程还有自己的工作内存,保存了被 该线程使用到的变量的主内存副本拷贝。

线程对变量的所有操作(读取、赋值)都必须在工作内存中进行,不能直接读写主内存的变量。不同的线程之间也无法直接访问对方工作内存的变量,线程间变量值的传递需要通过主内存。

23、请谈谈 volatile 有什么特点为什么它能保证变量对所有线程的可见性

关键字 volatile 是 Java 虚拟机提供的最轻量级的同步机制。当一个变量被定义成 volatile 之后,具备两种特性:

1. 保证此变量对所有线程的可见性。当一条线程修改了这个变量的值,新值对于其他线程是可以立即得知的。而普通变量做不到这一点。

2. 禁止指令重排序优化。普通变量仅仅能保证在该方法执行过程中,得到正确结果,但是不保证程序代码的执行顺序。

Java 的内存模型定义了 8 种内存间操作:

lock 和 unlock

把一个变量标识为一条线程独占的状态。

把一个处于锁定状态的变量释放出来,释放之后的变量才能被其他线程锁定。

read 和 write

把一个变量值从主内存传输到线程的工作内存,以便 load。

把 store 操作从工作内存得到的变量的值,放入主内存的变量中。

load 和 store

把 read 操作从主内存得到的变量值放入工作内存的变量副本中。

把工作内存的变量值传送到主内存,以便 write。

use 和 assgin

把工作内存变量值传递给执行引擎。

将执行引擎值传递给工作内存变量值。

volatile 的实现基于这 8 种内存间操作,保证了一个线程对某个 volatile 变量的修改,一定会被另一个线程看见,即保证了可见性。

24、既然 volatile 能够保证线程间的变量可见性是不是就意味着基于volatile变量的运算就是并发安全的

显然不是的。基于 volatile 变量的运算在并发下不一定是安全的。volatile 变量在各个线程的工作内存,不存在一致性问题(各个线程的工作内存中volatile 变量,每次使用前都要刷新到主内存)。

但是 Java 里面的运算并非原子操作,导致 volatile 变量的运算在并发下一样是不安全的。

25、请对比下 volatile 对比 Synchronized 的异同)

Synchronized 既能保证可见性,又能保证原子性,而 volatile 只能保证可见性,无法保证原子性。

ThreadLocal 和 Synchonized 都用于解决多线程并发访问,防止任务在共享资源上产生冲突。但是 ThreadLocal 与 Synchronized 有本质的区别。Synchronized 用于实现同步机制,是利用锁的机制使变量或代码块在某一时刻只能被一个线程访问,是一种 “以时间换空间” 的方式。

而 ThreadLocal 为每一个线程都提供了变量的副本,使得每个线程在某一时间访问到的并不是同一个对象,根除了对变量的共享,是一种“以空间换时间”的方式。

26、请谈谈 ThreadLocal 是怎么解决并发安全的

ThreadLocal 这是 Java 提供的一种保存线程私有信息的机制,因为 其在整个线程生命周期内有效,所以可以方便地在一个线程关联的不同业务模块之间传递信息,比如事务 ID、Cookie 等上下文相关信息。ThreadLocal 为每一个线程维护变量的副本,把共享数据的可见范围限 制在同一个线程之内,其实现原理是,在 ThreadLocal 类中有一个 Map,用于存储每一个线程的变量的副本。

27、很多人都说要慎用 ThreadLocal谈谈你的理解使用ThreadLocal 需要注意些什么

使用ThreadLocal 要注意 remove!

ThreadLocal 的实现是基于一个所谓的 ThreadLocalMap,在ThreadLocalMap 中,它的 key 是一个弱引用。

通常弱引用都会和引用队列配合清理机制使用,但是 ThreadLocal 是个例外,它并没有这么做。

这意味着,废弃项目的回收依赖于显式地触发,否则就要等待线程结束, 进而回收相应 ThreadLocalMap!这就是很多 OOM 的来源,所 以通常都会建议,应用一定要自己负责 remove,并且不要和线程池配 合,因为worker 线程往往是不会退出的。

并发编程(下)

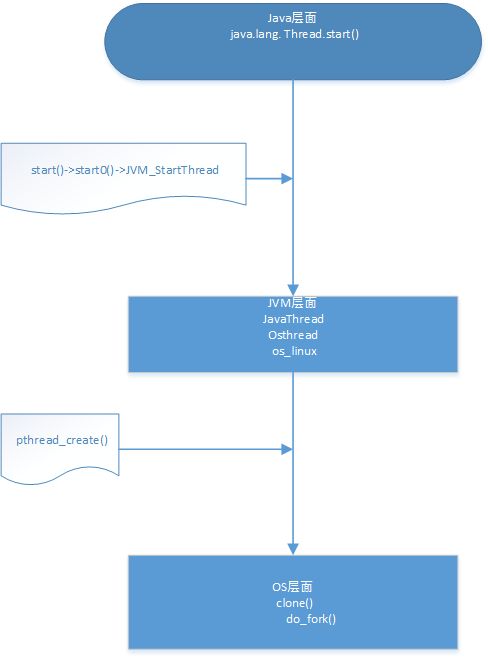

1、Java start 如何调用到run方法

java层面: start -> start0() -> native start0()

C(jvm)层面: JVM_StartThread()

OS层面: pthread_create() 这里会回调jvm的run方法

java调用 native方法,native 方法对应着 头文件,头文件会动态链接到 c文件,c文件会调用 系统函数。

2、synchronized 关键字的底层原理,synchronize锁是如何实现的?

-

首先每个类都由Objec派生出,每个对象都有ObjectMonitor,当线程发生同步,会去尝试将ObjectMonitor 的 owner 设置为自己,如果没有获得就会进入entryList中。

-

获取锁,monitor 的计数器就会加1,owner 就指向当前线程。同时synchronized 是支持重入锁,也就是同一个线程对同一个对象多次加锁。每加锁一次,计数器就会加1。

-

获取锁,线程进入同步块,虚拟机就会设置 monitorenter进入同步块,退出同步就会设置为monitorexit,为了防止同步中出现异常,设置了第二个monitorexit。

-

当退出同步,计数器就变为 0,owner 设置为 null,entryList中线程就会CAS去竞争获取对象monitor关联的锁。只有一个线程可以获取到锁。

-

当遇到wait就将同步的线程放入waitSet中。

-

当对象调用notify,就会随机从waitSet取一个线程,放到entryList中,然后线程去竞争monitor。

-

当对象调用notifyAll,就会从waitSet将持有该对象的所有的线程,放到entryList中,然后线程去竞争monitor。

wait

wait 会将线程从entryList 放回到waitSet中。

3、notify 区别和 notifyAll

notify 会从waitSet《等待队列》中随机拿取那一个线程放到entryList《阻塞队列》中

notifyAll 会将waitSet所有线程都放到entryList中,唤醒哪个不确定,因为不确定谁竞争到了monitor。

4、synchronize锁优化锁膨胀过程?

首先synchronize的锁的状态在对象头中。

64位jdk 对应的 对象头中一共128个字节。 64个字节为 mark word 64个字节为klass word。我们主要看 mark word 结构。

无锁:主要的头信息 lock(锁状态) : 01 2个字节,biased_lock(是否偏向锁)1个字节:0,年轻代年龄:4个字节(用于晋升到老年代阈值),indentity_hashcode:对象标识hash码 25个字节 剩下的 26字节没有用。

偏向锁:主要的头信息 lock: 01,biased_lock:1,thread:54位 当先线程id,age:4字节

轻量锁:主要的头信息 lock:00

重量锁:主要的头信息 lock:10

GC:主要的头信息 lock:11

对象头****我们可以使用 openjdk 的 jol插件测试打印头信息。

- 从无锁到偏向锁

- 默认开启延迟偏向锁,jvm运行默认超过4s,那么对象就会开启偏向锁。

当第一个线程来访问它的时候,它会修改 ThreadId 改为当前线程的id,之后再访问这个对象时,只要对比ThreadID,一样就不会再CAS。

他默认第一次会调用os加锁。可以修改 os上锁函数 打印系统线程id,再修改C文件 打印 c的线程id。当开启一个线程,然后同步只打印一次 系统线程id和 c的线程id。而开启两个线程,对同一个对象加锁,会发现 系统线程id和c的线程id 同步打印。

多个线程通过CAS来获取锁,偏向上个拥有的线程,是乐观锁。

一般是单个线程执行

- 从偏向锁到轻量级锁

- 当前为无锁,直接修改为轻量级锁。

- 当前为偏向锁,并且偏向的线程不是当前线程,他会判断该锁的偏向线程是否存活,没有存活,将偏向锁变为无锁。然后变为轻量级锁。

多个线程,通过CAS来获取锁,是乐观锁。

一般是多个线程,交替执行。

- 从轻量级锁到重量级锁

- 轻量级锁自旋一定次数或者一个线程在持有锁,一个在自旋,另外一个线程来访时,轻量级膨胀为重量级锁。

- 对象调用了wait()也会变为重量级锁。

重量级锁,是调用了os函数加锁,使除了拥有锁的线程以为的线程都是阻塞,防止 CPU 空转,是悲观锁。

一般是多个线程,竞争执行。

5、AQS原理

AQS 全称 AbstractQueuedSynchronizer 抽象的队列同步器。他是一个抽象类。

AQS 通过 CLH 队列 一个带有虚拟头节点的双向链表,来唤醒线程是否可以竞争获取锁。

他主要有两种方式:一种是独占方式:只有一个线程能执行;一种是共享方式,多个线程可以同时执行。

我主要研究了独占方式的AQS 实现,ReentrantLock的实现方式。