机器学习——05 Logistic回归

目录

1.LR基础

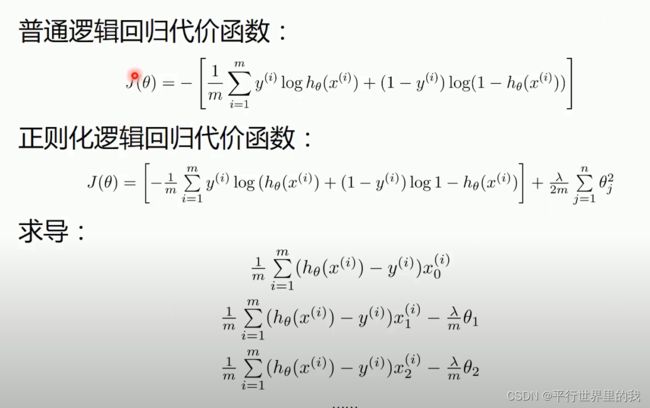

1.1 逻辑回归正则化

2. 线性逻辑回归代码实现

2.1 梯度下降法python实现

2.2 skleran库python实现

3. 非线性逻辑回归代码实现

3.1 梯度下降法python实现

3.2 skleran库python实现

4. LR总结

4.1 LR优缺点

4.2 逻辑回归 VS 线性回归

总结:

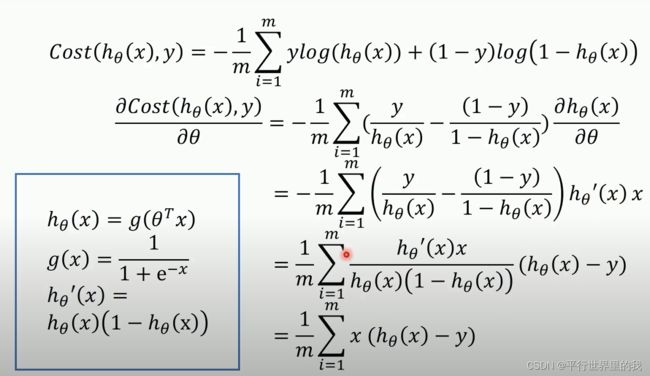

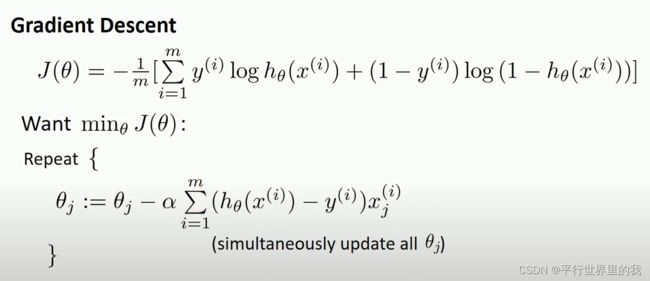

1.LR基础

虽然叫回归,但是做的是分类问题。

逻辑回归一般用于二分类。

对于多分类问题,可以使用多个二分类依次分出来

1.1 逻辑回归正则化

2. 线性逻辑回归代码实现

LR适合离散特征,不适合特征空间大的情况。

两种实现方式——1.梯度下降法python实现

2.skleran库python实现

数据集之后上传

2.1 梯度下降法python实现

import matplotlib.pyplot as plt

import numpy as np

from sklearn.metrics import classification_report

from sklearn import preprocessing

# 数据是否需要标准化

scale = True

# 载入数据

data = np.genfromtxt("LR-testSet.csv", delimiter=",")

x_data = data[:, :-1]

y_data = data[:, -1]

def plot():

x0 = []

x1 = []

y0 = []

y1 = []

# 切分不同类别的数据

for i in range(len(x_data)):

if y_data[i] == 0:

x0.append(x_data[i, 0])

y0.append(x_data[i, 1])

else:

x1.append(x_data[i, 0])

y1.append(x_data[i, 1])

# 画图

scatter0 = plt.scatter(x0, y0, c='b', marker='o')

scatter1 = plt.scatter(x1, y1, c='r', marker='x')

# 画图例

plt.legend(handles=[scatter0, scatter1], labels=['label0', 'label1'], loc='best')

plot()

plt.show()

# 数据处理,添加偏置项

x_data = data[:,:-1]

y_data = data[:,-1,np.newaxis]

print(np.mat(x_data).shape)

print(np.mat(y_data).shape)

# 给样本添加偏置项

X_data = np.concatenate((np.ones((100,1)),x_data),axis=1)

print(X_data.shape)

def sigmoid(x):

return 1.0 / (1 + np.exp(-x))

def cost(xMat, yMat, ws):

left = np.multiply(yMat, np.log(sigmoid(xMat * ws)))

right = np.multiply(1 - yMat, np.log(1 - sigmoid(xMat * ws)))

return np.sum(left + right) / -(len(xMat))

def gradAscent(xArr, yArr):

if scale == True:

xArr = preprocessing.scale(xArr)

xMat = np.mat(xArr)

yMat = np.mat(yArr)

lr = 0.001

epochs = 10000

costList = []

# 计算数据行列数

# 行代表数据个数,列代表权值个数

m, n = np.shape(xMat)

# 初始化权值

ws = np.mat(np.ones((n, 1)))

for i in range(epochs + 1):

# xMat和weights矩阵相乘

h = sigmoid(xMat * ws)

# 计算误差

ws_grad = xMat.T * (h - yMat) / m

ws = ws - lr * ws_grad

if i % 50 == 0:

costList.append(cost(xMat, yMat, ws))

return ws, costList

# 训练模型,得到权值和cost值的变化

ws,costList = gradAscent(X_data, y_data)

print(ws)

if scale == False:

# 画图决策边界

plot()

x_test = [[-4],[3]]

y_test = (-ws[0] - x_test*ws[1])/ws[2]

plt.plot(x_test, y_test, 'k')

plt.show()

# 画图 loss值的变化

x = np.linspace(0,10000,201)

plt.plot(x, costList, c='r')

plt.title('Train')

plt.xlabel('Epochs')

plt.ylabel('Cost')

plt.show()

# 预测

def predict(x_data, ws):

if scale == True:

x_data = preprocessing.scale(x_data)

xMat = np.mat(x_data)

ws = np.mat(ws)

return [1 if x >= 0.5 else 0 for x in sigmoid(xMat*ws)]

predictions = predict(X_data, ws)

print(classification_report(y_data, predictions))2.2 skleran库python实现

import matplotlib.pyplot as plt

import numpy as np

from sklearn.metrics import classification_report

from sklearn import preprocessing

from sklearn import linear_model

# 数据是否需要标准化

scale = False

# 载入数据

data = np.genfromtxt("LR-testSet.csv", delimiter=",")

x_data = data[:, :-1]

y_data = data[:, -1]

def plot():

x0 = []

x1 = []

y0 = []

y1 = []

# 切分不同类别的数据

for i in range(len(x_data)):

if y_data[i] == 0:

x0.append(x_data[i, 0])

y0.append(x_data[i, 1])

else:

x1.append(x_data[i, 0])

y1.append(x_data[i, 1])

# 画图

scatter0 = plt.scatter(x0, y0, c='b', marker='o')

scatter1 = plt.scatter(x1, y1, c='r', marker='x')

# 画图例

plt.legend(handles=[scatter0, scatter1], labels=['label0', 'label1'], loc='best')

plot()

plt.show()

logistic = linear_model.LogisticRegression()

logistic.fit(x_data, y_data)

if scale == False:

# 画图决策边界

plot()

x_test = np.array([[-4],[3]])

y_test = (-logistic.intercept_ - x_test*logistic.coef_[0][0])/logistic.coef_[0][1]

plt.plot(x_test, y_test, 'k')

plt.show()

predictions = logistic.predict(x_data)

print(classification_report(y_data, predictions))3. 非线性逻辑回归代码实现

就和回归里面的多项式回归差不多

3.1 梯度下降法python实现

import matplotlib.pyplot as plt

import numpy as np

from sklearn.metrics import classification_report

from sklearn import preprocessing

from sklearn.preprocessing import PolynomialFeatures

# 数据是否需要标准化

scale = False

# 载入数据

data = np.genfromtxt("LR-testSet2.txt", delimiter=",")

x_data = data[:, :-1]

y_data = data[:, -1, np.newaxis]

def plot():

x0 = []

x1 = []

y0 = []

y1 = []

# 切分不同类别的数据

for i in range(len(x_data)):

if y_data[i] == 0:

x0.append(x_data[i, 0])

y0.append(x_data[i, 1])

else:

x1.append(x_data[i, 0])

y1.append(x_data[i, 1])

# 画图

scatter0 = plt.scatter(x0, y0, c='b', marker='o')

scatter1 = plt.scatter(x1, y1, c='r', marker='x')

# 画图例

plt.legend(handles=[scatter0, scatter1], labels=['label0', 'label1'], loc='best')

plot()

plt.show()

# 定义多项式回归,degree的值可以调节多项式的特征

poly_reg = PolynomialFeatures(degree=3)

# 特征处理

x_poly = poly_reg.fit_transform(x_data)

def sigmoid(x):

return 1.0 / (1 + np.exp(-x))

def cost(xMat, yMat, ws):

left = np.multiply(yMat, np.log(sigmoid(xMat * ws)))

right = np.multiply(1 - yMat, np.log(1 - sigmoid(xMat * ws)))

return np.sum(left + right) / -(len(xMat))

def gradAscent(xArr, yArr):

if scale == True:

xArr = preprocessing.scale(xArr)

xMat = np.mat(xArr)

yMat = np.mat(yArr)

lr = 0.03

epochs = 50000

costList = []

# 计算数据列数,有几列就有几个权值

m, n = np.shape(xMat)

# 初始化权值

ws = np.mat(np.ones((n, 1)))

for i in range(epochs + 1):

# xMat和weights矩阵相乘

h = sigmoid(xMat * ws)

# 计算误差

ws_grad = xMat.T * (h - yMat) / m

ws = ws - lr * ws_grad

if i % 50 == 0:

costList.append(cost(xMat, yMat, ws))

return ws, costList

# 训练模型,得到权值和cost值的变化

ws,costList = gradAscent(x_poly, y_data)

print(ws)

# 获取数据值所在的范围

x_min, x_max = x_data[:, 0].min() - 1, x_data[:, 0].max() + 1

y_min, y_max = x_data[:, 1].min() - 1, x_data[:, 1].max() + 1

# 生成网格矩阵

xx, yy = np.meshgrid(np.arange(x_min, x_max, 0.02),

np.arange(y_min, y_max, 0.02))

# np.r_按row来组合array,

# np.c_按colunm来组合array

# >>> a = np.array([1,2,3])

# >>> b = np.array([5,2,5])

# >>> np.r_[a,b]

# array([1, 2, 3, 5, 2, 5])

# >>> np.c_[a,b]

# array([[1, 5],

# [2, 2],

# [3, 5]])

# >>> np.c_[a,[0,0,0],b]

# array([[1, 0, 5],

# [2, 0, 2],

# [3, 0, 5]])

z = sigmoid(poly_reg.fit_transform(np.c_[xx.ravel(), yy.ravel()]).dot(np.array(ws)))# ravel与flatten类似,多维数据转一维。flatten不会改变原始数据,ravel会改变原始数据

for i in range(len(z)):

if z[i] > 0.5:

z[i] = 1

else:

z[i] = 0

z = z.reshape(xx.shape)

# 等高线图

cs = plt.contourf(xx, yy, z)

plot()

plt.show()

# 预测

def predict(x_data, ws):

# if scale == True:

# x_data = preprocessing.scale(x_data)

xMat = np.mat(x_data)

ws = np.mat(ws)

return [1 if x >= 0.5 else 0 for x in sigmoid(xMat*ws)]

predictions = predict(x_poly, ws)

print(classification_report(y_data, predictions))

3.2 skleran库python实现

数据集是自己生成的

import numpy as np

import matplotlib.pyplot as plt

from sklearn import linear_model

from sklearn.datasets import make_gaussian_quantiles

from sklearn.preprocessing import PolynomialFeatures

# 生成2维正态分布,生成的数据按分位数分为两类,500个样本,2个样本特征

# 可以生成两类或多类数据

x_data, y_data = make_gaussian_quantiles(n_samples=500, n_features=2,n_classes=2)

plt.scatter(x_data[:, 0], x_data[:, 1], c=y_data)

plt.show()

# ###################################################################################################################################

# 线性逻辑回归效果很差

logistic = linear_model.LogisticRegression()

logistic.fit(x_data, y_data)

# 获取数据值所在的范围

x_min, x_max = x_data[:, 0].min() - 1, x_data[:, 0].max() + 1

y_min, y_max = x_data[:, 1].min() - 1, x_data[:, 1].max() + 1

# 生成网格矩阵

xx, yy = np.meshgrid(np.arange(x_min, x_max, 0.02),

np.arange(y_min, y_max, 0.02))

# np.r_按row来组合array,

# np.c_按colunm来组合array

# >>> a = np.array([1,2,3])

# >>> b = np.array([5,2,5])

# >>> np.r_[a,b]

# array([1, 2, 3, 5, 2, 5])

# >>> np.c_[a,b]

# array([[1, 5],

# [2, 2],

# [3, 5]])

# >>> np.c_[a,[0,0,0],b]

# array([[1, 0, 5],

# [2, 0, 2],

# [3, 0, 5]])

z = logistic.predict(np.c_[xx.ravel(), yy.ravel()])# ravel与flatten类似,多维数据转一维。flatten不会改变原始数据,ravel会改变原始数据

z = z.reshape(xx.shape)

# 等高线图

cs = plt.contourf(xx, yy, z)

# 样本散点图

plt.scatter(x_data[:, 0], x_data[:, 1], c=y_data)

plt.show()

print('score:',logistic.score(x_data,y_data))

# ###################################################################################################################################

# 定义多项式回归,degree的值可以调节多项式的特征

poly_reg = PolynomialFeatures(degree=5)

# 特征处理

x_poly = poly_reg.fit_transform(x_data)

# 定义逻辑回归模型

logistic = linear_model.LogisticRegression()

# 训练模型

logistic.fit(x_poly, y_data)

# 获取数据值所在的范围

x_min, x_max = x_data[:, 0].min() - 1, x_data[:, 0].max() + 1

y_min, y_max = x_data[:, 1].min() - 1, x_data[:, 1].max() + 1

# 生成网格矩阵

xx, yy = np.meshgrid(np.arange(x_min, x_max, 0.02),

np.arange(y_min, y_max, 0.02))

# np.r_按row来组合array,

# np.c_按colunm来组合array

# >>> a = np.array([1,2,3])

# >>> b = np.array([5,2,5])

# >>> np.r_[a,b]

# array([1, 2, 3, 5, 2, 5])

# >>> np.c_[a,b]

# array([[1, 5],

# [2, 2],

# [3, 5]])

# >>> np.c_[a,[0,0,0],b]

# array([[1, 0, 5],

# [2, 0, 2],

# [3, 0, 5]])

z = logistic.predict(poly_reg.fit_transform(np.c_[xx.ravel(), yy.ravel()]))# ravel与flatten类似,多维数据转一维。flatten不会改变原始数据,ravel会改变原始数据

z = z.reshape(xx.shape)

# 等高线图

cs = plt.contourf(xx, yy, z)

# 样本散点图

plt.scatter(x_data[:, 0], x_data[:, 1], c=y_data)

plt.show()

print('score:',logistic.score(x_poly,y_data))

4. LR总结

4.1 LR优缺点

| 优点 | 模型简单,解释性好 |

| 训练快,资源消耗小,易调整 | |

| 常用作Baseline | |

| 缺点 | 准确率不高 |

| 不适用数据不平衡的问题,因为区分度不好 | |

| 不适用大规模数据集,否则易过拟合 |

4.2 逻辑回归 VS 线性回归

Logistic Regression=逻辑回归 Linear Regression=线性回归

| 不同 | 逻辑回归处理分类问题,线性回归处理回归问题 |

| 逻辑回归变量没有要求,线性回归要求变量相互独立 | |

| 逻辑回归是离散变量,线性回归是连续变量 | |

| 相同 | 都使用了极大似然估计对训练样本进行建模 |

| 都可以使用梯度下降法训练参数 |

总结:

由于LR逻辑回归模型的简单高效,易于实现调整,常常用做baseline模型。

目前来看,LR模型是推荐系统、广告预估的三大基础模型之一,另外2个是GBDT、FM。

参考文献:LR逻辑回归模型的原理、公式推导、Python实现和应用

【机器学习】逻辑回归(非常详细)

逻辑回归原理小结

【机器学习】逻辑回归

逻辑回归(logistics regression)原理-让你彻底读懂逻辑回归