多模态知识图谱构建系统论文笔记

总结

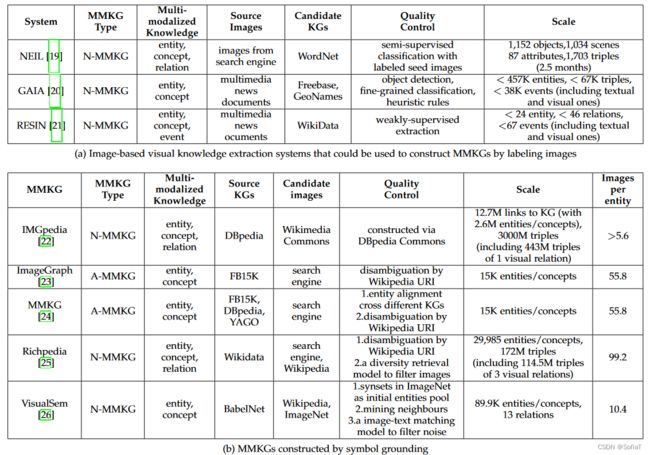

从数据来源,构建系统可以分类两大类:

1. 信息抽取:直接从原始材料中提取实体,比如Gaia、Neil。

2. 信息融合:根据已有的知识库进行融合,比如VisualSem。

可以参考下图,第一类列名有Source Images和Candidate KGs,把互联网上的原始图片抽取metions,然后链接到知识图谱中。第二类有Source KGs和Candidate images,把知识图谱库的entities链接上对应的image、

GAIA: A Fine-grained Multimedia Knowledge Extraction System

这篇论文,可以看到和多模态知识图谱RESIN是同个实验室出品。

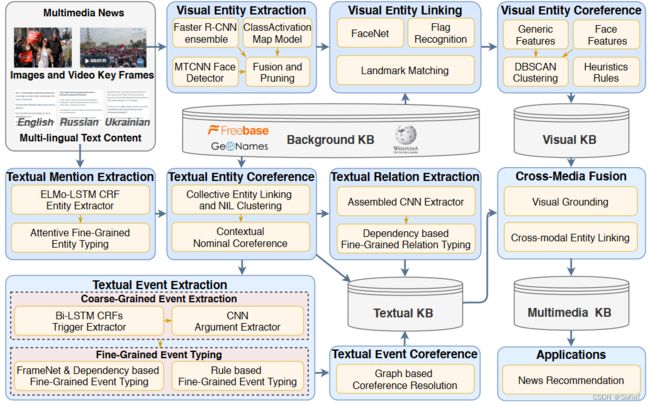

本文主要关注于从新闻中进行知识图谱构建,亮点在于多模态和多语言。读完后发现构建技术比较复杂和成熟,用到了该实验室多个前期工作成果。

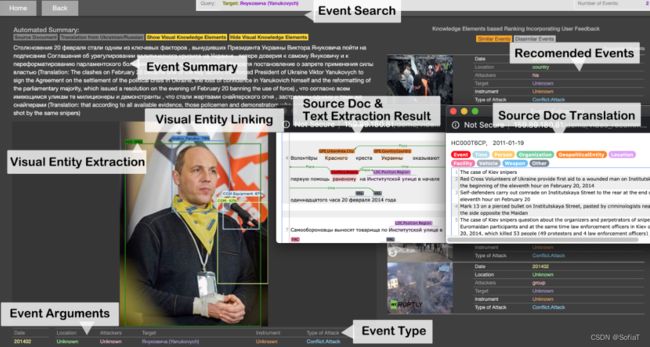

下图是在线演示网站的具体示例:

主要是KG构建(分两个方面)和知识融合。

3. Text Knowledge Extraction(TKE system)

专业词汇:

* co-reference resolution 共指消解(用不同的单词表达同一个实体,需要把它们合并)

* Pronominal co-reference resolution 代词共指消解(如she-June、he-jack)

* Nominal co-reference resolution 名词共指消解(如 the scientist-Albert Einstein)

分为三部分:实体提取和共指消解;关系提取;事件提取。这里基本用到了很多他们实验室自己的方法。

4. Visual Knowledge Extraction(VKE system)

作者团队在自然语言处理上做了比较多的工作,这部分多采用他人的图像处理上的工作。

0. 其他知识

更丰富的本体和提取细粒度的类型对场景理解和事件的预测很重要。例如根据常识,推断不同类型的战争事件,往往后续事件也不相同。

两个输出知识库使用相同的类型的本体(文本信息和图像信息相对应),并且数据来源也一样,所以可以做两个知识库的数据融合。

代码:提供了git仓库,需要docker运行。

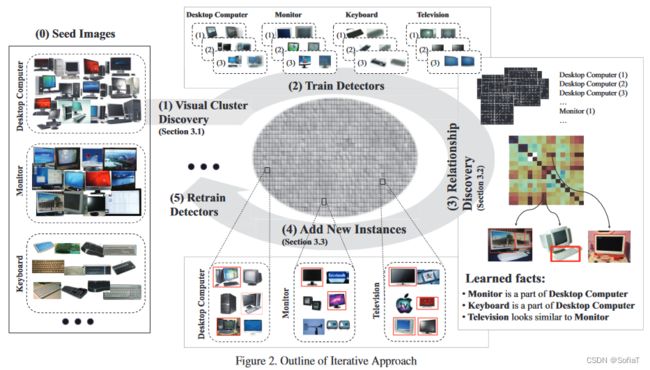

Neil知识图谱构建过程

所做工作:

(a) 从语义上理解网络上的图像;

(b) 使用这种语义理解通过新的标记实例和常识关系来扩充其知识库;

(c) 使用这个数据集和这些关系来构建更好的分类器和检测器,这反过来又有助于提高语义理解。

提出思想:

多数据集不需要理解每个图像的所有部分,而是理解一小部分数据,并从中统计抽取(这里主要指的是它对关系relation进行了抽取,这个工作后来的paper一般是通过人工定义的,上面列举的两个表里的Multi-modalized Knowledge基本也很少有relation)

具体细节:这部分看的不是很懂,仅做参考

1. 从google找图片喂给ELDA分类器聚类

2. 分割图片的pattern,得到label

3. 提取各个图片pattern对应的关系(预定义了一些关系)

这篇文章比较老了,后来作者又提出了一个新的KRISP系统。作者主要侧重做图像方面的工作。

代码:提供了git仓库,但是只包含前半部分处理工作。

VisualSem知识图谱构建过程

贡献

- 提供训练后的模型

- 提供训练思路

- 提供训练代码

这篇文章比较简单,主要就是用已有的方法(Word2Vector、VGG、Transformer)做特征提取、特征融合,以及一些数据清洗工作。数据来源是有拱开Api的babel,主要是获取与 ILSVRC 图像分类中使用的 1, 000 个 ImageNet 类对应的同义词集https://babelnet.org。

细节

edge graph consisting of 89, 896 unique nodes and 1, 481, 007 facts, facts为三元组,nodes为实体。默认构建中有13种关系[引用自2018年的work General knowledge embedded image representation learning.]

1. 从babel接口爬ImageNet的图像集名词的neighbors。

2. 从babel接口爬neighbors的图像。

2.1 删去hash重复图像、非摄影图像、与文本语义不一致的图像

3. 删去图像过少的neighbors

代码:提供了git仓库。

参考文献

《Multi-Modal Knowledge Graph Construction and Application: A Survey》Zhu Xiangru et.

《GAIA: A Fine-grained Multimedia Knowledge Extraction System》 Li Manling et.

《NEIL: Extracting Visual Knowledge from Web Data》 Chen Xinlei et.

《VisualSem: a high-quality knowledge graph for vision and language》 Alberts Houda et.