深度学习-使用CNN分类MNIST数据集

参考莫烦大神的视频,视频中没有讲最后的动画演示,他github中有,但是一是数据太大笔记本一运行就卡,二是绘制那部分代码看不懂,所以我删掉了,只是简单运行显示下正确率。

import torch

import torch.nn as nn

import torchvision

import torch.utils.data as Data

import matplotlib.pyplot as plt

"""超参数"""

LR = 0.001 # 学习率

BATCH_SIZE = 50 # 每批的训练个数

EPOCH = 1 # 对这些数据训练几次

DOWNLOAD_MNIST = False # 运行时是否下载(第一次运行写True,后边都改为False)

"""下载图片并处理"""

train_data = torchvision.datasets.MNIST( # 去官网下载训练数据

root='./mnist', # 保存位置

train=True, # 设置为训练数据

transform=torchvision.transforms.ToTensor(), # 下载的数据改为tensor的格式,该图片为灰度图片,只有一个通道,是二维的,转换后将数据点由(0,255)压缩为(0,1)

download=DOWNLOAD_MNIST # 运行时是否下载

)

train_loader = Data.DataLoader(dataset=train_data, batch_size=BATCH_SIZE, shuffle=True) # 数据加载器

test_data = torchvision.datasets.MNIST(root='./mnist/', train=False) # 去官网下载测试数据

test_x = torch.unsqueeze(test_data.data, dim=1).type(torch.FloatTensor)[

:2000] / 255 # torch.unsqueeze()这个函数主要是对数据维度进行扩充,给指定位置加上维数为一的维度, (2000, 28, 28) 转换为 (2000, 1, 28, 28), 值为(0,1)

test_y = test_data.targets[:2000] # 截取前两千个测试

"""设置卷积神经网络"""

class CNN(nn.Module):

def __init__(self):

super(CNN, self).__init__()

self.conv1 = nn.Sequential( # 第一个卷积神经网络,输入形状(1,28,28)

nn.Conv2d( # 卷积层,通过过滤器提取特征

in_channels=1, # 图片有几个通道(灰度图片1通道,彩色图片3通道)

out_channels=16, # 过滤器的个数

kernel_size=5, # 过滤器的宽和高都是5个像素点

stride=1, # 每次移动的像素点的个数(步子大小)

padding=2, # 在图片周围添加0的层数,stride=1时,padding=(kernel_size-1)/2

), # 输出形状 (16, 28, 28)

nn.ReLU(), # 激活函数

nn.MaxPool2d(kernel_size=2), # 池化层,压缩特征,一般采用Max方式,kernel_size=2代表在2*2的特征区间内去除最大的),输出形状为(16,14,14)

)

self.conv2 = nn.Sequential( # 第二个卷积神经网络,输入形状(16, 14, 14)

nn.Conv2d(16, 32, 5, 1, 2), # 输出形状(32, 14, 14)

nn.ReLU(), # 激活函数

nn.MaxPool2d(2), # 池化层,输出形状 (32, 7, 7)

)

self.out = nn.Linear(32 * 7 * 7, 10) # 展成二维的张量,10个分类

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x) # 形状为(50,32,7,7)

x = x.view(x.size(0), -1) # 行数为一批数据的个数,列数-1代表不知道多少列的情况下,根据原来Tensor内容和Tensor的大小自动分配列数,(50, 32 * 7 * 7)

output = self.out(x) # 转换成(50,10)

return output, x

cnn = CNN()

optimizer = torch.optim.Adam(cnn.parameters(), lr=LR) # 使用Adam训练

loss_func = nn.CrossEntropyLoss() # CrossEntropyLoss()用于处理多分类问题

"""训练网络模型"""

plt.ion()

for epoch in range(EPOCH):

for step, (b_x, b_y) in enumerate(train_loader):

output = cnn(b_x)[0] # 得到卷积神经网络的输出

loss = loss_func(output, b_y) # 计算损失

optimizer.zero_grad() # 清空梯度

loss.backward() # 反向传播

optimizer.step() # 以学习效率0.001来优化梯度

if step % 50 == 0: #每50次输出一次

test_output, last_layer = cnn(test_x)

pred_y = torch.max(test_output, 1)[1].data.numpy()

accuracy = float((pred_y == test_y.data.numpy()).astype(int).sum()) / float(test_y.size(0))

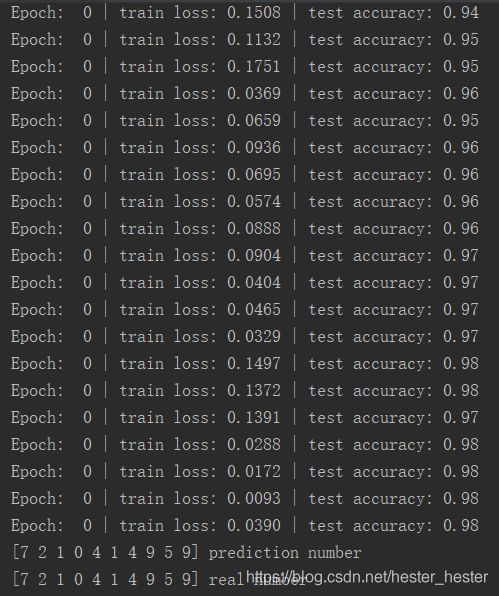

print('Epoch: ', epoch, '| train loss: %.4f' % loss.data.numpy(), '| test accuracy: %.2f' % accuracy)

plt.ioff()

test_output, _ = cnn(test_x[:10]) # 打印前10个的值

pred_y = torch.max(test_output, 1)[1].data.numpy()

print(pred_y, 'prediction number')

print(test_y[:10].numpy(), 'real number')

(因为一般喜欢代码中写详细的注释,就不再单独解释,过于难理解的会另开博客)