图嵌入综述整理(上)

通过近段时间的学习,自己发现无论基于多层图一般方法还是基于随机游走,还是模糊,所以这次查阅了相关资料,其中有包含随机游走的介绍。

1 为什么引入图?

我们身处的世界关系都可以建模为图的结构,用图的节点或节点属性表示真实网络系统中的实体或实体标签,用图中的边表示真实网络中的实体关系。因此,通过图嵌入方法可以提高效率等优势。

2 图的特点

- 海量

- 高维

- 稀疏

- 异构

- 复杂

- 动态

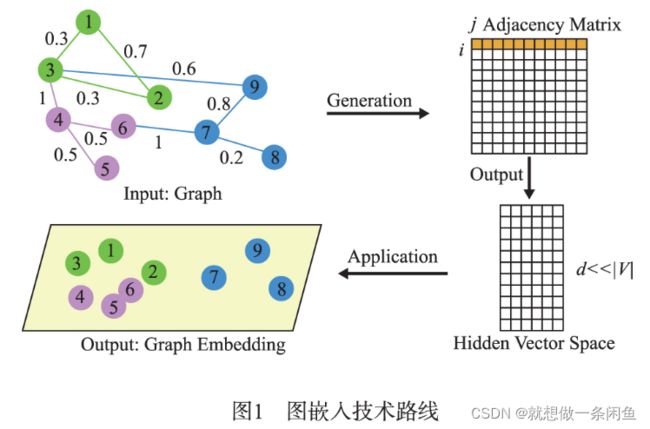

图嵌入是一种图表示学习方法,需要将高维向量映射到低维空间。

3 图嵌入问题及定义

【图嵌入】将图的节点或边映射到一个低维的向量空间,即将海量、高维、异构、复杂和动态的数据表示为 统一、低维、稠密的向量,用以保存图的结构和性质,旨 在实现节点分类与聚类、链接预测、图的重构和可视化 等,提供一种具有更低计算复杂度的方法.

【定义】

定义1(图)图通常表示为 G =(V,E),其中V 表示节点集,E 表示边集。

定义2(静态图)给定图 G =(V,E),如果节点和边的状态不随时间变化,图G 为静态图。

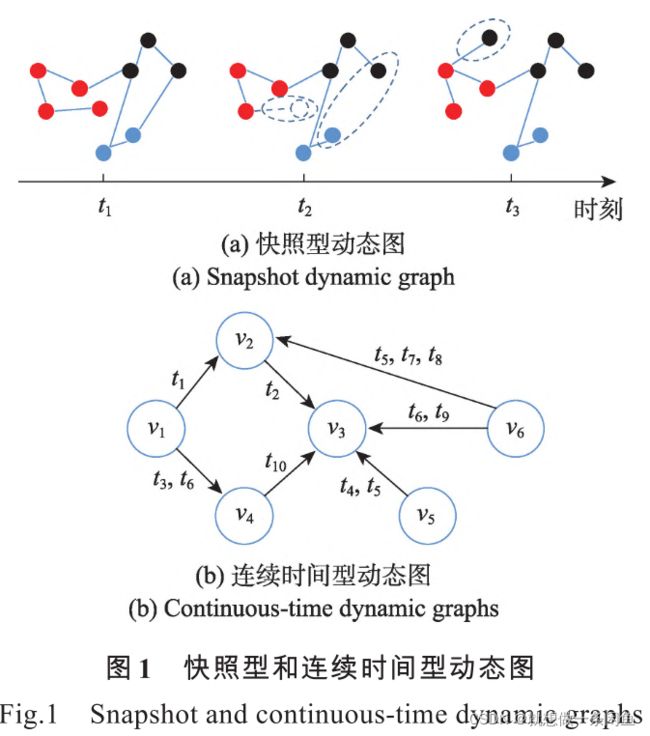

定义3(动态图)动态图可以按时间分成一系列演化图 G =(G1, G2,⋯, GT),T 表示演化图的数量。每个演化图 Gt=(Vt,Et) 表示节点和边在 t 时刻的状态。

动态图包含快照型和连续时间型(见下图所示)。快照型动态图按时间序列将动态图分解为等间隔的静态图;连续时间型用多个时间戳标记每条边来保留节点间的连接变化。

定义4(一阶相似度)一阶相似度描述节点之间的成对邻近度。如果节点 vi 和 vj 的一阶相似度为边权重 wij和 vj 之间存在一条边,vi ;如果在 vi和 vj 之间没有边,一阶相似度为0。

定义5(二阶相似度)二阶相似度描述节点邻域 = [wi1,wi2,⋯,win] 表示节点 vi 和 vj 的二阶相似结构的相似度。假设 wi与其他节点的一阶相似度,那么 vi 度由 wi 和 wj 的相似程度决定。

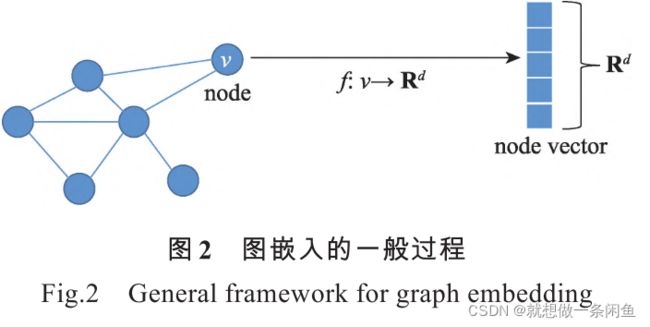

定义6(图嵌入)图嵌入将每个节点映射成低维向量表示(如下图所示),同时保留了原始图中某些关键信 息。映射函数通常定义为 f: vi嵌入向量的维度。

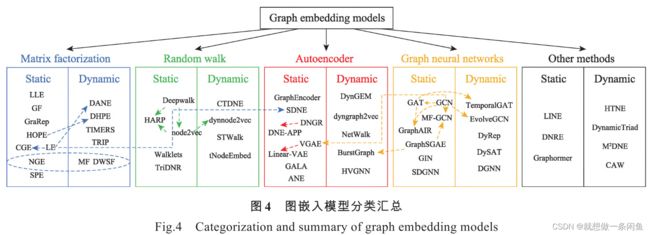

图嵌入内容体系

图嵌入模型分类汇总

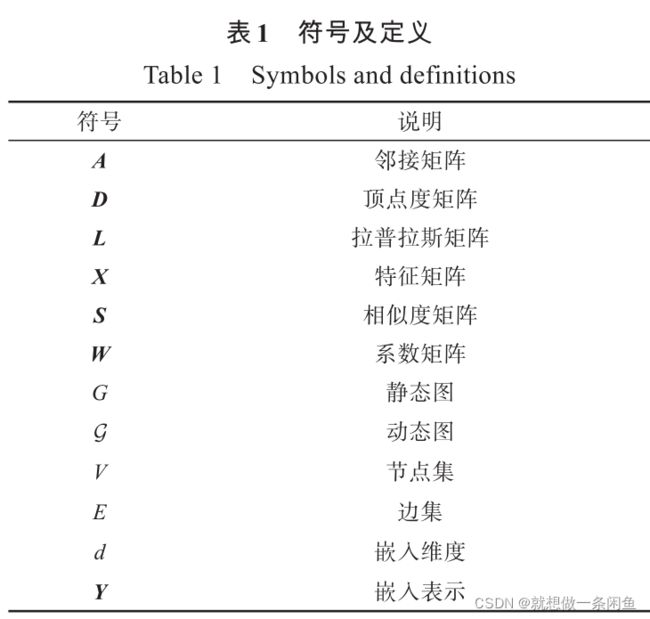

常用符号及定义

4 图嵌入方法

- 基于矩阵分解的图嵌入方法

- 基于随机游走的图嵌入方法

- 基于深度学习的图嵌入方法

//这篇主写随机游走,下篇整理深度学习

4.1 基于随机游走图嵌入方法

通常采用不同的游走策略获取图的局部结构和全局结构,并且生成节点序列,再利用Skip-gram算法完成图中节点的降维嵌入。图的结构分为同构和异构图,因此基于随机游走的图嵌入方法也各有千秋。

4.1.1 同构网络中的随机游走

(1)深度游走( DeepWalk) 是基于 Word2vec 提出的一种图嵌入方法,是语言模型和无监督学习从单词序列到图上的一种扩展,首先随机生成网络中节点的邻居节点、形成定长的随机游走序列,再用 Skip-Gram 模 型对生成的定长节点序列映射成低维嵌入向量.该方法能学习到节点对的关系信息,时间复杂度为 O( log | V| ) ,实现了动态图的增量学习.

【缺点】

- 不适合带权图,只能保持图的二阶相似性;

- 有限的步长会影响上下文信息的完整性;

- 面对大规模的图,调整超参数较复杂,且游走步数超过2^5 后嵌入效果不够显著。

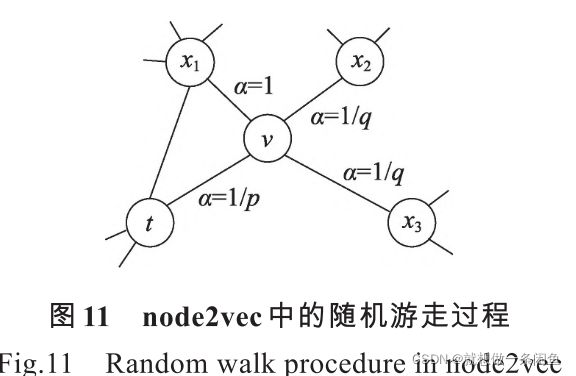

(2) 节点-向量模型(Node2vec)

通过分别调整广度优先游走( Breadth-First Search,BFS) 和 深度优先游走 ( Depth-First Search,DFS ) 策略的参数,来获取图的全局结构和局部结构.

【具体步骤】

- 计算转移概率,结合 BFS 和 DFS 生成随机游走序列,

- 用 Skip-Gram 模型对生成的游走序列进行嵌入.

【优点】每一步都能可并行处理,能保持语义信息和结构信息。

【缺点】对于含有特定属性的节点嵌入效果仍有待提高.

4.1.2 异构网络中的随机游走

元路径-向量模型(Metapath2vec)

采用基于元路径的随机游走策略得到的嵌入效果, 明显优于基于同构网络的随机游走方法在异构网络上的嵌入效果.

【 具体步骤】:

- 对网络中的节点建立元路径,根据节点在元路径中的距离和节点之间的语义关系生成游走序列,

- 对节点序列采用 Skip-Gram 模型实现节点嵌入.

【缺点】该方法在大规模图上的嵌入效果不佳,且不能自动学习有意义的元路径,也不能实现节点嵌入的增量更新.

4.2 基于随机游走的静态图嵌入

基于随机游走的静态图嵌入模型通过随机游走获得训练语料库,然后将语料库集成到Skip-Gram获得节点的低维嵌入表示。

(1)Deepwalk

Deepwalk使用随机游走对节点进行采样,生成节点序列,再通过Skip-Gram最大化节点序列中窗口 w 范围内节点之间的共现概率,将节点 vj 映射为嵌入向量Yj。

公式为:

生成的嵌入Y 将节点之间的关系编码在低维向量空间,用于捕捉邻域相似性和社区结构,学习节点的潜在特征。

【Deepwalk模型优点】Deepwalk不仅在数据量较少时有较好的表现,还可以扩展到大型图的表示学习。

【DeepWalk模型缺点】优化过程中未使用明确的目标函数,使得模型保持网络结构的能力受到限制。

(2)Node2vec

node2vec在Deepwalk的基础上,引入有偏的随机游走,增加邻域搜索的灵活性,生成质量更高、信息更多的嵌入表示。通过设置 p 和 q 两个参数,平衡广度优先搜索(breadth-first sampling,BFS)和深度优先搜索(depth-first sampling,DFS)策略,使生成的嵌入能够保持社区结构等价性或邻域结构等价性。

【优点】node2vec能够保持更多的一阶相似度和二阶相似度信息

【缺点】缺少明确的目标函数来保持全局网络结构。

【Deepwalk & node2vec遇到的问题】

Deepwalk和node2vec采用随机游走探索节点局部邻域,使得学习到的低维表示无法保留图的全局结构,同时使用随机梯度下降求解非凸的目标函数, 使生成的嵌入可能陷入局部最优解。

4.3 基于随机游走的动态图嵌入

基于随机游走的动态图嵌入模型将每条边与对应时刻相关联,使随机游走序列由一系列包含递增时刻的边所连接的节点构成,最后利用Skip-Gram模型将每个节点映射成 d 维向量。

5 参考文献

[1] 袁立宁,李欣,王晓冬,刘钊. 图嵌入模型综述[J].计算机科学与探索,2022,16(01):59-87.

[2] 祁志卫,王笳辉,岳昆,乔少杰,李劲. 图嵌入方法与应用:研究综述[J]. 电子学报,2020,48(04):808-818

[3] GOYAL P,FERRARA E. Graph embedding techniques,applications,and performance: A survey[J]. KnowledgeBased Systems,2018,151: 78 - 94.

[4] CAI H,ZHENG V,CHANG C. A comprehensive survey of graph embedding: problems,techniques and applications [J]. IEEE Transactions on Knowledge and Data Engineering,2018,30 ( 9) : 1616 - 1637.

[5] CUI P,WANG X,PEI J,et al. A survey on network embedding[J]. IEEE Transactions on Knowledge and Data Engineering,2019,31( 5) : 833 - 852.

[6] HAMILTON W,YING R,LESKOVEC J. Representation learning on graphs: methods and applications[J]. IEEE Data Engineering Bulletin,2017,40 ( 1) : 52 - 74.

[7] 涂存超,杨成,刘知远,等. 网络表示学习综述[J]. 中国 科学: 信息科学,2017,47 ( 8) : 980 - 996. TU Cunchao,YANG Cheng,LIU Zhiyuan,et al. Network representation learning: an overview[J]. SCIENTIA SINICA Informationis,2017,47 ( 8) : 980 - 996. ( in Chinese)