【论文翻译】NeurIPS2019 - GTNs: Graph Transformer Networks

文章目录

- 摘要

- 1 引言

- 2 相关工作

- 3 模型

- 3.1 基本定义

- 3.2 元路径生成

-

- 3.2.1 GT层

- 3.2.2 多层堆叠

- 4 实验

- 5 总结

论文链接: Graph Transformer Networks

论文代码: https://github.com/seongjunyun/Graph_Transformer_Networks

相关文章参考: https://blog.csdn.net/byn12345/article/details/104994163

摘要

图神经网络(GNNs)已广泛应用于图的表示学习,并在节点分类和链路预测等任务中取得了最先进的性能。然而,大多数现有的GNNs的设计目的是学习固定和同构图上的节点表示。当在一个错误图上或有各种类型的节点和边组成的异构图上的表示时,这些限制尤其成问题。在本文中,我们提出能够生成新的图结构的图Transformer网络(GTNs),它包括识别原始图上未连接节点之间的有用连接,同时以端到端方式学习新图上的有效节点表示。图Transformer层,GTNs的核心层,它可以选择出边类型和组合关系,以生成有用的多跳连接,即所谓的元路径。我们的实验表明,GTNs学习新的图结构,基于数据和没有领域知识的任务,并通过对新图的卷积产生强大的节点表示。在没有特定领域的图预处理的情况下,GTNs在所有三个基准节点分类任务中取得了最好的性能,而最先进的方法需要从领域知识中预先定义元路径。

1 引言

近年来,图形神经网络(GNNs)已被广泛应用于各种图形上的任务,如图形分类[11,21,40],链接预测[18,30,42]和节点分类[3,14,33]。GNNs学习的表征已经被证明在各种图形数据集上实现最先进的性能是有效的,例如社交网络[7,14,35],引用网络[19,33],大脑的功能结构[20],推荐系统[1,27,39]。底层图结构被神经网络利用,通过将节点特征[12,14]传递给邻居,直接在图上进行卷积,或者使用给定图的傅立叶基,即拉普拉斯算子[9,15,19]的特征函数,在谱域中进行卷积。

然而,大多数gnn的一个限制是,它们假定作用于gnn的图结构是固定且同质的。由于上面讨论的图卷积是由固定的图结构决定的,如果图上有噪声,缺失连边或者有错误的连边,就会导致与图上错误的邻居进行无效的卷积。此外,在某些应用程序中,构造用于操作gnn的图并不简单。例如,一个引文网络有多种类型的节点(如作者、论文、会议)和由它们的关系定义的边(如作者-论文、论文-会议),它被称为异构图。naïve方法是忽略节点/边类型,并将它们视为同构图(具有一种节点和边类型的标准图)。这显然是次优的,因为模型不能利用类型信息。最近的一种补救方法是手动设计元路径,即连接异构边缘的路径,把一个异构图转换成一个通过元路径定义的同构图。然后,传统的GNN可以作用于变换后的同构图[37,43]。这是一个两阶段的方法,需要为每个问题手工制作元路径。这些元路径的选择可以显著影响下游分析的准确性。

在这里,我们开发了图Transformer网络(GTN),它学习将异构输入图转换为每个任务的有用元路径图,并以端到端的方式学习图上的节点表示。GTNs可以被看作是空间变压器网络[16]的图形模拟,后者明确地学习输入图像或特征的空间变换。将异构图转换为元路径定义的新图结构的主要挑战是,元路径可能具有任意的长度和边类型。例如,引文网络中的作者分类可能受益于作者-论文-作者(APA)或作者-论文-会议-论文-作者(APCPA)的元路径。此外,引文网络是有向图,相对较少的图神经网络可以操作。为了解决这些挑战,我们需要一个模型,该模型基于异构图中软选择的边缘类型连接的复合关系生成新的图结构,并通过对已知问题的学习图结构的卷积来学习节点表示。

我们的贡献如下:

- 提出了一种新的图变换网络框架(GTNs),通过识别有用的元路径和多跳连接来学习新的图结构,从而学习图上有效的节点表示。

- 图的生成是可解释的,模型能够提供有效的元路径预测。

- 我们证明了通过图变压器网络学习的节点表示的有效性,与最先进的方法相比,该方法在异构图的所有三个基准节点分类中额外使用了领域知识,从而获得了最佳性能。

2 相关工作

图神经网络 近年来,许多类型的gnn被开发出来用于各种各样的任务。它们被分为两种方法:光谱方法[5,9,15,19,22,38]和非光谱方法[7,12,14,26,29,33]。基于谱图理论,Bruna等人[5]提出了一种利用给定图的傅里叶基在谱域中进行卷积的方法。Kipf等人使用谱图卷积的一阶近似简化了gnn。另一方面,非光谱方法直接在图上定义卷积操作,利用空间上的近邻。例如,V eliˇckovi´c等人[33]对不同程度的节点应用不同的权重矩阵,hamilton等人[14]提出了总结邻居信息的可学习聚合器函数,用于图表示学习。

GNNs中的节点分类 节点分类已经研究了几十年。通常情况下,使用手工制作的特性,如简单的图统计[2]、图内核[34]和从本地邻居结构[23]设计的特性。这些特性不灵活,性能差。为了克服这一缺点,最近在DeepWalk[28]、LINE[32]和node2vec[13]中提出了基于图上随机漫步的节点表示学习方法,该方法采用了深度学习模型(例如skip-gram)的技巧,并在性能上获得了一些改进。然而,这些方法都是完全基于图结构来学习节点表示。表示没有针对特定的任务进行优化。由于cnn在表征学习方面取得了显著的成功,gnn学习到对给定任务和数据的强大表征。为了提高性能或可扩展性,研究了基于谱卷积的广义卷积[4,26]、邻域注意机制[25,33]、分抽样[6,7]和大图[14]的归纳表示。这些方法虽然取得了很好的结果,但都有一个共同的局限性,即只处理一个齐次图。

然而,许多现实世界的问题往往不能用一个单一的同构图来表示。这些图是具有各种类型的节点和边的异构图。由于大多数gnn是为单个齐次图设计的,一个简单的解决方案是两阶段的方法。该算法利用多边缘类型的复合关系元路径作为预处理,将异构图转换为同构图,然后学习表示。元路径2vec[10]通过使用基于元路径的随机漫步学习图表示,而HAN[37]通过将异构图转换为由元路径构造的同构图学习图表示。然而,这些方法由领域专家手动选择元路径,因此可能无法捕获每个问题的所有有意义关系。此外,元路径的选择可能会显著影响性能。与这些方法不同的是,我们的图转换器网络可以在异构图上操作,并为任务转换图,同时以端到端方式学习转换图上的节点表示。

3 模型

GTNs框架的目的是为原始图生成新的图结构,并在新图上进行节点表示学习。

与大多数在给定图上进行CNN的方法不同,GTNs 使用多个候选的邻接矩阵生成新的图结构,以实现更有效的图卷积,学习到表示能力更强的节点嵌入表示。

在介绍我们的框架之前,我们简要地总结一下GCNs中元路径和图卷积的基本概念。

3.1 基本定义

3.2 元路径生成

以前的工作[37,43]需要手动定义元路径,并对元路径图进行图神经网络。相反,我们的图转换器网络(GTN)学习给定数据和任务的元路径,并对学到的元路径图进行图卷积。这提供了一个找到更有用的元路径的机会,并导致使用多个元路径图的各种图形卷积。

先前的工作都是人工定义元路径,然后在其基础上进行GNN。本文提出的GTNs为给定的数据和任务学习到元路径,然后在学习到的元路径图(meta-path graphs)上进行图卷积。

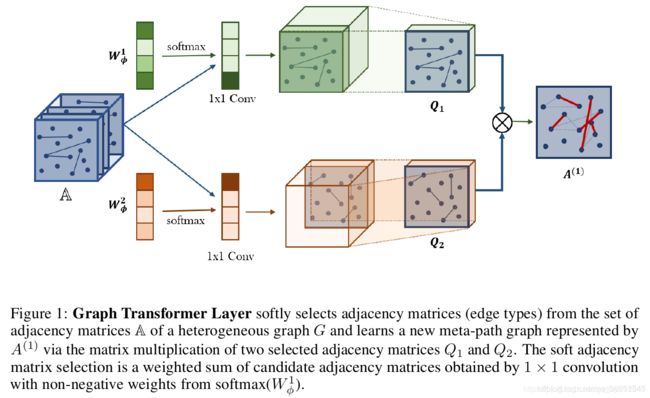

3.2.1 GT层

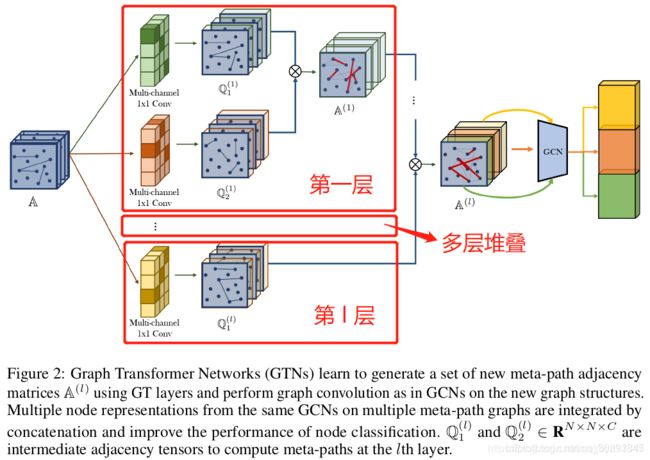

3.2.2 多层堆叠

整个模型架构可以看成是:在由GT层学习到的多个元路径图(meta-path graphs)上进行GCN。

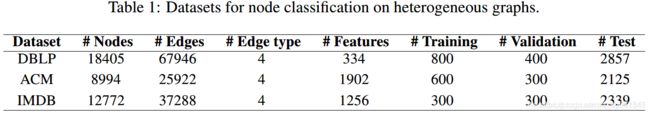

4 实验

实验并分析,回答如下的几个问题:

- GTN生成的新的图结构对节点的表示学习有效吗?

- GTN是否能根据数据集自适应地生成变长的元路径?

- 如何从GTN生成的邻接矩阵来解释每个元路径的重要性?

- Deepwalk

- meta2path

(2)GCN方法:

- GCN

- GAT

- HAN

我们忽略节点/边的异质性,在整个图上进行GCN和GAT测试。

HAN是一种利用人工选择的元路径的图形神经网络。这种方法需要通过用预定义的元路径连接顶点,将原始图手动转换为子图。

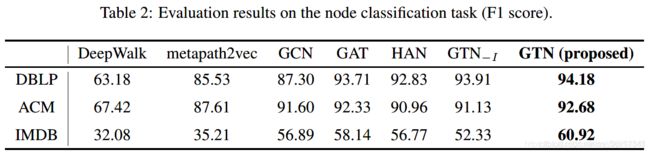

实验结果

(1)节点分类实验结果

其中 G T N − I GTN- _I GTN−I表示候选邻接矩阵 A A A没有包含单位矩阵。实验可以看出,使用3层的GT层,只能为IMDB数据集生成长度为4的元路径,效果很不好,因为IMDB中长度更短的元路径更合适。

(2)解释元路径的重要性

5 总结

本文提出图转换网络(GTNs)用于HIN上的节点表示学习。

将HIN转换为多个由元路径定义的新图,并且元路径中的边类型任意,长度是从1~ l l l的任意长度( l l l为GT层层数)。然后在学习到的元路径图上通过卷积操作,进行节点表示的学习。

GTNs的一大特点是,不需要预先定义元路径,也就是不需要专家的先验知识。GTNs可以为给定的数据集自适应地学习到合适长度的元路径,元路径的重要性体现为注意力分数。

未来的研究方向:

- 本文在GT层之后使用的数GCN方法,后续可以研究使用其他的GNN方法;

- 本文只在节点分类任务上体现出了很好的效果,后续可以研究在其他任务上的效果,例如链接预测、图分类等。