现场指纹识别(Handbook of Fingerprint Recognition第六章)

本文翻译自《Handbook of Fingerprint Recognition》第三版的第六章“Latent Fingerprint Recognition” 。本文会不定期更新,以反映一些新的进展。

1. 引言

现场指纹(或潜指纹,latent fingerprint)是手指触摸物体时产生的痕迹。这种痕迹的质量(包括脊线清晰度、有效指纹面积、皮肤扭曲等方面)是由手指和物体表面之间的相互作用决定的。使用现场指纹识别犯罪嫌疑人由来已久。在自动指纹识别系统(AFIS)出现之前,由于缺乏实用的单指索引技术在大规模档案指纹库中搜索现场指纹,只有在嫌疑人已经被拘留的情况下,指纹鉴定专家才能进行现场指纹识别。随着自动指纹识别系统的出现,没有任何嫌疑人的全库盲搜索才现实可行。今天,现场指纹识别技术是全世界警方最强大的侦察工具之一。仅在2020年,FBI的下一代识别(NGI)系统就收到了来自美国各地近30万个现场指纹识别任务(FBI,2021 年)。

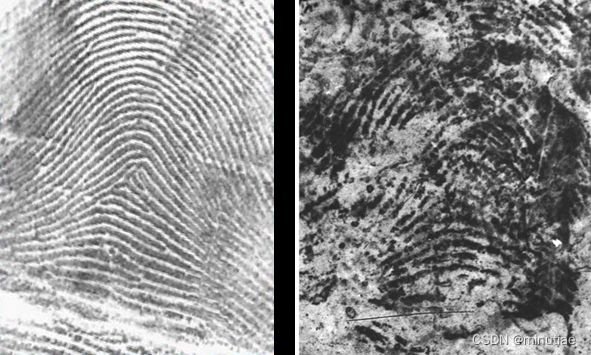

与通过活体指纹采集仪和指纹卡扫描仪获得的指纹相比,现场指纹对AFIS来说非常具有挑战性,这主要是由于三个因素:图像质量差,手指面积小和皮肤变形大。当这些因素同时存在时,现场指纹识别尤其困难。现场指纹识别系统通常是大库识别模式(1:N搜索),这进一步增加了挑战性。下图显示了三个现场指纹及其配对的滚动指纹。

由于上述困难,现场指纹的识别精度远低于平面或滚动指纹。在NIST对滚动和平面指纹识别技术的评测FpVTE 2012(Watson等人,2012)中,要在10万人档案库识别3万个查询指纹(其中1万个在库中),表现最佳的AFIS具有1.9%的假阴性识别率(FNIR)和0.1%的假阳性识别率(FPIR)。对于现场指纹识别技术,最新的评估是NIST ELFT-EFS,其中性能最佳的自动潜在识别系统在包含100,000个示例指纹的背景下搜索1,114个潜在指纹时,排名1识别率最高为67.2%(Indovana等人,2012)。尽管在这两个评测中采用了不同的性能指标,但现场指纹识别与平面/滚动指纹识别之间的准确率差距是显而易见的。实战中为了提高现场指纹的识别率,指纹鉴定专家需要人工标注细节点、奇异点等特征。并且,指纹鉴定专家需要将现场指纹与AFIS返回的候选列表(例如包含档案库中20个最相似的指纹)逐一进行比较,以确定真正的匹配指纹。相比之下,其他场景的自动指纹识别系统通常是在“无人值守”模式下工作的。

随着自动指纹识别系统性能的逐步提高,警方已经意识到可以在一定程度上利用现场指纹的自动处理模式。2008年和2009年,NIST与AFIS企业合作进行了一系列现场指纹技术评测(ELFT)。ELFT第二阶段的结果表明,一些现场指纹可以被全自动的特征提取和匹配技术识别,从而减少现场指纹搜索过程中的一些人力工作量。通常人工标注一个现场指纹的特征需要5到20分钟。通过自动特征提取,指纹鉴定专家可以将节省下来的时间用于更复杂的任务。此外,自动化程度的提高能让警方处理更多的现场指纹,提高破案率。

对自动现场指纹识别的需求激发了许多研究。研究课题包括方向场估计、指纹分割、脊线增强、配准、匹配和质量估计等。虽然特征提取和匹配步骤已在本书的第3章和第4章中介绍,但在这里我们将重新讨论这些主题,并介绍专门为现场指纹设计的方法。尽管这些方法主要针对现场指纹设计,但其中许多方法也适用于平面或滚动指纹。在介绍现场特征提取和匹配算法之前,下面先简要介绍人工现场指纹识别的方法。现场指纹提取技术对于最终的识别性能无疑是很重要的,不过本章不涉及这部分内容。感兴趣的读者可以参考Champod et al. (2017)。

2. 人工现场指纹识别

2.1 ACE-V框架

指纹鉴定专家按照ACE-V(分析、比对、评估、验证)流程进行现场指纹识别。

- 分析:通过考察一幅现场指纹的质量、信息量和罕见程度,专家将其分为三种类型:有识别价值 (VID)、仅有排除价值 (VEO)或无价值 (NV)。对于前两种价值高的现场指纹,专家手动标记其中的指纹特征(如细节点、奇异点等)。

- 比对:将现场指纹与一个或多个档案指纹进行比较,这些档案指纹是从相关人员(例如嫌疑人)那里采集的,或者是通过使用AFIS在大型档案库中搜索该现场指纹而获得的。专家会全面比对所有三个级别的指纹特征。

- 评估:根据比对过程中收集的证据和经验,专家做出认定、排除或不确定的决定。

- 验证:另一名专家独立重复上述过程以减少可能的错误。

ACE-V更像是一种框架,不同文献中关于它的细节并不相同(Champod等人,2017)。实际中并没有一个详细且标准化的、所有专家都严格遵循的ACE-V框架。这种情况类似于市场上存在许多不同的基于细节点匹配的自动指纹识别系统,它们遵循类似的整体方法,但在实现细节和性能方面存在显着差异。

2.2 批评

虽然人们普遍认为,经验丰富的指纹鉴定专家在识别现场指纹方面比AFIS准确得多,但在实际中难免会犯错误(Jain和Feng,2011)。专家可能会犯两种类型的错误:错误排除(假阴性)和错误识别(假阳性)。当现场指纹的匹配指纹在候选名单中,但专家未能识别它时,就发生了错误排除。而当专家将现场指纹识别为其他人的档案指纹时,就发生了错误识别。错误排除的后果是罪犯可能会逃脱。另一方面,错误识别的后果是无辜者被冤枉(同时导致真正的罪犯逃脱)。错误识别通常被认为是严重的错误,而错误排除通常被视为较不重要。Brandon Mayfield在2004年马德里火车爆炸事件中被错误逮捕,主要原因就是几名专家把嫌疑人的现场指纹错误识别为他的指纹(OIG,2006)。Cole(2004)总结了一些错误识别导致的案例。在一项认知实验中,Dror,Charlton和Péron(2006)发现,当给专家提供错误的先验信息时,例如错误地暗示专家某一对指纹是不匹配的,专家会改变自己之前正确的结论。这些事件使人们对于现场指纹作为法庭证据的可靠性产生了疑问。

作为对Mayfield错案的回应,联邦调查局成立了一个委员会评估指纹识别技术的科学基础(Budowle, Buscaglia, and Perlman, 2006)。委员会的结论是,尽管指纹识别总体是科学合理的,但对该方向的进一步研究可以提高人们对识别结果的信心,为人工指纹识别流程标准化提供指导,并为评估专家的表现提供指标。委员会建议了几个优先的研究方向,包括开发指纹识别的统计模型,对专家的表现进行黑盒测试,开发现场指纹的质量指标,以及研究现场指纹的排除能力。

2009年,美国国家研究委员会(NRC)发布了一份报告(NRC,2009),指出了当前法医学(包括指纹识别)的主要问题。有关现场指纹的主要结论总结如下:

- ACE-V框架没有指明具体的测量指标或标准的测试协议,专家必须在整个过程中进行主观评估。

- 同一指纹认定的阈值是主观的,以便专家可以考虑现场指纹中所有特征的数量和质量。

- 不同专家的指纹识别结果未必一致,而且同一个专家也未必能重复自己过去的识别结果。

2.3 研究进展

自NRC报告发布以来,研究者对上述问题进行了广泛研究,包括指纹专家的偏见,专家的准确性和可靠性,现场指纹的质量测量以及指纹的统计建模(Champod,2015)。FBI和Noblis的研究组联合发表了一系列关于这些主题的论文,Hicklin(2017)也汇总介绍了这些研究。指纹的统计建模将在本书第8章中介绍。

Ulery等人(2011)对专家决策的准确性和可重复性进行了研究。可重复性是指专家之间的一致性(两名专家是否对同一现场指纹达成了相同的决定)。共有164名专家参与了这项研究,他们每人比对了100对现场和档案指纹。该测试中的非配对指纹对比随机选择的非配对指纹对要困难得多,因为这些档案指纹是AFIS在5800万人档案库中检索现场指纹而获得的。这么做是考虑到专家在随机选择的非配对指纹对上的假阳性率非常低,因此对随机非配对指纹对的假阳性的可靠估计将需要过多数据(例如数十亿)。该研究的主要发现总结如下:

- 该研究报告的假阳性率为0.1%,假阴性率为7.5%。鉴于假阳性的潜在严重后果,专家往往会做出更多的假阴性决定。

- 第二名专家的独立检查可以检测出所有假阳性和大多数假阴性。

- 大多数假阳性是具有复杂背景的现场指纹。

- 在专家比对的356个现场指纹中(每个现场指纹平均由23名专家比对),仅43%的结论是一致的。

在一项后续研究中,Ulery et al. (2012) 评估了专家结论在间隔 7 个月后的可重复性。本研究的主要发现总结如下:

- 89.1%的同一结论和90.1%的排除结论可重复。

- 假阳性没有重复,而30%的假阴性重复出现。

- 大多数结论改变是变为不确定的结论(占84.6%)。

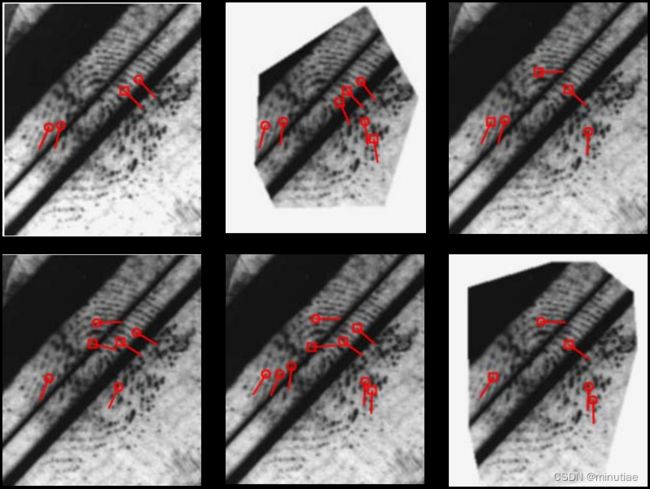

Ulery等人(2016)还研究了现场指纹细节点标注的差异性。他们发现不同专家在细节点标注方面存在很大差异,如下图所示。造成差异的主要因素是图像清晰度。在现场指纹的清晰区域,重现率为82%,而在不清楚的区域中,重现率仅为46%。

一些研究人员建议ACE-V过程应该以线性方式进行,以减少确认偏差。确认偏差是指,人们倾向于寻求和创造新的证据,以验证他们先前存在的信念(Kassin,Dror和Kukucka,2013)。确认偏差被认为是Mayfield案中错误识别的原因之一(OIG,2006)。例如,一些研究表明,在ACE-V过程中,细节点标注在分析和比对阶段之间发生了变化。特别是,Ulery等人(2015)分析了专家在分析和比对之间的标注变化。他们发现:

- 在同一认定的情况下,专家总是添加或删除细节;

- 在不确定和排除的情况下,细节点的变化不太常见;

- 对于在分析过程中分类为有排除价值(VEO)的现场指纹,在和正确的档案指纹比对时,专家通常能做出同一认定。

在另外两项研究(Ulery等人2013和2017)中,作者通过实验研究专家如何评估现场指纹的价值,并分析专家做出排除决定的相关因素。

3. 自动现场指纹识别

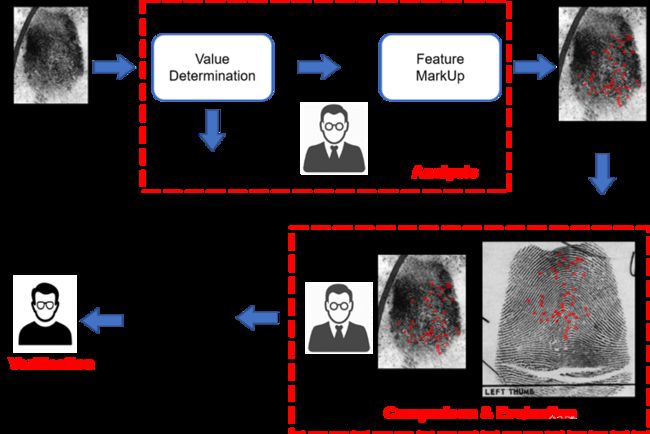

由于现场指纹识别的复杂性和错误的严重后果,现场指纹识别系统既有人工处理,也有自动模块,即它是一种人在回路的混合智能系统。下图显示了典型的现场指纹识别过程。其中,指纹采集、特征提取和最终确认都需要人工干预。这与门禁、手机解锁和支付以及自助通关等应用中使用的指纹识别系统完全不同。在那些场景中,由于应用程序的实时性需要,手动干预既不需要也不负担得起。

上图中人类和计算机系统的相对角色并不是一成不变的。我们预计现场指纹识别技术的演进大致可分为三个阶段。

- 手动特征提取。早期的现场指纹识别系统使用现场指纹中的手动标注特征执行自动比对。这些系统基本上解决了人工现场指纹比对的痛点,即在数百万个档案指纹库中搜索匹配指纹。比对算法主要基于细节点,尽管其他特征(例如方向场、脊线数)可用作辅助特征。比对算法不使用原始现场指纹图像本身。此阶段系统的主要问题是手动标注细节点非常耗时,而且手动标注的细节点与自动指纹识别系统从档案指纹提取的细节点可能不太一致。

- 手动和自动特征提取共存。随着现场指纹特征提取算法性能的提高以及比对算法利用现场指纹图像和多种特征的能力的提高,当前现场指纹比对算法可以成功地为大多数高质量现场指纹找到匹配指纹。例如,当背景库包含10万滚动指纹时,某商用现场指纹识别算法在NIST SD27好指纹集合上实现了92%的rank-1识别率(Cao 等人,2020)。但是,出于两个原因,手动特征标注仍然是必要的。首先,对于低质量的现场指纹,算法的性能并不够好(上面提到的现场指纹识别算法对NIST SD27的差指纹集合只有41%的rank-1识别率)。其次,如ELFT-EFS评测所示,手动标注特征和自动提取特征的融合具有更高的识别率。为了在不牺牲识别率的情况下减少专家的工作量,自动确定现场指纹是否需要人工干预尤为重要。

- 全自动现场指纹识别。随着自动指纹识别系统性能的不断提高,大多数现场指纹可能不需要人工干预。现场指纹识别系统不仅可以生成候选者的短名单,还可以输出与候选指纹相关的置信度,方便专家做出决定。只有在某些特殊情况下,才需要人为干预。例如,如果有多个重叠的现场指纹,其中感兴趣的指纹是未知的;或者如果存在异常的图像变形,需要关于犯罪现场的知识,而这是无法从现场指纹图像中获得的。在此阶段,专家的工作重点将向前端移动,在现场收集尽可能多的指纹以及提高现场指纹的质量。

在上述前两个阶段,现场指纹识别系统是人机混合系统。这类似于医疗诊断和自动驾驶等关键应用中的人工智能技术。由于任务的复杂性和错误决策的后果,人机混合阶段可能会持续很长时间。然而,考虑到现场指纹识别算法性能的快速提升,我们仍然乐观地认为,具有高识别率和高可信度的全自动现场指纹识别技术终将成为现实。

以下两节将介绍近十年发表的现场指纹特征提取和匹配方法。

4. 特征提取

4.1 挑战

现场指纹与活体采集或油墨指纹之间存在一些明显的差异,这使得算法难以从现场指纹中准确提取特征。例如

- 潜在指纹中的高水平噪声使得提取清晰的脊变得困难;

- 潜摩擦脊面积小,前景与背景对比度差,难以提取出精确的分割;

- 由于手指与物体表面之间的压力变化引起的较大的非线性畸变改变了局部定向场的一致性。

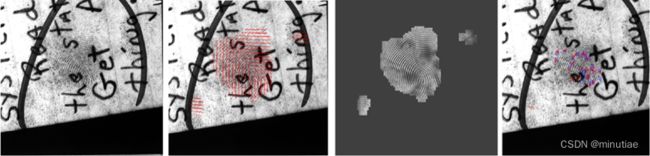

下图显示了使用VeriFinger SDK 12.0从现场指纹(来自NIST SD27)、油墨滚动指纹(来自NIST SD27)和活体采集平面指纹(来自FVC2002 DB1)提取的脊线和细节点。可以看出,由于背景噪声严重且指纹不清晰,该算法很难准确提取现场指纹图像中的特征。它提取了大量虚假的细节点,而且遗漏了一些真实的细节点。显然,基于这种不准确特征进行识别的性能会很差。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-QeTN7OZb-1671323119111)(“点击并拖拽以移动”)]编辑

以下子节按从粗到细的特征级别依次介绍现场指纹特征提取的研究进展。

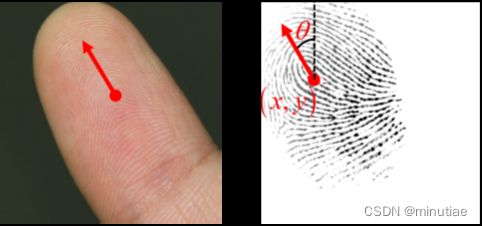

4.2 姿态估计

指纹的姿态由中心点(x,y)和方向θ定义。指纹的中心可以看作是指头几何中心对应的点,而指纹的方向可以看作是手指指向的方向。

指纹姿态显然的应用是指纹匹配和检索。如果可以从现场指纹和相应的滚动指纹中一致地估计出姿态,则有利于指纹匹配的准确性和速度。指纹姿态的另一个应用是,指纹的位置相关先验信息可用于提取方向场。不过,由于现场指纹噪声强、变形严重、且面积很小,很难估计准确的指纹姿态。

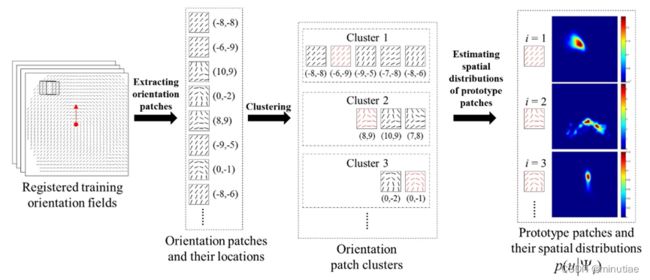

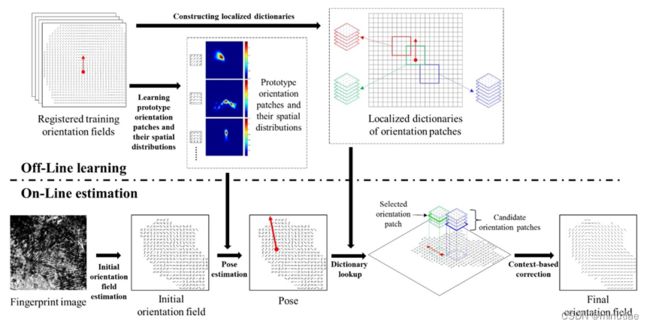

为了解决现场指纹的姿态估计问题,Yang, Feng, and Zhou(2014)研究了指纹不同区域的脊线方向分布,并建立了基于局部特征的统计模型。整个系统由两个阶段组成:在离线阶段,他们学习真实指纹方向块在指纹不同区域的空间分布,然后建立原型方向块的统计模型。在在线阶段,输入指纹的每个块都对指纹中心进行预测。然后将这些预测相加,并选择峰值作为输入指纹的最终姿态。

在离线阶段(流程见下图),作者首先从NIST SD4滚动指纹数据库中选择了398个高质量指纹作为训练集,然后手动标注它们的姿态和方向场。对于每个按照其姿态校正的训练方向场,一个4×4 窗口从上到下和从左到右滑动穿过图像。如果滑动窗口中的所有方向元素都有效,则方向块及其中心的坐标将添加到实际方向块训练集中。采用K中心聚类方法将所有方向块聚类为200个类,200个类中心形成原型方向块。最后,计算每个原型方向块的空间分布。

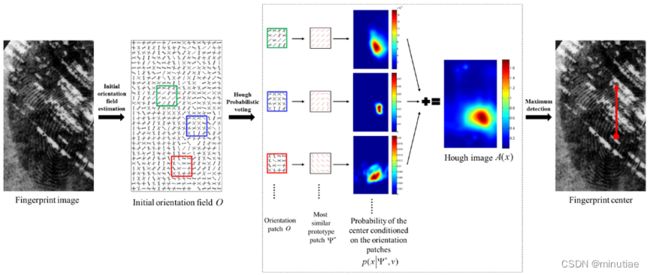

在在线阶段(流程如下图),对于输入指纹,首先通过短时傅里叶变换(STFT)计算初始方向场。然后,一个4×4滑动窗口从上到下和从左到右滑过方向区域。在每个位置,找到最相似的原型方向块,并通过该原型的空间分布获得指纹中心的投票。通过将输入指纹所有位置的投票相加,可以计算出Hough图像,并选择峰值作为指纹中心的估计。

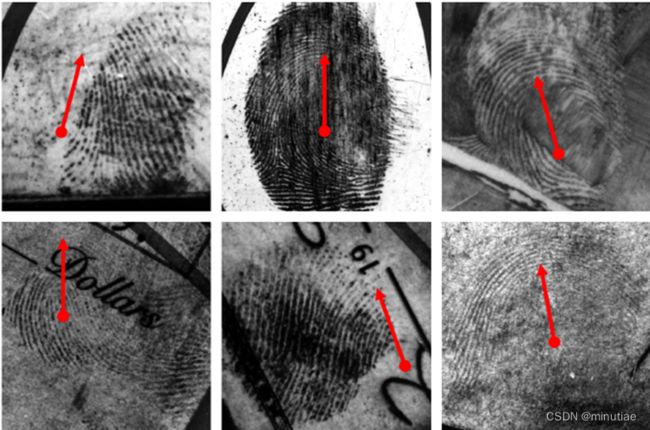

最后,将输入方向场以各种不同的角度旋转,并针对每个角度重复上述步骤以估计中心和相应的置信度值(流程见下图)。各角度最高值对应的中心和角度即最终的姿态。

未知方向的现场指纹的姿态估计。首先初始方向场按一组可能的角度旋转;然后应用指纹中心估计算法来检测每个角度的中心;最后,选择置信度值最大的。(Yang, Feng, and Zhou, 2014)

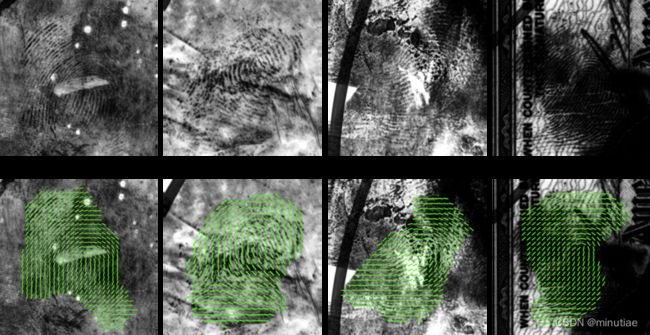

该姿态估计算法的一些实验结果如下图所示。可以看出,尽管一些现场指纹缺少中心区域,该投票算法仍然可以很好地处理这种情况。不过,现场指纹的姿态估计仍然是一个存在挑战的问题。如果要将其用于现场指纹匹配或检索,仍然需要进行大量改进。

4.3 前景分割

现场指纹前景分割是指估计现场指纹图像中的感兴趣指纹区域。准确的分割对于现场指纹特征提取至关重要。在现场指纹图像中,有效感兴趣区域的面积通常有限,而且大多数现场图像包含了大量噪点的背景干扰。如果将整个现场图像输入自动指纹识别系统,会产生大量虚假细节,导致识别性能严重下降。

然而,由于现场指纹的信噪比极低,现场指纹中的脊线结构往往是不完整的。此外,背景中通常存在与脊线图案高度相似的结构,使得传统算法难以有效地将指纹区域与背景区域分开。全变分(Total Variation)和基于深度学习的方法已被证明非常适合现场指纹。这里将详细描述一种基于深度学习的前景分割方法(Nguyen, Cao, and Jain, 2018)。请注意,某些现场指纹特征提取算法可以在提取方向场或细节点时同时输出前景区。这些方法将在后面的部分中介绍。

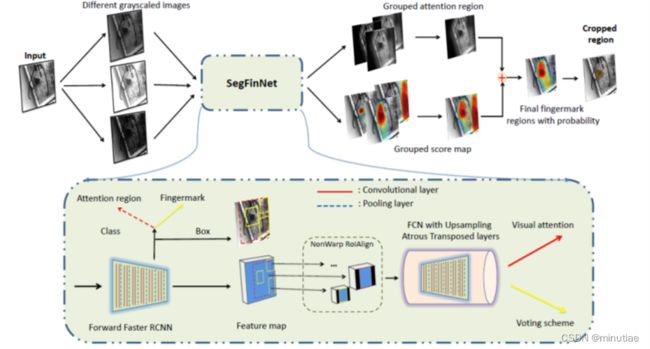

Nguyen, Cao, and Jain (2018)提出了一种简单但有效的现场指纹分割方法,称为SegFinNet。该算法结合了全卷积神经网络和基于检测的方法,可一次性处理整个输入图像,而不是使用滑动窗口处理每个局部图像。

SegFinNet使用Faster R-CNN作为其主干,而其头部层由atrous转置卷积层组成。作者利用Non-warp感兴趣区域技术、指纹注意机制以及融合投票和反馈方案的组合,以利用神经网络的深层信息和指纹领域知识。NonWarp-RoIAlign可将特征图中的感兴趣区域(裁剪区域)映射到原始图像的同时获得精确的分割。视觉注意技术旨在仅关注输入图像中的指纹区域。加权损失反馈方案强调了不同目标函数(前景-背景、边界框等)重要性的差异。在处理不同质量现场指纹图像时,多数投票融合掩膜可提高掩膜的稳定性。

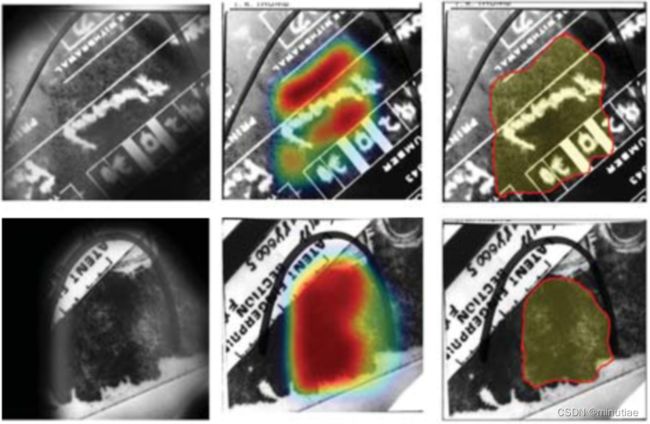

实验是在NIST SD27和WVU现场指纹数据库上进行的。为了评估分割的准确性,作者引入了像素级MDR(缺失检测率)和FDR(错误检测率)指标。SegFinNet比之前其他方法具有更低的MDR和FDR。在NIST SD27和WVU数据库中,MDR分别为2.57%和12.15%,而FDR分别为16.36%和5.30%。下图显示了一些分割示例。作者的实验还表明良好的分割可以提高匹配性能。

4.4 脊线方向估计

方向场提取在指纹的后续处理中起着重要作用。例如,在基于Gabor滤波器的指纹增强中,局部脊线方向是滤波器的两个关键参数之一。如果有精确的方向场,Gabor滤波可以有效增强脊线结构。相反,如果方向场估计不正确,滤波器会错误地改变真实的脊线结构,导致特征不准确,从而严重降低匹配性能。

传统的方向场提取算法使用局部信息估计初始方向场,然后对其进行平滑处理以减少噪声的影响。这些方向场估计方法容易受到现场指纹噪声的严重影响,而无法恢复正确的方向场。近年来的研究表明,利用在早期离线阶段学习到的先验信息,基于学习的估计方法具有更好的抗噪声性能。基于字典的方法能有效纠正错误严重的初始方向场,首先流行起来。其后,基于CNN的技术逐渐流行,取得了更高的性能。接下来,我们主要介绍两个代表性的脊线方向场估计方法:基于局部字典的方法(Yang, Feng, and Zhou, 2014)和基于CNN的方法(Cao and Jain, 2015)。

Yang, Feng, and Zhou(2014)改进了 Feng, Zhou, and Jain(2013)基于全局字典的方法。他们注意到指纹不同区域的脊线方向具有不同的特征(见下图)。考虑到指纹中不同区域方向场的先验知识,他们通过每个区域的统计模型建立了不同的字典。对于输入指纹,先使用4.2节中描述的方法估计其姿态,将指纹对齐到统一坐标系;然后,对于前景区域中的每个初始方向块,检索该位置相应字典中的相似方向块,以获取候选方向块集合。最后使用优化算法来获取最终的方向场。

具体来说,在离线阶段,在指纹坐标系的不同位置构建局部方向块字典。步骤如下:

- 利用姿态估计算法将所有训练方向场对齐到指纹坐标系。在指纹坐标系中,训练方向场所有前景的并集定义为局部字典的有效区域。

- 对于任何位置 u u u,收集所有有效的方向块以构成训练集 T u T_u Tu。

- 对 T u T_u Tu执行K中心聚类,得到位置 u u u处的局部方向块字典 D u D_u Du。

在在线阶段(见下图),首先将指纹图像划分为8×8像素的非重叠图像块,并基于短时傅里叶变换(STFT)方法估计每个图像块的相应方向,得到初始方向场,然后将其按照姿态对齐到指纹坐标系中。对于对齐的初始方向场的每个位置 u u u,从其相应的字典 D u D_u Du中检索相似的候选块。定义如下的能量函数:

E ( r ) = E s ( r ) + ω c E c ( r ) , E(r)=E_s(r)+ω_c E_c(r), E(r)=Es(r)+ωcEc(r),其中, r r r表示各位置候选块的编号; E s ( r ) E_s(r) Es(r)为相似项,表示候选块与初始方向块之间的相似性; E c ( r ) E_c(r) Ec(r)为相容项,表示相邻候选块之间的兼容性;而 ω c ω_c ωc为权重。作者使用循环置信传播算法(loopy belief propagation)最小化该能量函数(Blake, Kohli, and Rother, 2011)。最后,组合使能量 E ( r ) E(r) E(r)最小的候选块,得到方向场估计结果。

下图的四个例子表明,该算法对现场指纹的噪声具有很强的鲁棒性。相比全局字典的方法,局部字典方法避免了许多不合理的方向块。这应该归功于位置相关先验知识的使用。

不过,该算法的一个潜在风险是,它在方向场估计前需要姿态估计,因此姿态估计的错误可能会影响后面的步骤。然而,方向场估计的实验结果表明,不精确姿态对方向场估计的影响有限。下图显示了一个示例,其中错误的姿势估计不会影响方向场的估计。

Yang等人(2015)扩展了上述方法,无需手工分割指纹区域,即可自动检测和分割出指纹,并计算方向场。该方法还可以处理包含多个现场指纹的图像。作者串行使用姿态估计算法检测所有现场指纹;然后,根据局部字典估计每个现场指纹的方向场和置信度图;最后,通过分析置信图来划定每个现场指纹的边界。该方法的流程图如下所示。

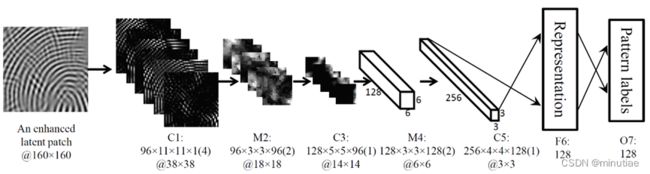

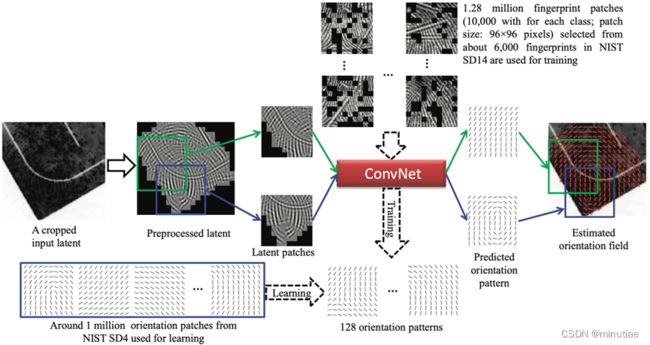

Cao and Jain(2015)将指纹图像块的方向场估计视为分类问题,提出了一种基于卷积神经网络(ConvNet)的现场指纹方向场估计方法。给定从现场图像提取的图像块,它们的方向块由经过训练的ConvNet预测并拼接在一起,以形成整个现场指纹的方向场。

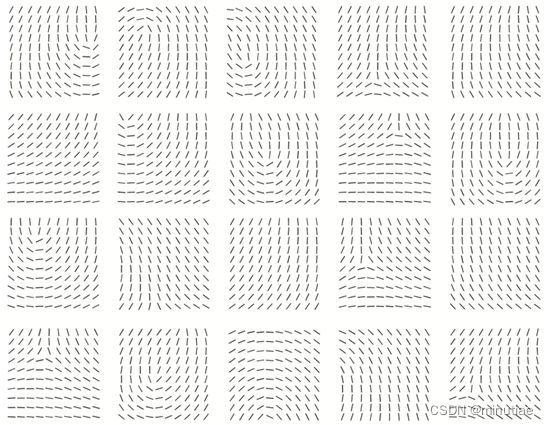

具体来说,首先利用传统算法从NIST SD4数据库中获得块大小为16×16像素的所有方向场。该数据库包含五种指纹类型中每种指纹的约400个滚动指纹。从这些方向场中选择大小为10×10的方向块。然后采用快速K均值聚类方法将这些方向块聚类为128个方向模式(部分见下图)。

从另一个更大的滚动指纹数据库NIST SD14中,选择大量大小为160×160像素的指纹块,通过计算与每个方向模式的方向相似性,将其分配给相应的方向模式。对于每个方向模式,一共收集了1万个指纹块,用于128类ConvNet分类网络的训练(结构如下图)。为了模拟现场指纹,还在这些图像块上叠加线条等噪声,得到更多的训练样本。

给定现场图像,该方法估计方向场的流程如下(见下图):(1)采用预处理步骤去除大尺度背景噪声,增强脊线结构;(2)将预处理的图像划分为重叠的图像块,并将每个块送到训练好的ConvNet以预测其方向模式;(3)将所有预测方向模式拼接在一起,形成整个方向场。

大多数现场指纹方向场估计研究进行了两种类型的评估:方向场估计的准确性和基于估计方向场的增强指纹的识别性能。由于背景数据库和指纹匹配算法的差异,难以公平比较不同研究中的识别性能。不过,方向场估计的准确性是可比的,因为大多数都使用了Feng, Zhou and Jain(2013)中相同的手动标注的方向场作为真值。下表根据 FVC_onGoing FOE指纹方向提取竞赛中采用的均方根偏差 (RMSD) 比较了不同方向场估计算法在NIST SD27数据库上的性能。可以看出,最近的基于深度学习的方法取得了最佳性能。

| Algorithms | All | Good | Bad | Ugly |

| Global Dictionary (Feng, Zhou, and Jain, 2013) | 18.44 | 14.40 | 19.18 | 21.88 |

| Local Dictionary (Yang, Feng, and Zhou, 2014) | 14.35 | 11.15 | 15.15 | 16.85 |

| RidgeDict (Cao, Liu, and Jain, 2014) | 19.53 | 15.34 | 20.70 | 22.68 |

| ConvNet (Cao and Jain, 2015) | 13.51 | 10.76 | 13.94 | 16.00 |

| ExhaustiveSearch (Yin et al., 2018) | 13.01 | 10.85 | 13.99 | 14.27 |

| FPRefNet (Duan et al., 2021) | 12.16 | 9.87 | 12.83 | 13.85 |

4.5 重叠指纹分离

指纹重叠的问题在现场指纹中也很常见。指纹重叠是指在同一位置存在两个或多个指纹,其他指纹会对感兴趣指纹的识别造成不利影响。针对这一问题,一些研究人员提出了自动重叠指纹分离算法,重点是获取每个成分指纹的方向场。

Chen等人(2011)提出了一种方向场估计算法,将重叠的指纹分离成成分指纹。他们首先估计给定图像的初始方向场,该方向场在重叠区域中具有两个方向元素,在非重叠区域中具有一个方向元素。然后,他们使用松弛标记技术将初始方向场分离为成分方向场。该算法的流程如下图所示。他们还提出利用指纹奇点信息进一步提高分离性能。

Zhao and Jain(2012)提高了重叠指纹分离的鲁棒性,特别是对于低质量图像。他们的算法通过使用成分指纹的方向线索(由人工标注)对指纹方向场进行建模来重建成分指纹的方向场。

Feng, Shi, and Zhou(2012)提出了一种用于潜在重叠指纹的方向场估计算法(称为基本算法),其核心是约束松弛标记算法。他们进一步针对两种特殊但常见的情况提出了基本算法的改进版本:1)一个成分指纹的配对模板指纹是已知的,2)两个成分指纹来自同一手指。在这两种情况下,都使用进一步的约束来减少松弛标签中的歧义。

4.6 脊线增强与细节点检测

脊线和细节点是密切相关的特征,因此将它们的提取放在一起讨论。如果方向场是可靠的,则使用Gabor滤波器增强指纹中的脊线是很有效的。如果噪声太强,Gabor滤波可以使用全局平均脊线频率,而不用容易被噪声干扰的局部频率估计。如果脊线得到了正确增强,则可以使用经典的二值化、细化等技术进行细节点检测。

最近,基于深度学习的技术被用于现场指纹增强和细节点提取。这里具体描述两种方法(Tang et al., 2017, Dabouei et al., 2018)。

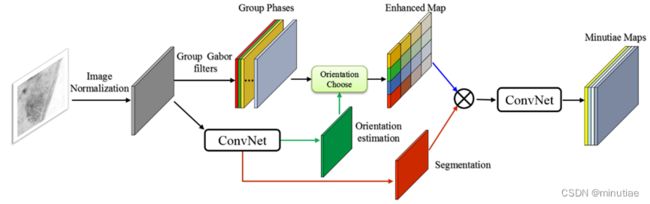

Tang等人(2017)提出结合指纹领域知识和深度学习的表示能力来设计深度卷积网络。首先将传统的指纹处理流程包括方向估计、分割、增强和细节点提取,转换为具有固定权重的卷积网络(如下图所示)。

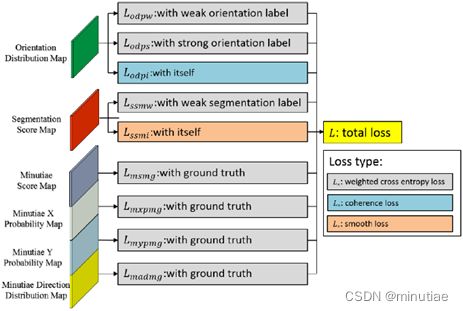

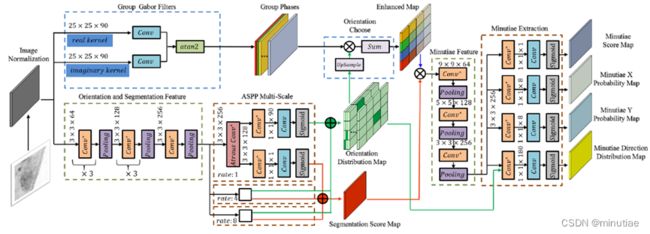

然后扩展为权重可学习的FingerNet网络(下图)以增强其表示能力。FingerNet网络是完全可导的,可以从大量数据中学习网络权重。首先,针对输入指纹图像,采用像素级归一化来固定输入图像的均值和方差。之后的整个网络分为三个部分:方向场估计和分割、增强、以及细节点提取。

方向场和分割模块的骨干是VGG网络,它由几个卷积-BN-pReLU块和最大池化层组成。在基本特征提取后,采用空洞空间金字塔池化(ASPP)层获取多尺度信息。空洞卷积的比例为 1、4 和 8。随后,对各尺度的特征图进行平行方向回归,直接预测每个输入像素90个离散角度的概率,得到方向分布图。并进行分割图回归,以预测每个输入像素为感兴趣区域的概率,得到分割得分图。

Gabor增强直接作为增强模块。其中,脊线频率取固定值,脊线方向离散化为90个离散角,对应于方向分布图。将相位组乘以上采样的方向分布图,即可获得最终的增强指纹图像。具体来说,Gabor滤波器的参数是可设置的,并在训练过程中进行微调。

增强的指纹图像被发送到细节点提取模块。该模块的主干也是VGG网络,后接ASPP层。特征提取后,细节点提取部分输出四种不同的图以满足网络要求。第一幅图是细节点得分图,它表示每个8×8块包含细节点的概率。第二幅和第三幅图是细节点的X/Y概率图,用于通过8个离散位置分类任务进行精确定位。最后一幅图是细节点方向分布图,它表示细节点方向,类似于方向分布图。

每个输出的损失函数如下图所示。由指纹专家标注的细节点被用作真值。由于方向场和分割图没有真值,因此由细节点和匹配的档案指纹分别生成弱标签和强标签。弱方向标签是传统方法提取的对齐档案指纹的方向场。强方向标签是细节点方向。最后,通过扩张细节点集合的凸包得到现场指纹的弱分割标签。

作者在NIST SD27和FVC2004数据库上进行了实验。在NIST SD27上,提取的细节点和真值之间的位置和角度平均误差分别为4.4像素和5.0°。在FVC2004上,位置和角度的平均误差分别为3.4像素和6.4°。下图显示了一个示例,其中包含FingerNet提取的方向场,增强的前景区域和细节点。

此外,作者还进行了识别实验,以测试指纹匹配是否可以受益于FingerNet。结果表明,由于细节点提取得更好,FingerNet的识别率优于其他方法。例如,和VeriFinger细节点提取方法相比,FingerNet的rank-1识别率高出约19%。

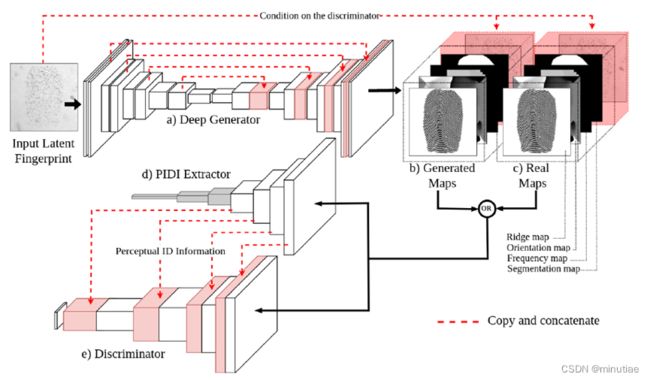

一些研究人员专注于提取现场指纹的脊线。Dabouei等人(2018)提出了一种基于条件生成对抗网络(cGAN)的直接现场指纹重建模型。作者对cGAN进行了两种修改,以使其适应现场指纹重建的任务。首先,强制模型在脊线图上生成三个附加图,以确保在生成过程中考虑方向和频率信息,并防止模型填充大面积缺失区域并产生虚假细节点。其次,开发了一种感知ID保留方法,强制生成器在重构过程中保留ID信息。作者使用合成的现场指纹数据库,训练深度网络预测输入现场图像的缺失信息。

该模型由三个网络组成:生成器、指纹感知ID信息(PIDI)提取器和鉴别器(见下图)。该生成器是一个U-net网络,它获取输入的现场指纹并同时生成脊线、频率图、方向图和分割图。重建误差是生成的各图与其各自真值误差的加权和。在此之后,生成的图与输入的现场指纹连接,为鉴别器提供条件。真值图是从原始的干净指纹中提取的,这些指纹首先被扭曲以模拟现场图像。在训练阶段,这些图用于为鉴别器提供监督。

指纹PIDI提取器是来自深度孪生指纹验证器的一支,该验证器使用对比损失进行训练。它被训练为指纹验证器,以提取生成图的感知ID信息(PIDI)。提取的PIDI是验证器模块前四个卷积层的输出特征图,并连接到判别器的相应层,以强调判别器决策上的ID信息。

鉴别器是一个深度CNN,它将大小为256×256×5的生成器的条件输出映射到大小为16×16×1的判别矩阵。相应的现场指纹连接到生成的或真值图以充当条件。指纹验证器获得的PIDI也会传递给鉴别器。

作者在IIIT-Delhi MOLF数据库上进行了实验。现场与活体指纹匹配的rank-50准确度为70.89%,现场与现场指纹匹配的rank-10准确度为88.02%。此外,使用NFIQ测量重建指纹的质量表明,与原始现场图像相比,生成指纹的质量明显升高。

4.7 质量估计

指纹的质量或价值是对其匹配性能的定量预测(Grother and Tabassi,2007)。如果一个现场指纹的匹配指纹可以在非常大的数据库中被识别为第一名,我们认为这个现场指纹的质量是很高的。虽然指纹图像的质量估计已经在第3章中讨论过,但在这里我们专注于现场指纹质量估计的具体问题。

现场指纹的匹配性能至少取决于三个部分:现场指纹、对应的档案指纹和匹配算法。由于在识别之前无法获得匹配的档案指纹,因此估计现场指纹的质量是一个很棘手的问题。不过通常可以假定档案指纹是高质量的,因为它们是在有人值守模式下采集的。

现场指纹的匹配性能高度依赖于特定的匹配算法(或指纹专家)。这在性能评测中很明显,不同的匹配算法和不同的专家表现出巨大的差异(Indovina, Hicklin, and Kiebuzinski (2011) ; Ulery et al. (2011))。为了实现其在精度预测方面的价值,现场指纹的质量应与特定的匹配算法相关。如果根据匹配算法A,某现场指纹的匹配性能良好,则匹配算法A应该将其视为高质量的。如果匹配算法B的匹配性能较差,则应将同一现场指纹评估为低质量的。在某些情况下,定义与特定匹配算法无关的质量是有益的。例如,融合多个自动指纹识别系统来搜索现场指纹,或者自动指纹识别系统可能会更新,或者从单个专家那里获得许多现场指纹的质量标签是不可靠或不切实际的。

虽然指纹质量可能有多种应用,但更受关注的主要应用是在不牺牲识别性能的情况下提高效率。如果现场指纹的质量非常高,可以采用全自动模式,以节省专家的时间;如果质量太低,可以直接丢弃;而对于中等质量的现场指纹,专家应先手工标注特征再做AFIS检索。

现场指纹的质量过去通常是由专家估计的。但是,这存在一些不足。

- 专家将现场指纹质量仅量化为三个级别:识别价值(VID)、排除价值(VEO)和无价值(NV)。有些人只考虑两个级别(VID 或非VID)。这忽略了现场指纹的质量是一个连续值的事实,使得无法区分相同量化质量的不同现场指纹的匹配性能。当需要连续质量值时,例如基于质量的多匹配算法融合,这也很不方便。

- 专家的质量评估是主观的,差异很大。正如Ulery等人(2011年,2012年)所报告的那样,专家质量评估的可重复性和可再现性并不高。

- 专家的质量评估与自动指纹识别系统的匹配性能不太一致。ELFT-EFS报告指出,被专家评估为VEO或NV的现场指纹的很大一部分,仍然可以通过AFIS成功识别(Indovina,Hicklin and Kiebuzinski,2011)。这并不奇怪,因为(1)专家根据对自身匹配性能的预测而不是自动指纹识别系统的性能来估计指纹质量水平;(2)专家很难预测特定自动指纹识别系统的性能,特别是当专家不熟悉它时。

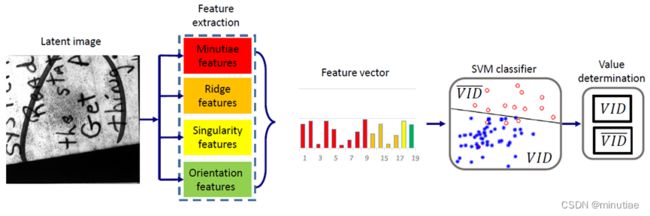

了解指纹专家如何评估现场指纹质量对于开发自动质量评估算法非常重要。根据SWGFAST(2013),专家做价值评估时会考虑特征的质量(观察到的特征的清晰度)、特征的数量(例如,细节点的数量和脊线区域面积)、特征的特异性以及特征之间的相互关系。其中,质量和数量是大多数研究考虑的因素(见下图的示例)。

Yoon, Liu, and Jain(2012)提出了一种现场质量评估方法。他们首先通过特征选择程序以选择两个最佳特征:包围所有细节点的凸包中的平均脊线清晰度 Q R Q_R QR和细节点的数量 N M N_M NM。然后将现场指纹图像质量 L F I Q LFIQ LFIQ定义为 L F I Q = Q R N M LFIQ=Q_R N_M LFIQ=QRNM。对于特征选择,他们提出了一个两类分类问题(VID与非VID),并选择了产生最高分类精度的特征。根据所得分类精度,他们评估了不同脊线清晰度特征和细节点特征组成的特征向量。为了评估质量测量的有效性,作者在NIST SD27和WVU现场数据集进行了识别实验。LFIQ通过拒绝21%被认为质量差的现场指纹,将rank-100识别率从69%提高到80%。然而,按照NFIQ质量指标,只有拒绝数据库中80%的现场指纹(NFIQ=5),才能实现相同的识别率。

Yoon等人(2013)提出的新LFIQ度量考虑了更多因素:(1)高质量脊线区域的全局连通性,(2)由细节点词典估计出的细节点可靠性,以及(3)通过检测参考点得到的手指位置。新的LFIQ指标是根据包含上述三个因素的细节三角测量来定义的。作者使用了手动标注的细节点和自动提取的细节点的组合。识别实验表明,在拒绝率相等的情况下,这种新的LFIQ度量可以取得更高的识别率。

Cao等人(2016)提出的自动现场指纹价值估计方法考虑了细节点的数量、可靠性和紧凑性,脊线质量和方向场,以及中心点和三角点的数量。鉴于VEO和NV标签的现场指纹数量较少,作者仅考虑VID和非VID两类。他们使用SVM分类器将从现场指纹提取的19维特征向量分类为VID或非VID(见下图)。实验表明,这种质量评估方法的性能与Yoon等人(2013)的LFIQ相当,而不需要手动标注特征。

Chugh等人(2018)提出了一个基于众包的框架,用于理解指纹专家做现场指纹价值评估的基础,并使用它来学习质量定量评估算法。实验表明,该方法在预测AFIS识别性能方面优于LFIQ和Cao等人(2016)的方法。

由于公开现场指纹数据集的规模较小,现有的现场指纹质量估计方法通常使用手动设计的特征,并通过经验设计的公式或经过训练的传统分类器/回归器来计算质量分数。大型训练数据集对于学习从现场图像到AFIS匹配性能的复杂映射是必要的。

5. 匹配

5.1 挑战

对于指纹匹配算法,理想的指纹图像应具有较大的指纹面积、高质量的脊线图和较小的皮肤变形。然而,现场指纹的情况常常恰恰相反。这使得现场指纹匹配成为一个非常具有挑战性的问题。下面通过一些统计分析将现场指纹与平面/滚动指纹进行比较。

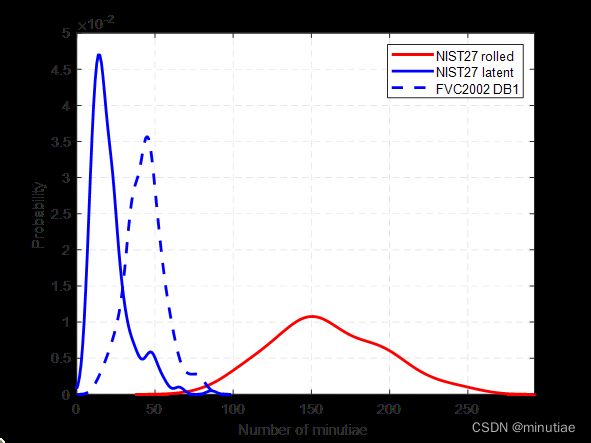

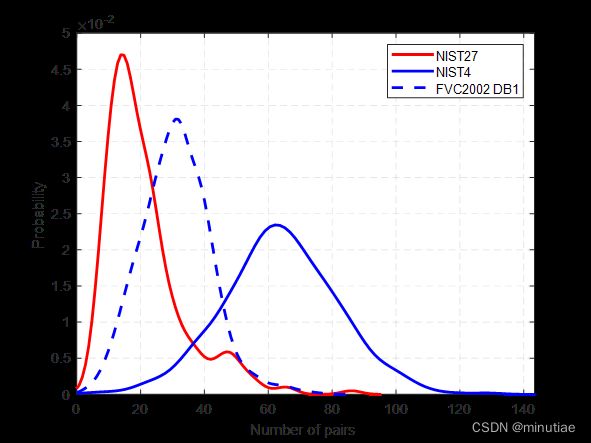

与滚动指纹相比,现场指纹通常具有较小的手指区域。由于面积小,细节点的数量可能非常少,例如≤10。下图显示了三类指纹图像的细节点数量分布,包括NIST SD27数据库中的现场和滚动指纹以及FVC2002 DB1的平面指纹。现场指纹的细节点是手动标注的,而其他两种指纹的细节点是自动提取的。由于现场指纹的细节点数量如此稀少,单细节点包含的识别信息非常有限。

由于存在背景噪声(例如纸上的现场指纹包含许多字符和笔画),特征提取算法可能会遗漏真正的细节点并产生许多虚假的细节点,这进一步降低了细节点描述子(如MCC)的一致性。下图显示了NIST SD27数据库的现场比滚动、NIST SD4数据库的滚动比滚动、以及FVC2002 DB1上的平面比平面中配对细节点数量的分布。细现场指纹的细节点是手动标注的,而其他两种指纹的细节点是自动提取的。细节点匹配算法为MCC描述子结合谱聚类图匹配算法。可以看出,现场比滚动的配对细节点数量远小于其他两种情况。

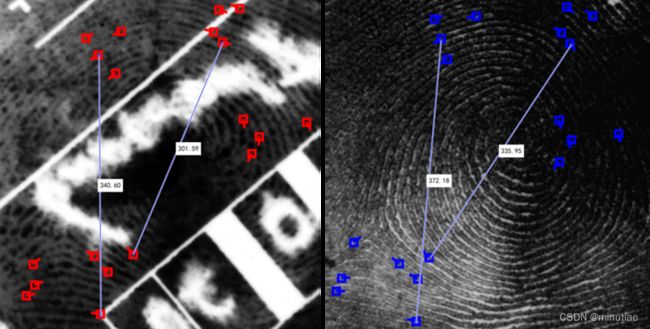

现场指纹可能存在各种扭曲问题(Maceo,2009)。由于人体皮肤固有的弹性、基于接触的指纹采集方法以及侧向力或扭力引入的弹性变形都可能会增加类内差异(同一手指不同指纹图像之间的差异)。这会导致错误的不匹配,因为现有指纹匹配算法识别严重扭曲指纹的能力有限。从下图可以看出,NIST SD27数据库中现场指纹的变形比FVC2002 DB1数据库中平面指纹的变形更严重。做刚性配准后,成对细节点的平均位置误差在NIST SD27数据库上为7.5个像素,而在FVC2002 DB1数据库上为4.2个像素。

下图显示了一对变形较大的现场和滚动指纹。

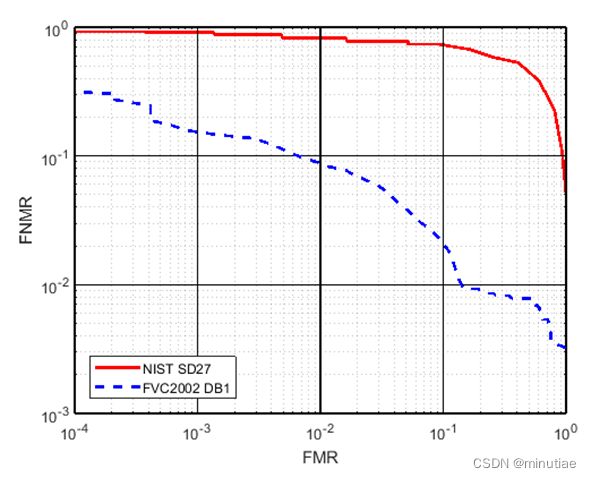

由于现场指纹匹配的上述困难,用于平面/滚动指纹匹配的指纹匹配算法在现场指纹匹配中的表现要差得多。下图显示了NIST SD27和FVC2002 DB1上VeriFinger SDK 12.0的DET曲线。为了提高现场指纹匹配的性能,在设计匹配算法时必须充分考虑上述挑战。

5.2 基于手动特征的现场指纹匹配

由于缺乏针对现场指纹的高性能特征提取算法,早期的现场指纹匹配研究主要使用手动标记的特征(Jain and Feng (2011); Paulino, Feng, and Jain (2012))。

Jain and Feng (2011)提出了一种现场比滚动的匹配算法,该算法利用多个指纹特征,包括1级特征(方向场、周期图、中心点、三角点),2级特征(细节点,细化图),以及质量图。选择多种特征是为了提高指纹模板的表达能力。现场指纹的特征是手动标记的,而滚动指纹的特征是自动提取的,匹配算法也是自动的。作者将NIST SD27中的现场图像与由NIST SD27、SD4和SD14组成的背景数据库进行匹配,获得了74%的rank-1识别率。为了评估每个扩展特征的相对重要性,作者按照标记成本的顺序逐步增加这些特征。实验结果表明,奇异点、质量图和方向场是提高匹配精度最有效的特征。

对齐是现场指纹匹配的第一步,因此对匹配性能至关重要。Paulino, Feng, and Jain (2012)提出了一种基于MCC描述子和广义霍夫变换的对齐方法。MCC描述子之间的分数用作对应变换的投票。作者通过细节点和方向场之间的相似性计算两个对齐指纹之间的匹配分数。

Arora等人(2014)使用滚动指纹作为现场指纹匹配的反馈。经过初步匹配和对齐后,获得匹配分数,并将现场指纹与滚动指纹对齐。然后,根据相应滚动指纹特征的反馈细化现场指纹的特征,并相应地更新反馈特征相似性。最终匹配分数是初始匹配分数和反馈匹配分数的融合。实验表明,使用反馈时的识别准确性显著提高。

Krish等人(2015)应用方向场在两个分层级别中用滚动指纹和现场指纹对齐。在第一级,计算每个旋转参数的现场指纹方向场与滚动指纹的方向场之间的归一化相关性,并将相关峰作为候选配准位置。在第二级中,计算这些候选位置上的多个相似性,并选择相似性最大的候选作为最终对齐位置。通过预配准,减少了细节点的搜索空间,这有助于提高细节点匹配器的性能。

Krish等人(2019)研究了结合罕见的细节点,以提高现场指纹识别的准确性。作者以罕见细节点为参考点,估计现场和滚动细节点集合之间的仿射变换的最小二乘拟合误差。根据拟合误差进一步修改基于细节点匹配器的相似性得分。当应用罕见的细节点来修改三个广泛使用的细节点匹配器的相似性得分时,作者观察到rank识别精度的提高。

Feng, Yoon, and Jain (2009)研究了平面指纹和滚动指纹的融合,以提高现场指纹的匹配性能。作者提出了三个不同层次的多种融合方法,包括排序层、分数层和特征层。实验表明,大多数融合方法都提高了识别性能,而一种考虑变换一致性的分数融合方法提升幅度最大。

5.3 基于自动特征的现场指纹匹配

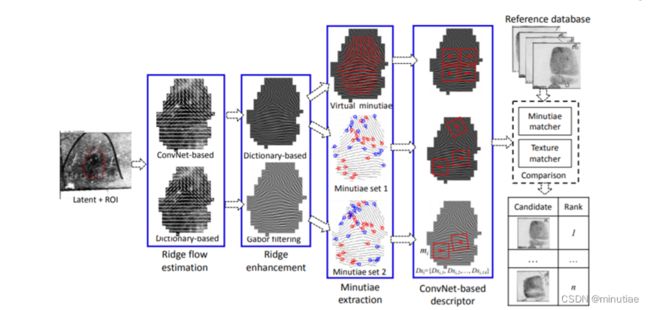

随着现场指纹特征提取技术的发展(特别是基于深度学习的方法),基于自动提取特征的现场指纹匹配成为可能。Cao and Jain (2019)在这个方向上进行了三项创新:基于ConvNet的细节点描述子,多个细节点模板和虚拟细节点。

细节点描述子是细节点匹配的非常重要的组成部分。过去,细节点描述子通常是根据经验设计的。其中,精心设计的描述子(如MCC)在活体指纹和油墨指纹的匹配方面表现相当不错。然而,在现场指纹匹配中,由于缺乏细节点和自动提取细节点的可靠性低,这些描述子的性能会大大降低。Cao and Jain (2019)建议使用ConvNet进行细节点描述子的提取。

该细节点描述子是从不同比例和位置的14个图像块中学习的(如下图所示)。对于从同一细节点提取的每个图像块,训练一个ConvNet以获得特征向量,最后将14个 ConvNet输出的14个特征向量中的一个子集连接成一个细节点描述子。

训练细节点图像是从密歇根州警方指纹数据库中提取的。该数据库包含1311人的十指指纹,每个手指至少有10个滚动指纹。每个不同细节点都被视为一个类,并且仅保留具有8个以上样本的类。在这种情况下,每个ConvNet都被训练为多类分类器。在测试时,每个卷积网的最后一个全连接层的输出被视为输入图像块的特征向量。

考虑到单一特征提取算法对于现场指纹可能不够可靠,作者使用了两种不同的算法进行特征提取。它们基于不同的方向场估计方法(基于卷积网和基于字典)和脊线增强方法(基于字典和基于Gabor滤波)。卷积神经网络使用通过两种特征提取方法获得的局部块提取细节点描述子。此方法的流程见下图。

此外,他们提出了纹理模板的概念,以解决现场指纹面积太小以至于不包含足够数量的细节点(以便与档案指纹进行可靠的比对)或现场指纹质量差以至于细节点提取不可靠的情况。纹理模板包含许多虚拟细节点,每一对虚拟细节点表示现场指纹每个不重叠的局部块(16×16像素)。设 ( x , y ) (x,y) (x,y)和 α \alpha α是块中心的位置和脊线方向。然后虚拟细节点对位于 ( x , y , α ) (x,y,\alpha) (x,y,α)和 ( x , y , α + π ) (x,y,\alpha+\pi) (x,y,α+π)。靠近边界的虚拟细节点需要删除。用于真实细节点的相同细节点描述子算法也用于虚拟细节点。

在比对现场指纹和滚动指纹时,他们首先应用二阶和三阶图匹配算法来建立细节点对应关系。相同的细节点匹配算法也用于纹理模板中的虚拟细节点匹配。现场和档案指纹之间的最终相似性得分为,将两个现场细节点模板与单个档案细节点模板匹配生成的两个相似度得分的加权和,以及通过比对现场和档案纹理模板生成的纹理相似性得分。对于档案指纹,他们仅提取一个细节点模板和纹理模板,是因为与现场指纹相比,档案指纹通常具有更高的质量。

在两个现场数据库NIST SD27和WVU上的实验结果表明,当与两个不同的真实细节点模板融合时,基于虚拟细节点的纹理模板的识别性能使rank-1准确率从58.5%提高到64.7%。

后来,Cao等人(2020)构建了一个全自动的端到端系统,并在Cao and Jain (2019)工作基础上提高了系统的搜索精度和计算效率。Cao and Jain(2019)的工作主要有以下限制:(1)需要手动标记ROI,(2)基于骨架的细节点提取引入了大量虚假的细节点,以及(3)纹理模板过大(1.4MB)使得现场与档案指纹的比对非常缓慢。因此,Cao等人(2020)通过(2)减小模板大小,(2)提高图匹配效率,以及(3)用C++和多线程实现匹配代码,提高了纹理模板的识别精度和搜索速度。

Cao and Jain(2019)的虚拟细节点仍然受到局部脊线方向不稳定估计的影响,而这在现场指纹中很常见。此外,虚拟细节点不是显著特征,无法准确定位。为了克服虚拟细节点的不足,Gu等人(2021)提出了一种基于稠密采样点的现场指纹配准算法。

该算法的流程图如下图所示。对待配准的一对图像,分别在两幅图像指纹区域内均匀采样获得稠密采样点,然后通过局部图像块的对齐和匹配估计两幅图像中采样点对之间的对齐参数和相似度。之后,根据各点对之间相似度得到采样点之间可能存在的对应关系,最后用基于谱聚类的全局匹配方法得到最终结果。

此外,考虑到配准精度和时间复杂度,作者提出了一种由粗到精的配准方案。两阶段的配准流程相同,但精配准以粗配准结果为输入。上图显示的是其中一次配准的流程。在粗配准阶段,采样点之间间隔较大,两个指纹上的所有采样点一一比较以获取候选对应关系。在精配准中,采样点更稠密,但每个采样点只与其相邻采样点进行比较。用这样的方法,粗配准中比对次数更多,但采样点数较少;而精配准中采样点稠密,但每个点所需的匹配次数减少。

作者在现场指纹数据库NIST SD27上进行了配准实验。每对指纹均已知对应细节点对,以配准后的匹配细节点对之间的位置和方向差作为评价指标。其中258对指纹位置和方向偏差的经验累积分布函数如下图所示。对比可见,利用由粗到精的配准方案后,精配准的配准准确率比粗配准能大大提升。在精配准后,超过80%的细节点对之间的距离小于20像素,方向差小于15度。和之前性能最好的现场指纹配准算法相比,该方法性能均更好。

指纹配准的最终目的是提升指纹匹配的性能,作者在NIST SD27进行了匹配实验。将一对输出指纹配准后,计算重叠区域内对应点的局部关键点描述子相似度,并用重叠区域内的所有描述子相似度的均值作为一对指纹的匹配分数。下图显示了匹配结果的CMC曲线。可见该配准算法和之前算法相比大大提升了匹配性能,在NIST SD27数据库上rank-1的识别率从61.6%提升到70.1%。

5.4 性能评测

在公开数据库上对指纹识别算法进行性能评估对于发现新技术的优势和劣势非常重要。目前,NIST SD27是科学论文中用于现场指纹的主要测试数据库,其次是MOLF(Sankaran, Vatsa, and Singh, 2015)和WVU现场指纹数据库。但是,这些数据库的规模很小,仅只有NIST SD27是真正从犯罪现场收集的。不幸的是,NIST SD27与其他著名的NIST指纹数据库一起被下线了。2019年,NIST发布了一个新的多模态指纹数据库SD302,包含了平面、滚动、非接触和现场指纹。一些最新的研究逐渐开始使用该数据库。

NIST对现场指纹识别技术进行了一系列测试,包括现场指纹技术评测(ELFT)和现场指纹技术评测之扩展特征集(ELFT-EFS)。参赛者主要是自动指纹识别系统供应商。

在最新的ELFT-EFS评估2中(Indovina等人,2012),目的是通过比较仅使用图像的识别准确性与使用由专家标记的不同特征集的识别准确性,以评估基于特征匹配的最新技术。该数据集包含来自826名受试者的1066个现场指纹,并由专家进行特征标记。档案库包含来自这826名受试者和近10万名其他受试者的所有十指指纹。

特征包括细节点、脊线数、中心、三角、指纹纹型、脊线质量图、细化图、方向场、皱褶、点、初期脊线、边缘突起和汗孔。除了“优秀”、“好”、“坏”、“丑陋”和“不可用”的主观质量评估外,专家还确定了有识别价值、有排除价值或无价值三种质量等级。大部分现场指纹的特征标记没有参考档案指纹,只有418个现场指纹是例外。这些指纹提供了特征的真值标记,可以算是特征标记的理想上限(但在操作上不可行)。

该评测中的一些主要发现总结如下:

- 对于所有匹配器,纯图像搜索比仅用特征搜索更准确。

- 当手动标注特征与现场图像一起提供时,大多数指纹匹配算法可受益。

- 使用除细节点之外的其他扩展特征可以提高准确性。

- 单个匹配算法在任何现场特征子集(不包括使用真值)上达到的最高识别精度为 71.4%。这表明通过改进算法可以进一步提高精度。各种匹配算法识别现场指纹的差异也表明,通过使用算法融合,可以提高准确性。

- 按照专家的主观质量评估,随着加入较低质量的现场指纹,所有匹配算法的性能都会下降。

- 分析显示,大部分漏识别是细节点数量低的现场指纹,以及被专家评估为质量差的指纹。所有参与者的算法准确性与细节点数量高度相关。

- 真值标注方法(在标注现场特征时参考了档案指纹)与原始标注方法相比,图像+完整扩展特征集(EFS)的识别性能提高了约4-6%,仅细节点搜索的性能提高了约12-15%。虽然这种标注方法在操作场景中显然是不切实际的,但它表明匹配算法的准确性受到特征标注精度的高度影响,特别是在没有图像数据可用的情况下。

但是,该评测没有公布参与评测算法的细节(均为商业算法),数据库也不公开可用。此外,NIST的最新评估是在2012年,并没有反映深度学习技术的最新进展。2020年5月,NIST宣布将启动新一轮现场指纹技术评测(包括掌纹),这应该能反映最新的技术进展。

6. 总结

由于质量差、面积小、变形大等因素,现场指纹识别颇具挑战性。然而,现场指纹识别是一个非常重要的研究课题,不仅因为它在识别嫌疑人方面具有不可替代的作用,还因为对现场指纹的研究可以产生对其他指纹识别问题也有益的技术。

近年来,这一领域取得了很大进展。一个显着的改进是深度学习技术在指纹识别的几个主要步骤中取得了比传统方法更好的性能。尽管取得了这些进展,但使用专家标记的特征进行现场指纹检索仍然是主流。例如,根据2021年6月美国联邦调查局NGI系统的统计数据(FBI,2021),一共有5031次图像搜索(即全自动特征提取)和20166次特征搜索(特征需要专家标注)。为了最终过渡到完全自动模式的现场指纹识别(Meagher and Dvornychenko,2011),显然还需要重大的技术进步。

下面是一些需要改进的方向:

- 公开指纹数据库的缺失是算法研究的一大障碍。目前,深度学习已成为现场指纹识别的主要技术,因此需要大量的样本。NIST SD27对于深度网络训练和测试来说太小了,特别是考虑到现场指纹的高度多样性。此外,该数据库在官方网站上已下线。

- 现场比现场和档案比现场的问题尚未被深入研究。虽然与现场比档案相比没有本质区别,但对这些问题的研究会进一步刺激技术进步。

- 现场指纹识别算法包括几个步骤。独立评估每个步骤是很重要的,这有助于发现问题并开发更好的方法。然而,目前只有方向场估计和指纹区域分割具有独立评估。

- 与特征提取相比,深度学习尚未彻底改变匹配和评分算法。特别是在大多数研究中,不同的匹配算法和评分方法并未与特征提取脱钩,因此难以评估不同的匹配算法和评分方法。

参考文献

Arora et al. (2014). Arora S.S., Liu E., Cao K. and Jain A.K., “Latent fingerprint matching: Performance gain via feedback from exemplar prints,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 36, no. 12, pp. 2452-2465, 2014.

Arora et al. (2015). Arora S. S., Cao K., Jain A.K. and Michaud G., “Crowd powered latent Fingerprint Identification: Fusing AFIS with examiner markups,” in Proc. Int. Conf. on Biometrics, pp. 363-370, 2015.

Blake, Kohli and Rother (2011). Blake A., Kohli P. and Rother C., Markov Random Fields for Vision and Image Processing, MIT Press, Cambridge, MA, USA, 2011.

Budowle, Buscaglia and Perlman (2006). Budowle B., Buscaglia J. and Perlman R.S., “Review of the scientific basis for friction ridge comparisons as a means of identification: Committee findings and recommendations,” Forensic Science Communications, vol. 8, no. 1, 2006.

Cao, Liu and Jain (2014). Cao K., Liu E. and Jain A.K., “Segmentation and enhancement of latent fingerprints: A coarse to fine ridgestructure dictionary,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 36, no. 9, pp. 1847-1859, 2014.

Cao and Jain (2015). Cao K. and Jain A.K., “Latent orientation field estimation via convolutional neural network,” in Proc. Int. Conf. on Biometrics, pp. 349-356, 2015.

Cao et al. (2016). Cao K., Chugh T., Zhou J., Tabassi E. and Jain A.K., “Automatic latent value determination,” in Proc. Int. Conf. on Biometrics, pp. 1-8, 2016.

Cao and Jain (2019). Cao K. and Jain A.K., “Automated latent fingerprint recognition,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 41, no. 4, pp. 788-800, 2019.

Cao et al. (2020). Cao K., Nguyen D.-L., Tymoszek C. and Jain A.K., “End-to-end latent fingerprint search,” IEEE Transactions on Information Forensics and Security, vol. 15, pp. 880-894, 2020.

Champod (2015). Champod C., “Fingerprint identification: Advances since the 2009 National Research Council report,” Philosophical Transactions of the Royal Society B: Biological Sciences, vol. 370, no. 1674, Article ID: 20140259, 2015.

Champod et al. (2017). Champod C., Lennard C.J., Margot P. and Stoilovic M., Fingerprints and Other Ridge Skin Impressions (2nd), CRC Press, Boca Raton, FL, USA, 2017.

Chen et al. (2011). Chen F., Feng J., Jain A.K., Zhou J. and Zhang J., “Separating overlapped fingerprints,” IEEE Transactions on Information Forensics and Security, vol. 6, no. 2, pp. 346-359, 2011.

Chugh, Cao and Jain (2018). Chugh T., Cao K. and Jain A.K., “Fingerprint spoof buster: Use of minutiae-centered patches,” IEEE Transactions on Information Forensics and Security, vol. 13, no. 9, pp. 2190-2202, 2018.

Chugh et al. (2018). Chugh, T., Cao K., Zhou J., Tabassi E. and Jain A.K., “Latent fingerprint value prediction: Crowd-based learning,” IEEE Transactions on Information Forensics and Security, vol. 13, no. 1, pp. 20-34, 2018.

Cole (2004). Cole S.A., “More than zero: Accounting for error in latent fingerprint identification,” Journal of Criminal Law & Criminology, vol. 95, pp. 985, 2004.

Dabouei et al. (2018). Dabouei A., Kazemi H., Iranmanesh S.M., Dawson J. and Nasrabadi N.M., “ID preserving generative adversarial network for partial latent fingerprint reconstruction,” in Proc. Int. Conf. on Biometrics Theory, Application and Systems, pp. 1-10, 2018.

Dror, Charlton and Péron (2006). Dror I.E., Charlton D. and Péron A.E., “Contextual information renders experts vulnerable to making erroneous identifications,” Forensic Science International, vol. 156, no. 1, pp. 74-78, 2006.

Duan et al. (2021). Duan Y., Feng J., Lu J. and Zhou J., “Orientation Field Estimation for Latent Fingerprints with Prior Knowledge of Fingerprint Pattern,” in Proc. Int. Joint. Conf. on Biometrics, pp. 1-8, 2021.

FBI (2021). FBI Biometric Services Section, “June 2021 Next Generation Identification (NGI) System Fact Sheet,” available at: https://www.fbi.gov/file-repository/ngi-monthly-fact-sheet (accessed July 2021).

Feng, Shi and Zhou (2012). Feng J., Shi Y. and Zhou J., “Robust and efficient algorithms for separating latent overlapped fingerprints,” IEEE Transactions on Information Forensics and Security, vol. 7, no. 5, pp. 1498-1510, 2012.

Feng, Yoon and Jain (2009). Feng J., Yoon S. and Jain A.K., “Latent fingerprint matching: Fusion of rolled and plain fingerprints,” in Proc. Int. Conf. on Biometrics, pp. 695-704, 2009.

Feng, Zhou and Jain (2013). Feng J., Zhou J. and Jain A.K., “Orientation field estimation for latent fingerprint enhancement,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 35, no. 4, pp. 925-940, 2013.

Gische (2012). Gische M.R., “Recent trends in fingerprint evidence,” Texas Forensic Science Seminar, 2012, available at: http://www.txcourts.gov/All_Archived_Documents/ccaInformation/tcjiu/ppt/Gische-9.pptx (accessed July 2021)

Grother and Tabassi (2007). Grother P. and Tabassi E., “Performance of biometric quality measures,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 29, no. 4, pp. 531-543, 2007.

Hicklin (2017). Hicklin A., “Improving the rigor of the latent print examination process,” Ph.D. thesis, University of Lausanne, 2017.

Gu et al. (2021). Gu S., Feng J., Lu J. and Zhou J., “Latent fingerprint registration via matching densely sampled points,” IEEE Transactions on Information Forensics and Security, vol. 16, pp. 1231-1244, 2021.

Indovina et al. (2012). Indovina M.D., Dvornychenko V., Hicklin R.A. and Kiebuzinski G.I., “NIST evaluation of latent fingerprint technologies: Extended feature sets [Evaluation# 2],” NIST-IR 7859, 2012.

Indovina, Hicklin and Kiebuzinski (2011). Indovina M.D., Hicklin R.A. and Kiebuzinski G.I., “NIST evaluation of latent fingerprint technologies: Extended feature sets [Evaluation# 1],” NIST-IR 7775, 2011.

Jain and Feng (2011). Jain A.K. and Feng J., “Latent fingerprint matching,” IEEE Transactions on Pattern Analysis Machine Intelligence, vol. 33, no. 1, pp. 88-100, 2011.

Kassin, Dror and Kukucka (2013). Kassin S.M., Dror I.E. and Kukucka J., “The forensic confirmation bias: Problems, perspectives, and proposed solutions,” Journal of Applied Research in Memory and Cognition, vol. 2, no. 1, pp. 42-52, 2013.

Krish et al. (2015). Krish R. P., Fierrez J., Ramos D., Ortega-Garcia J. and Bigun J., “Pre-registration of latent fingerprints based on orientation field,” IET Biometrics, vol. 4, no. 2, pp. 42-52, 2015.

Krish et al. (2019). Krish R. P., Fierrez J., Ramos D., Alonso-Fernandez F. and Bigun J., “Improving automated latent fingerprint identification using extended minutia types,” Information Fusion, vol. 50, pp. 9-19, 2019.

Maceo (2009). Maceo A.V., “Qualitative assessment of skin deformation: a pilot study,” Journal of Forensic Identification, vol. 59, no. 4, pp. 390-440, 2009.

Meagher and Dvornychenko (2011). Meagher S. and Dvornychenko V., “Defining AFIS latent print ‘lights-out’,” NIST-IR 7811, 2011.

Nguyen, Cao and Jain (2018). Nguyen D.-L., Cao K. and Jain A.K., “Automatic latent fingerprint segmentation,” in Porc. Int. Conf. on Biometrics Theory, Applications and Systems, pp. 1-9, 2018.

NRC (2009). National Research Council, “Strengthening forensic science in the United States: A path forward,” National Academies Press, 2009.

OIG (2006). Office of the Inspector General, “A Review of the FBI’s Handling of the Brandon Mayfield Case,” 2006.

Paulino, Feng and Jain (2012). Paulino A.A., Feng J. and Jain A.K., “Latent fingerprint matching using descriptor-based hough transform,” IEEE Transactions on Information Forensics and Security, vol. 8, no. 1, pp. 31-45, 2012.

Sankaran, Vatsa and Singh (2015). Sankaran A., Vatsa M. and Singh R., “Multisensor optical and latent fingerprint database,” IEEE Access, vol. 3, pp. 653–665, 2015.

SWGFAST (2013). SWGFAST, “Standards for examining friction ridge impressions and resulting conclusions (latent/tenprint) v2.0,” http://clpex.com/swgfast/documents/examinations-conclusions/130427_Examinations-Conclusions_2.0.pdf, 2013. (accessed July 2021)

Tang et al. (2017). Tang Y., Gao F., Feng J. and Liu Y., “FingerNet: An unified deep network for fingerprint minutiae extraction,” in Proc. Int. Joint Conf. on Biometrics, pp. 108-116, 2017.

Turroni et al. (2011). Turroni F., Maltoni D., Cappelli R. and Maio D., “Improving Fingerprint Orientation Extraction,” IEEE Transactions on Information Forensics and Security, vol. 6, no. 3, pp. 1002-1013, 2011.

Ulery et al. (2011). Ulery B.T., Hicklin R.A., Buscaglia J. and Roberts M.A., “Accuracy and reliability of forensic latent fingerprint decisions,” Proceedings of the National Academy of Sciences, vol. 108, no. 19, pp. 7733-7738, 2011.

Ulery et al. (2012). Ulery B. T., Hicklin R. A., Buscaglia J. and Roberts M.A., “Repeatability and reproducibility of decisions by latent fingerprint examiners,” PloS one, vol. 7, no. 3, pp. e32800, 2012.

Ulery et al. (2013). Ulery B.T., Hicklin R.A., Kiebuzinski G.I., Roberts M.A. and Buscaglia J., “Understanding the sufficiency of information for latent fingerprint value determinations,” Forensic Science International, vol. 230, no. 1-3, pp. 99-106, 2013.

Ulery et al. (2015). Ulery B.T., Hicklin R.A., Roberts M.A. and Buscaglia J., “Changes in latent fingerprint examiners’ markup between analysis and comparison,” Forensic Science International, vol. 247, pp. 54-61, 2015.

Ulery et al. (2016). Ulery B.T., Hicklin R.A., Roberts M.A. and Buscaglia J., “Interexaminer variation of minutia markup on latent fingerprints,” Forensic Science International, vol. 264, pp. 89-99, 2016.

Ulery et al. (2017). Ulery B.T., Hicklin R.A., Roberts M.A. and Buscaglia J., “Factors associated with latent fingerprint exclusion determinations,” Forensic Science International, vol. 275, pp. 65-75, 2017.

Watson et al. (2012). Watson C.I., Fiumara G., Tabassi E., Cheng S.L., Flanagan P. and Salamon W., “Fingerprint vendor technology evaluation,” NIST-IR 8034, 2012.

Watson et al. (2007). Watson C.I., Garris M.D., Tabassi E., Wilson C.L., McCabe R.M., Janet S. and Ko K., “User’s guide to NIST biometric image software (NBIS),” NIST-IR 7392, 2007.

Yang, Feng and Zhou (2014). Yang X., Feng J. and Zhou J., “Localized dictionaries based orientation field estimation for latent fingerprints,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 36, no. 5, pp. 955-969, 2014.

Yang et al. (2015). Yang X., Feng J., Zhou J. and Xia S., “Detection and segmentation of latent fingerprints,” in International Workshop on Information Forensics and Security, pp. 1-6, 2015.

Yin et al. (2018). Yin Q., Feng J., Lu J. and Zhou J., “Orientation Field Estimation for Latent Fingerprints by Exhaustive Search of Large Database,” in Proc. Int. Conf. on Biometrics: Theory, Applications and Systems (BTAS), pp. 1-9, 2018.

Yoon et al. (2013). Yoon S., Cao K., Liu E. and Jain A.K., “LFIQ: Latent fingerprint image quality,” in Proc. Int. Conf. on Biometrics Theory, Applications and Systems, pp. 1-8, 2013.

Yoon, Liu and Jain (2012). Yoon S., Liu E. and Jain A.K., “On latent fingerprint image quality,” in Proc. International Workshop on Computational Forensics, pp. 67-82, 2012.

Zhao and Jain (2012). Zhao Q. and Jain A.K., “Model based separation of overlapping latent fingerprints,” IEEE Transactions on Information Forensics and Security, vol. 7, no. 3, pp. 904-918, 2012.