牛顿法和高斯牛顿法对比

文章目录

- 一、非线性最小二乘

- 一、牛顿法

- 二、高斯牛顿法

- 三、列文伯格-马夸尔特法(LM)

- 四、ceres求解优化问题

一、非线性最小二乘

考虑最小二乘函数F(x), 其等于:

通过求F(x)导数为零,获得x的最优值

求解这个非线性最小二乘的方法可以是牛顿法、高斯牛顿法、梯度下降法、列文伯格-马夸尔特法等

一、牛顿法

用目标函数的二阶泰勒展开近似该目标函数,通过求解这个二次函数的极小值来求解凸优化的搜索方向。

1、将F(x)在xk处进行泰勒展开,即:

此时,状态的更新式子为:

![]()

即此时求解的式子变为:

![]()

其中J为雅可比矩阵,即一阶导数矩阵

H为黑塞矩阵

通过求解上面线性方程,得到增量,叫牛顿法。

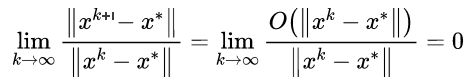

2、牛顿法具有超线性收敛性质,证明如下:

令

![]()

当获得最优值时,令导数为零,即

即

等式左右分别乘以

即

即

![]()

当

![]()

可得:

证毕

二、高斯牛顿法

高斯牛顿和牛顿法的区别在于牛顿法是对目标函数F二次偏导的迭代;高斯牛顿是分解目标函数F为f’*f后对f的一次偏导的迭代。

即此时不对F(x)展开,而是对f(x)展开,即

![]()

![]()

将上式变形为下面式子

![]()

可见和牛顿法获得了相同的等式形式。

但是此时H使用J^T * J近似;g = -J^T * f(x)

g函数是F(x)的一阶导数的转置,可见高斯牛顿和牛顿法的联系与区别

高斯牛顿方法虽然使用了雅可比矩阵乘积近似黑塞矩阵计算,但是雅可比矩阵乘积为奇异矩阵,此时会出现算法不收敛问题。

三、列文伯格-马夸尔特法(LM)

高斯牛顿法具有奇异性,即其可以在展开值附近有较好的优化结果,适合用于无约束优化。

LM针对高斯牛顿法的奇异性,增加了拉格朗日因子,保证了等式左边即HX始终正定。

此时优化问题变为

上式子的补充说明:

其中后面增加的那项就是通过拉格朗日乘子法,增加的拉格朗日因子约束。

拉格朗日乘子法是求优化函数f(x1,x2,x3,…,xn)在g(x1,x2,…xn)的约束条件下的极值方法。主要的思想是引入一个新的微小参数(拉格朗日乘子),将约束条件函数和原函数联系起来,使能配成与状态量数目相等的等式方程,保证等式的正定性。for an example:

对于优化函数f(x1,x2,x3,…,xn)的约束条件为A(x1,x2,x3,…,xn) = B;

设g(x1,x2,x3,…,xn)=B-A(x1,x2,x3,…,xn)

此时最小二乘优化函数变为

![]()

此时

![]()

变为

![]()

为简化计算,通常将D设为单位阵

其中H后面增加项(阻尼因子)会影响优化问题的梯度下降速度(收敛速度)。

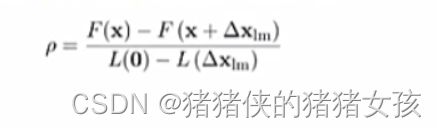

如果阻尼因子较大,下降速度加快,如果阻尼因子减少,下降速度变慢。为了更好地选择这个阻尼因子,LM算法引入了比例因子,即:

其中比例因子分母始终大于0,如果:

比例因子小于0,那么表示F(X)递增,此时与我们设计思路违背,即不符。

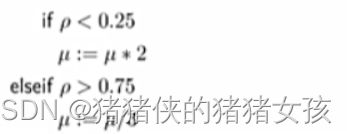

马夸尔特设置了一个阻尼因子策略如下:

四、ceres求解优化问题

这里面的ceres::Solver::Options设置了非线性优化的求解器的以下设置,可以选择高斯牛顿或者LM等求解方法

//

// Created by xiang on 18-11-19.

//

#include