【异构图->精读】Heterogeneous Graph Attention Network

HAN

Abstract

graph neural network没有考虑异构图。

异构图:在图里,节点的类型+边的类型>2。

异构性和丰富的语义信息给异构图的图神经网络设计带来了极大的挑战。

本文提出:heterogeneous graph neural network based on the hierarchical attention, including node-level and semantic-level attentions(基于层次注意力的异构图神经网络,包括节点级和语义级注意力)

具体来说,节点级注意旨在了解节点与其基于元路径的邻居之间的重要性,而语义级注意能够了解不同元路径的重要性。通过从节点级和语义级关注中学习到的重要性,可以充分考虑节点和元路径的重要性。

然后,该模型可以通过 从元路径的邻居,以分层的方式 聚合特征(aggregating features)。

Keywords

- Social Network

- Neural Network

- Graph Analysis

1 Introduction

Graph neural network(GNN)在图的表示上很强大。

[10,20,24]利用深度神经网络 学习 基于节点特征node features和图形结构graph structure的 节点表示node presentations。

同质图的Attention模型,Graph Attention Network(GAT)[35]

异构信息网络heterogeneous information network(HIN)[28] = heterogeneous graph 异构图。具有多种类型的节点和边。它有更全面的信息和丰富的语义。

meta-path 元路径[32],连接两个对象的composite relation,是一种广泛用于捕获语义的结构。

以图1a为例,包含3种类型节点,movie,actor,director。2部电影的关系可以通过元路径揭示,元路径比如Movie-Actor-Movie(同一个演员)、Movie-Director-Movie(同一个导演)。

可以看出,根据元路径的不同,异构图中节点之间的关系可以具有不同的语义。

由于异构图的复杂性,传统的图神经网络不能直接应用于异构图。

T1. 这里相当于提示了一些模型构建的初衷和注意点:

在为异构图设计具有注意机制的图神经网络体系结构时,我们需要满足以下新的要求:

- Heterogeneity of graph. 图的异质性,不同类型的节点有不同的特征,而且特征可能在不同的特征空间中。另一方面,例子中movie的特征可能涉及到plot(情节)和演员。

- Semantic-level attention. 语义层面的注意力。

- 异构图中不同的元路径可以提取不同的语义信息。如何为特定任务选择最有意义的元路径并融合语义信息是一个尚未解决的问题[4,19,26]。语义级关注旨在了解每个元路径的重要性,并为其分配适当的权重。

- 例子:movie《终结者》可以通过actor或year连接movie《终结者2》或《Birdy》,显然前者的元路径更重要。

- 同等对待不同的元路径是不现实的,会削弱一些有用的元路径提供的语义信息。

- Node-level attention. Node层面的注意力。

- 给定一个元路径,每个节点都有许多基于元路径的邻居。

- 如何区分这些邻居之间的细微差异,并选择一些信息丰富的邻居是必需的。对于每个节点,node-level注意力旨在了解基于元路径的邻居的重要性,并为其分配不同的注意力值。

- 例子:当使用Movie-Director-Movie时,《终结者》将通过导演詹姆斯·卡梅隆连接到《泰坦尼克号》和《终结者2》。为了更好地识别《终结者》作为科幻电影的类型,模型应该更多地关注《终结者2》,而不是《泰坦尼克号》。

- 因此,需要如何设计一个能够发现邻居的细微差异并正确学习其权重的模型。

本文提出了HAN,它同时考虑了node-level and semantic-level attentions.

- use the type-specific transformation matrix to project different types of node features into the same space 使用类型特定的转换矩阵将不同类型的节点特征投影到同一空间中。

- node-level attention: learn the attention values between the nodes and their meta-path based neighbor 学习节点与其基于元路径的邻居之间的注意值

- semantic-level attention: learn the attention values of different meta paths for the specific task in the heterogeneous graph. 学习异构图中特定任务的不同元路径的注意值

2 Related Work

2.1 Graph Neural Network

-

GNN模型在深度网络 应用于处理图结构数据[10, 24]

-

GNN的propagate information[20]

-

图结构数据 使用卷积。图卷积神经工作一般分为两类,即谱域[2] [6] [18]和非谱域[14]。

-

Attention机制,分为self-attention[34]和soft-attention[1]

-

attention应用在图上 做recommendation[15, 16]

-

用于学习节点及其邻居之间的重要性,并融合邻居进行节点分类[35]

上面都只能应用在同质图上。

2.2 Network Embedding

Network embedding = network representation learning(NRL)。旨在将network embed到低维空间中,同时保持network的结构和性质,以便将学习到的embedding应用于downstream network tasks。

例如,基于随机行走的方法[12,23]、基于深度神经网络的方法[36]、基于矩阵分解的方法[22,37]以及其他方法,例如LINE[33]。(在同质图上)

Heterogeneous graph embedding主要关注于保留基于元路径的结构信息。

- ESim[26],user-defined meta-paths作指导,学习顶点的向量,用于similarity search。

- Meta-path2vec[7],只使用一个原路径。

- 与上面类似,HERec[27],提出了一种类型约束策略来过滤节点序列并捕获异构图中反映的复杂语义。

- HIN2Vec[9],执行多个预测训练任务,同时学习节点和元路径的潜在向量

- PME[3],通过欧几里得距离保持节点的邻近性。

- HEER[29],通过edge representations,嵌入异构图

- metagraph2vec[8],最大限度地保留了结构和语义以用于恶意软件检测。

- meta-graph-based network embedding models[30],同时考虑了元图中所有元信息的隐藏关系。

3 Preliminary

- Heterogeneous Graph[31],异构图。表示为 G = ( V , ε ) \mathcal{G} = (\mathcal{V}, \varepsilon) G=(V,ε)(object set,link set)。

- meta-path

- meta-path based neighbors

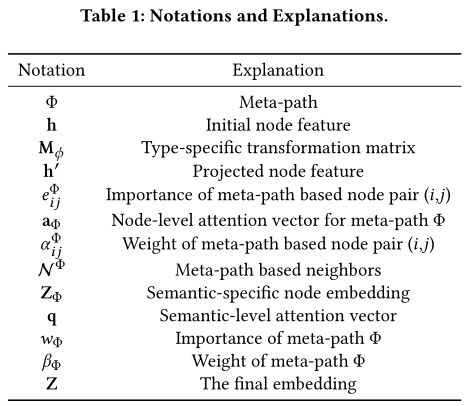

论文符号表:

4 The Proposed Model

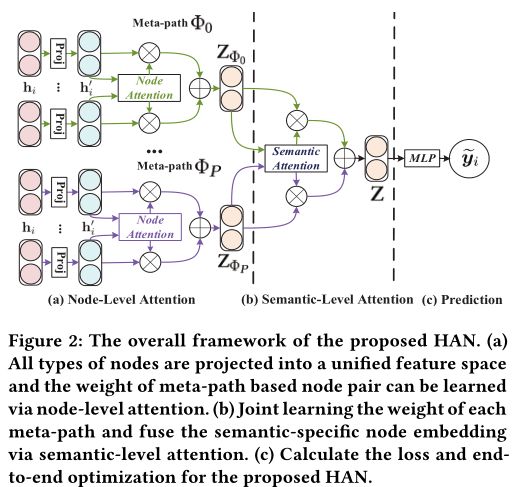

HAN framework

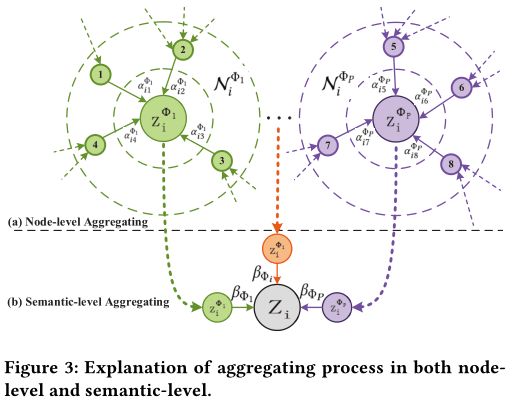

4.1 Node-level Attention

论文这里又复述了T1部分,说明了Node-level Attention的存在意义

由于异构性,不同类型节点有不同特征空间feature spaces。对于每种类型的节点,设计了type-specific transformation matrix M ϕ i M_{\phi_i} Mϕi,以将不同类型节点的特征投影到相同的特征空间中。

与[13]不同,matrix是基于node-type,rather than edge-type。

![]()

h i, h i’分别是original, projected feature of node i。

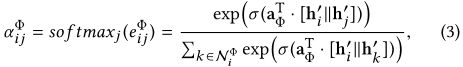

之后,使用self-attention[34]学习各种节点之间的权重。

- 左边 表示node j对node i来说有多重要, Φ \Phi Φ是元路径,ij在元路径上。

- 右边 att node表示 the deep neural network which performs the node-level attention。一条meta path中att node是共享的。

然后,inject the structural information into the model via masked attention。计算 i在元路径 Φ \Phi Φ上的所有邻居 j(复数加s)的 e i j Φ e^{\Phi}_{ij} eijΦ。

之后,normalize,通过softmax获得权重系数 α i j Φ \alpha^{\Phi}_{ij} αijΦ。

a Φ _\Phi Φ是针对meta-path Φ \Phi Φ的node-level attention vector。

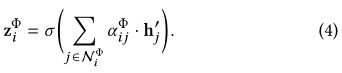

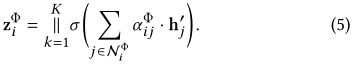

然后,节点i的基于元路径的embedding可以通过neighbor’s projected features与相应系数进行聚合,如下所示:

左边 = node i 学习到的embedding,在元路径 Φ \Phi Φ上。

为了更好地理解aggregating process of node-level,可以看图3a。

- Every node embedding is aggregated by its neighbors.

- the attention weight α i j Φ \alpha^{\Phi}_{ij} αijΦ is generated for single meta-path, it is semantic-specific and able to capture one kind of semantic information.

再多头注意力,重复K次。

输入meta-path set { . . . Φ p ...\Phi_p ...Φp}、node features,就可以获得P组的 semantic-specific node embeddings { . . . Z Φ p ...Z_{\Phi_p} ...ZΦp}。

4.2 Semantic-level Attention

To learn a more comprehensive node embedding, we need to fuse multiple semantics which can be revealed by meta-paths.

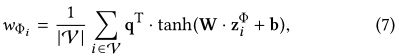

输入:P组 semantic-specific node embeddings learned from node-level attention。每条元路径的学习权重 β \beta β如下所示:

![]()

att sem表示deep neural network which performs the semantic-level attention.

- 首先利用 非线性转换(e.g., one-layer MLP) 转换 semantic-specific embedding。

- 然后 通过transformed embedding和semantic-level attention vector q的相似性,评判semantic-specific embedding的重要性。

- 此外,我们平均所有 semantic-specific node embedding的重要性(可以解释为每个元路径的重要性 w Φ i w_{\Phi_i} wΦi)。

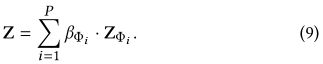

在获得每个元路径的重要性之后,对其softmax进行normalizing。可以获得元路径Φi的权重,表示为βΦi

这可以解释为元路径Φi对特定任务的贡献。显然,βΦi越高,元路径Φi越重要。这些权重 * semantic-specific embeddings = 最终的embedding Z:

如图3(b)所示,final embedding = all semantic-specific embedding的聚合。然后根据特定任务,设计不同的loss function。针对半监督节点分类,使用Cross-Entropy:

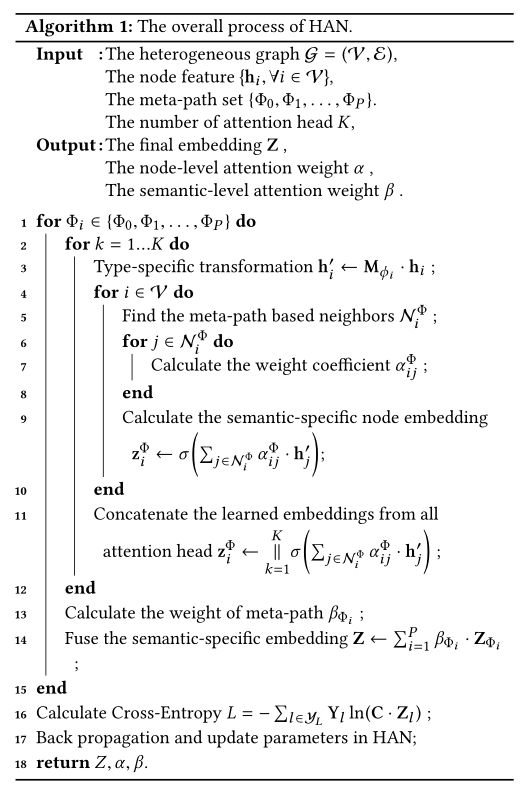

HAN的整个过程如Algorithm 1所示。(很清晰)

4.3 Analysis of the Proposed Model

HAN有以下优点:

- 异构图有丰富的语义

- 容易并行化,时间复杂度低

- 对整个异构图的分层关注是共享的,这意味着参数的数量不依赖于异构图的规模,可以用于归纳问题[14]。

- 该模型对学习节点嵌入具有潜在的良好解释性,这是异构图分析的一大优势。通过学习节点和元路径的重要性,该模型可以更加关注特定任务的一些有意义的节点或元路径,并对异构图进行更全面的描述。

5 Experiments

5.2 Baselines

- DeepWalk[23],随机游走的网络embedding方法,用于同构图

- ESim[26],用于异构图embedding

- metapath2vec[7],异构图embedding。它执行基于元路径的随机遍历,并利用skipgram嵌入异构图。只考虑一个元路径。

- HERec[27],异构图embedding

- GCN[18],为同质图设计的半监督图卷积网络。

- GAT[35],半监督神经网络,考虑了异构图上的注意机制。

6 Conclusion

- HAN可以捕获异构图背后的复杂结构和丰富语义。

- leverages node-level attention and semantic-level attention to learn the importance of nodes and meta-paths, respectively.(利用节点级注意和语义级注意分别学习节点和元路径的重要性。)

- utilizes the structural information and the feature information in a uniform way(统一利用了结构信息和特征信息)

我的疑问/总结

有些复杂的论文还是自己慢慢看一遍好理解。