【2021.07】datawhale组队学习李宏毅task03

文章目录

- 误差的来源

- 估测bias和variance

-

- 估测

- 估测x的偏差和方差

-

- 评估x的偏差

- 估测x的方差

- 多个f

-

- 不同模型的方差

- 不同模型的偏差

- 偏差v.s.方差

-

- 误差来自方差还是偏差?

-

- 偏差大-欠拟合

- 方差大-过拟合

- 模型选择

-

- 交叉验证

- N-fold cross validation

- gradient descent

-

- adaptive learning rate

- Adagrad 是什么?

-

- Adagrad举例

- 多参数下结论不一定成立

- 进一步的解释

- 随机梯度下降法

- 特征归一化

- warning of math

-

- 泰勒展开式

- 梯度下降的限制

-

- Gradient Descent (Demo by AOE)

- Gradient Descent (Demo by Minecraft)

误差的来源

上一次课我们用误差来衡量模型的好坏,同时从测试集数据来看,average error 随着模型复杂度的提高而呈指数上升的趋势,因此更复杂的模型并不能给测试集带来更好的效果。

了解error 的来源是很重要的,我们可以针对它挑选适当的方法来 improve 自己的 model ,从而提高准确性。

error 的来源主要有 bias 和 variance 。

然而 bias 和 variance 是什么?可以查看 机器学习中的 Bias(偏差),Error(误差),和Variance(方差)有什么区别和联系?

估测bias和variance

估测

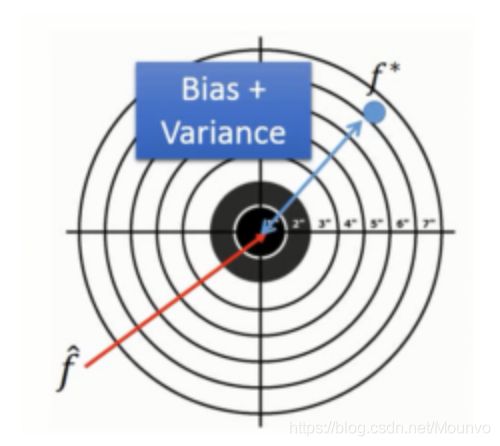

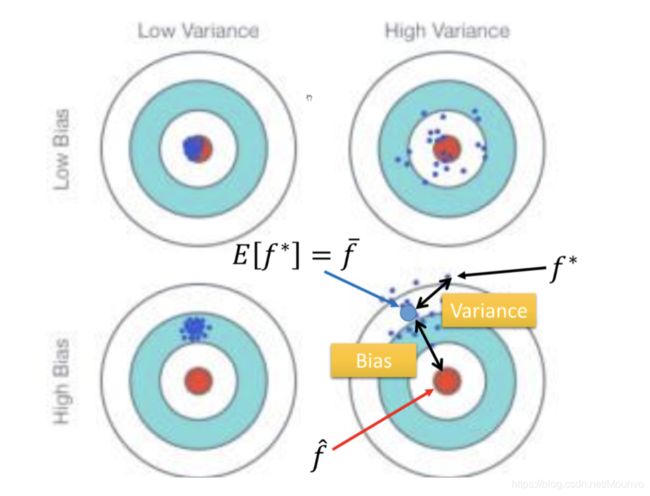

继续预测宝可梦进化后的cp值,假设真实的模型为 f ^ \hat f f^,但是我们没办法知道 f ^ \hat f f^,只能通过手机pokeon的数据,然后通过上一篇的step1~step3,得到我们的模型 f ∗ f^* f∗, f ∗ f^* f∗其实是对 f ^ \hat f f^的一个预测。

这个过程就像打靶, f ^ \hat f f^是我们的靶心, f ∗ f^* f∗就是我们投掷的结果,他们之间的距离就是偏差和方差导致的。

估测x的偏差和方差

偏差和方差实际上对应着物理实验中系统误差和随机误差的概念,偏差和方差的计算

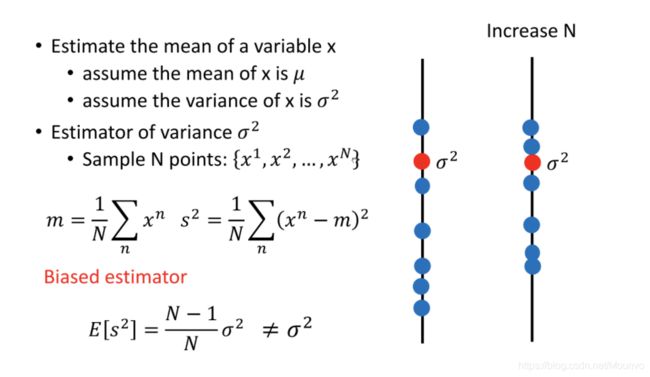

评估x的偏差

假设 x 的平均值是 μ \mu μ,方差为 σ 2 \sigma^2 σ2

评估平均值要怎么做呢?

首先拿到 个样本点: { x 1 , x 2 , ⋅ ⋅ ⋅ , x N } \{x^1,x^2,···,x^N\} {x1,x2,⋅⋅⋅,xN}

计算平均值 m, 得到 m= 1 N ∑ n x n ≠ μ \frac{1}{N}\sum_n x^n \neq \mu N1∑nxn=μ

但是如果计算很多组的m,然后求m的期望:

E [ m ] = E [ 1 N ∑ x n ] = 1 N ∑ n E [ x n ] = μ E[m]=E[\frac{1}{N}\sum x^n]=\frac{1}{N}\sum_nE[x^n]=\mu E[m]=E[N1∑xn]=N1∑nE[xn]=μ

这样得到的是无偏估计( unbiasd )

然后 m 分布对于$ \mu$的离散程度(方差):

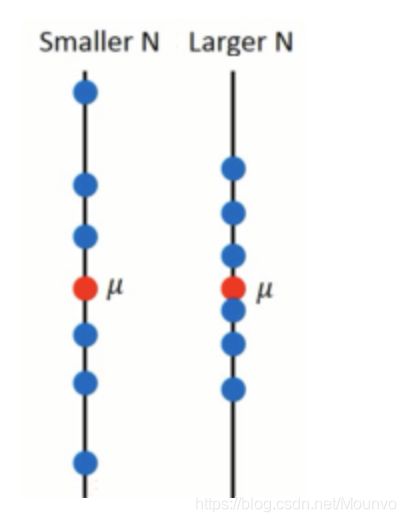

V a r [ m ] = σ 2 N Var[m]=\frac{\sigma^2}{N} Var[m]=Nσ2

这个取决于 N,下图看出 N 越小越离散:

估测x的方差

看图很好理解,左下角的数据比较集中,但他们的平均距离距离靶心有一段距离,所以它的bias比较大,而右上角的数据分散在靶心周围,variance较高

多个f

刚刚我们在只收集了十个data的情况下训练出来了一个f,那么我们是如何知道多个f来计算bias和variance呢?

因此我们在100个平行宇宙找了十只pokemon,计算得出的model如下图

不同模型的方差

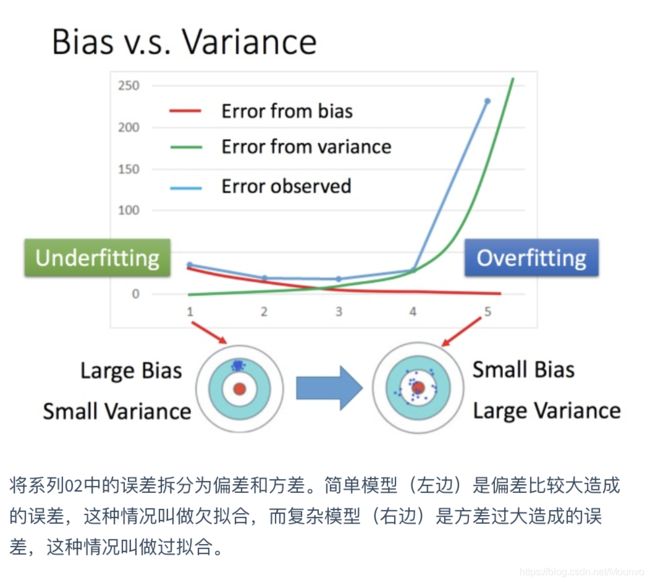

一次模型的variance是比较小的,而模型到五次式时,variance变得比较大

why?

简单的模型不容易overfitting,也就是没有高次项或者高次项的系数比较小,这样的模型表现的相当平滑,受到不同的数据的影响比较小

考虑一种极端情况f = c,那么所有宇宙的model都是一样的

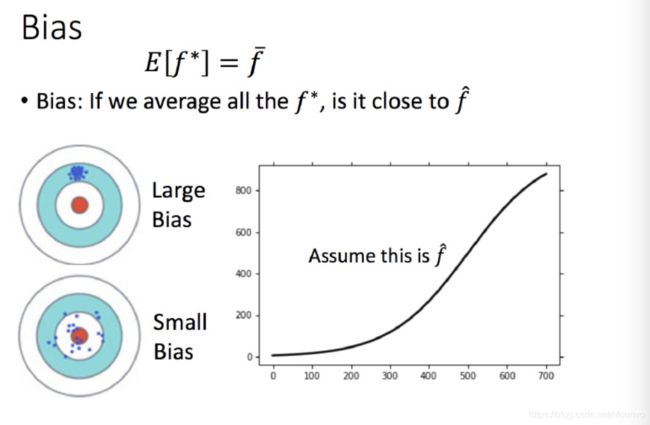

不同模型的偏差

这里没办法知道真正的 f ^ \hat f f^,所以假设图中的那条黑色曲线为真正的 f ^ \hat f f^

结果可视化,一次平均的 f ‾ \overline f f没有5次的好,虽然5次的整体结果离散程度很高。

偏差只与模型的复杂程度有关,一次模型的偏差比较大,而5次模型,偏差就比较小。

直观的解释:简单的模型函数集的space比较小,所以可能space里面就没有包含靶心,肯定射不中。而复杂的模型函数集的space比较大,可能就包含的靶心,只是没有办法找到确切的靶心在哪,但足够多的,就可能得到真正的f。

偏差v.s.方差

误差来自方差还是偏差?

- 如果模型并不能很好的适应训练集,那么存在很大的偏差

- 如果模型很好的适用训练集,但在测试集上的效果差强人意,那么存在很大的方差

欠拟合和过拟合要用不同的方式来处理

偏差大-欠拟合

此时应该重新设计模型。因为之前的函数集里面可能根本没有包含 f ∗ f^* f∗

可以将更多的函数加进去,比如考虑高度重量,或者HP值等等。 或者考虑更多次幂、更复杂的模型。 如果此时强行再收集更多的data去训练,这是没有什么帮助的,因为设计的函数集本身就不好,再找更多的训练集也不会更好。

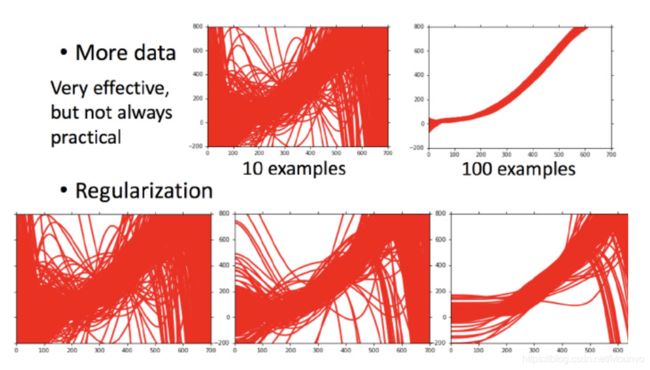

方差大-过拟合

简单粗暴的方法:更多的数据

但是很多时候不一定能做到收集更多的data。可以针对对问题的理解对数据集做调整。比如识别手写数字的时候,偏转角度的数据集不够,那就将正常的数据集左转15度,右转15度,类似这样的处理。

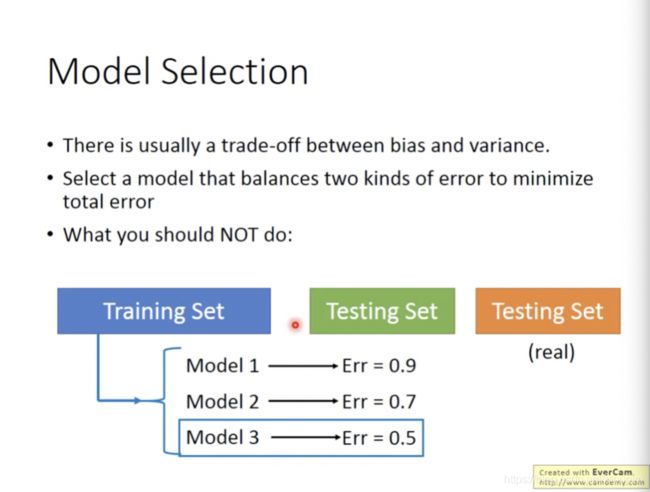

模型选择

如何权衡偏差和方差呢?

我们用来测试的测试集可能有自己的偏差,而不是真正的未使用过的测试集,因此,在真正的、完整的测试集上得到的误差一般会大于我们自己测试得到的误差。

因此,我们对训练集进行交叉验证。

交叉验证

将验证集分为training set(训练集)和validation set(验证集)两个部分,用训练集来构造每个model最好的function,使用验证集来选择model

如果担心把训练集分为训练集和验证集两部分之后,训练集的数目变少,可以这么做:

选中model3之后,用全部的训练集在model3上再选一个(使用所有的training data去更新model3的表达式),这个时候再public testing set上的error才可以反映private testing set的error

同时,得到error之后,不建议回过头重新调整model的参数,因此public testing set自身也可能存在bias,再次调整是围绕着有bias的testing set的模型优化,也是不合理的。

如果不相信这样得到的结果,即如果验证集中也有bias,那么使用接下来的方法。

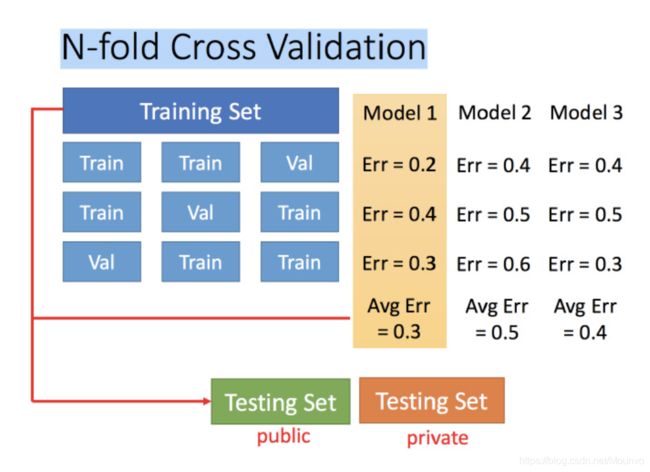

N-fold cross validation

将训练集分成N份,比如分成3份。一次使用一份当作验证集,另外两份当作训练集,分别计算每次的average error,得到model1最佳,再用完整的training data重新训练参数。

原则上,如果你根据public testing set上的error调整model的话,那你在private testing set上面得到error往往比较接近public testing error。

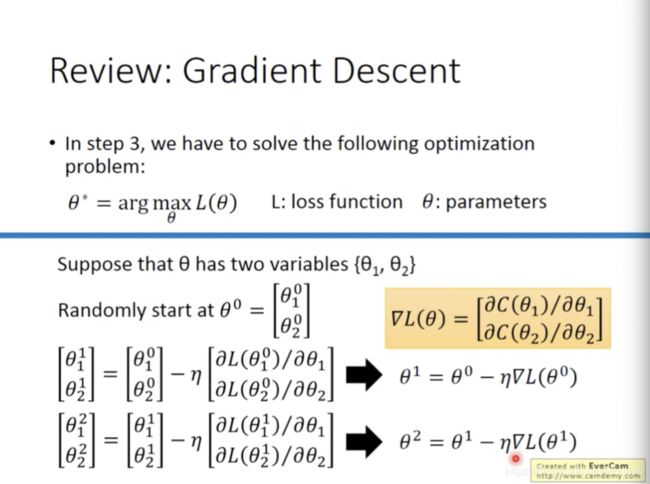

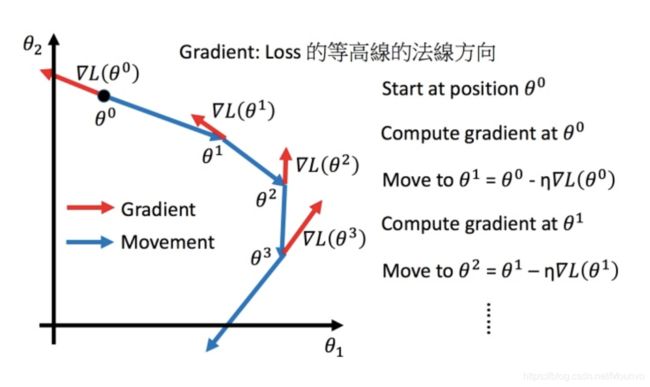

gradient descent

回顾之前学的梯度下降

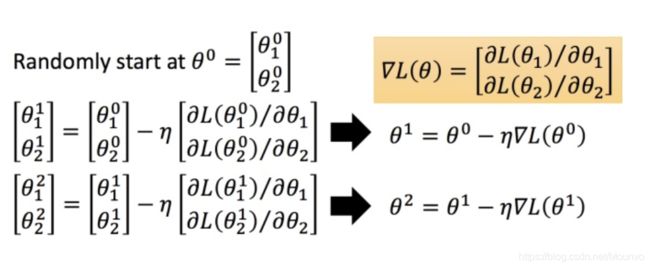

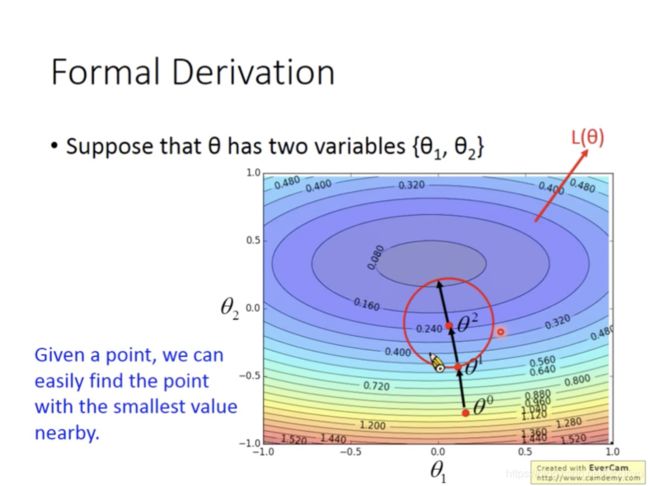

在第三步中,我们需要解决以上的问题,这里的parameters是复数,即 θ \theta θ 指代一堆参数,比如上篇说到的 w 和 b 。

我们要找一组参数 θ \theta θ ,让损失函数越小越好,这个问题可以用梯度下降法解决:

假设 θ θ \thetaθ θθ 有里面有两个参数 θ 1 , θ 2 θ \theta_1,\theta_2θ θ1,θ2θ,随机选取初始值

θ 0 = [ θ 1 0 θ 2 0 ] \theta^0 = \begin{bmatrix} \theta_1^0 \\ \theta_2^0 \end{bmatrix} θ0=[θ10θ20]

然后分别计算初始点处,两个参数对 LL 的偏微分,然后 θ 0 \theta^0 θ0减掉 η \eta η 乘上偏微分的值,得到一组新的参数。同理反复进行这样的计算。黄色部分为简洁的写法, ▽ L ( θ ) \triangledown L(\theta) ▽L(θ) 即为梯度。η 叫做Learning rates(学习速率)

梯度的方向是增长最快的方向,因此沿着反方向下降

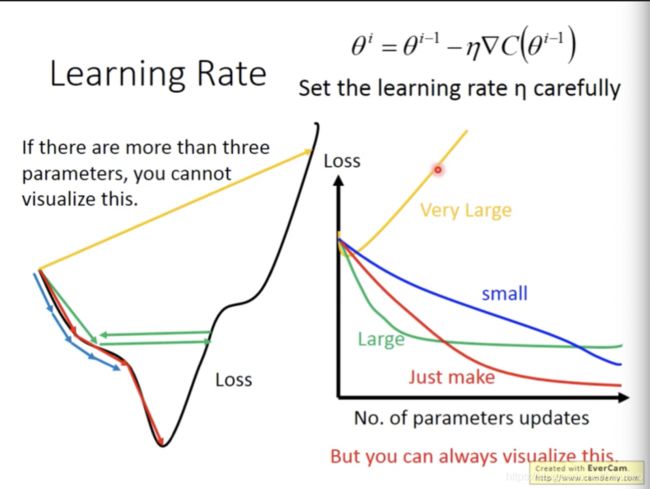

上图左边黑色为损失函数的曲线,假设从左边最高点开始,如果学习率调整的刚刚好,比如红色的线,就能顺利找到最低点。如果学习率调整的太小,比如蓝色的线,就会走的太慢,虽然这种情况给足够多的时间也可以找到最低点,实际情况可能会等不及出结果。如果 学习率调整的有点大,比如绿色的线,就会在上面震荡,走不下去,永远无法到达最低点。还有可能非常大,比如黄色的线,直接就飞出去了,更新参数的时候只会发现损失函数越更新越大。

learning rate的设置非常重要,如果learning rate太大,容易出现绿色和黄色的现象,最好的状态是红色。

手动调参过于复杂,因此我们想要一些自动调整learning rate的方法

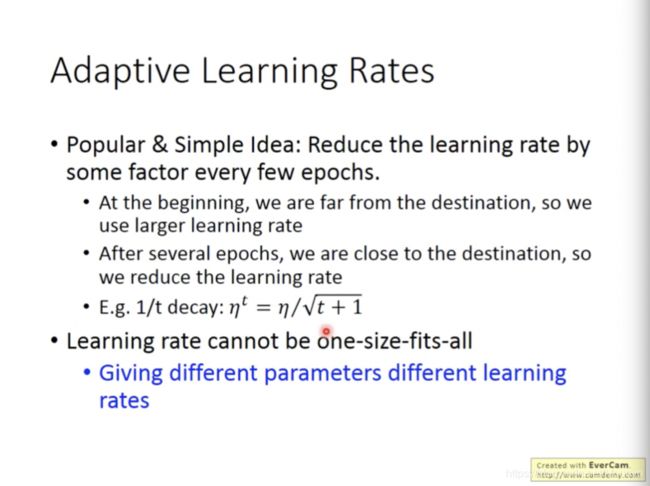

adaptive learning rate

自动调参的方法

最基本的原则就是:learning rate需要随着参数的更新越来越小

上面的例子中,learning rate变成了一个与次数有关的参数,随着调节次数的增加,learning rate会变小

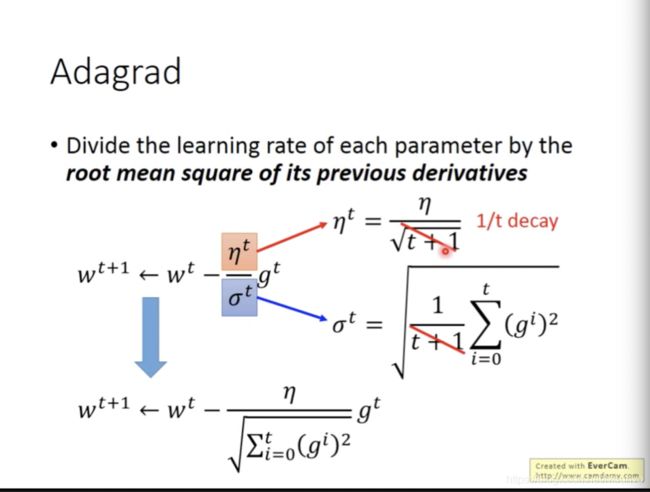

Adagrad 是什么?

每个参数的学习率都把它除上之前微分的均方根。解释:

普通的梯度下降为:

w t + 1 ← w t − η t g t w^{t+1} \leftarrow w^t -η^tg^t wt+1←wt−ηtgt

η t = η t t + 1 \eta^t =\frac{\eta^t}{\sqrt{t+1}} ηt=t+1ηt

- w 是一个参数

Adagrad 可以做的更好:

w t + 1 ← w t − η t σ t g t w^{t+1} \leftarrow w^t -\frac{η^t}{\sigma^t}g^t wt+1←wt−σtηtgt

g t = ∂ L ( θ t ) ∂ w g^t =\frac{\partial L(\theta^t)}{\partial w} gt=∂w∂L(θt)

σ t \sigma^t σt:之前参数的所有微分的均方根,对于每个参数都是不一样的。

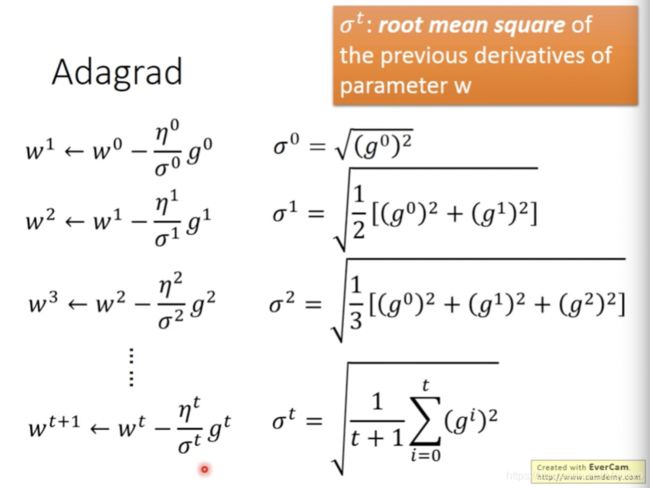

Adagrad举例

下图是一个参数的更新过程

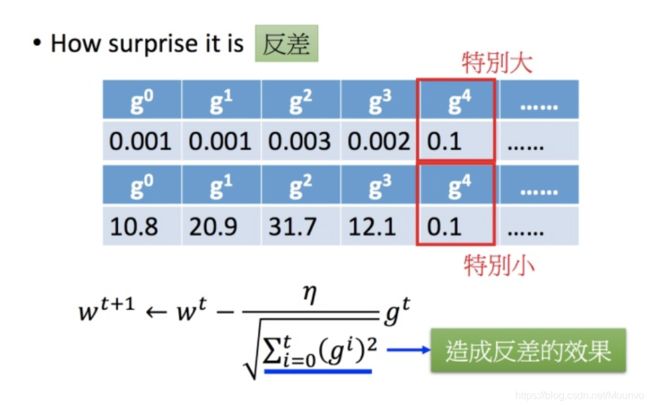

在Adagrad中似乎存在一些矛盾的地方,我们在做gradient descent的时候,希望的是当梯度值即微分值越大的时候,更新的步伐要大一些,而从Adagrad的表达式中我们却发现,分母中表示梯度越大步伐越小,分子却表示梯度越大步伐越大。

![]()

下图是一个直观的解释:

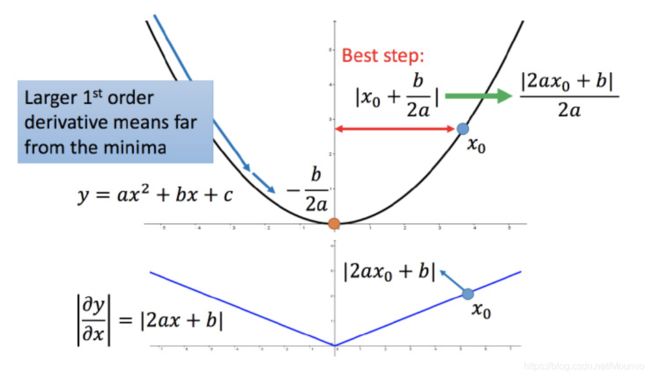

下面给一个正式的解释:

比如初始点在 x 0 x_0 x0,最低点为 − b 2 a − −\frac{b}{2a}− −2ab−,最佳的步伐就是 x 0 x0 x0 到最低点之间的距离 ∣ x 0 + b 2 a ∣ \left | x_0+\frac{b}{2a} \right | ∣∣x0+2ab∣∣,也可以写成 ∣ 2 a x 0 + b 2 a ∣ \left | \frac{2ax_0+b}{2a} \right | ∣∣2a2ax0+b∣∣ 。而刚好 ∣ 2 a x 0 + b ∣ |2ax_0+b| ∣2ax0+b∣就是方程绝对值在 x 0 x_0 x0 这一点的微分。

这样可以认为如果算出来的微分越大,则距离最低点越远。而且最好的步伐和微分的大小成正比。所以如果踏出去的步伐和微分成正比,它可能是比较好的。

结论1-1:梯度越大,就跟最低点的距离越远。

这个结论在多个参数的时候就不一定成立了。

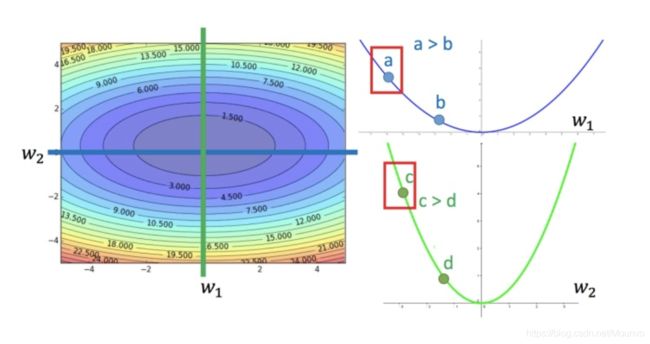

多参数下结论不一定成立

对比不同的参数

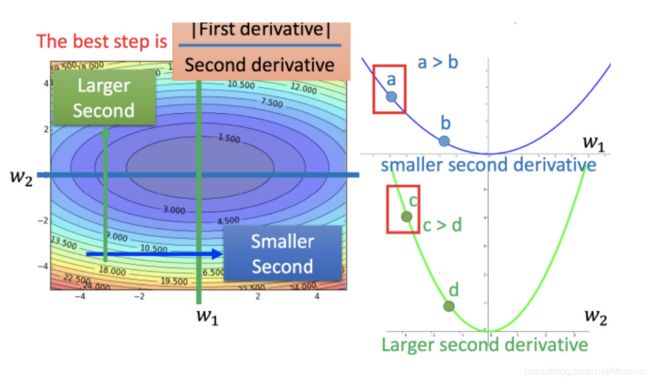

上图左边是两个参数的损失函数,颜色代表损失函数的值。如果只考虑参数 w 1 w_1 w1,就像图中蓝色的线,得到右边上图结果;如果只考虑参数 w 2 w_2 w2,就像图中绿色的线,得到右边下图的结果。确实对于 a 和 b,结论1-1是成立的,同理 c 和 b 也成立。但是如果对比a 和 c,就不成立了,c 比 a 大,但 c 距离最低点是比较近的。

所以结论1-1是在没有考虑跨参数对比的情况下,才能成立的。所以还不完善。

之前说到的最佳距离 ∣ 2 a x 0 + b 2 a ∣ \left | \frac{2ax_0+b}{2a} \right | ∣∣2a2ax0+b∣∣ ,还有个分母 2 a 2a 2a 。对function进行二次微分刚好可以得到:

∂ 2 y ∂ x 2 = 2 a \frac{\partial ^2y}{\partial x^2} = 2a ∂x2∂2y=2a

所以最好的步伐应该是:

一 次 微 分 二 次 微 分 \frac{一次微分}{二次微分} 二次微分一次微分

即不止和一次微分成正比,还和二次微分成反比。最好的step应该考虑到二次微分:

进一步的解释

分母部分可以看作二次微分,所以adagrad想要做的事情就是,在不增加任何额外运算的前提下,想办法去估测二次微分的值

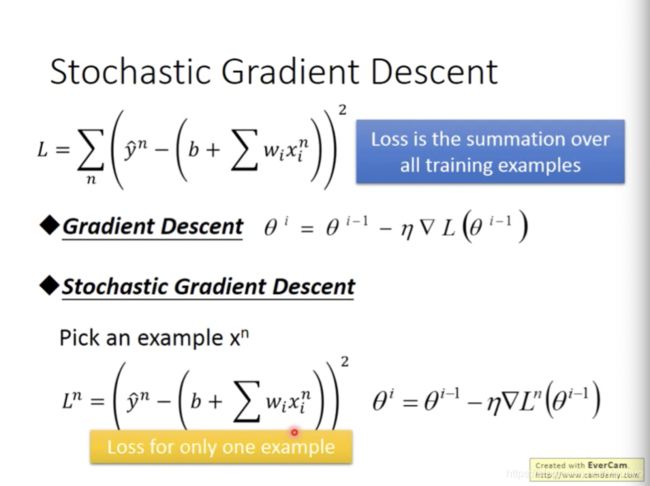

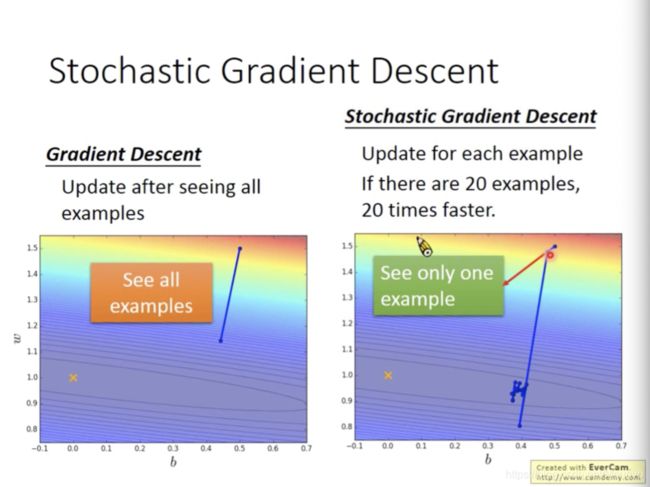

随机梯度下降法

传统的gradient descent是看完所有的样本点之后再构建损失函数,然后再更新参数,而随机梯度下降的做法是,看到一个样本点就更新一次,因此它的损失函数不是所有样本点的误差平方和,而是这个随机样本点的误差的平方,得到的对比图如上图所示。

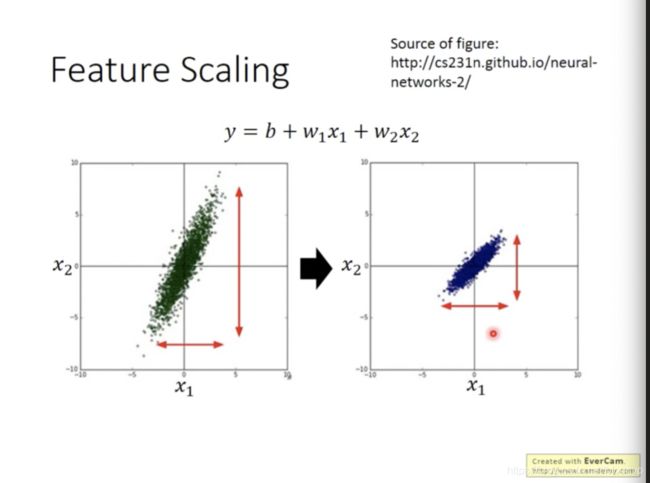

特征归一化

当两个输入的分布范围很不一样时,建议把他们的范围缩放,使得不同输入的范围是一样的。

为什么要这样做?

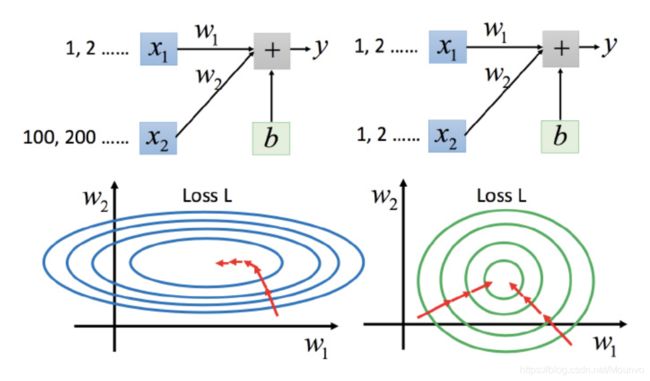

上图左边是 x 1 x_1 x1的scale比 x 2 x_2 x2要小很多,所以当 w 1 w_1 w1和 w 2 w_2 w2做同样的变化时, w 1 w_1 w1对 y 的变化影响是比较小的, x 2 x_2 x2对 y 的变化影响是比较大的。

坐标系中是两个参数的error surface(现在考虑左边蓝色),因为 w 1 w_1 w1对 y 的变化影响比较小,所以 w 1 w_1 w1 对损失函数的影响比较小, w 1 w_1 w1对损失函数有比较小的微分,所以 w 1 w_1 w1 方向上是比较平滑的。同理 x 2 x_2 x2对 y 的影响比较大,所以 x 2 x_2 x2对损失函数的影响比较大,所以在 x 2 x_2 x2方向有比较尖的峡谷。

上图右边是两个参数scaling比较接近,右边的绿色图就比较接近圆形。

对于左边的情况,上面讲过这种狭长的情形不过不用Adagrad的话是比较难处理的,两个方向上需要不同的学习率,同一组学习率会搞不定它。而右边情形更新参数就会变得比较容易。左边的梯度下降并不是向着最低点方向走的,而是顺着等高线切线法线方向走的。但绿色就可以向着圆心(最低点)走,这样做参数更新也是比较有效率。

warning of math

在 θ 0 \theta^0 θ0处,可以在一个小范围的圆圈内找到损失函数细小的 t h e t a 1 theta^1 theta1,那么问题是,如何找到红圈中最小的loss?

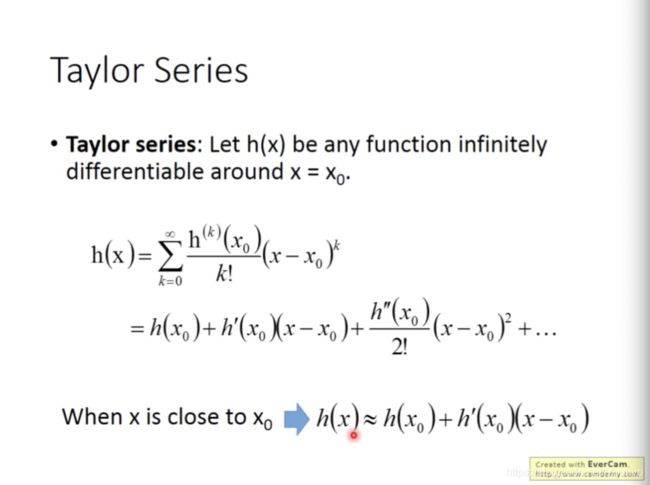

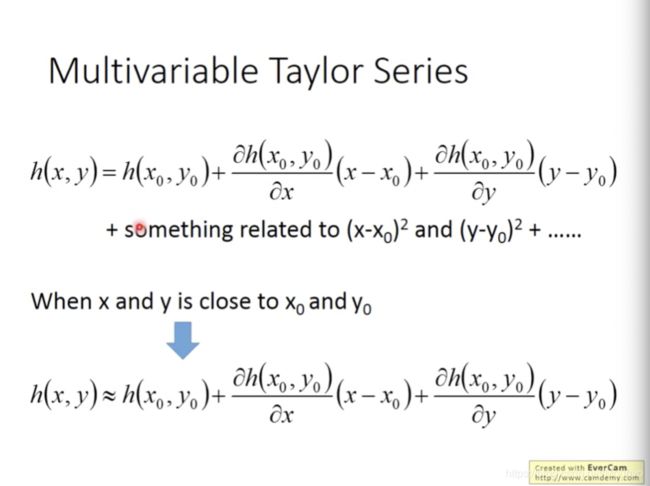

泰勒展开式

举例

在有多个参数的时候也可以泰勒展开

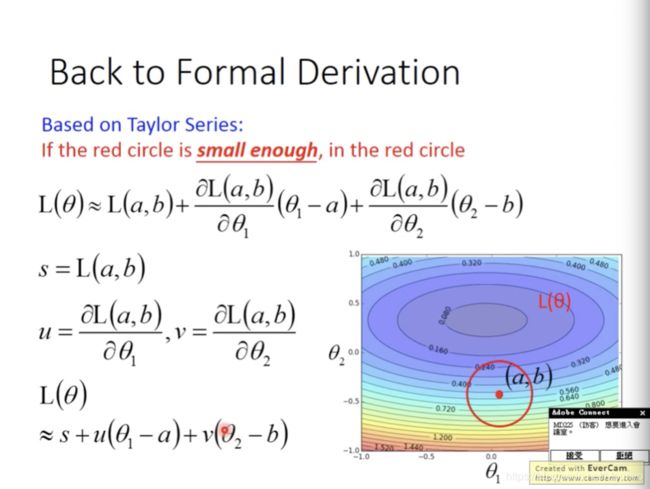

回到之前如何快速找到最小值,基于泰勒展开式,在(a,b)点的红色圆圈范围内,可以将损失函数用泰勒展示式进行简化:

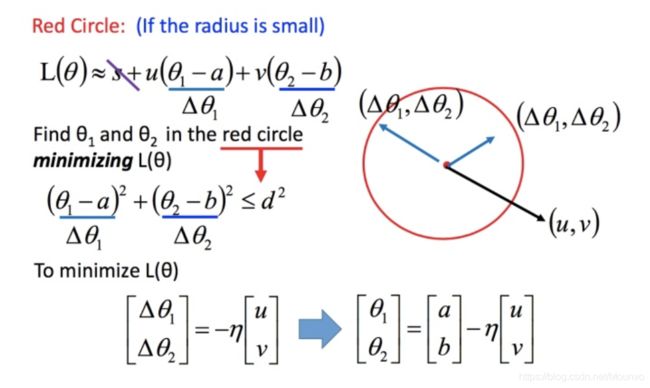

将问题进而简化为下图:

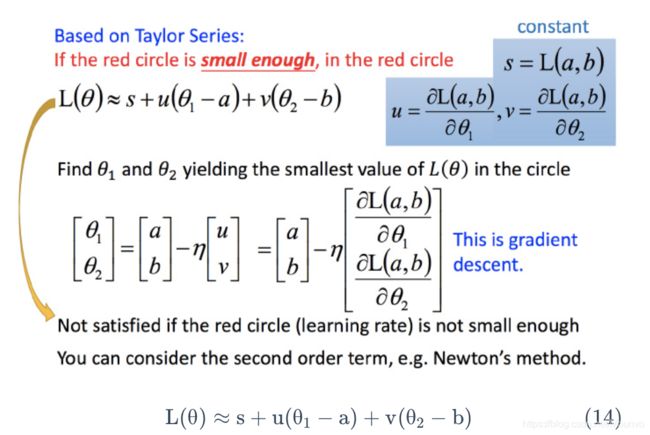

不考虑s的话,可以看出剩下的部分就是两个向量 ( △ θ 1 , △ θ 2 ) (\triangle \theta_1,\triangle \theta_2) (△θ1,△θ2)和 (u,v)(u,v) 的内积,那怎样让它最小,就是和向量 (u,v)(u,v) 方向相反的向量

然后将u和v带入。

发现最后的式子就是梯度下降的式子。但这里用这种方法找到这个式子有个前提,泰勒展开式给的损失函数的估算值是要足够精确的,而这需要红色的圈圈足够小(也就是学习率足够小)来保证。所以理论上每次更新参数都想要损失函数减小的话,即保证式1-2 成立的话,就需要学习率足够足够小才可以。

所以实际中,当更新参数的时候,如果学习率没有设好,是有可能式1-2是不成立的,所以导致做梯度下降的时候,损失函数没有越来越小。

式1-2只考虑了泰勒展开式的一次项,如果考虑到二次项(比如牛顿法),在实际中不是特别好,会涉及到二次微分等,多很多的运算,性价比不好。

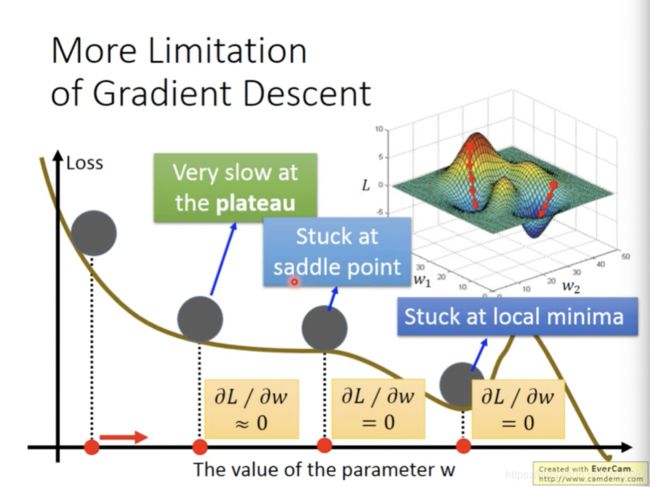

梯度下降的限制

- 容易陷入局部极值

- 会容易陷入不是极值,但是微分值是0的地方。

Gradient Descent (Demo by AOE)

利用帝国时代的方式模拟梯度下降;

在地图上大多数位置我们是未知的,只有我们单位走过的地方是可知;

地图上的海拔可以看作损失函数loss function,我们的目的就是寻找海拔的最低点的值;

随机初始一个位置,朝向较低的方向移动,周而复始,直到local minimal(在不开天眼的情况下,你始终不会知晓所在位置是否为global minimal)。

Gradient Descent (Demo by Minecraft)

利用梯度下降法更新参数,损失函数loss function可能会不降反升(利用Mincraft解释该情况);

人物的前方是较低方向,右方也是较低方向,利用梯度下降法,往右前方移动一步,然后反复用梯度下降法,往右前方移动一步,周而复始;

尽管前方和右方是下降的方向,但往右前方移动,将会失败(因为实际右前方是比较高的地方)。