pytorch深度学习实践-多维特征输入0106

目录

1、多维特征的输入实践-糖尿病数据预测

2、torch.nn.BCELoss相关参数含义

3、更换激活函数对比效果

1、多维特征的输入实践-糖尿病数据预测

import numpy as np

import torch

import matplotlib.pyplot as plt

# prepare dataset

xy = np.loadtxt('diabetes.csv', delimiter=',', dtype=np.float32)

# 创建两个tensor

x_data = torch.from_numpy(xy[:, :-1])

y_data = torch.from_numpy(xy[:, [-1]]) # 只填-1得到的是向量,[-1]最后得到的是个矩阵

# design model using class

class Model(torch.nn.Module):

def __init__(self):

super(Model, self).__init__()

# 三个线性模型

self.linear1 = torch.nn.Linear(8, 6) # 输入数据x的特征是8维,x有8个特征

self.linear2 = torch.nn.Linear(6, 4)

self.linear3 = torch.nn.Linear(4, 1)

self.sigmoid = torch.nn.Sigmoid() # 有所区别

def forward(self, x):

x = self.sigmoid(self.linear1(x)) # 第一个输出x作为第二个函数的输入

x = self.sigmoid(self.linear2(x))

x = self.sigmoid(self.linear3(x)) # y hat

return x

model = Model()

# construct loss and optimizer

criterion = torch.nn.BCELoss(size_average=True)

optimizer = torch.optim.SGD(model.parameters(), lr=0.1)

epoch_list = []

loss_list = []

# training cycle forward, backward, update

for epoch in range(1000):

y_pred = model(x_data)

loss = criterion(y_pred, y_data)

print(epoch, loss.item())

epoch_list.append(epoch)

loss_list.append(loss.item())

optimizer.zero_grad()

loss.backward()

optimizer.step()

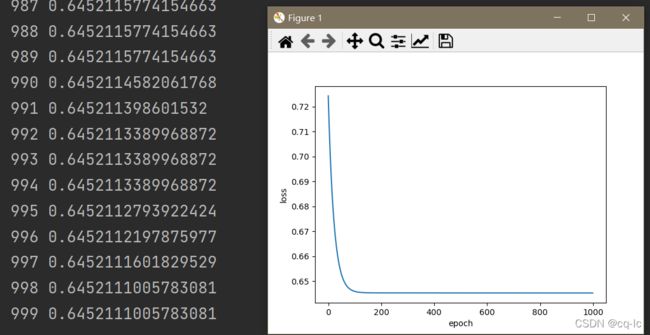

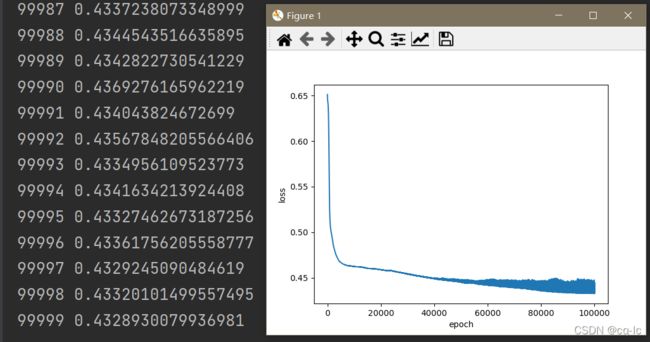

plt.plot(epoch_list, loss_list)

plt.ylabel('loss')

plt.xlabel('epoch')

plt.show()结果如下图:

2、torch.nn.BCELoss相关参数含义

torch.nn.BCELoss(weight=None, size_average=None, reduce=None, reduction=‘mean’) 计算目标值和预测值之间的二进制交叉熵损失函数。

有四个可选参数:weight、size_average、reduce、reduction

(1) weight必须和target的shape一致,默认为none。定义BCELoss的时候指定即可。

(2) 默认情况下 nn.BCELoss(),reduce = True,size_average = True。

(3) 如果reduce为False,size_average不起作用,返回向量形式的loss。

(4) 如果reduce为True,size_average为True,返回loss的均值,即loss.mean()。

(5) 如果reduce为True,size_average为False,返回loss的和,即loss.sum()。

(6) 如果reduction = 'none',直接返回向量形式的 loss。

(7) 如果reduction = 'sum',返回loss之和。

(8) 如果reduction = 'elementwise_mean',返回loss的平均值。

(9) 如果reduction = 'mean',返回loss的平均值

3、更换激活函数对比效果

最初只更改激活函数,只成功一个:

torch.nn.Hardsigmoid()换成其它激活函数时,一直报错:

调整学习率会影响结果,但大概率报错。

最后查找torch.nn.BCELoss发现,其用于二分类问题,使用nn.BCELoss时需要在该层前面加上Sigmoid函数,可把第三层函数改为sigmoid,或在返回数据前加一个x = torch.nn.Sigmoid()(x):

# design model using class

class Model(torch.nn.Module):

def __init__(self):

super(Model, self).__init__()

# 三个线性模型

self.linear1 = torch.nn.Linear(8, 6) # 输入数据x的特征是8维,x有8个特征

self.linear2 = torch.nn.Linear(6, 4)

self.linear3 = torch.nn.Linear(4, 1)

# self.activate1 = torch.nn.Sigmoid()

# self.activate = torch.nn.ReLU()

# self.activate = torch.nn.GELU()

# self.activate = torch.nn.ELU()

# self.activate = torch.nn.Hardshrink()

# self.activate = torch.nn.Hardsigmoid()

# self.activate = torch.nn.Hardtanh()

# self.activate = torch.nn.Hardswish()

# self.activate = torch.nn.LogSigmoid()

# self.activate = torch.nn.ReLU6()

# self.activate = torch.nn.RReLU()

def forward(self, x):

x = self.activate(self.linear1(x)) # 第一个输出x作为第二个函数的输入

x = self.activate(self.linear2(x))

x = self.activate(self.linear3(x)) # y hat

x = torch.nn.Sigmoid()(x)

return x

model = Model()

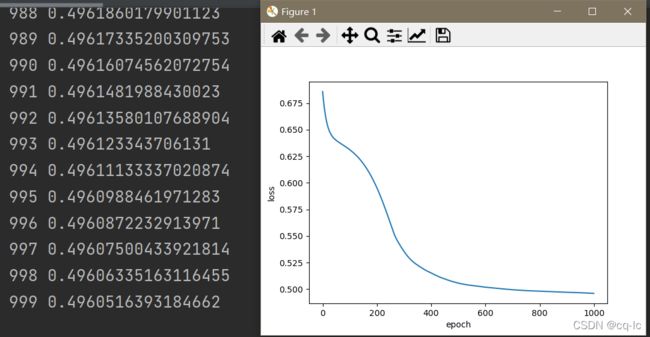

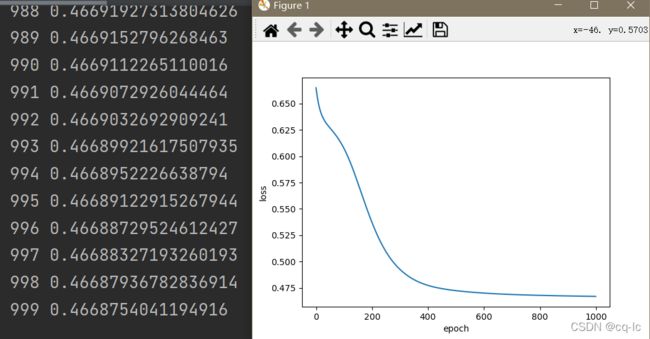

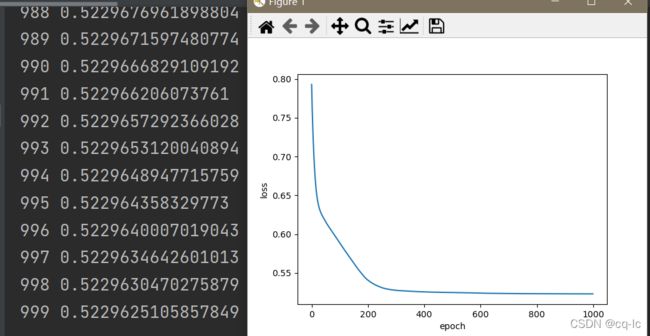

最终结果:

torch.nn.ReLU()torch.nn.GELU()torch.nn.ELU()torch.nn.Hardsigmoid()torch.nn.Hardtanh()torch.nn.ReLU6()torch.nn.RReLU()采用relu,lr=0.05,循环100000次:

发现后面部分过拟合了!