NIPS2014图上的谱聚类

题目:Spectral Networks and Deep Locally Connected Networks on Graphs

摘要:

卷积神经网络在图像和音频识别任务中是非常有效的结构,因为它们能够利用信号类在其域上的局部平移不变性。在本文中,我们考虑了在没有翻译组作用的情况下,CNN对更一般域上信号的可能概括。特别地,我们提出了两种构造,一种基于域的层次聚类,另一种基于图拉普拉斯的谱。我们通过实验证明,对于低维图,可以学习具有与输入大小无关的多个参数的卷积层,从而产生有效的深层结构。

介绍:

卷积神经网络(CNN)在机器学习问题中非常成功,其中基础数据表示的坐标具有网格结构(1、2和3维),并且在这些坐标中研究的数据相对于该网格具有平移等方差/不变性。语音[11]、图像[14、20、22]或视频[23、18]都是属于这类的显著例子。

在一个规则的网格上,CNN能够利用几个可以很好地协同工作的结构,从而大大减少系统中的参数数量:

1.translation结构,允许使用过滤器而不是通用线性映射,从而实现权重共享

2.网格上的度量,允许紧凑支持的过滤器,其支持通常比输入信号的大小小得多。

3.网格的多尺度二元聚类,允许通过stride卷积和池化实现子采样

如果在d维网格上有n个输入坐标,则具有m个输出的完全连接层需要n·m参数,在典型的操作状态下,这相当于o(n2)参数的复杂性。使用任意过滤器而不是通用的完全连接层,可以降低每个要素图参数的复杂性为O(N),就像通过构建“locally connected”网络使用度量结构一样[8,17]。同时使用这两个参数给出了O(k·s)参数,其中k是特征图的数量,s是过滤器的支持,因此,学习的复杂性与n无关。最后,使用多尺度二元聚类允许每个成功层使用每个过滤器的二维(空间)坐标减少系数

然而,在许多情况下,人们可能会面临在缺乏部分或全部上述几何特性的坐标上定义的数据。例如,在三维网格上定义的数据,如表面张力或温度、气象站网络的测量值、社会网络或协作过滤的数据,都是结构化输入的例子,不能应用标准的卷积网络。另一个相关的例子是由深神经网络产生的中间表示。虽然空间卷积结构可以在多个层次上被利用,但典型的CNN结构在“特征”维度上不假设任何几何结构,从而产生仅沿空间坐标卷积的4-D张量。

图提供了一个自然的框架来概括低维网格结构,并通过扩展卷积的概念。在这项工作中,我们将讨论除规则网格以外的图形上的深层神经网络的构造。我们提出两种不同的结构。在第一个图中,我们表明可以将属性(2)和(3)扩展到一般图,并使用它们来定义“局部”连接和池层,这需要O(n)参数而不是O(n2)。我们称之为空间结构。另一种构造,我们称之为谱构造,利用傅立叶域卷积的性质。在rd中,卷积是线性算子,由傅立叶基exp(iω·t),ω,t∈rd对角化。然后可以通过定义相应的“傅立叶”基将卷积扩展到一般图。这种等价是通过图拉普拉斯算子给出的,该算子对图[1]进行了调和分析。每个特征图的光谱构造最多需要O(n)个参数,并且可以在参数数量与输入尺寸n无关的情况下进行构造。这些构造允许有效的正向传播,并且可以应用于坐标数量非常大的数据集。

1.1 贡献

我们的主要贡献总结如下

- 我们证明,从输入域的弱几何结构中,可以使用O(N)参数获得有效的体系结构,并在低维图数据集上进行验证

- 我们引入了一个由经验验证的O(1)参数构成的结构,并讨论了它与图上谐波分析问题的联系。

2 spatial construction

将CNN泛化到一般的graph上最直接的就是考虑多尺度、层次、局部接受度,如[3]所示。为此,网格将替换为加权图G=(Ω,W),其中Ω是一组大小为m的离散集,W是一个m×m对称非负矩阵

2.1 Locality via W

局部性的概念可以在图的上下文中很容易地推广。实际上,图中的权重决定了局部性的概念。例如,在W上定义一个邻里的直接方法是设置一个阈值δ>0并取邻里:

我们可以限制对稀疏“过滤器”的关注,通过这些neighborhoods提供的感受野来获得局部连接的网络,从而将过滤器层中的参数数量减少到o(s·n),其中s是平均的邻域大小。

2.2 Multiresolution Analysis on Graphs

CNN通过池和子采样层减小网格的大小。由于网格的自然多尺度聚类,这些层是可能的:它们在一个簇上输入所有的特征映射,并为该簇输出一个特征。在网格上,二元聚类在度量和拉普拉斯(以及translation结构)方面表现良好。有大量关于在图上形成多尺度簇的文献,例如[16,25,6,13]。在图上发现多尺度簇,可以证明其行为良好的W.R.T.拉普拉斯仍然是一个开放的研究领域。在这项工作中,我们将使用一种幼稚的凝聚方法。

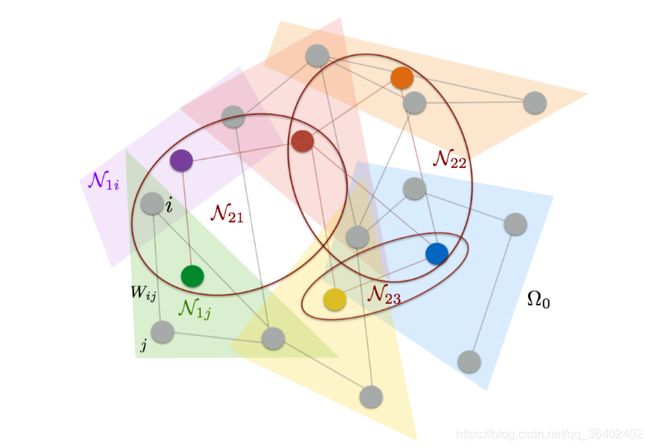

图1说明了一个带有相应邻域的图的多分辨率聚类

图1:两级聚类的无向图G=(Ω0,W)。原始点以灰色绘制。

2.3 Deep Locally Connected Networks

空间结构从图的多尺度聚类开始,类似于[3]中我们考虑的k尺度。我们设置了Ω0=Ω,对于每个k=1…k,我们定义了Ωk,将Ωk−1划分为dk集群;以及围绕Ωk−1的每个元素的一组邻居:

有了这些,我们现在可以定义网络的第k层。我们假设输入信号是用Ω0表示的真实信号,并用FK表示在每层k上创建的“滤波器”数量。网络的每层将把用Ωk-1表示的FK-1维信号转换成用Ωk表示的FK维信号,从而用新的已创建要素坐标。

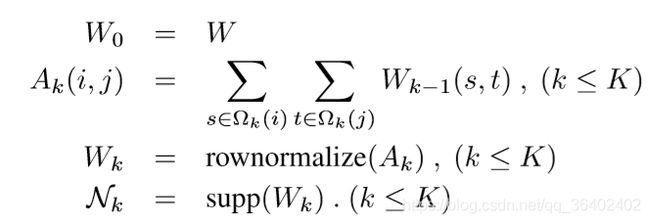

在当前代码中,要构建Ωk和nk,我们使用以下构造

图2:如(2.1)所述的空间结构,k=2。为了便于说明,池操作与过滤阶段同化。转换的每一层都会丢失空间分辨率,但会增加过滤器的数量。

在实践中,我们得到了sk·Ωk≈α·Ωk−1,其中α是过采样因子,通常是α∈(1,4)。空间结构可能看起来不太自然,但它的优点是需要对图形进行相对较弱的规则性假设。具有低内在维数的图具有局部邻域,即使不存在良好的全局嵌入。然而,在这种结构下,并没有一种简单的方法可以在图的不同位置诱导权重共享。一种可能的选择是考虑将图形全局嵌入到低维空间中,这在高维数据的实际应用中很少见。

-

Spectral Construction

图的拉普拉斯谱可以利用图的整体结构推广卷积算子

3.1 Harmonic Analysis on Weighted Graphs

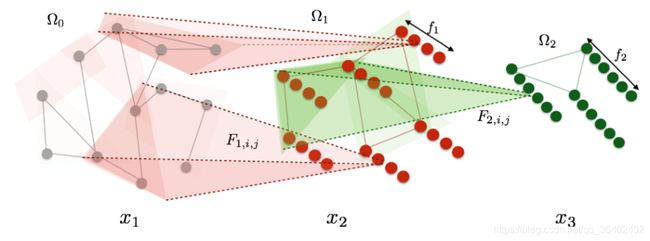

组合拉普拉斯L=d−w或图拉普拉斯L=i−d−1/2w d−1/2是拉普拉斯在网格上的推广;与w相关的频率和平滑度通过这些运算符相互关联[2,25]。为了简单起见,这里我们使用组合拉普拉斯函数。如果x是m维向量,则一个节点i上的光滑度函数的自然定义

是L的特征向量,特征值λi允许从[v0,…vm−1]中x的系数读取向量x的平滑度,相当于网格中定义的信号的傅立叶系数。因此,在网格的情况下,拉普拉斯的特征向量是傅立叶向量,拉普拉斯谱上的对角运算符调节其操作数的平滑度。此外,使用这些对角线操作符可以将过滤器的参数数量从m2减少到m。

-

滤波器是拉普拉斯∆特征值的乘数

-

相对于网格度量光滑的函数在特征向量∆的基础上具有快速衰减系数

-

次采样拉普拉斯函数的特征向量是∆的低频特征向量

3.2 Extending Convolutions via the Laplacian Spectrum

如第2.3节所述,设w为指数集为Ω的加权图,设v为拉普拉斯图L的特征向量,按特征值排序。给定一个加权图,我们可以通过对其图拉普拉斯图的特征向量给出的权重谱的运算来推广卷积网。

通常,只有拉普拉斯的前s个特征向量在实践中是有用的,它承载了图形的平滑几何。截止频率d取决于图形的固有规律以及样本大小。在这种情况下,我们可以用v d替换(3.2)v,保留v的第一个d列。

如果图有一个潜在的群体不变性,这个结构可以发现它;最好的例子是标准CNN;见3.3。但是,在许多情况下,图表没有组结构,或者组结构与拉普拉斯曲线不一致,因此我们不能将每个过滤器视为通过Ω传递模板并记录模板与该位置的相关性。正如我们将在第5.1节的示例中看到的那样,Ω在某种程度上可能不是同质的。

假设只保留拉普拉斯算子的d个本征向量,则等式(3.2)表明每层需要fk-1·fk·d = O(|Ω|)参数进行训练。 我们将看到在3.4如何将图的全局和局部规律性组合以产生具有O(1)参数的层,即,使得可学习参数的数量不依赖于输入的大小。

这种构造可能会遭受这样一个事实:大多数图只有在高频部分才有有意义的特征向量。即使个别高频特征向量没有意义,高频特征向量队列也可能包含有意义的信息。然而,这种结构可能无法访问这些信息,因为它在最高频率下几乎是对角的。

最后,在空间方面应用非线性时,如何有效地实现前向或后向,这并不明显,因为我们必须用V和V t进行昂贵的乘法;在光谱方面,如何实现标准非线性也不明显。但是,见4.1。

3.3 Rediscovering standard CNN’s

一个简单的,在某种意义上是普遍的,权重矩阵的选择在这个结构中是数据的协方差。设x=(x k)k为输入数据分布,其中x k∈rn。如果每个坐标j=1…n的方差相同,

然后拉普拉斯上的对角算符简单地缩放了x的主分量。虽然这看起来很小,但众所周知,固定大小图像集的主分量(实验上)对应于按频率组织的离散余弦变换基础。这可以通过注意到图像是平移不变量来解释,因此协方差运算符

满足∑(j,j’)=∑(j−j’),因此它由傅里叶基对角化。此外,众所周知,自然图像显示功率谱E(b x(ξ)2)ξ−2,因为附近像素比远处像素更相关。结果表明,协方差的主成分基本上是由低频到高频有序排列的,这与傅立叶基的标准群结构是一致的。

其结果是,当应用于自然图像时,3.2中以协方差为相似核的构造可以恢复标准卷积网络,而无需任何先验知识。实际上,等式(3.2)中的线性算符v fi,jv t是由傅立叶基中的前一个参数对角线决定的,因此平移不变量,因此是“经典”卷积。此外,第4.1节解释了如何通过去掉拉普拉斯谱的最后一部分来获得空间次采样,从而产生最大池,最终形成深卷积网络。

3.4 O(1) construction with smooth spectral multipliers

在标准网格中,我们不需要为每个傅立叶函数设置参数,因为过滤器在空间中得到紧密支持,但是在(3.2)中,每个过滤器对其作用的每个特征向量都需要一个参数。即使过滤器在此结构中在空间上得到了紧凑的支持,我们仍然不会得到低于O(n)个参数的每个过滤器,因为每个位置的空间响应都不同

绕过这一点的一种可能性是概括网格的二元性。在欧几里得网格上,空间域中函数的衰减转化为傅立叶域和维切夫斯域中的光滑度。结果表明,空间局部化的函数x具有平滑的频率响应_x=v tx。在这种情况下,拉普拉斯特征向量可以被认为是排列在与原始空间网格同构的网格上。

这表明,为了学习一个层,在这个层中,特征不仅在不同的位置上共享,而且在原始域中也有很好的局部性,我们可以学习平滑的谱乘子。光滑度可以通过只学习一组次采样的频率倍增器,并使用插值核来获得其余部分,如三次样条曲线来规定。然而,平滑度的概念要求在光谱坐标域中有一个几何图形,可以通过定义双图形w来获得,如(3.1)所示。如前所述,在规则网格上,这种几何图形由频率概念给出,但不能直接推广到其他图形。一个特别简单的navie选择包括选择一维排列,通过根据特征值排序特征向量获得。在此设置中,每个过滤器fk,i,j(最大尺寸为Ω)的对角线参数化为

其中k是d×qk固定三次样条核,αk,i,j是qk样条系数。如果我们寻求具有恒定空间支持的滤波器(即,其支持与输入尺寸Ω无关),那么我们可以在光谱域中选择一个采样步骤αΩ,这会导致系数αk,i,j的常数qkΩα−1=o(1)。

尽管第5节的结果似乎表明,拉普拉斯光谱给出的一维排列在创建空间局部化滤器方面是有效的,但一个基本问题是如何

定义一个捕获光谱坐标几何图形的双图表。一种可能的算法状态是考虑由空间局部化信号组成的输入分布x=(x k)k,并通过测量光谱域中的相似性来构造一个双图w:b x=v t x。相似性可以测量,例如,使用e(x−e(x))t(x−e(x)。

4 Relationship with previous work

有大量关于在图上建立小波的文献,例如[21,7,4,5,9]。基于网格的小波,在神经网络的语言中,是一种具有一定可证明的规律性的线性自动编码器(特别是在编码各种平滑函数时,保证了稀疏性)。经典小波变换中的前向传播与神经网络中的前向传播非常相似,只是每一层只有一个滤波器映射(并且通常每一层都是相同的滤波器),并且保持每一层的输出,而不仅仅是最后一层的输出。传统上,过滤器不是学习的,而是为了方便规律性的证明而建造的。

在图的情况下,目标是相同的,只是网格上的平滑度被图上的平滑度所取代。与经典的情况一样,大多数作品都试图在图形的基础上显式地构造小波(也就是说,没有学习),以便相应的AUT编码器具有正确的稀疏性属性。在这项工作和最近的工作[21]中,“滤波器”受构造的约束,具有子波的一些规律性特性,但也经过训练,因此它们适合于独立于(但可能有关)图上平滑度的任务。虽然[21]仍然建立了一个(稀疏)线性自动编码器,保持基本的小波变换设置,这项工作的重点是非线性结构,特别是试图建立类似CNN的

另一个与当前工作相关的工作是从数据中发现网格拓扑。在[19]中,作者根据经验确认了第3.3节中的陈述,表明可以通过二阶统计数据恢复二维网格结构。在[3,12]中,作者估计了构造局部连接网络的特征之间的相似性。

4.1 Multigrid

我们可以改进这两种构造,并在某种程度上将它们统一起来,使图的多尺度聚类与拉普拉斯图很好地配合。如前所述,在网格的情况下,标准的并矢立方体具有这样的性质:将网格上的傅立叶函数再采样到较粗的网格,与在较粗的网格上定义傅立叶函数相同。这一特性将消除将光谱结构映射到每层的最新网格以实现非线性的烦人必要性;并允许我们(通过插值)将空间结构中较深层的局部滤波器解释为低频。

这种聚类是求解离散PDE(和一般线性系统)的多重网格方法的基础[24]。已经有几篇论文扩展了多重网格方法,特别是与多重网格方法相关联的多尺度聚类,在比常规网格更通用的设置中,如本文中的情况请参见示例[16,15],一般情况下,代数多重网格方法请参见[24]。在本文中,为了简单起见,我们在空间边构造上使用了一个幼稚的多尺度聚类,它不能保证尊重原始图的拉普拉斯函数,并且在谱构造中没有明确的空间聚类。

5 Numerical Experiments

前面的结构在mnist数据集的两个变体上进行了测试。首先,我们对普通28×28网格进行次采样,得到400个坐标。这些坐标仍然具有二维结构,但不可能使用标准卷积。然后,我们通过将d=4096点放置在三维单位球体上,并将随机mnist图像投射到这组点上,如第5.2节所述。

在所有的实验中,我们使用直线单位作为非线性和最大池。我们使用动量为0.9的固定学习速率0.1来训练交叉熵损失模型。

5.1 Subsampled MNIST

我们首先将第3.2节和第2.3节中的结构应用于子样本mnist数据集。图3显示了产生的输入信号的示例,图4、5分别显示了由图和图的拉普拉斯函数的一些特征函数构造的层次聚类。各种图形体系结构的性能如表1所示。为了作为基线,我们计算标准最近邻分类,它的性能比完整mnist数据集(2.8%)稍差。两层全连接神经网络将误差降低到1.8%。数据的几何结构可以利用CNN图形体系结构进行开发。与图结构相适应的局部接收域优于全连通网络。特别是,两层过滤和最大池定义了一个有效地将信息聚合到最终类别的网络。光谱结构在这个数据集上的性能稍差。我们考虑了n/2=200的频率截止。然而,第3.4节中描述的包含最少参数的频率平滑结构优于常规频谱结构。

这些结果可以解释如下。mnist数字的特点是以局部为导向的笔画,要求测量具有良好的空间定位。局部可接受因子的构造是为了明确地满足这一约束,而在光谱构造中,测量值并没有强制变为空间局部化。在过滤器的光谱上添加平滑度约束可以提高分类结果,因为过滤器被强制要求具有更好的空间定位。

这一事实如图6所示。我们验证了在不同的空间邻里中,局部接受野编码不同的模板,因为没有将它们连接在一起的全局结构。另一方面,谱结构有能力生成在图中概括的局部测量值。当光谱倍增器不受约束时,产生的滤波器往往在空间上离域,如面板(c)-(d)所示。这符合傅立叶分析编码局部现象的基本限制。然而,我们在面板(e)-(f)中观察到,在拉普拉斯图的光谱上进行简单的平滑处理,可以恢复某种形式的空间定位,并创建过滤器,在不同的空间位置上进行概括,正如对卷积运算符所预期的那样。

5.2 MNIST on the sphere

我们在这一部分测试了图CNN在另一个低维图上的构造。在这种情况下,我们将mnist数字提升到球体上。数据集的构造如下。我们首次从单位球面s2 r3中随机抽取4096个点s=s j j≤4096。然后我们考虑r3的正交基e=(e1,e2,e3),其中e1=1,e2 2,e3=3,以及随机协方差算子∑(e+w)t(e+w),其中w是方差σ2<1的高斯IID矩阵。对于来自原始MNIST数据集的每个信号XI,我们从前一个分布中采样协方差算子I,并考虑其PCA基UI。这个基础是我们用双三次插值法将XI投影到S上的一个视点和面内旋转。图7显示了生成的投影数字的示例。因为数字“6”和“9”是等效的模旋转,所以我们从数据集中删除“9”。图8显示了拉普拉斯图的两个特征向量。