线性回归和逻辑回归(比较清楚)

1.线性回归

在统计学中,线性回归(Linear Regression)是利用称为线性回归方程的最小平方函数对一个或多个自变量和因变量之间关系进行建模的一种回归分析。这种函数是一个或多个称为回归系数的模型参数的线性组合(自变量都是一次方)。只有一个自变量的情况称为简单回归,大于一个自变量情况的叫做多元回归。

优点:结果易于理解,计算上不复杂。

缺点:对非线性数据拟合不好。

适用数据类型:数值型和标称型数据。

算法类型:回归算法

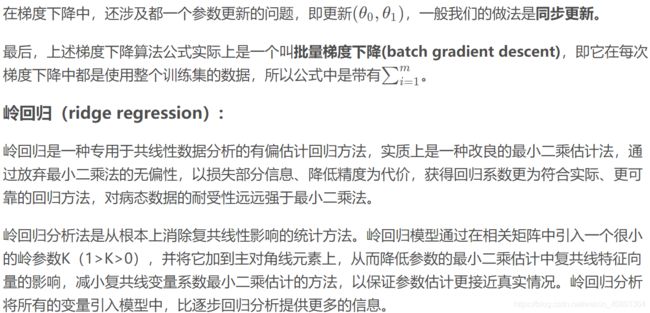

其中线性回归模型中,L1正则化 —Lasso回归;L2正则化— Ridge回归(岭回归)

正则化是用于约束损失函数的附加项

#Import Library

#Import other necessary libraries like pandas, numpy...

from sklearn import linear_model

#Load Train and Test datasets

#Identify feature and response variable(s) and values must be numeric and numpy arrays

x_train=input_variables_values_training_datasets

y_train=target_variables_values_training_datasets

x_test=input_variables_values_test_datasets

# Create linear regression object

linear = linear_model.LinearRegression()

# Train the model using the training sets and check score

linear.fit(x_train, y_train)

linear.score(x_train, y_train)

#Equation coefficient and Intercept

print('Coefficient: \n', linear.coef_)

print('Intercept: \n', linear.intercept_)

#Predict Output

predicted= linear.predict(x_test)

上述是使用sklearn包中的线性回归算法的代码例子,下面是一个实现的具体例子。

# -*- coding: utf-8 -*-

"""

Created on Mon Oct 17 10:36:06 2016

@author: cai

"""

import os

import numpy as np

import pandas as pd

import matplotlib.pylab as plt

from sklearn import linear_model

# 计算损失函数

def computeCost(X, y, theta):

inner = np.power(((X * theta.T) - y), 2)

return np.sum(inner) / (2 * len(X))

# 梯度下降算法

def gradientDescent(X, y, theta, alpha, iters):

temp = np.matrix(np.zeros(theta.shape))

parameters = int(theta.ravel().shape[1])

cost = np.zeros(iters)

for i in range(iters):

error = (X * theta.T) - y

for j in range(parameters):

# 计算误差对权值的偏导数

term = np.multiply(error, X[:, j])

# 更新权值

temp[0, j] = theta[0, j] - ((alpha / len(X)) * np.sum(term))

theta = temp

cost[i] = computeCost(X, y, theta)

return theta, cost

dataPath = os.path.join('data', 'ex1data1.txt')

data = pd.read_csv(dataPath, header=None, names=['Population', 'Profit'])

# print(data.head())

# print(data.describe())

# data.plot(kind='scatter', x='Population', y='Profit', figsize=(12, 8))

# 在数据起始位置添加1列数值为1的数据

data.insert(0, 'Ones', 1)

print(data.shape)

cols = data.shape[1]

X = data.iloc[:, 0:cols-1]

y = data.iloc[:, cols-1:cols]

# 从数据帧转换成numpy的矩阵格式

X = np.matrix(X.values)

y = np.matrix(y.values)

# theta = np.matrix(np.array([0, 0]))

theta = np.matrix(np.zeros((1, cols-1)))

print(theta)

print(X.shape, theta.shape, y.shape)

cost = computeCost(X, y, theta)

print("cost = ", cost)

# 初始化学习率和迭代次数

alpha = 0.01

iters = 1000

# 执行梯度下降算法

g, cost = gradientDescent(X, y, theta, alpha, iters)

print(g)

# 可视化结果

x = np.linspace(data.Population.min(),data.Population.max(),100)

f = g[0, 0] + (g[0, 1] * x)

fig, ax = plt.subplots(figsize=(12, 8))

ax.plot(x, f, 'r', label='Prediction')

ax.scatter(data.Population, data.Profit, label='Training Data')

ax.legend(loc=2)

ax.set_xlabel('Population')

ax.set_ylabel('Profit')

ax.set_title('Predicted Profit vs. Population Size')

fig, ax = plt.subplots(figsize=(12, 8))

ax.plot(np.arange(iters), cost, 'r')

ax.set_xlabel('Iteration')

ax.set_ylabel('Cost')

ax.set_title('Error vs. Training Epoch')

# 使用sklearn 包里面实现的线性回归算法

model = linear_model.LinearRegression()

model.fit(X, y)

x = np.array(X[:, 1].A1)

# 预测结果

f = model.predict(X).flatten()

# 可视化

fig, ax = plt.subplots(figsize=(12, 8))

ax.plot(x, f, 'r', label='Prediction')

ax.scatter(data.Population, data.Profit, label='Training Data')

ax.legend(loc=2)

ax.set_xlabel('Population')

ax.set_ylabel('Profit')

ax.set_title('Predicted Profit vs. Population Size(using sklearn)')

plt.show()

1、实现简单;

2、分类时计算量非常小,速度很快,存储资源低;

缺点:

1、容易欠拟合,一般准确度不太高

2、只能处理两分类问题(在此基础上衍生出来的softmax可以用于多分类),且必须线性可分;

适用数据类型:数值型和标称型数据。

类别:分类算法。

试用场景:解决二分类问题。

代码实现

首先是采用sklearn包中的逻辑回归算法代码:

#Import Library

from sklearn.linear_model import LogisticRegression

#Assumed you have, X (predictor) and Y (target) for training data set and x_test(predictor) of test_dataset

# Create logistic regression object

model = LogisticRegression()

# Train the model using the training sets and check score

model.fit(X, y)

model.score(X, y)

#Equation coefficient and Intercept

print('Coefficient: \n', model.coef_)

print('Intercept: \n', model.intercept_)

#Predict Output

predicted= model.predict(x_test)

应用例子

#!/usr/bin/env python

# -*- coding: utf-8 -*-

"""

@Time : 2016/10/19 21:35

@Author : cai

实现多类的逻辑回归算法

"""

import os

import numpy as np

import pandas as pd

import matplotlib.pylab as plt

from scipy.optimize import minimize

from scipy.io import loadmat

# 定义Sigmoid函数

def sigmoid(z):

return 1 / (1 + np.exp(-z))

# 定义 cost函数

def costReg(theta, X, y, lambdas):

theta = np.matrix(theta)

X = np.matrix(X)

y = np.matrix(y)

h = X * theta.T

first = np.multiply(-y, np.log(sigmoid(h)))

second = np.multiply((1-y), np.log(1 - sigmoid(h)))

reg = (lambdas / 2 * len(X)) * np.sum(np.power(theta[:, 1:theta.shape[1]], 2))

return np.sum(first - second) / (len(X)) + reg

# 梯度下降算法的实现, 输出梯度对权值的偏导数

def gradient(theta, X, y, lambdas):

theta = np.matrix(theta)

X = np.matrix(X)

y = np.matrix(y)

parameters = int(theta.ravel().shape[1])

grad = np.zeros(parameters)

# 计算误差

error = sigmoid(X * theta.T) - y

grad = ((X.T * error) / len(X)).T + ((lambdas / len(X)) * theta)

grad[0, 0] = np.sum(np.multiply(error, X[:, 0])) / len(X)

return np.array(grad).ravel()

# 实现一对多的分类方法

def one_vs_all(X, y, num_labels, lambdas):

rows = X.shape[0]

params = X.shape[1]

# 每个分类器有一个 k * (n+1)大小的权值数组

all_theta = np.zeros((num_labels, params + 1))

# 增加一列,这是用于偏置值

X = np.insert(X, 0, values=np.ones(rows), axis=1)

# 标签的索引从1开始

for i in range(1, num_labels + 1):

theta = np.zeros(params + 1)

y_i = np.array([1 if label == i else 0 for label in y])

y_i = np.reshape(y_i, (rows, 1))

# 最小化损失函数

fmin = minimize(fun=costReg, x0=theta, args=(X, y_i, lambdas), method='TNC', jac=gradient)

all_theta[i-1, :] = fmin.x

return all_theta

def predict_all(X, all_theta):

rows = X.shape[0]

params = X.shape[1]

num_labels = all_theta.shape[0]

# 增加一列,这是用于偏置值

X = np.insert(X, 0, values=np.ones(rows), axis=1)

X = np.matrix(X)

all_theta = np.matrix(all_theta)

# 对每个训练样本计算其类的概率值

h = sigmoid(X * all_theta.T)

# 获取最大概率值的数组索引

h_argmax = np.argmax(h, axis=1)

# 数组是从0开始索引,而标签值是从1开始,所以需要加1

h_argmax = h_argmax + 1

return h_argmax

dataPath = os.path.join('data', 'ex3data1.mat')

# 载入数据

data = loadmat(dataPath)

print(data)

print(data['X'].shape, data['y'].shape)

# print(np.unique(data['y']))

# 测试

# rows = data['X'].shape[0]

# params = data['X'].shape[1]

#

# all_theta = np.zeros((10, params + 1))

#

# X = np.insert(data['X'], 0, values=np.ones(rows), axis=1)

#

# theta = np.zeros(params + 1)

#

# y_0 = np.array([1 if label == 0 else 0 for label in data['y']])

# y_0 = np.reshape(y_0, (rows, 1))

# print(X.shape, y_0.shape, theta.shape, all_theta.shape)

all_theta = one_vs_all(data['X'], data['y'], 10, 1)

print(all_theta)

# 计算分类准确率

y_pred = predict_all(data['X'], all_theta)

correct = [1 if a == b else 0 for (a, b) in zip(y_pred, data['y'])]

accuracy = (sum(map(int, correct)) / float(len(correct)))

print('accuracy = {0}%'.format(accuracy * 100))

作者的github中有代码:https://github.com/ccc013/CodingPractise/blob/master/Python/MachineLearning/mulLogisticRegressionPractise.py

参考python代码资源:

https://www.johnwittenauer.net/machine-learning-exercises-in-python-part-1/

原文链接:https://blog.csdn.net/lc013/article/details/55002463

3.线性回归和逻辑回归的区别

1、 为什么是逻辑回归?

都说线性回归用来做回归预测,逻辑回归用于做二分类,一个是解决回归问题,一个用于解决分类问题。但很多人问起逻辑回归和线性回归的区别,很多人会大喊一声(也可能是三声):逻辑回归就是对线性回归做了一个压缩,将y 的阈值从y∈(+∞,−∞)y∈(+∞,−∞)压缩到(0,1)(0,1)。那么问题来了,问什么仅仅做一个简单的压缩,就将回归问题变成了分类问题?里面蕴含着本质?

首先要从数据说起,线性回归的样本的输出,都是连续值,y∈(+∞,−∞)y∈(+∞,−∞)而,逻辑回归中y∈{0,1}y∈{0,1},只能取0和1。对于拟合函数也有本质上的差别:

线性回归:f(x)=θTX=θ1x1+θ2x2+⋯+θnxnf(x)=θTX=θ1x1+θ2x2+⋯+θnxn

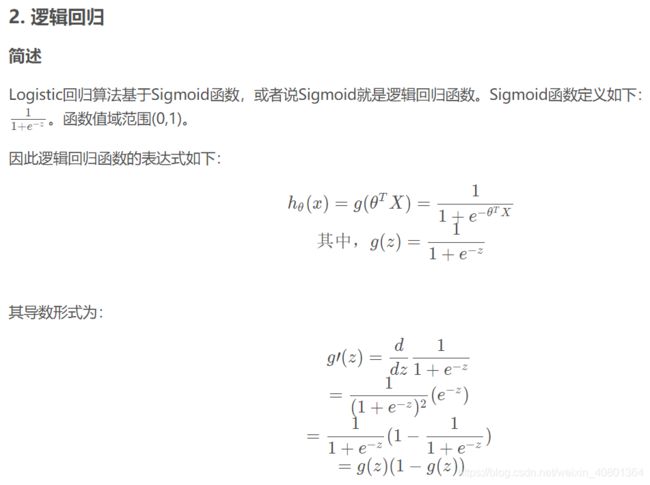

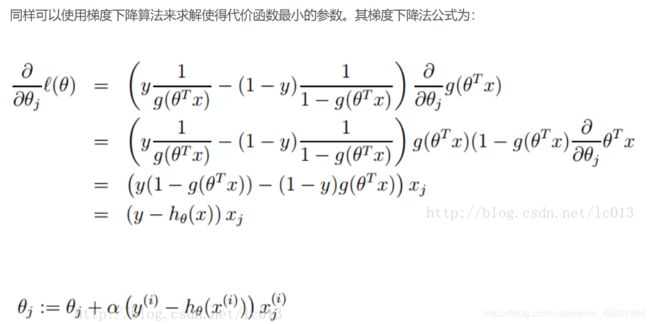

逻辑回归:f(x)=p(y=1∣x;θ)=g(θTX)f(x)=p(y=1∣x;θ)=g(θTX),其中,g(z)=11+e−zg(z)=11+e−z

可以看出,线性回归的拟合函数,的确是对f(x)的输出变量y的拟合,而逻辑回归的拟合函数是对为1类的样本的概率的拟合。

2、那么,为什么要以1类样本的概率进行拟合呢,为什么可以这样拟合呢?

首先,logstic 函数的本质说起。若要直接通过回归的方法去预测二分类问题, y 到底是0类还是1类,最好的函数是单位阶跃函数。然而单位阶跃函数不连续(GLM 的必要条件),而 logsitic 函数恰好接近于单位阶跃函数,且单调可微。于是希望通过该复合函数去拟合分类问题:

y=11+e−θTX

y=11+e−θTX

于是有:

lny1−y=θTX

lny1−y=θTX

发现如果我们假设 y=p(y为1类∣x;θ)y=p(y为1类∣x;θ) 作为我们的拟合函数,等号左边的表达式的数学意义就是1类和0类的对数几率(log odds)。这个表达式的意思就是:用线性模型的预测结果去逼近1类和0类的几率比。于是,θTX=0θTX=0就相当于是1类和0类的决策边界:

当θTX>0θTX>0,则有y>0.5y>0.5;若θTX→+∞θTX→+∞ ,则y→1y→1 ,即y 为1类;

当θTX<0θTX<0,则有y<0.5y<0.5 ; 若θTX→−∞θTX→−∞,则y→0y→0,即 y 为0类。

这个时候就能看出区别来了,在线性回归中θTXθTX为预测值的拟合函数;而在逻辑回归中θTX=0θTX=0为决策边界。

————————————————

版权声明:本文为CSDN博主「会飞的蝸牛」的原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/u010692239/article/details/52345754